Сгенерировано с помощью Midjourney

Предприятия во всех отраслях и уголках земного шара спешат интегрировать мощные языковые модели (LLM), такие как ChatGPT от OpenAI, Claude от Anthropic и Jurassic от AI12Lab, чтобы повысить производительность в широком спектре бизнес-приложений, таких как исследования рынка, обслуживание клиентов. и создание контента.

Однако создание приложения LLM в масштабе предприятия требует другого набора инструментов и понимания, чем создание традиционных приложений машинного обучения (ML). Бизнес-лидеры и руководители, которые хотят сохранить авторитет бренда и надежное качество обслуживания, должны глубже понять, как работают LLM, а также плюсы и минусы различных инструментов в стеке приложений LLM.

В этой статье мы познакомим вас с высокоуровневой стратегией и инструментами, которые вам понадобятся для создания и запуска приложения LLM для вашего бизнеса.

Традиционная разработка ML против приложений LLM

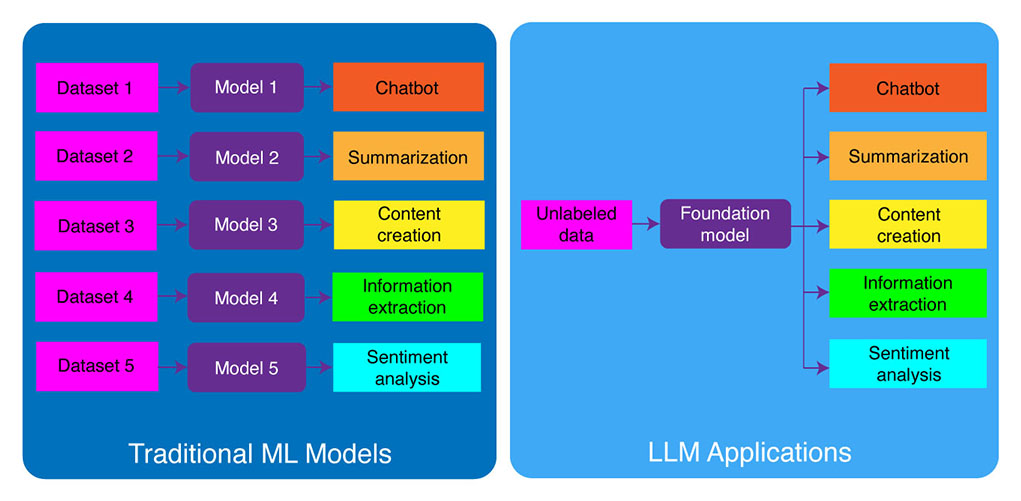

Традиционные модели машинного обучения были привязаны к конкретной задаче, а это означало, что вам нужно было построить отдельную модель для каждой отдельной задачи. Например, если вы хотите проанализировать настроения клиентов, вам нужно будет построить одну модель, а если вы хотите создать чат-бота для поддержки клиентов, вам потребуется создать другую модель.

Этот процесс создания и обучения моделей машинного обучения для конкретных задач занимает много времени и требует большого количества данных. Типы наборов данных, необходимых для обучения этих различных моделей машинного обучения, также будут различаться в зависимости от задачи. Чтобы обучить модель анализу настроений клиентов, вам потребуется набор данных отзывов клиентов, помеченных соответствующим настроением (положительным, отрицательным, нейтральным). Чтобы обучить модель для создания чат-бота службы поддержки клиентов, вам потребуется набор данных разговоров между клиентами и службой технической поддержки.

Большие языковые модели изменили это. LLM предварительно обучены на массивном наборе данных текста и кода, что позволяет им хорошо выполнять широкий спектр задач, в том числе:

- Обобщение текста

- Создание контента

- Переводы

- Извлечение информации

- Ответ на вопрос

- Анализ настроений

- Служба поддержки

- Поддержка продаж

Процесс разработки приложений LLM можно разбить на четыре основных этапа:

- Выберите подходящую модель фундамента. Это ключевой компонент, определяющий производительность вашего приложения LLM.

- При необходимости настройте модель. Вам может потребоваться доработать модель или дополнить ее дополнительной базой знаний для удовлетворения ваших конкретных потребностей.

- Настроить ML-инфраструктуру. Это включает в себя аппаратное и программное обеспечение, необходимое для запуска вашего приложения (например, полупроводники, микросхемы, облачный хостинг, вывод и развертывание).

- Дополните свое приложение дополнительными инструментами. Эти инструменты могут помочь повысить эффективность, производительность и безопасность вашего приложения.

Теперь давайте взглянем на соответствующий стек технологий.

Если этот подробный образовательный контент вам полезен, подпишитесь на нашу рассылку AI быть предупрежденным, когда мы выпустим новый материал.

Стек приложений LLM высокого уровня

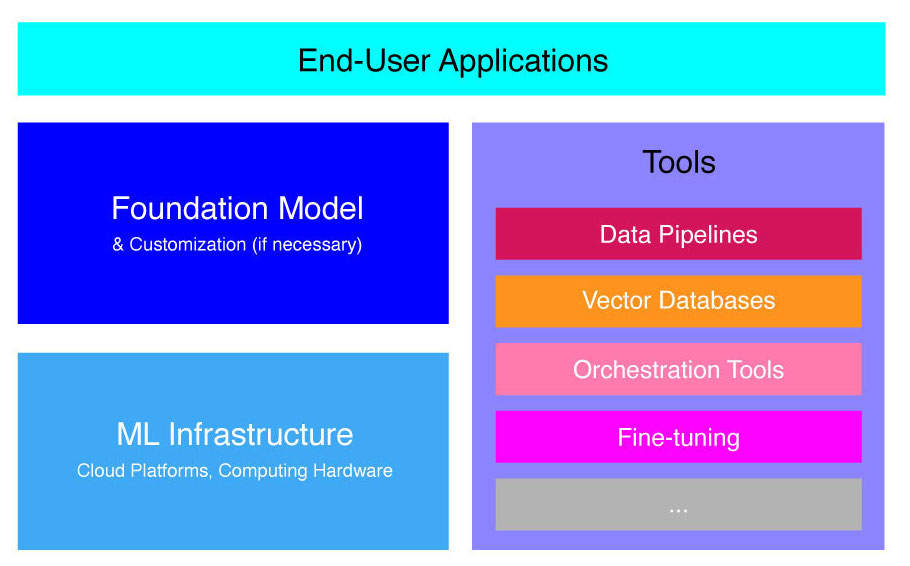

Приложения LLM построены на основе нескольких ключевых компонентов, в том числе:

- Базовая модель, что может потребовать настройки в конкретных случаях использования.

- Инфраструктура машинного обучения для достаточных вычислительных ресурсов через облачные платформы или собственное оборудование компании.

- Дополнительные инструменты, такие как конвейеры данных, векторные базы данных, инструменты оркестровки, точная настройка платформ машинного обучения, инструменты мониторинга производительности моделей и т. д.

Мы кратко познакомим вас с этими компонентами, чтобы вы могли лучше понять набор инструментов, необходимый для создания и развертывания приложения LLM.

Что такое модели фонда?

Использование одного предварительно обученного LLM может сэкономить вам много времени и ресурсов. Однако обучение такой модели с нуля — это своевременный и дорогостоящий процесс, который выходит за рамки возможностей большинства компаний, за исключением нескольких элитных технологических лидеров.

Несколько компаний и исследовательских групп обучили эти модели и разрешили другим компаниям их использовать. Основные примеры включают ChatGPT, Claude, Llama, Jurassic и T5. Эти общедоступные модели называются базовыми моделями. Некоторые из них являются проприетарными, и к ним можно получить доступ через вызовы API за определенную плату. Другие имеют открытый исходный код и могут использоваться бесплатно. Эти модели предварительно обучены на большом наборе неразмеченных текстовых данных, что позволяет им выполнять широкий спектр задач, от создания оригинальных рекламных копий до общения с вашими клиентами на их родном языке от имени компании.

Существует два основных типа базовых моделей: проприетарные и с открытым исходным кодом.

Собственные модели принадлежат одной компании или организации и обычно доступны только за плату. Некоторые из наиболее популярных примеров проприетарных моделей включают модели GPT от OpenAI, модели Claude от Anthropic и модели Jurassic от AI21 Labs.

Модели с открытым исходным кодом обычно доступны бесплатно для всех, кто хочет их использовать. Однако некоторые модели с открытым исходным кодом имеют ограничения на их использование, например: (1) они доступны только для исследовательских целей, (2) доступны только для коммерческого использования компаниями определенного размера. Сообщество разработчиков открытого исходного кода утверждает, что введение таких ограничений не позволяет модели квалифицироваться как «открытая». Тем не менее, наиболее яркими примерами языковых моделей, которые можно использовать бесплатно, являются модели Llama от Meta, модели Falcon от Института технологических инноваций в Абу-Даби и модели StableLM от Stability AI. Узнайте больше о моделях с открытым исходным кодом и связанных с ними рисках здесь.

Теперь давайте обсудим несколько факторов, которые следует учитывать при выборе базовой модели для вашего приложения LLM.

Выберите модель фонда

Выбор лучшей базовой модели для вашего приложения LLM может быть сложным процессом, но мы можем разбить его на три этапа:

- Выбирайте между проприетарными моделями и моделями с открытым исходным кодом. Проприетарные модели обычно крупнее и эффективнее, чем модели с открытым исходным кодом, но они могут быть более дорогими в использовании и менее гибкими. Кроме того, код не настолько прозрачен, что затрудняет отладку или устранение проблем с производительностью проприетарных моделей. С другой стороны, модели с открытым исходным кодом обычно получают меньше обновлений и меньше поддержки со стороны разработчиков.

- Выберите размер модели. Большие модели обычно лучше справляются с задачами, требующими больших знаний, такими как ответы на вопросы или создание творческого текста. Однако более крупные модели требуют больших вычислительных ресурсов. Вы можете начать с экспериментов с более крупными моделями, а затем перейти к более мелким, если производительность модели удовлетворяет вашему варианту использования.

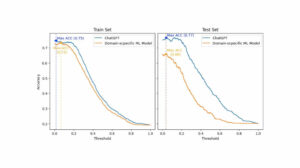

- Выберите конкретную модель. Вы можете начать с просмотра общих тестов, чтобы составить список моделей для тестирования. Затем приступайте к тестированию различных моделей для конкретных задач вашего приложения. Для пользовательского сравнительного анализа рассмотрите возможность расчета BLEU и ROUGE баллы, метрики, которые помогают количественно оценить количество исправлений, которые необходимо внести в сгенерированный ИИ текст перед выпуском вывода для приложений с автоматическим управлением.

Для лучшего понимания различий между различными языковыми моделями см. наш обзор самых мощных языковых (LLM) и визуальных языковых моделей (VLM).

После того, как вы выбрали базовую модель для своего приложения, вы можете подумать, нужно ли вам настраивать модель для повышения производительности.

Настройка базовой модели

В некоторых случаях вы можете захотеть настроить базовую языковую модель для повышения производительности в вашем конкретном случае использования. Например, вы можете оптимизировать для определенного:

- Домен. Если вы работаете в определенных областях, таких как юриспруденция, финансы или здравоохранение, вы можете обогатить словарный запас модели в этой области, чтобы она могла лучше понимать запросы конечных пользователей и отвечать на них.

- Сложность задачи . Например, если вы хотите, чтобы модель создавала маркетинговые кампании, вы можете предоставить ей конкретные примеры брендового маркетингового контента. Это поможет модели изучить шаблоны и стили, подходящие для вашей компании и аудитории.

- Тон голоса. Если вам нужно, чтобы модель использовала определенный тон голоса, вы можете настроить модель на наборе данных, который включает примеры ваших целевых лингвистических образцов.

Существует три возможных способа настройки базовой языковой модели:

- Тонкая настройка: предоставляет модели помеченный набор данных, содержащий около 100–500 записей. Веса модели обновляются, что должно привести к повышению производительности задач, представленных этим набором данных.

- Адаптация домена: предоставляет модели немаркированный набор данных для предметной области, который содержит большой объем данных из соответствующей предметной области. В этом случае также обновляются веса модели.

- Поиск информации: дополняет базовую модель знаниями из закрытой области. Модель не переобучается, и веса модели остаются прежними. Однако модели разрешено извлекать информацию из векторной базы данных, содержащей соответствующие данные.

Первые два подхода требуют значительных вычислительных ресурсов для повторного обучения модели, что обычно возможно только для крупных компаний с соответствующими техническими способностями для управления настройкой. Небольшие компании обычно используют более распространенный подход, заключающийся в дополнении модели знаниями предметной области с помощью векторной базы данных, который мы подробно рассмотрим далее в этой статье в разделе, посвященном инструментам LLM.

Настройка инфраструктуры машинного обучения

Компонент инфраструктуры машинного обучения ландшафта LLMOps включает облачные платформы, вычислительное оборудование и другие ресурсы, необходимые для развертывания и запуска LLM. Этот компонент особенно актуален, если вы решите использовать модель с открытым исходным кодом или настроить модель для своего приложения. В этом случае могут потребоваться значительные вычислительные ресурсы для тонкой настройки модели, если это необходимо, и ее запуска.

Существует ряд облачных платформ, которые предлагают услуги по развертыванию LLM, включая Google Cloud Platform, Amazon Web Services и Microsoft Azure. Эти платформы предоставляют ряд функций, упрощающих развертывание и запуск LLM, в том числе:

- Предварительно обученные модели, которые можно настроить для конкретного приложения.

- Управляемая инфраструктура, которая заботится о базовом аппаратном и программном обеспечении

- Инструменты и службы для мониторинга и отладки ваших LLM

Количество необходимых вычислительных ресурсов будет зависеть от размера и сложности вашей модели, задач, которые вы хотите, чтобы она выполняла, и масштаба бизнес-операций, где вы хотите развернуть эту модель.

Дополнить с помощью инструментов

Дополнительные смежные инструменты LLM можно использовать для дальнейшего повышения производительности вашего приложения LLM.

Конвейеры данных

Если вам нужно использовать свои данные в продукте LLM, конвейер предварительной обработки данных станет важной опорой вашего нового технологического стека, как и в традиционном корпоративном стеке ИИ. Эти инструменты включают соединители для приема данных из любого источника, уровень преобразования данных и нисходящие соединители. Ведущие поставщики конвейеров данных, такие как Databricks и Snowflake, а также новые игроки, такие как Unstructured, упрощают разработчикам поиск больших и крайне разнородных корпусов данных на естественном языке (например, тысячи PDF-файлов, презентаций PowerPoint, журналов чатов, извлеченных файлов HTML, и т. д.) в единую точку доступа или даже в единый документ, который в дальнейшем может использоваться приложениями LLM.

Векторные базы данных

Модели больших языков ограничены обработкой нескольких тысяч слов за раз, поэтому они не могут эффективно обрабатывать большие документы самостоятельно. Чтобы использовать возможности больших документов, компаниям необходимо использовать векторные базы данных.

Векторные базы данных — это системы хранения, которые преобразуют большие документы, которые они получают через конвейеры данных, в управляемые векторы или встраивания. Затем приложения LLM могут запрашивать эти базы данных, чтобы точно определить правильные векторы, извлекая только необходимые фрагменты информации.

Некоторые из наиболее известных векторных баз данных, доступных в настоящее время, — это Pinecone, Chroma и Weaviate.

Инструменты оркестрации

Когда пользователь отправляет запрос в ваше приложение LLM, например, вопрос в службу поддержки клиентов, приложению необходимо создать серию подсказок перед отправкой этого запроса в языковую модель. Окончательный запрос к языковой модели обычно состоит из шаблона приглашения, жестко закодированного разработчиком, примеров допустимых выходных данных, называемых примерами с несколькими выстрелами, любой необходимой информации, полученной из внешних API-интерфейсов, и набора соответствующих документов, извлеченных из векторной базы данных. . Инструменты оркестрации от таких компаний, как LangChain или LlamaIndex, могут помочь упростить этот процесс, предоставляя готовые к использованию платформы для управления и выполнения запросов.

Тонкая настройка

Большие языковые модели, обученные на массивных наборах данных, могут создавать грамматически правильный и плавный текст. Однако в некоторых областях, таких как медицина или юриспруденция, им может не хватать точности. Точная настройка этих моделей на наборах данных для предметной области позволяет им усвоить уникальные особенности этих областей, повышая их способность генерировать релевантный текст.

Тонкая настройка LLM может быть дорогостоящим процессом для небольших компаний. Однако решения от таких компаний, как Weights & Biases и OctoML, могут помочь в упорядоченной и эффективной тонкой настройке. Эти решения предоставляют компаниям платформу для тонкой настройки LLM без необходимости вкладывать средства в собственную инфраструктуру.

Другие инструменты

Есть много других инструментов, которые могут быть полезны для создания и запуска приложений LLM. Например, вам могут понадобиться инструменты для маркировки, если вы хотите точно настроить модель с вашими конкретными образцами данных. Вы также можете развернуть определенные инструменты для мониторинга производительности вашего приложения, поскольку даже незначительные изменения базовой модели или запросов от клиентов могут значительно повлиять на производительность подсказок. Наконец, есть инструменты, которые отслеживают безопасность моделей, чтобы помочь вам избежать рекламы ненавистнического контента, опасных рекомендаций или предубеждений. Необходимость и важность этих различных инструментов будет зависеть от вашего конкретного варианта использования.

Что дальше в разработке приложений LLM?

Четыре шага для разработки продукта LLM, которые мы обсуждали здесь, являются важной основой стратегии генеративного искусственного интеллекта любого предприятия, которая использует большие языковые модели. Они важны для понимания нетехническими бизнес-лидерами, даже если у вас есть техническая команда, реализующая детали. В будущем мы опубликуем более подробные руководства о том, как использовать широкий спектр генеративных инструментов искусственного интеллекта на рынке. На данный момент вы можете подписаться на нашу рассылку чтобы получать последние обновления.

Понравилась эта статья? Подпишитесь на обновления корпоративного ИИ.

Мы сообщим вам, когда мы выпустим больше кратких статей, подобных этой.

Похожие страницы:

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Автомобили / электромобили, Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- Смещения блоков. Модернизация права собственности на экологические компенсации. Доступ здесь.

- Источник: https://www.topbots.com/llm-product-development-technology-stack/

- :является

- :нет

- :куда

- $UP

- 1

- a

- способность

- О нас

- Абу-Даби

- доступ

- Доступ

- деятельность

- Ad

- дополнительный

- Дополнительно

- примыкающий

- AI

- ИИ стратегия

- позволять

- разрешено

- позволяет

- причислены

- Amazon

- Amazon Web Services

- количество

- an

- анализировать

- и

- Другой

- Антропный

- любой

- кто угодно

- API

- API

- Применение

- Разработка приложения

- Приложения

- подхода

- подходы

- соответствующий

- МЫ

- области

- гайд

- статьи

- AS

- связанный

- At

- аудитория

- доступен

- избежать

- Лазурный

- Использование темпера с изогнутым основанием

- в основном

- BE

- было

- до

- от имени

- не являетесь

- бенчмаркинг

- тесты

- ЛУЧШЕЕ

- Лучшая

- между

- Beyond

- предубеждения

- повышение

- Коробка

- марка

- заклеймили

- Ломать

- кратко

- Сломанный

- строить

- Строительство

- построенный

- бизнес

- Бизнес-приложения

- Бизнес лидеры

- бизнес

- но

- by

- расчет

- под названием

- Объявления

- Кампании

- CAN

- возможности

- способный

- заботится

- случаев

- случаев

- определенный

- сложные

- менялась

- изменения

- Chatbot

- ChatGPT

- проверка

- чипсы

- Выберите

- Выбирая

- выбранный

- требования

- облако

- Облако хостинг

- Облачная платформа

- код

- коммерческая

- Общий

- общение

- сообщество

- Компании

- Компания

- Компании

- сложность

- компонент

- компоненты

- состоящие

- вычисление

- Минусы

- Рассматривать

- строить

- содержит

- содержание

- Беседы

- копии

- Corner

- исправить

- исправления

- соответствующий

- дорогостоящий

- творческий

- В настоящее время

- изготовленный на заказ

- клиент

- Служба поддержки игроков

- служба поддержки

- Клиенты

- настройка

- настроить

- опасно

- данным

- База данных

- базы данных

- Databricks

- Наборы данных

- более глубокий

- определяющий

- в зависимости

- развертывание

- развертывание

- развертывание

- подробность

- подробный

- подробнее

- развивать

- Застройщик

- застройщиков

- развивающийся

- Развитие

- -Даби

- Различия

- различный

- трудный

- обсуждать

- обсуждается

- документ

- Документация

- не

- домен

- доменов

- вниз

- e

- каждый

- легко

- образовательных

- фактически

- затрат

- эффективный

- элита

- позволяет

- повышать

- повышение

- обогащать

- Предприятие

- особенно

- существенный

- и т.д

- Эфир (ETH)

- Даже

- Каждая

- пример

- Примеры

- Кроме

- проведение

- руководителей высшего звена.

- дорогим

- и, что лучший способ

- факторы

- сокол

- выполнимый

- Особенности

- Комисии

- несколько

- меньше

- окончательный

- в заключение

- финансовый

- First

- гибкого

- Что касается

- Год основания

- 4

- каркасы

- Бесплатно

- от

- далее

- будущее

- Общие

- порождать

- порождающий

- поколение

- генеративный

- Генеративный ИИ

- получить

- Дайте

- земной шар

- Go

- будет

- Google Cloud

- Виртуальная платформа Google

- земля

- рука

- Аппаратные средства

- упряжь

- Есть

- имеющий

- здравоохранение

- помощь

- здесь

- на высшем уровне

- очень

- хостинг

- Как

- How To

- Однако

- HTML

- HTTPS

- i

- if

- Влияние

- Осуществляющий

- значение

- важную

- улучшать

- in

- углубленный

- включают

- включает в себя

- В том числе

- промышленность

- информация

- Инфраструктура

- Инновации

- Институт

- интегрировать

- в

- Введение

- Грин- карта инвестору

- IT

- JPG

- всего

- Основные

- Вид

- Знать

- знания

- маркировка

- Labs

- Отсутствие

- пейзаж

- язык

- большой

- больше

- новее

- последний

- Последние обновления

- закон

- слой

- Лидеры

- ведущий

- УЧИТЬСЯ

- изучение

- Юр. Информация

- Меньше

- Кредитное плечо

- рычаги

- такое как

- недостатки

- Ограниченный

- Лама

- Длинное

- посмотреть

- серия

- машина

- обучение с помощью машины

- Главная

- сделать

- ДЕЛАЕТ

- управлять

- управления

- многих

- рынок

- исследования рынка

- Маркетинг

- Маркетинговые кампании

- рынка

- массивный

- материала

- макс-ширина

- Май..

- смысл

- медицина

- Встречайте

- Мета

- Метрика

- Microsoft

- Microsoft Azure

- может быть

- небольшая

- ML

- модель

- Модели

- монитор

- Мониторинг

- БОЛЕЕ

- самых

- Самые популярные

- родной

- натуральный

- Естественный язык

- необходимо

- Необходимость

- необходимый

- потребности

- отрицательный

- Нейтральные

- Новые

- Новая технология

- Новостные рассылки

- следующий

- нетехнических

- сейчас

- номер

- of

- предлагают

- on

- ONE

- те,

- только

- с открытым исходным кодом

- OpenAI

- работать

- Оптимизировать

- or

- оркестровка

- организация

- Другое

- Другое

- наши

- внешний

- выходной

- обзор

- собственный

- принадлежащих

- паттеранами

- выполнять

- производительность

- выполнения

- мародерство

- трубопровод

- Платформа

- Платформы

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- игроки

- Точка

- Популярное

- положительный

- возможное

- мощностью

- мощный

- Точность

- Presentations

- проблемам

- процесс

- обработка

- производит

- Продукт

- разработка продукта

- видный

- Содействие

- ( изучите наши патенты),

- PROS

- обеспечивать

- поставщики

- приводит

- обеспечение

- публиковать

- целей

- Полагая

- квалифицировать

- Запросы

- вопрос

- Вопросы

- ассортимент

- Читать

- Получать

- рекомендаций

- учет

- освободить

- выпуска

- соответствующие

- складская

- представленный

- запросить

- Запросы

- требовать

- требуется

- исследованиям

- Полезные ресурсы

- Реагируйте

- Ограничения

- результат

- обзор

- Отзывы

- правую

- рисках,

- Run

- Бег

- Сохранность

- то же

- Сохранить

- Шкала

- Раздел

- безопасность

- Полупроводниковые приборы

- настроение

- отдельный

- Серии

- обслуживание

- Услуги

- набор

- несколько

- должен

- подпись

- значительный

- существенно

- одинарной

- Размер

- небольшой

- меньше

- So

- Software

- Решения

- некоторые

- Источник

- конкретный

- Стабильность

- стек

- Начало

- оставаться

- Шаги

- По-прежнему

- диск

- Стратегия

- упорядочить

- обтекаемый

- стили

- такие

- достаточный

- РЕЗЮМЕ

- поддержка

- системы

- взять

- принимает

- Талант

- цель

- Сложность задачи

- задачи

- команда

- команды

- технологии

- Технический

- техническая поддержка

- Технологии

- технологические инновации

- шаблон

- Тестирование

- чем

- который

- Ассоциация

- Будущее

- их

- Их

- тогда

- Там.

- Эти

- они

- этой

- те

- тысячи

- три

- Через

- время

- кропотливый

- в

- TONE

- Тон голоса

- Инструментарий

- инструменты

- топ

- ТОП-БОТЫ

- традиционный

- Train

- специалистов

- Обучение

- Transform

- трансформация

- прозрачный

- учебные пособия

- два

- Типы

- типично

- лежащий в основе

- понимать

- понимание

- созданного

- Уникальные особенности

- обновление

- Updates

- использование

- прецедент

- используемый

- Информация о пользователе

- обычно

- различный

- с помощью

- Режимы

- vs

- хотеть

- стремятся

- хочет

- способы

- we

- Web

- веб-сервисы

- ЧТО Ж

- были

- когда

- будь то

- который

- КТО

- широкий

- Широкий диапазон

- будете

- без

- слова

- Работа

- бы

- являетесь

- ВАШЕ

- зефирнет