Рекламные содержания

ChatGPT и подобные инструменты, основанные на больших языковых моделях (LLM), просто потрясающие. Но они не являются универсальными инструментами.

Это похоже на выбор других инструментов для строительства и творчества. Вам нужно выбрать подходящий для работы. Вы не станете пытаться затянуть болт молотком или перевернуть котлету для гамбургера венчиком. Этот процесс будет неудобным и приведет к грязному провалу.

Языковые модели, такие как LLM, составляют лишь часть более широкого набора инструментов машинного обучения, охватывающего как генеративный ИИ, так и прогнозирующий ИИ. Выбор правильного типа модели машинного обучения имеет решающее значение для соответствия требованиям вашей задачи.

Давайте углубимся в то, почему программы LLM лучше подходят для составления текста или мозгового штурма идей подарков, чем для решения наиболее важных задач прогнозного моделирования в вашем бизнесе. «Традиционные» модели машинного обучения, которые предшествовали LLM и неоднократно доказывали свою ценность в бизнесе, по-прежнему играют жизненно важную роль. Мы также рассмотрим новаторский подход к совместному использованию этих инструментов — захватывающую разработку, которую мы в Pecan называем Прогнозирующий генИИ.

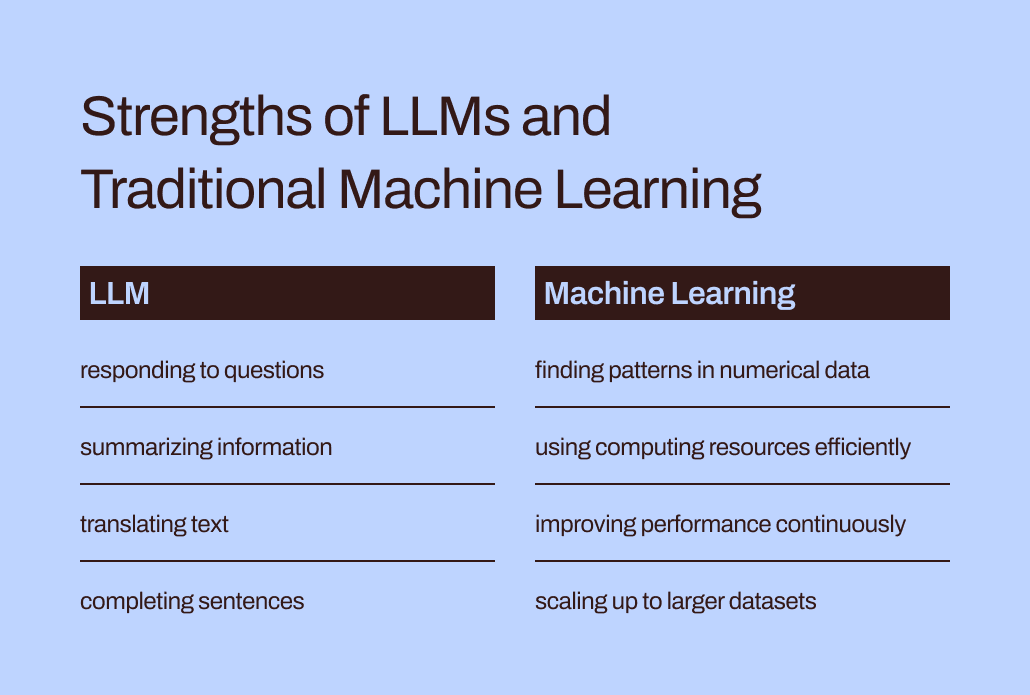

LLM созданы для слов, а не цифр.

В машинном обучении различные математические методы используются для анализа так называемых «обучающих данных» — исходного набора данных, представляющего проблему, которую аналитик данных или специалист по данным надеется решить.

Значение обучающих данных невозможно переоценить. Он содержит в себе закономерности и взаимосвязи, которые модель машинного обучения «научится» предсказывать результаты, когда позже ей будут предоставлены новые, невидимые данные.

Итак, что же такое LLM? Большие языковые модели, или LLM, подпадают под действие машинного обучения. Они возникают в результате глубокого обучения, а их структура специально разработана для обработки естественного языка.

Можно сказать, что они построены на основе слов. Их цель — просто предсказать, какое слово будет следующим в последовательности слов. Например, функция автозамены iPhone в iOS 17 теперь использует LLM, чтобы лучше предсказать, какое слово вы, скорее всего, собираетесь ввести следующим.

Теперь представьте, что вы — модель машинного обучения. (Потерпите, мы знаем, что это натяжка.) Вас научили предсказывать слова. Вы прочитали и изучили миллионы слов из огромного количества источников на самые разные темы. Ваши наставники (они же разработчики) помогли вам научиться лучше всего предсказывать слова и создавать новый текст, соответствующий запросу пользователя.

Но вот поворот. Теперь пользователь предоставляет вам огромную электронную таблицу данных о клиентах и транзакциях с миллионами строк чисел и просит вас предсказать числа, связанные с этими существующими данными.

Как вы думаете, чем оправдаются ваши прогнозы? Во-первых, вас, вероятно, будет раздражать то, что это задание не соответствует тому, над чем вы так усердно работали. (К счастью, насколько нам известно, у студентов-магистров еще нет чувств.) Что еще более важно, вас просят выполнить задачу, которая не соответствует тому, чему вы научились. И вы, вероятно, не будете так хорошо выступать.

Разрыв между обучением и выполнением задач помогает объяснить, почему LLM не очень подходят для задач прогнозирования, включающих числовые и табличные данные — основной формат данных, который собирает большинство компаний. Вместо этого более эффективной является модель машинного обучения, специально созданная и настроенная для обработки данных такого типа. Его буквально этому обучали.

Проблемы эффективности и оптимизации LLM

Традиционные методы машинного обучения не только лучше подходят для числовых данных, но и гораздо более эффективны, и их легче оптимизировать для повышения производительности, чем LLM.

Давайте вернемся к вашему опыту выдачи себя за LLM. Чтение всех этих слов и изучение их стиля и последовательности — это огромная работа, не так ли? Чтобы усвоить всю эту информацию, потребуется немало усилий.

Точно так же сложное обучение LLM может привести к созданию моделей с миллиардами параметров. Эта сложность позволяет этим моделям понимать и реагировать на сложные нюансы человеческого языка. Однако интенсивное обучение сопряжено с тяжелыми вычислительными требованиями, когда LLM генерирует ответы. Численно-ориентированные «традиционные» алгоритмы машинного обучения, такие как деревья решений или нейронные сети, вероятно, потребуют гораздо меньше вычислительных ресурсов. И это не тот случай, когда «чем больше, тем лучше». Даже если бы LLM могли обрабатывать числовые данные, эта разница означала бы, что традиционные методы машинного обучения все равно будут быстрее, эффективнее, экологически устойчивее и экономичнее.

Кроме того, спрашивали ли вы когда-нибудь ChatGPT, откуда он знает, что нужно дать тот или иной ответ? Его ответ, вероятно, будет немного расплывчатым:

Я генерирую ответы на основе лицензированных данных, данных, созданных тренерами, и общедоступных данных. Мое обучение также включало крупномасштабные наборы данных, полученные из различных источников, включая книги, веб-сайты и другие тексты, для развития широкого понимания человеческого языка. Процесс обучения включает в себя выполнение вычислений на тысячах графических процессоров в течение недель или месяцев, но точные детали и сроки являются собственностью OpenAI.

Какая часть «знаний», отраженных в этом ответе, была получена от тренеров-людей, а не из общедоступных данных или из книг? Даже сам ChatGPT не уверен: «Относительные пропорции этих источников неизвестны, и у меня нет подробной информации о том, какие конкретные документы были частью моего обучающего набора».

Немного нервирует то, что ChatGPT дает такие уверенные ответы на ваши вопросы, но не может отследить свои ответы до конкретных источников. Ограниченная интерпретируемость и объяснимость LLM также создают проблемы при их оптимизации для конкретных потребностей бизнеса. Может быть трудно понять обоснование их информации или прогнозов. Ситуация еще больше усложняется тем, что некоторые предприятия сталкиваются с нормативными требованиями, которые означают, что они должны быть в состоянии объяснить факторы, влияющие на прогнозы модели. В целом, эти проблемы показывают, что традиционные модели машинного обучения — как правило, более интерпретируемые и объяснимые — вероятно, лучше подходят для случаев использования в бизнесе.

Правильное место для LLM в наборе инструментов прогнозирования бизнеса

Итак, должны ли мы просто предоставить LLM их задачам, связанным с текстом, и забыть о них для сценариев прогнозного использования? Теперь может показаться, что они все-таки не могут помочь с прогнозированием оттока клиентов или пожизненной ценности клиентов.

Вот в чем дело: хотя слова «традиционные модели машинного обучения» делают эти методы широко понятными и простыми в использовании, мы знаем из нашего опыта в Pecan, что предприятиям все еще сложно внедрить даже эти более знакомые формы ИИ.

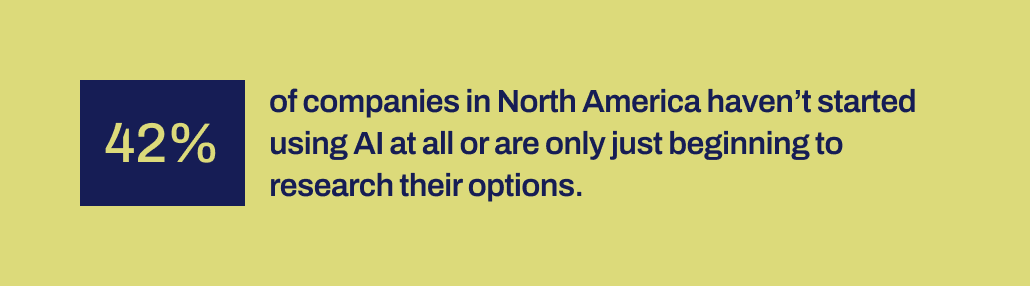

Недавнее исследование Workday показывает, что 42% компаний в Северной Америке либо еще не начали использовать ИИ, либо находятся только на ранних стадиях изучения своих возможностей. Прошло более десяти лет с тех пор, как инструменты машинного обучения стали более доступными для компаний. У них было время и доступны различные инструменты.

По какой-то причине успешные реализации ИИ оказались на удивление редкими, несмотря на огромный ажиотаж вокруг науки о данных и ИИ, а также их признанный потенциал для значительного влияния на бизнес. Отсутствует какой-то важный механизм, который помог бы преодолеть разрыв между обещаниями, данными ИИ, и способностью их продуктивно реализовать.

И именно здесь мы считаем, что LLM теперь могут сыграть жизненно важную связующую роль. LLM могут помочь бизнес-пользователям преодолеть пропасть между определением бизнес-проблемы, которую необходимо решить, и разработкой прогнозной модели.

Теперь, когда LLM становится реальностью, бизнес-команды и команды по работе с данными, у которых нет возможности или возможностей для ручного кодирования моделей машинного обучения, теперь могут лучше воплощать свои потребности в моделях. Они могут «использовать свои слова», как любят говорить родители, чтобы начать процесс моделирования.

Объединение LLM с методами машинного обучения, созданными для достижения успеха в работе с бизнес-данными

Теперь эта возможность появилась в Predictive GenAI от Pecan, который объединяет сильные стороны LLM с нашей уже усовершенствованной и автоматизированной платформой машинного обучения. Наш прогнозирующий чат на базе LLM собирает информацию от бизнес-пользователя для определения и разработки прогнозного вопроса — конкретной проблемы, которую пользователь хочет решить с помощью модели.

Затем, используя GenAI, наша платформа создает блокнот прогнозирования, чтобы сделать следующий шаг к моделированию еще проще. Опять же, опираясь на возможности LLM, блокнот содержит предварительно заполненные SQL-запросы для выбора обучающих данных для прогнозной модели. Автоматизированная подготовка данных, разработка функций, построение моделей и возможности развертывания Pecan позволяют выполнить остальную часть процесса в рекордно короткие сроки, быстрее, чем любое другое решение для прогнозного моделирования.

Короче говоря, Predictive GenAI от Pecan использует беспрецедентные языковые навыки LLM, чтобы сделать нашу лучшую в своем классе платформу прогнозного моделирования гораздо более доступной и дружественной для бизнес-пользователей. Мы рады видеть, как этот подход поможет многим другим компаниям добиться успеха с помощью ИИ.

Итак, хотя LLM в одиночестве не очень хорошо подходят для удовлетворения всех ваших потребностей в прогнозировании, они могут сыграть важную роль в продвижении ваших проектов ИИ. Интерпретируя ваш вариант использования и предоставляя вам возможность начать работу с автоматически сгенерированным кодом SQL, Predictive GenAI от Pecan является лидером в объединении этих технологий. Ты можешь проверьте это сейчас с помощью бесплатной пробной версии.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- :имеет

- :является

- :нет

- :куда

- 15%

- 17

- a

- способность

- в состоянии

- О нас

- доступной

- признанный

- дополнение

- адрес

- принять

- После

- снова

- AI

- ака

- алгоритмы

- выравнивать

- Все

- позволяет

- в одиночестве

- уже

- причислены

- удивительный

- Америка

- an

- аналитик

- анализировать

- и

- ответ

- ответы

- любой

- подхода

- МЫ

- около

- прибывший

- AS

- помощь

- At

- Автоматизированный

- автоматизированное машинное обучение

- автоматически

- доступен

- назад

- основанный

- BE

- медведь

- стали

- было

- начало

- за

- не являетесь

- верить

- ЛУЧШЕЕ

- Лучшая

- между

- миллиарды

- Немного

- болт

- Книги

- изоферменты печени

- мозговой штурм

- МОСТ

- шунтирование

- шире

- Строительство

- построенный

- бизнес

- влияние на бизнес

- бизнес

- но

- by

- призывают

- пришел

- CAN

- возможности

- возможности

- Пропускная способность

- нести

- случаев

- случаев

- определенный

- проблемы

- бездна

- чат

- ChatGPT

- Выбирая

- код

- собирать

- выходит

- Компании

- Компании

- комплекс

- сложность

- вычислительный

- расчеты

- вычисление

- уверенный

- составлять

- содержит

- исправить

- рентабельным

- может

- проработаны

- Создайте

- создали

- Создающий

- критической

- Пересекать

- решающее значение

- клиент

- данным

- аналитик данных

- Подготовка данных

- наука о данных

- ученый данных

- Наборы данных

- десятилетие

- решение

- глубоко

- глубокое обучение

- более глубокий

- определение

- запросы

- развертывание

- предназначенный

- Несмотря на

- подробный

- подробнее

- развивать

- развитый

- застройщиков

- развивающийся

- Развитие

- разница

- различный

- КОПАТЬ

- do

- Документация

- не

- Дон

- Dont

- проект

- рисование

- Рано

- легче

- легко

- Эффективный

- затрат

- эффективный

- усилие

- или

- охватывая

- Проект и

- экологически

- Эфир (ETH)

- Даже

- НИКОГДА

- пример

- Excel

- возбужденный

- захватывающий

- существующий

- опыт

- Объяснять

- Объяснимость

- Больше

- Исследование

- факторы

- Ошибка

- Осень

- знакомый

- далеко

- быстрее

- Особенность

- чувства

- меньше

- First

- соответствовать

- припадки

- кувырок

- Что касается

- формат

- формы

- К счастью

- вперед

- Год основания

- Бесплатно

- дружественный

- от

- далее

- фьюзинг

- разрыв

- Genai

- в общем

- порождать

- генерируется

- генерирует

- генеративный

- Генеративный ИИ

- подарок

- данный

- дает

- Отдаете

- Go

- цель

- Графические процессоры

- инструкция

- было

- забивать

- обрабатывать

- Управляемость

- Жесткий

- Есть

- убежище

- сверхмощный

- помощь

- помог

- помощь

- помогает

- очень

- имеет

- надеется,

- Как

- Однако

- HTTPS

- человек

- i

- идеи

- идентифицирующий

- if

- картина

- Влияние

- осуществлять

- реализации

- важную

- важно

- in

- В том числе

- влияющий

- информация

- начальный

- начатый

- вход

- вместо

- намереваться

- в

- вовлеченный

- включает в себя

- с участием

- iOS

- IT

- ЕГО

- саму трезвость

- работа

- всего

- КДнаггетс

- Знать

- известный

- язык

- большой

- крупномасштабный

- в значительной степени

- новее

- ведущий

- УЧИТЬСЯ

- узнали

- изучение

- Оставлять

- Лицензирована

- продолжительность жизни

- такое как

- Вероятно

- Ограниченный

- серия

- машина

- обучение с помощью машины

- Методы машинного обучения

- сделанный

- сделать

- ДЕЛАЕТ

- многих

- массивный

- Совпадение

- математический

- значить

- механизм

- наставниками

- методы

- может быть

- миллионы

- отсутствующий

- смесь

- модель

- моделирование

- Модели

- месяцев

- БОЛЕЕ

- более эффективным

- самых

- перемещение

- много

- должен

- my

- натуральный

- Естественный язык

- Обработка естественного языка

- Необходимость

- потребности

- сетей

- нервный

- нейронные сети

- Новые

- следующий

- север

- Северная Америка

- ноутбук

- сейчас

- нюансы

- номера

- полученный

- of

- on

- ONE

- только

- OpenAI

- оптимизация

- Оптимизировать

- оптимизирующий

- Опции

- or

- Другое

- наши

- внешний

- Результаты

- за

- завышенный

- параметры

- родители

- часть

- особый

- паттеранами

- выполнять

- производительность

- выбирать

- картина

- Новаторская

- Часть

- Платформа

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- Играть

- потенциал

- мощный

- Точно

- предсказывать

- прогнозирования

- Predictions

- интеллектуального

- подготовка

- первичный

- вероятно

- Проблема

- процесс

- обработка

- проектов

- Обещает

- ( изучите наши патенты),

- доказанный

- обеспечивать

- что такое варган?

- публично

- Запросы

- вопрос

- Вопросы

- ассортимент

- РЕДКИЙ

- обоснование

- Читать

- Reading

- причина

- запись

- рафинированный

- отметила

- регуляторы

- Связанный

- Отношения

- относительный

- НЕОДНОКРАТНО

- представляющий

- запросить

- Требования

- исследованиям

- Полезные ресурсы

- Реагируйте

- ответ

- ответы

- ОТДЫХ

- результат

- в результате

- Показывает

- правую

- Роли

- Бег

- s

- сообщили

- поговорка

- Наука

- Ученый

- посмотреть

- казаться

- выберите

- выбор

- Последовательность

- набор

- Короткое

- должен

- показывать

- значение

- значительный

- аналогичный

- просто

- с

- навыки

- So

- Решение

- РЕШАТЬ

- некоторые

- Звук

- звуки

- Источники

- конкретный

- конкретно

- Таблица

- SQL

- этапы

- Начало

- и политические лидеры

- Шаг

- По-прежнему

- сильные

- Структура

- Борющийся

- учился

- изучение

- стиль

- быть успешными

- успешный

- такие

- Убедитесь

- комфортного

- T

- Tackling

- взять

- Сложность задачи

- задачи

- команды

- снижения вреда

- технологии

- текст

- чем

- который

- Ассоциация

- их

- Их

- Эти

- они

- задача

- вещи

- think

- этой

- те

- тысячи

- затянуть

- время

- в

- вместе

- тонна

- Инструментарий

- инструменты

- Темы

- к

- прослеживать

- традиционный

- специалистов

- Обучение

- сделка

- переведите

- Деревья

- стараться

- ОЧЕРЕДЬ

- поворот

- напишите

- зонтик

- под

- понимать

- понимание

- понимать

- объединяющий

- неизвестный

- беспрецедентный

- us

- использование

- прецедент

- используемый

- Информация о пользователе

- пользователей

- использования

- через

- ценностное

- разнообразие

- различный

- Огромная

- видимость

- жизненный

- vs

- хочет

- Путь..

- способы

- we

- веб-сайты

- Недели

- ЧТО Ж

- были

- Что

- Что такое

- когда

- который

- в то время как

- зачем

- широко

- будете

- в

- Word

- слова

- Работа

- работавший

- стоимость

- бы

- еще

- являетесь

- ВАШЕ

- зефирнет