Pe măsură ce inovarea în inteligența artificială (AI) continuă cu ritmul accelerat, 2024 va fi un moment crucial pentru organizații și organismele de conducere pentru a stabili standarde de securitate, protocoale și alte balustrade pentru a împiedica AI să le înainteze, avertizează experții în securitate.

Modelele de limbaj mari (LLM), alimentate de algoritmi sofisticați și seturi masive de date, demonstrează o înțelegere remarcabilă a limbajului și capacități de conversație asemănătoare omului. Una dintre cele mai sofisticate dintre aceste platforme până în prezent este GPT-4 de la OpenAI, care se mândrește cu capacități avansate de raționament și de rezolvare a problemelor și alimentează botul ChatGPT al companiei. Și compania, în parteneriat cu Microsoft, a început să lucreze la GPT-5, ceea ce a spus CEO-ul Sam Altman va merge mult mai departe — până la punctul de a poseda „superinteligență”.

Aceste modele reprezintă un potențial enorm pentru câștiguri semnificative de productivitate și eficiență pentru organizații, dar experții sunt de acord că a venit timpul pentru industrie în ansamblu. pentru a aborda riscurile de securitate inerente puse de dezvoltarea și desfășurarea lor. Într-adevăr, cercetări recente ale Writerbuddy AI, care oferă un instrument de scriere de conținut bazat pe inteligență artificială, a constatat că ChatGPT a avut deja 14 miliarde de vizite și sunt în număr.

Pe măsură ce organizațiile se îndreaptă către progres în AI, acesta „ar trebui să fie cuplat cu considerații etice riguroase și evaluări ale riscurilor”, spune Gal Ringel, CEO al companiei de confidențialitate și securitate bazată pe inteligență artificială MineOS.

Este AI o amenințare existențială?

Preocupările legate de securitatea următoarei generații de inteligență artificială au început să se răspândească în martie, cu o scrisoare deschisă semnată de aproape 34,000 de tehnologi de top care solicita oprirea dezvoltării sistemelor AI generative mai puternice decât GPT-4 al OpenAI. Scrisoarea a citat „riscurile profunde” pentru societate pe care le reprezintă tehnologia și „cursa scăpată de sub control a laboratoarelor de inteligență artificială pentru a dezvolta și implementa minți digitale tot mai puternice pe care nimeni – nici măcar creatorii lor – nu le poate înțelege, prezice sau control fiabil.”

În ciuda acestor temeri distopice, cei mai mulți experți în securitate nu sunt atât de preocupați de un scenariu apocaliptic în care mașinile devin mai inteligente decât oamenii și cuceresc lumea.

„Scrisoarea deschisă a notat preocupări valide cu privire la progresul rapid și la potențialele aplicații ale AI într-un sens larg, „este bine pentru umanitate””, spune Matt Wilson, director de inginerie de vânzări la firma de securitate cibernetică Netrix. „Deși sunt impresionante în anumite scenarii, versiunile publice ale instrumentelor AI nu par atât de amenințătoare.”

Ceea ce este îngrijorător este faptul că progresele și adoptarea AI se mișcă prea repede pentru ca riscurile să fie gestionate corespunzător, notează cercetătorii. „Nu putem pune capacul înapoi pe cutia Pandorei”, observă Patrick Harr, CEO al furnizorului de securitate AI SlashNext.

Mai mult, doar „încercarea de a opri rata de inovare în spațiu nu va ajuta la atenuarea” riscurilor pe care le prezintă, care trebuie abordate separat, observă Marcus Fowler, CEO al firmei de securitate AI DarkTrace Federal. Asta nu înseamnă că dezvoltarea AI ar trebui să continue necontrolată, spune el. Dimpotrivă, rata de evaluare a riscurilor și punerea în aplicare a garanțiilor adecvate ar trebui să se potrivească cu ritmul cu care sunt instruiți și dezvoltati LLM.

„Tehnologia AI evoluează rapid, așa că guvernele și organizațiile care folosesc AI trebuie, de asemenea, să accelereze discuțiile despre siguranța AI”, explică Fowler.

Riscuri AI generative

Există mai multe riscuri larg recunoscute pentru IA generativă care necesită luare în considerare și se vor înrăutăți pe măsură ce generațiile viitoare ale tehnologiei devin mai inteligente. Din fericire pentru oameni, niciunul dintre ei nu prezintă până acum un scenariu de apocalipsă științifico-fantastică în care AI conspiră pentru a-și distruge creatorii.

În schimb, ele includ amenințări mult mai familiare, cum ar fi scurgerile de date, potențiale informații sensibile pentru afaceri; utilizarea abuzivă pentru activitate rău intenționată; și rezultate inexacte care pot induce în eroare sau deruta utilizatorii, ducând în cele din urmă la consecințe negative asupra afacerii.

Deoarece LLM-urile necesită acces la cantități mari de date pentru a oferi rezultate precise și relevante din punct de vedere contextual, informațiile sensibile pot fi dezvăluite sau utilizate greșit din neatenție.

„Riscul principal este că angajații îl hrănesc cu informații sensibile pentru afaceri când îi cereți să scrie un plan sau să reformuleze e-mailurile sau pachetele de afaceri care conțin informațiile deținute ale companiei”, notează Ringel.

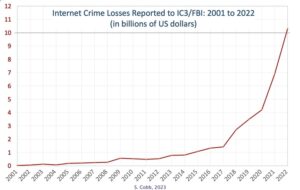

Din perspectiva atacurilor cibernetice, actorii amenințărilor au găsit deja nenumărate modalități de a arma ChatGPT și alte sisteme AI. O modalitate a fost utilizarea modelelor pentru a crea compromisuri sofisticate de e-mail de afaceri (BEC) și alte atacuri de tip phishing, care necesită crearea de mesaje personalizate, concepute social, concepute pentru succes.

„Cu programele malware, ChatGPT le permite infractorilor cibernetici să facă variații infinite de cod pentru a rămâne cu un pas înaintea motoarelor de detectare a malware”, spune Harr.

Halucinațiile AI reprezintă, de asemenea, o amenințare semnificativă pentru securitate și permit actorilor rău intenționați să armeze tehnologia bazată pe LLM, cum ar fi ChatGPT, într-un mod unic. O halucinație AI este un răspuns plauzibil al AI care este insuficient, părtinitor sau total nu este adevărat. „Răspunsurile fictive sau alte răspunsuri nedorite pot conduce organizațiile spre luarea deciziilor, procese și comunicări înșelătoare”, avertizează Avivah Litan, vicepreședinte Gartner.

Actorii amenințărilor pot folosi, de asemenea, aceste halucinații pentru a otrăvi LLM-urile și pentru a „genera dezinformații specifice ca răspuns la o întrebare”, observă Michael Rinehart, vicepreședinte AI la furnizorul de securitate a datelor Securiti. „Acest lucru este extensibil la generarea de cod sursă vulnerabil și, eventual, la modele de chat capabile să direcționeze utilizatorii unui site către acțiuni nesigure.”

Atacatorii pot merge chiar atât de departe încât publica versiuni rău intenționate ale pachetelor software pe care un LLM l-ar putea recomanda unui dezvoltator de software, crezând că este o soluție legitimă pentru o problemă. În acest fel, atacatorii pot arma în continuare AI pentru a organiza atacuri în lanțul de aprovizionare.

Calea înainte

Gestionarea acestor riscuri va necesita acțiuni măsurate și colective înainte ca inovația AI să depășească capacitatea industriei de a o controla, notează experții. Dar au și idei despre cum să rezolve problema AI.

Harr crede într-un „lupta cu AI cu A”, în care „progresele în soluțiile de securitate și strategiile de a contracara riscurile alimentate de AI trebuie să se dezvolte într-un ritm egal sau mai mare.

„Protecția securității cibernetice trebuie să folosească AI pentru a lupta cu succes împotriva amenințărilor cibernetice folosind tehnologia AI”, adaugă el. „În comparație, tehnologia de securitate moștenită nu are nicio șansă împotriva acestor atacuri.”

Cu toate acestea, organizațiile ar trebui, de asemenea, să adopte o abordare măsurată pentru adoptarea AI, inclusiv Soluții de securitate bazate pe inteligență artificială — ca nu cumva să introducă mai multe riscuri în mediul lor, avertizează Wilson de la Netrix.

„Înțelegeți ce este și ce nu este AI”, ne sfătuiește el. „Provocați furnizorii care pretind că folosesc AI pentru a descrie ceea ce face, cum le îmbunătățește soluția și de ce contează asta pentru organizația dumneavoastră.”

Rinehart de la Securiti oferă o abordare pe două niveluri pentru introducerea treptată a AI într-un mediu prin implementarea de soluții concentrate și apoi punerea în aplicare a unor balustrade imediat înainte de a expune organizația la riscuri inutile.

„Mai întâi adoptați modele specifice aplicației, potențial îmbunătățite de baze de cunoștințe, care sunt adaptate pentru a oferi valoare în cazuri de utilizare specifice”, spune el. „Atunci... implementați un sistem de monitorizare pentru a proteja aceste modele prin examinarea mesajelor către și de la ele pentru probleme de confidențialitate și securitate.”

Experții recomandă, de asemenea, să stabiliți politici și proceduri de securitate în jurul AI înainte de a fi implementat, mai degrabă decât ca o idee ulterioară pentru a atenua riscul. Ei pot chiar să înființeze un ofițer de risc AI dedicat sau un grup operativ pentru a supraveghea conformitatea.

În afara întreprinderii, industria în ansamblu trebuie, de asemenea, să ia măsuri pentru a stabili standarde și practici de securitate în jurul AI pe care toți cei care dezvoltă și folosesc tehnologia le pot adopta - ceva care va necesita o acțiune colectivă atât din partea sectorului public, cât și a celui privat la scară globală. , spune Fowler de la DarkTrace Federal.

El citează linii directoare pentru construirea de sisteme AI sigure publicat în colaborare de către Agenția de Securitate Cibernetică și Infrastructură din SUA (CISA) și Centrul Național de Securitate Cibernetică din Marea Britanie (NCSC) ca un exemplu al tipului de eforturi care ar trebui să însoțească evoluția continuă a AI.

„În esență”, spune Rinehart de la Securiti, „anul 2024 va fi martorul unei adaptări rapide atât a securității tradiționale, cât și a tehnicilor de IA de ultimă oră pentru protejarea utilizatorilor și a datelor în această eră emergentă a AI generativă.”

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://www.darkreading.com/vulnerabilities-threats/skynet-ahoy-what-to-expect-next-gen-ai-security-risks

- :are

- :este

- :nu

- $UP

- 000

- 14

- 2024

- a

- capacitate

- Despre Noi

- accelera

- acces

- însoți

- precis

- Acțiune

- acțiuni

- activitate

- actori

- adaptare

- adresa

- adresat

- Adaugă

- adopta

- Adoptarea

- Adoptare

- avansat

- avansare

- progresele

- împotriva

- agenție

- înainte

- AI

- Sisteme AI

- algoritmi

- TOATE

- permite

- deja

- de asemenea

- Sume

- an

- și

- și infrastructură

- apărea

- aplicatii

- abordare

- adecvat

- SUNT

- ARM

- în jurul

- artificial

- inteligență artificială

- Inteligența artificială (AI)

- AS

- solicitând

- evaluare

- evaluări

- At

- Atacuri

- încercarea

- augmented

- înapoi

- Luptă

- BE

- BEC

- deveni

- fost

- înainte

- fiind

- consideră că

- credincios

- părtinitor

- Miliard

- se mândreşte cu

- organisme

- Bot

- atât

- Cutie

- larg

- Clădire

- afaceri

- compromis de e-mail de afaceri

- dar

- by

- denumit

- CAN

- nu poti

- capacități

- capabil

- cazuri

- Măsuri de precauție

- centru

- CEO

- sigur

- lanţ

- contesta

- șansă

- Chat

- Chat GPT

- CISA

- citată

- pretinde

- cod

- Colectiv

- Actiune colectiva

- cum

- Comunicații

- companie

- comparație

- conformitate

- compromis

- îngrijorat

- referitor la

- preocupările

- Consecințele

- considerare

- Considerații

- continua

- a continuat

- continuă

- contrar

- Control

- de conversaţie

- socoteală

- cuplat

- crea

- creaţie

- Creatorii

- crucial

- ultima generație

- Cyber

- securitate cibernetică

- Atac cibernetic

- cybercriminals

- Securitate cibernetică

- Agenția de securitate cibernetică și infrastructură

- de date

- securitatea datelor

- seturi de date

- Data

- Luarea deciziilor

- dedicat

- Cerere

- demonstra

- implementa

- dislocate

- Implementarea

- desfășurarea

- descrie

- proiectat

- distruge

- Detectare

- dezvolta

- dezvoltat

- Dezvoltator

- în curs de dezvoltare

- Dezvoltare

- digital

- călăuzitor

- Director

- discuții

- face

- nu

- don

- judecata de apoi

- distopian

- eficiență

- Eforturile

- e-mailuri

- șmirghel

- de angajați

- permite

- inginerie

- Inginerie

- Motoare

- Îmbunătăţeşte

- enorm

- Afacere

- Mediu inconjurator

- egal

- Eră

- esenţă

- stabili

- Eter (ETH)

- etic

- Chiar

- EVER

- toată lumea

- evoluţie

- evoluție

- exemplu

- existențială

- aștepta

- experți

- explică

- fapt

- familiar

- departe

- defect

- temeri

- federal

- hrănire

- fictiv

- Firmă

- First

- Repara

- complet

- concentrat

- Pentru

- Forţarea

- din fericire

- găsit

- din

- FT

- alimentat

- mai mult

- viitor

- câștig

- FATĂ

- Gartner

- genera

- generaţie

- generații

- generativ

- AI generativă

- obține

- obtinerea

- Caritate

- Scala globala

- Go

- bine

- guvernare

- guvernele

- mai mare

- HAD

- Avea

- he

- ajutor

- Cum

- Cum Pentru a

- HTTPS

- Umanitate

- Oamenii

- idei

- imediat

- punerea în aplicare a

- Punere în aplicare a

- impresionant

- in

- inexact

- neatenție

- include

- Inclusiv

- industrie

- info

- informații

- Infrastructură

- inerent

- Inovaţie

- Inteligență

- în

- introduce

- ISN

- probleme de

- IT

- ESTE

- jpg

- cunoştinţe

- Labs

- limbă

- Scurgeri

- Moştenire

- legitim

- scrisoare

- Pârghie

- ca

- Masini

- Principal

- face

- rău

- malware

- detectarea programelor malware

- gestionate

- Martie

- Marcus

- masiv

- Meci

- mat

- materie

- însemna

- măsurat

- pur și simplu

- mesaje

- Michael

- Microsoft

- ar putea

- mințile

- Dezinformare

- derutant

- folosire greșită

- diminua

- Modele

- Monitorizarea

- mai mult

- cele mai multe

- MOUNT

- în mişcare

- mult

- trebuie sa

- imensitate

- național

- CNSC

- aproape

- nevoilor

- negativ

- următor

- Nu.

- Nici unul

- nota

- notat

- notițe

- observă

- of

- promoții

- Ofiţer

- on

- ONE

- afară

- deschide

- OpenAI

- or

- organizație

- organizații

- Altele

- iesiri

- peste

- supraveghea

- Pace

- Pandora

- Asociere

- patrick

- Personalizat

- perspectivă

- Phishing

- atacuri de phishing

- Loc

- plan

- Platforme

- Plato

- Informații despre date Platon

- PlatoData

- Punct

- otravă

- Politicile

- pozat

- ridică

- eventual

- potenţial

- potenţial

- alimentat

- puternic

- competenţelor

- practicile

- prezice

- cadouri

- preşedinte

- împiedica

- intimitate

- Confidențialitate și securitate

- privat

- sectorul privat

- Problemă

- de rezolvare a problemelor

- Proceduri

- procese

- productivitate

- profund

- Progres

- cum se cuvine

- proprietate

- protecţie

- protocoale

- furniza

- furnizorul

- public

- publicat

- pune

- Punând

- întrebare

- repede

- Rasă

- rapid

- rată

- mai degraba

- recunoscut

- recomanda

- remarcabil

- reformularea

- reprezenta

- reprezintă

- necesita

- cercetare

- cercetători

- răspuns

- răspunsuri

- rezultând

- Dezvăluit

- riguros

- Risc

- evaluare a riscurilor

- Riscurile

- s

- salvgardare

- garanții

- Siguranţă

- Said

- de vânzări

- Sam

- spune

- Scară

- scenariu

- scenarii

- sector

- sigur

- securitate

- politicile de securitate

- riscuri de securitate

- sens

- sensibil

- set

- Seturi

- instalare

- câteva

- să

- semnat

- semnificativ

- teren

- Skynet

- mai inteligent

- So

- până acum

- socialmente

- Societate

- Software

- soluţie

- soluţii

- ceva

- sofisticat

- Spaţiu

- specific

- stand

- standarde

- început

- şedere

- conduce

- Pas

- paşi

- Stop

- strategii

- Strategie

- succes

- Reușit

- astfel de

- Super inteligență

- livra

- lanțului de aprovizionare

- sistem

- sisteme

- T

- adaptate

- Lua

- Sarcină

- Task Force

- tehnici de

- tehnologi

- Tehnologia

- decât

- acea

- Marea Britanie

- lumea

- lor

- Lor

- apoi

- Acestea

- ei

- acest

- aceste

- amenințare

- actori amenințători

- amenințări

- timp

- la

- de asemenea

- instrument

- Unelte

- top

- spre

- tradiţional

- dresat

- adevărat

- tip

- Uk

- în cele din urmă

- înţelege

- înţelegere

- unic

- nedorit

- us

- utilizare

- utilizatorii

- folosind

- valabil

- valoare

- variații

- Fixă

- furnizori

- viciu

- Vicepreședinte

- Vizite

- vulnerabil

- avertizează

- Cale..

- modalități de

- we

- Ce

- cand

- care

- în timp ce

- întreg

- de ce

- pe larg

- voi

- Wilson

- cu

- martor

- Apartamente

- lume

- mai rău

- scrie

- an

- Ta

- zephyrnet