Imagine de autor

Există multe cursuri și resurse disponibile despre învățarea automată și știința datelor, dar foarte puține despre ingineria datelor. Acest lucru ridică câteva întrebări. Este un domeniu dificil? Oferă salariu mic? Nu este considerat la fel de interesant ca și alte roluri tehnologice? Cu toate acestea, realitatea este că multe companii caută în mod activ talent în inginerie de date și oferă salarii substanțiale, uneori depășind 200,000 USD. Inginerii de date joacă un rol crucial ca arhitecți ai platformelor de date, proiectând și construind sistemele fundamentale care permit oamenilor de știință în date și experților în învățarea automată să funcționeze eficient.

Remediind acest decalaj al industriei, DataTalkClub a introdus un bootcamp transformator și gratuit, „Ingineria datelor Zoomcamp„. Acest curs este conceput pentru a împuternici începătorii sau profesioniștii care doresc să schimbe cariera, cu abilități esențiale și experiență practică în ingineria datelor.

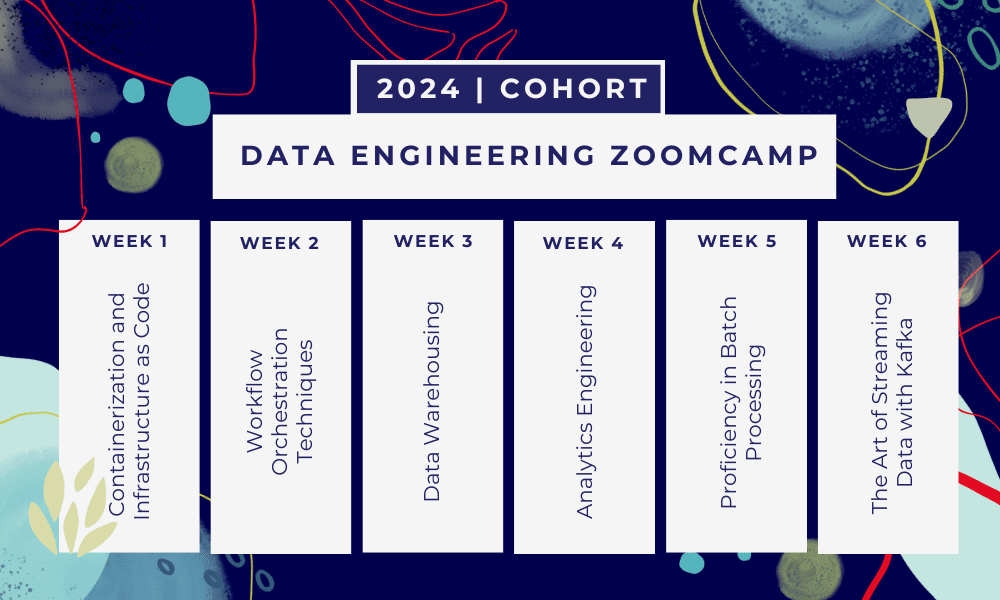

Aceasta este o Bootcamp de 6 săptămâni unde veți învăța prin mai multe cursuri, materiale de lectură, ateliere și proiecte. La sfârșitul fiecărui modul, vi se vor da teme pentru a exersa ceea ce ați învățat.

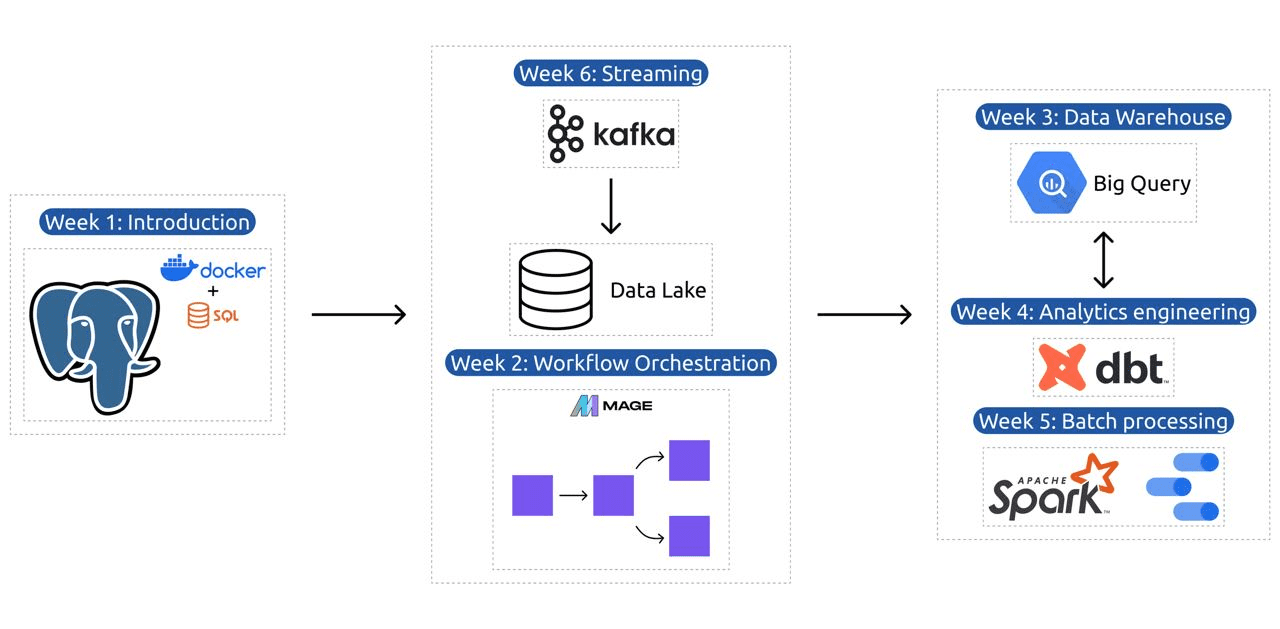

- Săptămâna 1: Introducere în GCP, Docker, Postgres, Terraform și configurarea mediului.

- Săptămâna 2: Orchestrarea fluxului de lucru cu Mage.

- Săptămâna 3: Depozitarea datelor cu BigQuery și învățarea automată cu BigQuery.

- Săptămâna 4: Inginer analitic cu dbt, Google Data Studio și Metabase.

- Săptămâna 5: Procesare lot cu Spark.

- Săptămâna 6: Streaming cu Kafka.

Imagine de la DataTalksClub/data-engineering-zoomcamp

Programa conține 6 module, 2 ateliere și un proiect care acoperă tot ceea ce este necesar pentru a deveni un inginer profesionist de date.

Modulul 1: Stăpânirea containerizării și a infrastructurii ca cod

În acest modul, veți afla despre Docker și Postgres, începând cu elementele de bază și avansând prin tutoriale detaliate despre crearea conductelor de date, rularea Postgres cu Docker și multe altele.

Modulul acoperă, de asemenea, instrumente esențiale precum pgAdmin, Docker-compose și subiecte de reîmprospătare SQL, cu conținut opțional despre rețeaua Docker și o prezentare specială pentru utilizatorii Linux subsistemului Windows. În final, cursul vă prezintă GCP și Terraform, oferind o înțelegere holistică a containerizării și infrastructurii ca cod, esențial pentru mediile moderne bazate pe cloud.

Modulul 2: Tehnici de orchestrare a fluxului de lucru

Modulul oferă o explorare aprofundată a Mage, un cadru hibrid inovator open-source pentru transformarea și integrarea datelor. Acest modul începe cu elementele de bază ale orchestrarii fluxului de lucru, trecând la exerciții practice cu Mage, inclusiv configurarea acestuia prin Docker și construirea conductelor ETL de la API la Postgres și Google Cloud Storage (GCS), apoi în BigQuery.

Combinația de videoclipuri, resurse și sarcini practice din modulul asigură o experiență de învățare cuprinzătoare, echipând cursanții cu abilitățile de a gestiona fluxuri de lucru sofisticate de date folosind Mage.

Atelierul 1: Strategii de absorbție a datelor

În primul atelier, veți stăpâni construirea unor conducte eficiente de asimilare a datelor. Atelierul se concentrează pe abilități esențiale, cum ar fi extragerea datelor din API-uri și fișiere, normalizarea și încărcarea datelor și tehnicile de încărcare incrementală. După finalizarea acestui atelier, veți putea crea conducte eficiente de date ca un inginer de date senior.

Modulul 3: Depozitarea datelor

Modulul este o explorare aprofundată a stocării și analizei datelor, concentrându-se pe depozitarea datelor folosind BigQuery. Acesta acoperă concepte-cheie, cum ar fi partiționarea și gruparea, și analizează cele mai bune practici BigQuery. Modulul progresează în subiecte avansate, în special integrarea Machine Learning (ML) cu BigQuery, evidențiind utilizarea SQL pentru ML și oferind resurse pentru reglarea hiperparametrilor, preprocesarea caracteristicilor și implementarea modelului.

Modulul 4: Inginerie analitică

Modulul de inginerie de analiză se concentrează pe construirea unui proiect utilizând dbt (Instrument de generare a datelor) cu un depozit de date existent, fie BigQuery, fie PostgreSQL.

Modulul acoperă configurarea dbt în medii cloud și locale, introducând concepte de inginerie analitică, ETL vs ELT și modelarea datelor. De asemenea, acoperă funcții avansate dbt, cum ar fi modele incrementale, etichete, cârlige și instantanee.

În cele din urmă, modulul introduce tehnici de vizualizare a datelor transformate folosind instrumente precum Google Data Studio și Metabase și oferă resurse pentru depanarea și încărcarea eficientă a datelor.

Modulul 5: Competență în procesarea în loturi

Acest modul acoperă procesarea loturilor folosind Apache Spark, începând cu introduceri în procesarea în lot și Spark, împreună cu instrucțiuni de instalare pentru Windows, Linux și MacOS.

Include explorarea Spark SQL și DataFrames, pregătirea datelor, efectuarea de operațiuni SQL și înțelegerea elementelor interne Spark. În cele din urmă, se încheie cu rularea Spark în cloud și integrarea Spark cu BigQuery.

Modulul 6: Arta transmiterii în flux a datelor cu Kafka

Modulul începe cu o introducere în conceptele de procesare a fluxului, urmată de o explorare aprofundată a Kafka, inclusiv elementele fundamentale ale acestuia, integrarea cu Confluent Cloud și aplicațiile practice care implică producători și consumatori.

Modulul acoperă, de asemenea, configurația și fluxurile Kafka, abordând subiecte precum îmbinări, testare, ferestre și utilizarea Kafka ksqldb & Connect. În plus, își extinde atenția asupra mediilor Python și JVM, prezentând Faust pentru procesarea fluxului Python, Pyspark – Structured Streaming și exemple Scala pentru Kafka Streams.

Atelierul 2: Procesarea fluxului cu SQL

Veți învăța să procesați și să gestionați datele în flux cu RisingWave, care oferă o soluție eficientă din punct de vedere al costurilor cu o experiență în stil PostgreSQL pentru a vă împuternici aplicațiile de procesare a fluxului.

Proiect: Aplicație de inginerie a datelor din lumea reală

Obiectivul acestui proiect este de a implementa toate conceptele pe care le-am învățat în acest curs pentru a construi o conductă de date end-to-end. Veți crea pentru a crea un tablou de bord format din două plăci prin selectarea unui set de date, construirea unei conducte pentru procesarea datelor și stocarea lor într-un lac de date, construirea unei conducte pentru transferul datelor procesate de la lacul de date într-un depozit de date, transformarea datele din depozitul de date și pregătirea lor pentru tabloul de bord și, în final, construirea unui tablou de bord pentru a prezenta datele vizual.

Detalii Cohorta 2024

- Înregistrare: Inscrie-te acum

- Data începerii: 15 ianuarie 2024, ora 17:00 CET

- Învățare în ritm propriu cu sprijin ghidat

- Dosarul de cohortă cu teme și termene limită

- Interactiv Comunitatea Slack pentru învăţarea de la egal la egal

Cerințe preliminare

- Abilități de bază de codare și linie de comandă

- Fundație în SQL

- Python: benefic, dar nu obligatoriu

Instructori experți care vă conduc călătoria

- Ankush Khanna

- Victoria Perez Mola

- Alexei Grigorev

- Matt Palmer

- luis oliveira

- Michael Cizmar

Alăturați-vă cohortei noastre din 2024 și începeți să învățați cu o comunitate uimitoare de inginerie a datelor. Cu instruire condusă de experți, experiență practică și un curriculum adaptat nevoilor industriei, acest bootcamp nu numai că vă echipează cu abilitățile necesare, ci vă poziționează și în fruntea unei cariere profitabile și solicitate. Înscrie-te astăzi și transformă-ți aspirațiile în realitate!

Abid Ali Awan (@ 1abidaliawan) este un profesionist certificat în domeniul științei datelor, căruia îi place să construiască modele de învățare automată. În prezent, se concentrează pe crearea de conținut și pe scrierea de bloguri tehnice despre învățarea automată și tehnologiile științei datelor. Abid deține o diplomă de master în managementul tehnologiei și o diplomă de licență în ingineria telecomunicațiilor. Viziunea lui este de a construi un produs AI folosind o rețea neuronală grafică pentru studenții care se luptă cu boli mintale.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://www.kdnuggets.com/the-only-free-course-you-need-to-become-a-professional-data-engineer?utm_source=rss&utm_medium=rss&utm_campaign=the-only-free-course-you-need-to-become-a-professional-data-engineer

- :are

- :este

- :nu

- :Unde

- $UP

- 000

- 1

- 15%

- 17

- 2024

- a

- Capabil

- Despre Noi

- activ

- În plus,

- adresare

- avansat

- înaintând

- După

- AI

- TOATE

- de-a lungul

- de asemenea

- uimitor

- an

- analiză

- Analitic

- Google Analytics

- și

- și infrastructură

- Apache

- Apache Spark

- api

- API-uri

- aplicatii

- arhitecți

- SUNT

- Artă

- AS

- At

- disponibil

- Noțiuni de bază

- BE

- deveni

- devenire

- începători

- benefică

- CEL MAI BUN

- Cele mai bune practici

- BigQuery

- Amesteca

- bloguri

- atât

- construi

- Clădire

- dar

- by

- Carieră

- cariere

- Certificate

- Cloud

- Stocare in cloud

- clustering

- cod

- Codificare

- Cohortă

- comunitate

- Companii

- completarea

- cuprinzător

- Concepte

- conchide

- Configuraţie

- joncțiune

- Conectați

- luate în considerare

- Constând

- construi

- Consumatorii

- conține

- conţinut

- crearea de continut

- înscrie-te la cursul

- cursuri

- acoperă

- crea

- Crearea

- creaţie

- crucial

- În prezent

- Curriculum

- tablou de bord

- de date

- inginer de date

- Lacul de date

- știința datelor

- om de știință de date

- stocare a datelor

- depozit de date

- Data

- Grad

- desfășurarea

- proiectat

- proiect

- detaliat

- dificil

- Docher

- fiecare

- în mod eficient

- eficient

- oricare

- împuternici

- permite

- capăt

- un capăt la altul

- inginer

- Inginerie

- inginerii

- înscrie

- asigură

- Mediu inconjurator

- medii

- esenţial

- Eter (ETH)

- tot

- exemple

- captivant

- existent

- experienţă

- experți

- explorare

- Explorarea

- extinde

- Caracteristică

- DESCRIERE

- Dispunând

- puțini

- camp

- Fişiere

- În cele din urmă

- First

- Concentra

- se concentrează

- concentrându-se

- a urmat

- Pentru

- frunte

- foundational

- Cadru

- Gratuit

- din

- funcţie

- Fundamentele

- decalaj

- BPSC

- dat

- Google Cloud

- grafic

- Rețeaua neuronală grafică

- ghidate

- hands-on

- Avea

- he

- subliniind

- lui

- deține

- holistică

- teme pentru acasă

- cârlige

- Totuși

- HTTPS

- Hibrid

- Reglarea hiperparametrului

- boală

- punerea în aplicare a

- in

- în profunzime

- include

- Inclusiv

- incrementală

- industrie

- Infrastructură

- inovatoare

- instalare

- instrucțiuni

- integrarea

- integrare

- în

- introdus

- Prezintă

- introducerea

- Introducere

- Prezentarea

- implicând

- IT

- ESTE

- ianuarie

- Se alătură

- Kafka

- KDnuggets

- Cheie

- lac

- conducere

- AFLAȚI

- învățat

- elevi

- învăţare

- ca

- Linie

- linux

- încărcare

- local

- cautati

- iubeste

- Jos

- lucrativ

- maşină

- masina de învățare

- MacOS

- administra

- administrare

- obligatoriu

- multe

- maestru

- Stăpânirea

- Materiale

- mental

- Boală mintală

- ML

- model

- modelare

- Modele

- Modern

- modul

- Module

- mai mult

- multiplu

- necesar

- Nevoie

- necesar

- nevoilor

- reţea

- rețele

- neural

- rețele neuronale

- obiectiv

- of

- oferind

- promoții

- on

- afară

- open-source

- Operațiuni

- or

- orchestrație

- Altele

- al nostru

- Hagiu

- în special

- cale

- Plătește

- egal

- efectuarea

- conducte

- Platforme

- Plato

- Informații despre date Platon

- PlatoData

- Joaca

- poziţii

- postgresql

- Practic

- Aplicații practice

- practică

- practicile

- pregătirea

- prezenta

- proces

- prelucrate

- prelucrare

- Producătorii

- Produs

- profesional

- profesioniști

- progresează

- proiect

- Proiecte

- furnizează

- furnizarea

- Piton

- Întrebări

- ridică

- Citind

- lumea reală

- Realitate

- Resurse

- Rol

- rolurile

- funcţionare

- s

- salarii

- Scala

- Ştiinţă

- Om de stiinta

- oamenii de stiinta

- caută

- selectarea

- senior

- instalare

- configurarea

- aptitudini

- moale

- soluţie

- unele

- uneori

- sofisticat

- Scânteie

- special

- SQL

- Începe

- Pornire

- depozitare

- curent

- de streaming

- fluxuri

- structurat

- Incercand

- Elevi

- studio

- substanțial

- astfel de

- a sustine

- Intrerupator

- sisteme

- adaptate

- TRAINERI

- sarcini

- tech

- Tehnic

- tehnici de

- Tehnologii

- Tehnologia

- telecomunicaţie

- Terraform

- Testarea

- acea

- Noțiuni de bază

- apoi

- acest

- Prin

- la

- astăzi

- instrument

- Unelte

- subiecte

- Pregătire

- transferare

- Transforma

- Transformare

- transformativă

- transformat

- transformare

- tutoriale

- Două

- înţelegere

- USD

- utilizare

- utilizatorii

- folosind

- Ve

- foarte

- de

- Video

- viziune

- vizual

- vs

- Depozit

- depozitare

- we

- Ce

- care

- OMS

- voi

- ferestre

- cu

- flux de lucru

- fluxuri de lucru

- atelier

- Ateliere

- scris

- tu

- Ta

- zephyrnet