Suresh este un director de tehnologie cu expertiză tehnică profundă în semiconductori, inteligență artificială, securitate cibernetică, internet-ul lucrurilor, hardware, software etc. dezvoltarea de cipuri de încredere la Technology Innovation Institute, Abu Dhabi și în alte companii de semiconductori din Fortune 20, cum ar fi Intel, Qualcomm și MediaTek, în diferite roluri de conducere, unde a cercetat și dezvoltat înaltă performanță, eficiență energetică, post-cuantică sigură, sigură. microcipuri/system-on-cip-uri (SoC)/acceleratoare pentru piețele Datacenter, Client, Smartphone, Networking, IoT și AI/ML. El a contribuit la Falcon LLM (clasat pe locul 500 în huggingface) și a fost arhitectul principal pentru platforma hardware personalizată AI (anulată – prioritățile schimbate). El deține peste 1 brevete din SUA și a publicat/prezentat la peste 15 de conferințe.

Suresh este un director de tehnologie cu expertiză tehnică profundă în semiconductori, inteligență artificială, securitate cibernetică, internet-ul lucrurilor, hardware, software etc. dezvoltarea de cipuri de încredere la Technology Innovation Institute, Abu Dhabi și în alte companii de semiconductori din Fortune 20, cum ar fi Intel, Qualcomm și MediaTek, în diferite roluri de conducere, unde a cercetat și dezvoltat înaltă performanță, eficiență energetică, post-cuantică sigură, sigură. microcipuri/system-on-cip-uri (SoC)/acceleratoare pentru piețele Datacenter, Client, Smartphone, Networking, IoT și AI/ML. El a contribuit la Falcon LLM (clasat pe locul 500 în huggingface) și a fost arhitectul principal pentru platforma hardware personalizată AI (anulată – prioritățile schimbate). El deține peste 1 brevete din SUA și a publicat/prezentat la peste 15 de conferințe.

De asemenea, Suresh ocupă o poziție de conducere la RISC-V International, unde conduce Trusted Computing Group pentru a dezvolta capacitatea de calcul confidențial RISC-V și conduce grupul AI/ML pentru a dezvolta accelerarea hardware RISC-V pentru sarcinile de lucru AI/ML, cum ar fi Transformer Large Language Modele utilizate în aplicațiile de tip ChatGPT. De asemenea, consiliază startup-urile și firmele de capital de risc cu privire la sprijinul pentru deciziile de investiții, strategia de produs, due diligence tehnologice etc.

El a obținut un MBA de la INSEAD, un MS de la Birla Institute of Technology & Science Pilani, un certificat de inginerie a sistemelor de la MIT, un certificat AI de la Stanford și un certificat de siguranță funcțională auto de la TÜV SÜD.

Spune-ne despre compania ta

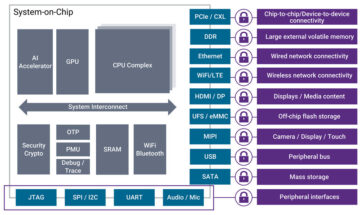

Mastiṣka AI” (Mastiṣka înseamnă creier în sanscrită) este o companie de inteligență artificială axată pe construirea de computere asemănătoare creierului pentru a rula modele de bază mai eficient pentru cazurile de utilizare a IA generativă de mâine.

Ce probleme rezolvi?

Având în vedere beneficiile AI/GenAI, cererea sa este obligată să crească, la fel și efectele sale secundare asupra planetei noastre. Cum putem reduce sau neutraliza efectele secundare ale AI pe planeta noastră? Captarea carbonului și energia nucleară sunt în direcția bună. Dar trebuie să regândim fundamental modul în care facem IA, este modul greșit de a face tone de înmulțiri de matrice?

Creierul nostru poate învăța și face multe sarcini în paralel, în și sub 10 W, dar de ce aceste sisteme AI consumă 10 de megawați pentru a antrena modele?

Poate că viitorul deține arhitecturi eficiente din punct de vedere energetic, cum ar fi arhitecturile neuromorfe și transformatoarele bazate pe rețele neuronale care sunt cele mai aproape de creierul uman, care ar putea consuma de 100-1000 de ori mai puțină energie, reducând astfel costul utilizării AI, democratându-l și salvându-ne astfel. planetă.

Provocările actuale cu care ne confruntăm cu AI și anume a) disponibilitatea, b) accesibilitatea, c) accesibilitatea și d) siguranța mediului, împreună cu câteva recomandări pentru a le aborda.

Dacă prevedem în viitor, câteva concepte utile AGI sunt demonstrate în filmul „HER”, în care personajul „Samantha” – un agent conversațional care este natural, înțelege emoțiile, dă dovadă de empatie, este un copilot uimitor la locul de muncă – și rulează mai departe. dispozitive portabile pe tot parcursul zilei, atunci s-ar putea să fie nevoiți să rezolvăm provocările de mai jos chiar acum.

Problema 1: Formarea unui LLM poate costa oriunde de la 150 la peste 10 milioane de dolari și le permite doar celor cu buzunare mai adânci să dezvolte AI. În plus, costurile de inferență sunt și ele uriașe (cost de 10 ori mai mult decât o căutare pe web)

—> Trebuie să îmbunătățim eficiența energetică a modelelor/hardware-ului pentru a democratiza AI în beneficiul umanității.

Problema 2: Rularea unor modele AI uriașe pentru agenți conversaționali sau sisteme de recomandare afectează mediul în ceea ce privește consumul de energie electrică și răcire.

—> Trebuie să îmbunătățim eficiența energetică a modelelor/hardware-ului pentru a ne salva planeta pentru copiii noștri.

Problema 3: Creierul uman este capabil și poate face mai multe sarcini, dar consumă doar 10 wați în loc de megawați.

—> Poate că ar trebui să construim mai repede mașini precum creierul nostru și nu multiplicatorii obișnuiți de matrice.

Omenirea poate prospera doar cu inovații durabile, și nu prin tăierea tuturor pădurilor și fierberea oceanelor în numele inovației. Trebuie să ne protejăm planeta pentru bunăstarea copiilor noștri și a generațiilor viitoare…

Ce domenii de aplicare sunt cele mai puternice ale tale?

Instruire și deducere a modelelor de fundație bazate pe Transformer (și viitoarea arhitectură neuronală), la o energie de 50-100 ori mai eficientă în comparație cu soluțiile bazate pe GPU de astăzi.

Ce vă ține clienții treji noaptea?

Probleme pentru clienții care folosesc în prezent alte produse:

Consumul de energie electrică pentru antrenarea modelelor de limbă uriașă depășește limitele, de exemplu, antrenarea unui LLM cu parametri 13B pe jetoane text de 390B pe 200 de GPU-uri timp de 7 zile costă 151,744 USD (Sursa: noua pagină de servicii de grup de instruire HuggingFace - https://lnkd.in/g6Vc5cz3). Și chiar și modelele mai mari cu 100+ parametri B costă 10+ milioane USD doar pentru antrenament. Apoi plătiți pentru deducere de fiecare dată când sosește o nouă solicitare promptă.

Consumul de apă pentru răcire, cercetătorii de la Universitatea din California, Riverside au estimat impactul asupra mediului al serviciului de tip ChatGPT și spun că înghite 500 de mililitri de apă (aproape de ceea ce se află într-o sticlă de apă de 16 uncii) de fiecare dată când îi întrebi un serie de între 5 și 50 de solicitări sau întrebări. Gama variază în funcție de locul în care se află serverele sale și de sezon. Estimarea include utilizarea indirectă a apei pe care companiile nu o măsoară - cum ar fi pentru răcirea centralelor electrice care alimentează centrele de date cu energie electrică. (Sursă: https://lnkd.in/gybcxX8C)

Probleme pentru non-clienții produselor curente:

Nu își pot permite CAPEX să cumpere hardware

Nu își permit să folosească serviciile cloud

Nu pot inova sau folosi inteligența artificială - blocat cu un model de servicii care elimină orice avantaj competitiv

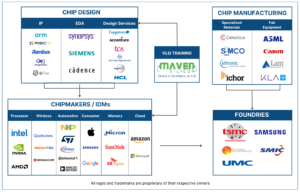

Cum arată peisajul competitiv și cum te diferențiezi?

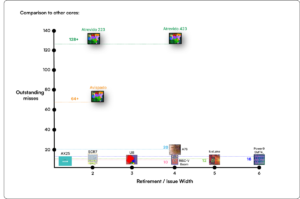

- GPU-urile domină spațiul de antrenament, deși ASIC-urile specializate concurează și ele în acest segment

- Inferența Cloud & Edge are prea multe opțiuni disponibile

Digital, analogic, fotonic - cum spuneți că oamenii încearcă să abordeze aceeași problemă.

Puteți să vă împărtășiți părerile despre starea actuală a arhitecturii chip pentru AI/ML, adică care vedeți ca fiind cele mai semnificative tendințe și oportunități în acest moment?

Următoarele tendințe:

Tendința 1: În urmă cu 10 ani, învățarea profundă activată de hardware a înflorit, iar acum același hardware inhibă progresul. Datorită costului uriaș al hardware-ului și costurilor cu electricitatea pentru a rula modele, a devenit o provocare să accesați hardware-ul. Doar companiile cu buzunare adânci își pot permite acestea și devin monopoluri.

Tendința 2: Acum, că aceste modele sunt acolo, trebuie să le folosim în scopuri practice, astfel încât sarcina de inferență să crească, permițând procesoarelor cu acceleratoare AI să vină din nou în lumina reflectoarelor.

Tendința 3: Startup-urile încearcă să vină cu reprezentări alternative ale numerelor în virgulă mobilă, conform cărora formatul tradițional IEEE – cum ar fi logaritmul și bazat pe poziții – sunt bune, dar nu suficiente. Optimizarea spațiului de proiectare PPA$ explodează atunci când încercăm să optimizăm unul și altul merge la aruncare.

Tendința 4: Industria se îndepărtează de la modelul AI bazat pe servicii pentru a găzdui propriile modele private în propriile sale sedii – dar accesul la hardware este o provocare din cauza penuriei de aprovizionare, a sancțiunilor etc.

Starea actuală a lucrurilor:

Disponibilitatea hardware-ului și a datelor a alimentat creșterea inteligenței artificiale în urmă cu 10 ani, acum același hardware o inhibă într-un fel - permiteți-mi să vă explic

De când CPU-urile mergeau mizerabil și GPU-urile au fost reutilizate pentru a face AI, s-au întâmplat multe lucruri

Companiile au abordat 4 segmente ale AI/ML și anume – 1) instruire în cloud, 2) inferență în cloud, 3) deducere marginală și 4) formare în margine (învățare federată pentru aplicații sensibile la confidențialitate).

Digital & Analogic

Partea de instruire – o multitudine de companii care fac GPU-uri, acceleratoare pentru clienți bazate pe RISC-V, cipuri la scară wafer (850K nuclee) și așa mai departe, acolo unde procesoarele tradiționale lipsesc (scopul lor general). Partea inferenței – Acceleratoarele NN sunt disponibile de la fiecare producător, în smartphone-uri, laptopuri și alte dispozitive de vârf.

Arhitecturile analogice bazate pe memristor au apărut, de asemenea, cu ceva timp în urmă.

Credem că procesoarele pot fi foarte bune la deducere dacă o îmbunătățim cu accelerare, cum ar fi extensiile matriceale

Partea RISC-V a lucrurilor:

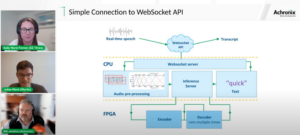

În ceea ce privește RISC-V, dezvoltăm acceleratoare pentru operațiuni cu matrice și alte operațiuni neliniare pentru a elimina posibilele blocaje pentru sarcinile de lucru ale transformatorului. Blocajele Von Neumann sunt, de asemenea, abordate prin arhitectura de amintiri mai apropiate de calcul, făcând în cele din urmă procesoarele cu accelerare AI alegerea potrivită pentru inferență.

Oportunități:

Există oportunități unice de a completa piața modelelor de fundații. Exemplu – OpenAI a menționat că nu au reușit să asigure suficient calcul AI (GPU) pentru a continua să-și impulsioneze serviciile ChatGPT... iar știrile spun despre costurile cu electricitatea de 10 ori mai mari decât cele ale căutării obișnuite pe internet și 500 ml de apă pentru a răci sistemele pentru fiecare interogare. Există o piață de completat aici - nu este o nișă, ci este întreaga piață care va democratiza AI abordând toate provocările menționate mai sus - a) disponibilitate, b) accesibilitate, c) accesibilitate și d) siguranța mediului.

La ce funcții/tehnologii noi lucrați?

Construim creier ca un computer, utilizând tehnici neuromodrfice și adaptăm modele pentru a profita de hardware-ul eficient din punct de vedere energetic, reutilizand mai multe cadre deschise disponibile

Cum vă imaginați ca sectorul AI/ML să crească sau să se schimbe în următoarele 12-18 luni?

Pe măsură ce cererea de GPU-uri a scăzut (costând 30 USD), iar unele părți ale lumii se confruntă cu sancțiuni pentru cumpărarea acestor GPU-uri, unele părți ale lumii simt că sunt înghețate în cercetarea și dezvoltarea AI fără acces la GPU-uri. Platformele hardware alternative vor cuceri piața.

Poate că modelele vor începe să se micșoreze – modelele personalizate sau chiar, în principiu, densitatea informațiilor ar crește

Aceeași întrebare, dar cum rămâne cu creșterea și schimbarea în următorii 3-5 ani?

a) CPU-urile cu extensii AI ar captura piața de inferență AI

b) Modelele ar deveni agile, iar parametrii vor scădea pe măsură ce densitatea informațiilor se îmbunătățește de la 16% la 90%

c) Eficiența energetică se îmbunătățește, amprenta de CO2 se reduce

d) Apar noi arhitecturi

e) costurile cu hardware-ul și costurile cu energia scad, astfel încât bariera de intrare pentru companiile mai mici de a crea și antrena modele devine accesibilă

f) oamenii vorbesc despre momentul pre-AGI, dar punctul meu de referință ar fi personajul Samantha (IA conversațională) din filmul „ea”.. asta poate puțin probabil, având în vedere costul ridicat al extinderii.

Care sunt unele dintre provocările care ar putea afecta sau limita creșterea sectorului AI/ML?

a) Accesul la hardware

b) Costurile energiei și costurile de răcire și daune mediului

Citeste si:

Interviu CEO: David Moore de la Pragmatic

Interviu CEO: Dr. Meghali Chopra de la Sandbox Semiconductor

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://semiwiki.com/ceo-interviews/338703-ceo-interview-suresh-sugumar-of-mastiska-ai/

- :are

- :este

- :nu

- :Unde

- $UP

- 1

- 10

- 150

- 20

- ani 20

- 200

- 50

- 500

- 7

- a

- Capabil

- Despre Noi

- mai sus

- Abu Dhabi

- accelerare

- acceleratoare

- acces

- accesibilitate

- activ

- adresa

- adresat

- adresare

- Avantaj

- afaceri

- din nou

- Agent

- agenţi

- AGI

- în urmă

- AI

- Modele AI

- cercetare ai

- Sisteme AI

- ai cazuri de utilizare

- AI / ML

- aliniat

- TOATE

- Permiterea

- permite

- de-a lungul

- de asemenea

- alternativă

- uimitor

- an

- și

- O alta

- Orice

- oriunde

- aplicație

- aplicatii

- arhitectură

- SUNT

- domenii

- soseşte

- artificial

- inteligență artificială

- AS

- Asics

- cere

- At

- auto

- disponibilitate

- disponibil

- departe

- b

- barieră

- bazat

- BE

- deveni

- devine

- devenire

- fost

- fiind

- Crede

- de mai jos

- Benchmark

- beneficia

- Beneficiile

- între

- Dincolo de

- blocaje

- legat

- Creier

- creier

- construi

- Clădire

- dar

- cumpăra

- by

- California

- CAN

- anulat

- capacitate

- capabil

- capital

- captura

- carbon

- captarea carbonului

- cazuri

- Centre

- CEO

- Interviu CEO

- certificat

- contesta

- provocări

- Schimbare

- si-a schimbat hainele;

- schimbarea

- caracter

- Chat GPT

- Copii

- cip

- Chips

- alegere

- Chopra

- client

- Închide

- mai aproape

- Cloud

- Grup

- co2

- cum

- Companii

- companie

- comparație

- concura

- competitiv

- Calcula

- calculator

- Calculatoare

- tehnica de calcul

- Concepte

- conferințe

- consuma

- consum

- continua

- Contribuit

- de conversaţie

- AI de conversație

- Rece

- A costat

- Cheltuieli

- ar putea

- crea

- Curent

- Starea curenta

- În prezent

- personalizat

- client

- clienţii care

- tăiere

- Securitate cibernetică

- de date

- centre de date

- Datacenter

- David

- zi

- Zi

- decizie

- adânc

- învățare profundă

- Mai adânc

- Cerere

- democratiza

- democratizarea

- demonstrat

- densitate

- În funcție

- Amenajări

- dezvolta

- dezvoltat

- în curs de dezvoltare

- Dezvoltare

- Dispozitive

- Dhabi

- distinge

- diligență

- direcţie

- Director

- do

- face

- face

- de dolari

- Dont

- jos

- dr

- Picătură

- două

- câștigat

- Margine

- efecte

- eficiență

- eficient

- eficient

- electricitate

- consumul de energie electrică

- elimina

- elimină

- emotii

- Empatia

- energie

- eficiența energetică

- Inginerie

- spori

- suficient de

- Întreg

- intrare

- Mediu inconjurator

- de mediu

- imagina

- estima

- estimativ

- etc

- Eter (ETH)

- Chiar

- în cele din urmă

- Fiecare

- exemplu

- executiv

- Director Executiv

- exista

- expertiză

- explodeaza

- extensii

- Față

- cu care se confruntă

- şoim

- mai repede

- senzaţie

- umple

- firme

- plutitor

- concentrat

- Picior

- Pentru

- prevedea

- format

- Avere

- Fundație

- cadre

- din

- congelate

- alimentat

- funcțional

- fundamental

- viitor

- General

- generații

- generativ

- AI generativă

- dat

- Go

- Merge

- merge

- bine

- unități de procesare grafică

- grup

- În creştere

- Creștere

- Piese metalice

- Avea

- he

- prin urmare

- aici

- Înalt

- deține

- găzduire

- Cum

- HTTPS

- mare

- Față îmbrățișată

- uman

- Umanitate

- IEEE

- if

- imagine

- Impactul

- îmbunătăţi

- îmbunătăţeşte

- in

- În altele

- include

- Crește

- industrie

- informații

- inova

- Inovaţie

- inovații

- in schimb

- Institut

- Intel

- Inteligență

- Internațional

- Internet

- Interviu

- investiţie

- IoT

- IT

- ESTE

- doar

- copii

- Copil

- lipsă

- peisaj

- limbă

- laptop-uri

- mare

- mai mare

- conduce

- Conducere

- AFLAȚI

- învăţare

- lăsa

- Pârghie

- efectului de pârghie

- ca

- lumină reflectorului

- LIMITĂ

- încărca

- situat

- Uite

- arată ca

- LOWER

- Masini

- Efectuarea

- Producător

- multe

- Piață

- pieţe

- Matrice

- max-width

- Mai..

- poate

- MBA

- me

- sens

- mijloace

- măsura

- Amintiri

- menționat

- ar putea

- milion

- un milion de dolari

- MIT

- model

- Modele

- moment

- monopoluri

- luni

- mai mult

- cele mai multe

- film

- în mişcare

- MS

- trebuie sa

- my

- nume

- și anume

- Natural

- Nevoie

- bazat pe rețea

- rețele

- neural

- Nou

- ştiri

- următor

- nișă

- noapte

- agil

- acum

- nuclear

- Energie nucleara

- număr

- oceane

- of

- on

- ONE

- afară

- deschide

- open-source

- OpenAI

- Operațiuni

- Oportunităţi

- optimizare

- Optimizați

- Opţiuni

- or

- Altele

- al nostru

- afară

- propriu

- pagină

- Paralel

- parametru

- parametrii

- piese

- Brevete de inventie

- Plătește

- oameni

- poate

- planetă

- plante

- platformă

- Platforme

- Plato

- Informații despre date Platon

- PlatoData

- pletoră

- la care se adauga

- buzunare

- Punct

- poziţie

- posibil

- putere

- centrale electrice

- Practic

- privat

- Problemă

- probleme

- Produs

- Produse

- Profil

- Progres

- solicitări

- proteja

- scop

- scopuri

- Împinge

- puts

- Qualcomm

- întrebare

- Întrebări

- gamă

- clasat

- Citeste

- recent

- Recomandare

- Recomandări

- reduce

- reducerea

- regulat

- Rapoarte

- solicita

- cercetare

- cercetare și dezvoltare

- cercetători

- dreapta

- Riverside

- rolurile

- acoperiş

- Alerga

- funcţionare

- ruleaza

- sigur

- Siguranţă

- acelaşi

- sancţiuni

- nisip

- Economisiți

- economisire

- Spune

- scalare

- Ştiinţă

- Caută

- Sezon

- sector

- sigur

- vedea

- segmente

- semiconductor

- Semiconductori

- serie

- servere

- serviciu

- Servicii

- servire

- Distribuie

- penuriei

- să

- a arătat

- Emisiuni

- parte

- semnificativ

- întrucât

- mai mici

- smartphone

- smartphone-uri

- So

- Software

- soluţii

- Rezolvarea

- unele

- Sursă

- Spaţiu

- de specialitate

- uzat

- stanford

- Începe

- Startup-urile

- Stat

- Strategie

- mai puternic

- astfel de

- livra

- a sustine

- durabilă

- sisteme

- aborda

- tackling

- croitorie

- Lua

- Vorbi

- sarcini

- Tehnic

- Tehnologia

- inovația tehnologică

- termeni

- a) Sport and Nutrition Awareness Day in Manasia Around XNUMX people from the rural commune Manasia have participated in a sports and healthy nutrition oriented activity in one of the community’s sports ready yards. This activity was meant to gather, mainly, middle-aged people from a Romanian rural community and teach them about the benefits that sports have on both their mental and physical health and on how sporting activities can be used to bring people from a community closer together. Three trainers were made available for this event, so that the participants would get the best possible experience physically and so that they could have the best access possible to correct information and good sports/nutrition practices. b) Sports Awareness Day in Poiana Țapului A group of young participants have taken part in sporting activities meant to teach them about sporting conduct, fairplay, and safe physical activities. The day culminated with a football match.

- decât

- acea

- Viitorul

- informațiile

- lumea

- lor

- Lor

- apoi

- Acolo.

- astfel

- Acestea

- ei

- lucruri

- acest

- aceste

- deşi?

- Prospera

- timp

- la

- azi

- indicativele

- mâine

- de asemenea

- top

- arunca

- tradiţional

- Tren

- Pregătire

- transformator

- transformatoare

- Tendinţe

- de încredere

- încerca

- încercat

- în

- înțelege

- universitate

- Universitatea din California

- improbabil

- us

- Folosire

- utilizare

- utilizat

- folosind

- diverse

- aventura

- de capital de risc

- Firme cu capital de risc

- foarte

- de

- a fost

- Apă

- Cale..

- we

- web

- Asistență socială

- au fost

- Ce

- cand

- care

- OMS

- de ce

- voi

- cu

- fără

- Apartamente

- de lucru

- lume

- ar

- Greșit

- ani

- tu

- Ta

- zephyrnet