Viteza de transfer a memoriei și latența scăzută sunt esențiale, deoarece inferența trece de la centrul de date la marginea rețelei.

AI/ML evoluează într-un ritm fulger. Nu trece o săptămână în acest moment fără unele dezvoltări noi și interesante în domeniu, iar aplicații precum ChatGPT au adus capabilitățile AI generative în prim-planul atenției publice.

AI/ML este de fapt două aplicații: antrenament și inferență. Fiecare se bazează pe performanța memoriei și fiecare are un set unic de cerințe care conduc la alegerea celei mai bune soluții de memorie.

Cu antrenament, lățimea de bandă a memoriei și capacitatea sunt cerințe critice. Acest lucru este valabil mai ales având în vedere dimensiunea și complexitatea modelelor de date ale rețelelor neuronale care au crescut cu o rată de 10X pe an. Precizia rețelei neuronale depinde de calitatea și cantitatea de exemple din setul de date de antrenament, ceea ce se traduce prin necesitatea de cantități enorme de date și, prin urmare, lățimea de bandă și capacitatea memoriei.

Având în vedere valoarea creată prin antrenament, există un stimulent puternic pentru a finaliza cursele de antrenament cât mai repede posibil. Pe măsură ce aplicațiile de antrenament rulează în centre de date din ce în ce mai limitate pentru putere și spațiu, sunt favorizate soluțiile care oferă eficiență energetică și dimensiuni mai mici. Având în vedere toate aceste cerințe, HBM3 este o soluție de memorie ideală pentru hardware-ul de antrenament AI. Oferă capacități excelente de lățime de bandă și capacitate.

Rezultatul antrenamentului rețelei neuronale este un model de inferență care poate fi implementat pe scară largă. Cu acest model, un dispozitiv de inferență poate procesa și interpreta intrări în afara limitelor datelor de antrenament. Pentru deducere, viteza memoriei și latența scăzută sunt esențiale, mai ales atunci când este nevoie de acțiuni în timp real. Odată cu trecerea din ce în ce mai multe inferențe AI de la inima centrului de date la marginea rețelei, aceste caracteristici de memorie devin și mai critice.

Designerii au o serie de opțiuni de memorie pentru inferența AI/ML, dar în ceea ce privește parametrul critic al lățimii de bandă, memoria GDDR6 strălucește cu adevărat. La o rată a datelor de 24 Gigabiți pe secundă (Gb/s) și o interfață largă de 32 de biți, un dispozitiv GDDR6 poate furniza 96 Gigabiți pe secundă (GB/s) de lățime de bandă a memoriei, mai mult decât dublu față de orice DDR alternativ sau Soluții LPDDR. Memoria GDDR6 oferă o combinație excelentă de viteză, lățime de bandă și performanță de latență pentru inferența AI/ML, în special pentru inferența la margine.

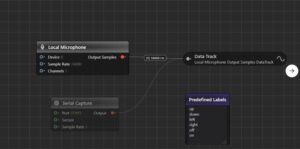

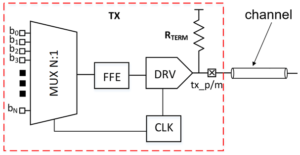

Subsistemul de interfață de memorie Rambus GDDR6 oferă performanțe de 24 Gb/s și este construit pe o bază de peste 30 de ani de experiență în integritatea semnalului de mare viteză și integritatea puterii (SI/PI), esențială pentru operarea GDDR6 la viteze mari. Este alcătuit dintr-un controler PHY și digital - oferind un subsistem complet de interfață de memorie GDDR6.

Vino alături de mine la webinarul Rambus luna aceasta pe „Inferență AI/ML de înaltă performanță cu memorie 24G GDDR6” pentru a descoperi modul în care GDDR6 acceptă cerințele de memorie și performanță ale sarcinilor de lucru de inferență AI/ML și pentru a afla despre unele dintre considerentele cheie de proiectare și implementare ale subsistemelor de interfață de memorie GDDR6.

Resurse:

Frank Ferro

(toate postările)

Frank Ferro este director senior de marketing de produs pentru nuclee IP la Rambus.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoAiStream. Web3 Data Intelligence. Cunoștințe amplificate. Accesați Aici.

- Mintând viitorul cu Adryenn Ashley. Accesați Aici.

- Cumpărați și vindeți acțiuni în companii PRE-IPO cu PREIPO®. Accesați Aici.

- Sursa: https://semiengineering.com/gddr6-delivers-the-performance-for-ai-ml-inference/

- :are

- :este

- :nu

- 24

- 26

- 27

- 30

- 8

- a

- Despre Noi

- precizie

- Acțiune

- AI

- Instruire AI

- AI / ML

- TOATE

- Toate mesajele

- alternativă

- Sume

- an

- și

- Orice

- aplicatii

- SUNT

- AS

- At

- atenţie

- Lățime de bandă

- BE

- devenire

- fost

- CEL MAI BUN

- in linii mari

- adus

- construit

- dar

- by

- CAN

- capacități

- Capacitate

- Centru

- Centre

- Chat GPT

- alegere

- alegeri

- combinaţie

- Completă

- complexitate

- Considerații

- controlor

- a creat

- critic

- de date

- Data Center

- centre de date

- set de date

- livra

- Oferă

- depinde de

- dislocate

- Amenajări

- evoluții

- dispozitiv

- digital

- Director

- descoperi

- dubla

- conduce

- fiecare

- Margine

- eficiență

- enorm

- mai ales

- Chiar

- evoluție

- exemple

- excelent

- captivant

- expertiză

- DESCRIERE

- camp

- cu fermitate

- Pentru

- frunte

- Fundație

- din

- generativ

- AI generativă

- dat

- Merge

- mare

- În creştere

- Piese metalice

- Avea

- inimă

- prin urmare

- Înalt

- Cum

- HTTPS

- ideal

- implementarea

- in

- Stimulent

- tot mai mult

- intrări

- integritate

- interfaţă

- în

- IP

- IT

- jpg

- Cheie

- Latență

- AFLAȚI

- fulger

- ca

- Jos

- Marketing

- Memorie

- model

- Modele

- Lună

- mai mult

- necesar

- au nevoie

- reţea

- Date de rețea

- neural

- rețele neuronale

- Nou

- acum

- număr

- of

- oferi

- promoții

- on

- de operare

- or

- producție

- exterior

- peste

- Pace

- parametru

- special

- în special

- performanță

- Plato

- Informații despre date Platon

- PlatoData

- popularitate

- posibil

- postări

- putere

- puternic

- proces

- Produs

- furnizează

- furnizarea

- public

- calitate

- cantitate

- repede

- rată

- în timp real

- într-adevăr

- Cerinţe

- dreapta

- RÂND

- Alerga

- Al doilea

- senior

- set

- SCHIMBARE

- Ture

- Semnal

- Mărimea

- mai mici

- So

- soluţie

- soluţii

- unele

- Spaţiu

- viteză

- viteze

- Sprijină

- decât

- acea

- Acolo.

- Acestea

- acest

- Prin

- debit

- miniatura

- la

- Pregătire

- Două

- unic

- valoare

- webinar

- săptămână

- cand

- care

- larg

- cu

- fără

- an

- ani

- zephyrnet