De ce și cum ar trebui să înveți „Știința datelor productive”?

De ce și cum ar trebui să înveți „Știința datelor productive”?

Ce este Productive Data Science și care sunt unele dintre componentele acesteia?

Sursă de imagini: Pixabay (Imagine gratuită)

Eficiență în fluxul de lucru în știința datelor

Știința datelor și învățarea automată pot fi practicate cu diferite grade de eficiență și productivitate. Indiferent de domeniul de aplicare sau de specializare, un cercetător de date – începător sau profesionist experimentat – ar trebui să se străduiască să spori eficiența acestuia la toate aspectele sarcinilor tipice ale științei datelor,

- analize statistice,

- vizualizare,

- selecția modelului, ingineria caracteristicilor,

- testarea calității codului, modularizarea,

- procesare paralelă,

- implementare ușoară a aplicației web

Sursă de imagini: Pixabay (Imagine gratuită)

Aceasta înseamnă îndeplinirea tuturor acestor sarcini,

- la viteză mai mare

- cu depanare mai rapidă

- într-o manieră sincronizată

- profitând din plin de toate resursele hardware disponibile

Ce ar trebui să vă așteptați să învățați în acest proces?

Să ne imaginăm că cineva predă un „Știința datelor productive” curs sau scrierea unei cărți despre asta - folosind Python ca cadru de limbaj. Care ar trebui să fie așteptările tipice de la un astfel de curs sau carte?

Sursă de imagini: Pixabay (Imagine gratuită)

Cursul/cartea ar trebui să fie destinată celor care doresc sări dincolo de calea standard de a efectua sarcini de știință a datelor și de învățare automată și de a utiliza întregul spectru al ecosistemului de știință a datelor Python pentru un nivel mult mai ridicat de productivitate.

Cititorii ar trebui să fie învățați cum să caute ineficiențe și blocaje în procesul standard și cum să gândească dincolo de cutie.

Automatizarea sarcinilor repetitive de știință a datelor este o mentalitate cheie pe care cititorii o vor dezvolta în urma citirii acestei cărți. În multe cazuri, ei vor învăța, de asemenea, cum să extindă practica de codificare existentă pentru a gestiona seturi de date mai mari cu eficiență ridicată, cu ajutorul instrumentelor software avansate care există deja în ecosistemul Python, dar care nu sunt predate în nicio știință a datelor standard.

Aceasta nu ar trebui să fie o carte de bucate Python obișnuită care predă biblioteci standard precum Numpy sau Pandas.

Mai degrabă, ar trebui să se concentreze pe tehnici utile, cum ar fi cum să măsurați amprenta memoriei și viteza de execuție a modelelor ML, test de calitate o conductă de știință a datelor, modularizează o conductă de știință a datelor pentru dezvoltarea de aplicații etc. Ar trebui să acopere și bibliotecile Python, care sunt foarte utile pentru automatizarea și accelerând sarcinile de zi cu zi ale oricărui cercetător de date.

În plus, ar trebui să abordeze instrumentele și pachetele care ajută un cercetător de date abordarea unor seturi de date mari și complexe într-un mod mult mai optim decât ceea ce ar fi fost posibil prin respectarea înțelepciunii standard de tehnologie a științei datelor Python.

Câteva abilități specifice de stăpânit

Sursă de imagini: Pixabay (Imagine gratuită)

Pentru a pune lucrurile în termeni concreti, să rezumăm câteva abilități specifice de stăpânit pentru învățare și exersare Știința datelor productive. De asemenea, am încercat să introduc link-uri către câteva articole reprezentative pentru a merge cu fiecare abilitate ca referință.

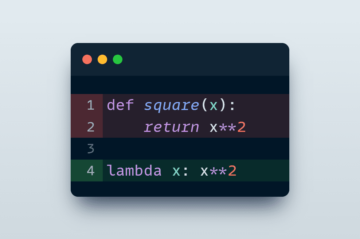

- Cum să scrie cod rapid și eficient pentru știința datelor/ML și cum să le măsoare viteza și eficiența (vezi acest articol)

- Cum să construiți conducte modulare și expresive pentru știința datelor pentru a îmbunătăți productivitatea (vezi acest articol)

- Cum se scrie module de testare pentru știința datelor și modelele ML (vezi acest articol)

- Cum să gestionați eficient seturi de date mari și complexe (ceea ce ar fi fost dificil cu instrumentele tradiționale DS)

- Cum să utilizați pe deplin procesoarele GPU și multi-core pentru toate tipurile de sarcini de știință a datelor și de analiză, și nu doar pentru modelarea specializată de învățare profundă (vezi acest articol)

- Cum să creați aplicații GUI rapide pentru demonstrația unei idei de știință a datelor/ML sau de reglare a modelului (vezi acest articol), sau cum să implementați ușor (și rapid) modele ML și cod de analiză a datelor la nivel de aplicație (vezi acest articol)

O carte ideală pe această temă va...

Sursă de imagini: Pixabay (Imagine gratuită)

- Învață cum să ai grijă ineficiențe și blocaje în codul standard al științei datelor și cum să gândiți dincolo de cutie pentru a rezolva aceste probleme.

- Învățați cum să scrieți analiză modularizată și eficientă a datelor și cod de învățare automată pentru a îmbunătăți productivitatea într-o varietate de situații - analiză exploratorie a datelor, vizualizare, învățare profundă etc.

- Acoperă o gamă largă de subiecte secundare, cum ar fi testarea software-ului, dezvoltarea modulelor, Programare GUI, Implementarea modelului ML ca aplicație web, care sunt seturi de abilități neprețuite pe care oamenii de știință de date în devenire le pot poseda și care sunt greu de găsit în mod colectiv în orice carte standard de știință a datelor.

- Acoperiți calculul paralel (de exemplu, Dask, Ray), scalabilitate (de ex., Vaex, Modin), și stiva de știință a datelor alimentată de GPU (PRAGURI) cu exemple practice.

- Expuneți și ghidați cititorii către un ecosistem Python mai mare și în continuă expansiune de instrumente pentru știința datelor, care sunt conectate la aspectele mai largi ale Inginerie software și implementare la nivel de producție.

Un exemplu concret: știința datelor alimentată de GPU și distribuită

În timp ce utilizarea GPU-urilor și a calculatoarelor distribuite este discutată pe scară largă în cercurile academice și de afaceri pentru sarcinile de bază AI/ML, acestea au găsit mai puțină acoperire în utilitatea lor pentru sarcinile obișnuite de știință a datelor și de inginerie a datelor. Cu toate acestea, utilizarea GPU-urilor pentru analize statistice obișnuite de zi cu zi sau alte sarcini de știință a datelor poate face un drum lung spre a deveni proverbialul „Scientist de date productive".

De exemplu, Suita RAPIDS de biblioteci software și API-uri vă oferă — un om de știință de date obișnuit (și nu neapărat un practician de deep learning) — opțiunea și flexibilitatea de a executa pipeline end-to-end de știință a datelor și de analiză în întregime pe GPU-uri.

Sursă de imagini: Autorul a creat colajul

Atunci când sunt folosite chiar și cu un GPU modest, aceste biblioteci arată o îmbunătățire remarcabilă a vitezei față de omologii lor obișnuiți din Python. Desigur, ar trebui să le îmbrățișăm ori de câte ori putem Știința datelor productive flux de lucru.

În mod similar, există oportunități excelente de sursă deschisă de a depăși limitele naturii cu un singur nucleu a limbajului Python și de a îmbrățișa paradigma de calcul paralel, fără a te îndepărta de personajul chintesențial al cercetătorului de date.

Sursă de imagini: Autorul a creat colajul

Rezumat

Am discutat despre utilitățile și componentele de bază ale a Știința datelor productive fluxul de lucru. Ne-am imaginat ce le-ar oferi cititorilor un curs sau o carte ideală pe această temă. Am atins câteva exemple concrete și am ilustrat beneficiile. Au fost oferite și unele resurse conexe în contextul abilităților de stăpânit.

Puteți verifica autorul GitHub arhive pentru cod, idei și resurse în învățarea automată și știința datelor. Dacă sunteți, ca și mine, pasionat de AI / învățarea automată / știința datelor, vă rugăm să nu ezitați adaugă-mă pe LinkedIn or urmați-mă pe Twitter.

Original. Repostat cu permisiunea.

Related:

Sursa: https://www.kdnuggets.com/2021/07/learn-productive-data-science.html

- "

- &

- Avantaj

- TOATE

- analiză

- Google Analytics

- aplicaţia

- Dezvoltarea aplicațiilor

- aplicație

- Apps

- ZONĂ

- bunuri

- Blog

- Cutie

- construi

- afaceri

- cazuri

- cod

- Codificare

- tehnica de calcul

- Corp

- de date

- analiza datelor

- știința datelor

- om de știință de date

- învățare profundă

- dezvolta

- Dezvoltare

- Director

- calcul distribuit

- ecosistem

- eficiență

- inginer

- Inginerie

- inginerii

- etc

- execuție

- FAST

- Caracteristică

- Flexibilitate

- Concentra

- Cadru

- Gratuit

- Complet

- Aur

- GPU

- unități de procesare grafică

- ghida

- la indemana

- Piese metalice

- Înalt

- Cum

- Cum Pentru a

- HTTPS

- sute

- idee

- imagine

- IT

- Cheie

- limbă

- mare

- AFLAȚI

- învăţare

- Nivel

- Lung

- masina de învățare

- măsura

- mediu

- ML

- model

- modelare

- oferi

- on-line

- deschide

- open-source

- Oportunităţi

- Opțiune

- Altele

- paradigmă

- postări

- productivitate

- Piton

- calitate

- gamă

- cititori

- Citind

- Resurse

- scalabilitate

- Ştiinţă

- oamenii de stiinta

- aptitudini

- Software

- Testare software

- REZOLVAREA

- viteză

- Istorii

- Predarea

- Tehnologia

- Testarea

- top

- subiecte

- atingeţi

- us

- utilitati

- utilitate

- vizualizare

- Ce este

- OMS

- flux de lucru

- scris

- X

- ani