Consiliul Consultativ Economic al Primului Ministru al Indiei (EACPM) a scris un document în care avertizează că reglementările actuale globale ale inteligenței artificiale ar putea fi ineficiente și a recomandat reglementarea tehnologiei cu tactici alternative, precum cele utilizate pe piețele financiare.

Consiliul este foarte îngrijorat de AI. Documentul său avertizează „Prin o combinație de supraveghere, mesagerie persuasivă și generare de media sintetică, inteligența artificială răuvoitoare ar putea controla din ce în ce mai mult ecosistemele informaționale și chiar ar putea fabrica realități înșelătoare personalizate pentru a constrânge comportamentul uman, inducând schizofrenie în masă”.

Organizația critică abordarea SUA cu privire la inteligența artificială ca fiind prea lipsită de importanță, cea a Marii Britanii ca prezentând riscuri prin faptul că este pro-inovare și laissez-faire, iar regulile UE în materie de inteligență artificială ca fiind viciate din cauza scindării și adoptării diferitelor accentuări și aplicații ale statelor membre ale blocului. măsuri de executare.

Documentul susține, de asemenea, că tendința Chinei de a reglementa cu „un sistem birocratic centralizat atotputernic” este defectuoasă – așa cum demonstrează „originea probabilă a COVID-19 în urma scurgerii în laborator”.

Suntem prin oglindă aici, oameni buni.

(Pentru înregistrare, Oficiul american al directorului de informații naționale a nu a gasit nici un indiciu că virusul s-a scurs dintr-un laborator chinez.)

Dar noi divagăm.

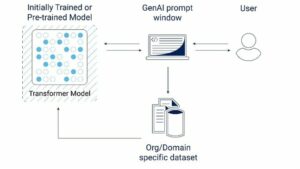

Consiliul sugerează că IA să fie considerată un „sistem de auto-organizare descentralizat [care evoluează] prin bucle de feedback, tranziții de fază și sensibilitate la condițiile inițiale” și prezintă alte exemple de astfel de sisteme – cum ar fi entitățile neliniare văzute pe piețele financiare, comportamentul coloniilor de furnici. , sau modele de trafic.

„Metodele tradiționale sunt insuficiente din cauza naturii neliniare și imprevizibile a AI. Sistemele AI sunt asemănătoare sistemelor complexe adaptive (CAS), în care componentele interacționează și evoluează în moduri imprevizibile.” a explicat [PDF] consiliul.

Consiliul nu este dornic să se bazeze pe măsuri „ex-ante”, deoarece este imposibil să cunoască în avans riscul pe care îl va prezenta un sistem AI – comportamentul său este rezultatul prea multor factori.

Prin urmare, documentul propune ca India să adopte cinci măsuri de reglementare:

- Infiintarea balustradelor si compartimentarii, care ar trebui să se asigure că tehnologiile AI nu depășesc funcția intenționată și nici nu invadează teritorii periculoase, cum ar fi luarea deciziilor privind armamentul nuclear. Dacă într-un fel încalcă acea balustradă într-un sistem, partițiile sunt acolo pentru a se asigura că nu se răspândește.

- Asigurarea depășirilor manuale și a punctelor de sufocare de autorizare care păstrează oamenii sub control și îi mențin în siguranță cu autentificarea cu mai mulți factori și un proces de revizuire pe mai multe niveluri pentru factorii de decizie umani.

- Transparență și explicabilitate cu măsuri precum acordarea de licențe deschise pentru algoritmii de bază pentru a promova un mediu prietenos cu auditul, audituri și evaluări regulate și documentație de dezvoltare standardizată.

- Responsabilitate distinctă prin protocoale de răspundere predefinite, raportare standardizată obligatorie a incidentelor și mecanisme de investigare.

- Crearea unui organism de reglementare specializatcare primește un mandat larg, adoptă o abordare bazată pe feedback, monitorizează și urmărește comportamentul sistemului AI, integrează sisteme automate de alertă și stabilește un registru național.

Consiliul a recomandat să se uite la alte sisteme CAS pentru idei despre cum să-și transmită ideile – în primul rând, piețele financiare.

„Perspectivele de la guvernarea sistemelor haotice, cum ar fi piețele financiare, demonstrează abordări fezabile de reglementare pentru tehnologii complexe”, observă documentul, sugerând că autoritățile de reglementare dedicate AI ar putea fi modelate pe autoritățile de reglementare financiare precum SEBI din India sau SEC din SUA.

Așa cum acele organisme impun opriri de tranzacționare atunci când piețele sunt în pericol, autoritățile de reglementare ar putea adopta „puncte de sufocare” similare la care AI ar fi pus la cale. Raportarea financiară obligatorie este un model bun pentru tipul de dezvăluire pe care operatorii AI ar putea fi obligați să o depună.

Preocupările autorilor sunt alimentate de convingerea că omniprezența în creștere a IA – combinată cu opacitatea funcționării sale – înseamnă că infrastructura critică, operațiunile de apărare și multe alte domenii sunt în pericol.

Printre pericolele pe care le evidențiază se numără „IA fugitivă” în care sistemele s-ar putea auto-îmbunătăți recursiv dincolo de controlul uman și „se pot alinia greșit cu bunăstarea umană” și efectul fluture – un scenariu „în care schimbări minore pot duce la consecințe semnificative, neprevăzute”.

„Prin urmare, un sistem de control opac al stării asupra algoritmilor, seturilor de antrenament și modelelor cu scopul de a maximiza interesele poate duce la rezultate catastrofale”, a avertizat Consiliul.

Documentul notează că reglementările propuse pot însemna că unele scenarii trebuie excluse.

„Este posibil să nu permitem niciodată un internet super conectat pentru orice”, admite Consiliul. Dar concluzionează că omenirea poate avea mai mult de câștigat din reglementări puternice.

„Cei care creează instrumente AI nu vor fi lăsați cu ușurință pentru presupuse consecințe neintenționate – inserând astfel un „Skin în joc” ex-ante. Oamenii își vor păstra puterile de depășire și de autorizare. Auditurile obligatorii regulate vor trebui să impună explicabilitatea.” ®

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://go.theregister.com/feed/www.theregister.com/2024/02/01/indian_pms_ai_advice/

- :are

- :este

- :nu

- :Unde

- a

- Despre Noi

- adaptivă

- adopta

- Adoptarea

- avansa

- consilieri

- consultativ

- AI

- Sisteme AI

- înrudit

- Alerta

- algoritmi

- permite

- de asemenea

- alternativă

- an

- și

- furnică

- aplicatii

- abordare

- abordari

- SUNT

- susține

- AS

- evaluări

- At

- audituri

- Autentificare

- autorizare

- Autorii

- Automata

- BE

- comportament

- fiind

- credinţă

- Dincolo de

- bloc

- organisme

- încălcarea

- adus

- birocratic

- dar

- by

- CAN

- catastrofic

- Provoca

- centralizat

- Modificări

- China

- chinez

- CO

- combinaţie

- combinate

- complex

- componente

- preocupările

- conchide

- Condiții

- legat

- Consecințele

- luate în considerare

- Control

- Nucleu

- ar putea

- Consiliu

- Covid-19

- Crearea

- critic

- Infrastructura critică

- critică

- Curent

- personalizate

- PERICOL

- pericole

- descentralizată

- Luarea deciziilor

- factorii de decizie

- dedicat

- Apărare

- livra

- demonstra

- demonstrat

- Dezvoltare

- diferit

- Director

- dezvăluire

- document

- documentaţie

- nu

- două

- cu ușurință

- Economic

- ecosistemele

- efect

- aplica

- executare

- asigura

- entități

- Mediu inconjurator

- stabilește

- Eter (ETH)

- EU

- Chiar

- tot

- evolua

- evoluează

- exemple

- depăși

- Explicabilitate

- factori

- Cădea

- realizabil

- feedback-ul

- Domenii

- Fișier

- financiar

- Autoritățile de reglementare financiară

- cinci

- defectuoasă

- Pentru

- Foster

- din

- alimentat

- funcţie

- Câştig

- joc

- generaţie

- dat

- de sticlă

- Caritate

- scop

- bine

- guvernare

- Avea

- aici

- Cum

- Cum Pentru a

- HTTPS

- uman

- Umanitate

- Oamenii

- idei

- if

- a impune

- imposibil

- in

- incident

- crescând

- tot mai mult

- India

- indian

- informații

- Infrastructură

- inițială

- perspective

- integreaza

- Inteligență

- destinate

- interacţiona

- interese

- Internet

- investigaţie

- ISN

- IT

- ESTE

- jpg

- pasionat

- A pastra

- păstrare

- Copil

- Cunoaște

- de laborator

- conduce

- lăsa

- răspundere

- de licențiere

- ca

- Probabil

- cautati

- face

- Mandat

- manual

- multe

- pieţe

- Masa

- Maximaliza

- Mai..

- însemna

- mijloace

- măsuri

- mecanisme

- Mass-media

- membru

- mesagerie

- Metode

- ar putea

- ministru

- minor

- model

- Modele

- monitoare

- mai mult

- autentificare multi-factor

- național

- Națiuni

- Natură

- Nevoie

- Nici

- nu

- Nu.

- neliniar

- nici

- notițe

- nuclear

- observă

- of

- de pe

- Birou

- Oficiul directorului informațiilor naționale

- on

- ONE

- opac

- deschide

- Operațiuni

- Operatorii

- or

- Origine

- Altele

- afară

- rezultate

- schiță

- peste

- trece peste

- modele

- oameni

- fază

- Plato

- Informații despre date Platon

- PlatoData

- pm

- competenţelor

- predefinite

- prezenta

- în primul rând

- Prim

- primul ministru

- proces

- propus

- propune

- protocoale

- RE

- realități

- recomandat

- record

- registru

- regulat

- Reglementa

- reglementare

- Regulament

- regulament

- Autoritățile de reglementare

- autoritățile de reglementare

- bazându-se

- Raportarea

- necesar

- rezultat

- reține

- revizuiască

- Risc

- a decis

- norme

- s

- sigur

- Spune

- scenariu

- scenarii

- SEC

- văzut

- Sensibilitate

- Seturi

- Pantaloni scurți

- să

- semnificativ

- asemănător

- Piele

- unele

- oarecum

- de specialitate

- răspândire

- standardizate

- Stat

- controlul statului

- puternic

- astfel de

- sugerează

- Super

- a presupus

- sigur

- supraveghere

- sintetic

- sistem

- sisteme

- T

- tactică

- ia

- Tehnologii

- Tehnologia

- teritorii

- acea

- Marea Britanie

- lor

- Lor

- Acolo.

- astfel

- prin urmare

- ei

- aceste

- Prin

- la

- de asemenea

- Unelte

- piese

- Trading

- tradiţional

- trafic

- Pregătire

- tranziții

- Uk

- neprevăzut

- imprevizibil

- us

- utilizat

- foarte

- virus

- a avertizat

- de avertizare

- avertizează

- modalități de

- we

- Asistență socială

- cand

- care

- voi

- cu

- lucrări

- îngrijorat

- ar

- zephyrnet