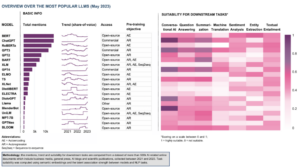

În domeniul în evoluție rapidă al inteligenței artificiale, procesarea limbajului natural a devenit un punct focal atât pentru cercetători, cât și pentru dezvoltatori. Construindu-se pe bazele Arhitectura transformatorului și Upgrade-ul bidirecțional al BERT, în ultimii ani au apărut mai multe modele de limbaj inovatoare, împingând limitele a ceea ce mașinile pot înțelege și genera.

În acest articol, vom explora cele mai recente progrese din lumea modelelor de limbaj la scară largă, explorând îmbunătățirile introduse de fiecare model, capacitățile acestora și aplicațiile potențiale. Vom analiza, de asemenea, modelele de limbaj vizual (VLM) care sunt antrenate să proceseze nu numai date textuale, ci și vizuale.

Dacă doriți să săriți peste, iată modelele de limbă pe care le-am prezentat:

- GPT-3 de OpenAI

- LaMDA de la Google

- PaLM de la Google

- Flamingo de DeepMind

- BLIP-2 de la Salesforce

- LLaMA de Meta AI

- GPT-4 de OpenAI

Dacă acest conținut educațional aprofundat vă este util, puteți abonați-vă la lista noastră de corespondență pentru cercetare AI pentru a fi avertizați atunci când lansăm material nou.

Cele mai importante modele de limbaj mari (LLM) și modele de limbaj vizual (VLM) în 2023

1. GPT-3 de la OpenAI

Rezumat

Echipa OpenAI a introdus GPT-3 ca o alternativă la un set de date etichetat pentru fiecare sarcină de limbă nouă. Ei au sugerat că extinderea modelelor lingvistice poate îmbunătăți performanța la câteva lovituri independente de sarcini. Pentru a testa această sugestie, au antrenat un model de limbaj autoregresiv cu parametri 175B, numit GPT-3și și-a evaluat performanța la peste două duzini de sarcini NLP. Evaluarea în cadrul învățării cu câteva puncte, învățării one-shot și învățării zero-shot a demonstrat că GPT-3 a obținut rezultate promițătoare și chiar a depășit ocazional rezultatele de ultimă generație obținute prin modele reglate fin.

Care este scopul?

- Pentru a sugera o soluție alternativă la problema existentă, atunci când este necesar un set de date etichetat pentru fiecare sarcină de limbă nouă.

Cum este abordată problema?

- Cercetătorii au sugerat extinderea modelelor lingvistice pentru a îmbunătăți performanța la câteva lovituri independente de sarcini.

- GPT-3 modelul utilizează același model și arhitectură ca GPT-2, inclusiv inițializarea modificată, pre-normalizarea și tokenizarea reversibilă.

- Cu toate acestea, spre deosebire de GPT-2, folosește modele de atenție dense și rare, alternate cu benzi locale în straturile transformatorului, ca în Transformator rar.

Care sunt rezultatele?

- Modelul GPT-3 fără reglaj fin obține rezultate promițătoare pentru o serie de sarcini NLP și chiar depășește ocazional modelele de ultimă generație care au fost reglate fin pentru acea sarcină specifică:

- Pe CoQA de referință, 81.5 F1 în setarea zero-shot, 84.0 F1 în setarea one-shot și 85.0 F1 în setarea câteva lovituri, în comparație cu scorul F90.7 de 1 obținut de SOTA reglat fin.

- Pe TriviaQA benchmark, 64.3% acuratețe în setarea zero-shot, 68.0% în setarea one-shot și 71.2% în setarea câteva lovituri, depășind stadiul tehnicii (68%) cu 3.2%.

- Pe LAMBADA set de date, precizie de 76.2% în setarea zero-shot, 72.5% în setarea one-shot și 86.4% în setarea câteva lovituri, depășind stadiul tehnicii (68%) cu 18%.

- Articolele de știri generate de modelul GPT-175 cu parametru 3B sunt greu de distins de cele reale, conform evaluărilor umane (cu o acuratețe abia peste nivelul șanselor de ~52%).

- În ciuda performanței remarcabile a GPT-3, acesta a primit recenzii mixte din partea comunității AI:

- „Hep-ul GPT-3 este mult prea mare. Este impresionant (mulțumesc pentru complimentele frumoase!) dar încă are slăbiciuni serioase și uneori face greșeli foarte prostești. AI va schimba lumea, dar GPT-3 este doar o privire foarte timpurie. Mai avem multe de aflat.” – Sam Altman, CEO și co-fondator al OpenAI.

- „Sunt șocat cât de greu este să generezi text despre musulmani din GPT-3 care nu are nimic de-a face cu violența... sau cu a fi ucis...” – Abubakar Abid, CEO și fondator al Gradio.

- "Nu. GPT-3, în principiu, nu înțelege lumea despre care vorbește. Creșterea în continuare a corpus îi va permite să genereze o pastișă mai credibilă, dar nu să-și repare lipsa fundamentală de înțelegere a lumii. Demonstrațiile GPT-4 vor necesita în continuare culesul de cireșe umane.” – Gary Marcus, CEO și fondator al Robust.ai.

- „Extrapolarea performanței spectaculoase a GPT3 în viitor sugerează că răspunsul la viață, univers și tot este doar 4.398 trilioane de parametri.” – Geoffrey Hinton, câștigător al Premiului Turing.

Unde să aflați mai multe despre această cercetare?

De unde puteți obține codul de implementare?

- Codul în sine nu este disponibil, dar unele statistici ale setului de date împreună cu mostre necondiționate, nefiltrate de 2048 de jetoane de la GPT-3 sunt lansate pe GitHub.

2. LaMDA de la Google

Rezumat

Lalimbaj Models pentru Ddialog Aaplicatii (TheMDA) au fost create prin procesul de reglare fină a unui grup de modele de limbaj neuronal bazate pe Transformer, care sunt concepute special pentru dialoguri. Aceste modele au maximum 137B parametri și au fost instruite să utilizeze surse externe de cunoștințe. Dezvoltatorii LaMDA au avut în vedere trei obiective cheie – calitate, siguranță și temeinic. Rezultatele au demonstrat că reglarea fină permite reducerea decalajului de calitate la nivelurile umane, dar performanța modelului a rămas sub nivelurile umane în ceea ce privește siguranța și temeinicia.

Bard de la Google, eliberat recent, ca alternativă la ChatGPT, este alimentat de LaMDA. În ciuda faptului că Bard a fost adesea etichetat ca plictisitor, ar putea fi văzută ca o dovadă a angajamentului Google de a acorda prioritate siguranței, chiar și în mijlocul rivalității intense dintre Google și Microsoft pentru a stabili dominația în domeniul AI generativ.

Care este scopul?

- Pentru a construi un model pentru aplicații de dialog cu domeniu deschis, în care un agent de dialog este capabil să converseze despre orice subiect, cu răspunsuri sensibile, specifice contextului, bazate pe surse de încredere și etice.

Cum este abordată problema?

- LaMDA este construit pe Transformator, o arhitectură de rețea neuronală pe care Google Research a inventat-o și a oferit-o cu sursă deschisă în 2017.

- La fel ca și alte modele mari de limbaj, inclusiv BERT și GPT-3, LaMDA este antrenat pe terabytes de date text pentru a afla cum se leagă cuvintele între ele și apoi să prezică ce cuvinte vor urma.

- Cu toate acestea, spre deosebire de majoritatea modelelor de limbaj, LaMDA a fost instruit pe dialog pentru a prelua nuanțe care disting conversația deschisă de alte forme de limbaj.

- Modelul este, de asemenea, reglat pentru a îmbunătăți sensibilitatea, siguranța și specificitatea răspunsurilor sale. În timp ce expresii precum „așa e drăguț” și „Nu știu” pot avea sens în multe scenarii de dialog, nu este probabil să conducă la conversații interesante și captivante.

- Generatorul LaMDA generează mai întâi mai multe răspunsuri candidate, care sunt toate punctate în funcție de cât de sigure, sensibile, specifice și interesante sunt. Răspunsurile cu scoruri de siguranță scăzute sunt filtrate, iar apoi rezultatul cel mai bine clasat este selectat ca răspuns.

Care sunt rezultatele?

- Numeroase experimente arată că LaMDA poate participa la conversații deschise pe o varietate de subiecte.

- O serie de evaluări calitative au confirmat că răspunsurile modelului tind să fie sensibile, specifice, interesante și bazate pe surse externe de încredere, dar există încă loc de îmbunătățire.

- În ciuda tuturor progreselor înregistrate până acum, autorii recunosc că modelul are încă multe limitări care pot avea ca rezultat generarea de răspunsuri inadecvate sau chiar dăunătoare.

Unde să aflați mai multe despre această cercetare?

De unde puteți obține codul de implementare?

- O implementare open-source PyTorch pentru arhitectura de pre-training a LaMDA este disponibilă pe GitHub.

3. PaLM de la Google

Rezumat

Pade altfel Langoasă Model (Palmier) este un parametru de 540 de miliarde, model de limbaj bazat pe Transformer. PaLM a fost antrenat pe 6144 cipuri TPU v4 folosind Pathways, un nou sistem ML pentru antrenament eficient pe mai multe poduri TPU. Modelul demonstrează beneficiile extinderii în învățarea cu puține lovituri, obținând rezultate de ultimă generație pe sute de înțelegere a limbii și repere de generație. PaLM depășește modelele de ultimă generație pentru sarcinile de raționament în mai mulți pași și depășește performanța umană medie la benchmark-ul BIG-bench.

Care este scopul?

- Pentru a îmbunătăți înțelegerea modului în care scalarea modelelor lingvistice mari afectează învățarea în câteva momente.

Cum este abordată problema?

- Ideea cheie este de a scala formarea unui model de limbaj cu 540 de miliarde de parametri cu sistemul Pathways:

- Echipa folosea paralelismul de date la nivel de pod pe două poduri Cloud TPU v4, în timp ce folosea paralelismul de date standard și model în fiecare pod.

- Ei au reușit să extindă antrenamentul la 6144 de cipuri TPU v4, cea mai mare configurație de sistem bazată pe TPU utilizată pentru antrenament până în prezent.

- Modelul a atins o eficiență de antrenament de 57.8% de utilizare a FLOP-urilor hardware, care, după cum susțin autorii, este cea mai mare eficiență de antrenament atinsă până acum pentru modelele mari de limbaj la această scară.

- Datele de instruire pentru modelul PaLM au inclus o combinație de seturi de date în limba engleză și multilingvă care conține documente web de înaltă calitate, cărți, Wikipedia, conversații și cod GitHub.

Care sunt rezultatele?

- Numeroase experimente demonstrează că performanța modelului a crescut considerabil pe măsură ce echipa a ajuns la cel mai mare model.

- PaLM 540B a atins performanțe revoluționare în mai multe sarcini foarte dificile:

- Înțelegerea și generarea limbajului. Modelul introdus a depășit performanța cu puține rezultate ale modelelor mari anterioare la 28 din 29 de sarcini care includ sarcini de răspuns la întrebări, sarcini de închidere și completare a propozițiilor, sarcini de înțelegere a citirii în context, sarcini de raționament de bun simț, sarcini SuperGLUE și Mai mult. Performanța PaLM la sarcinile BIG-bench a arătat că ar putea distinge cauza și efectul, precum și să înțeleagă combinațiile conceptuale în contexte adecvate.

- Raţionament. Cu ajutorul de 8 lovituri, PaLM rezolvă 58% dintre problemele din GSM8K, un etalon de mii de întrebări provocatoare de matematică la nivel de școală, depășind scorul anterior de 55% obținut prin reglarea fină a modelului GPT-3 175B. PaLM demonstrează, de asemenea, capacitatea de a genera explicații explicite în situații care necesită o combinație complexă de inferență logică în mai mulți pași, cunoaștere a lumii și înțelegere profundă a limbajului.

- Generarea codului. PaLM funcționează la egalitate cu Codex 12B reglat în timp ce folosește de 50 de ori mai puțin cod Python pentru antrenament, confirmând că modelele mari de limbaj transferă învățarea atât din alte limbaje de programare, cât și din datele din limbajul natural mai eficient.

Unde să aflați mai multe despre această cercetare?

De unde puteți obține codul de implementare?

- O implementare neoficială PyTorch a arhitecturii specifice Transformer din lucrarea de cercetare PaLM este disponibilă pe GitHub. Nu se va scala și este publicat doar în scopuri educaționale.

4. Flamingo de DeepMind

Rezumat

Flamingo este o familie de ultimă oră de modele de limbaj vizual (VLM), instruite pe corpuri web multimodale la scară largă, cu text și imagini mixte. Cu acest antrenament, modelele se pot adapta la noi sarcini folosind exemple minime adnotate, furnizate ca prompt. Flamingo încorporează progrese arhitecturale cheie concepute pentru a îmbina punctele forte ale modelelor preantrenate doar pentru viziune și numai pentru limbaj, procesează secvențe de date vizuale și textuale intercalate variabil și găzduiește imagini sau videoclipuri ca intrări fără probleme. Modelele demonstrează o adaptabilitate impresionantă la o gamă largă de sarcini de imagine și video, cum ar fi răspunsul la întrebări vizuale, sarcinile de subtitrare și răspunsul la întrebări vizuale cu opțiuni multiple, stabilind noi standarde de performanță folosind instrucțiuni specifice sarcinii în învățarea cu câteva fotografii.

Care este scopul?

- Pentru a face progrese spre a permite modelelor multimodale să învețe și să efectueze rapid sarcini noi pe baza unor instrucțiuni scurte:

- Paradigma utilizată pe scară largă de pregătire preliminară a unui model pe o cantitate mare de date supravegheate, apoi reglarea fină a acestuia pentru sarcina specifică, necesită resurse intensive și necesită mii de puncte de date adnotate, împreună cu reglarea atentă a hiperparametrului per sarcină.

- Modelele actuale care folosesc un obiectiv contrastiv permit adaptarea zero-shot la sarcini noi, dar nu au sarcini mai deschise, cum ar fi subtitrărea sau răspunsul vizual la întrebări, deoarece le lipsesc capabilitățile de generare a limbajului.

- Această cercetare își propune să introducă un nou model care abordează eficient aceste probleme și demonstrează performanțe superioare în regimurile cu date reduse.

Cum este abordată problema?

- DeepMind a introdus Flamingo, VLM-uri concepute pentru învățarea în câteva momente pe diferite sarcini deschise de viziune și limbaj, folosind doar câteva exemple de intrare/ieșire.

- Modelele Flamingo sunt modele de generare de text autoregresive condiționate vizual, care pot procesa simboluri de text amestecate cu imagini și/sau videoclipuri și pot genera text ca rezultat.

- Arhitectura Flamingo încorporează două modele complementare pre-antrenate și congelate:

- Un model de viziune capabil de a „percepe” scene vizuale.

- Un model de limbaj mare, însărcinat cu efectuarea raționamentului de bază.

- Componentele noi de arhitectură integrează aceste modele într-un mod care păstrează cunoștințele dobândite în timpul pregătirii lor intensive din punct de vedere computațional.

- În plus, modelele Flamingo au o arhitectură bazată pe Perceiver, permițându-le să ingereze imagini sau videoclipuri de înaltă rezoluție. Această arhitectură poate genera un număr fix de simboluri vizuale per imagine/video dintr-o gamă largă și variabilă de caracteristici de intrare vizuală.

Care sunt rezultatele?

- Cercetarea arată că, în mod similar cu LLM-urile, care sunt buni cursanți cu puține fotografii, VLM-urile pot învăța din câteva exemple de intrare/ieșire pentru sarcini de înțelegere a imaginilor și a videoclipurilor, cum ar fi clasificarea, subtitrarea sau răspunsul la întrebări.

- Flamingo stabilește un nou punct de referință în învățarea cu câteva fotografii, demonstrând performanțe superioare pe o gamă largă de 16 sarcini multimodale de înțelegere a imaginilor/video.

- Pentru 6 din aceste 16 sarcini, Flamingo depășește performanța de ultimă generație, chiar dacă folosește doar 32 de exemple specifice sarcinii - de aproximativ 1000 de ori mai puține date de antrenament specifice sarcinii decât modelele actuale cu cele mai bune performanțe.

Unde să aflați mai multe despre această cercetare?

De unde puteți obține codul de implementare?

- DeepMind nu a lansat implementarea oficială a Flamingo.

- Puteți găsi implementarea open source a abordării introduse în OpenFlamingo Github Repo.

- Implementarea alternativă a PyTorch este disponibilă aici.

5. BLIP-2 de la Salesforce

Rezumat

BLIP-2 este un cadru eficient și generic de pre-antrenament pentru modele de viziune și limbaj, conceput pentru a evita costurile din ce în ce mai prohibitive ale pre-antrenării modelelor la scară largă. BLIP-2 folosește codificatoare de imagine pre-antrenate înghețate și modele de limbaj mari congelate pentru a bootstrap pre-antrenarea limbajului de viziune, încorporând un transformator de interogare ușor, pre-antrenat în două etape. Prima etapă inițiază învățarea reprezentării viziunii-limbaj de la un codificator de imagine înghețată, iar a doua etapă propulsează învățarea generativă viziunii-limbaj dintr-un model de limbaj înghețat. În ciuda faptului că are mult mai puțini parametri antrenabili, BLIP-2 depășește metodele de ultimă generație, depășind Flamingo80B de la DeepMind cu 8.7% la zero-shot VQAv2 cu de 54 de ori mai puțini parametri antrenabili. Modelul prezintă, de asemenea, capacități promițătoare de generare de imagine în text, urmând instrucțiuni în limbaj natural.

Care este scopul?

- Pentru a obține performanțe de ultimă generație în sarcinile limbajului vizual, reducând în același timp costurile de calcul.

Cum este abordată problema?

- Echipa Salesforce a introdus un nou cadru de pre-formare în limbajul viziunii, numit BLIP-2, Bootstrapping Llimba-IMAGE Preinstruire cu modele unimodale congelate:

- Modelele unimodale pre-antrenate rămân înghețate în timpul pre-antrenamentului pentru a reduce costurile de calcul și pentru a evita problema uitării catastrofale.

- Pentru a facilita alinierea intermodală și pentru a reduce decalajul de modalități dintre modelele de viziune pre-antrenate și modelele de limbaj pre-antrenate, echipa propune un transformator de interogare ușor (Q-Former) care acționează ca un blocaj de informare între codificatorul de imagine înghețată și cel înghețat. LLM.

- Q-former este pre-antrenat cu o nouă strategie în două etape:

- Prima etapă pre-formare realizează învățarea reprezentării limbajului vizional. Acest lucru îl obligă pe Q-Former să învețe reprezentarea vizuală cea mai relevantă pentru text.

- A doua etapă de pre-formare realizează învățarea generativă viziune-la-limbaj prin conectarea ieșirii Q-Former la un LLM înghețat. Q-Former este antrenat astfel încât reprezentarea sa vizuală de ieșire să poată fi interpretată de către LLM.

Care sunt rezultatele?

- BLIP-2 oferă rezultate excepționale, de ultimă generație, într-o varietate de sarcini în limbajul vizual, cuprinzând răspunsul vizual la întrebări, subtitrărea imaginilor și recuperarea textului imaginii.

- De exemplu, îl depășește pe Flamingo cu 8.7% la zero-shot VQAv2.

- În plus, această performanță remarcabilă este obținută cu o eficiență semnificativ mai mare a computerului:

- BLIP-2 depășește Flamingo-80B în timp ce utilizează de 54 ori mai puțini parametri antrenabili.

- BLIP-2 are capacitatea de a întreprinde generarea zero-shot de imagine în text ca răspuns la instrucțiunile din limbajul natural, deschizând astfel calea pentru dezvoltarea abilităților precum raționamentul cunoștințelor vizuale și conversația vizuală, printre altele.

- În cele din urmă, este important de reținut că BLIP-2 este o abordare versatilă care poate folosi modele unimodale mai sofisticate pentru a îmbunătăți și mai mult performanța pre-antrenamentului pentru limbajul vizual.

Unde să aflați mai multe despre această cercetare?

De unde puteți obține codul de implementare?

Implementarea oficială BLIP-2 este disponibilă pe GitHub.

6. LLaMA de Meta AI

Rezumat

Echipa Meta AI afirmă că modelele mai mici antrenate pe mai multe jetoane sunt mai ușor de reantrenat și de reglat fin pentru aplicații specifice de produs. Prin urmare, ei introduc Lamă (LARGE Lalimbaj Model Meta AI), o colecție de modele de limbaj fundamentale cu parametri de la 7B la 65B. LLaMA 33B și 65B au fost antrenate pe 1.4 trilioane de jetoane, în timp ce cel mai mic model, LLaMA 7B, a fost antrenat pe un trilion de jetoane. Ei au folosit exclusiv seturi de date disponibile public, fără a depinde de date proprietare sau restricționate. Echipa a implementat, de asemenea, îmbunătățiri arhitecturale cheie și tehnici de optimizare a vitezei de antrenament. În consecință, LLaMA-13B a depășit GPT-3, fiind de peste 10 ori mai mic, iar LLaMA-65B a prezentat performanțe competitive cu PaLM-540B.

Care este scopul?

- Să demonstreze fezabilitatea antrenării modelelor de cea mai bună performanță exclusiv pe seturi de date accesibile publicului, fără a se baza pe surse de date proprietare sau restricționate.

- Pentru a oferi comunității de cercetare modele mai mici și mai performante și, astfel, a le permite celor care nu au acces la cantități mari de infrastructură, să studieze modele lingvistice mari.

Cum este abordată problema?

- Pentru a antrena modelul LLaMA, cercetătorii au folosit doar date disponibile public și compatibile cu sursele deschise.

- De asemenea, au introdus câteva îmbunătățiri arhitecturii standard Transformer:

- Adoptând metodologia GPT-3, stabilitatea antrenamentului a fost îmbunătățită prin normalizarea intrării pentru fiecare sub-strat transformator, mai degrabă decât prin normalizarea ieșirii.

- Inspirați de modelele PaLM, cercetătorii au înlocuit neliniaritatea ReLU cu funcția de activare SwiGLU, pentru a îmbunătăți performanța.

- Inspirat de Su și colab (2021), au eliminat înglobările poziționale absolute și, în schimb, au încorporat încorporații poziționale rotative (RoPE) la fiecare strat al rețelei.

- În cele din urmă, echipa Meta AI a îmbunătățit viteza de antrenament a modelului lor prin:

- Folosind implementarea eficientă a atenției cauzale cu mai multe capete, prin nu stocarea ponderilor atenției sau calculul scorurilor de cheie/interogare mascate.

- Utilizarea punctelor de control pentru a minimiza activările recalculate în timpul trecerii înapoi.

- Suprapunerea calculului activărilor și a comunicării dintre GPU-uri prin rețea (datorită operațiunilor all_reduce).

Care sunt rezultatele?

- LLaMA-13B depășește GPT-3, în ciuda faptului că este de peste 10 ori mai mic, în timp ce LLaMA-65B se menține singur față de PaLM-540B.

Unde să aflați mai multe despre această cercetare?

De unde puteți obține codul de implementare?

- Meta AI oferă acces la LLaMA cercetătorilor academicieni, persoanelor asociate cu guvernul, societatea civilă, instituțiile academice și laboratoarele de cercetare din industria globală, pe baza evaluării de caz individual. Pentru a aplica, accesați următoarele GitHub depozit.

7. GPT-4 de la OpenAI

Rezumat

GPT-4 este un model multimodal la scară largă, care acceptă intrări de imagini și text și generează ieșiri de text. Din cauza preocupărilor legate de concurență și siguranță, detaliile specifice despre arhitectura și formarea modelului sunt ascunse. În ceea ce privește performanța, GPT-4 depășește modelele lingvistice anterioare în comparațiile tradiționale și prezintă îmbunătățiri semnificative în înțelegerea intenției utilizatorului și proprietățile de siguranță. Modelul realizează, de asemenea, performanțe la nivel uman la diferite examene, inclusiv un scor de top 10% la un examen simulat al baroului uniform.

Care este scopul?

- Pentru a dezvolta un model multimodal la scară largă, care poate accepta intrări de imagini și text și poate produce ieșiri de text.

- Pentru a dezvolta infrastructură și metode de optimizare care să se comporte previzibil pe o gamă largă de scale.

Cum este abordată problema?

- Din cauza peisajului competitiv și a implicațiilor legate de siguranță, OpenAI a decis să rețină detalii despre arhitectură, dimensiunea modelului, hardware, calculul de antrenament, construcția setului de date și metodele de antrenament.

- Ei dezvăluie că:

- GPT-4 este un model bazat pe Transformer, pre-antrenat pentru a prezice următorul token dintr-un document.

- Utilizează date disponibile public și date licențiate de terți.

- Modelul a fost ajustat folosind învățarea prin întărire din feedback uman (RLHF).

- Informațiile neconfirmate sugerează că GPT-4 nu este un model dens la fel ca predecesorii săi, ci o coaliție puternică de opt modele separate, fiecare cu 220 de miliarde de parametri uimitoare.

Care sunt rezultatele?

- GPT-4 realizează performanțe la nivel uman la majoritatea examenelor profesionale și academice, în special obținând un punctaj în primele 10% la o simulare de examen uniform baroului.

- Modelul de bază GPT-4 pre-antrenat depășește modelele de limbaj existente și sistemele anterioare de ultimă generație pe benchmark-urile tradiționale NLP, fără elaborarea specifică benchmark-ului sau protocoale de antrenament suplimentare.

- GPT-4 demonstrează o îmbunătățire substanțială în urmărirea intenției utilizatorului, răspunsurile sale fiind preferate față de răspunsurile lui GPT-3.5 în 70.2% din 5,214 solicitări de la ChatGPT și API-ul OpenAI.

- Proprietățile de siguranță ale GPT-4 s-au îmbunătățit semnificativ în comparație cu GPT-3.5, cu o scădere cu 82% a răspunsului la solicitările de conținut nepermis și o creștere cu 29% a conformității cu politicile pentru solicitările sensibile (de exemplu, sfaturi medicale și autovătămare).

Unde să aflați mai multe despre această cercetare?

De unde puteți obține codul de implementare?

- Implementarea codului GPT-4 nu este disponibilă.

Aplicații din lumea reală ale modelelor de limbaje mari (de viziune).

Cele mai semnificative descoperiri ale cercetării AI din ultimii ani provin din modele mari de AI antrenate pe seturi de date uriașe. Aceste modele demonstrează performanțe impresionante și este fascinant să ne gândim cum AI poate revoluționa industrii întregi, cum ar fi serviciile pentru clienți, marketingul, comerțul electronic, asistența medicală, dezvoltarea de software, jurnalismul și multe altele.

Modelele de limbaj mari au numeroase aplicații în lumea reală. GPT-4 enumeră următoarele:

- Înțelegerea și generarea limbajului natural pentru chatbot și asistenți virtuali.

- Traducere automată între limbi.

- Rezumarea articolelor, rapoartelor sau a altor documente text.

- Analiza sentimentelor pentru cercetarea pieței sau monitorizarea rețelelor sociale.

- Generare de conținut pentru marketing, social media sau scriere creativă.

- Sisteme de răspuns la întrebări pentru asistență pentru clienți sau baze de cunoștințe.

- Clasificarea textului pentru filtrarea spamului, clasificarea subiectelor sau organizarea documentelor.

- Instrumente personalizate de învățare a limbilor și de îndrumare.

- Asistență pentru generarea de cod și dezvoltarea de software.

- Analiză și asistență de documente medicale, juridice și tehnice.

- Instrumente de accesibilitate pentru persoanele cu dizabilități, cum ar fi conversia text în vorbire și conversie vorbire în text.

- Servicii de recunoaștere a vorbirii și transcriere.

Dacă adăugăm o parte vizuală, domeniile posibilelor aplicații se extind și mai mult:

Este foarte interesant să urmărești recentele descoperiri ale AI și să te gândești la potențialele lor aplicații în lumea reală. Cu toate acestea, înainte de a implementa aceste modele în viața reală, trebuie să abordăm riscurile și limitările corespunzătoare, care, din păcate, sunt destul de semnificative.

Riscuri și limitări

Dacă întrebați GPT-4 despre riscurile și limitările sale, probabil că vă va oferi o listă lungă de preocupări relevante. După ce am filtrat prin această listă și am adăugat câteva considerații suplimentare, am ajuns la următorul set de riscuri și limitări cheie pe care le posedă modelele moderne de limbaj mari:

- Prejudecăți și discriminare: Aceste modele învață din cantități mari de date text, care conțin adesea părtiniri și conținut discriminatoriu. Ca rezultat, rezultatele generate pot perpetua, din neatenție, stereotipuri, limbaj ofensator și discriminare bazată pe factori precum genul, rasa sau religia.

- Dezinformare: modelele de limbă mari pot genera conținut incorect, înșelător sau depășit. Deși modelele sunt instruite pe o gamă variată de surse, este posibil să nu ofere întotdeauna informațiile cele mai precise sau actualizate. Adesea, acest lucru se întâmplă deoarece modelul prioritizează generarea de rezultate care sunt corecte din punct de vedere gramatical sau par coerente, chiar dacă sunt înșelătoare.

- Lipsa de intelegere: Deși aceste modele par să înțeleagă limbajul uman, ele funcționează în primul rând prin identificarea tiparelor și a asociațiilor statistice în datele de instruire. Ei nu au o înțelegere profundă a conținutului pe care îl generează, ceea ce poate duce uneori la rezultate fără sens sau irelevante.

- Conținut inadecvat: Modelele de limbaj pot genera uneori conținut ofensator, dăunător sau inadecvat. Deși se depun eforturi pentru a minimiza un astfel de conținut, acesta poate apărea din cauza naturii datelor de instruire și a incapacității modelelor de a discerne contextul sau intenția utilizatorului.

Concluzie

Modelele de limbaj mari au revoluționat, fără îndoială, domeniul prelucrării limbajului natural și au demonstrat un potențial imens în creșterea productivității în diferite roluri și industrii. Capacitatea lor de a genera text asemănător omului, de a automatiza sarcinile banale și de a oferi asistență în procesele creative și analitice le-a făcut instrumente indispensabile în lumea de astăzi, în ritm rapid, bazată pe tehnologie.

Cu toate acestea, este esențial să recunoaștem și să înțelegem limitările și riscurile asociate cu aceste modele puternice. Probleme precum părtinirea, dezinformarea și potențialul de utilizare rău intenționată nu pot fi ignorate. Pe măsură ce continuăm să integrăm aceste tehnologii bazate pe inteligența artificială în viața noastră de zi cu zi, este esențial să găsim un echilibru între valorificarea capacităților lor și asigurarea supravegherii umane, în special în situații sensibile și cu risc ridicat.

Dacă reușim să adoptăm tehnologiile AI generative în mod responsabil, vom deschide calea către un viitor în care inteligența artificială și expertiza umană conlucrează pentru a stimula inovația și a crea o lume mai bună pentru toți.

Bucurați-vă de acest articol? Înscrieți-vă pentru mai multe actualizări ale cercetării AI.

Vă vom anunța când vom lansa mai multe articole sumare ca acesta.

Legate de

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. Automobile/VE-uri, carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- BlockOffsets. Modernizarea proprietății de compensare a mediului. Accesați Aici.

- Sursa: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- :are

- :este

- :nu

- :Unde

- $UP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- capacitate

- Capabil

- Despre Noi

- mai sus

- Absolut

- academic

- Accept

- acceptă

- acces

- accesibil

- găzdui

- Conform

- precizie

- precis

- realizat

- Realizeaza

- realizarea

- recunoaște

- peste

- Activarea

- activări

- Acte

- adapta

- adaptare

- adăuga

- adăugare

- plus

- Suplimentar

- adresa

- adrese

- Adoptarea

- progresele

- sfat

- După

- împotriva

- Agent

- AI

- cercetare ai

- isi propune

- AL

- deopotrivă

- TOATE

- permite

- Permiterea

- permite

- de-a lungul

- de asemenea

- alternativă

- Cu toate ca

- mereu

- în mijlocul

- printre

- sumă

- Sume

- an

- analiză

- Analitic

- și

- O alta

- răspunde

- Orice

- api

- apărea

- aplicatii

- Aplică

- abordare

- adecvat

- aproximativ

- arhitectural

- arhitectură

- SUNT

- domenii

- în jurul

- Mulțime

- Artă

- articol

- bunuri

- artificial

- inteligență artificială

- AS

- Asistență

- asistenți

- asociate

- asociaţii

- At

- atenţie

- Autorii

- automatizarea

- disponibil

- in medie

- evita

- acordare

- Sold

- bar

- de bază

- bazat

- de bază

- bază

- BE

- deoarece

- deveni

- înainte

- fiind

- de mai jos

- Benchmark

- valori de referință

- Beneficiile

- Mai bine

- între

- părtinire

- distorsiunilor

- Miliard

- Manuale

- Bootstrap

- atât

- limitele

- descoperire

- descoperiri

- POD

- larg

- construi

- Clădire

- construit

- dar

- by

- denumit

- CAN

- candidat

- nu poti

- capacități

- capabil

- Capacitate

- atent

- caz

- catastrofic

- Provoca

- CEO

- CEO și fondator

- provocare

- șansă

- Schimbare

- chatbots

- Chat GPT

- Chips

- pretinde

- clasificare

- Cloud

- Co-fondator

- cod

- COERENT

- colectare

- combinaţie

- combinaţii

- cum

- angajament

- Comunicare

- comunitate

- comparație

- compatibil

- competitiv

- complementar

- complex

- conformitate

- componente

- calcul

- Calcula

- calculator

- tehnica de calcul

- conceptual

- preocupările

- Configuraţie

- CONFIRMAT

- Conectarea

- prin urmare

- Considerații

- construcţie

- conţinut

- context

- contexte

- continua

- contrast

- Conversație

- conversații

- Convertire

- corecta

- Corespunzător

- A costat

- Cheltuieli

- ar putea

- crea

- a creat

- Creator

- credibil

- crucial

- Curent

- client

- Serviciu clienți

- Relații Clienți

- ultima generație

- zilnic

- de date

- puncte de date

- seturi de date

- Data

- hotărât

- scădea

- adânc

- DeepMind

- Oferă

- demonstra

- demonstrat

- demonstrează

- demonstrând

- Demos

- În funcție

- Implementarea

- proiectat

- În ciuda

- detalii

- dezvolta

- Dezvoltatorii

- în curs de dezvoltare

- Dezvoltare

- Dialog

- Dialog

- dificil

- dizabilități

- dezvălui

- Discriminare

- distinge

- diferit

- do

- document

- documente

- face

- Predominanța

- Dont

- duzină

- conduce

- numit

- două

- în timpul

- e

- e-commerce

- E&T

- fiecare

- Devreme

- mai ușor

- de învăţământ

- efect

- în mod eficient

- eficiență

- eficient

- Eforturile

- eliminat

- a apărut

- permite

- permițând

- care să cuprindă

- captivant

- Engleză

- spori

- sporită

- îmbunătățiri

- consolidarea

- asigurare

- esenţial

- stabili

- stabilește

- etic

- evaluat

- evaluare

- evaluări

- Chiar

- Fiecare

- tot

- dovadă

- evoluție

- examinare

- exemplu

- exemple

- depășește

- excepțional

- captivant

- exclusiv

- Exponatele

- existent

- Extinde

- experimente

- expertiză

- Explorarea

- extern

- f1

- facilita

- factori

- Cădea

- familie

- departe

- fascinant

- ritm rapid

- Caracteristică

- Recomandate

- DESCRIERE

- feedback-ul

- puțini

- mai puține

- camp

- Figura

- filtrare

- Găsi

- First

- Repara

- fixată

- urma

- următor

- Pentru

- formulare

- Fundații

- fondator

- Cadru

- din

- congelate

- funcţie

- fundamental

- fundamental

- mai mult

- viitor

- dobândită

- decalaj

- Gen

- genera

- generată

- generează

- generator

- generaţie

- generativ

- AI generativă

- generator

- obține

- GitHub

- licărire

- Caritate

- Go

- scop

- merge

- bine

- Guvern

- unități de procesare grafică

- calitate

- inovatoare

- grup

- HAD

- se întâmplă

- Greu

- Piese metalice

- nociv

- Avea

- având în

- de asistență medicală

- aici

- de înaltă calitate

- Rezoluție înaltă

- Risc ridicat

- superior

- cea mai mare

- deține

- Cum

- Totuși

- HTML

- HTTPS

- mare

- uman

- sute

- hype

- Reglarea hiperparametrului

- idee

- identificarea

- if

- imagine

- imagini

- imens

- implementarea

- implementat

- implicații

- important

- impresionant

- îmbunătăţi

- îmbunătățit

- îmbunătățire

- îmbunătățiri

- in

- în profunzime

- incapacitate

- include

- inclus

- Inclusiv

- Incorporated

- încorporează

- care încorporează

- Crește

- a crescut

- crescând

- tot mai mult

- individ

- persoane fizice

- industrii

- industrie

- informații

- Infrastructură

- Initiaza

- Inovaţie

- intrare

- intrări

- in schimb

- instituții

- instrucțiuni

- integra

- Inteligență

- scop

- interesant

- în

- introduce

- introdus

- Inventat

- problema

- probleme de

- IT

- ESTE

- în sine

- ziaristică

- jpg

- doar

- Cheie

- obiective-cheie

- Cunoaște

- cunoştinţe

- Labs

- lipsă

- peisaj

- limbă

- Limbă

- mare

- pe scară largă

- cea mai mare

- Ultimele

- strat

- straturi

- conduce

- AFLAȚI

- învăţare

- Legal

- mai puțin

- Nivel

- nivelurile de

- Pârghie

- pîrghii

- efectului de pârghie

- Autorizat

- Viaţă

- categorie ușoară

- ca

- Probabil

- limitări

- Listă

- liste

- Locuiește

- Lamă

- la nivel local

- logic

- Lung

- Uite

- Lot

- Jos

- Masini

- făcut

- face

- FACE

- multe

- Marcus

- Piață

- de cercetare de piață

- Marketing

- material

- matematica

- max-width

- maxim

- Mai..

- semnificativ

- Mass-media

- medical

- Îmbina

- meta

- Metodologie

- Metode

- Microsoft

- minte

- minim

- Dezinformare

- derutant

- greşeli

- mixt

- ML

- model

- Modele

- Modern

- modificată

- Monitorizarea

- mai mult

- cele mai multe

- mult

- multiplu

- musulmanii

- Natural

- Limbajul natural

- Procesarea limbajului natural

- Natură

- Nevoie

- necesar

- reţea

- neural

- Limbajul neuronal

- rețele neuronale

- Nou

- ştiri

- următor

- frumos

- nlp

- în special

- nimic

- număr

- numeroși

- obiectiv

- Obiectivele

- avea loc

- of

- ofensator

- oficial

- de multe ori

- on

- ONE

- cele

- afară

- deschide

- open-source

- OpenAI

- funcionar

- Operațiuni

- optimizare

- or

- organizație

- Altele

- Altele

- al nostru

- afară

- surclasa

- surclasează

- producție

- remarcabil

- peste

- propriu

- palmier

- Hârtie

- paradigmă

- parametru

- parametrii

- parte

- participa

- în special

- trece

- modele

- Pave

- Pavaj

- pentru

- efectua

- performanță

- efectuarea

- efectuează

- Expresii

- alege

- Plato

- Informații despre date Platon

- PlatoData

- păstaie

- Punct

- puncte

- Politicile

- posibil

- potenţial

- alimentat

- puternic

- prezice

- preferat

- precedent

- în primul rând

- anterior

- Stabilirea priorităților

- Problemă

- probleme

- proces

- procese

- prelucrare

- produce

- Produs

- productivitate

- profesional

- Programare

- limbaje de programare

- Progres

- promițător

- proprietăţi

- propune

- proprietate

- protocoale

- furniza

- prevăzut

- furnizează

- public

- publicat

- scopuri

- împingerea

- Piton

- pirtorh

- calitativ

- calitate

- întrebare

- Întrebări

- repede

- Rasă

- gamă

- repede

- mai degraba

- Citind

- real

- viata reala

- lumea reală

- recent

- recent

- recunoaştere

- recunoaște

- reduce

- reducerea

- regimuri

- Consolidarea învățării

- eliberaţi

- eliberat

- de încredere

- surse sigure

- religie

- bazându-se

- rămâne

- a ramas

- remarcabil

- înlocuiește

- Rapoarte

- reprezentare

- cereri de

- necesita

- Necesită

- cercetare

- Comunitatea de cercetare

- cercetători

- consumatoare de resurse

- respect

- răspunde

- răspuns

- răspunsuri

- limitat

- rezultat

- REZULTATE

- reține

- Recenzii

- revoluţiona

- revoluționat

- Riscurile

- rivalitate

- robust

- rolurile

- Cameră

- sigur

- Siguranţă

- Salesforce

- acelaşi

- Scară

- cântare

- scalare

- scenarii

- scene

- Şcoală

- scor

- scorurile

- notare

- perfect

- Al doilea

- părea

- văzut

- selectate

- sensibil

- distinct

- serie

- serios

- serviciu

- Servicii

- set

- instalare

- câteva

- șocat

- Pantaloni scurți

- Arăta

- a arătat

- Emisiuni

- semna

- semnificativ

- semnificativ

- asemănător

- singular

- situații

- Mărimea

- aptitudini

- mai mici

- So

- până acum

- Social

- social media

- Societate

- Software

- de dezvoltare de software

- Numai

- soluţie

- rezolvă

- unele

- sofisticat

- Sursă

- Surse

- Sourcing

- spam-

- specific

- specific

- specificitate

- spectaculos

- vorbire-text

- viteză

- Stabilitate

- Etapă

- Stadiile

- standard

- standarde

- Stat

- de ultimă oră

- statistic

- statistică

- Încă

- Strategie

- puncte forte

- grevă

- Studiu

- substanțial

- reuși

- astfel de

- sugera

- sugerează

- REZUMAT

- superior

- supraveghere

- a sustine

- depășit

- sistem

- sisteme

- Tratative

- Sarcină

- sarcini

- echipă

- Tehnic

- tehnici de

- Tehnologii

- termeni

- test

- generarea textului

- Text-to-Speech

- decât

- Mulțumiri

- acea

- Viitorul

- Statul

- lumea

- lor

- Lor

- apoi

- Acolo.

- astfel

- prin urmare

- Acestea

- ei

- crede

- terț

- acest

- aceste

- deşi?

- mii

- trei

- Prin

- ori

- la

- azi

- împreună

- semn

- tokenizarea

- indicativele

- de asemenea

- Unelte

- top

- TOPBOTS

- subiect

- subiecte

- față de

- tradiţional

- Tren

- dresat

- Pregătire

- transfer

- transformator

- transformare

- Traducere

- Trilion

- Turing

- meditații

- Două

- necondiţionat

- în

- înţelege

- înţelegere

- întreprinde

- fara indoiala

- din pacate

- Univers

- spre deosebire de

- up-to-data

- actualizări

- utilizare

- utilizat

- Utilizator

- utilizări

- folosind

- utilizează

- varietate

- diverse

- Fixă

- multilateral

- foarte

- Video

- Video

- Virtual

- viziune

- VOX

- a fost

- Cale..

- we

- web

- BINE

- au fost

- Ce

- cand

- care

- în timp ce

- OMS

- întreg

- larg

- Gamă largă

- Wikipedia

- voi

- cu

- în

- fără

- cuvinte

- Apartamente

- lucram impreuna

- lume

- scris

- ani

- încă

- tu

- zephyrnet

- Învățare Zero-Shot