O lucrare tehnică intitulată „Soluție eficientă de inferență LLM pe Intel GPU” a fost publicată de cercetătorii de la Intel Corporation.

Rezumat:

„Modelele de limbaj mari (LLM) bazate pe transformatoare au fost utilizate pe scară largă în multe domenii, iar eficiența inferenței LLM devine subiect fierbinte în aplicațiile reale. Cu toate acestea, LLM-urile sunt de obicei proiectate complicat în structura modelului cu operații masive și efectuează inferențe în modul auto-regresiv, ceea ce face o sarcină dificilă proiectarea unui sistem cu eficiență ridicată.

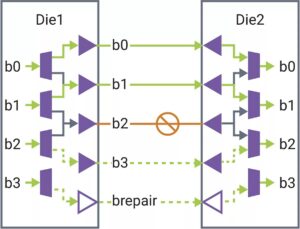

În această lucrare, propunem o soluție eficientă de inferență LLM cu latență scăzută și debit mare. În primul rând, simplificăm stratul de decodor LLM prin fuzionarea mișcării datelor și a operațiunilor în funcție de elemente pentru a reduce frecvența de acces la memorie și latența sistemului. De asemenea, propunem o politică de cache KV pe segmente pentru a păstra cheia/valoarea token-urilor de solicitare și răspuns în memorie fizică separată pentru o gestionare eficientă a memoriei dispozitivului, ajutând la mărirea dimensiunii lotului de rulare și la îmbunătățirea debitului sistemului. Un nucleu personalizat Scaled-Dot-Product-Attention este proiectat pentru a se potrivi cu politica noastră de fuziune bazată pe soluția de cache KV de segment. Implementăm soluția noastră de inferență LLM pe Intel GPU și o publicăm public. În comparație cu implementarea standard HuggingFace, soluția propusă realizează o latență a jetonului de până la 7 ori mai mică și un randament de 27 ori mai mare pentru unele LLM-uri populare pe Intel GPU.”

Găsi lucrare tehnică aici. Publicat în decembrie 2023 (preprint).

Wu, Hui, Yi Gan, Feng Yuan, Jing Ma, Wei Zhu, Yutao Xu, Hong Zhu, Yuhua Zhu, Xiaoli Liu și Jinghui Gu. „Soluție de inferență LLM eficientă pe GPU Intel.” arXiv preprint arXiv:2401.05391 (2023).

Citire asemănătoare

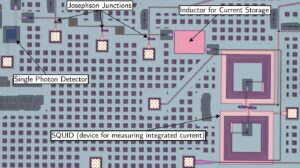

Inferență LLM asupra procesoarelor (Intel)

O lucrare tehnică intitulată „Efficient LLM Inference on CPUs” a fost publicată de cercetătorii de la Intel.

AI Ras To the Edge

Inferențele și unele antrenamente sunt transferate pe dispozitive mai mici, pe măsură ce AI se răspândește la noi aplicații.

- Distribuție de conținut bazat pe SEO și PR. Amplifică-te astăzi.

- PlatoData.Network Vertical Generative Ai. Împuterniciți-vă. Accesați Aici.

- PlatoAiStream. Web3 Intelligence. Cunoștințe amplificate. Accesați Aici.

- PlatoESG. carbon, CleanTech, Energie, Mediu inconjurator, Solar, Managementul deșeurilor. Accesați Aici.

- PlatoHealth. Biotehnologie și Inteligență pentru studii clinice. Accesați Aici.

- Sursa: https://semiengineering.com/llm-inference-on-gpus-intel/

- :este

- $UP

- 2023

- a

- acces

- Realizeaza

- AI

- de asemenea

- an

- și

- aplicatii

- SUNT

- AS

- At

- bazat

- devine

- fost

- fiind

- by

- cache

- provocare

- comparație

- CORPORAȚIE

- personalizate

- de date

- decembrie

- Amenajări

- proiectat

- dispozitiv

- Dispozitive

- Eficace

- eficiență

- eficient

- mări

- Domenii

- Pentru

- Frecvență

- fuzionând

- fuziune

- GPU

- unități de procesare grafică

- Avea

- ajutor

- aici

- Înalt

- superior

- Hong

- FIERBINTE

- Totuși

- HTTPS

- Față îmbrățișată

- punerea în aplicare a

- implementarea

- îmbunătăţi

- in

- Intel

- IT

- jpg

- A pastra

- limbă

- mare

- Latență

- strat

- LLM

- Jos

- LOWER

- Efectuarea

- administrare

- multe

- masiv

- Meci

- Memorie

- mod

- model

- Modele

- mişcare

- Nou

- of

- on

- deschide

- Operațiuni

- al nostru

- Hârtie

- efectua

- fizic

- Plato

- Informații despre date Platon

- PlatoData

- Politica

- Popular

- propune

- propus

- public

- publica

- publicat

- împins

- cursă

- real

- reduce

- solicita

- cercetători

- răspuns

- segment

- distinct

- simplifica

- Mărimea

- mai mici

- soluţie

- unele

- Spread-

- standard

- structura

- sistem

- Sarcină

- Tehnic

- acest

- debit

- cu denumirea

- la

- semn

- indicativele

- subiect

- Pregătire

- utilizat

- obișnuit

- a fost

- we

- pe larg

- cu

- Yuan

- zephyrnet