Gerado com Midjourney

Empresas em todos os setores e cantos do mundo estão correndo para integrar o poder de grandes modelos de linguagem (LLMs) como ChatGPT da OpenAI, Claude da Anthropic e Jurassic da AI12Lab para aumentar o desempenho em uma ampla gama de aplicativos de negócios, como pesquisa de mercado, atendimento ao cliente e geração de conteúdo.

No entanto, a criação de um aplicativo LLM em escala corporativa requer um conjunto de ferramentas e um entendimento diferentes do que a criação de aplicativos tradicionais de aprendizado de máquina (ML). Os líderes e executivos de negócios que desejam preservar a voz da marca e a qualidade confiável do serviço precisam desenvolver uma compreensão mais profunda de como os LLMs funcionam e os prós e contras de várias ferramentas em uma pilha de aplicativos LLM.

Neste artigo, forneceremos uma introdução essencial à estratégia e às ferramentas de alto nível necessárias para criar e executar um aplicativo LLM para sua empresa.

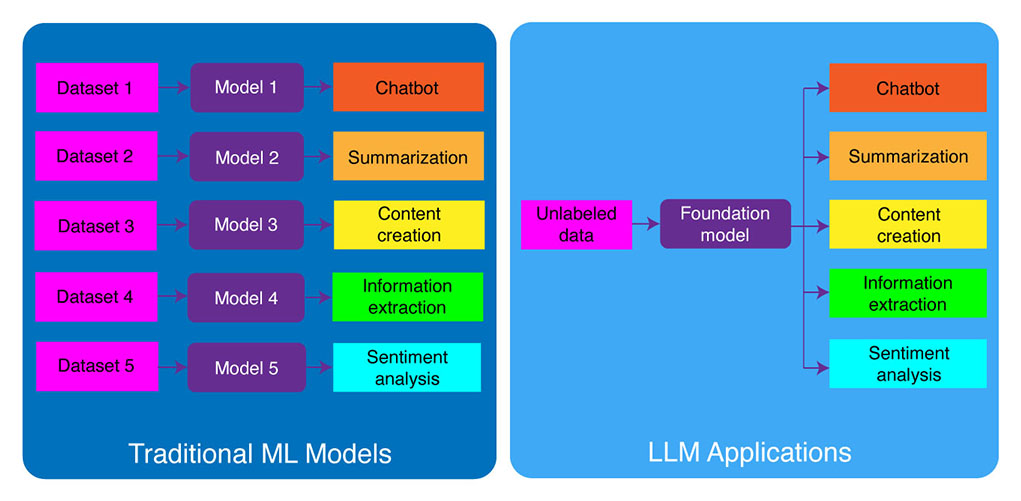

Desenvolvimento de ML tradicional versus aplicativos LLM

Os modelos tradicionais de aprendizado de máquina eram específicos da tarefa, o que significa que você precisava criar um modelo separado para cada tarefa diferente. Por exemplo, se você quiser analisar o sentimento do cliente, precisará criar um modelo e, se quiser criar um chatbot de suporte ao cliente, precisará criar outro modelo.

Esse processo de criação e treinamento de modelos de ML específicos para tarefas é demorado e requer muitos dados. O tipo de conjunto de dados necessário para treinar esses diferentes modelos de ML também varia dependendo da tarefa. Para treinar um modelo para analisar o sentimento do cliente, você precisaria de um conjunto de dados de avaliações de clientes rotulados com um sentimento correspondente (positivo, negativo, neutro). Para treinar um modelo para construir um chatbot de suporte ao cliente, você precisaria de um conjunto de dados de conversas entre clientes e suporte técnico.

Grandes modelos de linguagem mudaram isso. Os LLMs são pré-treinados em um enorme conjunto de dados de texto e código, o que lhes permite um bom desempenho em uma ampla gama de tarefas prontas para uso, incluindo:

- Resumo de texto

- Criação de conteúdo

- Tradução

- Extração de informação

- Resposta de perguntas

- Análise de sentimentos

- Atendimento ao cliente

- Suporte de vendas

O processo de desenvolvimento de aplicativos LLM pode ser dividido em quatro etapas essenciais:

- Escolha um modelo de fundação apropriado. É um componente chave, definindo o desempenho do seu aplicativo LLM.

- Personalize o modelo, se necessário. Pode ser necessário ajustar o modelo ou aumentá-lo com a base de conhecimento adicional para atender às suas necessidades específicas.

- Configure a infraestrutura de ML. Isso inclui o hardware e o software necessários para executar seu aplicativo (ou seja, semicondutores, chips, hospedagem em nuvem, inferência e implantação).

- Aumente seu aplicativo com ferramentas adicionais. Essas ferramentas podem ajudar a melhorar a eficiência, o desempenho e a segurança de seu aplicativo.

Agora, vamos dar uma olhada na pilha de tecnologia correspondente.

Se este conteúdo educacional aprofundado for útil para você, inscreva-se em nossa lista de discussão de IA para ser alertado quando lançarmos novo material.

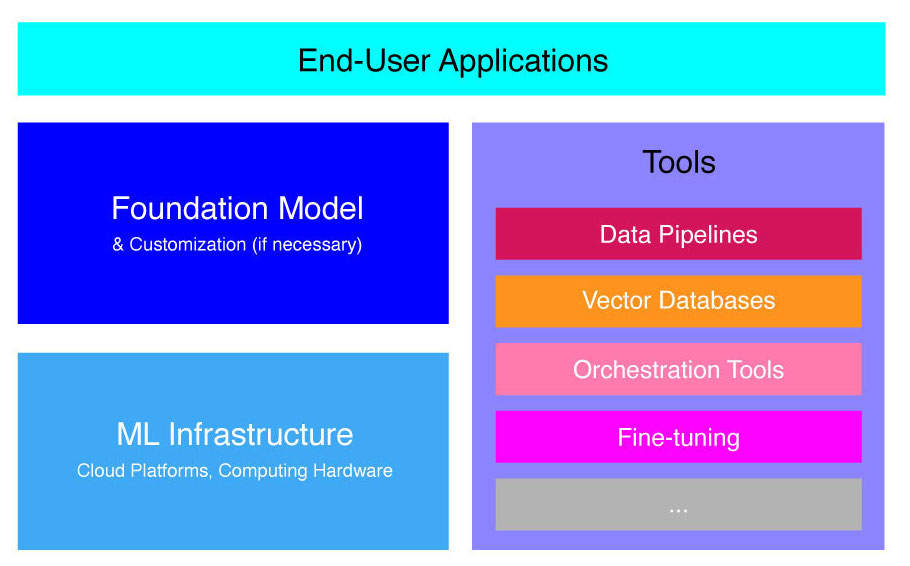

Pilha de aplicativos LLM de alto nível

Os aplicativos LLM são construídos sobre vários componentes principais, incluindo:

- Um modelo de fundação, o que pode exigir customização em casos de uso específicos.

- infraestrutura de ML para recursos de computação suficientes por meio de plataformas de nuvem ou hardware da própria empresa.

- Ferramentas adicionais, como pipelines de dados, bancos de dados vetoriais, ferramentas de orquestração, plataformas de ML de ajuste fino, ferramentas de monitoramento de desempenho de modelos, etc.

Vamos orientá-lo brevemente por esses componentes para que você possa entender melhor o kit de ferramentas necessário para criar e implantar um aplicativo LLM.

O que são modelos de fundação?

O uso de um único LLM pré-treinado pode economizar muito tempo e recursos. No entanto, treinar esse modelo desde o início é um processo oportuno e caro que está além da capacidade da maioria das empresas, exceto para alguns líderes de tecnologia de elite.

Várias empresas e equipes de pesquisa treinaram esses modelos e permitem que outras empresas os utilizem. Os principais exemplos incluem ChatGPT, Claude, Llama, Jurassic e T5. Esses modelos voltados para o público são chamados de modelos de fundação. Alguns deles são proprietários e podem ser acessados por meio de chamadas de API por uma taxa. Outros são de código aberto e podem ser usados gratuitamente. Esses modelos são pré-treinados em um enorme conjunto de dados textuais não rotulados, permitindo que eles executem uma ampla gama de tarefas, desde a geração de cópias criativas de anúncios até a comunicação com seus clientes em seu idioma nativo em nome da empresa.

Existem dois tipos principais de modelos de fundação: proprietários e de código aberto.

Modelos proprietários são de propriedade de uma única empresa ou organização e normalmente estão disponíveis apenas por uma taxa. Alguns dos exemplos mais populares de modelos proprietários incluem modelos GPT da OpenAI, modelos Claude da Anthropic e modelos Jurassic da AI21 Labs.

Modelos de código aberto geralmente estão disponíveis gratuitamente para quem quiser usá-los. No entanto, alguns modelos de código aberto apresentam limitações de uso, como: (1) estarem disponíveis apenas para fins de pesquisa, (2) estarem disponíveis apenas para uso comercial por empresas de determinado porte. A comunidade de código aberto afirma que colocar tais restrições não permite que um modelo se qualifique como “código aberto”. Ainda assim, os exemplos mais proeminentes de modelos de linguagem que podem ser usados gratuitamente incluem modelos Llama da Meta, modelos Falcon do Technology Innovation Institute em Abu Dhabi e modelos StableLM da Stability AI. Leia mais sobre modelos de código aberto e os riscos associados SUA PARTICIPAÇÃO FAZ A DIFERENÇA.

Agora vamos discutir vários fatores a serem considerados ao escolher um modelo de base para seu aplicativo LLM.

Escolha um modelo de fundação

Selecionar o melhor modelo de fundação para sua aplicação LLM pode ser um processo desafiador, mas basicamente podemos dividi-lo em três etapas:

- Escolha entre modelos proprietários e de código aberto. Os modelos proprietários são geralmente maiores e mais capazes do que os modelos de código aberto, mas podem ser mais caros de usar e menos flexíveis. Além disso, o código não é tão transparente, o que dificulta a depuração ou solução de problemas com o desempenho dos modelos proprietários. Os modelos de código aberto, por outro lado, geralmente recebem menos atualizações e menos suporte dos desenvolvedores.

- Escolha o tamanho do modelo. Modelos maiores geralmente são melhores na execução de tarefas que exigem muito conhecimento, como responder a perguntas ou gerar textos criativos. No entanto, modelos maiores também são computacionalmente mais caros de usar. Você pode começar experimentando modelos maiores e, em seguida, ir para os menores, desde que o desempenho do modelo seja satisfatório para o seu caso de uso.

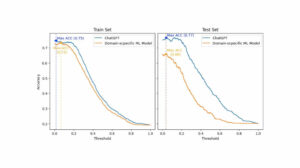

- Selecione um modelo específico. Você pode começar revisando os benchmarks gerais para selecionar os modelos para teste. Em seguida, prossiga com o teste de modelos diferentes para suas atribuições específicas do aplicativo. Para benchmarking personalizado, considere calcular Pontuações BLEU e ROUGE, as métricas que ajudam a quantificar o número de correções necessárias para o texto gerado por IA antes de liberar a saída para aplicativos humanos em loop.

Para uma melhor compreensão das diferenças entre vários modelos de linguagem, confira nossa visão geral dos modelos de linguagem (LLM) e linguagem visual (VLM) mais poderosos.

Depois de escolher um modelo de base para seu aplicativo, você pode considerar se precisa customizar o modelo para um desempenho ainda melhor.

Personalizar um modelo de fundação

Em alguns casos, você pode querer customizar um modelo de linguagem de base para melhor desempenho em seu caso de uso específico. Por exemplo, você pode querer otimizar para um determinado:

- Domínio. Se você opera em domínios específicos, como jurídico, financeiro ou de saúde, convém enriquecer o vocabulário do modelo nesse domínio para que ele possa entender e responder melhor às consultas do usuário final.

- Tarefa. Por exemplo, se você deseja que o modelo gere campanhas de marketing, pode fornecer exemplos específicos de conteúdo de marketing de marca. Isso ajudará o modelo a aprender os padrões e estilos apropriados para sua empresa e público.

- Tom de voz. Se você precisar que o modelo use um tom de voz específico, poderá personalizar o modelo em um conjunto de dados que inclua exemplos de suas amostras lingüísticas de destino.

Há três maneiras possíveis de personalizar um modelo de linguagem de base:

- Afinação: fornece ao modelo um conjunto de dados rotulado específico do domínio de cerca de 100 a 500 registros. Os pesos do modelo são atualizados, o que deve resultar em melhor desempenho nas tarefas representadas por este conjunto de dados.

- Adaptação de domínio: fornece ao modelo um conjunto de dados não rotulado específico do domínio que contém um grande corpus de dados do domínio correspondente. Os pesos do modelo também são atualizados neste caso.

- Recuperação de informação: aumenta o modelo de fundação com conhecimento de domínio fechado. O modelo não é treinado novamente e os pesos do modelo permanecem os mesmos. No entanto, o modelo pode recuperar informações de um banco de dados vetorial contendo dados relevantes.

As duas primeiras abordagens requerem recursos computacionais significativos para retreinar o modelo, o que geralmente só é viável para grandes empresas com o talento técnico adequado para gerenciar a customização. Empresas menores geralmente usam a abordagem mais comum de aumentar o modelo com conhecimento de domínio por meio de um banco de dados vetorial, que detalhamos mais adiante neste artigo na seção sobre ferramentas LLM.

Configurar infraestrutura de ML

O componente de infraestrutura de ML do cenário LLMOps inclui plataformas de nuvem, hardware de computação e outros recursos necessários para implantar e executar LLMs. Esse componente é especialmente relevante se você optar por usar um modelo de software livre ou customizar o modelo para seu aplicativo. Nesse caso, você pode precisar de recursos computacionais significativos para ajustar o modelo, se necessário, e executá-lo.

Existem várias plataformas de nuvem que oferecem serviços para implantação de LLMs, incluindo Google Cloud Platform, Amazon Web Services e Microsoft Azure. Essas plataformas fornecem vários recursos que facilitam a implantação e a execução de LLMs, incluindo:

- Modelos pré-treinados que podem ser ajustados para sua aplicação específica

- Infraestrutura gerenciada que cuida do hardware e software subjacente

- Ferramentas e serviços para monitorar e depurar seus LLMs

A quantidade de recursos de computação necessários dependerá do tamanho e da complexidade de seu modelo, das tarefas que deseja executar e da escala da atividade comercial em que deseja implantar esse modelo.

Aumentar com ferramentas

Ferramentas adjacentes LLM adicionais podem ser usadas para aprimorar ainda mais o desempenho de seu aplicativo LLM.

Pipelines de Dados

Se você precisar usar seus dados em seu produto LLM, o pipeline de pré-processamento de dados será um pilar essencial de sua nova pilha de tecnologia, assim como na pilha tradicional de IA corporativa. Essas ferramentas incluem conectores para ingerir dados de qualquer fonte, uma camada de transformação de dados e conectores downstream. Os principais provedores de pipeline de dados, como Databricks e Snowflake, e novos players, como Unstructured, tornam mais fácil para os desenvolvedores apontar grandes e altamente heterogêneos corpora de dados em linguagem natural (por exemplo, milhares de PDFs, apresentações em PowerPoint, logs de bate-papo, HTML raspado, etc.) para um único ponto de acesso ou mesmo para um único documento que pode ser usado posteriormente por aplicativos LLM.

Bancos de dados vetoriais

Modelos de linguagem grandes são limitados ao processamento de alguns milhares de palavras por vez, portanto, eles não podem processar documentos grandes de forma eficaz por conta própria. Para aproveitar o poder de documentos grandes, as empresas precisam usar bancos de dados vetoriais.

Bancos de dados vetoriais são sistemas de armazenamento que transformam grandes documentos recebidos por meio de pipelines de dados em vetores gerenciáveis ou incorporações. Os aplicativos LLM podem consultar esses bancos de dados para identificar os vetores corretos, extraindo apenas as informações necessárias.

Alguns dos bancos de dados de vetores mais proeminentes atualmente disponíveis são Pinecone, Chroma e Weaviate.

Ferramentas de orquestração

Quando um usuário envia uma consulta ao seu aplicativo LLM, como uma pergunta para atendimento ao cliente, o aplicativo precisa construir uma série de prompts antes de enviar essa consulta ao modelo de idioma. A solicitação final para o modelo de linguagem é normalmente composta por um modelo de prompt codificado pelo desenvolvedor, exemplos de saídas válidas chamadas de exemplos de poucos disparos, qualquer informação necessária recuperada de APIs externas e um conjunto de documentos relevantes recuperados do banco de dados de vetores . As ferramentas de orquestração de empresas como LangChain ou LlamaIndex podem ajudar a simplificar esse processo, fornecendo estruturas prontas para uso para gerenciamento e execução de prompts.

Afinação

Grandes modelos de linguagem treinados em conjuntos de dados massivos podem produzir texto gramaticalmente correto e fluente. No entanto, podem faltar precisão em certas áreas, como medicina ou direito. O ajuste fino desses modelos em conjuntos de dados específicos do domínio permite que eles internalizem os recursos exclusivos dessas áreas, aprimorando sua capacidade de gerar texto relevante.

O ajuste fino de um LLM pode ser um processo caro para pequenas empresas. No entanto, soluções de empresas como Weights & Biases e OctoML podem ajudar com um ajuste fino simplificado e eficiente. Essas soluções fornecem uma plataforma para as empresas ajustarem os LLMs sem precisar investir em sua própria infraestrutura.

Outras Ferramentas

Existem muitas outras ferramentas que podem ser úteis para criar e executar aplicativos LLM. Por exemplo, você pode precisar de ferramentas de rotulagem se quiser ajustar o modelo com suas amostras de dados específicas. Você também pode implantar ferramentas específicas para monitorar o desempenho de seu aplicativo, pois até mesmo pequenas alterações no modelo de base ou solicitações de clientes podem afetar significativamente o desempenho dos prompts. Por fim, existem ferramentas que monitoram a segurança do modelo para ajudar você a evitar a promoção de conteúdo odioso, recomendações perigosas ou preconceitos. A necessidade e a importância dessas diferentes ferramentas dependerão do seu caso de uso específico.

O que vem a seguir no desenvolvimento de aplicativos LLM?

As quatro etapas para o desenvolvimento de produtos LLM que discutimos aqui são uma base essencial da estratégia de IA generativa de qualquer empresa que aproveita grandes modelos de linguagem. Eles são importantes para os líderes de negócios não técnicos entenderem, mesmo se você tiver uma equipe técnica implementando os detalhes. Publicaremos tutoriais mais detalhados no futuro sobre como aproveitar a ampla gama de ferramentas de IA generativas no mercado. Por enquanto, você pode subscrever a nossa newsletter para obter as atualizações mais recentes.

Gostou deste artigo? Inscreva-se para mais atualizações de IA empresarial.

Avisaremos quando lançarmos mais artigos de resumo como este.

Relacionado

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Automotivo / EVs, Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- BlockOffsets. Modernizando a Propriedade de Compensação Ambiental. Acesse aqui.

- Fonte: https://www.topbots.com/llm-product-development-technology-stack/

- :é

- :não

- :onde

- $UP

- 1

- a

- habilidade

- Sobre

- abu dhabi

- Acesso

- acessadas

- atividade

- Ad

- Adicional

- Adicionalmente

- adjacente

- AI

- Estratégia AI

- permitir

- permitidas

- permite

- tb

- Amazon

- Amazon Web Services

- quantidade

- an

- analisar

- e

- Outro

- Antrópico

- qualquer

- qualquer um

- api

- APIs

- Aplicação

- Desenvolvimento de Aplicações

- aplicações

- abordagem

- se aproxima

- apropriado

- SOMOS

- áreas

- artigo

- artigos

- AS

- associado

- At

- público

- disponível

- evitar

- Azul

- base

- Basicamente

- BE

- sido

- antes

- lado

- ser

- aferimento

- benchmarks

- MELHOR

- Melhor

- entre

- Pós

- vieses

- impulsionar

- Caixa

- interesse?

- de marca

- Break

- brevemente

- Quebrado

- construir

- Prédio

- construído

- negócio

- Aplicações de Negócio

- Líderes de negócios

- negócios

- mas a

- by

- cálculo

- chamado

- chamadas

- Campanhas

- CAN

- capacidades

- capaz

- Cuidado

- casas

- casos

- certo

- desafiante

- mudado

- Alterações

- chatbot

- ChatGPT

- verificar

- Chips

- Escolha

- escolha

- escolhido

- reivindicações

- Na nuvem

- cloud Hosting

- Plataforma em nuvem

- código

- comercial

- comum

- comunicação

- comunidade

- Empresas

- Empresa

- Empresa

- complexidade

- componente

- componentes

- composta

- computação

- Desvantagens

- Considerar

- construir

- contém

- conteúdo

- conversas

- cópias

- Canto

- correta

- Correções

- Correspondente

- dispendioso

- Criatividade

- Atualmente

- personalizadas

- cliente

- Atendimento ao Cliente

- Suporte ao cliente

- Clientes

- personalização

- personalizar

- Perigoso

- dados,

- banco de dados

- bases de dados

- Bancos de dados

- conjuntos de dados

- mais profunda

- definição

- Dependendo

- implantar

- Implantação

- desenvolvimento

- detalhe

- detalhado

- detalhes

- desenvolver

- Developer

- desenvolvedores

- em desenvolvimento

- Desenvolvimento

- Dhabi

- diferenças

- diferente

- difícil

- discutir

- discutido

- documento

- INSTITUCIONAIS

- Não faz

- domínio

- domínios

- down

- e

- cada

- fácil

- educacional

- efetivamente

- eficiência

- eficiente

- elite

- permitindo

- aumentar

- aprimorando

- enriquecer

- Empreendimento

- especialmente

- essencial

- etc.

- Éter (ETH)

- Mesmo

- Cada

- exemplo

- exemplos

- Exceto

- executando

- executivos

- caro

- externo

- fatores

- falcão

- factível

- Funcionalidades

- taxa

- poucos

- menos

- final

- Finalmente

- financeiro

- Primeiro nome

- flexível

- Escolha

- Foundation

- quatro

- enquadramentos

- Gratuito

- da

- mais distante

- futuro

- Geral

- gerar

- gerando

- geração

- generativo

- IA generativa

- ter

- OFERTE

- globo

- Go

- vai

- Parceria

- Google Cloud Platform

- Solo

- mão

- Hardware

- arreios

- Ter

- ter

- saúde

- ajudar

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- de alto nível

- altamente

- hospedagem

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- HTML

- HTTPS

- i

- if

- Impacto

- implementação

- importância

- importante

- melhorar

- in

- em profundidade

- incluir

- inclui

- Incluindo

- indústria

- INFORMAÇÕES

- Infraestrutura

- Inovação

- Instituto

- integrar

- para dentro

- Introdução

- Investir

- IT

- jpg

- apenas por

- Chave

- Tipo

- Saber

- Conhecimento

- marcação

- Laboratório

- Falta

- paisagem

- língua

- grande

- Maior

- mais tarde

- mais recente

- Ultimas atualizações

- Escritórios de

- camada

- líderes

- principal

- APRENDER

- aprendizagem

- Legal

- menos

- Alavancagem

- aproveita as

- como

- limitações

- Limitado

- lhama

- longo

- olhar

- lote

- máquina

- aprendizado de máquina

- a Principal

- fazer

- FAZ

- gerencia

- gestão

- muitos

- mercado

- pesquisa de mercado

- Marketing

- Campanhas de marketing

- marketplace

- maciço

- material

- max-width

- Posso..

- significado

- medicina

- Conheça

- Meta

- Métrica

- Microsoft

- e Microsoft Azure

- poder

- menor

- ML

- modelo

- modelos

- Monitore

- monitoração

- mais

- a maioria

- Mais populares

- nativo

- natural

- Linguagem Natural

- necessário

- você merece...

- necessário

- Cria

- negativo

- Neutro

- Novo

- Nova tecnologia

- Newsletter

- Próximo

- não técnico

- agora

- número

- of

- oferecer

- on

- ONE

- queridos

- só

- open source

- OpenAI

- operar

- Otimize

- or

- orquestração

- organização

- Outros

- Outros

- A Nossa

- Fora

- saída

- Visão geral

- próprio

- propriedade

- padrões

- realizar

- atuação

- realização

- Pilar

- oleoduto

- plataforma

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- players

- ponto

- Popular

- positivo

- possível

- poder

- poderoso

- Precisão

- Apresentações

- problemas

- processo

- em processamento

- produzir

- Produto

- desenvolvimento de produtos

- proeminente

- Promoção

- proprietário

- PROS

- fornecer

- fornecedores

- fornece

- fornecendo

- publicar

- fins

- Colocar

- qualificar

- qualidade

- consultas

- questão

- Frequentes

- alcance

- Leia

- receber

- recomendações

- registros

- liberar

- liberação

- relevante

- confiável

- representado

- solicitar

- pedidos

- requerer

- exige

- pesquisa

- Recursos

- Responder

- restrições

- resultar

- revendo

- Opinões

- certo

- riscos

- Execute

- corrida

- Segurança

- mesmo

- Salvar

- Escala

- Seção

- segurança

- Semicondutores

- sentimento

- separado

- Série

- serviço

- Serviços

- conjunto

- vários

- rede de apoio social

- assinar

- periodo

- de forma considerável

- solteiro

- Tamanho

- pequeno

- menor

- So

- Software

- Soluções

- alguns

- fonte

- específico

- Estabilidade

- pilha

- começo

- ficar

- Passos

- Ainda

- armazenamento

- Estratégia

- simplificar

- simplificada

- estilos

- tal

- suficiente

- RESUMO

- ajuda

- sistemas

- Tire

- toma

- Talento

- Target

- Tarefa

- tarefas

- Profissionais

- equipes

- tecnologia

- Dados Técnicos:

- suporte técnico

- Tecnologia

- inovação tecnológica

- modelo

- ensaio

- do que

- que

- A

- O Futuro

- deles

- Eles

- então

- Lá.

- Este

- deles

- isto

- aqueles

- milhares

- três

- Através da

- tempo

- demorado

- para

- TOM

- Tom de voz

- kit de ferramentas

- ferramentas

- topo

- TOPBOTS

- tradicional

- Trem

- treinado

- Training

- Transformar

- Transformação

- transparente

- tutoriais

- dois

- tipos

- tipicamente

- subjacente

- compreender

- compreensão

- único

- características únicas

- Atualizada

- Atualizações

- usar

- caso de uso

- usava

- Utilizador

- geralmente

- vário

- via

- voz

- vs

- queremos

- querido

- quer

- maneiras

- we

- web

- serviços web

- BEM

- foram

- quando

- se

- qual

- QUEM

- Largo

- Ampla variedade

- precisarão

- de

- sem

- palavras

- Atividades:

- seria

- Você

- investimentos

- zefirnet