Como inteligência artificial (AI) impulsionaram o centro da tecnologia, os investidores naturalmente sentem o cheiro de oportunidade no ar. Eles também sentem o cheiro dos formulários recém-impressos e da burocracia do regulador que está apenas esperando para receber sua parte e dificultar a máquina ruidosa da inovação da IA. Mas para aqueles que estão preocupados com a possibilidade de o Tio Sam esmagar a indústria através de novas regulamentações e restrições, eu diria que aqui se verifica exactamente o oposto: as regulamentações podem salvar a indústria de si mesma. E, por extensão, mais regulamentações para o setor protegem, e não prejudicam, os investidores.

Na maioria das novas indústrias, a palavra “regulação” é um tabu. Agora, a indústria de IA não é exatamente nova. O conceito moderno remonta à década de 1950, e tanto os investimentos privados como públicos neste campo aumentaram e diminuíram ao longo dos últimos 70 anos ou mais. A década de 1980 e o início da década de 1990 testemunharam uma ciclo de crescimento e queda em investimentos em inteligência artificial. Os investimentos do governo japonês na década de 80 deram início ao primeiro grande boom comercial da IA. No entanto, em 1993, “mais de 300 empresas fecharam as portas” quando a bolha estourou. No entanto, os avanços modernos no poder da computação e nos grandes modelos de linguagem (LLMs) deram uma nova vida à indústria, e o seu potencial não consiste apenas em atrair investidores, mas também reguladores.

Regulamentos de IA: uma confusão de interesses e riscos

A questão de saber o que a “regulamentação da IA” deveria ou mesmo poderia ser é uma questão para políticos, decisores políticos e especialistas em ética. O que os investidores querem saber é o que isso significaria para as suas carteiras, naturalmente. Quais são os maiores riscos? E é aqui que as leis e regulamentos podem proporcionar alguma proteção e ajudar a gerir esses riscos.

Os maiores riscos para os investidores resumem-se a três preocupações centrais sobrepostas: fraude, proteção da propriedade intelectual e privacidade. É claro que já existem leis em vigor que abordam todas essas três questões individualmente. O problema, porém, é que a IA representa uma combinação singularmente complicada dos três riscos que, sem quadros, leis e regulamentos claros, ameaçam o progresso de toda a indústria.

A preocupação mais urgente dessa lista para os investidores é a fraude. Quase todos concordam que a prevenção da fraude é um papel importante e vital da regulamentação.

Macacos fraudulentos que montam arame: dois estudos de caso

Dois estudos de caso mostram o futuro potencial das regulamentações de IA, o risco de fraude e os prazos regulamentares que os investidores devem esperar. Ambos também resumem como a fraude moldará as ações regulatórias que virão.

O primeiro é o mundo das criptomoedas e dos tokens não fungíveis (NFTs). Uma indústria significativamente mais nova que a IA, a criptografia viu seu quinhão de altos e baixos e, o mais importante, de fraudes. A Comissão de Valores Mobiliários (SEC) e a Comissão Federal de Comércio (FTC) passaram uma boa década tentando descobrir como encaixar a criptografia em seus esquemas regulatórios. O Congresso ainda não aprovou nenhuma legislação explícita relacionada à criptografia, apesar algumas tentativas.

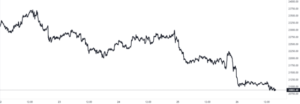

Nesse período, inúmeras bolsas subiram e entraram em colapso. Os NFTs deixaram de ser a moda em 2021 e 2022 para perdendo 95% do seu valor, levando consigo bilhões de dólares de investidores. De forma infame, o colapso da FTX e o ensaio recente de Sam Bankman-Fried envolveu milhares de milhões de dólares em fundos utilizados de forma fraudulenta.

O segundo estudo de caso aqui é o da segurança cibernética. Ao contrário da criptografia, existem algumas leis básicas estabelecidas para a indústria. As duas primeiras leis “verdadeiras” de segurança cibernética foram a Lei de Fraude e Abuso de Computadores de 1986 e a Lei de Controle Abrangente do Crime de 1984. Ambas se basearam em entendimentos criativos e relativamente novos de “fios” (como nos fios telegráficos) e fraude eletrônica.

Nas décadas seguintes, o Congresso aprovou leis fragmentadas sobre temas cibernéticos com resultados mistos. Isso resultou em estados compensando a folga. O mundo da cibersegurança também fornece um exemplo de uma indústria com interesses profundamente interligados, muitos dos quais não são diferentes dos riscos e pontos cegos regulamentares que a indústria da inteligência artificial enfrenta. Um dos mais notáveis é a privacidade. As preocupações com a privacidade individual, normalmente associadas às redes sociais e à Internet das Coisas (IoT), também surgem com os modelos de formação em IA.

Ambos os exemplos aqui fornecem lições para a indústria de IA em rápido crescimento. O ambiente de alto risco, alta recompensa e baixa regulamentação do mundo criptográfico está repleto de fraudes e instabilidade. A cibersegurança é uma indústria muito mais antiga e estabelecida, mas o ambiente regulamentar ainda é irregular, especialmente no que diz respeito à privacidade.

O estado atual dos regulamentos de IA

Assim, para se ter uma ideia de quais destes caminhos regulatórios os investidores devem esperar, vejamos o atual ambiente regulatório para a inteligência artificial.

Começando pelo cenário doméstico, bom… não tem muita coisa, pelo menos legislativamente. O Presidente Joe Biden, por outro lado, tem estado ocupado a forjar um caminho regulamentar através de um compromisso voluntário e, mais recentemente e mais importante, de uma Ordem Executiva histórica e abrangente.

No início deste ano, a Casa Branca anunciou um compromisso voluntário não vinculativo de “gerenciar os riscos apresentados pela IA.” Entre os signatários deste compromisso estão alguns grandes nomes como Amazon (NASDAQ:AMZN), Metaplataformas (NASDAQ:META), Alfabeto (NASDAQ:GOOGNASDAQ:GOOGL) e OpenAI. O Escritório de Política Científica e Tecnológica (OSTP), um departamento da Casa Branca, também publicou um “Plano para uma Declaração de Direitos da IA.” Outra estrutura notavelmente voluntária para o uso seguro e ético da IA.

De acordo com a Casa Branca, o “uso seguro e ético da IA” requer “testes pré-implantação” rigorosos e é criado com “consultas de diversas comunidades, partes interessadas e especialistas do domínio para identificar preocupações, riscos e impactos potenciais do sistema”. Os sistemas de IA também devem ter “avaliação e relatórios independentes” para garantir que permanecem seguros a longo prazo.

Ordem Executiva de IA de Biden

Nas primeiras horas da manhã de 30 de outubro, a Casa Branca anunciou o impulso regulatório mais abrangente em relação à IA. Impulsionar esse esforço foi um Ordem Executiva abrangente (e um novo e elegante site do Network Development Group) cobrindo tudo, desde segurança e proteção até privacidade, direitos civis e muito mais. Esta Ordem Executiva baseia-se no compromisso voluntário acima mencionado e na Declaração de Direitos da IA, e concentra-se predominantemente no que a maioria das Ordens Executivas faz: mobilizar os muitos departamentos e agências do Poder Executivo para a ação.

Há muitos detalhes a serem resolvidos sobre como esta Ordem Executiva impactará o setor, mas as conclusões mais significativas para os investidores são:

1. Levará algum tempo até que os reguladores desenvolvam estas novas directrizes e políticas.

2. Quaisquer regulamentos específicos que surjam desta OE serão construídos sobre bases jurídicas instáveis até que o Congresso aprove leis relacionadas com a IA. Ainda depende do cumprimento voluntário, com uma exceção importante: a Lei de Produção de Defesa (DPA).

A invocação do DPA por Biden é tão notável quanto confusa. O DPA foi a única lei explícita que a EO faz referência com algumas implicações potencialmente poderosas. O DPA foi utilizado mais recentemente no contexto da pandemia de Covid-19, mas está normalmente associado à produção em tempos de guerra. Biden está usando isso aqui num contexto puramente de segurança nacional:

“… a Ordem exigirá que as empresas que desenvolvam qualquer modelo básico que represente um sério risco para a segurança nacional, a segurança econômica nacional ou a saúde e segurança públicas nacionais notifiquem o governo federal ao treinar o modelo e compartilhem os resultados de todas as red- testes de segurança da equipe.”

Não está claro quem está coberto por este “processo de revisão” apoiado pela DPA, uma vez que outras agências têm responsabilidades regulatórias mais específicas. Por exemplo, o Instituto Nacional de Padrões e Tecnologia (NIST) deve desenvolver padrões de segurança de IA e o Departamento de Segurança Interna (DHS) é implementá-los em infraestruturas críticas. Talvez mais importante ainda, é necessário esclarecimento sobre qual agência implementará esta política.

Há um candidato notável que a DPA cobriria quase definitivamente devido aos seus contratos de defesa existentes: Palantir (NYSE:PLTR). O Big Data e o empreiteiro de defesa cada vez mais focado em IA não são signatários do acordo da Casa Branca promessa voluntária. Isto pode ter mais a ver com as tendências políticas conservadoras-libertárias do presidente da Palantir, Peter Thiel, e com o apoio ao ex-presidente Donald Trump do que com uma rejeição total de mais regulamentação. No entanto, esta omissão é notável porque Palantir tem grandes planos para “tomando todo o mercado de IA.”

No seu conjunto, o quadro regulamentar estabelecido pela Ordem Executiva de Biden é inovador e prepara o Congresso para construir o resto da casa reguladora, por assim dizer.

Infelizmente, poderemos esperar um bom tempo até que os legisladores comecem a “derramar o concreto”.

E o Congresso?

A Ordem Executiva de IA da Casa Branca faz apenas duas referências ao Congresso, mas ambas são apelos para que o Congresso aprove leis bipartidárias sobre IA (uma tratava explicitamente da aprovação de uma lei de privacidade).

De acordo com o Brennan Center For Justice, o Congresso cerca de 60 contas relacionadas à IA participando de diversas comissões.

No entanto, no momento em que este livro foi escrito, a Câmara dos Representantes acabava de chegar a acordo sobre um novo Presidente da Câmara e tem “peixes maiores para fritar”, com mais um prazo iminente de paralisação do governo e a batalha orçamental que a acompanha se aproximando. Para não mencionar as controversas leis de ajuda de Israel e da Ucrânia e uma série de outras preocupações mais prementes.

Isso deixa duas outras fontes de regulamentação da IA: estados individuais dos EUA e intervenientes internacionais. O primeiro grupo, composto por apenas alguns dos 50 estados do país, passou uma colcha de retalhos de leis relevantes, sendo a IA e a privacidade do consumidor o foco principal. A nível internacional, a China está a liderar o caminho na construção de uma conjunto complexo e avançado dos regulamentos de IA. O quadro regulamentar abrangente da União Europeia, simplesmente intitulado “Lei de IA,” deverá ser finalizado e aprovado até o final do ano.

Regulamentos de IA e o que o futuro reserva

Então, onde fica esta indústria em rápido crescimento e potencialmente altamente disruptiva? Será que seguirá o caminho da criptografia para a regulamentação, que tem sido repleta de fraudes e instabilidade? Ou o caminho mais lento e estável, mas ainda irregular, da segurança cibernética. Bem, por enquanto, pelo menos nos Estados Unidos, provavelmente será uma mistura dos dois.

A IA tem o potencial disruptivo e lucrativo com que a indústria de criptografia só pode sonhar. No entanto, também tem o potencial e a utilidade mainstream que a indústria da segurança cibernética proporciona. Para os investidores, e para não parecer muito sensacionalista aqui, para a humanidade, essa é uma combinação arriscada.

Existem inúmeras aplicações potenciais da IA no mundo real, desde a agricultura à defesa, às finanças e à saúde. Uma criptografia pode defraudar o dinheiro dos investidores, ou um hacker pode roubar dinheiro de um banco, mas os riscos de acidentes de IA ou comportamento malicioso poderia ser catastrófico.

As hipóteses sobre o que poderia dar errado são infinitas à medida que a IA é incorporada na vida cotidiana. Mas já estamos vendo casos preocupantes de uso malicioso de IA. O recente início da guerra Israel-Hamas assistiu a uma enxurrada de desinformação em plataformas de redes sociais como o X, antigo Twitter. Algumas das imagens falsas compartilhadas online são geradas por IA, muitas vezes criadas com ferramentas de fácil acesso, como o Gerador de Imagens do Bing. Com a tecnologia cada vez melhor, será mais difícil identificar imagens e vídeos falsos.

Também estamos enfrentando riscos que antes só eram encontrados na ficção científica, como “IAs desonestas”. Enquanto planejador de refeições com IA sugerindo acidentalmente uma receita para gás cloro vale a pena rir hoje, seria muito menos engraçado se fosse uma IA encarregada de, digamos, uma fazenda automatizada em grande escala contaminar acidentalmente (ou pior, intencionalmente) uma colheita de vegetais.

Como diz o ditado: “As normas de segurança estão escritas com sangue”. E realmente não deveríamos ter que esperar até que o sangue fosse derramado antes de agir.

Legalmente, já existe uma “marreta” de um processo contra o Google que, segundo a empresa, destruir o conceito de IA generativa. O que a indústria precisa para evitar este destino são regulamentações claras e aplicáveis que possam proteger tanto o público como as empresas de IA da ira legal umas das outras.

Para o bem dos investidores e de todos, é necessária mais supervisão regulamentar sobre a indústria da inteligência artificial antes que algo corra terrivelmente errado. A nova Ordem Executiva da Casa Branca proporciona um quadro muito abrangente sobre inúmeras questões relacionadas com a IA e é um bom começo. No entanto, sem leis aprovadas pelo Congresso que proporcionem uma base sólida sobre a qual os reguladores possam construir, acabaremos com uma confusão de reguladores confusos ao estilo criptográfico. Isto só levará à confusão dos participantes do mercado e dos investidores. E com o potencial da IA sendo tão grande e perigoso, isso não é algo que alguém deveria querer.

Então não, os regulamentos de IA não são "o inimigo," como afirmou o manifesto de um capitalista de risco, mas podem funcionar como barreiras de segurança que podem ajudar a proteger a indústria e os investidores de riscos enormes.

O que os investidores devem fazer agora

Sem barreiras claras, investir no mundo da inteligência artificial é um negócio arriscado. Os investidores que não estão muito preocupados com o impacto destas regulamentações desmanteladas podem fazer apostas mais arriscadas na série de startups que tentam enriquecer. Ou em peças estabelecidas, mas que rejeitam a regulamentação, como Palantir.

Caso contrário, seria melhor para os investidores verem quais as empresas que estão a “jogar bola” com o compromisso voluntário da Casa Branca. Ou aqueles que estão a adaptar-se às mudanças regulamentares internacionais provenientes da UE e da China. Essas empresas provavelmente veem essas novas regulamentações como algo com o qual podem conviver ou como algo que podem usar em seu benefício.

De qualquer forma, o martelo da regulamentação cairá num momento ou outro. Seria melhor para todos, e não apenas para os investidores, que caísse antes que a segunda metade da expressão “aja rápido e quebre as coisas” quebre a indústria de IA.

Na data da publicação, Andrew Bush ocupava uma posição LONG em ações GOOGL e AMZN. As opiniões expressas neste artigo são de responsabilidade do redator, sujeitas às Diretrizes de Publicação do InvestorPlace.com.

Andrew Bush é editor de notícias financeiras da InvestorPlace e possui dois diplomas em Assuntos Internacionais. Ele trabalhou na educação, no setor de tecnologia e como analista de pesquisa para uma empresa de consultoria focada em segurança nacional com sede em DC.

#Regulação #Salvar #Humanidade #IA.. #Salvar #Ações

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://cryptoinfonet.com/regulation/we-need-regulation-to-save-humanity-from-ai-and-to-save-ai-stocks/

- :tem

- :é

- :não

- :onde

- $UP

- 2021

- 2022

- 30

- 300

- 50

- 60

- 70

- 95%

- a

- Sobre

- abuso

- acessível

- acidentes

- Segundo

- Aja

- Açao Social

- ações

- atores

- real

- endereço

- avançado

- avanços

- Vantagem

- Negócios

- contra

- agências

- agência

- concordando

- agricultura

- AI

- Sistemas de IA

- Treinamento de IA

- Ajuda

- AR

- Todos os Produtos

- quase

- Alfabeto

- já

- tb

- Amazon

- entre

- an

- analista

- e

- Andrew

- anunciou

- Outro

- qualquer

- qualquer um

- Macacos

- aplicações

- SOMOS

- argumentar

- surgir

- artigo

- artificial

- inteligência artificial

- AS

- associado

- At

- atraindo

- Automatizado

- evitar

- em caminho duplo

- Bank

- Banqueiro Frito

- Batalha

- BE

- tornam-se

- sido

- antes

- comportamento

- ser

- MELHOR

- apostas

- Melhor

- Biden

- Grande

- Big Data

- O maior

- Projeto de lei

- bilhões

- Contas inclusas

- bipartidário

- blending

- cego

- sangue

- Bloomberg

- Livros

- estrondo

- ambos

- Break

- quebra

- bolha

- orçamento

- construir

- Prédio

- Constrói

- construído

- negócio

- bustos

- ocupado

- mas a

- by

- chamadas

- CAN

- candidato

- casas

- Estudos de Caso

- estudo de caso

- casos

- Centralização de

- centro do palco

- presidente

- Alterações

- carregar

- China

- civil

- Direitos civis

- remover filtragem

- fechado

- menos -

- colapso

- COM

- como

- vinda

- comercial

- de referência

- geralmente

- Comunidades

- Empresas

- Empresa

- compliance

- complicado

- compreensivo

- Composto

- computador

- computação

- poder de computação

- conceito

- Interesse

- preocupado

- Preocupações

- concreto

- confuso

- Congresso

- consultor

- consumidor

- privacidade do consumidor

- contexto

- continuar

- Contratante

- contratos

- ao controle

- núcleo

- poderia

- país

- curso

- cobrir

- coberto

- cobertura

- Covid-19

- Pandemia de COVID-19

- criado

- Criatividade

- Crime

- crítico

- Infraestrutura crítica

- colheita

- cripto

- Indústria de criptografia

- criptomoedas

- CriptoInfonet

- Atual

- Estado atual

- Cortar

- cibernético

- Cíber segurança

- Perigoso

- dados,

- Data

- Baseado em DC

- prazo de entrega

- década

- décadas

- profundo

- Defesa

- definitivamente

- Departamento

- Departamento de Segurança Interna

- departamentos

- dependente

- Apesar de

- detalhes

- desenvolver

- em desenvolvimento

- desenvolvimentos

- disruptivo

- diferente

- do

- parece

- dólares

- domínio

- Doméstico

- donald

- Donald Trump

- down

- seu "Sonho"

- condução

- dois

- cada

- Cedo

- facilmente

- Econômico

- editor

- Educação

- esforço

- ou

- final

- Interminável

- exequível

- enorme

- Todo

- Meio Ambiente

- especialmente

- estabelecido

- considerações éticas

- EU

- Europa

- Europa

- avaliação

- Mesmo

- cotidiano

- todos

- tudo

- exatamente

- exemplo

- exemplos

- exceção

- exchange

- Comissão de Intercâmbio

- Trocas

- executivo

- ordem executiva

- existente

- esperado

- esperando

- especialistas

- explicitamente

- expressa

- expressão

- extensão

- enfrentando

- feira

- falsificação

- Cair

- longe

- fazenda

- RÁPIDO

- destino

- Federal

- Governo federal

- Federal Trade Commission

- poucos

- Ficção

- campo

- Figura

- finalizado

- financiar

- financeiro

- notícias financeiras

- Empresa

- empresas

- Primeiro nome

- Fish

- caber

- inundação

- Foco

- concentra-se

- Escolha

- para Investidores

- Forbes

- Forjar

- Antigo

- Antigamente

- formas

- adiante

- encontrado

- Foundation

- Quadro

- enquadramentos

- fraude

- PREVENÇÃO DE FRAUDE

- da

- FTX

- fundos

- mais distante

- futuro

- Futuro da IA

- generativo

- gerador

- ter

- dado

- Go

- vai

- Bom estado, com sinais de uso

- Governo

- ótimo

- Solo

- inovador

- Grupo

- Crescente

- orientações

- cabouqueiro

- Metade

- martelo

- mão

- punhado

- mais duro

- prejudicar

- Ter

- he

- Saúde

- saúde

- Herói

- ajudar

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- alto risco

- altamente

- detém

- pátria

- Segurança Interna

- hospedeiro

- HORÁRIO

- House

- casa de representantes

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- HTTPS

- Humanidade

- i

- idéia

- identificar

- if

- imagem

- imagens

- Impacto

- Impacto

- iminente

- executar

- implicações

- importante

- importante

- in

- Incorporado

- cada vez mais

- Individual

- Individualmente

- indústrias

- indústria

- da indústria

- Infraestrutura

- Inovação

- instabilidade

- Instituto

- intelectual

- propriedade intelectual

- proteção da propriedade intelectual

- Inteligência

- intencionalmente

- interesses

- Internacionais

- Internacionalmente

- Internet

- internet das coisas

- para dentro

- investir

- Investimentos

- Investidores

- envolvido

- iot

- Israel

- questões

- IT

- ESTÁ

- se

- Japonês

- joe

- Joe Biden

- apenas por

- Justiça

- Kickstarted

- Saber

- ponto de referência

- língua

- grande

- em grande escala

- Escritórios de

- legisladores

- Leis

- Leis e regulamentos

- conduzir

- principal

- mínimo

- Deixar

- Legal

- Legislação

- menos

- lições

- vida

- como

- Provável

- LINK

- Lista

- viver

- longo

- olhar

- iminente

- máquina

- Corrente principal

- principal

- fazer

- FAZ

- gerencia

- manifesto

- muitos

- mercado

- significar

- Mídia

- mencionar

- Meta

- META PLATAFORMAS

- poder

- Desinformação

- misturar

- modelo

- modelos

- EQUIPAMENTOS

- dinheiro

- fazer dinheiro

- mais

- manhã

- a maioria

- muito

- devo

- miríade

- nomes

- Nasdaq

- Nacional

- segurança nacional

- Navegação

- você merece...

- necessário

- Cria

- Novo

- mais novo

- notícias

- NTF`s

- nist

- não

- não fungível

- fichas não fungíveis

- TOKENS NÃO FUNGÍVEIS (NFTS)

- notável

- notavelmente

- agora

- numeroso

- NYSE

- Out

- of

- WOW!

- Office

- frequentemente

- mais velho

- on

- uma vez

- ONE

- online

- só

- OpenAI

- Opiniões

- Oportunidade

- oposto

- or

- ordem

- ordens

- OSTP

- Outros

- Fora

- abertamente

- Acima de

- Supervisão

- pandemia

- participantes

- passar

- passou

- passes

- Passagem

- passado

- caminho

- possivelmente

- Peter

- planos

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- desempenha

- penhor

- ponto

- políticas

- Privacidade

- formuladores de políticas

- político

- Políticos

- carteiras

- colocada

- coloca

- posição

- potencial

- potencialmente

- poder

- poderoso

- presidente

- Presidente Donald Trump

- presidente joe biden

- premente

- Prevenção

- primário

- política de privacidade

- privado

- Problema

- Produção

- Progresso

- propriedade

- proteger

- proteção

- fornecer

- fornece

- fornecendo

- público

- saúde pública

- Publicação

- publicado

- Publishing

- puramente

- Empurrar

- colocar

- questão

- bastante

- Rage

- faixas

- rapidamente

- Leitura

- mundo real

- clientes

- recentemente

- recentemente

- receita

- Vermelho

- referências

- em relação a

- Regulamento

- regulamentos

- regulador

- Reguladores

- reguladores

- relativamente

- relevante

- Representantes

- representa

- requerer

- exige

- pesquisa

- responsabilidades

- DESCANSO

- restrições

- resultou

- Resultados

- Reuters

- Rico

- equitação

- direitos

- rigoroso

- Ressuscitado

- Risco

- riscos

- Arriscado

- Tipo

- puxar tapete

- Execute

- s

- seguro

- Segurança

- Segurança e Protecção

- saquê

- Sam

- Sam Bankman-Fried

- Salvar

- serra

- dizer

- dizendo

- cena

- esquemas

- Ciência

- Ciência e Tecnologia

- Ficção científica

- SEC

- Segundo

- setor

- Valores mobiliários

- Securities and Exchange Commission

- segurança

- Vejo

- visto

- visto

- grave

- conjunto

- Shape

- Partilhar

- compartilhado

- derramar

- rede de apoio social

- mostrar

- encerramento

- signatários

- signatário

- periodo

- de forma considerável

- simplesmente

- desde

- Sentado

- folga

- Lustroso

- Cheiro

- So

- Redes Sociais

- meios de comunicação social

- sociais plataformas de mídia

- sólido

- alguns

- algo

- Parecer

- Fontes

- falar

- Palestrantes

- específico

- gasto

- pontos

- estável

- Etapa

- partes interessadas

- padrões

- começo

- Startups

- Estado

- Unidos

- ficar

- Ainda

- estoque

- Ações

- greve

- caso

- Estudo

- sujeito

- ajuda

- certo

- .

- sistemas

- Tire

- Takeaways

- tomar

- fita

- tecnologia

- setor de tecnologia

- Tecnologia

- testes

- do que

- que

- A

- O Futuro

- o mundo

- deles

- Eles

- Lá.

- Este

- deles

- coisas

- isto

- este ano

- aqueles

- Apesar?

- ameaçar

- três

- Através da

- impulso

- tempo

- intitulado

- para

- hoje

- juntos

- Tokens

- também

- ferramentas

- Temas

- comércio

- Training

- perturbador

- verdadeiro

- acima

- tentando

- dois

- tipicamente

- nos

- Ucrânia

- não está claro

- para

- unicamente

- Unido

- Estados Unidos

- ao contrário

- até

- sobre

- Uso

- usar

- usava

- utilização

- utilidade

- vário

- Legumes

- risco

- muito

- via

- VÍDEOS

- vital

- voluntário

- esperar

- Esperando

- queremos

- guerra

- foi

- Caminho..

- we

- BEM

- fui

- foram

- O Quê

- o que quer

- quando

- qual

- enquanto

- branco

- a Casa Branca

- QUEM

- inteiro

- precisarão

- Fio

- Fraude eletrônica

- de

- dentro

- sem

- Word

- trabalhou

- mundo

- do mundo

- preocupado

- pior

- Equivalente há

- seria

- escritor

- escrita

- escrito

- Errado

- X

- ano

- anos

- ainda

- zefirnet