Após anos de desenvolvimento, a Meta pode finalmente lançar seus aceleradores de IA desenvolvidos internamente de forma significativa este ano.

O império do Facebook confirmou seu desejo de complementar as implantações das GPUs Nvidia H100 e AMD MI300X com sua família de chips Meta Training Inference Accelerator (MTIA) esta semana. Especificamente, a Meta implantará um processador otimizado para inferência, supostamente codinome Artemis, baseado nas peças de primeira geração da gigante do Vale do Silício provocado ano passado.

“Estamos entusiasmados com o progresso que fizemos em nossos esforços internos de silício com a MTIA e estamos no caminho certo para começar a implantar nossa variante de inferência em produção em 2024”, disse um porta-voz da Meta. O registro na quinta-feira.

“Vemos que nossos aceleradores desenvolvidos internamente são altamente complementares às GPUs disponíveis comercialmente, fornecendo a combinação ideal de desempenho e eficiência em cargas de trabalho específicas do Meta”, continuou o representante. Detalhes? Não. O porta-voz nos disse: “Estamos ansiosos para compartilhar mais atualizações sobre nossos planos futuros de MTIA ainda este ano”.

Estamos entendendo que isso significa que o chip focado em inferência de segunda geração está sendo amplamente implementado, seguindo uma versão de primeira geração somente para laboratório para inferência, e podemos descobrir mais tarde sobre peças destinadas principalmente ao treinamento ou treinamento e inferência.

A Meta se tornou um dos melhores clientes da Nvidia e da AMD à medida que sua implantação de cargas de trabalho de IA cresceu, aumentando sua necessidade e uso de silício especializado para fazer seu software de aprendizado de máquina funcionar o mais rápido possível. Assim, a decisão da gigante Instagram de desenvolver os seus próprios processadores personalizados não é tão surpreendente.

Na verdade, a megacorporação, aparentemente, está relativamente atrasada para a festa do silício de IA personalizado em termos de implantação no mundo real. A Amazon e o Google têm usado componentes internos para acelerar sistemas internos de aprendizado de máquina, como modelos de recomendação e código de ML do cliente há alguns anos. Enquanto isso, a Microsoft revelou seus aceleradores locais no ano passado.

Mas, além do fato de a Meta estar lançando um chip de inferência MTIA em escala, a rede social não divulgou sua arquitetura precisa nem quais cargas de trabalho está reservando para silício interno e quais está descarregando para as GPUs da AMD e da Nvidia.

É provável que o Meta execute modelos estabelecidos em seus ASICs personalizados para liberar recursos de GPU para aplicativos mais dinâmicos ou em evolução. Já vimos o Meta seguir esse caminho antes com aceleradores personalizados projetados para descarregar dados e calcular cargas de trabalho intensivas de vídeo.

Quanto ao design subjacente, os observadores da indústria na SemiAnalysis nos dizem que o novo chip é baseado na arquitetura das peças de primeira geração do Meta.

Trampolins

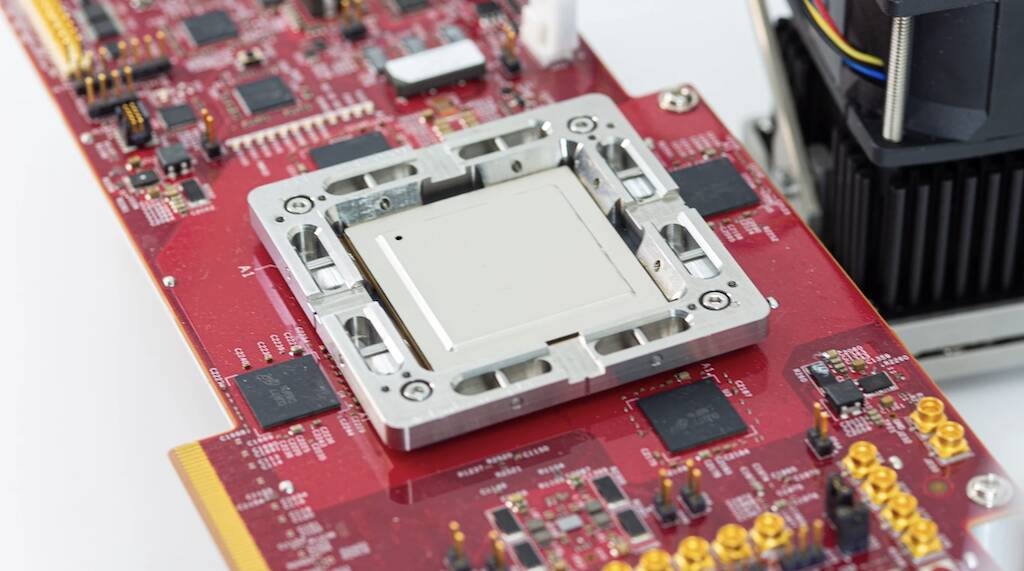

Anunciadas no início de 2023, após três anos de desenvolvimento, as peças MTIA v1 da Meta, que nossos amigos da A próxima plataforma olhou na primavera passada, foram projetados especificamente com modelos de recomendação de aprendizado profundo em mente.

O chip de primeira geração foi construído em torno de um cluster de CPU RISC-V e fabricado usando o processo de 7nm da TSMC. Nos bastidores, o componente empregava uma matriz de oito por oito de elementos de processamento, cada um equipado com dois núcleos de CPU RV, um dos quais equipado com extensões matemáticas vetoriais. Esses núcleos são alimentados por generosos 128 MB de SRAM no chip e até 128 GB de memória LPDDR5.

Como a Meta afirmou no ano passado, o chip funcionou a 800 MHz e atingiu 102.4 trilhões de operações por segundo de desempenho INT8 ou 51.2 teraFLOPS com meia precisão (FP16). Em comparação, o H100 da Nvidia é capaz de quase quatro petaFLOPS de desempenho esparso de FP8. Embora nem de longe tão poderoso quanto as GPUs da Nvidia ou da AMD, o chip tinha uma grande vantagem: consumo de energia. O chip em si tinha uma potência térmica de apenas 25 watts.

De acordo com o SemiAnálise, O chip mais recente da Meta possui núcleos aprimorados e comercializa LPDDR5 por memória de alta largura de banda empacotada usando a tecnologia chip-on-wafer-on-substrate (CoWoS) da TSMC.

Outra diferença notável é que o chip de segunda geração da Meta terá uma implantação generalizada em sua infraestrutura de datacenter. De acordo com o titã do Facebook, embora a peça de primeira geração tenha sido usada para executar modelos de publicidade de produção, ela nunca saiu do laboratório.

Perseguindo a inteligência artificial geral

Deixando de lado as peças personalizadas, o pai do Facebook e Instagram descartou bilhões de dólares em GPUs nos últimos anos para acelerar todos os tipos de tarefas inadequadas para plataformas de CPU convencionais. No entanto, o surgimento de grandes modelos de linguagem, como GPT-4 e o próprio Llama 2 do Meta, mudou o cenário e impulsionou a implantação de enormes clusters de GPU.

Na escala em que a Meta opera, essas tendências exigiram mudanças drásticas em sua infraestrutura, incluindo o redesenhar de vários datacenters para dar suporte aos imensos requisitos de energia e resfriamento associados a grandes implantações de IA.

E as implantações do Meta só vão aumentar nos próximos meses, à medida que a empresa muda o foco do metaverso para o desenvolvimento de inteligência artificial geral. Supostamente, o trabalho realizado em IA ajudará a formar o metaverso ou algo parecido.

De acordo com o CEO Mark Zuckerberg, a Meta planeja implantar até 350,000 Nvidia H100 somente este ano.

A empresa também anunciou planos para implantar o novo lançado GPUs MI300X em seus datacenters. Zuckerberg afirmou que sua empresa terminaria o ano com o poder computacional equivalente a 600,000 mil H100s. Claramente, os chips MTIA da Meta não substituirão as GPUs tão cedo. ®

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://go.theregister.com/feed/www.theregister.com/2024/02/02/meta_ai_chips/

- :tem

- :é

- $UP

- 000

- 102

- 2%

- 2023

- 2024

- 25

- 350

- 4

- 51

- 600

- 800

- a

- Sobre

- acelerar

- acelerador

- aceleradores

- Segundo

- em

- Vantagem

- Publicidade

- Depois de

- AI

- Todos os Produtos

- sozinho

- ao lado de

- tb

- Amazon

- AMD

- an

- e

- anunciou

- aplicações

- arquitetura

- SOMOS

- por aí

- artificial

- inteligência geral artificial

- AS

- Asics

- de lado

- associado

- At

- disponível

- baseado

- BE

- tornam-se

- sido

- antes

- MELHOR

- Pós

- biz

- ostenta

- construído

- by

- capaz

- Chefe executivo

- mudado

- Alterações

- lasca

- Chips

- afirmou

- claramente

- de perto

- Agrupar

- CO

- código

- comercialmente

- Empresa

- comparação

- complementar

- componente

- componentes

- Computar

- computação

- poder de computação

- CONFIRMADO

- consumo

- continuou

- convencional

- CORPORAÇÃO

- CPU

- personalizadas

- cliente

- Clientes

- dados,

- Datacenter

- decisão

- entregando

- implantar

- Implantação

- desenvolvimento

- Implantações

- Design

- projetado

- desejo

- detalhes

- desenvolver

- desenvolvido

- Desenvolvimento

- DID

- diferença

- dólares

- feito

- down

- dirigido

- dinâmico

- cada

- Cedo

- eficiência

- esforços

- ou

- elementos

- império

- empregada

- final

- equipado

- Equivalente

- estabelecido

- Éter (ETH)

- evolução

- animado

- extensões

- Rosto

- fato

- família

- RÁPIDO

- Alimentado

- poucos

- Finalmente

- Encontre

- Foco

- seguinte

- Escolha

- formulário

- para a frente

- quatro

- Gratuito

- amigos

- da

- futuro

- Geral

- inteligência geral

- generoso

- ter

- gigante

- Go

- vai

- GPU

- GPUs

- crescido

- tinha

- Metade

- Ter

- ajudar

- altamente

- sua

- homegrown

- capuz

- Contudo

- HTTPS

- imenso

- melhorado

- in

- Incluindo

- aumentando

- indústria

- Infraestrutura

- Inteligência

- Pretendido

- intensivo

- interno

- internamente

- isn

- IT

- ESTÁ

- se

- jpg

- apenas por

- laboratório

- paisagem

- língua

- grande

- Maior

- Sobrenome

- Ano passado

- Atrasado

- mais tarde

- mais recente

- esquerda

- como

- Provável

- lhama

- olhar

- moldadas

- principal

- fazer

- maneira

- muitos

- marca

- marcar zuckerberg

- maciço

- matemática

- Matriz

- Posso..

- significar

- significativo

- Entretanto

- Memória

- Meta

- metaverso

- Microsoft

- mente

- misturar

- ML

- modelos

- mês

- mais

- Perto

- quase

- você merece...

- rede

- nunca

- Novo

- novo chip

- recentemente

- Próximo

- nem

- notável

- Nvidia

- of

- on

- ONE

- só

- opera

- Operações

- ideal

- or

- A Nossa

- Fora

- Acima de

- próprio

- empacotado

- parte

- peças

- festa

- para

- atuação

- planos

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- possível

- poder

- poderoso

- preciso

- Precisão

- principalmente

- processo

- em processamento

- Subcontratante

- processadores

- Produção

- Progresso

- RE

- mundo real

- recentemente

- relativamente

- Requisitos

- Recursos

- Reuters

- Revelado

- Subir

- Rolo

- rolando

- Rota

- Execute

- s

- Escala

- Segundo

- Vejo

- visto

- vários

- compartilhando

- Turnos

- Silício

- Vale do Silício

- So

- Redes Sociais

- rede social

- Software

- alguns

- algo

- Em breve

- escasso

- especializado

- especificamente

- porta-voz

- primavera

- começo

- tal

- completar

- ajuda

- surpreendente

- sistemas

- T

- tomar

- tarefas

- tecnologia

- dizer

- condições

- que

- A

- A paisagem

- O Metaverso

- térmico

- Este

- isto

- esta semana

- este ano

- três

- quinta-feira

- Assim

- titã

- para

- disse

- coberto

- pista

- trades

- Training

- Tendências

- Trilhão

- TSMC

- dois

- para

- subjacente

- Atualizações

- us

- usar

- usava

- utilização

- v1

- Vale

- Variante

- Ve

- vetor

- versão

- Vídeo

- foi

- Caminho..

- we

- semana

- foram

- qual

- enquanto

- largamente

- generalizada

- precisarão

- de

- Ganhou

- Atividades:

- seria

- ano

- anos

- zefirnet

- Zuckerberg