Imagem do autor

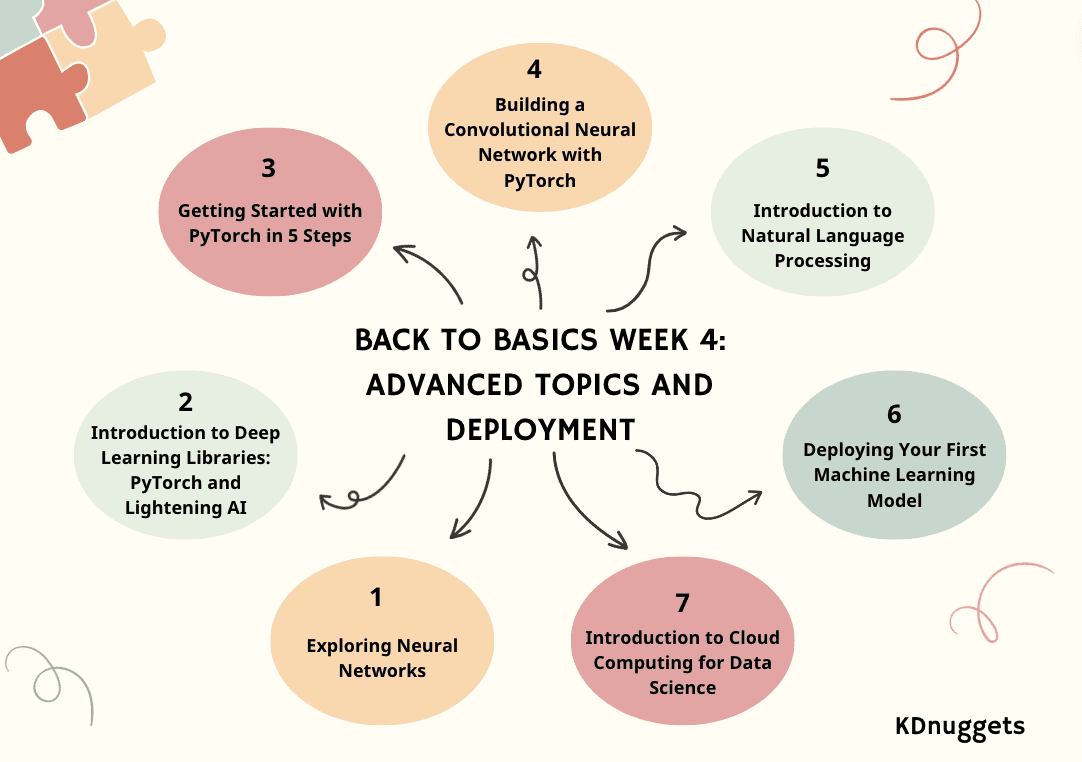

Junte-se ao KDnuggets com nosso caminho Back to Basics para começar uma nova carreira ou aprimorar suas habilidades em ciência de dados. O caminho Back to Basics é dividido em 4 semanas com uma semana de bônus. Esperamos que você possa usar esses blogs como um guia de curso.

Se ainda não o fez, dê uma olhada em:

Passando para a terceira semana, nos aprofundaremos em tópicos avançados e implantação.

- Dia 1: Explorando Redes Neurais

- Dia 2: Introdução às bibliotecas de aprendizagem profunda: PyTorch e Lightening AI

- Dia 3: Primeiros passos com PyTorch em 5 etapas

- Dia 4: Construindo uma Rede Neural Convolucional com PyTorch

- Dia 5: Introdução ao Processamento de Linguagem Natural

- Dia 6: Implantando seu primeiro modelo de aprendizado de máquina

- Dia 7: Introdução à computação em nuvem para ciência de dados

Semana 4 – Parte 1: Explorando Redes Neurais

Desbloqueando o poder da IA: um guia para redes neurais e suas aplicações.

Imagine uma máquina pensando, aprendendo e se adaptando como o cérebro humano e descobrindo padrões ocultos nos dados.

Esta tecnologia, Redes Neurais (NN), algoritmos estão imitando a cognição. Exploraremos o que são NNs e como funcionam mais tarde.

Neste artigo, explicarei os aspectos fundamentais das Redes Neurais (NN) – estrutura, tipos, aplicações na vida real e termos-chave que definem o funcionamento.

Semana 4 – Parte 2: Introdução às bibliotecas de aprendizado profundo: PyTorch e Lightning AI

Uma explicação simples de PyTorch e Lightning AI.

O aprendizado profundo é um ramo do modelo de aprendizado de máquina baseado em redes neurais. No outro modelo de máquina, o processamento de dados para encontrar as características significativas é muitas vezes feito manualmente ou com base na experiência do domínio; entretanto, o aprendizado profundo pode imitar o cérebro humano para descobrir os recursos essenciais, aumentando o desempenho do modelo.

Existem muitas aplicações para modelos de aprendizagem profunda, incluindo reconhecimento facial, detecção de fraudes, conversão de fala em texto, geração de texto e muito mais. O aprendizado profundo se tornou uma abordagem padrão em muitos aplicativos avançados de aprendizado de máquina e não temos nada a perder aprendendo sobre eles.

Para desenvolver este modelo de aprendizagem profunda, existem várias estruturas de biblioteca nas quais podemos confiar, em vez de trabalharmos do zero. Neste artigo, discutiremos duas bibliotecas diferentes que podemos usar para desenvolver modelos de aprendizagem profunda: PyTorch e Lighting AI.

Semana 4 – Parte 3: Primeiros passos com PyTorch em 5 etapas

Este tutorial fornece uma introdução detalhada ao aprendizado de máquina usando PyTorch e seu wrapper de alto nível, PyTorch Lightning. O artigo aborda etapas essenciais desde a instalação até tópicos avançados, oferecendo uma abordagem prática para construir e treinar redes neurais e enfatizando os benefícios do uso do Lightning.

PyTorch é uma estrutura popular de aprendizado de máquina de código aberto baseada em Python e otimizada para computação acelerada por GPU. Originalmente desenvolvido pela Meta AI em 2016 e agora parte da Linux Foundation, o PyTorch rapidamente se tornou uma das estruturas mais utilizadas para pesquisas e aplicações de aprendizado profundo.

Relâmpago PyTorch é um wrapper leve construído sobre PyTorch que simplifica ainda mais o processo de fluxo de trabalho do pesquisador e desenvolvimento de modelo. Com o Lightning, os cientistas de dados podem se concentrar mais no design de modelos, em vez de código padronizado.

Semana 4 – Parte 4: Construindo uma rede neural convolucional com PyTorch

Esta postagem do blog fornece um tutorial sobre a construção de uma rede neural convolucional para classificação de imagens no PyTorch, aproveitando camadas convolucionais e de pooling para extração de recursos, bem como camadas totalmente conectadas para previsão.

Uma Rede Neural Convolucional (CNN ou ConvNet) é um algoritmo de aprendizado profundo projetado especificamente para tarefas onde o reconhecimento de objetos é crucial – como classificação, detecção e segmentação de imagens. As CNNs são capazes de alcançar precisão de última geração em tarefas de visão complexas, potencializando muitas aplicações da vida real, como sistemas de vigilância, gerenciamento de armazéns e muito mais.

Como humanos, podemos reconhecer facilmente objetos em imagens analisando padrões, formas e cores. As CNNs também podem ser treinadas para realizar esse reconhecimento, aprendendo quais padrões são importantes para a diferenciação. Por exemplo, ao tentar distinguir entre a foto de um gato e a de um cachorro, nosso cérebro se concentra em formas, texturas e características faciais únicas. A CNN aprende a captar esses mesmos tipos de características distintivas. Mesmo para tarefas de categorização muito refinadas, as CNNs são capazes de aprender representações complexas de recursos diretamente dos pixels.

Semana 4 – Parte 5: Introdução ao Processamento de Linguagem Natural

Uma visão geral do Processamento de Linguagem Natural (PNL) e suas aplicações.

Estamos aprendendo muito sobre ChatGPT e grandes modelos de linguagem (LLMs). O processamento de linguagem natural tem sido um tópico interessante, um tópico que atualmente está dominando o mundo da IA e da tecnologia. Sim, LLMs como o ChatGPT ajudaram no seu crescimento, mas não seria bom entender de onde vem tudo isso? Então, vamos voltar ao básico – PNL.

A PNL é um subcampo da inteligência artificial e é a capacidade de um computador detectar e compreender a linguagem humana, por meio da fala e do texto, da mesma forma que nós, humanos, podemos. A PNL ajuda os modelos a processar, compreender e produzir a linguagem humana.

O objetivo da PNL é preencher a lacuna de comunicação entre humanos e computadores. Os modelos de PNL são normalmente treinados em tarefas como previsão da próxima palavra, o que lhes permite construir dependências contextuais e, então, ser capazes de gerar resultados relevantes.

Semana 4 – Parte 6: Implantando seu primeiro modelo de aprendizado de máquina

Com apenas 3 etapas simples, você pode construir e implantar um modelo de classificação de vidro mais rápido do que você pode dizer…modelo de classificação de vidro!

Neste tutorial, aprenderemos como construir um modelo simples de multiclassificação usando o Classificação de vidro conjunto de dados. Nosso objetivo é desenvolver e implantar uma aplicação web que possa prever vários tipos de vidro, como:

- Construindo Windows Float Processado

- Construindo Windows Processado Não-Float

- Flutuação das janelas do veículo processada

- Janelas do veículo não flutuantes processadas (ausentes no conjunto de dados)

- Containers

- Talheres

- faróis

Além disso, aprenderemos sobre:

- Skops: Compartilhe seus modelos baseados no scikit-learn e coloque-os em produção.

- Gradio: estrutura de aplicativos web de ML.

- HuggingFace Spaces: modelo gratuito de aprendizado de máquina e plataforma de hospedagem de aplicativos.

Ao final deste tutorial, você terá experiência prática na construção, treinamento e implantação de um modelo básico de aprendizado de máquina como um aplicativo Web.

Semana 4 – Parte 7: Introdução à computação em nuvem para ciência de dados

E o Power Duo da tecnologia moderna.

No mundo de hoje, duas forças principais surgiram como revolucionárias: Ciência de Dados e Computação em Nuvem.

Imagine um mundo onde quantidades colossais de dados são geradas a cada segundo. Bem… você não precisa imaginar… É o nosso mundo!

Desde interações nas redes sociais até transações financeiras, desde registros de saúde até preferências de comércio eletrônico, os dados estão em toda parte.

Mas de que adianta esses dados se não conseguimos obter valor? É exatamente isso que a Ciência de Dados faz.

E onde armazenamos, processamos e analisamos esses dados? É aí que a computação em nuvem brilha.

Vamos embarcar numa viagem para compreender a relação entrelaçada entre estas duas maravilhas tecnológicas. Vamos (tentar) descobrir tudo juntos!

Parabéns por completar a semana 4!!

A equipe da KDnuggets espera que o caminho Back to Basics tenha fornecido aos leitores uma abordagem abrangente e estruturada para dominar os fundamentos da ciência de dados.

A semana de bônus será publicada na próxima semana, na segunda-feira – fique ligado!

Nisha Arya é Cientista de Dados e Redator Técnico Freelance. Ela está particularmente interessada em fornecer conselhos de carreira em Ciência de Dados ou tutoriais e conhecimento baseado em teoria sobre Ciência de Dados. Ela também deseja explorar as diferentes maneiras pelas quais a Inteligência Artificial é/pode beneficiar a longevidade da vida humana. Um aprendiz interessado, buscando ampliar seus conhecimentos técnicos e habilidades de escrita, enquanto ajuda a orientar os outros.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.kdnuggets.com/back-to-basics-week-4-advanced-topics-and-deployment?utm_source=rss&utm_medium=rss&utm_campaign=back-to-basics-week-4-advanced-topics-and-deployment

- :tem

- :é

- :não

- :onde

- $UP

- 1

- 2016

- 7

- a

- habilidade

- Capaz

- Sobre

- precisão

- Alcançar

- avançado

- conselho

- AI

- algoritmo

- algoritmos

- Todos os Produtos

- permitir

- já

- tb

- quantidades

- an

- analisar

- análise

- e

- Aplicação

- aplicações

- abordagem

- SOMOS

- por aí

- artigo

- artificial

- inteligência artificial

- AS

- aspectos

- At

- em caminho duplo

- baseado

- basic

- fundamentos básicos

- BE

- tornam-se

- sido

- beneficiar

- Benefícios

- entre

- Blog

- Blogs

- Bônus

- Cérebro

- Ramo

- PONTE

- ampliar

- construir

- Prédio

- construído

- mas a

- by

- CAN

- Oportunidades

- CAT

- características

- ChatGPT

- classificação

- Na nuvem

- computação em nuvem

- CNN

- código

- conhecimento

- vem

- Comunicação

- completando

- integrações

- compreensivo

- computador

- computadores

- computação

- conectado

- construção

- contextual

- rede neural convolucional

- curso

- cobre

- crucial

- Atualmente

- dados,

- informática

- ciência de dados

- cientista de dados

- profundo

- deep learning

- definição

- dependências

- implantar

- Implantação

- desenvolvimento

- projetado

- concepção

- descobrir

- Detecção

- desenvolver

- desenvolvido

- Desenvolvimento

- diferente

- diretamente

- descobrir

- descobrindo

- discutir

- distinguir

- mergulho

- do

- parece

- Cachorro

- domínio

- feito

- duo

- e-commerce,

- facilmente

- embarcar

- emergiu

- enfatizando

- final

- essencial

- Éter (ETH)

- Mesmo

- Cada

- em toda parte

- exatamente

- exemplo

- vasta experiência

- experiência

- Explicação

- explicação

- explorar

- Explorando

- Extração

- Facial

- reconhecimento facial

- mais rápido

- Característica

- Funcionalidades

- financeiro

- Encontre

- Primeiro nome

- Flutuador

- Foco

- concentra-se

- Escolha

- Forças

- Foundation

- Quadro

- enquadramentos

- fraude

- detecção de fraude

- Gratuito

- freelance

- da

- totalmente

- função

- fundamental

- Fundamentos

- mais distante

- lacuna

- gerar

- gerado

- geração

- ter

- obtendo

- vidro

- Go

- meta

- Bom estado, com sinais de uso

- Growth

- guia

- mãos em

- Ter

- saúde

- ajudou

- ajuda

- ajuda

- sua experiência

- oculto

- de alto nível

- esperança

- hospedagem

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- HTTPS

- humano

- Humanos

- i

- if

- imagem

- Classificação de imagem

- imagens

- importante

- in

- em profundidade

- Incluindo

- aumentando

- instalação

- Inteligência

- interações

- interessado

- interessante

- entrelaçado

- para dentro

- Introdução

- IT

- ESTÁ

- viagem

- apenas por

- KDnuggetsGenericName

- Afiado

- Chave

- Kickstarted

- Conhecimento

- língua

- grande

- mais tarde

- camadas

- APRENDER

- aprendiz

- aprendizagem

- aproveitando

- bibliotecas

- Biblioteca

- vida

- clareamento

- Iluminação

- relâmpago

- leve

- como

- linux

- fundação linux

- ll

- longevidade

- olhar

- perder

- lote

- máquina

- aprendizado de máquina

- a Principal

- de grupos

- manualmente

- muitos

- Dominar

- significativo

- Mídia

- Meta

- desaparecido

- ML

- modelo

- modelos

- EQUIPAMENTOS

- Segunda-feira

- mais

- a maioria

- natural

- Linguagem Natural

- Processamento de linguagem natural

- rede

- redes

- Neural

- rede neural

- redes neurais

- Novo

- Próximo

- semana que vem

- PNL

- nada

- agora

- objeto

- objetos

- of

- oferecendo treinamento para distância

- frequentemente

- on

- ONE

- open source

- operação

- otimizado

- or

- originalmente

- Outros

- Outros

- A Nossa

- saída

- outputs

- Visão geral

- parte

- particularmente

- caminho

- padrões

- realizar

- atuação

- foto

- escolher

- plataforma

- platão

- Inteligência de Dados Platão

- PlatãoData

- Popular

- Publique

- publicado

- poder

- Powering

- predizer

- predição

- preferências

- processo

- processado

- em processamento

- Produção

- fornecido

- fornece

- fornecendo

- colocar

- Python

- pytorch

- rapidamente

- em vez

- leitores

- reconhecimento

- reconhecer

- registros

- relacionamento

- relevante

- depender

- contando

- pesquisa

- investigador

- mesmo

- dizer

- Ciência

- Cientista

- cientistas

- scikit-learn

- arranhar

- Segundo

- busca

- segmentação

- Shape

- formas

- Partilhar

- ela

- brilha

- simples

- simplifica

- Habilidades

- So

- Redes Sociais

- meios de comunicação social

- espaços

- especificamente

- discurso

- fala para texto

- divisão

- padrão

- começado

- estado-da-arte

- ficar

- Passos

- loja

- Storm

- estrutura

- estruturada

- tal

- vigilância

- sistemas

- tomar

- tarefas

- Profissionais

- tecnologia

- Dados Técnicos:

- tecnológica

- Tecnologia

- condições

- texto

- geração de texto

- do que

- que

- A

- O Básico

- deles

- Eles

- então

- teoria

- Lá.

- Este

- deles

- Pensando

- Terceiro

- isto

- Através da

- para

- hoje

- também

- topo

- tópico

- Temas

- treinado

- Training

- Transações

- tentar

- tentando

- tutorial

- tutoriais

- dois

- tipos

- tipicamente

- compreender

- único

- sobre

- usar

- usava

- utilização

- valor

- vário

- Contra

- muito

- visão

- Armazém

- gerenciamento de armazenagem

- Caminho..

- maneiras

- we

- web

- Aplicativo da Web

- Aplicativos da web

- semana

- semanas

- BEM

- O Quê

- quando

- qual

- Enquanto

- largamente

- Wikipedia

- precisarão

- Windows

- desejos

- de

- dentro

- Word

- de gestão de documentos

- trabalhar

- mundo

- escritor

- escrita

- sim

- Você

- investimentos

- zefirnet