O aprendizado de máquina (ML), um ramo da inteligência artificial (IA), ganhou atenção significativa nos últimos anos. O ML se concentra em treinar computadores para aprender com os dados, com a ajuda de algoritmos e modelos, para tomar decisões ou previsões. Nesta abordagem de treinamento, as máquinas não precisam ser explicitamente programadas. Os computadores aprendem com a experiência, assim como os humanos. A IA vai além do ML, abrangendo várias técnicas, como processamento de linguagem natural (PNL), visão computacional e robótica. O objetivo é criar máquinas inteligentes que possam simular o comportamento humano e executar tarefas complexas de forma autônoma. Compreender os conceitos básicos de aprendizado de máquina é essencial para qualquer pessoa interessada nessas áreas, pois elas possuem um imenso potencial na transformação de setores como saúde, finanças, transporte e muito mais.

In ML, as máquinas analisam conjuntos de dados muito grandes para identificar padrões, tendências e relacionamentos dentro dos dados. Esta capacidade orientada por dados ajuda as máquinas a tomar decisões informadas ou a fazer previsões precisas.

O papel dos dados no aprendizado de máquina

Os dados servem como base sobre a qual os modelos são construídos e as previsões são feitas. Técnicas de pré-processamento como limpeza, transformação e normalização dos dados garantem sua adequação para análise. A extração de recursos desempenha um papel vital no ML, identificando atributos ou características relevantes no conjunto de dados que contribuem para previsões precisas. Este processo envolve selecionar ou transformar variáveis que melhor representem os padrões subjacentes nos dados.

Conceitos de pré-processamento de dados

Pré-processamento de dados desempenha um papel fundamental na melhoria da precisão e confiabilidade dos modelos de ML. Nesta etapa, os dados brutos são limpos, removendo erros e inconsistências, e então preparados em um formato adequado para análises posteriores. Outra etapa importante no pré-processamento de dados é o tratamento valores ausentes. Dados ausentes podem introduzir preconceitos e afetar a precisão do modelo. Essas etapas de pré-processamento garantem que os algoritmos de aprendizagem tenham o desempenho esperado.

Outra etapa importante é o escalonamento de recursos, onde as variáveis são ajustadas para evitar que certos recursos dominem outros, garantindo assim uma representação justa dos recursos dentro do modelo.

Além disso, variáveis categóricas muitas vezes requerem codificação em representações numéricas para compatibilidade com algoritmos de ML. Técnicas como codificação one-hot ou codificação de rótulo são comumente usadas para converter variáveis categóricas em valores numéricos significativos. Além disso, valores discrepantes podem distorcer o desempenho do modelo; portanto, métodos de detecção de valores discrepantes são aplicados para identificá-los e tratá-los adequadamente.

No geral, o pré-processamento preciso de dados garante que os modelos de ML recebam entradas limpas, consistentes e confiáveis. Isto não só melhora a precisão, mas também permite uma melhor generalização ao fazer previsões sobre dados não vistos.

Conceitos de treinamento de dados: aprendizagem supervisionada e não supervisionada

Algoritmos de ML pode treinar modelos por dois métodos principais: aprendizagem supervisionada e aprendizagem não supervisionada. Na aprendizagem supervisionada, o modelo aprende a partir de dados rotulados, onde cada exemplo é emparelhado com o seu resultado correto.

Por outro lado, aprendizado não supervisionado O método depende de “dados não rotulados”, onde apenas recursos de entrada estão disponíveis. O objetivo é descobrir estruturas ou padrões inerentes aos dados sem rótulos predefinidos. Essa abordagem é útil para tarefas como agrupamento de instâncias semelhantes ou redução de dimensionalidade.

Independentemente da abordagem escolhida, dados de treinamento desempenha um papel fundamental no aprendizado de máquina. Conjuntos de dados de alta qualidade são essenciais para a construção de modelos robustos, capazes de generalizar bem para exemplos inéditos. Além dos dados de treinamento, a engenharia de recursos também desempenha um papel vital nos pipelines de ML. Envolve transformar recursos de entrada brutos em uma representação mais adequada que capture informações significativas sobre o problema em questão.

Conceitos de algoritmo de ML: modelagem preditiva, redes neurais e aprendizado profundo

No domínio do ML, os algoritmos formam a espinha dorsal da criação de sistemas inteligentes capazes de fazer previsões e decisões precisas. A modelagem preditiva é um conceito fundamental em ML que envolve o uso de dados históricos para construir modelos para prever resultados futuros. Ao analisar padrões e relacionamentos dentro dos dados, os modelos preditivos nos permitem fazer previsões informadas sobre instâncias novas e invisíveis.

Redes neurais, uma classe especial de algoritmos, imita de perto a estrutura e o funcionamento do cérebro humano. Consistindo em nós ou “neurônios” interconectados, as redes neurais têm um desempenho excepcionalmente bom no reconhecimento de padrões complexos e na extração de insights significativos de grandes quantidades de dados. Eles provaram ser altamente eficazes em vários domínios, como reconhecimento de imagens, processamento de linguagem natural e sistemas de recomendação.

A aprendizagem profunda (DL) é uma subconjunto de redes neurais que ganhou enorme popularidade nos últimos anos devido ao seu notável desempenho em tarefas desafiadoras. Envolve treinar redes neurais com camadas progressivamente divulgadas (daí o termo “profundo”) para permitir “ganho de conhecimento” hierárquico a partir de dados brutos. Isso permite que os modelos DL aprendam automaticamente recursos complexos sem engenharia de recursos explícita.

Ao se aprofundar nas técnicas de modelagem preditiva, explorar o funcionamento interno das redes neurais e compreender o poder das abordagens de DL, os iniciantes podem obter insights valiosos sobre como os algoritmos conduzem as soluções de ML.

Conceitos de avaliação de desempenho de modelo: overfitting, underfitting, validação cruzada, matriz de confusão e curva Roc

Avaliando desempenho do modelo é uma etapa crucial no processo de ML. Este subtópico explorará vários conceitos importantes relacionados à avaliação do desempenho do modelo.

Durante a fase de treinamento, o modelo ajusta seus parâmetros internos para minimizar erros entre os resultados previstos e os valores alvo reais. Este processo, conhecido como “otimização” ou “ajuste”, permite ao modelo generalizar seu aprendizado para exemplos inéditos. Assim, é vital avaliar o desempenho do modelo treinado em dados invisíveis para avaliar a sua capacidade de fazer previsões precisas em cenários do mundo real. É aqui que os dados de teste entram em jogo. Os dados de teste atuam como um conjunto de dados independente que não foi usado durante o treinamento, mas contém padrões e distribuições semelhantes.

Overfitting ocorre quando um modelo é muito complexo – capturando padrões irrelevantes dos dados de treinamento. Este tipo de modelo não funciona bem com novos dados. O underfitting é exatamente o oposto – acontece quando um modelo é muito simples para capturar os padrões subjacentes nos dados, levando a um desempenho insatisfatório.

Validação cruzada é usado para avaliar o desempenho de um modelo em dados não vistos. Isso envolve dividir o conjunto de dados em vários subconjuntos e, em seguida, treinar e testar o modelo nos subconjuntos de dados iterativamente.

Métricas como exatidão, precisão, recall e pontuação F1 fornecem insights sobre quão bem os modelos generalizam para dados novos ou não vistos. A compreensão desses conceitos permitirá que iniciantes avaliem seus modelos de ML de maneira eficaz e tomem decisões informadas sobre seu desempenho.

Extração e engenharia de recursos: exemplos da vida real

Um exemplo está na PNL, onde extraindo recursos relevantes a partir de dados de texto é crucial. Na análise de sentimento, por exemplo, recursos como frequência de palavras, tags de classes gramaticais ou léxicos de sentimento podem ser extraídos para treinar um modelo para classificar o texto como positivo ou negativo.

Em aplicações de visão computacional, a extração de recursos é essencial para reconhecer objetos e padrões em imagens. Redes Neurais Convolucionais (CNNs) geralmente usam modelos pré-treinados como VGGNet ou ResNet para extrair recursos significativos a partir de imagens antes do treinamento em tarefas específicas, como detecção de objetos ou classificação de imagens.

Outro exemplo da vida real pode ser encontrado nos sistemas de detecção de fraude. Para detectar transações fraudulentas de forma eficaz, vários recursos são projetados com base no histórico de transações, incluindo frequência de transações, incompatibilidade de localização, padrões de compra incomuns e anomalias de endereço IP.

Em aplicações de saúde, a engenharia de recursos desempenha um papel significativo. Por exemplo, o risco de doença cardíaca pode ser previsto usando dados do paciente, como idade, pressão arterial, níveis de colesterol e hábitos de fumar. Essas variáveis são cuidadosamente selecionadas e transformadas em recursos significativos que capturam conhecimento médico relevante.

Sistemas de recomendação e detecção de anomalias: exemplos da vida real

Na era digital de hoje, os sistemas de recomendação tornaram-se parte integrante da nossa vida quotidiana. Desde recomendações personalizadas de filmes em plataformas de streaming até sugestões de produtos direcionados em sites de comércio eletrônico, esses sistemas desempenham um papel crucial na melhoria da experiência do usuário. Ao aproveitar algoritmos de ML, os sistemas de recomendação analisam grandes quantidades de dados para prever com precisão as preferências do usuário.

Um exemplo proeminente de sistemas de recomendação é a filtragem colaborativa, que sugere itens com base nas preferências e comportamentos de usuários semelhantes. Esta técnica revolucionou a forma como descobrimos novos conteúdos, promovendo uma sensação de personalização num mundo online que de outra forma seria esmagador.

Outro aspecto fascinante do aprendizado de máquina são os algoritmos de detecção de anomalias. Esses algoritmos são excelentes na identificação de desvios de padrões ou comportamentos esperados em um conjunto de dados. Desde a detecção de fraudes em transações financeiras até a detecção de invasões de rede na segurança cibernética, a detecção de anomalias desempenha um papel vital na proteção contra atividades maliciosas.

Ao empregar técnicas como clustering, modelagem estatística e redes neurais, os algoritmos de detecção de anomalias podem identificar valores discrepantes e anomalias que podem passar despercebidas pelos métodos tradicionais baseados em regras. Esta capacidade torna-os ferramentas inestimáveis para melhorar as medidas de segurança em vários setores.

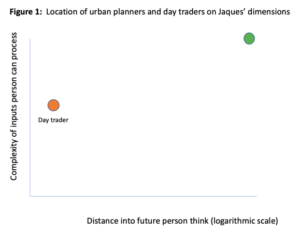

No domínio do aprendizado de máquina, análise de série temporal desempenha um papel fundamental, permitindo-nos extrair insights valiosos de dados que evoluem ao longo do tempo. Este ramo da estatística concentra-se na compreensão e previsão de padrões em dados sequenciais, tornando-se uma ferramenta indispensável para diversas aplicações da vida real. Uma área proeminente onde a análise de séries temporais desempenha um papel crucial é na previsão financeira.

Ao analisar preços históricos de ações ou taxas de câmbio, os modelos de ML podem prever tendências futuras e ajudar os investidores a tomar decisões informadas. Da mesma forma, na previsão de vendas, compreender os padrões de vendas anteriores é essencial para prever a demanda futura e otimizar o gerenciamento de estoques.

Outra aplicação vital reside no campo da ciência ambiental. A análise de séries temporais ajuda-nos a compreender os padrões climáticos, examinando as flutuações de temperatura, os níveis de precipitação ou mesmo os índices de qualidade do ar durante longos períodos. Ao identificar tendências e sazonalidade nestes conjuntos de dados, os investigadores podem fazer previsões precisas sobre os impactos das alterações climáticas e orientar os decisores políticos em conformidade.

Além disso, a análise de séries temporais também encontra sua importância na saúde. Ao analisar os sinais vitais dos pacientes ao longo do tempo ou ao estudar os padrões de progressão da doença, os profissionais médicos podem fazer melhores diagnósticos e prever os resultados da doença com maior precisão.

No geral, a análise de série temporal é um componente integral das aplicações de ML em diversos domínios.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.dataversity.net/machine-learning-concepts-for-beginners/

- :tem

- :é

- :não

- :onde

- 224

- 300

- a

- habilidade

- Sobre

- conformemente

- precisão

- preciso

- exatamente

- em

- atividades

- atos

- real

- Ad

- Adição

- Adicionalmente

- endereço

- Ajustado

- ajusta

- afetar

- contra

- idade

- AI

- visa

- AR

- algoritmo

- algoritmos

- tb

- quantidades

- an

- análise

- analisar

- análise

- e

- detecção de anomalia

- Outro

- qualquer

- qualquer um

- aplauso

- Aplicação

- aplicações

- aplicado

- abordagem

- se aproxima

- adequadamente

- SOMOS

- ÁREA

- artificial

- inteligência artificial

- Inteligência artificial (AI)

- AS

- aspecto

- avaliar

- auxiliar

- At

- por WhatsApp.

- atributos

- automaticamente

- autonomamente

- disponível

- Espinha dorsal

- baseado

- basic

- BE

- tornam-se

- antes

- Iniciantes

- comportamento

- MELHOR

- Melhor

- entre

- Pós

- viés

- sangue

- Pressão arterial

- Cérebro

- Ramo

- construir

- Prédio

- construído

- mas a

- by

- CAN

- capacidade

- capaz

- capturar

- capturas

- Capturar

- Oportunidades

- cuidadosamente

- certo

- desafiante

- alterar

- características

- escolhido

- classe

- classificação

- classificar

- limpar

- Limpeza

- Clima

- Das Alterações Climáticas

- de perto

- agrupamento

- colaborativo

- vem

- geralmente

- compatibilidade

- integrações

- componente

- compreender

- computador

- Visão de Computador

- Aplicativos de visão computacional

- computadores

- conceito

- conceitos

- confusão

- consistente

- Consistindo

- contém

- conteúdo

- contribuir

- converter

- correta

- crio

- Criar

- crucial

- Moeda

- Cíber segurança

- dados,

- orientado por dados

- conjuntos de dados

- DATAVERSIDADE

- decisões

- profundo

- Demanda

- descobrir

- Detecção

- digital

- idade digital

- descobrir

- Doença

- distribuições

- diferente

- do

- parece

- domínios

- dominando

- distância

- dois

- durante

- e-commerce,

- cada

- Eficaz

- efetivamente

- empregando

- permitir

- permite

- permitindo

- codificação

- abrangente

- engenharia

- Engenharia

- aprimorando

- garantir

- garante

- assegurando

- ambiental

- erros

- essencial

- Éter (ETH)

- avaliar

- avaliação

- avaliação

- Mesmo

- Evento

- cotidiano

- evolui

- Examinando

- exemplo

- exemplos

- Excel

- excepcionalmente

- exchange

- esperado

- vasta experiência

- explicitamente

- explorar

- Explorando

- opção

- extrato

- Extração

- f1

- feira

- fascinante

- Característica

- Funcionalidades

- campo

- Campos

- filtragem

- financiar

- financeiro

- encontra

- flutuações

- concentra-se

- Escolha

- Previsão

- formulário

- formato

- formas

- fomento

- encontrado

- Foundation

- fraude

- detecção de fraude

- fraudulento

- Frequência

- da

- funcionamento

- fundamental

- mais distante

- futuro

- Ganho

- ganhou

- Go

- meta

- vai

- maior

- guia

- mão

- manipular

- acontece

- Ter

- saúde

- Coração

- Doença cardíaca

- ajudar

- ajuda

- conseqüentemente

- hierárquica

- Alta

- alta qualidade

- altamente

- histórico

- história

- segurar

- Como funciona o dobrador de carta de canal

- HTML

- HTTPS

- humano

- Humanos

- identificar

- identificar

- imagem

- Classificação de imagem

- Reconhecimento de Imagem

- imagens

- imenso

- Impacto

- importante

- melhora

- melhorar

- in

- Incluindo

- inconsistências

- de treinadores em Entrevista Motivacional

- Índices

- indústrias

- INFORMAÇÕES

- informado

- inerente

- interior

- entrada

- inputs

- insights

- instância

- instâncias

- integral

- Inteligência

- Inteligente

- interconectado

- interessado

- interno

- para dentro

- intricado

- introduzir

- detecção de intrusão

- inestimável

- inventário

- Gestão de Inventário

- Investidores

- envolve

- IP

- Endereço IP

- IT

- Unid

- ESTÁ

- apenas por

- KDnuggetsGenericName

- Conhecimento

- conhecido

- O rótulo

- Rótulos

- língua

- grande

- camadas

- principal

- APRENDER

- aprendizagem

- níveis

- aproveitando

- encontra-se

- como

- Vidas

- localização

- máquina

- aprendizado de máquina

- máquinas

- moldadas

- fazer

- FAZ

- Fazendo

- malicioso

- de grupos

- Matriz

- max-width

- significativo

- medidas

- médico

- método

- métodos

- poder

- minimizar

- desaparecido

- ML

- Algoritmos de ML

- modelo

- modelagem

- modelos

- mais

- filme

- múltiplo

- my

- natural

- Linguagem Natural

- Processamento de linguagem natural

- negativo

- rede

- redes

- Neural

- redes neurais

- Novo

- PNL

- nós

- objeto

- Detecção de Objetos

- objetos

- of

- frequentemente

- on

- ONE

- online

- só

- oposto

- otimizando

- or

- Outros

- Outros

- de outra forma

- A Nossa

- Resultado

- resultados

- ponto fora da curva

- outputs

- Acima de

- esmagador

- emparelhado

- parâmetros

- parte

- passado

- paciente

- dados do paciente

- padrões

- realizar

- atuação

- períodos

- Personalização

- Personalizado

- fase

- essencial

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- Jogar

- desempenha

- Podcast

- formuladores de políticas

- pobre

- popularidade

- positivo

- potencial

- poder

- Precisão

- predefinido

- predizer

- previsto

- prevendo

- Previsões

- preditivo

- preferências

- preparado

- pressão

- evitar

- Valores

- primário

- Problema

- processo

- em processamento

- Produto

- Sugestões de produtos

- programado

- progressão

- progressivamente

- proeminente

- comprovado

- fornecer

- compra

- qualidade

- Preços

- Cru

- dados não tratados

- mundo real

- reino

- receber

- recentemente

- reconhecimento

- reconhecendo

- Recomendação

- recomendações

- redução

- em relação a

- relacionado

- Relacionamentos

- relevante

- confiabilidade

- confiável

- notável

- removendo

- representar

- representação

- requerer

- pesquisadores

- revolucionou

- Risco

- robótica

- uma conta de despesas robusta

- Tipo

- salvaguardando

- vendas

- dimensionamento

- cenários

- Ciência

- Ponto

- segurança

- Medidas de Segurança

- selecionado

- selecionando

- sentido

- sentimento

- Série

- serve

- vários

- Shutterstock

- significado

- periodo

- Sinais

- semelhante

- Similarmente

- simples

- Fumar

- Soluções

- específico

- estatístico

- estatística

- Passo

- Passos

- estoque

- de streaming

- estrutura

- estruturas

- Estudando

- tal

- Sugere

- aptidão

- adequado

- aprendizagem supervisionada

- sistemas

- Tire

- Target

- visadas

- tarefas

- técnica

- técnicas

- prazo

- ensaio

- texto

- que

- A

- deles

- Eles

- então

- Este

- deles

- isto

- Assim

- tempo

- Séries temporais

- para

- hoje

- juntos

- também

- ferramenta

- ferramentas

- tradicional

- Trem

- treinado

- Training

- transação

- Transações

- transformando

- transporte

- tremendo

- Tendências

- dois

- tipo

- descobrir

- subjacente

- compreensão

- aprendizado não supervisionado

- incomum

- sobre

- us

- usar

- usava

- útil

- Utilizador

- Experiência do Usuário

- usuários

- utilização

- Valioso

- Valores

- vário

- Grande

- muito

- visto

- visão

- vital

- foi

- Caminho..

- we

- sites

- BEM

- quando

- qual

- precisarão

- de

- dentro

- sem

- Word

- funcionamento

- mundo

- anos

- ZDNET

- zefirnet