O rápido crescimento da IA generativa traz inovações promissoras e, ao mesmo tempo, levanta novos desafios. Esses desafios incluem alguns que eram comuns antes da IA generativa, como preconceito e explicabilidade, e novos exclusivos para modelos de fundação (FMs), incluindo alucinações e toxicidade. Na AWS, temos o compromisso de desenvolver IA generativa de forma responsável, adotando uma abordagem centrada nas pessoas que prioriza a educação, a ciência e nossos clientes, para integrar a IA responsável em todo o ciclo de vida da IA de ponta a ponta.

No ano passado, introduzimos novos recursos em nossos aplicativos e modelos generativos de IA, como verificação de segurança integrada em Sussurrador de Código da Amazon, treinamento para detectar e bloquear conteúdo prejudicial em Titã Amazonae proteções de privacidade de dados em Rocha Amazônica. Nosso investimento em IA generativa segura, transparente e responsável inclui a colaboração com a comunidade global e os legisladores, à medida que incentivamos e apoiamos tanto o Compromissos voluntários de IA da Casa Branca e Cúpula de Segurança de IA no Reino Unido. E continuamos a trabalhar lado a lado com os clientes para operacionalizar a IA responsável com ferramentas específicas, como Esclarecimento do Amazon SageMaker, Governança de ML com Amazon SageMakerE muito mais.

Apresentando uma nova inovação de IA responsável

À medida que a IA generativa se expande para novas indústrias, organizações e casos de utilização, este crescimento deve ser acompanhado por um investimento sustentado no desenvolvimento de FM responsável. Os clientes desejam que seus FMs sejam construídos tendo em mente a segurança, a imparcialidade e a proteção, para que possam, por sua vez, implantar a IA de maneira responsável. No AWS re:Invent deste ano, temos o prazer de anunciar novos recursos para promover a inovação responsável e generativa de IA em um amplo conjunto de recursos com novas ferramentas integradas, proteções ao cliente, recursos para aumentar a transparência e ferramentas para combater a desinformação. Nosso objetivo é fornecer aos clientes as informações de que precisam para avaliar os FMs em relação às principais considerações de IA responsável, como toxicidade e robustez, e introduzir proteções para aplicar proteções com base nos casos de uso do cliente e nas políticas de IA responsável. Ao mesmo tempo, nossos clientes desejam estar mais bem informados sobre a segurança, a imparcialidade, a proteção e outras propriedades dos serviços de IA e FMs, à medida que os utilizam em sua própria organização. Temos o prazer de anunciar mais recursos para ajudar os clientes a entender melhor nossos serviços de IA da AWS e oferecer a transparência que eles solicitam.

Implementando salvaguardas: Guardrails para Amazon Bedrock

A segurança é uma prioridade quando se trata de introduzir IA generativa em grande escala. As organizações desejam promover interações seguras entre seus clientes e aplicações generativas de IA que evitem linguagem prejudicial ou ofensiva e se alinhem com as políticas da empresa. A maneira mais fácil de fazer isso é implementar proteções consistentes em toda a organização para que todos possam inovar com segurança. Ontem anunciamos a prévia do Guarda-corpos para Amazon Bedrock—um novo recurso que facilita a implementação de proteções específicas de aplicativos com base em casos de uso de clientes e políticas de IA responsáveis.

Os Guardrails promovem consistência na forma como os FMs no Amazon Bedrock respondem a conteúdos indesejáveis e prejudiciais nos aplicativos. Os clientes podem aplicar proteções a modelos de linguagem grandes no Amazon Bedrock, bem como a modelos ajustados e em combinação com Agentes da Amazon Bedrock. Guardrails permite especificar tópicos a serem evitados, e o serviço detecta e evita automaticamente consultas e respostas que se enquadram em categorias restritas. Os clientes também podem configurar limites de filtro de conteúdo em categorias, incluindo discurso de ódio, insultos, linguagem sexualizada e violência, para filtrar conteúdo prejudicial no nível desejado. Por exemplo, uma aplicação bancária online pode ser configurada para evitar fornecer aconselhamento de investimento e limitar conteúdos inadequados (como discurso de ódio, insultos e violência). Num futuro próximo, os clientes também poderão redigir informações de identificação pessoal (PII) nas entradas dos usuários e nas respostas dos FMs, definir filtros de palavrões e fornecer uma lista de palavras personalizadas para bloquear interações entre usuários e FMs, melhorando a conformidade e ainda mais protegendo os usuários. Com o Guardrails, você pode inovar mais rapidamente com IA generativa e, ao mesmo tempo, manter proteções e salvaguardas consistentes com as políticas da empresa.

Identificando o melhor FM para um caso de uso específico: avaliação de modelo no Amazon Bedrock

Hoje, as organizações têm uma ampla gama de opções de FM para potencializar suas aplicações generativas de IA. Para encontrar o equilíbrio certo entre precisão e desempenho para seu caso de uso, as organizações devem comparar modelos de forma eficiente e encontrar a melhor opção com base na IA responsável e nas métricas de qualidade que são importantes para elas. Para avaliar modelos, as organizações devem primeiro passar dias identificando benchmarks, configurando ferramentas de avaliação e executando avaliações, o que requer profundo conhecimento em ciência de dados. Além disso, esses testes não são úteis para avaliar critérios subjetivos (por exemplo, voz da marca, relevância e estilo) que exigem julgamento por meio de fluxos de trabalho tediosos, demorados e de revisão humana. O tempo, a experiência e os recursos necessários para essas avaliações — para cada novo caso de uso — tornam difícil para as organizações avaliar modelos em relação às dimensões responsáveis da IA e fazer uma escolha informada sobre qual modelo fornecerá a experiência mais precisa e segura para seus clientes.

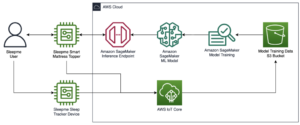

Agora disponível em versão prévia, Avaliação de modelo no Amazon Bedrock ajuda os clientes a avaliar, comparar e selecionar os melhores FMs para seu caso de uso específico com base em métricas personalizadas, como precisão e segurança, usando avaliações automáticas ou humanas. No console do Amazon Bedrock, os clientes escolhem os FMs que desejam comparar para uma determinada tarefa, como resposta a perguntas ou resumo de conteúdo. Para avaliações automáticas, os clientes selecionam critérios de avaliação predefinidos (por exemplo, precisão, robustez e toxicidade) e carregam seu próprio conjunto de dados de teste ou selecionam conjuntos de dados integrados e disponíveis publicamente. Para critérios subjetivos ou conteúdo diferenciado que exige julgamento, os clientes podem configurar facilmente fluxos de trabalho de avaliação baseados em humanos com apenas alguns cliques. Esses fluxos de trabalho aproveitam a equipe de trabalho interna de um cliente ou usam uma força de trabalho gerenciada fornecida pela AWS para avaliar as respostas do modelo. Durante as avaliações baseadas em humanos, os clientes definem métricas específicas do caso de uso (por exemplo, relevância, estilo e voz da marca). Depois que os clientes concluem o processo de configuração, o Amazon Bedrock executa avaliações e gera um relatório, para que os clientes possam entender facilmente o desempenho do modelo em relação aos principais critérios de segurança e precisão e selecionar o melhor modelo para seu caso de uso.

Essa capacidade de avaliar modelos não se limita ao Amazon Bedrock; os clientes também podem usar a avaliação de modelos no Amazon SageMaker Clarify para avaliar, comparar e selecionar facilmente a melhor opção de FM nas principais métricas de qualidade e responsabilidade, como precisão, robustez e toxicidade – em todos os aspectos. todos os FMs.

Combate à desinformação: marca d'água no Amazon Titan

Hoje, anunciamos Gerador de imagem Amazon Titan em visualização, que permite aos clientes produzir e aprimorar rapidamente imagens de alta qualidade em escala. Consideramos a IA responsável durante cada estágio do processo de desenvolvimento do modelo, incluindo a seleção de dados de treinamento, a construção de recursos de filtragem para detectar e remover entradas de usuários e resultados de modelo inadequados e melhorar a diversidade demográfica de nossos resultados de modelo. Todas as imagens geradas pelo Amazon Titan contêm uma marca d’água invisível por padrão, projetada para ajudar a reduzir a disseminação de desinformação, fornecendo um mecanismo discreto para identificar imagens geradas por IA. A AWS está entre os primeiros fornecedores de modelos a lançar amplamente marcas d’água invisíveis integradas às saídas de imagem e projetadas para serem resistentes a alterações.

Construindo confiança: apoiando nossos modelos e aplicações com indenização

Construir a confiança do cliente é fundamental para a AWS. Estamos em uma jornada com nossos clientes desde o nosso início e, com o crescimento da IA generativa, continuamos comprometidos em construir juntos tecnologia inovadora. Para permitir que os clientes aproveitem o poder da nossa IA generativa, eles precisam saber que estão protegidos. A AWS oferece cobertura de indenização por direitos autorais para resultados dos seguintes serviços de IA generativos da Amazon: Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazon-Lex e Amazon Customize. Isto significa que os clientes que utilizam os serviços de forma responsável estão protegidos contra reclamações de terceiros que alegam violação de direitos de autor pelos resultados gerados por esses serviços (ver Secção 50.10 do Termos de serviço). Além disso, nossa indenização padrão de PI pelo uso dos serviços protege os clientes de reclamações de terceiros que alegam violação de PI pelos serviços e pelos dados usados para treiná-los. Em outras palavras, se você usar um serviço de IA generativa da Amazon listado acima e alguém processá-lo por violação de IP, a AWS defenderá esse processo, o que inclui a cobertura de qualquer julgamento contra você ou custos de liquidação.

Apoiamos nossos serviços generativos de IA e trabalhamos para melhorá-los continuamente. À medida que a AWS lança novos serviços e a IA generativa continua a evoluir, a AWS continuará a se concentrar incansavelmente em conquistar e manter a confiança do cliente.

Aprimorando a transparência: AWS AI Service Card para Amazon Titan Text

We introduziu os cartões de serviço AWS AI no re:Invent 2022 como um recurso de transparência para ajudar os clientes a entender melhor nossos serviços de IA da AWS. Os cartões de serviço de IA são uma forma de documentação de IA responsável que fornece aos clientes um único local para encontrar informações sobre os casos de uso e limitações pretendidos, opções de design de IA responsável e práticas recomendadas de implantação e otimização de desempenho para nossos serviços de IA. Eles fazem parte de um processo de desenvolvimento abrangente que assumimos para construir nossos serviços de forma responsável, abordando justiça, explicabilidade, veracidade e robustez, governança, transparência, privacidade e segurança, proteção e controlabilidade.

Na re:Invent deste ano estamos anunciando um novo cartão de serviço de IA para Amazon Titan Text para aumentar a transparência nos modelos de fundação. Também estamos lançando quatro novos cartões de serviço de IA, incluindo: Amazon Comprehend Detectar PII, Detecção de Toxicidade do Amazon Transcribe, Animação facial do Amazon Rekognition e AWS HealthScribe. Você pode explorar cada uma dessas cartas no Site da AWS. À medida que a IA generativa continua a crescer e evoluir, a transparência sobre como a tecnologia é desenvolvida, testada e utilizada será um componente vital para ganhar a confiança das organizações e dos seus clientes. Na AWS, temos o compromisso de continuar a levar recursos de transparência, como cartões de serviço de IA, para a comunidade mais ampla, e de iterar e coletar feedback sobre os melhores caminhos a seguir.

Investir em IA responsável em todo o ciclo de vida da IA generativa

Estamos entusiasmados com as inovações anunciadas na re:Invent esta semana, que oferecem aos nossos clientes mais ferramentas, recursos e proteções integradas para construir e usar IA generativa com segurança. Da avaliação do modelo às proteções e marcas d'água, os clientes agora podem trazer IA generativa para suas organizações com mais rapidez, ao mesmo tempo que mitigam os riscos. Novas proteções para clientes, como cobertura de indenização de propriedade intelectual, e novos recursos para aumentar a transparência, como cartões de serviço de IA adicionais, também são exemplos importantes do nosso compromisso de construir confiança entre empresas de tecnologia, legisladores, grupos comunitários, cientistas e muito mais. Continuamos a fazer investimentos significativos em IA responsável em todo o ciclo de vida de um modelo básico — para ajudar nossos clientes a dimensionar a IA de maneira segura e responsável.

Sobre os autores

Peter Hallinan lidera iniciativas na ciência e na prática de IA responsável na AWS AI, ao lado de uma equipe de especialistas responsáveis em IA. Ele tem profundo conhecimento em IA (PhD, Harvard) e empreendedorismo (Blindsight, vendido para a Amazon). Suas atividades voluntárias incluíram servir como professor consultor na Escola de Medicina da Universidade de Stanford e como presidente da Câmara Americana de Comércio em Madagascar. Sempre que possível, ele está nas montanhas com seus filhos: esqui, escalada, caminhada e rafting

Peter Hallinan lidera iniciativas na ciência e na prática de IA responsável na AWS AI, ao lado de uma equipe de especialistas responsáveis em IA. Ele tem profundo conhecimento em IA (PhD, Harvard) e empreendedorismo (Blindsight, vendido para a Amazon). Suas atividades voluntárias incluíram servir como professor consultor na Escola de Medicina da Universidade de Stanford e como presidente da Câmara Americana de Comércio em Madagascar. Sempre que possível, ele está nas montanhas com seus filhos: esqui, escalada, caminhada e rafting

Vasi Philomin atualmente é vice-presidente de IA generativa da AWS. Ele lidera esforços generativos de IA, incluindo Amazon Bedrock, Amazon Titan e Amazon CodeWhisperer.

Vasi Philomin atualmente é vice-presidente de IA generativa da AWS. Ele lidera esforços generativos de IA, incluindo Amazon Bedrock, Amazon Titan e Amazon CodeWhisperer.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- :tem

- :é

- :não

- $UP

- 10

- 100

- 125

- 2022

- 50

- a

- habilidade

- Capaz

- Sobre

- acima

- acompanhado

- precisão

- preciso

- em

- atividades

- Adição

- Adicional

- endereços

- conselho

- contra

- AI

- Serviços de IA

- visar

- alinhar

- muito parecido

- Todos os Produtos

- ao lado de

- tb

- Amazon

- Sussurrador de Código da Amazon

- Amazon Sage Maker

- Amazon Web Services

- americano

- entre

- an

- e

- Anunciar

- anunciou

- Anunciando

- Outro

- qualquer

- Aplicação

- aplicações

- Aplicar

- abordagem

- SOMOS

- por aí

- AS

- pergunta

- avaliações

- At

- Automático

- automaticamente

- disponível

- evitar

- evitou

- AWS

- AWS re: Invent

- Equilíbrio

- Bancário

- baseado

- BE

- sido

- antes

- atrás

- benchmarks

- MELHOR

- melhores práticas

- Melhor

- entre

- viés

- Bloquear

- ambos

- interesse?

- trazer

- Traz

- amplo

- mais amplo

- construir

- ganhar confiança

- Prédio

- construído

- construídas em

- by

- CAN

- capacidades

- capacidade

- cartão

- Cartões

- casas

- casos

- Categorias

- desafios

- Câmara

- Crianças

- escolha

- escolhas

- Escolha

- reivindicações

- Escalada

- colaboração

- combater

- combinação

- vem

- Commerce

- compromisso

- comprometido

- comum

- comunidade

- Empresas

- Empresa

- comparar

- compliance

- componente

- compreender

- compreensivo

- Considerações

- considerado

- consistente

- cônsul

- consultor

- não contenho

- conteúdo

- continuamente

- continuar

- continua

- continuar

- direitos autorais

- violação de direitos autorais

- núcleo

- custos

- cobertura

- cobertura

- critérios

- Atualmente

- personalizadas

- cliente

- Clientes

- dados,

- privacidade de dados

- ciência de dados

- conjuntos de dados

- dias

- profundo

- profundo conhecimento

- Padrão

- definir

- entregar

- demográfico

- implantar

- desenvolvimento

- Design

- projetado

- desejado

- descobrir

- desenvolvido

- Desenvolvimento

- difícil

- dimensões

- desinformação

- Diversidade

- do

- documentação

- distância

- durante

- e

- cada

- ganhar

- Ganhando

- maneira mais fácil é

- facilmente

- fácil

- Educação

- eficientemente

- esforços

- ou

- empodera

- permitir

- encorajados

- end-to-end

- aumentar

- Todo

- empreendedorismo

- Éter (ETH)

- avaliar

- avaliação

- avaliação

- avaliações

- Cada

- todos

- evolui

- exemplo

- exemplos

- animado

- vasta experiência

- experiência

- especialistas

- Explicação

- explorar

- expresso

- Rosto

- justiça

- Cair

- mais rápido

- retornos

- poucos

- filtro

- filtragem

- filtros

- Encontre

- acabamento

- Primeiro nome

- Foco

- seguinte

- Escolha

- formulário

- para a frente

- Promover

- Foundation

- quatro

- da

- mais distante

- Além disso

- futuro

- reunir

- gerado

- gera

- generativo

- IA generativa

- dado

- dá

- Global

- governo

- Do grupo

- Cresça:

- Growth

- prejudicial

- arreios

- Harvard

- odiar

- discurso de ódio

- Ter

- he

- ajudar

- ajuda

- alta qualidade

- caminhadas

- sua

- House

- Como funciona o dobrador de carta de canal

- HTTPS

- humano

- identificar

- identificar

- if

- imagem

- imagens

- executar

- importante

- melhorar

- melhorar

- in

- começo

- incluir

- incluído

- inclui

- Incluindo

- Crescimento

- indústrias

- INFORMAÇÕES

- informado

- violação

- iniciativas

- inovar

- Inovação

- e inovações

- inovadores

- tecnologia inovadora

- inputs

- integrar

- integrado

- Pretendido

- interações

- para dentro

- introduzir

- introduzido

- introduzindo

- investimento

- Investimentos

- invisível

- IP

- IT

- viagem

- jpg

- apenas por

- Chave

- Saber

- língua

- grande

- lança

- de lançamento

- ação judicial

- Leads

- Permite

- Nível

- Alavancagem

- wifecycwe

- como

- LIMITE

- limitações

- Limitado

- Lista

- Listado

- manutenção

- fazer

- FAZ

- gerenciados

- significativo

- significa

- mecanismo

- medicina

- Métrica

- mente

- mitigando

- modelo

- modelos

- mais

- a maioria

- devo

- Perto

- você merece...

- Novo

- agora

- of

- WOW!

- ofensivo

- Oferece

- on

- uma vez

- queridos

- online

- serviços bancários online

- otimização

- Opção

- Opções

- or

- organização

- organizações

- Outros

- A Nossa

- Fora

- outputs

- próprio

- parte

- passado

- atuação

- realizada

- Pessoalmente

- phd

- Pii

- Lugar

- platão

- Inteligência de Dados Platão

- PlatãoData

- políticas

- formuladores de políticas

- possível

- poder

- prática

- práticas

- presidente

- impede

- visualização

- prioriza

- prioridade

- política de privacidade

- Privacidade e segurança

- processo

- produzir

- PROFANIDADE

- profissional

- Professor

- promissor

- a promover

- Propriedades

- protegido

- proteger

- protege

- fornecer

- fornecido

- fornecedores

- fornecendo

- publicamente

- colocar

- qualidade

- consultas

- raises

- alcance

- rápido

- rapidamente

- RE

- reduzir

- liberar

- relevância

- permanecem

- remover

- Denunciar

- requeridos

- exige

- resistente

- recurso

- Recursos

- Responder

- respostas

- responsabilidade

- responsável

- com responsabilidade

- restringido

- certo

- Risco

- robustez

- corrida

- é executado

- seguro

- proteções

- seguramente

- Segurança

- sábio

- mesmo

- Escala

- escala ai

- Escalas

- exploração

- Escola

- Ciência

- cientistas

- Seção

- seguro

- segurança

- Vejo

- selecionar

- doadores,

- serviço

- Serviços

- de servir

- conjunto

- contexto

- assentamento

- instalação

- desde

- solteiro

- So

- vendido

- alguns

- Alguém

- específico

- discurso

- gastar

- propagação

- Etapa

- suporte

- padrão

- de pé

- Stanford

- Universidade de Stanford

- greve

- estilo

- tal

- Sues

- Suportado

- telhado

- tomar

- Tarefa

- Profissionais

- Tecnologia

- empresas de tecnologia

- testado

- ensaio

- testes

- texto

- que

- A

- as informações

- do Reino Unido

- deles

- Eles

- Este

- deles

- De terceiros

- isto

- esta semana

- este ano

- aqueles

- Através da

- tempo

- titã

- para

- juntos

- ferramentas

- Temas

- Trem

- Training

- Transparência

- transparente

- Confiança

- VIRAR

- Uk

- compreender

- empreender

- único

- universidade

- usar

- caso de uso

- usava

- Utilizador

- usuários

- utilização

- vital

- voz

- voluntário

- voluntário

- vp

- queremos

- marca d'água

- Watermarking

- marcas d'água

- Caminho..

- maneiras

- we

- web

- serviços web

- Site

- semana

- BEM

- foram

- O Quê

- quando

- qual

- enquanto

- QUEM

- inteiro

- Largo

- Ampla variedade

- largamente

- precisarão

- de

- dentro

- palavras

- Atividades:

- fluxos de trabalho

- Força de trabalho

- ano

- ontem

- Você

- zefirnet