Todos queremos ver os nossos valores humanos ideais refletidos nas nossas tecnologias. Esperamos que tecnologias como a inteligência artificial (IA) não nos mintam, não discriminem e sejam seguras para nós e para os nossos filhos usarmos. No entanto, muitos criadores de IA enfrentam atualmente reações adversas devido aos preconceitos, imprecisões e práticas de dados problemáticas expostas nos seus modelos. Estas questões requerem mais do que uma solução técnica, algorítmica ou baseada em IA. Na realidade, é necessária uma abordagem holística e sociotécnica.

A matemática demonstra uma verdade poderosa

Todos os modelos preditivos, incluindo a IA, são mais precisos quando incorporam diversas experiências e inteligência humana. Isto não é uma opinião; tem validade empírica. Considere o teorema de previsão de diversidade. Simplificando, quando a diversidade num grupo é grande, o erro da multidão é pequeno – apoiando o conceito de “sabedoria da multidão”. Em um estudo influente, foi demonstrado que diversos grupos de solucionadores de problemas com baixa habilidade podem superar grupos de solucionadores de problemas com alta habilidade (Hong & Page, 2004).

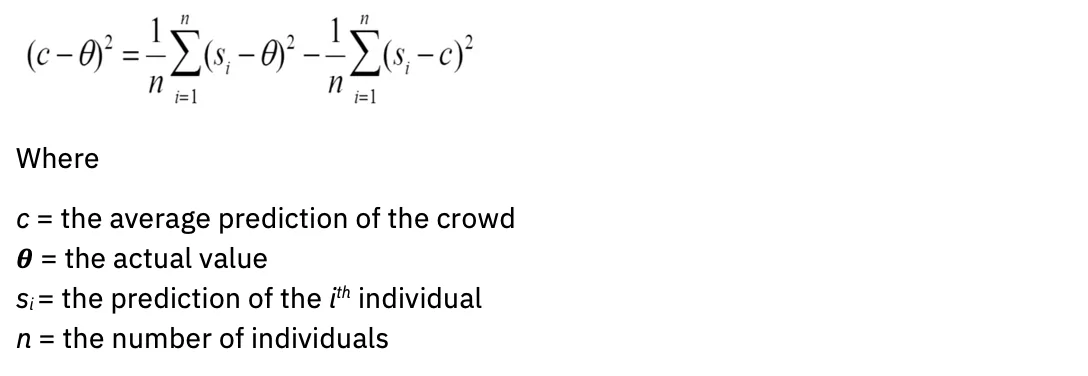

Em linguagem matemática: quanto maior for a sua variância, mais padronizada será a sua média. A equação é semelhante a esta:

A um estudo mais aprofundado forneceu mais cálculos que refinam as definições estatísticas de uma multidão sábia, incluindo a ignorância das previsões de outros membros e a inclusão daqueles com maximamente diferente previsões ou julgamentos (correlacionados negativamente). Portanto, não é apenas o volume, mas a diversidade que melhora as previsões. Como esse insight pode afetar a avaliação de modelos de IA?

(in)precisão do modelo

Para citar um aforismo comum, todos os modelos estão errados. Isto é verdade nas áreas de estatística, ciência e IA. Modelos criados com falta de experiência no domínio podem levar a errôneo Saídas.

Hoje, um pequeno grupo homogêneo de pessoas determina quais dados usar para treinar modelos generativos de IA, extraídos de fontes que representam muito o inglês. “Para a maioria dos mais de 6,000 idiomas do mundo, os dados de texto disponíveis não são suficientes para treinar um modelo básico em larga escala” (de “Sobre as oportunidades e riscos dos modelos de fundação”, Bommasani et al., 2022).

Além disso, os próprios modelos são criados a partir de arquiteturas limitadas: “Quase todos os modelos de PNL de última geração são agora adaptados de um dos poucos modelos básicos, como BERT, RoBERTa, BART, T5, etc. alavancagem extremamente alta (qualquer melhoria nos modelos básicos pode levar a benefícios imediatos em toda a PNL), é também um passivo; todos os sistemas de IA podem herdar os mesmos preconceitos problemáticos de alguns modelos básicos (Bommasani et al.) "

Para que a IA generativa reflita melhor as diversas comunidades que serve, uma variedade muito maior de dados de seres humanos deve ser representada em modelos.

A avaliação da precisão do modelo anda de mãos dadas com a avaliação do viés. Devemos perguntar: qual é a intenção do modelo e para quem ele é otimizado? Considere, por exemplo, quem se beneficia mais com algoritmos de recomendação de conteúdo e algoritmos de mecanismos de busca. As partes interessadas podem ter interesses e objetivos muito diferentes. Algoritmos e modelos requerem alvos ou proxies para o erro de Bayes: o erro mínimo que um modelo deve melhorar. Esse proxy geralmente é uma pessoa, como um especialista no assunto com experiência no domínio.

Um desafio muito humano: avaliar o risco antes da aquisição ou desenvolvimento do modelo

As regulamentações e planos de ação emergentes em matéria de IA sublinham cada vez mais a importância dos formulários algorítmicos de avaliação de impacto. O objetivo destes formulários é capturar informações críticas sobre os modelos de IA para que as equipas de governação possam avaliar e abordar os seus riscos antes de os implementar. Perguntas típicas incluem:

- Qual é o caso de uso do seu modelo?

- Quais são os riscos de impactos díspares?

- Como você está avaliando a justiça?

- Como você está tornando seu modelo explicável?

Embora concebido com boas intenções, o problema é que a maioria dos proprietários de modelos de IA não entende como avaliar os riscos para o seu caso de uso. Um refrão comum poderia ser: “Como meu modelo poderia ser injusto se não coleta informações de identificação pessoal (PII)?” Consequentemente, os formulários raramente são preenchidos com a atenção necessária para que os sistemas de governação sinalizem com precisão os factores de risco.

Assim, sublinha-se a natureza sócio-técnica da solução. O proprietário de um modelo – um indivíduo – não pode simplesmente receber uma lista de caixas de seleção para avaliar se seu caso de uso causará danos. Em vez disso, o que é necessário é que grupos de pessoas com experiências de mundo vividas muito variadas se reúnam em comunidades que oferecem segurança psicológica para terem conversas difíceis sobre impactos díspares.

Acolhendo perspectivas mais amplas para uma IA confiável

A IBM® acredita em adotar uma abordagem “cliente zero”, implementando as recomendações e sistemas que criaria para seus próprios clientes em soluções de consultoria e orientadas a produtos. Essa abordagem se estende às práticas éticas, e é por isso que a IBM criou um Centro de Excelência (COE) de IA confiável.

Tal como explicado acima, a diversidade de experiências e conjuntos de competências é fundamental para avaliar adequadamente os impactos da IA. Mas a perspectiva de participar num Centro de Excelência pode ser intimidante numa empresa repleta de inovadores, especialistas e engenheiros ilustres em IA, pelo que é necessário cultivar uma comunidade de segurança psicológica. A IBM comunica isso claramente dizendo: “Interessado em IA? Interessado na ética da IA? Você tem um assento nesta mesa.

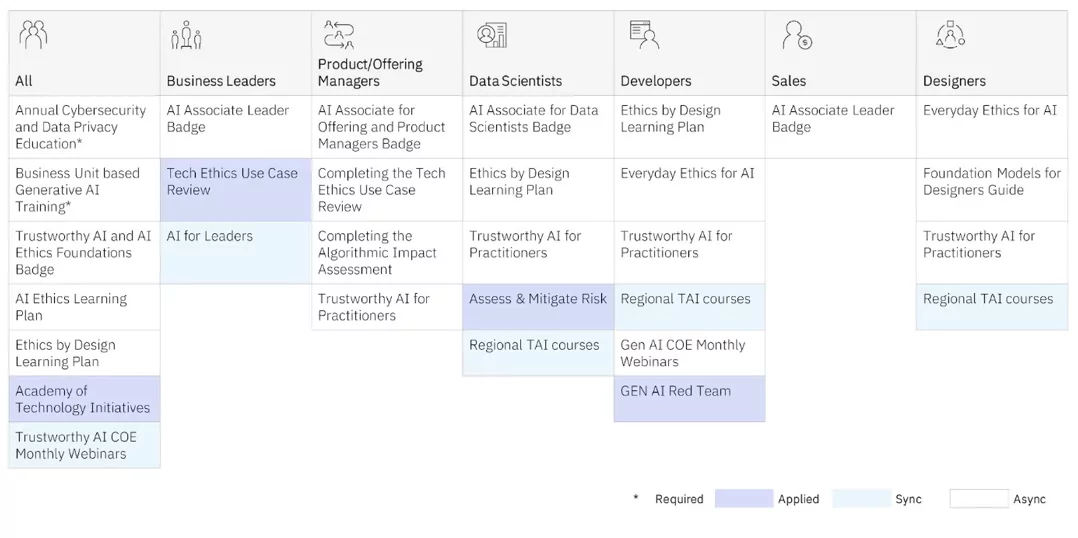

O COE oferece treinamento em ética em IA para profissionais de todos os níveis. São oferecidos programas de aprendizagem síncrona (professor e alunos em sala de aula) e assíncronos (autoguiados).

Mas são os COE aplicado treinamento que oferece aos nossos profissionais os insights mais profundos, à medida que trabalham com equipes globais, diversas e multidisciplinares em projetos reais para compreender melhor os impactos díspares. Eles também aproveitam estruturas de design thinking que a IBM Design para IA grupo usa internamente e com clientes para avaliar os efeitos não intencionais dos modelos de IA, mantendo aqueles que são frequentemente marginalizados em mente. (Veja o livro de Sylvia Duckworth Roda de Poder e Privilégio para exemplos de como as características pessoais se cruzam para privilegiar ou marginalizar as pessoas.) A IBM também doou muitas das estruturas para a comunidade de código aberto Projete com ética.

Abaixo estão alguns dos relatórios que a IBM publicou publicamente sobre esses projetos:

Ferramentas automatizadas de governança de modelos de IA são necessárias para obter insights importantes sobre o desempenho do seu modelo de IA. Mas observe que capturar o risco bem antes de seu modelo ser desenvolvido e estar em produção é o ideal. Ao criar comunidades de profissionais diversos e multidisciplinares que oferecem um espaço seguro para as pessoas terem conversas difíceis sobre impactos díspares, você pode começar sua jornada para operacionalizar seus princípios e desenvolver IA de forma responsável.

Na prática, ao contratar profissionais de IA, considere que bem mais de 70% do esforço na criação de modelos é a curadoria dos dados corretos. Você deseja contratar pessoas que saibam como coletar dados representativos, mas que também sejam coletados com consentimento. Você também deseja que pessoas que saibam trabalhar em estreita colaboração com especialistas no domínio para garantir que eles tenham a abordagem correta. É fundamental garantir que estes profissionais tenham inteligência emocional para enfrentar o desafio de uma curadoria responsável da IA, com humildade e discernimento. Devemos ser intencionais ao aprender como reconhecer como e quando os sistemas de IA podem exacerbar a desigualdade, tanto quanto podem aumentar a inteligência humana.

Reinvente a forma como sua empresa funciona com IA

Esse artigo foi útil?

SimNão

Mais de Inteligência Artificial

Boletins informativos da IBM

Receba nossos boletins informativos e atualizações de tópicos que oferecem as mais recentes lideranças inovadoras e insights sobre tendências emergentes.

Inscreva-se agora

Mais boletins informativos

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.ibm.com/blog/why-we-need-diverse-multidisciplinary-coes-for-model-risk/

- :tem

- :é

- :não

- :onde

- $UP

- 000

- 1

- 16

- 2022

- 2024

- 23

- 25

- 28

- 29

- 30

- 300

- 32

- 39

- 40

- 400

- 65

- 7

- 9

- a

- habilidade

- Sobre

- acima

- AC

- acelerar

- precisão

- preciso

- exatamente

- em

- Açao Social

- adaptado

- endereço

- Admitem

- adotar

- Publicidade

- conselho

- afetar

- agentes

- AI

- Modelos de IA

- Sistemas de IA

- visar

- AL

- algorítmico

- algoritmos

- Todos os Produtos

- tb

- sempre

- amp

- an

- analítica

- e

- qualquer

- Aplicação

- aplicações

- abordagem

- SOMOS

- áreas

- artigo

- artificial

- inteligência artificial

- Inteligência artificial (AI)

- AS

- perguntar

- avaliar

- Avaliando

- avaliação

- assistentes

- ajudando

- At

- auditivo

- aumentar

- autor

- disponível

- evitar

- em caminho duplo

- equilíbrio

- BE

- sido

- antes

- começar

- ser

- acredita

- Benefícios

- Melhor

- Pós

- viés

- vieses

- Blog

- Blogs

- Azul

- Boston

- ambos

- mais amplo

- Prédio

- negócio

- funções empresariais

- negócios

- mas a

- botão

- by

- CAN

- capturar

- Capturar

- carbono

- cartão

- Cartões

- Cuidado

- casas

- CAT

- Categoria

- Causar

- Centralização de

- Centro de Excelência

- central

- certo

- desafiar

- características

- chatbots

- verificar

- criança

- Crianças

- círculos

- CIS

- classe

- claramente

- clientes

- de perto

- Na nuvem

- cor

- combinação

- vinda

- comum

- Comunidades

- comunidade

- Empresas

- Empresa

- Efetuado

- conceito

- consentimento

- Consequentemente

- Considerar

- consultor

- Recipiente

- continuar

- conversas

- núcleo

- correta

- correlacionados

- Custo

- poderia

- criado

- Criar

- criadores

- crítico

- multidão

- APF

- curadoria

- Atualmente

- personalizadas

- cliente

- experiência do cliente

- Clientes

- dados,

- Data

- decisões

- mais profundo

- Padrão

- definições

- entregar

- demonstra

- Implantação

- descrição

- Design

- design thinking

- projetado

- Determinar

- desenvolver

- desenvolvido

- diferente

- difícil

- digital

- Transformação Digital

- díspar

- Distinto

- diferente

- Diversidade

- do

- domínio

- doada

- desenhado

- distância

- E & T

- efeitos

- esforço

- eliminando

- embutindo

- abraços

- emergente

- colaboradores

- permitir

- noivando

- Motor

- Engenheiros

- Inglês

- suficiente

- assegurando

- Entrar

- erro

- etc.

- Éter (ETH)

- considerações éticas

- ética

- avaliar

- avaliação

- avaliação

- Mesmo

- Cada

- em toda parte

- exacerbar

- exemplo

- exemplos

- Excelência

- saída

- esperar

- vasta experiência

- Experiências

- especialista

- experiência

- especialistas

- explicado

- exposto

- se estende

- extremamente

- Facebook Messenger

- facilitar

- enfrentando

- fatores

- justiça

- falso

- longe

- RÁPIDO

- poucos

- Encontre

- Foco

- seguir

- seguinte

- fontes

- Escolha

- Frente

- formas

- Foundation

- enquadramentos

- da

- frente

- funções

- reunir

- colhido

- coleta

- generativo

- IA generativa

- gerador

- ter

- dado

- dá

- Global

- meta

- Objetivos

- vai

- Bom estado, com sinais de uso

- governo

- Gramática

- grandemente

- Grade

- Grupo

- Do grupo

- Growth

- guia

- prejudicar

- Ter

- Título

- ouvir

- altura

- ajudar

- útil

- Alta

- ele

- contratar

- Contratando

- sua

- detém

- holística

- Início

- Como funciona o dobrador de carta de canal

- Como Negociar

- HTTPS

- humano

- inteligência humana

- humildade

- HÍBRIDO

- Nuvem híbrida

- i

- EU VOU

- IBM

- ICO

- ÍCONE

- ideal

- identificado

- if

- Ignorância

- imagem

- Imediato

- Impacto

- Impacto

- executar

- implementação

- importância

- importante

- melhorar

- melhorias

- melhora

- in

- incluir

- Incluindo

- inclusão

- incorporar

- cada vez mais

- incrementais

- índice

- indústria

- Influente

- INFORMAÇÕES

- Inovação

- inovadores

- entrada

- introspecção

- insights

- imediatamente

- em vez disso

- Instituto

- com seguro

- seguradoras

- Inteligência

- Inteligente

- intenção

- Intencional

- intenções

- interessado

- interesses

- internamente

- interceptar

- da intervenção

- intimidante

- intrínseco

- isn

- emitem

- questões

- IT

- ESTÁ

- janeiro

- juntar

- Faça parte

- viagem

- jpg

- apenas por

- manutenção

- Chave

- Saber

- conhecido

- Falta

- língua

- Idiomas

- grande

- em grande escala

- mais recente

- conduzir

- líder

- Liderança

- aprendizagem

- deixar

- Nível

- Alavancagem

- responsabilidade

- mentira

- como

- Limitado

- Lista

- local

- local

- OLHARES

- fazer

- Fazendo

- de grupos

- manual

- muitos

- matemática

- matemático

- Importância

- max-width

- Posso..

- me

- significar

- Conheça

- Messenger

- poder

- minutos

- mente

- mínimo

- minutos

- Móvel Esteira

- modelo

- modelos

- modernização

- mais

- a maioria

- mover

- muito

- multidisciplinar

- devo

- my

- Natureza

- Navegação

- necessário

- você merece...

- necessário

- Cria

- negativamente

- Novo

- novos produtos

- newsletters

- PNL

- não

- nota

- nada

- agora

- numeroso

- of

- WOW!

- oferecer

- oferecido

- Oferece

- frequentemente

- on

- ONE

- open source

- Opinião

- oportunidades

- ideal

- otimizado

- or

- organizações

- Outros

- A Nossa

- Outperform

- outputs

- Acima de

- próprio

- proprietários

- página

- participando

- passar

- Pessoas

- realização

- pessoa

- pessoal

- Pessoalmente

- perspectivas

- PHP

- Pii

- planos

- platão

- Inteligência de Dados Platão

- PlatãoData

- plug-in

- Privacidade

- posição

- Publique

- potencial

- potenciais clientes

- poder

- poderoso

- prática

- práticas

- predição

- Previsões

- preditivo

- primário

- princípios

- Priorizar

- privilégio

- Problema

- aquisição

- produz

- Produção

- produtividade

- Produtos

- Programas

- projetos

- devidamente

- prospecto

- fornecido

- fornecendo

- proxies

- procuração

- psicológico

- publicamente

- publicado

- colocar

- Frequentes

- rapidamente

- citar

- raramente

- Prontidão

- Leitura

- reais

- Realidade

- reconhecer

- recomendações

- redução

- refinar

- refletir

- refletida

- regulamentos

- Relatórios

- representante

- representado

- pedidos

- requerer

- requeridos

- pesquisa

- responder

- responsável

- com responsabilidade

- responsivo

- receita

- Crescimento da receita

- certo

- Risco

- fatores de risco

- riscos

- estrada

- robôs

- seguro

- Segurança

- Dito

- mesmo

- dizendo

- Escala

- dimensionamento

- Ciência

- Peneira

- Scripts

- Pesquisar

- motor de busca

- seguro

- Vejo

- seo

- serve

- Configurações

- rede de apoio social

- mostrando

- simplesmente

- local

- folga

- pequeno

- smart

- Alto-falantes inteligentes

- SMS

- So

- solução

- Soluções

- alguns

- Fontes

- Espaço

- caixas de som

- Patrocinado

- quadrados

- partes interessadas

- padrão

- começo

- estado-da-arte

- estatístico

- estatística

- Estudantes

- Estudo

- sujeito

- Inscreva-se

- tal

- ajuda

- Apoiar

- SVG

- sistemas

- T

- mesa

- tomar

- tem como alvo

- professor

- equipes

- Dados Técnicos:

- Tecnologias

- terciário

- texto

- do que

- obrigado

- que

- A

- o mundo

- deles

- Eles

- tema

- si mesmos

- Este

- deles

- think

- Pensando

- isto

- aqueles

- pensamento

- liderança de pensamento

- três

- Através da

- tempo

- Título

- para

- juntos

- ferramentas

- topo

- tópico

- difícil

- Trem

- Training

- Transformação

- Tendências

- verdadeiro

- digno de confiança

- dois

- tipo

- típico

- compreender

- Injusto

- único

- Desbloqueio

- Atualizações

- sobre

- URL

- us

- usar

- caso de uso

- usos

- Utilizando

- valor

- Valores

- variedade

- variando

- muito

- Virtual

- volume

- W

- queremos

- foi

- we

- BEM

- O Quê

- O que é a

- quando

- se

- qual

- enquanto

- QUEM

- o qual

- porque

- largamente

- mais largo

- precisarão

- sabedoria

- SENSATO

- de

- Word

- WordPress

- Atividades:

- trabalho

- mundo

- seria

- escrito

- Errado

- ainda

- Você

- investimentos

- zefirnet