Naukowcy z Uniwersytetu Purdue opublikowali artykuł techniczny zatytułowany „WWW: Co, kiedy, gdzie wykonać obliczenia w pamięci”.

Abstrakcyjny:

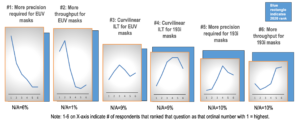

„Obliczenia w pamięci (CiM) okazały się przekonującym rozwiązaniem pozwalającym obniżyć wysokie koszty przesyłania danych w maszynach von Neumanna. CiM może wykonywać masowo równoległe operacje ogólnego mnożenia macierzy (GEMM) w pamięci, co jest dominującym obliczeniem w wnioskowaniu uczenia maszynowego (ML). Jednakże zmiana przeznaczenia pamięci do celów obliczeniowych rodzi kluczowe pytania: 1) Jakiego typu CiM użyć: Biorąc pod uwagę mnogość analogowych i cyfrowych CiM, konieczne jest określenie ich przydatności z punktu widzenia systemowego. 2) Kiedy stosować CiM: Wnioskowanie ML obejmuje obciążenia o różnych wymaganiach dotyczących pamięci i obliczeń, co utrudnia określenie, kiedy CiM jest bardziej korzystny niż standardowe rdzenie przetwarzające. 3) Gdzie zintegrować CiM: Każdy poziom pamięci ma inną przepustowość i pojemność, co wpływa na przepływ danych i zalety lokalizacji wynikające z integracji CiM.

W tym artykule badamy odpowiedzi na te pytania dotyczące integracji CiM w celu przyspieszenia wnioskowania ML. Używamy Timeloop-Accelergy do wczesnej oceny prototypów CiM na poziomie systemu, w tym prymitywów analogowych i cyfrowych. Integrujemy CiM z różnymi poziomami pamięci podręcznej w architekturze bazowej podobnej do Nvidia A100 i dostosowujemy przepływ danych do różnych obciążeń ML. Nasze eksperymenty pokazują, że architektury CiM poprawiają efektywność energetyczną, osiągając do 0.12 razy mniej energii w porównaniu z ustaloną wartością bazową z precyzją INT-8 i do 4 razy większą wydajność dzięki przeplataniu wag i powielaniu. Proponowana praca zapewnia wgląd w to, jakiego typu CiM należy użyć oraz kiedy i gdzie optymalnie zintegrować go z hierarchią pamięci podręcznej w celu akceleracji GEMM”.

Znajdź papier techniczny tutaj. Opublikowano w grudniu 2023 r. (przeddruk).

Sharma, Tanvi, Mustafa Ali, Indranil Chakraborty i Kaushik Roy. „WWW: Co, kiedy, gdzie obliczać w pamięci”. Przedruk arXiv arXiv:2312.15896 (2023).

Powiązane artykuły

Zwiększanie efektywności energetycznej AI dzięki przetwarzaniu w pamięci

Jak przetwarzać obciążenia w skali zetta i nie przekraczać ustalonego budżetu mocy.

Modelowanie obliczeń w pamięci z wydajnością biologiczną

Generatywna sztuczna inteligencja zmusza producentów chipów do bardziej inteligentnego wykorzystywania zasobów obliczeniowych.

SRAM w AI: przyszłość pamięci

Dlaczego pamięć SRAM jest postrzegana jako krytyczny element nowych i tradycyjnych architektur obliczeniowych.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://semiengineering.com/cim-integration-for-ml-inference-acceleration/

- :ma

- :Jest

- :Gdzie

- $W GÓRĘ

- 1

- 2023

- a

- przyśpieszenie

- osiągnięcia

- AI

- łagodzić

- an

- i

- odpowiedzi

- architektura

- AS

- At

- przepustowość

- Baseline

- korzystny

- Korzyści

- obie

- budżet

- by

- Pamięć podręczna

- CAN

- Pojemność

- zniewalający

- obliczenia

- obliczać

- Koszty:

- krytyczny

- dane

- grudzień

- określaniu

- różne

- trudny

- cyfrowy

- dominujący

- każdy

- Wcześnie

- efektywność

- element

- wyłonił

- energia

- efektywności energetycznej

- ustanowiony

- ewaluację

- eksperymenty

- odkryj

- ustalony

- W razie zamówieenia projektu

- Siły

- od

- przyszłość

- Zyski

- Ogólne

- dany

- tutaj

- hierarchia

- Wysoki

- Jednak

- HTTPS

- zidentyfikować

- podnieść

- in

- obejmuje

- Włącznie z

- spostrzeżenia

- integrować

- integracja

- najnowszych

- IT

- jpg

- Klawisz

- nauka

- poziom

- poziomy

- niższy

- maszyna

- uczenie maszynowe

- maszyny

- Dokonywanie

- masywnie

- Matrix

- Pamięć

- ML

- jeszcze

- ruch

- wielość

- potrzebne

- Nowości

- Nvidia

- of

- on

- koncepcja

- operacje

- ludzkiej,

- Papier

- Parallel

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- perspektywa

- plato

- Analiza danych Platona

- PlatoDane

- stwarza

- power

- Detaliczność

- wygląda tak

- przetwarzanie

- zaproponowane

- prototypy

- zapewnia

- opublikowany

- pytania

- w sprawie

- wymagania

- Badacze

- Zasoby

- Roy

- pokazać

- rozwiązanie

- standard

- pobyt

- stosowność

- systemy

- Techniczny

- niż

- że

- Połączenia

- Przyszłość

- ich

- Te

- to

- pod tytulem

- do

- tradycyjny

- rodzaj

- uniwersytet

- posługiwać się

- różnorodność

- różnorodny

- oglądany "

- z

- była

- we

- waga

- Co

- jeśli chodzi o komunikację i motywację

- w

- w ciągu

- Praca

- zefirnet