Szybki rozwój generatywnej sztucznej inteligencji przynosi obiecujące nowe innowacje, a jednocześnie rodzi nowe wyzwania. Wyzwania te obejmują niektóre, które były powszechne przed generatywną sztuczną inteligencją, takie jak stronniczość i możliwość wyjaśnienia, oraz nowe, unikalne dla modeli fundamentowych (FM), w tym halucynacje i toksyczność. W AWS jesteśmy zobowiązani do odpowiedzialne rozwijanie generatywnej sztucznej inteligencji, stosując podejście skoncentrowane na ludziach, które priorytetowo traktuje edukację, naukę i naszych klientów, aby zintegrować odpowiedzialną sztuczną inteligencję w całym cyklu życia sztucznej inteligencji.

W ciągu ostatniego roku wprowadziliśmy nowe możliwości w naszych generatywnych aplikacjach i modelach AI, takie jak wbudowane skanowanie bezpieczeństwa Zaklinacz kodów Amazon, szkolenia w zakresie wykrywania i blokowania szkodliwych treści w Amazon Tytanoraz ochrona prywatności danych w Amazońska skała macierzysta. Nasza inwestycja w bezpieczną, przejrzystą i odpowiedzialną generatywną sztuczną inteligencję obejmuje współpracę ze społecznością globalną i decydentami, w ramach której zachęcaliśmy i wspieraliśmy zarówno Dobrowolne zobowiązania Białego Domu dotyczące sztucznej inteligencji i Szczyt bezpieczeństwa AI w UK. Nadal współpracujemy z klientami, aby wdrożyć odpowiedzialną sztuczną inteligencję za pomocą specjalnie opracowanych narzędzi, takich jak Amazon SageMaker Wyjaśnij, Zarządzanie systemem uczenia maszynowego z Amazon SageMakerI więcej.

Przedstawiamy nową, odpowiedzialną innowację AI

W miarę skalowania generatywnej sztucznej inteligencji do nowych branż, organizacji i przypadków użycia, wzrostowi temu muszą towarzyszyć ciągłe inwestycje w odpowiedzialny rozwój FM. Klienci chcą, aby ich FM były budowane z myślą o bezpieczeństwie, uczciwości i ochronie, aby mogli z kolei odpowiedzialnie wdrażać sztuczną inteligencję. Z radością ogłaszamy na tegorocznym AWS re:Invent nowe możliwości wspierania odpowiedzialnych, generatywnych innowacji w zakresie sztucznej inteligencji w szerokim zakresie możliwości dzięki nowym wbudowanym narzędziom, zabezpieczeniom klientów, zasobom zwiększającym przejrzystość i narzędziom do zwalczania dezinformacji. Naszym celem jest zapewnienie klientom informacji potrzebnych do oceny FM pod kątem kluczowych aspektów odpowiedzialnej sztucznej inteligencji, takich jak toksyczność i solidność, a także wprowadzenie poręczy umożliwiających stosowanie zabezpieczeń w oparciu o przypadki użycia przez klientów i zasady odpowiedzialnej sztucznej inteligencji. Jednocześnie nasi klienci chcą być lepiej poinformowani o bezpieczeństwie, uczciwości, ochronie i innych właściwościach usług AI i FM, ponieważ korzystają z nich we własnej organizacji. Z radością ogłaszamy więcej zasobów, które pomogą klientom lepiej zrozumieć nasze usługi AWS AI i zapewnić przejrzystość, o którą proszą.

Wdrażanie zabezpieczeń: Poręcze zabezpieczające dla Amazon Bedrock

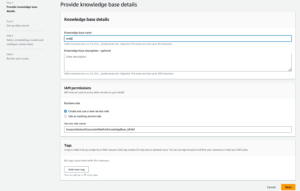

Bezpieczeństwo jest priorytetem przy wprowadzaniu generatywnej sztucznej inteligencji na dużą skalę. Organizacje chcą promować bezpieczne interakcje między swoimi klientami a generatywnymi aplikacjami AI, które unikają szkodliwego lub obraźliwego języka i są zgodne z polityką firmy. Najprostszym sposobem na osiągnięcie tego jest wprowadzenie spójnych zabezpieczeń w całej organizacji, aby każdy mógł bezpiecznie wprowadzać innowacje. Wczoraj ogłosiliśmy premierę Poręcze dla Amazon Bedrock— nowa funkcja ułatwiająca wdrażanie zabezpieczeń specyficznych dla aplikacji w oparciu o przypadki użycia przez klientów i odpowiedzialne zasady sztucznej inteligencji.

Poręcze zapewniają spójność reakcji FM na Amazon Bedrock na niepożądane i szkodliwe treści w aplikacjach. Klienci mogą stosować poręcze do dużych modeli językowych na Amazon Bedrock, a także do modeli precyzyjnie dostrojonych oraz w połączeniu z Agenci Amazon Bedrock. Guardrails pozwala określić tematy, których należy unikać, a usługa automatycznie wykrywa zapytania i odpowiedzi należące do zastrzeżonych kategorii oraz zapobiega im. Klienci mogą także skonfigurować progi filtrowania treści dla różnych kategorii, w tym mowy nienawiści, obelg, języka o charakterze seksualnym i przemocy, aby odfiltrować szkodliwe treści do pożądanego poziomu. Na przykład aplikację bankowości internetowej można skonfigurować tak, aby unikać udzielania porad inwestycyjnych i ograniczać nieodpowiednie treści (takie jak mowa nienawiści, obelgi i przemoc). W najbliższej przyszłości klienci będą mogli także redagować informacje umożliwiające identyfikację we wpisach użytkowników i odpowiedziach FM, ustawiać filtry wulgaryzmów i dostarczać listę niestandardowych słów do blokowania w interakcjach pomiędzy użytkownikami a FM, poprawiając zgodność i dalsze ochrona użytkowników. Dzięki Guardrails możesz szybciej wprowadzać innowacje dzięki generatywnej sztucznej inteligencji, zachowując jednocześnie zabezpieczenia i zabezpieczenia zgodne z polityką firmy.

Identyfikacja najlepszego FM dla konkretnego przypadku użycia: ocena modelu w Amazon Bedrock

Obecnie organizacje mają do dyspozycji szeroką gamę opcji FM wspomagających generatywne aplikacje AI. Aby osiągnąć właściwą równowagę między dokładnością i wydajnością w przypadku ich użycia, organizacje muszą skutecznie porównywać modele i znajdować najlepszą opcję w oparciu o kluczowe odpowiedzialne dla nich wskaźniki sztucznej inteligencji i jakości. Aby ocenić modele, organizacje muszą najpierw spędzić kilka dni na identyfikowaniu punktów odniesienia, konfigurowaniu narzędzi oceny i przeprowadzaniu ocen, a wszystko to wymaga głębokiej wiedzy z zakresu analityki danych. Co więcej, testy te nie są przydatne do oceny kryteriów subiektywnych (np. głosu marki, trafności i stylu), które wymagają oceny na podstawie żmudnych, czasochłonnych procesów weryfikacji przez człowieka. Czas, wiedza specjalistyczna i zasoby potrzebne do tych ocen – dla każdego nowego przypadku użycia – utrudniają organizacjom ocenę modeli pod kątem odpowiedzialnych wymiarów sztucznej inteligencji i dokonanie świadomego wyboru, który model zapewni klientom najdokładniejsze i najbezpieczniejsze środowisko.

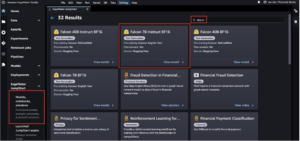

Teraz dostępne w wersji zapoznawczej, Ocena modelu na Amazon Bedrock pomaga klientom oceniać, porównywać i wybierać najlepsze FM dla ich konkretnego przypadku użycia w oparciu o niestandardowe wskaźniki, takie jak dokładność i bezpieczeństwo, przy użyciu ocen automatycznych lub ludzkich. W konsoli Amazon Bedrock klienci wybierają FM, które chcą porównać pod kątem danego zadania, np. odpowiedzi na pytanie czy podsumowania treści. W przypadku ocen automatycznych klienci wybierają wstępnie zdefiniowane kryteria oceny (np. dokładność, solidność i toksyczność) i przesyłają własny zestaw danych testowych lub wybierają spośród wbudowanych, publicznie dostępnych zestawów danych. W przypadku kryteriów subiektywnych lub zniuansowanych treści wymagających oceny klienci mogą łatwo skonfigurować przepływy pracy oceny opartej na ludziach za pomocą zaledwie kilku kliknięć. Te przepływy pracy wykorzystują wewnętrzny zespół roboczy klienta lub zarządzaną siłę roboczą dostarczoną przez AWS, aby ocenić odpowiedzi modelu. Podczas ocen opartych na ludziach klienci definiują wskaźniki specyficzne dla danego przypadku użycia (np. trafność, styl i głos marki). Gdy klienci zakończą proces konfiguracji, Amazon Bedrock przeprowadza oceny i generuje raport, dzięki czemu klienci mogą łatwo zrozumieć, jak model działał w oparciu o kluczowe kryteria bezpieczeństwa i dokładności oraz wybrać najlepszy model dla swojego przypadku użycia.

Ta możliwość oceny modeli nie ogranicza się do Amazon Bedrock, klienci mogą również skorzystać z oceny modeli w Amazon SageMaker Clarify, aby łatwo ocenić, porównać i wybrać najlepszą opcję FM w oparciu o kluczowe wskaźniki jakości i odpowiedzialności, takie jak dokładność, solidność i toksyczność – we wszystkich wszystkie FM.

Zwalczanie dezinformacji: znak wodny w Amazon Titan

Dziś ogłosiliśmy Generator obrazu Amazon Titan w wersji zapoznawczej, która umożliwia klientom szybkie tworzenie i ulepszanie obrazów o wysokiej jakości na dużą skalę. Uwzględniliśmy odpowiedzialną sztuczną inteligencję na każdym etapie procesu opracowywania modelu, w tym przy wyborze danych szkoleniowych, budowaniu możliwości filtrowania w celu wykrywania i usuwania nieodpowiednich danych wejściowych użytkowników i wyników modelu oraz zwiększaniu różnorodności demograficznej wyników naszego modelu. Wszystkie obrazy wygenerowane przez Amazon Titan domyślnie zawierają niewidoczny znak wodny, który ma pomóc w ograniczeniu rozprzestrzeniania się dezinformacji poprzez zapewnienie dyskretnego mechanizmu identyfikacji obrazów wygenerowanych przez sztuczną inteligencję. AWS jest jednym z pierwszych dostawców modeli, który szeroko udostępnił wbudowane, niewidoczne znaki wodne, które są zintegrowane z wyjściowymi obrazami i zaprojektowane tak, aby były odporne na zmiany.

Budowanie zaufania: Wspieranie naszych modeli i aplikacji z zabezpieczeniem

Budowanie zaufania klientów jest podstawą AWS. Od samego początku towarzyszymy naszym klientom w podróży, a wraz z rozwojem generatywnej sztucznej inteligencji nadal angażujemy się we wspólne budowanie innowacyjnych technologii. Aby umożliwić klientom wykorzystanie mocy naszej generatywnej sztucznej inteligencji, muszą wiedzieć, że są chronieni. AWS oferuje ochronę praw autorskich dla wyników następujących generatywnych usług sztucznej inteligencji Amazon: Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazonka Lex, Amazon Personalizuj. Oznacza to, że klienci korzystający z usług w sposób odpowiedzialny są chronieni przed roszczeniami osób trzecich z tytułu naruszenia praw autorskich przez produkty generowane przez te usługi (patrz sekcja 50.10 Regulaminu). Warunki świadczenia usług). Ponadto nasze standardowe zabezpieczenie własności intelektualnej za korzystanie z usług chroni klientów przed roszczeniami stron trzecich dotyczącymi naruszenia własności intelektualnej przez usługi i dane wykorzystywane do ich szkolenia. Inaczej mówiąc, jeśli korzystasz z wymienionej powyżej usługi generowania sztucznej inteligencji Amazon i ktoś pozwie Cię za naruszenie własności intelektualnej, AWS będzie bronić tego pozwu, co obejmuje pokrycie wszelkich wydanych przeciwko Tobie wyroków lub pokrycie kosztów ugody.

Wspieramy nasze generatywne usługi AI i pracujemy nad ich ciągłym ulepszaniem. W miarę jak AWS wprowadza nowe usługi, a generatywna sztuczna inteligencja stale ewoluuje, AWS będzie w dalszym ciągu nieprzerwanie koncentrować się na zdobywaniu i utrzymywaniu zaufania klientów.

Większa przejrzystość: karta serwisowa AWS AI dla tekstu Amazon Titan

We wprowadził karty usługowe AWS AI na re:Invent 2022 jako źródło przejrzystości, które pomoże klientom lepiej zrozumieć nasze usługi AWS AI. Karty usług AI to forma odpowiedzialnej dokumentacji AI, która zapewnia klientom jedno miejsce, w którym można znaleźć informacje na temat zamierzonych przypadków użycia i ograniczeń, odpowiedzialnych wyborów projektowych AI oraz najlepszych praktyk w zakresie wdrażania i optymalizacji wydajności naszych usług AI. Stanowią one część kompleksowego procesu rozwoju, którego podejmujemy się, aby budować nasze usługi w odpowiedzialny sposób, który uwzględnia uczciwość, wyjaśnialność, prawdziwość i solidność, zarządzanie, przejrzystość, prywatność i bezpieczeństwo, bezpieczeństwo i możliwość kontroli.

Podczas re:Invent w tym roku ogłaszamy: nowa karta usług AI dla Amazon Titan Text w celu zwiększenia przejrzystości modeli fundamentów. Wprowadzamy także cztery nowe karty usług AI, w tym: Amazon Zrozumienie Wykryj PII, Wykrywanie toksyczności w transkrypcji Amazon, Amazon Recognition Żywotność twarzy, AWS HealthScribe. Każdą z tych kart możesz eksplorować na stronie internetowej AWS-a. W miarę ciągłego rozwoju i ewolucji generatywnej sztucznej inteligencji przejrzystość sposobu opracowywania, testowania i wykorzystywania technologii będzie istotnym elementem zdobywania zaufania zarówno organizacji, jak i ich klientów. W AWS dokładamy wszelkich starań, aby w dalszym ciągu udostępniać szerszej społeczności zasoby zapewniające przejrzystość, takie jak karty usług AI, a także powtarzać i zbierać opinie na temat najlepszych rozwiązań.

Inwestowanie w odpowiedzialną sztuczną inteligencję w całym cyklu życia generatywnej sztucznej inteligencji

Jesteśmy podekscytowani nowymi innowacjami ogłoszonymi w tym tygodniu na konferencji re:Invent, które zapewniają naszym klientom więcej narzędzi, zasobów i wbudowanych zabezpieczeń umożliwiających bezpieczne tworzenie i korzystanie z generatywnej sztucznej inteligencji. Od oceny modelu po poręcze i znak wodny — klienci mogą teraz szybciej wprowadzać generatywną sztuczną inteligencję do swojej organizacji, ograniczając jednocześnie ryzyko. Nowe zabezpieczenia dla klientów, takie jak ubezpieczenie własności intelektualnej i nowe zasoby zwiększające przejrzystość, takie jak dodatkowe karty usług AI, to także kluczowe przykłady naszego zaangażowania w budowanie zaufania wśród firm technologicznych, decydentów, grup społecznych, naukowców i nie tylko. Kontynuujemy znaczące inwestycje w odpowiedzialną sztuczną inteligencję w całym cyklu życia modelu podstawowego, aby pomóc naszym klientom skalować sztuczną inteligencję w bezpieczny i odpowiedzialny sposób.

O autorach

Piotr Halinan prowadzi inicjatywy w zakresie nauki i praktyki Odpowiedzialnej AI w AWS AI wraz z zespołem odpowiedzialnych ekspertów AI. Ma głębokie doświadczenie w sztucznej inteligencji (doktorat, Harvard) i przedsiębiorczości (Blindsight, sprzedany Amazonowi). Jego działalność wolontariacka obejmowała pracę jako profesor-konsultant w Szkole Medycznej Uniwersytetu Stanforda oraz jako prezes Amerykańskiej Izby Handlowej na Madagaskarze. Jeśli to możliwe, wyjeżdża z dziećmi w góry: na narty, wspinaczkę, wędrówki i rafting

Piotr Halinan prowadzi inicjatywy w zakresie nauki i praktyki Odpowiedzialnej AI w AWS AI wraz z zespołem odpowiedzialnych ekspertów AI. Ma głębokie doświadczenie w sztucznej inteligencji (doktorat, Harvard) i przedsiębiorczości (Blindsight, sprzedany Amazonowi). Jego działalność wolontariacka obejmowała pracę jako profesor-konsultant w Szkole Medycznej Uniwersytetu Stanforda oraz jako prezes Amerykańskiej Izby Handlowej na Madagaskarze. Jeśli to możliwe, wyjeżdża z dziećmi w góry: na narty, wspinaczkę, wędrówki i rafting

Wasi Filomin jest obecnie wiceprezesem ds. Generative AI w AWS. Kieruje działaniami związanymi z generatywną sztuczną inteligencją, w tym Amazon Bedrock, Amazon Titan i Amazon CodeWhisperer.

Wasi Filomin jest obecnie wiceprezesem ds. Generative AI w AWS. Kieruje działaniami związanymi z generatywną sztuczną inteligencją, w tym Amazon Bedrock, Amazon Titan i Amazon CodeWhisperer.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- :ma

- :Jest

- :nie

- $W GÓRĘ

- 10

- 100

- 125

- 2022

- 50

- a

- zdolność

- Zdolny

- O nas

- powyżej

- towarzyszy

- precyzja

- dokładny

- w poprzek

- zajęcia

- dodatek

- Dodatkowy

- Adresy

- Rada

- przed

- AI

- Usługi AI

- zmierzać

- wyrównać

- zarówno

- Wszystkie kategorie

- wzdłuż

- również

- Amazonka

- Zaklinacz kodów Amazon

- Amazon Sage Maker

- Amazon Web Services

- amerykański

- wśród

- an

- i

- Ogłosić

- ogłosił

- Ogłaszając

- Inne

- każdy

- Zastosowanie

- aplikacje

- Aplikuj

- podejście

- SĄ

- na około

- AS

- pytanie

- oceny

- At

- automatycznie

- automatycznie

- dostępny

- uniknąć

- unikany

- AWS

- AWS re: Invent

- Bilans

- Bankowość

- na podstawie

- BE

- być

- zanim

- za

- Benchmarki

- BEST

- Najlepsze praktyki

- Ulepsz Swój

- pomiędzy

- stronniczość

- Blokować

- obie

- marka

- przynieść

- Przynosi

- szeroki

- szerszy

- budować

- budować zaufanie

- Budowanie

- wybudowany

- wbudowany

- by

- CAN

- możliwości

- zdolność

- karta

- Kartki okolicznosciowe

- walizka

- Etui

- kategorie

- wyzwania

- Izba

- Dzieci

- wybór

- wybory

- Dodaj

- roszczenia

- Wspinaczka

- współpraca

- zwalczania

- połączenie

- byliśmy spójni, od początku

- Handel

- zobowiązanie

- zobowiązany

- wspólny

- społeczność

- Firmy

- sukcesy firma

- porównać

- spełnienie

- składnik

- zrozumieć

- wszechstronny

- Rozważania

- za

- zgodny

- Konsola

- consulting

- zawierać

- zawartość

- nieustannie

- kontynuować

- ciągły

- kontynuując

- prawo autorskie

- naruszenie praw autorskich

- rdzeń

- Koszty:

- pokrycie

- pokrycie

- Kryteria

- Obecnie

- zwyczaj

- klient

- Klientów

- dane

- prywatność danych

- nauka danych

- zbiory danych

- Dni

- głęboko

- głęboka ekspertyza

- Domyślnie

- określić

- dostarczyć

- demograficzny

- rozwijać

- Wdrożenie

- Wnętrze

- zaprojektowany

- życzenia

- wykryć

- rozwinięty

- oprogramowania

- trudny

- Wymiary

- dezinformacja

- Różnorodność

- do

- dokumentacja

- napęd

- podczas

- e

- każdy

- zarabiać

- Zarobek

- Najprostszym

- z łatwością

- łatwo

- Edukacja

- skutecznie

- starania

- bądź

- upoważnia

- umożliwiać

- zachęcać

- koniec końców

- wzmacniać

- Cały

- przedsiębiorczość

- Eter (ETH)

- oceniać

- oceny

- ewaluację

- oceny

- Każdy

- wszyscy

- ewoluuje

- przykład

- przykłady

- podniecony

- doświadczenie

- ekspertyza

- eksperci

- Wyjaśnialność

- odkryj

- ekspresowy

- Twarz

- uczciwość

- Spadać

- szybciej

- informacja zwrotna

- kilka

- filtrować

- filtracja

- filtry

- Znajdź

- koniec

- i terminów, a

- Skupiać

- następujący

- W razie zamówieenia projektu

- Nasz formularz

- Naprzód

- Sprzyjać

- Fundacja

- cztery

- od

- dalej

- Ponadto

- przyszłość

- zbierać

- wygenerowane

- generuje

- generatywny

- generatywna sztuczna inteligencja

- dany

- daje

- Globalne

- zarządzanie

- Grupy

- Rosnąć

- Wzrost

- szkodliwy

- uprząż

- harvard

- nienawidzić

- mowy nienawiści

- Have

- he

- pomoc

- pomaga

- wysokiej jakości

- turystyka

- jego

- dom

- W jaki sposób

- HTTPS

- człowiek

- zidentyfikować

- identyfikacja

- if

- obraz

- zdjęcia

- wdrożenia

- ważny

- podnieść

- poprawy

- in

- początek

- zawierać

- włączony

- obejmuje

- Włącznie z

- Zwiększać

- przemysłowa

- Informacja

- poinformowany

- naruszenie

- inicjatywy

- wprowadzać innowacje

- Innowacja

- innowacje

- Innowacyjny

- Innowacyjna technologia

- Wejścia

- integrować

- zintegrowany

- zamierzony

- Interakcje

- najnowszych

- przedstawiać

- wprowadzono

- wprowadzenie

- inwestycja

- Inwestycje

- niewidoczny

- IP

- IT

- podróż

- jpg

- właśnie

- Klawisz

- Wiedzieć

- język

- duży

- uruchamia

- wodowanie

- proces sądowy

- Wyprowadzenia

- pozwala

- poziom

- Dźwignia

- wifecycwe

- lubić

- LIMIT

- Ograniczenia

- Ograniczony

- Lista

- Katalogowany

- utrzymanie

- robić

- WYKONUJE

- zarządzane

- wymowny

- znaczy

- mechanizm

- lekarstwo

- Metryka

- nic

- łagodzenie

- model

- modele

- jeszcze

- większość

- musi

- Blisko

- Potrzebować

- Nowości

- już dziś

- of

- poza

- obraźliwy

- Oferty

- on

- pewnego razu

- te

- Online

- bankowości online

- optymalizacja

- Option

- Opcje

- or

- organizacja

- organizacji

- Inne

- ludzkiej,

- na zewnątrz

- Wyjścia

- własny

- część

- Przeszłość

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywane

- Osobiście

- PhD

- pii

- Miejsce

- plato

- Analiza danych Platona

- PlatoDane

- polityka

- politycy

- możliwy

- power

- praktyka

- praktyki

- prezydent

- zapobiega

- Podgląd

- ustala priorytety

- priorytet

- prywatność

- Prywatność i bezpieczeństwo

- wygląda tak

- produkować

- BLUŹNIERSTWO

- profesjonalny

- Profesor

- obiecujący

- promować

- niska zabudowa

- chroniony

- ochrony

- chroni

- zapewniać

- pod warunkiem,

- dostawców

- że

- publicznie

- położyć

- jakość

- zapytania

- podnosi

- zasięg

- szybki

- szybko

- RE

- zmniejszyć

- zwolnić

- mających znaczenie

- pozostawać

- usunąć

- raport

- wymagany

- Wymaga

- odporny

- Zasób

- Zasoby

- Odpowiadać

- Odpowiedzi

- odpowiedzialność

- odpowiedzialny

- odpowiedzialnie

- ograniczony

- prawo

- Ryzyko

- krzepkość

- bieganie

- działa

- "bezpiecznym"

- zabezpieczenia

- bezpiecznie

- Bezpieczeństwo

- sagemaker

- taki sam

- Skala

- skala ai

- waga

- skanowanie

- Szkoła

- nauka

- Naukowcy

- Sekcja

- bezpieczne

- bezpieczeństwo

- widzieć

- wybierać

- wybór

- usługa

- Usługi

- służąc

- zestaw

- ustawienie

- osada

- ustawienie

- ponieważ

- pojedynczy

- So

- sprzedany

- kilka

- Ktoś

- specyficzny

- przemówienie

- wydać

- rozpiętość

- STAGE

- stoisko

- standard

- stojący

- Stanford

- Uniwersytet Stanford

- strajk

- styl

- taki

- Pozywa

- Utrzymany

- podtrzymany

- biorąc

- Zadanie

- zespół

- Technologia

- firmy technologiczne

- przetestowany

- Testowanie

- Testy

- XNUMX

- że

- Połączenia

- Informacje

- UK

- ich

- Im

- Te

- one

- innych firm

- to

- w tym tygodniu

- w tym roku

- tych

- Przez

- czas

- tytan

- do

- razem

- narzędzia

- tematy

- Pociąg

- Trening

- Przezroczystość

- przezroczysty

- Zaufaj

- SKRĘCAĆ

- Uk

- zrozumieć

- podjąć

- wyjątkowy

- uniwersytet

- posługiwać się

- przypadek użycia

- używany

- Użytkownik

- Użytkownicy

- za pomocą

- istotny

- Głos

- dobrowolny

- wolontariusz

- vp

- chcieć

- watermark

- znak wodny

- Znaki wodne

- Droga..

- sposoby

- we

- sieć

- usługi internetowe

- Strona internetowa

- tydzień

- DOBRZE

- były

- Co

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- KIM

- cały

- szeroki

- Szeroki zasięg

- szeroko

- będzie

- w

- w ciągu

- słowa

- Praca

- przepływów pracy

- Siła robocza

- rok

- wczoraj

- ty

- zefirnet