1Wydział Fizyki, Uniwersytet Waterloo, Waterloo, ON, N2L 3G1, Kanada

2Instytut Obliczeń Kwantowych, Waterloo, ON, N2L 3G1, Kanada

3Perimeter Institute for Theoretical Physics, Waterloo, Ontario, N2L 2Y5, Kanada

4Xanadu, Toronto, ON, M5G 2C8, Kanada

Czy ten artykuł jest interesujący czy chcesz dyskutować? Napisz lub zostaw komentarz do SciRate.

Abstrakcyjny

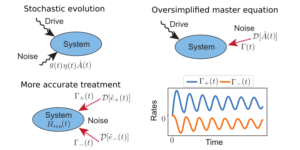

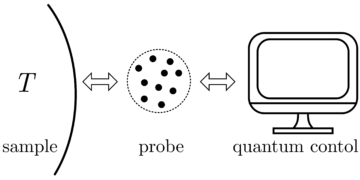

Powszechny sukces głębokich sieci neuronowych ujawnił niespodziankę w klasycznym uczeniu maszynowym: bardzo złożone modele często dobrze generalizują, a jednocześnie nadmiernie dopasowują dane szkoleniowe. Zjawisko łagodnego nadmiernego dopasowania badano w różnych modelach klasycznych w celu lepszego zrozumienia mechanizmów leżących u podstaw głębokiego uczenia się. Scharakteryzowanie tego zjawiska w kontekście kwantowego uczenia maszynowego może w podobny sposób poprawić nasze zrozumienie związku między nadmiernym dopasowaniem, przeparametryzowaniem i uogólnieniem. W tej pracy przedstawiamy charakterystykę łagodnego nadmiernego dopasowania w modelach kwantowych. W tym celu wyprowadzamy zachowanie klasycznych interpolujących modeli cech Fouriera dla regresji na zaszumionych sygnałach i pokazujemy, jak klasa modeli kwantowych wykazuje analogiczne cechy, łącząc w ten sposób strukturę obwodów kwantowych (takich jak kodowanie danych i operacje przygotowania stanu ) do przeparametryzacji i nadmiernego dopasowania w modelach kwantowych. Intuicyjnie wyjaśniamy te cechy zgodnie ze zdolnością modelu kwantowego do interpolacji zaszumionych danych z lokalnie „kolczastym” zachowaniem i dostarczamy konkretny przykład demonstracyjny łagodnego nadmiernego dopasowania.

► Dane BibTeX

► Referencje

[1] Michaela Nielsena. „Sieci neuronowe i głębokie uczenie się”. Determinacja Naciśnij. (2015). adres URL: http:///neuralnetworksanddeeplearning.com/.

http: // neuralnetworksanddeeplearning.com/

[2] Stuart Geman, Elie Bienenstock i René Doursat. „Sieci neuronowe i dylemat stronniczości/wariancji”. Obliczenia neuronowe. 4, 1–58 (1992).

https: // doi.org/ 10.1162 / neco.1992.4.1.1

[3] Trevor Hastie, Robert Tibshirani, Jerome H. Friedman i Jerome H. Friedman. „Elementy uczenia się statystycznego: eksploracja danych, wnioskowanie i przewidywanie”. Tom 2. Springer. (2009).

https://doi.org/10.1007/978-0-387-84858-7

[4] Peter L. Bartlett, Andrea Montanari i Alexander Rakhlin. „Głębokie uczenie się: statystyczny punkt widzenia”. Acta Numerica 30, 87–201 (2021).

https: / / doi.org/ 10.1017 / S0962492921000027

[5] Michaił Belkin. „Dopasuj bez strachu: niezwykłe matematyczne zjawiska głębokiego uczenia się przez pryzmat interpolacji”. Acta Numerica 30, 203–248 (2021).

[6] Peter L. Bartlett, Philip M. Long, Gábor Lugosi i Alexander Tsigler. „Łagodne nadmierne dopasowanie w regresji liniowej”. Proc. Natl. Acad. Nauka. 117, 30063–30070 (2020).

https: / / doi.org/ 10.1073 / pnas.1907378117

[7] Michaił Belkin, Daniel Hsu, Siyuan Ma i Soumik Mandal. „Pogodzenie nowoczesnej praktyki uczenia maszynowego i klasycznego kompromisu w zakresie odchyleń i wariancji”. Proc. Natl. Acad. Nauka. 116, 15849–15854 (2019).

https: / / doi.org/ 10.1073 / pnas.1903070116

[8] Michaił Biełkin, Aleksander Rachlin i Aleksandr B. Cybakow. „Czy interpolacja danych jest sprzeczna ze statystyczną optymalnością?”. W Proceedings of Machine Learning Research. Tom 89, strony 1611–1619. PMLR (2019). adres URL: https:///proceedings.mlr.press/v89/belkin19a.html.

https:///proceedings.mlr.press/v89/belkin19a.html

[9] Vidya Muthukumar, Kailas Vodrahalli, Vignesh Subramanian i Anant Sahai. „Nieszkodliwa interpolacja zaszumionych danych w regresji”. IEEE Journal on Selected Areas in Information Theory 1, 67–83 (2020).

https: / / doi.org/ 10.1109 / ISIT.2019.8849614

[10] Vidya Muthukumar, Adhyyan Narang, Vignesh Subramanian, Mikhail Belkin, Daniel Hsu i Anant Sahai. „Klasyfikacja a regresja w reżimach przeparametryzowanych: czy funkcja straty ma znaczenie?”. J. Mach. Uczyć się. Rozdzielczość 22, 1–69 (2021). adres URL: http:///jmlr.org/papers/v22/20-603.html.

http: // jmlr.org/ papers / v22 / 20-603.html

[11] Yehuda Dar, Vidya Muthukumar i Richard G. Baraniuk. „Pożegnanie z kompromisem w zakresie odchylenia i wariancji? przegląd teorii przeparametryzowanego uczenia maszynowego” (2021). arXiv:2109.02355.

arXiv: 2109.02355

[12] Marcello Benedetti, Erika Lloyd, Stefan Sack i Mattia Fiorentini. „Sparametryzowane obwody kwantowe jako modele uczenia maszynowego”. Nauka kwantowa. Techn. 4, 043001 (2019).

https://doi.org/10.1088/2058-9565/ab4eb5

[13] K. Mitarai, M. Negoro, M. Kitagawa i K. Fujii. „Uczenie się obwodów kwantowych”. fizyka Wersja A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / physreva.98.032309

[14] Maria Schuld, Ville Bergholm, Christian Gogolin, Josh Izaac i Nathan Killoran. „Ocena gradientów analitycznych na sprzęcie kwantowym”. fizyka Rev. A 99, 032331 (2019).

https: / / doi.org/ 10.1103 / physreva.99.032331

[15] Marii Schuld i Nathana Killorana. „Kwantowe uczenie maszynowe w przestrzeniach Hilberta”. fizyka Wielebny Lett. 122, 040504 (2019).

https: / / doi.org/ 10.1103 / physrevlett.122.040504

[16] Vojtěch Havlíček, Antonio D. Córcoles, Kristan Temme, Aram W. Harrow, Abhinav Kandala, Jerry M. Chow i Jay M. Gambetta. „Nadzorowane uczenie się z przestrzeniami cech wzmocnionymi kwantowo”. Natura 567, 209–212 (2019).

https://doi.org/10.1038/s41586-019-0980-2

[17] Setha Lloyda i Christiana Weedbrooka. „Kwantowo-generatywne uczenie się kontradyktoryjne”. Fiz. Wielebny Lett. 121, 040502 (2018).

https: / / doi.org/ 10.1103 / physrevlett.121.040502

[18] Pierre-Luc Dallaire-Demers i Nathan Killoran. „Kwantowe generatywne sieci przeciwne”. Fiz. Rev. A 98, 012324 (2018).

https: / / doi.org/ 10.1103 / physreva.98.012324

[19] Amira Abbas, David Sutter, Christa Zoufal, Aurelien Lucchi, Alessio Figalli i Stefan Woerner. „Siła kwantowych sieci neuronowych”. Nat. Oblicz. Nauka. 1, 403–409 (2021).

https://doi.org/10.1038/s43588-021-00084-1

[20] Logana G. Wrighta i Petera L. McMahona. „Wydajność kwantowych sieci neuronowych”. W 2020 r. Konferencja na temat laserów i elektrooptyki (CLEO). Strony 1–2. (2020). adres URL: https:///ieeexplore.ieee.org/document/9193529.

https: // ieeexplore.ieee.org/ document / 9193529

[21] Sukin Sim, Peter D. Johnson i Alán Aspuru-Guzik. „Wyrażalność i zdolność splątania sparametryzowanych obwodów kwantowych dla hybrydowych algorytmów kwantowo-klasycznych”. Adw. Technologia kwantowa. 2, 1900070 (2019).

https: / / doi.org/ 10.1002 / qute.201900070

[22] Thomas Hubregtsen, Josef Pichlmeier, Patrick Stecher i Koen Bertels. „Ocena sparametryzowanych obwodów kwantowych: o związku między dokładnością klasyfikacji, wyrazistością i zdolnością splątania”. Kwantowy Mach. Intel. 3, 1 (2021).

https: / / doi.org/ 10.1007 / s42484-021-00038-w

[23] Jarrod R. McClean, Sergio Boixo, Vadim N. Smelyanskiy, Ryan Babbush i Hartmut Neven. „Jałowe płaskowyże w krajobrazach szkoleniowych kwantowych sieci neuronowych”. Nat. komuna. 9, 4812 (2018).

https://doi.org/10.1038/s41467-018-07090-4

[24] Marco Cerezo, Akira Sone, Tyler Volkoff, Łukasz Cincio i Patrick J. Coles. „Zależne od funkcji kosztu jałowe plateau w płytkich sparametryzowanych obwodach kwantowych”. Nat. komuna. 12, 1791 (2021).

https: / / doi.org/ 10.1038 / s41467-021-21728-w

[25] Matthias C. Caro, Elies Gil-Fuster, Johannes Jakob Meyer, Jens Eisert i Ryan Sweke. „Zależne od kodowania granice uogólnienia dla sparametryzowanych obwodów kwantowych”. Kwant 5, 582 (2021).

https://doi.org/10.22331/q-2021-11-17-582

[26] Hsin-Yuan Huang, Michael Broughton, Masoud Mohseni, Ryan Babbush, Sergio Boixo, Hartmut Neven i Jarrod R McClean. „Moc danych w kwantowym uczeniu maszynowym”. Nat. komuna. 12, 2631 (2021).

https://doi.org/10.1038/s41467-021-22539-9

[27] Matthias C. Caro, Hsin-Yuan Huang, M. Cerezo, Kunal Sharma, Andrew Sornborger, Łukasz Cincio i Patrick J. Coles. „Uogólnienie kwantowego uczenia maszynowego na podstawie kilku danych szkoleniowych”. Nat. komuna. 13, 4919 (2022).

https://doi.org/10.1038/s41467-022-32550-3

[28] Leonardo Banchi, Jason Pereira i Stefano Pirandola. „Uogólnienie w kwantowym uczeniu maszynowym: punkt widzenia dotyczący informacji kwantowej”. PRX Quantum 2, 040321 (2021).

https: // doi.org/ 10.1103 / PRXQuantum.2.040321

[29] Francisco Javier Gil Vidal i Dirk Oliver Theis. „Redundancja wejściowa dla sparametryzowanych obwodów kwantowych”. Przód. Fiz. 8, 297 (2020).

https: / / doi.org/ 10.3389 / fphy.2020.00297

[30] Maria Schuld, Ryan Sweke i Johannes Jakob Meyer. „Wpływ kodowania danych na siłę wyrazu wariacyjnych modeli uczenia maszynowego kwantowego”. Fiz. Rev. A 103, 032430 (2021).

https: / / doi.org/ 10.1103 / physreva.103.032430

[31] David Wierichs, Josh Izaac, Cody Wang i Cedric Yen-Yu Lin. „Ogólne zasady przesunięcia parametrów dla gradientów kwantowych”. Kwant 6, 677 (2022).

https://doi.org/10.22331/q-2022-03-30-677

[32] Kendalla E. Atkinsona. „Wprowadzenie do analizy numerycznej”. Johna Wileya i synów. (2008).

[33] Ali Rahimi i Benjamin Recht. „Losowe funkcje dla maszyn z jądrem na dużą skalę”. Postępy w systemach przetwarzania informacji neuronowych. Tom 20. (2007). adres URL: https:///papers.nips.cc/paper_files/paper/2007/hash/013a006f03dbc5392effeb8f18fda755-Abstract.html.

https://papers.nips.cc/paper_files/paper/2007/hash/013a006f03dbc5392effeb8f18fda755-Abstract.html

[34] Waltera Rudina. „Podstawowe twierdzenia analizy Fouriera”. John Wiley & Sons, Ltd. (1990).

https: / / doi.org/ 10.1002 / 9781118165621.ch1

[35] Song Mei i Andrea Montanari. „Błąd uogólnienia regresji cech losowych: precyzyjna asymptotyka i krzywa podwójnego opadania”. komuna. Czysta aplikacja Matematyka. 75, 667–766 (2022).

https: / / doi.org/ 10.1002 / cpa.22008

[36] Trevor Hastie, Andrea Montanari, Saharon Rosset i Ryan J. Tibshirani. „Niespodzianki w wielowymiarowej interpolacji metodą najmniejszych kwadratów bez grzbietów”. Anna. Statystyka 50, 949 – 986 (2022).

https: / / doi.org/ 10.1214 / 21-AOS2133

[37] Tengyuan Liang, Alexander Rakhlin i Xiyu Zhai. „O wielokrotnym zejściu interpolantów o minimalnej normie i ograniczonej dolnej izometrii jąder”. W Proceedings of Machine Learning Research. Tom 125, strony 1–29. PMLR (2020). adres URL: http:///proceedings.mlr.press/v125/liang20a.html.

http:///proceedings.mlr.press/v125/liang20a.html

[38] Edwarda Farhiego i Hartmuta Nevena. „Klasyfikacja z kwantowymi sieciami neuronowymi na procesorach bliskiego terminu” (2018). arXiv:1802.06002.

arXiv: 1802.06002

[39] Maria Schuld, Alex Bocharov, Krysta M. Svore i Nathan Wiebe. „Klasyfikatory kwantowe skupione na obwodzie”. Fiz. Rev. A 101, 032308 (2020).

https: / / doi.org/ 10.1103 / physreva.101.032308

[40] Adrián Pérez-Salinas, Alba Cervera-Lierta, Elies Gil-Fuster i José I. Latorre. „Ponowne przesyłanie danych do uniwersalnego klasyfikatora kwantowego”. Kwant 4, 226 (2020).

https://doi.org/10.22331/q-2020-02-06-226

[41] Sofiene Jerbi, Lukas J. Fiderer, Hendrik Poulsen Nautrup, Jonas M. Kübler, Hans J. Briegel i Vedran Dunjko. „Kwantowe uczenie maszynowe wykraczające poza metody jądra”. Nat. komuna. 14, 517 (2023).

https: / / doi.org/ 10.1038 / s41467-023-36159-y

[42] Casper Gyurik, Dyon Vreumingen, van i Vedran Dunjko. „Minimalizacja ryzyka strukturalnego dla kwantowych klasyfikatorów liniowych”. Kwant 7, 893 (2023).

https://doi.org/10.22331/q-2023-01-13-893

[43] Maria Szuld. „Nadzorowane kwantowe modele uczenia maszynowego to metody jądra” (2021). arXiv:2101.11020.

arXiv: 2101.11020

[44] S. Shin, Y. S. Teo i H. Jeong. „Wykładnicze kodowanie danych dla uczenia się nadzorowanego kwantowo”. Fiz. Rev. A 107, 012422 (2023).

https: / / doi.org/ 10.1103 / PhysRevA.107.012422

[45] Zofia Piccard. „Sur les zespoły de Distances des Ensemble de Points d’un espace euclidien.”. Memoires de l'Universite de Neuchatel. Sekretariat de l'Universite. (1939).

[46] Dave Wecker, Matthew B. Hastings, Nathan Wiebe, Bryan K. Clark, Chetan Nayak i Matthias Troyer. „Rozwiązywanie silnie skorelowanych modeli elektronów na komputerze kwantowym”. Fiz. Rev. A 92, 062318 (2015).

https: / / doi.org/ 10.1103 / PhysRevA.92.062318

[47] Ian D. Kivlichan, Jarrod McClean, Nathan Wiebe, Craig Gidney, Alán Aspuru-Guzik, Garnet Kin-Lic Chan i Ryan Babbush. „Symulacja kwantowa struktury elektronicznej z liniową głębią i łącznością”. fizyka Wielebny Lett. 120, 110501 (2018).

https: / / doi.org/ 10.1103 / PhysRevLett.120.110501

[48] Martín Larocca, Frédéric Sauvage, Faris M. Sbahi, Guillaume Verdon, Patrick J. Coles i M. Cerezo. „Kwantowe uczenie maszynowe niezmiennicze w grupie”. PRX Quantum 3, 030341 (2022).

https: // doi.org/ 10.1103 / PRXQuantum.3.030341

[49] Johannes Jakob Meyer, Marian Mularski, Elies Gil-Fuster, Antonio Anna Mele, Francesco Arzani, Alissa Wilms i Jens Eisert. „Wykorzystanie symetrii w wariacyjnym kwantowym uczeniu maszynowym”. PRX Quantum 4, 010328 (2023).

https: // doi.org/ 10.1103 / PRXQuantum.4.010328

[50] Martin Larocca, Nathan Ju, Diego García-Martín, Patrick J. Coles i Marco Cerezo. „Teoria nadparametryzacji w kwantowych sieciach neuronowych”. Nat. Oblicz. Nauka. 3, 542–551 (2023).

https://doi.org/10.1038/s43588-023-00467-6

[51] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu i Dacheng Tao. „Ekspresyjna moc sparametryzowanych obwodów kwantowych”. Fiz. Ks. Res. 2, 033125 (2020).

https: / / doi.org/ 10.1103 / physrevresearch.2.033125

[52] Zoë Holmes, Kunal Sharma, M. Cerezo i Patrick J. Coles. „Łączenie wyrażalności ansatz z wielkościami gradientów i jałowymi płaskowyżami”. PRX Quantum 3, 010313 (2022).

https: // doi.org/ 10.1103 / PRXQuantum.3.010313

[53] Samson Wang, Enrico Fontana, Marco Cerezo, Kunal Sharma, Akira Sone, Łukasz Cincio i Patrick J. Coles. „Wywołane hałasem jałowe płaskowyże w wariacyjnych algorytmach kwantowych”. Nat. komuna. 12, 6961 (2021).

https://doi.org/10.1038/s41467-021-27045-6

[54] Abdulkadir Canatar, Evan Peters, Cengiz Pehlevan, Stefan M. Wild i Ruslan Shaydulin. „Przepustowość umożliwia uogólnienie modeli jądra kwantowego”. Transakcje dotyczące badań nad uczeniem maszynowym (2023). adres URL: https:///openreview.net/forum?id=A1N2qp4yAq.

https:///openreview.net/forum?id=A1N2qp4yAq

[55] Hsin-Yuan Huang, Michael Broughton, Jordan Cotler, Sitan Chen, Jerry Li, Masoud Mohseni, Hartmut Neven, Ryan Babbush, Richard Kueng, John Preskill i Jarrod R. McClean. „Kwantowa przewaga w uczeniu się na podstawie eksperymentów”. Nauka 376, 1182–1186 (2022).

https:///doi.org/10.1126/science.abn7293

[56] Sitan Chen, Jordan Cotler, Hsin-Yuan Huang i Jerry Li. „Wykładnicze separacje między uczeniem się z pamięcią kwantową i bez niej”. W 2021 r. odbędzie się 62. doroczne sympozjum IEEE na temat podstaw informatyki (FOCS). Strony 574–585. (2022).

https:///doi.org/10.1109/FOCS52979.2021.00063

[57] Hsin-Yuan Huang, Richard Kueng i John Preskill. „Teoretyczne ograniczenia informacji dotyczące przewagi kwantowej w uczeniu maszynowym”. Fiz. Wielebny Lett. 126, 190505 (2021).

https: / / doi.org/ 10.1103 / PhysRevLett.126.190505

[58] Ville Bergholm, Josh Izaac, Maria Schuld, Christian Gogolin, M. Sohaib Alam, Shahnawaz Ahmed, Juan Miguel Arrazola, Carsten Blank, Alain Delgado, Soran Jahangiri, Keri McKiernan, Johannes Jakob Meyer, Zeyue Niu, Antal Száva i Nathan Killoran. „Pennylane: Automatyczne różnicowanie hybrydowych obliczeń kwantowo-klasycznych” (2018). arXiv:1811.04968.

arXiv: 1811.04968

[59] Peter L. Bartlett, Philip M. Long, Gábor Lugosi i Alexander Tsigler. „Łagodne nadmierne dopasowanie w regresji liniowej”. Proc. Natl. Acad. Nauka. 117, 30063–30070 (2020).

https: / / doi.org/ 10.1073 / pnas.1907378117

[60] Władimir Kolczyński i Karim Lounici. „Nierówności koncentracji i granice momentów dla przykładowych operatorów kowariancji”. Bernoulli 23, 110 – 133 (2017).

https:///doi.org/10.3150/15-BEJ730

[61] Zbigniew Puchała i Jarosław Adam Miszczak. „Integracja symboliczna względem miary haar na grupie unitarnej”. Byk. Pol. Acad. Nauka. 65, 21–27 (2017).

https: // doi.org/ 10.1515 / bpasts-2017-0003

[62] Daniel A. Roberts i Beni Yoshida. „Chaos i złożoność już w fazie projektowania”. J. Fizyka wysokiej energii. 2017, 121 (2017).

https:///doi.org/10.1007/jhep04(2017)121

[63] Wallace’a C. Babcocka. „Częstotliwość występowania zakłóceń intermodulacyjnych w systemach radiowych i ich kontrola poprzez wybór kanału”. System dzwonkowy technologia J. 32, 63–73 (1953).

https: / / doi.org/ 10.1002 / j.1538-7305.1953.tb01422.x

[64] M. Atkinson, N. Santoro i J. Urrutia. „Zestawy liczb całkowitych z odrębnymi sumami i różnicami oraz przydziałami częstotliwości nośnych dla nieliniowych przemienników”. IEEE Trans. komuna. 34, 614–617 (1986).

https:///doi.org/10.1109/TCOM.1986.1096587

[65] J. Robinsona i A. Bernsteina. „Klasa binarnych kodów rekurencyjnych z ograniczoną propagacją błędów”. IEEE Trans. Inf. 13, 106–113 (1967).

https: / / doi.org/ 10.1109 / TIT.1967.1053951

[66] RJF Fang i WA Sandrin. „Przydział częstotliwości nośnej dla nieliniowych przemienników”. Przegląd techniczny COMSAT 7, 227–245 (1977).

Cytowany przez

[1] Alexey Melnikov, Mohammad Kordzanganeh, Alexander Alodjants i Ray-Kuang Lee, „Kwantowe uczenie maszynowe: od fizyki do inżynierii oprogramowania”, Postępy w fizyce X 8 1, 2165452 (2023).

[2] Mo Kordzanganeh, Pavel Sekatski, Leonid Fedichkin i Alexey Melnikov, „Wykładniczo rosnąca rodzina uniwersalnych obwodów kwantowych”, Uczenie maszynowe: nauka i technologia 4 3, 035036 (2023).

[3] Stefano Mangini, „Wariacyjne algorytmy kwantowe w uczeniu maszynowym: teoria i zastosowania”, arXiv: 2306.09984, (2023).

[4] Ben Jaderberg, Antonio A. Gentile, Youssef Achari Berrada, Elvira Shishenina i Vincent E. Elfving, „Niech kwantowe sieci neuronowe wybierają własne częstotliwości”, arXiv: 2309.03279, (2023).

[5] Yuxuan Du, Yibo Yang, Dacheng Tao i Min-Hsiu Hsieh, „Problem-Dependent Power of Quantum Neural Networks on Multiclass Classification”, Listy z przeglądu fizycznego 131 14, 140601 (2023).

[6] S. Shin, Y. S. Teo i H. Jeong, „Wykładnicze kodowanie danych dla uczenia się nadzorowanego kwantowo”, Przegląd fizyczny A 107 1, 012422 (2023).

[7] Elies Gil-Fuster, Jens Eisert i Carlos Bravo-Prieto, „Zrozumienie kwantowego uczenia maszynowego wymaga również ponownego przemyślenia uogólnień”, arXiv: 2306.13461, (2023).

[8] Jason Iaconis i Sonika Johri, „Efektywne ładowanie obrazów kwantowych w oparciu o sieć Tensor”, arXiv: 2310.05897, (2023).

[9] Alice Barthe i Adrián Pérez-Salinas, „Gradienty i profile częstotliwości modeli ponownego przesyłania kwantowego”, arXiv: 2311.10822, (2023).

[10] Tobias Haug i M. S. Kim, „Uogólnienie z geometrią kwantową do uczenia się unitarów”, arXiv: 2303.13462, (2023).

[11] Jonas Landman, Slimane Thabet, Constantin Dalyac, Hela Mhiri i Elham Kashefi, „Klasycznie przybliżające wariacyjne kwantowe uczenie maszynowe z losowymi funkcjami Fouriera”, arXiv: 2210.13200, (2022).

[12] Berta Casas i Alba Cervera-Lierta, „Wielowymiarowy szereg Fouriera z obwodami kwantowymi”, Przegląd fizyczny A 107 6, 062612 (2023).

[13] Elies Gil-Fuster, Jens Eisert i Vedran Dunjko, „O wyrazistości osadzania jąder kwantowych”, arXiv: 2309.14419, (2023).

[14] Lucas Slattery, Ruslan Shaydulin, Shouvanik Chakrabarti, Marco Pistoia, Sami Khairy i Stefan M. Wild, „Numeryczne dowody przeciwko przewadze z jądrami wierności kwantowej na danych klasycznych”, Przegląd fizyczny A 107 6, 062417 (2023).

[15] Mo Kordzanganeh, Daria Kosichkina i Alexey Melnikov, „Równoległe sieci hybrydowe: interakcja między kwantowymi i klasycznymi sieciami neuronowymi”, arXiv: 2303.03227, (2023).

[16] Aikaterini, Gratsea i Patrick Huembeli, „Wpływ operatorów przetwarzania i pomiaru na moc ekspresyjną modeli kwantowych”, arXiv: 2211.03101, (2022).

[17] Shun Okumura i Masayuki Ohzeki, „Współczynnik Fouriera sparametryzowanych obwodów kwantowych i problem jałowego plateau”, arXiv: 2309.06740, (2023).

[18] Massimiliano Incudini, Michele Grossi, Antonio Mandarino, Sofia Vallecorsa, Alessandra Di Pierro i David Windridge, „The Quantum Path Kernel: a Generalized Quantum Neural Tangent Kernel for Deep Quantum Machine Learning”, arXiv: 2212.11826, (2022).

[19] Jorja J. Kirk, Matthew D. Jackson, Daniel J. M. King, Philip Intallura i Mekena Metcalf, „Emergent Order in Classical Data Representations on Ising Spin Models”, arXiv: 2303.01461, (2023).

[20] Francesco Scala, Andrea Ceschini, Massimo Panella i Dario Gerace, „A General Approach to Dropout in Quantum Neural Networks”, arXiv: 2310.04120, (2023).

[21] Julian Berberich, Daniel Fink, Daniel Pranjić, Christian Tutschku i Christian Holm, „Trening solidnych i możliwych do uogólnienia modeli kwantowych”, arXiv: 2311.11871, (2023).

Powyższe cytaty pochodzą z Reklamy SAO / NASA (ostatnia aktualizacja pomyślnie 2023-12-21 00:40:54). Lista może być niekompletna, ponieważ nie wszyscy wydawcy podają odpowiednie i pełne dane cytowania.

On Serwis cytowany przez Crossref nie znaleziono danych na temat cytowania prac (ostatnia próba 2023-12-21 00:40:53).

Niniejszy artykuł opublikowano w Quantum pod Creative Commons Uznanie autorstwa 4.0 Międzynarodowe (CC BY 4.0) licencja. Prawa autorskie należą do pierwotnych właścicieli praw autorskich, takich jak autorzy lub ich instytucje.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://quantum-journal.org/papers/q-2023-12-20-1210/

- :ma

- :Jest

- :nie

- 1

- 10

- 107

- 11

- 110

- 116

- 12

- 120

- 121

- 125

- 13

- 14

- 15%

- 16

- 17

- 1791

- 19

- 20

- 2008

- 2015

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 35%

- 36

- 39

- 40

- 41

- 43

- 46

- 49

- 50

- 51

- 52

- 53

- 54

- 58

- 60

- 65

- 66

- 7

- 75

- 8

- 9

- 98

- a

- Abbas

- zdolność

- powyżej

- ABSTRACT

- dostęp

- Stosownie

- precyzja

- Adam

- zaliczki

- Korzyść

- przeciwny

- powiązania

- przed

- Ahmed

- alex

- Alexander

- Algorytmy

- alicja

- Wszystkie kategorie

- również

- an

- analiza

- Analityczny

- i

- Andrew

- anna

- roczny

- aplikacje

- podejście

- SĄ

- obszary

- AS

- próba

- autor

- Autorzy

- automatycznie

- b

- bary

- na podstawie

- podstawowy

- BE

- być

- zachowanie

- za

- Dzwon

- ben

- Beniaminek

- Ulepsz Swój

- pomiędzy

- Poza

- pusty

- miedza

- przerwa

- Bryan

- byk

- by

- zdolność

- Pojemność

- Carlos

- casper

- chan

- Kanał

- chen

- Dodaj

- jedzenie

- chrześcijański

- cytując

- klasa

- klasyfikacja

- Kody

- komentarz

- Lud

- kompletny

- kompleks

- kompleksowość

- obliczenia

- komputer

- Computer Science

- computing

- beton

- Konferencja

- Łączność

- kontekst

- kontrola

- prawo autorskie

- współzależny

- Craig

- krzywa

- Daniel

- dane

- data mining

- Dave

- David

- grudzień

- głęboko

- głęboka nauka

- głębokie sieci neuronowe

- To

- zależny

- głębokość

- czerpać

- Wnętrze

- Mimo

- determinacja

- Diego

- Różnice

- dyskutować

- odrębny

- do

- robi

- Podwójna

- e

- Edward

- efekt

- wydajny

- Elektroniczny

- Elementy

- osadzanie

- Umożliwia

- kodowanie

- energia

- Inżynieria

- Erika

- błąd

- Eter (ETH)

- dowód

- przykład

- eksponaty

- eksperymenty

- Wyjaśniać

- wykładniczy

- ekspresyjny

- członków Twojej rodziny

- pożegnanie

- strach

- Cecha

- Korzyści

- kilka

- wierność

- W razie zamówieenia projektu

- znaleziono

- Fundamenty

- Francisco

- Częstotliwość

- od

- z przodu

- funkcjonować

- Ogólne

- generatywny

- generatywne sieci przeciwne

- geometria

- cel

- gradienty

- Zarządzanie

- sprzęt komputerowy

- harvard

- Wysoki

- posiadacze

- W jaki sposób

- HTML

- http

- HTTPS

- Huang

- Hybrydowy

- hybrydowy kwantowo-klasyczny

- i

- IEEE

- zdjęcia

- podnieść

- in

- Nierówności

- Informacja

- Instytut

- instytucje

- integracja

- ciekawy

- ingerencja

- na świecie

- Wprowadzenie

- Jackson

- JAVASCRIPT

- Jerome

- John

- Johnson

- Jordania

- dziennik

- John

- Karim

- Kendall

- Kim

- król

- kaplica

- na dużą skalę

- Lasery

- Nazwisko

- UCZYĆ SIĘ

- nauka

- najmniej

- Pozostawiać

- Lee

- niech

- li

- Licencja

- Ograniczony

- lin

- Powiązanie

- Lista

- załadunek

- lokalnie

- Logan

- długo

- od

- niższy

- Ltd

- maszyna

- uczenie maszynowe

- maszyny

- struktura

- maria

- Martin

- matematyka

- matematyczny

- Materia

- Matthew

- Matthias

- Może..

- Mcclean

- zmierzyć

- pomiary

- Mechanizmy

- Pamięć

- metcalf

- metody

- Meyer

- Michał

- może

- michaił

- minimalizacja

- Górnictwo

- model

- modele

- Nowoczesne technologie

- moment

- Miesiąc

- wielokrotność

- Natura

- Blisko

- sieć

- sieci

- Nerwowy

- sieci neuronowe

- sieci neuronowe

- Nie

- występowanie

- of

- często

- Oliver

- on

- Ontario

- koncepcja

- operacje

- operatorzy

- or

- zamówienie

- oryginalny

- ludzkiej,

- przegląd

- własny

- stron

- Papier

- Parallel

- ścieżka

- Patrick

- Piotr

- zjawisko

- Fizyka

- plato

- Analiza danych Platona

- PlatoDane

- zwrotnica

- power

- praktyka

- precyzyjny

- przepowiednia

- przygotowanie

- naciśnij

- Problem

- PROC

- Obrady

- przetwarzanie

- Procesory

- profile

- propagacja

- zapewniać

- opublikowany

- wydawca

- wydawcy

- Kwant

- przewaga kwantowa

- algorytmy kwantowe

- Komputer kwantowy

- informatyka kwantowa

- informacja kwantowa

- kwantowe uczenie maszynowe

- R

- radio

- przypadkowy

- nawracający

- referencje

- reżimy

- regresja

- relacja

- związek

- szczątki

- znakomity

- Wymaga

- Badania naukowe

- poszanowanie

- ograniczony

- Ujawnił

- przeglądu

- Richard

- Ryzyko

- ROBERT

- krzepki

- reguły

- Ryan

- s

- Scala

- SCI

- nauka

- Nauka i technika

- wybrany

- wybór

- Serie

- Zestawy

- płytki

- Sharma

- pokazać

- Sygnały

- TAK

- Podobnie

- symulacja

- jednocześnie

- Tworzenie

- Inżynieria oprogramowania

- piosenka

- obowiązuje

- Spin

- kwadraty

- punkt widzenia

- Stan

- statystyczny

- stefan

- strongly

- Struktura

- Studiował

- sukces

- Z powodzeniem

- taki

- odpowiedni

- sumy

- Nadzorowana nauka

- niespodzianka

- Sympozjum

- systemy

- tech

- Techniczny

- Technologia

- semestr

- Połączenia

- ich

- teoretyczny

- teoria

- a tym samym

- Te

- to

- Przez

- Tytuł

- do

- Toronto

- Trening

- trans

- transakcje

- Trevor

- Tyler

- UN

- dla

- zrozumienie

- uniwersalny

- uniwersytet

- zaktualizowane

- URL

- różnorodność

- początku.

- vincent

- Tom

- vs

- W

- Wang

- chcieć

- była

- we

- DOBRZE

- Podczas

- rozpowszechniony

- Dziki

- w

- bez

- Praca

- działa

- Wright

- X

- rok

- zefirnet