Na wynos

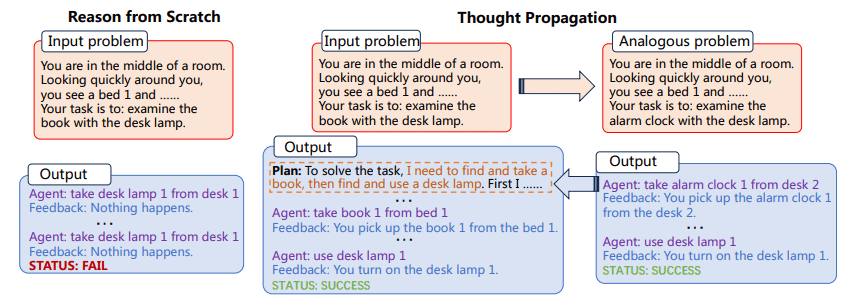

- Propagacja myśli (TP) to nowatorska metoda, która zwiększa możliwości złożonego rozumowania dużych modeli językowych (LLM).

- Zamiast tworzyć argumenty LLM od zera, TP wykorzystuje analogiczne problemy i ich rozwiązania, aby ulepszyć rozumowanie.

- Eksperymenty obejmujące różne zadania pokazują, że TP znacznie przewyższa metody podstawowe, a ulepszenia wahają się od 12% do 15%.

TP w pierwszej kolejności skłania LLM do zaproponowania i rozwiązania zestawu analogicznych problemów, które są powiązane z problemem wejściowym. Następnie TP ponownie wykorzystuje wyniki analogicznych problemów, aby bezpośrednio opracować nowe rozwiązanie lub opracować oparty na wiedzy plan wykonania w celu zmiany pierwotnego rozwiązania uzyskanego od podstaw.

Wszechstronność i moc obliczeniowa modeli wielkojęzykowych (LLM) są niezaprzeczalne, ale nie są nieograniczone. Jednym z najbardziej znaczących i spójnych wyzwań stojących przed LLM jest ich ogólne podejście do rozwiązywania problemów, polegające na rozumowaniu na podstawie pierwszych zasad w przypadku każdego nowego napotkanego zadania. Jest to problematyczne, ponieważ pozwala na wysoki stopień adaptacji, ale także zwiększa prawdopodobieństwo błędów, szczególnie w zadaniach wymagających wieloetapowego rozumowania.

Wyzwanie, jakim jest „wnioskowanie od zera”, jest szczególnie widoczne w przypadku złożonych zadań, które wymagają wielu etapów logiki i wnioskowania. Na przykład, jeśli LLM zostanie poproszony o znalezienie najkrótszej ścieżki w sieci połączonych ze sobą punktów, zazwyczaj nie będzie wykorzystywał wcześniejszej wiedzy ani analogicznych problemów do znalezienia rozwiązania. Zamiast tego próbowałby rozwiązać problem w izolacji, co może prowadzić do nieoptymalnych wyników, a nawet wręcz błędów. Wchodzić Propagacja myśli (TP), metoda zaprojektowana w celu zwiększenia możliwości rozumowania LLM. Celem TP jest przezwyciężenie nieodłącznych ograniczeń LLM, umożliwienie im czerpania ze zbioru analogicznych problemów i odpowiadających im rozwiązań. To innowacyjne podejście nie tylko poprawia dokładność rozwiązań generowanych w ramach LLM, ale także znacznie zwiększa ich zdolność do radzenia sobie z wieloetapowymi, złożonymi zadaniami rozumowania. Wykorzystując siłę analogii, TP zapewnia ramy wzmacniające wrodzone możliwości rozumowania LLM, przybliżając nas o krok do stworzenia naprawdę inteligentnych sztucznych systemów.

Propagacja myśli obejmuje dwa główne etapy:

- Po pierwsze, LLM jest proszony o zaproponowanie i rozwiązanie zestawu analogicznych problemów związanych z problemem wejściowym

- Następnie rozwiązania tych analogicznych problemów są wykorzystywane do bezpośredniego uzyskania nowego rozwiązania lub zmiany rozwiązania początkowego

Proces identyfikowania analogicznych problemów pozwala LLM na ponowne wykorzystanie strategii i rozwiązań rozwiązywania problemów, poprawiając w ten sposób swoje zdolności rozumowania. TP jest kompatybilna z istniejącymi metodami podpowiedzi, zapewniając uogólnione rozwiązanie, które można włączyć do różnych zadań bez konieczności wykonywania znacznych prac inżynieryjnych dostosowanych do konkretnego zadania.

Rysunek 1: Proces propagacji myśli (zdjęcie z papieru)

Ponadto nie należy lekceważyć zdolności adaptacyjnych TP. Zgodność z istniejącymi metodami podpowiedzi sprawia, że jest to narzędzie bardzo wszechstronne. Oznacza to, że TP nie ogranicza się do żadnego konkretnego rodzaju domeny rozwiązywania problemów. Otwiera to ekscytujące możliwości dostrajania i optymalizacji pod kątem konkretnych zadań, podnosząc w ten sposób użyteczność i skuteczność LLM w szerokim spektrum zastosowań.

Wdrożenie propagacji myśli można zintegrować z przepływem pracy istniejących LLM. Na przykład w zadaniu Rozumowanie najkrótszą ścieżką TP może najpierw rozwiązać zestaw prostszych, analogicznych problemów, aby zrozumieć różne możliwe ścieżki. Następnie wykorzystałby te spostrzeżenia do rozwiązania złożonego problemu, zwiększając w ten sposób prawdopodobieństwo znalezienia optymalnego rozwiązania.

1 przykład

- Zadanie: Rozumowanie najkrótszą ścieżką

- Problemy analogiczne: Najkrótsza droga pomiędzy punktami A i B, Najkrótsza droga pomiędzy punktami B i C

- Ostateczne rozwiązanie: Optymalna droga z punktu A do C, biorąc pod uwagę rozwiązania analogicznych problemów

2 przykład

- Zadanie: Twórcze pisanie

- Problemy analogiczne: Napisz krótką historię o przyjaźni. Napisz krótką historię o zaufaniu

- Ostateczne rozwiązanie: Napisz złożone opowiadanie, które integruje tematy przyjaźni i zaufania

Proces ten polega najpierw na rozwiązaniu analogicznych problemów, a następnie wykorzystaniu zdobytych spostrzeżeń do rozwiązania złożonego zadania. Metoda ta wykazała swoją skuteczność w przypadku wielu zadań, wykazując znaczną poprawę wskaźników wydajności.

Konsekwencje propagowania myśli wykraczają poza zwykłą poprawę istniejących wskaźników. Ta technika podpowiedzi może zmienić sposób, w jaki rozumiemy i wdrażamy LLM. Metodologia podkreśla przejście od izolowanego, atomowego rozwiązywania problemów do bardziej holistycznego, wzajemnie powiązanego podejścia. Skłania nas to do zastanowienia się, w jaki sposób LLM mogą uczyć się nie tylko na podstawie danych, ale także na podstawie samego procesu rozwiązywania problemów. Dzięki ciągłemu aktualizowaniu swojej wiedzy poprzez rozwiązania analogicznych problemów, LLM wyposażone w TP są lepiej przygotowane do stawienia czoła nieprzewidzianym wyzwaniom, dzięki czemu są bardziej odporne i elastyczne w szybko zmieniających się środowiskach.

Propagacja myśli to obiecujący dodatek do zestawu metod podpowiedzi mających na celu zwiększenie możliwości LLM. Umożliwiając LLM wykorzystanie analogicznych problemów i ich rozwiązań, TP zapewnia bardziej zniuansowaną i skuteczną metodę rozumowania. Eksperymenty potwierdzają jego skuteczność, co czyni go kandydatem na strategię poprawy wydajności LLM w różnych zadaniach. TP może ostatecznie stanowić znaczący krok naprzód w poszukiwaniu bardziej wydajnych systemów sztucznej inteligencji.

Mateusz Majo (@ Mattmayo13.) posiada tytuł magistra informatyki oraz dyplom ukończenia studiów wyższych w zakresie eksploracji danych. Jako redaktor naczelny KDnuggets Matthew stara się udostępniać złożone koncepcje analityki danych. Jego zainteresowania zawodowe obejmują przetwarzanie języka naturalnego, algorytmy uczenia maszynowego i odkrywanie powstającej sztucznej inteligencji. Kieruje nim misja demokratyzacji wiedzy w społeczności analityki danych. Matthew koduje od 6 roku życia.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.kdnuggets.com/thought-propagation-an-analogical-approach-to-complex-reasoning-with-large-language-models?utm_source=rss&utm_medium=rss&utm_campaign=thought-propagation-an-analogical-approach-to-complex-reasoning-with-large-language-models

- :ma

- :Jest

- :nie

- $W GÓRĘ

- 15%

- 8

- a

- zdolności

- zdolność

- O nas

- dostępny

- precyzja

- w poprzek

- dodatek

- AI

- Systemy SI

- wymierzony

- Cele

- Algorytmy

- Pozwalać

- pozwala

- również

- wzmacnia

- an

- i

- każdy

- aplikacje

- podejście

- SĄ

- sztuczny

- AS

- At

- próba

- zwiększać

- aleje

- b

- Baseline

- BE

- być

- Ulepsz Swój

- pomiędzy

- Poza

- Bringing

- szeroki

- ale

- by

- CAN

- kandydat

- możliwości

- zdolny

- wyzwanie

- wyzwania

- bliższy

- Kodowanie

- społeczność

- zgodność

- zgodny

- kompleks

- obliczeniowy

- moc obliczeniowa

- komputer

- Computer Science

- Koncepcje

- Potwierdzać

- Rozważać

- wobec

- zgodny

- Składający się

- bez przerwy

- Odpowiedni

- mógłby

- Twórczy

- dane

- data mining

- nauka danych

- Stopień

- Kreowanie

- zdemokratyzować

- wykazać

- rozwijać

- zaprojektowany

- bezpośrednio

- domena

- rysować

- napędzany

- redaktor naczelny

- Efektywne

- skuteczność

- skuteczność

- bądź

- budujący

- wschodzących

- Inżynieria

- Poprawia

- wzmocnienie

- Wchodzę

- środowiska

- wyposażony

- Błędy

- szczególnie

- Parzyste

- Każdy

- ewoluuje

- przykład

- ekscytujący

- egzekucja

- Przede wszystkim system został opracowany

- eksperymenty

- Exploring

- Znajdź

- znalezieniu

- i terminów, a

- W razie zamówieenia projektu

- Naprzód

- Framework

- Przyjaźń

- od

- zdobyte

- Ogólne

- Go

- absolwent

- ręka

- he

- Wysoki

- wysoko

- jego

- posiada

- holistyczne

- W jaki sposób

- HTTPS

- identyfikacja

- if

- obraz

- realizacja

- implikacje

- podnieść

- ulepszenia

- poprawia

- poprawy

- in

- zawierać

- Rejestrowy

- Zwiększenia

- wzrastający

- nieodłączny

- początkowy

- wrodzony

- Innowacyjny

- wkład

- spostrzeżenia

- zamiast

- zintegrowany

- Integruje się

- Inteligentny

- połączone

- zainteresowania

- najnowszych

- dotyczy

- odosobniony

- izolacja

- IT

- JEGO

- samo

- jpg

- właśnie

- Knuggety

- Uprzejmy

- wiedza

- język

- duży

- prowadzić

- UCZYĆ SIĘ

- nauka

- Dźwignia

- wykorzystuje

- lewarowanie

- prawdopodobieństwo

- LIMIT

- Ograniczenia

- Ograniczony

- logika

- maszyna

- uczenie maszynowe

- Główny

- robić

- WYKONUJE

- Dokonywanie

- mistrz

- Matthew

- Może..

- znaczy

- jedynie

- metoda

- Metodologia

- metody

- Metryka

- Górnictwo

- Misja

- modele

- jeszcze

- większość

- wielokrotność

- Naturalny

- Język naturalny

- Przetwarzanie języka naturalnego

- sieć

- Nowości

- nowe rozwiązanie

- powieść

- uzyskane

- of

- Stary

- on

- ONE

- tylko

- otwiera

- Optymalny

- optymalizacja

- or

- Przewyższa

- wprost

- Przezwyciężać

- Papier

- szczególnie

- ścieżka

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- krok po kroku

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- zwrotnica

- możliwy

- potencjał

- power

- przygotowany

- Zasady

- Wcześniejszy

- Problem

- rozwiązanie problemu

- problemy

- wygląda tak

- przetwarzanie

- profesjonalny

- obiecujący

- wyraźny

- propagacja

- zaproponować

- zapewnia

- że

- nośny

- szybko

- raczej

- realizacja

- powód

- związane z

- wykonanie

- reprezentować

- wymagać

- sprężysty

- Efekt

- ponownie

- s

- nauka

- zadraśnięcie

- Szukaj

- zestaw

- przesunięcie

- Short

- powinien

- pokazać

- ściąganie

- znaczący

- znacznie

- ponieważ

- rozwiązanie

- Rozwiązania

- ROZWIĄZANIA

- Rozwiązywanie

- specyficzny

- Widmo

- Ewolucja krok po kroku

- Cel

- Historia

- strategie

- Strategia

- znaczny

- w zasadzie

- systemy

- sprzęt

- Zadanie

- zadania

- technika

- niż

- że

- Połączenia

- ich

- Im

- motywy

- następnie

- a tym samym

- Te

- one

- to

- myśl

- Przez

- do

- narzędzie

- Toolbox

- w kierunku

- tp

- naprawdę

- Zaufaj

- drugiej

- zazwyczaj

- Ostatecznie

- niezaprzeczalny

- podkreślenia

- zrozumieć

- zrozumienie

- nieprzewidziany

- aktualizowanie

- us

- posługiwać się

- używany

- za pomocą

- użyteczność

- różnorodność

- różnorodny

- wszechstronny

- wszechstronność

- była

- we

- który

- w

- bez

- workflow

- by

- napisać

- pisanie

- lat

- jeszcze

- Wydajność

- zefirnet