Obraz autorstwa redaktora

Jest rok 2023, co oznacza, że większość firm w większości branż zbiera informacje i podejmuje mądrzejsze decyzje za pomocą dużych zbiorów danych. Nie jest to w dzisiejszych czasach takie zaskoczenie — możliwość gromadzenia, kategoryzowania i analizowania dużych zbiorów danych jest niezwykle przydatna, jeśli chodzi o podejmowanie decyzji biznesowych w oparciu o dane.

A ponieważ coraz więcej organizacji przechodzi na cyfryzację, zdolność do zrozumienia przydatności analizy danych i polegania na niej będzie nadal rosła.

Oto sprawa związana z dużymi danymi: im więcej organizacji zaczyna na nich polegać, tym większa staje się szansa, że więcej z nich będzie wykorzystywać duże zbiory danych nieprawidłowo. Dlaczego? Ponieważ duże zbiory danych i spostrzeżenia, które oferują, są przydatne tylko wtedy, gdy organizacje dokładnie analizują swoje dane.

Obraz z drabinka danych

W tym celu upewnijmy się, że unikasz typowych błędów, które często wpływają na dokładność analizy danych. Czytaj dalej, aby dowiedzieć się o tych problemach i jak możesz ich uniknąć.

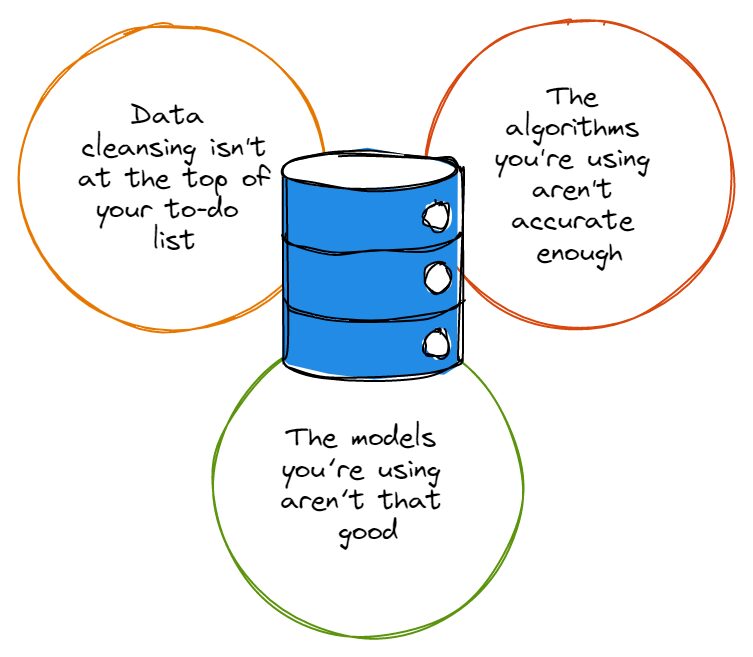

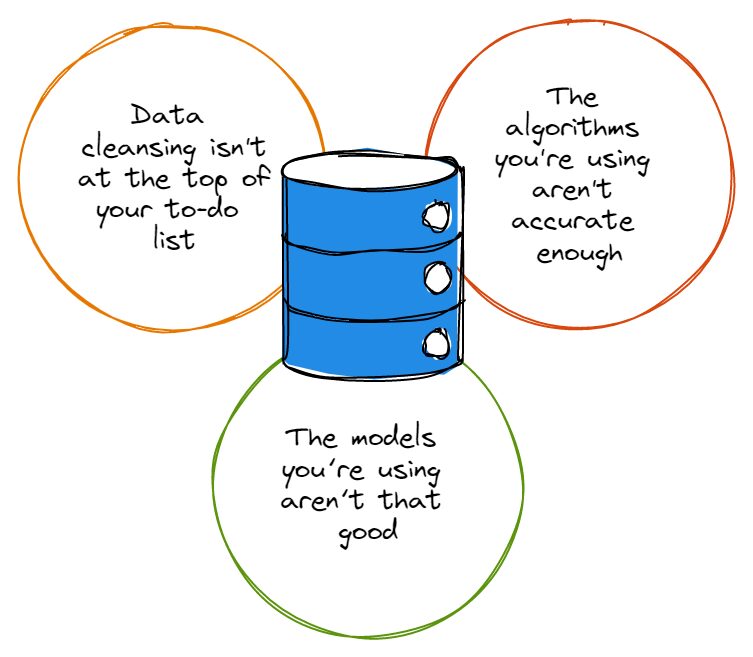

Zanim przejdziemy do wytykania palcami, musimy przyznać, że większość zestawów danych zawiera sporo błędów, a te błędy nie przynoszą nikomu żadnej przysługi, gdy przychodzi czas na analizę danych. Niezależnie od tego, czy są to literówki, dziwne konwencje nazewnictwa czy nadmiarowość, błędy w zestawach danych utrudniają dokładność analizy danych.

Więc zanim będziesz zbyt podekscytowany głębokim nurkowaniem do króliczej nory analizy danych, musisz najpierw upewnić się, że czyszczenie danych znajduje się na szczycie listy rzeczy do zrobienia i że zawsze właściwie oczyszczasz swoje zbiory danych. Być może mówisz: „hej, czyszczenie danych jest dla mnie zbyt czasochłonne”, na co kiwamy głowami ze współczuciem.

Na szczęście dla Ciebie możesz inwestować w rozwiązania takie jak rozszerzona analityka. Wykorzystuje to algorytmy uczenia maszynowego do przyspieszenia tempa przeprowadzania analizy danych (i poprawia również dokładność analizy).

Podsumowując: bez względu na to, jakiego rozwiązania użyjesz do automatyzacji i ulepszenia czyszczenia danych, nadal musisz przeprowadzić rzeczywiste czyszczenie — jeśli tego nie zrobisz, nigdy nie będziesz mieć odpowiednich podstaw, na których można oprzeć dokładną analizę danych.

Podobnie jak w przypadku zbiorów danych, większość algorytmów nie jest w stu procentach doskonała; większość z nich ma sporo wad i po prostu nie działa tak, jak byś tego chciał za każdym razem, gdy ich używasz. Algorytmy z wieloma niedoskonałościami mogą nawet ignorować dane, które są niezbędne do analizy, lub mogą skupiać się na niewłaściwym rodzaju danych, które w rzeczywistości nie są tak ważne.

Nie jest tajemnicą, że są to największe nazwiska w branży technologicznej stale analizując swoje algorytmy i dostrajanie ich tak blisko perfekcji, jak to tylko możliwe, a to dlatego, że tak niewiele algorytmów jest w rzeczywistości bezbłędnych. Im dokładniejszy jest twój algorytm, tym większa gwarancja, że twoje programy osiągają swoje cele i robią to, czego potrzebujesz.

Ponadto, jeśli Twoja organizacja zatrudnia choćby kilku analityków danych, powinna upewnić się, że ci analitycy danych regularnie aktualizują algorytmy, które są wykorzystywane w ich programach do analizy danych — warto nawet ustalić harmonogram, zgodnie z którym zespoły będą odpowiedzialne za utrzymanie oraz aktualizowanie ich algorytmów analizy danych zgodnie z uzgodnionym harmonogramem.

Jeszcze lepiej niż to może być ustanowienie strategii, która wykorzystuje algorytmy oparte na AI/ML, które powinny mieć możliwość automatycznej aktualizacji.

Co zrozumiałe, wielu liderów biznesowych, którzy nie są bezpośrednio zaangażowani w swoje zespoły ds. analizy danych, nie zdaje sobie sprawy, że algorytmy i modele nie są tymi samymi rzeczami. Jeśli TY też nie byłeś tego świadomy, pamiętaj, że algorytmy to metody, których używamy do analizy danych; modele to obliczenia, które powstają dzięki wykorzystaniu danych wyjściowych algorytmu.

Algorytmy mogą przetwarzać dane przez cały dzień, ale jeśli ich dane wyjściowe nie przechodzą przez modele zaprojektowane do sprawdzania późniejszej analizy, nie będziesz mieć żadnych użytecznych ani przydatnych spostrzeżeń.

Pomyśl o tym w ten sposób: jeśli masz fantazyjne algorytmy przetwarzające dane, ale nie masz żadnych spostrzeżeń do pokazania, nie będziesz podejmować decyzji opartych na danych ani lepiej, niż byłeś przed tymi algorytmami; to tak, jakby chcieć włączyć badania użytkowników do planu działania produktu, ale ignorować fakt, że na przykład branża badań rynkowych wygenerował 76.4 miliarda dolarów przychodów w 2021 r., co stanowi 100% wzrost od 2008 r.

Twoje intencje mogą być godne podziwu, ale musisz wykorzystać dostępne nowoczesne narzędzia i wiedzę, aby zebrać te spostrzeżenia lub włączyć badania użytkowników do planu działania najlepiej jak potrafisz.

To niefortunne, że modele suboptymalne są niezawodnym sposobem na bałagan w wynikach algorytmów, bez względu na to, jak wyrafinowane są te algorytmy. Dlatego tak ważne jest, aby dyrektorzy biznesowi i liderzy techniczni ściślej angażowali swoich ekspertów ds. analizy danych w celu tworzenia modeli, które nie są ani zbyt skomplikowane, ani zbyt proste.

W zależności od ilości danych, z którymi pracują, liderzy biznesowi mogą zdecydować się na kilka różnych modeli, zanim zdecydują się na taki, który najlepiej odpowiada ilości i rodzajowi danych, z którymi muszą sobie poradzić.

Na koniec dnia, jeśli chcesz mieć pewność, że analiza danych nie jest konsekwentnie błędna, musisz również pamiętać o nigdy nie paść ofiarą uprzedzeń. Odchylenie jest niestety jedną z największych przeszkód, które należy pokonać, jeśli chodzi o utrzymanie dokładności analizy danych.

Niezależnie od tego, czy mają wpływ na rodzaj gromadzonych danych, czy też na sposób, w jaki liderzy biznesowi interpretują dane, uprzedzenia są zróżnicowane i często trudne do ustalenia — dyrektorzy muszą zrobić wszystko, co w ich mocy, aby zidentyfikować swoje uprzedzenia i zrezygnować z nich, aby konsekwentnie korzystać z dokładna analiza danych.

Dane mają potężną moc: odpowiednio wykorzystane mogą zapewnić liderom biznesowym i ich organizacjom niezwykle przydatne informacje, które mogą zmienić sposób, w jaki opracowują i dostarczają swoje produkty swoim klientom. Upewnij się tylko, że robisz wszystko, co w Twojej mocy, aby zapewnić dokładność analiz danych i uniknąć łatwo możliwych do uniknięcia błędów, które opisaliśmy w tym artykule.

Nahlę Davies jest programistą i pisarzem technicznym. Zanim całkowicie poświęciła się pracy nad pisaniem technicznym, udało jej się – między innymi intrygujących rzeczy – służyć jako główny programista w empirycznej organizacji brandingowej Inc. 5,000, której klientami są Samsung, Time Warner, Netflix i Sony.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://www.kdnuggets.com/2023/03/3-mistakes-could-affecting-accuracy-data-analytics.html?utm_source=rss&utm_medium=rss&utm_campaign=3-mistakes-that-could-be-affecting-the-accuracy-of-your-data-analytics

- :Jest

- 000

- 2021

- 2023

- a

- zdolności

- zdolność

- Zdolny

- O nas

- przyśpieszyć

- osiągnięcie

- precyzja

- dokładny

- dokładnie

- faktycznie

- zachwycający

- przyznać

- oddziaływać

- wpływający

- algorytm

- Algorytmy

- Wszystkie kategorie

- zawsze

- wśród

- analiza

- analityka

- w czasie rzeczywistym sprawiają,

- Analizując

- i

- ktoś

- SĄ

- artykuł

- AS

- At

- zwiększona

- zautomatyzować

- automatycznie

- dostępny

- unikając

- baza

- BE

- bo

- staje się

- zanim

- jest

- korzyści

- BEST

- Ulepsz Swój

- stronniczość

- Duży

- Big Data

- większe

- Najwyższa

- Dolny

- branding

- budować

- Pęczek

- biznes

- biznes

- by

- CAN

- walizka

- szansa

- ZOBACZ

- Dodaj

- klientów

- Zamknij

- dokładnie

- Codecademy

- Zbieranie

- jak

- wspólny

- skomplikowane

- obliczenia

- kontynuować

- Konwencje

- mógłby

- Para

- Stwórz

- stworzony

- schrupać

- Klientów

- dane

- analiza danych

- Analityka danych

- zestawy danych

- sterowane danymi

- dzień

- Dni

- Decyzje

- głęboko

- dostarczyć

- W zależności

- zaprojektowany

- rozwijać

- Deweloper

- różne

- trudny

- digitalizacja

- bezpośrednio

- robi

- na dół

- jazdy

- z łatwością

- bądź

- objąć

- zobowiązany

- zaangażowany

- zapewnić

- Błędy

- niezbędny

- zapewniają

- ustanowienie

- Parzyste

- Każdy

- wszystko

- przykład

- podniecony

- kierownictwo

- empiryczny

- eksperci

- sprawiedliwy

- Spadać

- przysługi

- kilka

- i terminów, a

- Skazy

- Skupiać

- następujący

- W razie zamówieenia projektu

- Fundacja

- od

- pełny

- otrzymać

- Go

- Gole

- będzie

- przyznać

- chwycić

- większy

- Największym

- Rosnąć

- Rozwój

- gwarancja

- uchwyt

- Have

- głowice

- pomoc

- posiada

- W jaki sposób

- HTML

- http

- HTTPS

- Przeszkody

- zidentyfikować

- niezmiernie

- ważny

- podnieść

- poprawia

- in

- Inc

- zawierać

- niepoprawnie

- Zwiększać

- przemysłowa

- przemysł

- wpływanie

- spostrzeżenia

- intencje

- Inwestuj

- problemy

- IT

- jpg

- Knuggety

- Uprzejmy

- wiedza

- prowadzić

- Przywódcy

- UCZYĆ SIĘ

- nauka

- wykorzystuje

- lewarowanie

- lubić

- Linia

- Lista

- długo

- Partia

- maszyna

- uczenie maszynowe

- robić

- Dokonywanie

- zarządzane

- rynek

- badania rynku

- Materia

- znaczy

- metody

- błędy

- modele

- Nowoczesne technologie

- jeszcze

- większość

- Nazwy

- nazywania

- Potrzebować

- Ani

- Netflix

- numer

- of

- Oferty

- on

- ONE

- zamówienie

- organizacja

- organizacji

- Inne

- opisane

- wydajność

- Przezwyciężać

- procent

- doskonały

- wykonać

- BADANIA PEW

- plato

- Analiza danych Platona

- PlatoDane

- możliwy

- power

- mocny

- Produkt

- Produkty

- Programista

- Programy

- właściwy

- prawidłowo

- królik

- Kurs

- RE

- Czytaj

- zrealizować

- regularnie

- pamiętać

- reprezentowanie

- Badania naukowe

- dochód

- mapa drogowa

- s

- taki sam

- Samsung

- rozkład

- Naukowcy

- Tajemnica

- służyć

- Zestawy

- rozstrzygać

- Share

- powinien

- pokazać

- Prosty

- po prostu

- ponieważ

- mądrzejszy

- So

- Tworzenie

- rozwiązanie

- Rozwiązania

- kilka

- Sony

- wyrafinowany

- Nadal

- Strategia

- kolejny

- taki

- cierpienie

- niespodzianka

- Zespoły

- tech

- Techniczny

- że

- Połączenia

- ich

- Im

- sami

- w związku z tym

- Te

- rzecz

- rzeczy

- Przez

- czas

- czasochłonne

- do

- także

- narzędzia

- Top

- Przekształcać

- szczypanie

- Zrozumiały

- nieszczęśliwy

- Aktualizacja

- Nowości

- aktualizowanie

- nadający się do użytku

- posługiwać się

- Użytkownik

- Ve

- Ofiara

- Tom

- brakujący

- Warner

- Droga..

- Co

- czy

- który

- KIM

- będzie

- w

- Praca

- pracujący

- wart

- pisarz

- pisanie

- Źle

- Twój

- zefirnet