Sponset innhold

ChatGPT og lignende verktøy basert på store språkmodeller (LLM) er fantastiske. Men de er ikke allsidige verktøy.

Det er akkurat som å velge andre verktøy for å bygge og skape. Du må velge den rette for jobben. Du ville ikke prøve å stramme en bolt med en hammer eller snu en hamburgerpatte med en visp. Prosessen ville være vanskelig, og resultere i en rotete fiasko.

Språkmodeller som LLM-er utgjør bare en del av det bredere maskinlæringsverktøysettet, som omfatter både generativ AI og prediktiv AI. Å velge riktig type maskinlæringsmodell er avgjørende for å tilpasse seg kravene til oppgaven din.

La oss grave dypere inn i hvorfor LLM-er passer bedre for å hjelpe deg med å utarbeide tekst eller brainstorme gaveideer enn for å takle virksomhetens mest kritiske prediktive modelleringsoppgaver. Det er fortsatt en viktig rolle for de "tradisjonelle" maskinlæringsmodellene som gikk foran LLM-er og gjentatte ganger har bevist sin verdi i bedrifter. Vi vil også utforske en banebrytende tilnærming for å bruke disse verktøyene sammen - en spennende utvikling vi i Pecan kaller Prediktiv GenAI.

LLM-er er laget for ord, ikke tall

I maskinlæring brukes forskjellige matematiske metoder for å analysere det som er kjent som "treningsdata" - et første datasett som representerer problemet som en dataanalytiker eller dataforsker håper å løse.

Betydningen av treningsdata kan ikke overvurderes. Den inneholder mønstrene og relasjonene som en maskinlæringsmodell vil "lære" å forutsi utfall når den senere får nye, usynlige data.

Så hva er egentlig en LLM? Store språkmodeller, eller LLM-er, faller inn under paraplyen av maskinlæring. De stammer fra dyp læring, og strukturen deres er spesielt utviklet for naturlig språkbehandling.

Du kan si at de er bygget på et fundament av ord. Målet deres er ganske enkelt å forutsi hvilket ord som blir det neste i en rekke ord. For eksempel bruker iPhones autokorrigeringsfunksjon i iOS 17 nå en LLM for bedre å forutsi hvilket ord du mest sannsynlig har tenkt å skrive neste gang.

Tenk deg nå at du er en maskinlæringsmodell. (Bli med oss, vi vet at det er en strekk.) Du har blitt opplært til å forutsi ord. Du har lest og studert millioner av ord fra en lang rekke kilder om alle slags emner. Dine mentorer (også kjent som utviklere) har hjulpet deg med å lære de beste måtene å forutsi ord og lage ny tekst som passer en brukers forespørsel.

Men her er en vri. En bruker gir deg nå et massivt regneark med kunde- og transaksjonsdata, med millioner av rader med tall, og ber deg forutsi tall relatert til disse eksisterende dataene.

Hvordan tror du spådommene dine vil slå ut? For det første vil du sannsynligvis bli irritert over at denne oppgaven ikke samsvarer med det du har jobbet så hardt for å lære. (Heldigvis, så vidt vi vet, har ikke LLM-er følelser ennå.) Enda viktigere er at du blir bedt om å gjøre en oppgave som ikke samsvarer med det du har lært å gjøre. Og du vil sannsynligvis ikke prestere så bra.

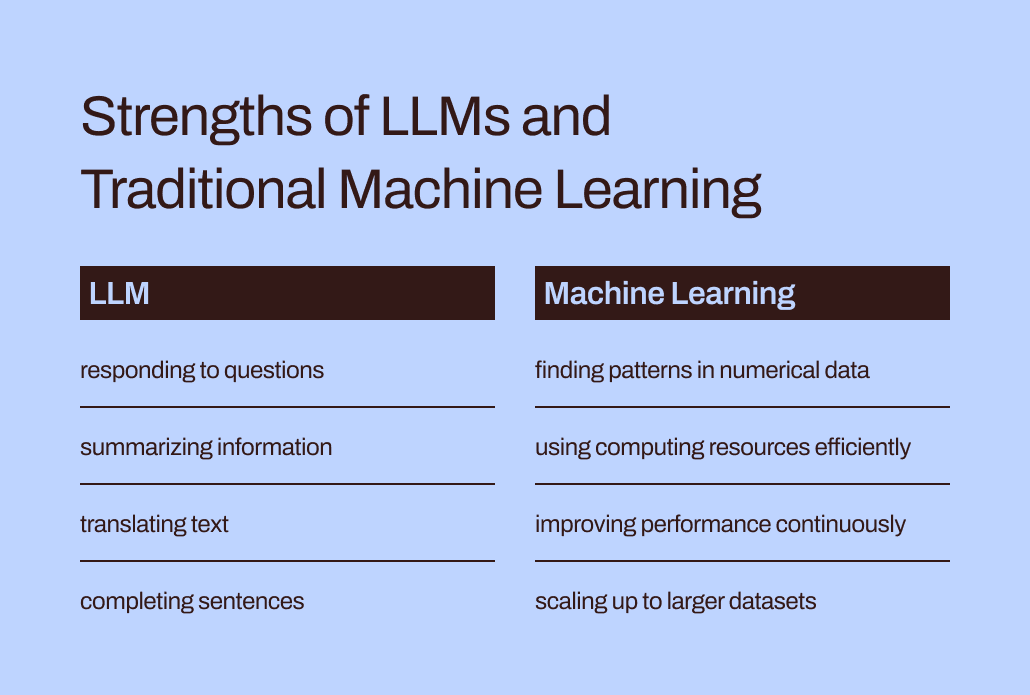

Gapet mellom opplæring og oppgave er med på å forklare hvorfor LLM-er ikke er godt egnet for prediktive oppgaver som involverer numeriske data i tabellform – det primære dataformatet de fleste bedrifter samler inn. I stedet er en maskinlæringsmodell spesielt laget og finjustert for å håndtere denne typen data mer effektiv. Den har bokstavelig talt blitt trent for dette.

LLMs effektivitets- og optimaliseringsutfordringer

I tillegg til å være en bedre match for numeriske data, er tradisjonelle maskinlæringsmetoder langt mer effektive og enklere å optimalisere for bedre ytelse enn LLM-er.

La oss gå tilbake til opplevelsen din av å utgi seg for å være en LLM. Å lese alle disse ordene og studere stilen og rekkefølgen deres høres ut som massevis av arbeid, ikke sant? Det ville kreve mye innsats å internalisere all den informasjonen.

På samme måte kan LLMs komplekse opplæring resultere i modeller med milliarder av parametere. Denne kompleksiteten lar disse modellene forstå og svare på de vanskelige nyansene i menneskelig språk. Imidlertid kommer tung trening med tunge beregningskrav når LLM-er genererer svar. Numerisk orienterte «tradisjonelle» maskinlæringsalgoritmer, som beslutningstrær eller nevrale nettverk, vil sannsynligvis trenge langt færre dataressurser. Og dette er ikke et tilfelle av "større er bedre." Selv om LLM-er kunne håndtere numeriske data, ville denne forskjellen bety at tradisjonelle maskinlæringsmetoder fortsatt ville være raskere, mer effektive, mer miljømessig bærekraftige og mer kostnadseffektive.

I tillegg, har du noen gang spurt ChatGPT hvordan det visste å gi et bestemt svar? Svaret vil sannsynligvis være litt vagt:

Jeg genererer svar basert på en blanding av lisensierte data, data laget av menneskelige trenere og offentlig tilgjengelige data. Opplæringen min involverte også store datasett hentet fra en rekke kilder, inkludert bøker, nettsteder og andre tekster, for å utvikle en bred forståelse av menneskelig språk. Opplæringsprosessen innebærer å kjøre beregninger på tusenvis av GPUer over uker eller måneder, men nøyaktige detaljer og tidsskalaer er proprietære for OpenAI.

Hvor mye av "kunnskapen" som ble reflektert i det svaret kom fra menneskelige trenere kontra offentlige data vs bøker? Selv ChatGPT selv er ikke sikker: "De relative proporsjonene av disse kildene er ukjente, og jeg har ikke detaljert innsyn i hvilke spesifikke dokumenter som var en del av treningssettet mitt."

Det er litt urovekkende å ha ChatGPT til å gi så sikre svar på spørsmålene dine, men ikke være i stand til å spore svarene til spesifikke kilder. LLMs begrensede tolkbarhet og forklarbarhet byr også på utfordringer med å optimalisere dem for spesielle forretningsbehov. Det kan være vanskelig å forstå begrunnelsen bak informasjonen eller spådommene deres. For å komplisere ting ytterligere, sliter visse virksomheter med regulatoriske krav som betyr at de må kunne forklare faktorene som påvirker en modells spådommer. Alt i alt viser disse utfordringene at tradisjonelle maskinlæringsmodeller - generelt mer tolkbare og forklarbare - sannsynligvis er bedre egnet for forretningsbruk.

Det rette stedet for LLM-er i bedrifters prediktive verktøysett

Så, bør vi bare overlate LLM-er til deres ordrelaterte oppgaver og glemme dem for prediktive brukstilfeller? Det kan nå virke som om de tross alt ikke kan hjelpe med å forutsi kundeavgang eller kundelevetidsverdi.

Her er tingen: Selv om vi sier «tradisjonelle maskinlæringsmodeller» får disse teknikkene til å høres allment forstått og enkle å bruke, vet vi fra vår erfaring hos Pecan at bedrifter fortsatt i stor grad sliter med å ta i bruk selv disse mer kjente formene for AI.

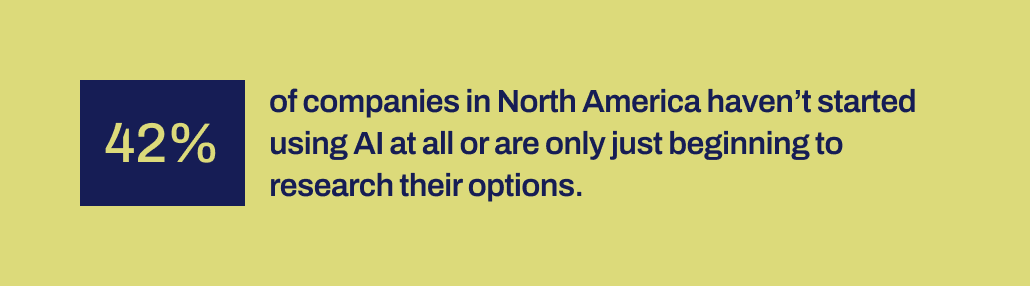

Nyere forskning fra Workday avslører at 42 % av selskapene i Nord-Amerika enten ikke har tatt i bruk AI eller bare er i de tidlige stadiene av å utforske alternativene sine. Og det er over et tiår siden maskinlæringsverktøy ble mer tilgjengelige for bedrifter. De har hatt tid, og ulike verktøy er tilgjengelige.

Av en eller annen grunn har vellykkede AI-implementeringer vært overraskende sjeldne til tross for den massive buzz rundt datavitenskap og AI – og deres erkjente potensial for betydelig forretningseffekt. En viktig mekanisme mangler for å bygge bro mellom løftene fra AI og evnen til å implementere det produktivt.

Og det er nettopp der vi tror at LLM-er nå kan spille en viktig brofunksjon. LLM-er kan hjelpe bedriftsbrukere å krysse avgrunnen mellom å identifisere et forretningsproblem å løse og utvikle en prediktiv modell.

Med LLM-er nå i bildet, kan forretnings- og datateam som ikke har evnen eller kapasiteten til å håndkode maskinlæringsmodeller nå bedre oversette behovene sine til modeller. De kan "bruke ordene sine", som foreldre liker å si, for å kickstarte modelleringsprosessen.

Kombinere LLM med maskinlæringsteknikker bygget for å utmerke seg på forretningsdata

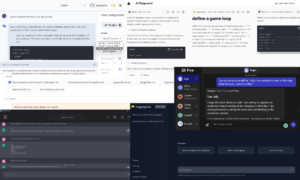

Den muligheten har nå kommet i Pecans Predictive GenAI, som kombinerer styrken til LLM med vår allerede svært raffinerte og automatiserte maskinlæringsplattform. Vår LLM-drevne Predictive Chat samler inn innspill fra en bedriftsbruker for å veilede definisjonen og utviklingen av et prediktivt spørsmål – det spesifikke problemet brukeren ønsker å løse med en modell.

Deretter, ved å bruke GenAI, genererer plattformen vår en Predictive Notebook for å gjøre neste steg mot modellering enda enklere. Igjen, ved å trekke på LLM-funksjoner, inneholder den bærbare datamaskinen forhåndsutfylte SQL-spørringer for å velge treningsdata for den prediktive modellen. Pecans automatiserte dataforberedelse, funksjonsutvikling, modellbygging og distribusjon kan utføre resten av prosessen på rekordtid, raskere enn noen annen prediktiv modelleringsløsning.

Kort sagt, Pecans Predictive GenAI bruker de enestående språkkunnskapene til LLM-er for å gjøre vår klassens beste prediktive modelleringsplattform langt mer tilgjengelig og vennlig for forretningsbrukere. Vi er spente på å se hvordan denne tilnærmingen vil hjelpe mange flere selskaper til å lykkes med AI.

Så mens LLMs alene ikke er godt egnet til å håndtere alle dine prediktive behov, kan de spille en kraftig rolle i å flytte AI-prosjektene dine fremover. Ved å tolke brukssaken din og gi deg et forsprang med automatisk generert SQL-kode, leder Pecans Predictive GenAI an når det gjelder å forene disse teknologiene. Du kan sjekk det ut nå med en gratis prøveversjon.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- : har

- :er

- :ikke

- :hvor

- 15%

- 17

- a

- evne

- I stand

- Om oss

- tilgjengelig

- erkjente

- tillegg

- adresse

- adoptere

- Etter

- en gang til

- AI

- aka

- algoritmer

- justere

- Alle

- tillater

- alene

- allerede

- også

- utrolig

- america

- an

- analytiker

- analysere

- og

- besvare

- svar

- noen

- tilnærming

- ER

- rundt

- kom frem

- AS

- bistå

- At

- Automatisert

- automatisert maskinlæring

- automatisk

- tilgjengelig

- tilbake

- basert

- BE

- Bær

- ble

- vært

- Begynnelsen

- bak

- være

- tro

- BEST

- Bedre

- mellom

- milliarder

- Bit

- Bolt

- bøker

- både

- brainstorm

- BRO

- bridging

- bredere

- Bygning

- bygget

- virksomhet

- Forretningsmessig påvirkning

- bedrifter

- men

- by

- ring

- kom

- CAN

- evner

- evne

- Kapasitet

- bære

- saken

- saker

- viss

- utfordringer

- kløft

- chatte

- ChatGPT

- velge

- kode

- samle

- kommer

- Selskaper

- Selskapets

- komplekse

- kompleksitet

- beregnings

- beregninger

- databehandling

- trygg

- utgjør

- inneholder

- korrigere

- kostnadseffektiv

- kunne

- utformet

- skape

- opprettet

- Opprette

- kritisk

- Kryss

- avgjørende

- kunde

- dato

- data analytiker

- Dataklargjøring

- datavitenskap

- dataforsker

- datasett

- tiår

- avgjørelse

- dyp

- dyp læring

- dypere

- definisjon

- krav

- distribusjon

- designet

- Til tross for

- detaljert

- detaljer

- utvikle

- utviklet

- utviklere

- utvikle

- Utvikling

- forskjell

- forskjellig

- DIG

- do

- dokumenter

- ikke

- Don

- ikke

- Utkast

- tegning

- Tidlig

- enklere

- lett

- Effektiv

- effektivitet

- effektiv

- innsats

- enten

- altomfattende

- Ingeniørarbeid

- miljø

- Eter (ETH)

- Selv

- NOEN GANG

- eksempel

- Excel

- opphisset

- spennende

- eksisterende

- erfaring

- Forklar

- Forklarbarhet

- utforske

- Utforske

- faktorer

- Failure

- Fall

- kjent

- langt

- raskere

- Trekk

- følelser

- færre

- Først

- passer

- passer inn

- Flip

- Til

- format

- skjemaer

- Heldigvis

- Forward

- Fundament

- Gratis

- vennlig

- fra

- videre

- smelting

- mellomrom

- genai

- generelt

- generere

- generert

- genererer

- generative

- Generativ AI

- gave

- gitt

- gir

- Giving

- Go

- mål

- GPU

- veilede

- HAD

- hammer

- håndtere

- Håndtering

- Hard

- Ha

- haven

- hode

- Tungt arbeid

- hjelpe

- hjulpet

- hjelpe

- hjelper

- svært

- holder

- håper

- Hvordan

- Men

- HTTPS

- menneskelig

- i

- Ideer

- identifisering

- if

- forestille

- Påvirkning

- iverksette

- implementeringer

- viktig

- viktigere

- in

- Inkludert

- å påvirke

- informasjon

- innledende

- initiert

- inngang

- i stedet

- hensikt

- inn

- involvert

- innebærer

- involverer

- iOS

- IT

- DET ER

- selv

- Jobb

- bare

- KDnuggets

- Vet

- kjent

- Språk

- stor

- storskala

- i stor grad

- seinere

- ledende

- LÆRE

- lært

- læring

- Permisjon

- Licensed

- livstid

- i likhet med

- Sannsynlig

- Begrenset

- Lot

- maskin

- maskinlæring

- Maskinlæringsteknikker

- laget

- gjøre

- GJØR AT

- mange

- massive

- Match

- matematiske

- bety

- mekanisme

- mentorer

- metoder

- kunne

- millioner

- mangler

- blanding

- modell

- modellering

- modeller

- måneder

- mer

- mer effektivt

- mest

- flytting

- mye

- må

- my

- Naturlig

- Naturlig språk

- Natural Language Processing

- Trenger

- behov

- nettverk

- neural

- nevrale nettverk

- Ny

- neste

- nord

- nord amerika

- bærbare

- nå

- skyggelegging

- tall

- innhentet

- of

- on

- ONE

- bare

- OpenAI

- optimalisering

- Optimalisere

- optimalisere

- alternativer

- or

- Annen

- vår

- ut

- utfall

- enn

- tydelig

- parametere

- foreldre

- del

- Spesielt

- mønstre

- utføre

- ytelse

- plukke

- bilde

- Banebryt

- Sted

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- Spille

- potensiell

- kraftig

- nettopp

- forutsi

- forutsi

- Spådommer

- prediktiv

- forberedelse

- primære

- sannsynligvis

- Problem

- prosess

- prosessering

- prosjekter

- lover

- proprietær

- utprøvd

- gi

- offentlig

- offentlig

- spørsmål

- spørsmål

- spørsmål

- område

- SJELDEN

- begrunnelsen

- Lese

- Lesning

- grunnen til

- rekord

- raffinert

- reflektert

- regulatorer

- i slekt

- Relasjoner

- slektning

- GJENTATTE GANGER

- representerer

- anmode

- Krav

- forskning

- Ressurser

- Svare

- svar

- svar

- REST

- resultere

- resulterende

- avslører

- ikke sant

- Rolle

- rennende

- s

- sier

- sier

- Vitenskap

- Forsker

- se

- synes

- velg

- velge

- Sequence

- sett

- Kort

- bør

- Vis

- betydning

- signifikant

- lignende

- ganske enkelt

- siden

- ferdigheter

- So

- løsning

- LØSE

- noen

- Lyd

- lyder

- Kilder

- spesifikk

- spesielt

- regneark

- SQL

- stadier

- Begynn

- startet

- Trinn

- Still

- styrker

- struktur

- Sliter

- studert

- Studerer

- stil

- lykkes

- vellykket

- slik

- sikker

- bærekraftig

- T

- takling

- Ta

- Oppgave

- oppgaver

- lag

- teknikker

- Technologies

- tekst

- enn

- Det

- De

- deres

- Dem

- Disse

- de

- ting

- ting

- tror

- denne

- De

- tusener

- stramme

- tid

- til

- sammen

- ton

- verktøykasse

- verktøy

- temaer

- mot

- spore

- tradisjonelle

- trent

- Kurs

- Transaksjonen

- oversette

- Trær

- prøve

- SVING

- vri

- typen

- paraply

- etter

- forstå

- forståelse

- forstås

- forenende

- ukjent

- enestående

- us

- bruke

- bruk sak

- brukt

- Bruker

- Brukere

- bruker

- ved hjelp av

- verdi

- variasjon

- ulike

- enorme

- synlighet

- vital

- vs

- ønsker

- Vei..

- måter

- we

- nettsteder

- uker

- VI VIL

- var

- Hva

- Hva er

- når

- hvilken

- mens

- hvorfor

- allment

- vil

- med

- innenfor

- ord

- ord

- Arbeid

- arbeidet

- verdt

- ville

- ennå

- du

- Din

- zephyrnet