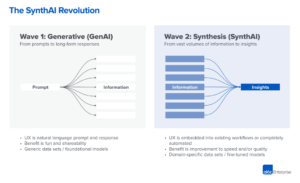

Vi begynner å se de veldig tidlige stadiene av en teknologistabel dukke opp i generativ kunstig intelligens (AI). Hundrevis av nye startups skynder seg inn i markedet for å utvikle grunnmodeller, bygge AI-native apper og stand up-infrastruktur/verktøy.

Mange hete teknologitrender blir overhypet langt før markedet tar igjen. Men den generative AI-boomen har blitt ledsaget av reelle gevinster i virkelige markeder, og reell trekkraft fra ekte selskaper. Modeller som Stable Diffusion og ChatGPT setter historiske rekorder for brukervekst, og flere applikasjoner har nådd 100 millioner dollar i årlig inntekt mindre enn ett år etter lansering. Side-ved-side sammenligninger viser AI-modeller utkonkurrerende mennesker i noen oppgaver i flere størrelsesordener.

Så det er nok tidlige data til å antyde at massiv transformasjon finner sted. Det vi ikke vet, og det som nå har blitt det kritiske spørsmålet, er: Hvor i dette markedet vil verdi påløpe?

I løpet av det siste året har vi møtt dusinvis av startup-gründere og operatører i store selskaper som driver direkte med generativ AI. Det har vi observert leverandører av infrastruktur er sannsynligvis de største vinnerne i dette markedet så langt, og fanger de fleste dollar som strømmer gjennom stabelen. Applikasjonsselskaper øker topplinjeinntektene veldig raskt, men sliter ofte med oppbevaring, produktdifferensiering og bruttomarginer. Og de fleste modellleverandører, selv om de er ansvarlige for selve eksistensen av dette markedet, har de ennå ikke oppnådd stor kommersiell skala.

Med andre ord, selskapene som skaper mest verdi – dvs. å trene generative AI-modeller og bruke dem i nye apper – har ikke fanget opp det meste. Det er mye vanskeligere å forutsi hva som vil skje videre. Men vi tror det viktigste å forstå er hvilke deler av stabelen som virkelig er differensiert og forsvarlig. Dette vil ha stor innvirkning på markedsstrukturen (dvs. horisontal kontra vertikal selskapsutvikling) og driverne for langsiktig verdi (f.eks. marginer og oppbevaring). Så langt har vi hatt vanskelig for å finne strukturell forsvarlighet hvor som helst i stabelen, utenfor tradisjonelle vollgraver for sittende.

Vi er utrolig positive på generativ AI og tror det vil ha en massiv innvirkning i programvareindustrien og utover. Målet med dette innlegget er å kartlegge dynamikken i markedet og begynne å svare på de bredere spørsmålene om generative AI-forretningsmodeller.

Teknologistabel på høyt nivå: Infrastruktur, modeller og apper

For å forstå hvordan det generative AI-markedet tar form, må vi først definere hvordan stabelen ser ut i dag. Her er vårt foreløpige syn.

Stabelen kan deles inn i tre lag:

- applikasjoner som integrerer generative AI-modeller i et brukervendt produkt, enten kjører sine egne modellpipelines ("ende-til-ende-apper") eller stoler på en tredjeparts API

- Modeller som driver AI-produkter, gjort tilgjengelig enten som proprietære APIer eller som åpen kildekode-sjekkpunkter (som igjen krever en vertsløsning)

- Infrastruktur leverandører (dvs. skyplattformer og maskinvareprodusenter) som kjører opplærings- og slutningsarbeidsbelastninger for generative AI-modeller

Det er viktig å merke seg: Dette er ikke et markedskart, men et rammeverk for å analysere markedet. I hver kategori har vi listet opp noen få eksempler på kjente leverandører. Vi har ikke gjort noe forsøk på å være omfattende eller liste opp alle de fantastiske generative AI-applikasjonene som har blitt utgitt. Vi går heller ikke dypt inn her på MLops eller LLMops-verktøy, som ennå ikke er høyt standardisert og vil bli behandlet i et fremtidig innlegg.

Den første bølgen av generative AI-apper begynner å nå skala, men sliter med oppbevaring og differensiering

I tidligere teknologisykluser var den konvensjonelle visdommen at for å bygge et stort, uavhengig selskap, må du eie sluttkunden – enten det betydde individuelle forbrukere eller B2B-kjøpere. Det er fristende å tro at de største selskapene innen generativ AI også vil være sluttbrukerapplikasjoner. Så langt er det ikke klart at det er tilfelle.

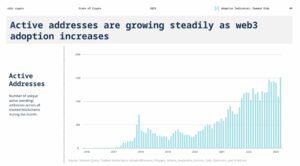

For å være sikker, har veksten av generative AI-applikasjoner vært svimlende, drevet av ren nyhet og en mengde brukssaker. Faktisk er vi klar over minst tre produktkategorier som allerede har overskredet $100 millioner i årlig inntekt: bildegenerering, tekstforfatting og kodeskriving.

Vekst alene er imidlertid ikke nok til å bygge holdbare programvareselskaper. Kritisk sett må vekst være lønnsom – i den forstand at brukere og kunder, når de har registrert seg, genererer fortjeneste (høy bruttomarginer) og holder seg lenge (høy oppbevaring). I fravær av sterk teknisk differensiering, driver B2B- og B2C-apper langsiktig kundeverdi gjennom nettverkseffekter, å holde på data eller bygge stadig mer komplekse arbeidsflyter.

I generativ AI stemmer ikke disse antakelsene nødvendigvis. På tvers av appselskaper vi har snakket med, er det et bredt spekter av bruttomarginer – så høye som 90 % i noen få tilfeller, men oftere så lave som 50–60 %, hovedsakelig drevet av kostnadene ved modellslutning. Veksten på toppen av trakten har vært fantastisk, men det er uklart om nåværende strategier for kundeanskaffelse vil være skalerbare – vi ser allerede at betalt oppkjøpseffektivitet og oppbevaring begynner å avta. Mange apper er også relativt udifferensierte, siden de er avhengige av lignende underliggende AI-modeller og ikke har oppdaget åpenbare nettverkseffekter, eller data/arbeidsflyter, som er vanskelige for konkurrenter å duplisere.

Så det er ennå ikke åpenbart at salg av sluttbrukerapper er den eneste, eller til og med den beste, veien til å bygge en bærekraftig generativ AI-virksomhet. Marginene bør forbedres etter hvert som konkurransen og effektiviteten i språkmodeller øker (mer om dette nedenfor). Bevaring bør øke etter hvert som AI-turister forlater markedet. Og det er et sterkt argument for at vertikalt integrerte apper har en fordel i å drive differensiering. Men det er fortsatt mye å bevise.

Når vi ser fremover, inkluderer noen av de store spørsmålene generative AI-appselskaper står overfor:

- Vertikal integrasjon ("modell + app"). Å konsumere AI-modeller som en tjeneste gjør at apputviklere kan iterere raskt med et lite team og bytte modellleverandører etter hvert som teknologien skrider frem. På baksiden hevder noen utviklere at produktet is modellen, og at trening fra bunnen av er den eneste måten å skape forsvarlighet på – dvs. ved å kontinuerlig omskolere på proprietære produktdata. Men det kommer på bekostning av mye høyere kapitalkrav og et mindre smidig produktteam.

- Byggefunksjoner kontra apper. Generative AI-produkter har en rekke forskjellige former: skrivebordsapper, mobilapper, Figma/Photoshop-plugins, Chrome-utvidelser, til og med Discord-roboter. Det er enkelt å integrere AI-produkter der brukere allerede jobber, siden brukergrensesnittet vanligvis bare er en tekstboks. Hvilke av disse vil bli frittstående selskaper - og hvilke vil bli absorbert av etablerte selskaper, som Microsoft eller Google, som allerede inkorporerer AI i produktlinjene sine?

- Klarer seg gjennom hype-syklusen. Det er ennå ikke klart om churn er iboende i den nåværende gruppen av generative AI-produkter, eller om det er en artefakt av et tidlig marked. Eller hvis bølgen av interesse for generativ AI vil falle av når hypen avtar. Disse spørsmålene har viktige implikasjoner for app-selskaper, inkludert når man skal trykke gasspedalen på pengeinnsamling; hvor aggressivt å investere i kundeanskaffelse; hvilke brukersegmenter som skal prioriteres; og når du skal erklære at produktet passer til markedet.

Modellleverandører oppfant generativ AI, men har ikke nådd stor kommersiell skala

Det vi nå kaller generativ AI ville ikke eksistert uten den strålende forskningen og ingeniørarbeidet som er gjort på steder som Google, OpenAI og Stability. Gjennom nye modellarkitekturer og heroiske anstrengelser for å skalere treningspipelines, drar vi alle nytte av de overveldende egenskapene til nåværende store språkmodeller (LLM) og bildegenereringsmodeller.

Likevel er inntektene knyttet til disse selskapene fortsatt relativt små sammenlignet med bruken og buzz. I bildegenerering har Stable Diffusion sett en eksplosiv fellesskapsvekst, støttet av et økosystem av brukergrensesnitt, vertsbaserte tilbud og finjusteringsmetoder. Men Stabilitet gir de viktigste sjekkpunktene deres bort gratis som en kjernen i virksomheten deres. I naturlige språkmodeller dominerer OpenAI med GPT-3/3.5 og ChatGPT. Men relativt få killer-apper bygget på OpenAI eksisterer så langt, og prisene har allerede falt en gang.

Dette kan bare være et midlertidig fenomen. Stabilitet er et nytt selskap som ennå ikke har fokusert på inntektsgenerering. OpenAI har potensialet til å bli en massiv virksomhet, og tjene en betydelig del av alle NLP-kategoriinntekter etter hvert som flere killer-apper bygges – spesielt hvis deres integrering i Microsofts produktportefølje går greit. Gitt den enorme bruken av disse modellene, kan det hende at store inntekter ikke er langt bak.

Men det finnes også motkrefter. Modeller utgitt som åpen kildekode kan være vert for alle, inkludert eksterne selskaper som ikke bærer kostnadene forbundet med modellopplæring i stor skala (opptil titalls eller hundrevis av millioner dollar). Og det er ikke klart om noen lukkede kildemodeller kan opprettholde fordelen på ubestemt tid. For eksempel begynner vi å se LLM-er bygget av selskaper som Anthropic, Cohere og Character.ai komme nærmere OpenAI ytelsesnivåer, trent på lignende datasett (dvs. internett) og med lignende modellarkitekturer. Eksemplet med stabil diffusjon antyder det if åpen kildekode-modeller når et tilstrekkelig nivå av ytelse og fellesskapsstøtte, da kan proprietære alternativer finne det vanskelig å konkurrere.

Den kanskje klareste løsningen for modellleverandører så langt er at kommersialisering sannsynligvis er knyttet til hosting. Etterspørselen etter proprietære APIer (f.eks. fra OpenAI) vokser raskt. Vertstjenester for åpen kildekode-modeller (f.eks. Hugging Face og Replicate) dukker opp som nyttige knutepunkter for enkelt å dele og integrere modeller – og til og med ha noen indirekte nettverkseffekter mellom modellprodusenter og forbrukere. Det er også en sterk hypotese om at det er mulig å tjene penger gjennom finjustering og vertsavtaler med bedriftskunder.

Utover det er det imidlertid en rekke store spørsmål som modellleverandører står overfor:

- Commoditization. Det er en vanlig oppfatning at AI-modeller vil konvergere i ytelse over tid. Når man snakker med apputviklere, er det tydelig at det ikke har skjedd ennå, med sterke ledere innen både tekst- og bildemodeller. Fordelene deres er ikke basert på unike modellarkitekturer, men på høye kapitalkrav, proprietære produktinteraksjonsdata og knappe AI-talent. Vil dette tjene som en varig fordel?

- Eksamensrisiko. Å stole på modellleverandører er en fin måte for appselskaper å komme i gang, og til og med å utvide virksomhetene sine. Men det er insentiv for dem til å bygge og/eller være vert for sine egne modeller når de når skala. Og mange modellleverandører har svært skjeve kundedistribusjoner, med noen få apper som representerer størstedelen av inntektene. Hva skjer hvis/når disse kundene bytter til egen AI-utvikling?

- Er penger viktig? Løftet om generativ AI er så stort – og også potensielt så skadelig – at mange modellleverandører har organisert seg som allmennyttige selskaper (B-korps), utstedt overskuddsandeler eller på annen måte inkorporert allmennheten eksplisitt i sitt oppdrag. Dette har overhodet ikke hindret deres innsamlingsarbeid. Men det er en rimelig diskusjon å ha rundt om de fleste modellleverandører faktisk ønsker for å fange verdi, og om de burde.

Infrastrukturleverandører berører alt, og høster fruktene

Nesten alt i generativ AI går gjennom en skybasert GPU (eller TPU) på et tidspunkt. Enten for modellleverandører / forskningslaboratorier som kjører treningsarbeidsmengder, vertsselskaper som kjører slutninger/finjustering, eller applikasjonsselskaper som gjør en kombinasjon av begge deler - FLOPER er livsnerven til generativ AI. For første gang på veldig lenge er fremskritt innen den mest forstyrrende datateknologien massivt databundet.

Som et resultat flyter mye av pengene i det generative AI-markedet til slutt til infrastrukturselskaper. For å sette noen veldig grove tall rundt det: Vi anslår at appselskaper i gjennomsnitt bruker rundt 20-40 % av inntektene på slutninger og finjustering per kunde. Dette betales vanligvis enten direkte til skyleverandører for dataforekomster eller til tredjepartsmodellleverandører – som igjen bruker omtrent halvparten av inntektene sine på skyinfrastruktur. Så det er rimelig å gjette at 10-20 % av totale inntekter i generativ AI går i dag til skyleverandører.

På toppen av dette har startups som trener sine egne modeller samlet inn milliarder av dollar i risikokapital – de fleste (opptil 80-90 % i tidlige runder) brukes vanligvis også hos skyleverandørene. Mange offentlige teknologiselskaper bruker hundrevis av millioner per år på modellopplæring, enten med eksterne skyleverandører eller direkte med maskinvareprodusenter.

Dette er hva vi vil kalle, i tekniske termer, "mye penger" - spesielt for et begynnende marked. Det meste av det brukes på Big 3 skyer: Amazon Web Services (AWS), Google Cloud Platform (GCP) og Microsoft Azure. Disse skyleverandørene samlet bruke mer enn $ 100 milliarder per år i capex for å sikre at de har de mest omfattende, pålitelige og kostnadskonkurransedyktige plattformene. Spesielt i generativ AI drar de også fordel av forsyningsbegrensninger fordi de har fortrinnsrett tilgang til knapp maskinvare (f.eks. Nvidia A100 og H100 GPUer).

Interessant nok begynner vi imidlertid å se troverdig konkurranse dukke opp. Utfordrere som Oracle har gjort inntog med store investeringsutgifter og salgsinsentiver. Og noen få startups, som Coreweave og Lambda Labs, har vokst raskt med løsninger rettet spesielt mot store modellutviklere. De konkurrerer på kostnader, tilgjengelighet og personlig støtte. De avslører også mer granulære ressursabstraksjoner (dvs. containere), mens de store skyene tilbyr kun VM-forekomster på grunn av GPU-virtualiseringsgrenser.

Bak kulissene, kjører det store flertallet av AI-arbeidsmengdene, er kanskje den største vinneren innen generativ AI så langt: Nvidia. Firmaet rapporterte 3.8 XNUMX dollar milliarder av datasenterets GPU-inntekter i tredje kvartal av regnskapsåret 2023, inkludert en meningsfull del for generative AI-brukstilfeller. Og de har bygget sterke vollgraver rundt denne virksomheten gjennom tiår med investeringer i GPU-arkitekturen, et robust programvareøkosystem og dyp bruk i det akademiske samfunnet. En fersk analyse fant at Nvidia GPU-er er sitert i forskningsartikler 90 ganger mer enn de beste AI-brikkene til sammen.

Andre maskinvarealternativer finnes, inkludert Google Tensor Processing Units (TPUer); AMD Instinct GPUer; AWS Inferentia og Trainium chips; og AI-akseleratorer fra startups som Cerebras, Sambanova og Graphcore. Intel, sent til spillet, kommer også inn på markedet med sine high-end Habana-brikker og Ponte Vecchio GPU-er. Men så langt har få av disse nye sjetongene tatt betydelige markedsandeler. De to unntakene å se på er Google, hvis TPU-er har fått gjennomslag i Stable Diffusion-fellesskapet og i noen store GCP-avtaler, og TSMC, som antas å produsere alle av brikkene som er oppført her, inkludert Nvidia GPUer (Intel bruker en blanding av sine egne fabrikker og TSMC for å lage sine brikker).

Infrastruktur er med andre ord et lukrativt, holdbart og tilsynelatende forsvarlig lag i stabelen. De store spørsmålene å svare på for infra-selskaper inkluderer:

- Holder på statsløse arbeidsmengder. Nvidia GPUer er de samme uansett hvor du leier dem. De fleste AI-arbeidsbelastninger er statsløse, i den forstand at modellslutninger ikke krever tilknyttede databaser eller lagring (annet enn for modellvektene selv). Dette betyr at AI-arbeidsbelastninger kan være mer bærbare på tvers av skyer enn tradisjonelle applikasjonsarbeidsbelastninger. Hvordan kan skyleverandører i denne sammenheng skape klissete og hindre kunder i å hoppe til det billigste alternativet?

- Overlever slutten på brikkemangel. Prissetting for skyleverandører, og for Nvidia selv, har blitt støttet av knappe forsyninger av de mest ettertraktede GPUene. En leverandør fortalte oss at listeprisen for A100s faktisk har økt siden lanseringen, noe som er svært uvanlig for datamaskinvare. Når denne forsyningsbegrensningen til slutt fjernes, gjennom økt produksjon og/eller bruk av nye maskinvareplattformer, hvordan vil dette påvirke skyleverandører?

- Kan en utfordrersky bryte gjennom? Det tror vi sterkt på vertikale skyer vil ta markedsandeler fra Big 3 med mer spesialiserte tilbud. I AI så langt har utfordrere skaffet seg meningsfull trekkraft gjennom moderat teknisk differensiering og støtte fra Nvidia – for hvem de etablerte skyleverandørene er både de største kundene og nye konkurrenter. Det langsiktige spørsmålet er, vil dette være nok til å overvinne skalafordelene til Big 3?

Så ... hvor vil verdien oppstå?

Vi vet selvfølgelig ikke ennå. Men basert på de tidlige dataene vi har for generativ AI, kombinert med vår erfaring med tidligere AI/ML-selskaper, vår intuisjon er følgende.

Det ser ikke ut til å være noen systemiske vollgraver i generativ AI i dag. Som en første-ordens tilnærming mangler applikasjoner sterk produktdifferensiering fordi de bruker lignende modeller; modeller står overfor uklar langsiktig differensiering fordi de er trent på lignende datasett med lignende arkitekturer; skyleverandører mangler dyp teknisk differensiering fordi de kjører de samme GPUene; og til og med maskinvareselskapene produserer brikkene sine på de samme fabrikkene.

Det er selvfølgelig standard vollgraver: skalagraver («Jeg har eller kan skaffe mer penger enn deg!»), forsyningskjedegraver («Jeg har GPUene, du har ikke!»), økosystemgraver (« Alle bruker programvaren min allerede!»), algoritmiske vollgraver («Vi er flinkere enn deg!»), distribusjonsgraver («Jeg har allerede et salgsteam og flere kunder enn deg!») og datarørledningsgraver («Jeg» har gjennomsøkt mer av internett enn deg!"). Men ingen av disse vollgravene har en tendens til å være holdbare på lang sikt. Og det er for tidlig å si om sterke, direkte nettverkseffekter tar tak i ethvert lag av stabelen.

Basert på tilgjengelige data, er det bare ikke klart om det vil være en langsiktig, vinner-ta-alt-dynamikk i generativ AI.

Dette er rart. Men for oss er det gode nyheter. Den potensielle størrelsen på dette markedet er vanskelig å forstå - et sted mellom all programvare og alle menneskelige bestrebelser — så vi forventer mange, mange spillere og sunn konkurranse på alle nivåer av stabelen. Vi forventer også at både horisontale og vertikale selskaper skal lykkes, med den beste tilnærmingen diktert av sluttmarkeder og sluttbrukere. For eksempel, hvis den primære differensieringen i sluttproduktet er AI selv, er det sannsynlig at vertikalisering (dvs. tett kobling av den brukervendte appen til den hjemmedyrkede modellen) vil vinne frem. Mens hvis AI er en del av et større funksjonssett med lang hale, er det mer sannsynlig at horisontalisering vil skje. Selvfølgelig bør vi også se byggingen av mer tradisjonelle vollgraver over tid - og vi kan til og med se nye typer vollgraver ta tak.

Uansett er en ting vi er sikre på at generativ AI endrer spillet. Vi lærer alle reglene i sanntid, det er en enorm mengde verdi som vil bli låst opp, og det teknologiske landskapet kommer til å se mye, mye annerledes ut som et resultat. Og vi er her for det!

Alle bildene i dette innlegget ble laget med Midjourney.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://a16z.com/2023/01/19/who-owns-the-generative-ai-platform/

- $ 100 millioner

- $3

- 1

- a

- A100

- Om oss

- akademisk

- akseleratorer

- adgang

- oppnådd

- oppkjøp

- tvers

- faktisk

- Adopsjon

- fremskritt

- Fordel

- fordeler

- Etter

- avtaler

- fremover

- AI

- AI-plattform

- ai brukstilfeller

- AI / ML

- algoritmisk

- Alle

- tillater

- alene

- allerede

- alternativer

- utrolig

- Amazon

- Amazon Web Services

- Amazon Web Services (AWS)

- AMD

- beløp

- analysere

- og

- annualisert

- besvare

- noen

- APIer

- app

- vises

- Søknad

- søknader

- påføring

- tilnærming

- apps

- arkitektur

- argumentere

- argument

- rundt

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- assosiert

- tilgjengelighet

- tilgjengelig

- gjennomsnittlig

- AWS

- AWS slutning

- Azure

- B2B

- B2C

- basert

- Bær

- fordi

- bli

- før du

- bak

- tro

- tro

- antatt

- troende

- under

- nytte

- BEST

- mellom

- Beyond

- Stor

- Biggest

- Milliarder

- milliarder

- boom

- roboter

- bundet

- Eske

- Break

- brilliant

- bredere

- bygge

- Bygning

- bygget

- Bullish

- virksomhet

- bedrifter

- Strijela

- ring

- evner

- hovedstad

- fangst

- fange

- saken

- saker

- kategorier

- Kategori

- sentrum

- viss

- challenger

- Endringer

- karakter

- ChatGPT

- billigste

- chip

- chips

- Chrome

- sitert

- fjerne

- nærmere

- Cloud

- sky infrastruktur

- Skyplattform

- kode

- samlet sett

- kombinasjon

- kombinert

- Kom

- kommersiell

- kommersialisering

- Felles

- samfunnet

- Selskaper

- Selskapet

- sammenlignet

- konkurrere

- konkurranse

- konkurrenter

- komplekse

- omfattende

- Beregn

- databehandling

- begrensninger

- Forbrukere

- Containere

- kontekst

- kontinuerlig

- konvensjonell

- konvergerer

- copywriting

- Kjerne

- Corporations

- Kostnad

- Kostnader

- kurs

- skape

- opprettet

- Opprette

- troverdig

- kritisk

- Gjeldende

- kunde

- Kunder

- sykluser

- dato

- Datasenter

- databaser

- datasett

- avtale

- Tilbud

- tiår

- dyp

- Etterspørsel

- desktop

- utvikle

- utviklere

- Utvikling

- devs

- forskjellig

- forskjellige former

- differensiert

- kringkasting

- direkte

- direkte

- disharmoni

- oppdaget

- diskusjon

- forstyrrende

- distribusjon

- Distribusjoner

- Divided

- gjør

- dollar

- dominerer

- ikke

- dusinvis

- stasjonen

- drevet

- drivere

- kjøring

- dynamisk

- dynamikk

- hver enkelt

- Tidligere

- Tidlig

- tjene

- lett

- økosystem

- Edge

- effekter

- effektivitet

- innsats

- enten

- Emery

- Ingeniørarbeid

- nok

- sikre

- Enterprise

- bedriftskunder

- spesielt

- anslag

- Selv

- etter hvert

- alt

- eksempel

- eksempler

- forvente

- erfaring

- utvidelser

- utvendig

- Face

- vendt

- Fall

- Trekk

- Egenskaper

- Noen få

- Finn

- finne

- Først

- første gang

- skatt

- passer

- Flip

- Rennende

- Flows

- fokuserte

- etter

- Krefter

- skjemaer

- funnet

- Fundament

- grunnleggere

- Rammeverk

- Gratis

- fra

- Pengeinnsamling

- framtid

- inntjening

- spill

- GAS

- generelt

- generere

- generasjonen

- generative

- Generativ AI

- få

- gitt

- gir

- mål

- Går

- skal

- god

- Google Cloud

- Google Cloud Platform

- GPU

- GPU

- gripe

- flott

- brutto

- Grow

- Økende

- voksen

- Vekst

- Halvparten

- skje

- skjedde

- skjer

- Hard

- maskinvare

- skadelig

- sunt

- her.

- Høy

- høyere

- svært

- historisk

- hit

- hold

- holder

- Horisontal

- vert

- vert

- Hosting

- HOT

- Hvordan

- HTTPS

- stort

- menneskelig

- Hundrevis

- hundrevis av millioner

- Hype

- bilde

- bildegenerering

- bilder

- Påvirkning

- implikasjoner

- viktig

- forbedre

- in

- I andre

- Incentive

- Incentiver

- inkludere

- Inkludert

- Incorporated

- innlemme

- Øke

- økt

- øker

- stadig

- utrolig

- påhviler

- uavhengig

- individuelt

- industri

- Infrastruktur

- iboende

- integrere

- integrert

- integrering

- Intel

- Intelligens

- interaksjon

- interesse

- grensesnitt

- Internet

- intuisjon

- Oppfunnet

- Investere

- investering

- Utstedt

- IT

- selv

- nøkkel

- Vet

- Labs

- maling

- landskap

- Språk

- stor

- storskala

- i stor grad

- større

- Siste

- I fjor

- Late

- lansere

- lag

- lag

- ledere

- læring

- Permisjon

- Nivå

- nivåer

- Sannsynlig

- grenser

- linjer

- Liste

- oppført

- Lang

- lang tid

- langsiktig

- Se

- UTSEENDE

- Lot

- Lav

- lukrative

- laget

- vedlikeholde

- større

- Flertall

- gjøre

- Produsenter

- mange

- kart

- marginer

- marked

- markedskart

- Markedsstruktur

- Markets

- massive

- massivt

- max bredde

- meningsfylt

- midler

- metoder

- Microsoft

- Microsoft Azure

- MidJourney

- millioner

- millioner

- Oppdrag

- MLOps

- Mobil

- mobil-apps

- modell

- modeller

- inntjenings

- tjene penger

- penger

- mer

- mest

- flere

- begynnende

- Naturlig

- Naturlig språk

- nødvendigvis

- Trenger

- nettverk

- Ny

- ny maskinvare

- nyheter

- neste

- kvikk

- nlp

- roman

- nyhet

- Antall

- tall

- Nvidia

- Åpenbare

- tilby

- tilbud

- ONE

- åpen

- åpen kildekode

- OpenAI

- operatører

- Alternativ

- alternativer

- orakel

- ordrer

- Organisert

- Annen

- ellers

- utenfor

- Overcome

- egen

- eier

- betalt

- papirer

- del

- Spesielt

- deler

- passerer

- banen

- ytelse

- kanskje

- Personlig

- fenomen

- rørledning

- Sted

- steder

- plattform

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- spillere

- overflod

- plugins

- Point

- mulig

- Post

- potensiell

- potensielt

- makt

- forutsi

- forebygge

- pris

- Prisene

- primære

- Før

- Prioriter

- prosessering

- Produsentene

- Produkt

- Produksjon

- Produkter

- Profit

- lønnsom

- fortjeneste

- Progress

- løfte

- proprietær

- Bevis

- leverandør

- tilbydere

- offentlig

- sette

- Fjerdedel

- spørsmål

- spørsmål

- raskt

- heve

- hevet

- område

- raskt

- å nå

- nådd

- ekte

- sanntids

- rimelig

- nylig

- poster

- relativt

- utgitt

- pålitelig

- fjernet

- Leie

- representerer

- krever

- Krav

- forskning

- ressurs

- ansvarlig

- resultere

- oppbevaring

- inntekter

- inntekter

- Risiko

- robust

- runder

- regler

- Kjør

- rennende

- salg

- Salgsinsentiver

- samme

- skalerbar

- Skala

- Knappe

- Knapphet

- Scener

- se

- segmenter

- Å Sell

- forstand

- betjene

- tjeneste

- Tjenester

- sett

- innstilling

- flere

- Form

- Del

- Aksjer

- bør

- Vis

- undertegne

- signifikant

- lignende

- siden

- Størrelse

- liten

- problemfritt

- So

- så langt

- Software

- løsning

- Solutions

- noen

- et sted

- kilde

- spesialisert

- spesielt

- bruke

- brukt

- Stabilitet

- stabil

- stable

- stadier

- stå

- stående

- Standard

- Begynn

- startet

- Start

- oppstart

- startups

- Stick

- Still

- lagring

- strategier

- sterk

- strukturell

- struktur

- Struggle

- lykkes

- tilstrekkelig

- foreslår

- levere

- støtte

- Støttes

- bølge

- bærekraftig

- Bytte om

- systemisk

- Ta

- ta

- Talent

- snakker

- målrettet

- oppgaver

- lag

- tech

- tech selskaper

- Teknisk

- Teknologi

- midlertidig

- vilkår

- De

- deres

- seg

- ting

- Tredje

- tredjeparts

- tre

- Gjennom

- Tied

- tett

- tid

- ganger

- til

- i dag

- også

- topp

- berøre

- trekkraft

- tradisjonelle

- trent

- Kurs

- Transformation

- enorm

- Trender

- sant

- tsmc

- SVING

- typer

- typisk

- ui

- Til syvende og sist

- underliggende

- forstå

- unik

- lomper

- uvanlig

- us

- bruk

- bruke

- Bruker

- Brukere

- verdi

- enorme

- leverandører

- venture-

- venture kapital

- av

- Se

- Se

- Wave

- web

- webtjenester

- velkjent

- Hva

- om

- hvilken

- mens

- HVEM

- bred

- Bred rekkevidde

- Wikipedia

- vil

- vinne

- vinnere

- visdom

- uten

- ord

- Arbeid

- arbeidsflyt

- skriving

- år

- zephyrnet