Vi ønsker alle å se våre ideelle menneskelige verdier reflektert i teknologiene våre. Vi forventer at teknologier som kunstig intelligens (AI) ikke lyver for oss, ikke diskriminerer og er trygge for oss og barna våre å bruke. Likevel møter mange AI-skapere for tiden tilbakeslag for skjevhetene, unøyaktighetene og problematiske datapraksisene som blir avslørt i modellene deres. Disse problemene krever mer enn en teknisk, algoritmisk eller AI-basert løsning. I realiteten kreves en helhetlig, sosioteknisk tilnærming.

Matematikken viser en mektig sannhet

Alle prediktive modeller, inkludert AI, er mer nøyaktige når de inkluderer mangfoldig menneskelig intelligens og erfaring. Dette er ikke en mening; den har empirisk gyldighet. Vurder mangfoldsprediksjonsteorem. Enkelt sagt, når mangfoldet i en gruppe er stort, er feilen til mengden liten – noe som støtter begrepet «mengdens visdom». I en innflytelsesrik studie ble det vist at forskjellige grupper av problemløsere med lav evne kan utkonkurrere grupper av problemløsere med høy evne (Hong & Page, 2004).

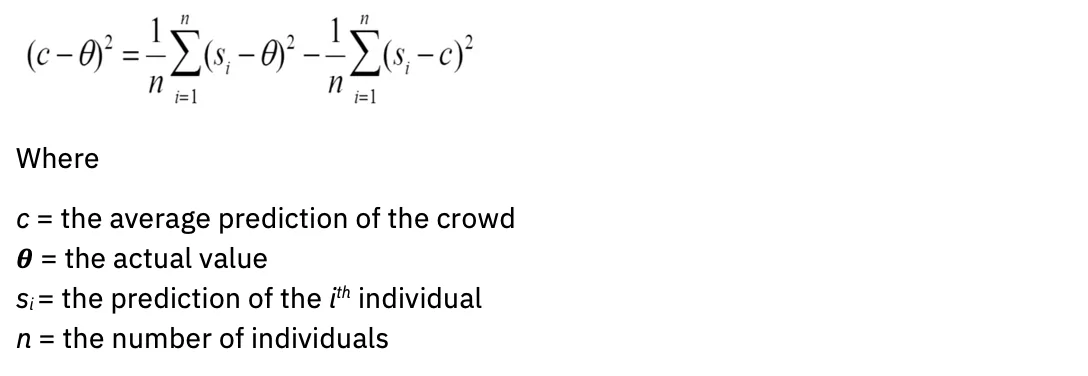

På matematisk språk: jo større variasjon, jo mer standard er gjennomsnittet. Ligningen ser slik ut:

A videre studier ga flere beregninger som avgrenser de statistiske definisjonene av en klok skare, inkludert uvitenhet om andre medlemmers spådommer og inkludering av de med maksimalt annerledes (negativt korrelerte) spådommer eller vurderinger. Så det er ikke bare volum, men mangfold som forbedrer spådommene. Hvordan kan denne innsikten påvirke evalueringen av AI-modeller?

Modell (u)nøyaktighet

For å sitere en vanlig aforisme, er alle modeller feil. Dette gjelder innenfor områdene statistikk, vitenskap og AI. Modeller laget med mangel på domenekompetanse kan føre til feilaktig utganger.

I dag bestemmer en liten homogen gruppe mennesker hvilke data som skal brukes til å trene generative AI-modeller, som er hentet fra kilder som i stor grad overrepresenterer engelsk. "For de fleste av de over 6,000 språkene i verden er ikke de tilgjengelige tekstdataene nok til å trene opp en storskala grunnmodell" (fra "Om mulighetene og risikoene ved grunnmodeller", Bommasani et al., 2022).

I tillegg er selve modellene laget av begrensede arkitekturer: «Nesten alle toppmoderne NLP-modeller er nå tilpasset fra en av noen få grunnmodeller, som BERT, RoBERTa, BART, T5, osv. Mens denne homogeniseringen produserer ekstremt høy innflytelse (enhver forbedring i grunnmodellene kan føre til umiddelbare fordeler på tvers av hele NLP), det er også et ansvar; alle AI-systemer kan arve de samme problematiske skjevhetene til noen få grunnmodeller (Bommasani et al.) "

For at generativ AI bedre skal reflektere de mangfoldige samfunnene den betjener, må et langt bredere utvalg av menneskelige data representeres i modeller.

Evaluering av modellnøyaktighet går hånd i hånd med evaluering av skjevhet. Vi må spørre, hva er intensjonen med modellen og for hvem er den optimalisert? Tenk for eksempel på hvem som drar mest nytte av innholdsanbefalingsalgoritmer og søkemotoralgoritmer. Interessenter kan ha vidt forskjellige interesser og mål. Algoritmer og modeller krever mål eller proxyer for Bayes-feil: minimumsfeilen som en modell må forbedre. Denne fullmektigen er ofte en person, for eksempel en saksekspert med domeneekspertise.

En svært menneskelig utfordring: Vurdere risiko før modellanskaffelse eller utvikling

Nye AI-forskrifter og handlingsplaner understreker i økende grad viktigheten av algoritmiske konsekvensvurderingsskjemaer. Målet med disse skjemaene er å fange opp kritisk informasjon om AI-modeller slik at styringsteam kan vurdere og adressere risikoene deres før de distribueres. Typiske spørsmål inkluderer:

- Hva er modellens bruksområde?

- Hva er risikoen for ulik påvirkning?

- Hvordan vurderer du rettferdighet?

- Hvordan gjør du modellen din forklarbar?

Selv om det er designet med gode intensjoner, er problemet at de fleste eiere av AI-modeller ikke forstår hvordan de skal vurdere risikoen for brukssaken deres. Et vanlig refreng kan være: "Hvordan kan modellen min være urettferdig hvis den ikke samler inn personlig identifiserbar informasjon (PII)?" Følgelig blir skjemaene sjelden utfylt med den omtanke som er nødvendig for at styringssystemer skal kunne flagge risikofaktorer nøyaktig.

Dermed blir løsningens sosiotekniske karakter understreket. En modelleier – en person – kan ikke bare få en liste over avmerkingsbokser for å vurdere om deres brukstilfelle vil forårsake skade. Det som i stedet kreves er at grupper av mennesker med vidt forskjellige livserfaringer kommer sammen i samfunn som tilbyr psykologisk trygghet for å ha vanskelige samtaler om ulik påvirkning.

Tar imot bredere perspektiver for pålitelig AI

IBM® tror på en "klientnull"-tilnærming, og implementerer anbefalingene og systemene den vil lage for sine egne kunder på tvers av konsulent- og produktledede løsninger. Denne tilnærmingen strekker seg til etisk praksis, og det er grunnen til at IBM opprettet et Trustworthy AI Center of Excellence (COE).

Som forklart ovenfor, er mangfold av erfaringer og ferdigheter avgjørende for å kunne evaluere virkningene av AI på riktig måte. Men utsiktene til å delta i et Center of Excellence kan være skremmende i et selskap full av AI-innovatører, eksperter og anerkjente ingeniører, så det er nødvendig å dyrke et fellesskap av psykologisk sikkerhet. IBM kommuniserer dette tydelig ved å si: «Interessert i AI? Interessert i AI-etikk? Du har en plass ved dette bordet.»

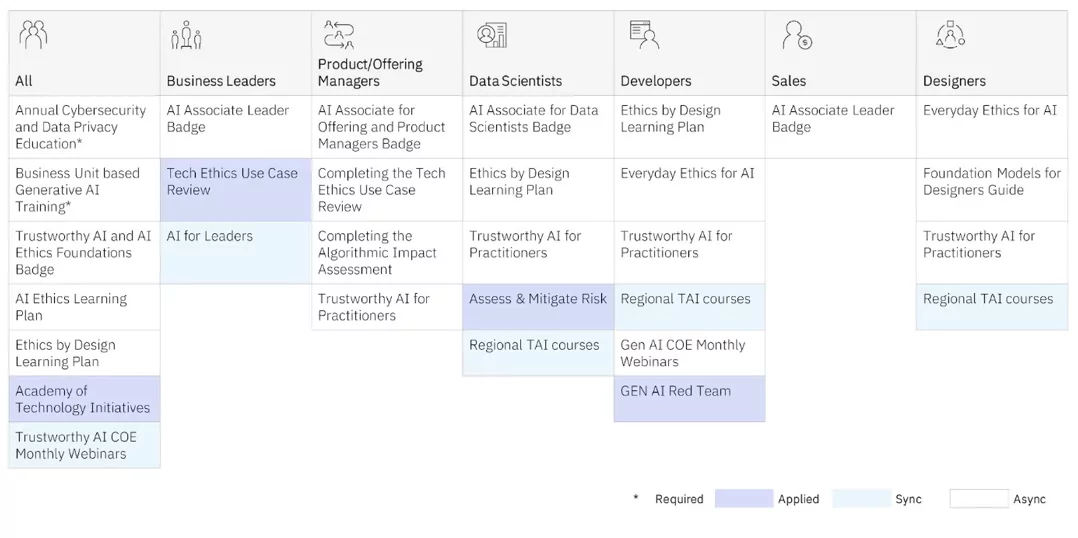

COE tilbyr opplæring i AI-etikk til utøvere på alle nivåer. Både synkron læring (lærer og elever i klassemiljøer) og asynkrone (selvstyrte) programmer tilbys.

Men det er COEs anvendt opplæring som gir våre utøvere den dypeste innsikten, ettersom de jobber med globale, mangfoldige, tverrfaglige team på virkelige prosjekter for å bedre forstå ulike effekter. De utnytter også rammeverk for designtenkning som IBMs Design for AI group bruker internt og med klienter for å vurdere de utilsiktede effektene av AI-modeller, og holde de som ofte er marginaliserte øverst i tankene. (Se Sylvia Duckworths Wheel of Power and Privilege for eksempler på hvordan personlige egenskaper krysser hverandre for å privilegere eller marginalisere mennesker.) IBM donerte også mange av rammene til åpen kildekode-fellesskapet Design etisk.

Nedenfor er noen av rapportene IBM har publisert offentlig om disse prosjektene:

Automatiserte verktøy for styring av AI-modeller er nødvendige for å få viktig innsikt om hvordan AI-modellen din presterer. Men merk at det er optimalt å fange risiko i god tid før modellen er utviklet og er i produksjon. Ved å skape fellesskap av varierte, tverrfaglige utøvere som tilbyr et trygt sted for folk å ha tøffe samtaler om ulik påvirkning, kan du begynne reisen din til å operasjonalisere prinsippene dine og utvikle AI på en ansvarlig måte.

I praksis, når du ansetter for AI-utøvere, må du tenke på at godt over 70 % av innsatsen med å lage modeller er å kurere de riktige dataene. Du ønsker å ansette folk som vet hvordan de skal samle inn data som er representativ og som også samles inn med samtykke. Du vil også at folk som vet skal jobbe tett med domeneeksperter for å sikre at de har riktig tilnærming. Å sikre at disse utøverne har den emosjonelle intelligensen til å nærme seg utfordringen med å ansvarlig kuratere AI med ydmykhet og dømmekraft er nøkkelen. Vi må være bevisste på å lære å gjenkjenne hvordan og når AI-systemer kan forverre ulikhet like mye som de kan øke menneskelig intelligens.

Gjenoppfinn hvordan virksomheten din fungerer med AI

Var denne artikkelen til hjelp?

JaNei

Mer fra kunstig intelligens

IBMs nyhetsbrev

Få våre nyhetsbrev og emneoppdateringer som gir den siste tankeledelsen og innsikt om nye trender.

Abonner nå

Flere nyhetsbrev

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.ibm.com/blog/why-we-need-diverse-multidisciplinary-coes-for-model-risk/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 000

- 1

- 16

- 2022

- 2024

- 23

- 25

- 28

- 29

- 30

- 300

- 32

- 39

- 40

- 400

- 65

- 7

- 9

- a

- evne

- Om oss

- ovenfor

- AC

- akselerere

- nøyaktighet

- nøyaktig

- nøyaktig

- tvers

- Handling

- tilpasset

- adresse

- innrømme

- adoptere

- Annonsering

- råd

- påvirke

- agenter

- AI

- AI-modeller

- AI-systemer

- sikte

- AL

- algoritmisk

- algoritmer

- Alle

- også

- alltid

- amp

- an

- analytics

- og

- noen

- Søknad

- søknader

- tilnærming

- ER

- områder

- Artikkel

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- AS

- spør

- vurdere

- vurdere

- evaluering

- assistenter

- bistå

- At

- lyd

- øke

- forfatter

- tilgjengelig

- unngå

- tilbake

- balansering

- BE

- vært

- før du

- begynne

- være

- mener

- Fordeler

- Bedre

- Beyond

- Bias

- skjevheter

- Blogg

- blogger

- Blå

- boston

- både

- bredere

- Bygning

- virksomhet

- forretningsfunksjoner

- bedrifter

- men

- knapp

- by

- CAN

- fangst

- fange

- karbon

- kort

- Kort

- hvilken

- saken

- CAT

- Kategori

- Årsak

- sentrum

- Center of Excellence

- sentral

- viss

- utfordre

- egenskaper

- chatbots

- sjekk

- barn

- Barn

- sirkler

- CIS

- klasse

- klart

- klienter

- tett

- Cloud

- farge

- kombinasjon

- kommer

- Felles

- Communities

- samfunnet

- Selskaper

- Selskapet

- Terminado

- konsept

- samtykke

- Følgelig

- Vurder

- konsulent

- Container

- fortsette

- samtaler

- Kjerne

- korrigere

- korrelert

- Kostnad

- kunne

- opprettet

- Opprette

- skaperne

- kritisk

- mengde

- CSS

- kuratering

- I dag

- skikk

- kunde

- kundeopplevelse

- Kunder

- dato

- Dato

- avgjørelser

- dypeste

- Misligholde

- definisjoner

- leverer

- demonstrerer

- utplasserings

- beskrivelse

- utforming

- design tenkning

- designet

- Bestem

- utvikle

- utviklet

- forskjellig

- vanskelig

- digitalt

- Digital Transformation

- uensartede

- Fornem

- diverse

- Mangfold

- do

- domene

- donert

- trukket

- stasjonen

- E&T

- effekter

- innsats

- eliminere

- embedding

- omfavne

- Emery

- ansatte

- muliggjøre

- engasjerende

- Motor

- Ingeniører

- Engelsk

- nok

- sikrer

- Enter

- feil

- etc

- Eter (ETH)

- etisk

- etikk

- evaluere

- evaluere

- evaluering

- Selv

- Hver

- overalt

- forverre

- eksempel

- eksempler

- Excellence

- Utgang

- forvente

- erfaring

- Erfaringer

- Expert

- ekspertise

- eksperter

- forklarte

- utsatt

- strekker

- ekstremt

- facebook messenger

- legge til rette

- vendt

- faktorer

- rettferdighet

- falsk

- langt

- FAST

- Noen få

- Finn

- Fokus

- følge

- etter

- fonter

- Til

- teten

- skjemaer

- Fundament

- rammer

- fra

- foran

- funksjoner

- samle

- samlet

- samle

- generative

- Generativ AI

- generator

- få

- gitt

- gir

- Global

- mål

- Mål

- Går

- god

- styresett

- Grammatikk

- sterkt

- Grid

- Gruppe

- Gruppens

- Vekst

- veilede

- skade

- Ha

- Overskrift

- høre

- høyde

- hjelpe

- nyttig

- Høy

- ham

- leie

- Ansetter

- hans

- holder

- helhetlig

- Hjemprodukt

- Hvordan

- Hvordan

- HTTPS

- menneskelig

- menneskelig intelligens

- ydmykhet

- Hybrid

- hybrid sky

- i

- JEG VIL

- IBM

- ICO

- ICON

- ideell

- identifisert

- if

- Uvitenhet

- bilde

- umiddelbar

- Påvirkning

- Konsekvenser

- iverksette

- implementere

- betydning

- viktig

- forbedre

- forbedringer

- forbedrer

- in

- inkludere

- Inkludert

- inkludering

- innlemme

- stadig

- inkrementell

- indeks

- industri

- Innflytelsesrik

- informasjon

- Innovasjon

- innovatører

- inngang

- innsikt

- innsikt

- øyeblikkelig

- i stedet

- Institute

- forsikring

- forsikringsselskaper

- Intelligens

- Intelligent

- hensikt

- Tilsiktet

- intensjoner

- interessert

- interesser

- internt

- Snitt

- intervensjon

- skremmende

- egenverdi

- er n

- utstedelse

- saker

- IT

- DET ER

- Januar

- bli medlem

- Bli med oss

- reise

- jpg

- bare

- holde

- nøkkel

- Vet

- kjent

- maling

- Språk

- språk

- stor

- storskala

- siste

- føre

- leder

- Ledelse

- læring

- la

- Nivå

- Leverage

- ansvar

- løgn

- i likhet med

- Begrenset

- Liste

- lokal

- lokale

- UTSEENDE

- gjøre

- Making

- ledelse

- håndbok

- mange

- math

- matematiske

- Saken

- max bredde

- Kan..

- me

- bety

- Møt

- Messenger

- kunne

- minutter

- tankene

- minimum

- minutter

- Mobil

- modell

- modeller

- modernisering

- mer

- mest

- flytte

- mye

- tverrfaglig

- må

- my

- Natur

- Navigasjon

- nødvendig

- Trenger

- nødvendig

- behov

- negativt

- Ny

- nye produkter

- nyhetsbrev

- nlp

- Nei.

- note

- ingenting

- nå

- mange

- of

- off

- tilby

- tilbudt

- Tilbud

- ofte

- on

- ONE

- åpen kildekode

- Mening

- Muligheter

- optimal

- optimalisert

- or

- organisasjoner

- Annen

- vår

- outperform

- utganger

- enn

- egen

- eiere

- side

- deltakende

- passere

- Ansatte

- utfører

- person

- personlig

- personlig

- prospektet

- PHP

- PII

- planer

- plato

- Platon Data Intelligence

- PlatonData

- plugg inn

- politikk

- posisjon

- Post

- potensiell

- potensielle kunder

- makt

- kraftig

- praksis

- praksis

- prediksjon

- Spådommer

- prediktiv

- primære

- prinsipper

- Prioriter

- privilegium

- Problem

- innkjøp

- produserer

- Produksjon

- produktivitet

- Produkter

- programmer

- prosjekter

- riktig

- prospektet

- forutsatt

- gi

- fullmakter

- proxy

- psykologisk

- offentlig

- publisert

- sette

- spørsmål

- raskt

- sitere

- sjelden

- Beredskap

- Lesning

- ekte

- Reality

- gjenkjenne

- anbefalinger

- redusere

- avgrense

- reflektere

- reflektert

- forskrifter

- Rapporter

- representant

- representert

- forespørsler

- krever

- påkrevd

- forskning

- svare

- ansvarlig

- ansvarlig

- responsive

- inntekter

- omsetningsvekst

- ikke sant

- Risiko

- risikofaktorer

- risikoer

- vei

- roboter

- trygge

- Sikkerhet

- Sa

- samme

- sier

- Skala

- skalering

- Vitenskap

- Skjerm

- skript

- Søk

- søkemotor

- sikre

- se

- SEO

- serverer

- innstillinger

- bør

- vist

- ganske enkelt

- nettstedet

- slakk

- liten

- Smart

- Smarte høyttalere

- SMS

- So

- løsning

- Solutions

- noen

- Kilder

- Rom

- høyttalere

- Sponset

- firkanter

- interessenter

- Standard

- Begynn

- state-of-the-art

- statistisk

- statistikk

- Studenter

- Studer

- emne

- abonnere

- slik

- støtte

- Støtte

- SVG

- Systemer

- T

- bord

- ta

- mål

- lærer

- lag

- Teknisk

- Technologies

- tertiære

- tekst

- enn

- Takk

- Det

- De

- verden

- deres

- Dem

- tema

- seg

- Disse

- de

- tror

- tenker

- denne

- De

- trodde

- tenkte ledelse

- tre

- Gjennom

- tid

- Tittel

- til

- sammen

- verktøy

- topp

- Tema

- tøff

- Tog

- Kurs

- Transformation

- Trender

- sant

- troverdig

- to

- typen

- typisk

- forstå

- urettferdig

- unik

- opplåsing

- oppdateringer

- upon

- URL

- us

- bruke

- bruk sak

- bruker

- utnytte

- verdi

- Verdier

- variasjon

- Varierende

- veldig

- virtuelle

- volum

- W

- ønsker

- var

- we

- VI VIL

- Hva

- Hva er

- når

- om

- hvilken

- mens

- HVEM

- hvem

- hvorfor

- allment

- bredere

- vil

- visdom

- KLOK

- med

- ord

- WordPress

- Arbeid

- virker

- verden

- ville

- skrevet

- Feil

- ennå

- du

- Din

- zephyrnet