Gitt populær fascinasjon virker det umulig i disse dager å snakke om noe annet enn AI. På CadenceLIVE var det forfriskende å bli minnet på at de grunnleggende metodene som design av enhver type forblir på og alltid vil bli dominert i alle aspekter av ingeniørkunst av dyp, presis og skalerbar matematikk, fysikk, informatikk og kjemi. AI utfyller designteknologier, slik at ingeniører kan utforske flere alternativer og optimaliseringer. Men det vil fortsette å stå på skuldrene til over 200 år med akkumulert STEM-ekspertise og beregningsmetoder som en innpakning rundt, men ikke fortrenge disse metodene.

For å gi denne observasjonen, hvor er AI nyttig i elektroniske designsystemer, og mer generelt, hvordan påvirker AI og andre teknologier forretningsskifter i halvleder- og elektroniske systemindustrien? Det er temaet for resten av denne bloggen.

AI i Cadence-produkter

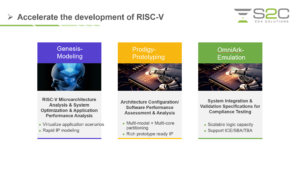

Cadence har helt klart til hensikt å være en frontløper innen AI-applikasjoner. I løpet av de siste årene har de annonsert flere AI-drevne produkter – Cadence Cerebrus for fysisk syntese, Verisium for verifisering, Joint Enterprise Data og AI (JedAI) for å forene massive datasett, og Optimality for multi-fysikkoptimalisering. Nylig la de til Virtuoso-utvidelser for analog design, Allegro X AI for avansert PCB og Integrity for 3D-IC-design.

Som et fysisk synteseprodukt forventer jeg at Cadence Cerebrus primært er rettet mot blokkdesign av de samme grunnene som jeg nevnte i en tidligere blogg. Her forventer jeg at forsterkende læring rundt flere fulle fysiske syntesekjøringer driver bredere utforskning av alternativer og bedre ultimate PPA.

Verisium har et ganske bredt mål innen verifisering, som omfatter feilsøking og optimalisering av testsuiter, for eksempel, i tillegg til dekningsoptimalisering på blokknivå. Bortsett fra dekning på blokknivå, forventer jeg at andre aspekter vil tilby verdi på tvers av designspekteret, igjen basert på forsterkende læring over flere serier (og kanskje til og med mellom produkter i samme familie).

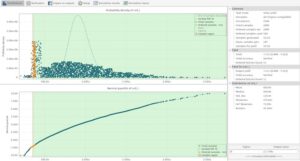

Optimalitet er i seg selv en analyse- og optimaliseringspakke på systemnivå. Også her kan forsterkende læring på tvers av flere kjøringer hjelpe komplekse multifysikkanalyser – elektromagnetikk, termisk, signal- og strømintegritet – til å konvergere over flere prøver enn det som er mulig å vurdere i tradisjonell manuell iterasjon.

Virtuoso Studio for analog er i seg selv et designverktøy på blokknivå fordi ingen, så vidt jeg vet, bygger full-chip analoge design på SoC-skalaen (med unntak av minner og kanskje nevromorfe ting). Automatisering i analog design har vært et håpet, men uoppnådd mål i flere tiår. Virtuoso tilbyr nå læringsbaserte metoder for plassering og ruting, noe som høres spennende ut.

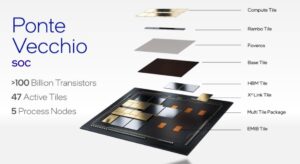

Allegro X AI sikter mot lignende mål innen PCB-design, og tilbyr automatisert PCB-plassering og ruting. Nettstedet antyder at de bruker generative teknikker her, helt i forkant av AI i dag. Integrity-plattformen bygger på den store databasekapasiteten til Innovus Implementation System og utnytter både Virtuoso og Allegro for analog RF og pakke-co-design, og gir en omfattende og enhetlig løsning 3D-IC-design.

Tre perspektiver på tilpasning til endring

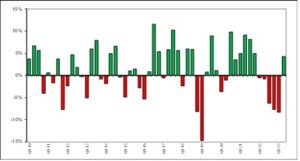

Det er ingen hemmelighet at markedene endrer seg raskt som svar på flere nye teknologier (inkludert AI) og raskere endringer i systemmarkeder samt økonomiske og geopolitiske påkjenninger. En veldig tydelig endring i vår verden er den raske veksten av chipdesign internt blant systemselskaper. Hvorfor skjer det, og hvordan tilpasser halvleder- og EDA-selskaper seg?

Et systemperspektiv fra Google Cloud

Thomas Kurian, administrerende direktør i Google Cloud, snakket med Anirudh om trender innen sky- og chipdesignbehov. Han gikk gjennom utviklingen av etterspørselen etter cloud computing, og startet med Software-as-a-Service (SaaS), drevet av applikasjoner fra Intuit og Salesforce. Derfra gikk landskapet videre til Infrastructure-as-a-Service (IaaS) som lar oss kjøpe elastisk tilgang til datamaskinvare uten å måtte administrere den maskinvaren.

Nå ser Thomas på digitalisering som hoveddriveren: i biler, mobiltelefoner, hvitevarer, industrimaskiner. Etter hvert som digitaliseringen skjer, har digitale tvillinger blitt populære for å modellere og optimalisere virtualiserte prosesser, ved å bruke dyp læring for å utforske et bredere spekter av muligheter.

For å støtte dette målet i stor skala, ønsker Google å kunne behandle verdensomspennende nettverksbaserte datasentre som en enhetlig dataressurs, som kobles til gjennom nettverksstrukturer med superlav ventetid for forutsigbar ytelse og ventetid uansett hvordan arbeidsbelastningen er fordelt. Å nå dette målet krever mye tilpasset halvlederdesign for nettverk, for lagring, for AI-motorer og for andre akseleratorer. Thomas mener at de på visse kritiske områder kan bygge differensierte løsninger som oppfyller deres CAPEX- og OPEX-mål bedre enn gjennom eksternt hentede halvledere.

Hvorfor? Det er ikke alltid praktisk for en ekstern leverandør å teste i ekte systemskala. Hvem kan reprodusere strømming av videotrafikk i skalaen til en Google eller AWS eller Microsoft? Dessuten hjelper det å optimalisere komponentene i byggesystemprosessdifferensiering, men ikke like mye som fullprosessoptimalisering. Si fra Kubernetes, til containere, til klargjøring, til en beregningsfunksjon. Vanskelig for en vanlig semileverandør å administrere dette omfanget.

Et halvlederperspektiv fra Marvell

Chris Koopmans, COO hos Marvell, snakket om hvordan de tilpasser seg til utviklende systemselskapsbehov. Marvell er helt fokusert på datainfrastrukturteknologi i datasentre og gjennom trådløse og kablede nettverk. AI-trening og andre noder må kunne kommunisere pålitelig med høy båndbredde og med lav latens ved terabyte per sekund på tvers av avstander i datasenterstørrelse. Tenk på ChatGPT, som ryktes å trenge ~10K GPUer for trening.

Dette tilkoblingsnivået krever supereffektiv datainfrastruktur, men likevel trenger skytjenesteleverandører (CSP) all den differensieringen de kan få og ønsker å unngå løsninger som passer for alle. Marvell samarbeider med CSP-er for å bygge det de kaller skyoptimalisert silisium. Dette starter med en generell komponent, som tjener et supersett av behov, som inneholder noen av de riktige ingrediensene for en gitt CSP, men overbygget og derfor utilstrekkelig effektiv som den er. En skyoptimalisert løsning er skreddersydd fra denne plattformen til en CSPs målarbeidsbelastninger og applikasjoner, og dropper det som ikke er nødvendig og optimaliserer for spesielle akseleratorer og grensesnitt etter behov. Denne tilnærmingen lar Marvell levere kundespesifikke design fra et referansedesign ved hjelp av Marvell-differensierte infrastrukturkomponenter.

Et EDA-perspektiv fra Cadence

Tom Beckley, senior VP og GM for Cadence Custom IC & PCB-gruppen på Cadence, avsluttet med et EDA-perspektiv på tilpasning til endringer. Du tror kanskje at med kunder innen systemer og halvlederdesign, har EDA det enkelt. For å dekke dette spekteret av behov må imidlertid en omfattende "EDA"-løsning spenne over spekteret – fra IC-design (digital, analog og RF) til 3D-IC og pakkedesign, til PCB-design og deretter opp til elektromekanisk design (Dassault) Systemsamarbeid).

Legg til analyser og optimalisering til blandingen for å sikre elektromagnetisk, termisk, signal- og strømintegritet, slik at kundene kan modellere og optimalisere komplette systemer (ikke bare brikker) før maskinvaren er klar. Mens de også erkjenner at deres kunder jobber etter stramme tidsplaner med nå ytterligere begrenset bemanning. Til sammen er det en stor ordre. Mer samarbeid, mer automatisering og mer AI-veiledet design vil være avgjørende.

Med løsningene som er skissert her, ser det ut til at Cadence er på god vei. Min takeaway, CadenceLIVE 2023 ga en god oppdatering om hvordan Cadence imøtekommer industribehov (med en sunn dose AI), pluss ny innsikt i retninger for systemer/halvledere/designindustrien.

Del dette innlegget via:

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoAiStream. Web3 Data Intelligence. Kunnskap forsterket. Tilgang her.

- Minting the Future med Adryenn Ashley. Tilgang her.

- Kjøp og selg aksjer i PRE-IPO-selskaper med PREIPO®. Tilgang her.

- kilde: https://semiwiki.com/artificial-intelligence/328563-takeaways-from-cadencelive-2023/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 2023

- a

- I stand

- Om oss

- akseleratorer

- adgang

- akkumulert

- tvers

- la til

- tillegg

- adressering

- avansert

- fremskritt

- påvirke

- en gang til

- AI

- AI-trening

- AI-drevet

- sikte

- mål

- Alle

- tillate

- tillater

- også

- alltid

- blant

- an

- analyse

- analytics

- og

- annonsert

- noen

- hva som helst

- tilsynelatende

- hvitevarer

- søknader

- påføring

- tilnærming

- ER

- områder

- rundt

- AS

- aspekter

- At

- Automatisert

- Automatisering

- unngå

- AWS

- Båndbredde

- basert

- BE

- fordi

- bli

- vært

- før du

- mener

- Bedre

- mellom

- Blokker

- Blogg

- både

- bred

- bygge

- Bygning

- bygger

- virksomhet

- men

- kjøpe

- by

- Cadence

- ring

- CAN

- Kan få

- Kapasitet

- biler

- mobil

- Sentre

- konsernsjef

- viss

- endring

- Endringer

- endring

- ChatGPT

- kjemi

- chip

- chips

- klart

- Cloud

- cloud computing

- samarbeid

- kommunisere

- Selskaper

- Selskapet

- fullføre

- komplekse

- komponent

- komponenter

- omfattende

- Beregn

- datamaskin

- informatikk

- databehandling

- Tilkobling

- Tilkobling

- Vurder

- Containere

- fortsette

- konvergerer

- COO

- dekning

- kritisk

- CSP

- skikk

- Kunder

- dato

- datasentre

- datainfrastruktur

- datasett

- Database

- Dager

- tiår

- dyp

- dyp læring

- leverer

- Etterspørsel

- krav

- utforming

- prosjekteringssystemer

- design

- differensiert

- vanskelig

- digitalt

- Digitale tvillinger

- digitalisering

- retninger

- distribueres

- do

- drevet

- sjåfør

- slippe

- Tidligere

- lett

- økonomisk

- Edge

- effektiv

- elektronisk

- Emery

- Nye teknologier

- Ingeniørarbeid

- Ingeniører

- Motorer

- sikre

- Enterprise

- avgjørende

- Eter (ETH)

- Selv

- evolusjon

- utvikling

- eksempel

- unntak

- forvente

- ekspertise

- leting

- utforske

- utvidelser

- utvendig

- eksternt

- stoffer

- familie

- raskere

- gjennomførbart

- Noen få

- fokuserte

- Til

- fra

- fullt

- funksjon

- videre

- generell

- generelt

- generative

- geopolitiske

- få

- gitt

- GM

- mål

- Mål

- god

- Google Cloud

- GPU

- Gruppe

- Vekst

- skje

- Skjer

- maskinvare

- Ha

- he

- sunt

- hjelpe

- hjelper

- her.

- Høy

- Hjemprodukt

- Hvordan

- Men

- HTTPS

- i

- gjennomføring

- umulig

- in

- Inkludert

- industriell

- bransjer

- industri

- Infrastruktur

- innsikt

- integritet

- hensikt

- grensesnitt

- inn

- egen~~POS=TRUNC

- Intuit

- IT

- køyring

- ledd

- jpg

- bare

- kunnskap

- Kubernetes

- landskap

- stor

- Siste

- Ventetid

- ledende

- læring

- Nivå

- utnytter

- Lot

- Lav

- maskiner

- Mainstream

- administrer

- håndbok

- Markets

- massive

- math

- Saken

- max bredde

- møte

- Minner

- nevnt

- metoder

- Microsoft

- kunne

- modell

- mer

- flytting

- mye

- flere

- må

- my

- nødvendig

- Trenger

- nødvendig

- behov

- nettverk

- nettverk

- nettverk

- Nei.

- noder

- roman

- nå

- Målet

- of

- tilby

- tilby

- on

- ONE

- optimalisering

- Optimalisere

- optimalisere

- alternativer

- or

- rekkefølge

- Annen

- vår

- skissert

- enn

- pakke

- partnere

- banen

- ytelse

- kanskje

- perspektiv

- prospektet

- telefoner

- fysisk

- Fysikk

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- i tillegg til

- Populær

- muligheter

- Post

- makt

- Praktisk

- presis

- Forutsigbar

- primært

- Principal

- prosess

- Prosesser

- Produkt

- Produkter

- utviklet seg

- forutsatt

- tilbydere

- gi

- formål

- område

- rask

- raskt

- klar

- grunner

- nylig

- gjenkjenne

- referansedesign

- forsterkning læring

- forbli

- Krever

- ressurs

- svar

- REST

- ikke sant

- ruting

- SaaS

- Salesforce

- samme

- sier

- skalerbar

- Skala

- Vitenskap

- omfang

- Sekund

- Secret

- synes

- Sees

- Semi

- halvledere

- Halvledere

- senior

- betjene

- tjeneste

- tjenestetilbydere

- servering

- sett

- flere

- Skift

- Signal

- Silicon

- lignende

- løsning

- Solutions

- noen

- hentet

- span

- spesiell

- Spectrum

- bemanning

- stå

- Start

- starter

- stem

- lagring

- streaming

- studio

- emne

- foreslår

- suite

- Super

- støtte

- system

- Systemer

- skreddersydd

- Takeaways

- Snakk

- Target

- teknikker

- Technologies

- Teknologi

- test

- enn

- Det

- De

- Landskapet

- deres

- deretter

- Der.

- derfor

- termisk

- Disse

- de

- tror

- denne

- De

- Gjennom

- til

- i dag

- sammen

- verktøy

- tradisjonelle

- trafikk

- Kurs

- behandle

- Trender

- sant

- Twins

- typen

- ultimate

- enhetlig

- Oppdater

- upon

- us

- ved hjelp av

- verdi

- Verifisering

- veldig

- av

- video

- gikk

- ønsker

- ønsker

- var

- Nettsted

- VI VIL

- Hva

- Hva er

- hvilken

- mens

- HVEM

- hvorfor

- bredere

- vil

- trådløs

- med

- uten

- arbeid

- verden

- verdensomspennende

- ville

- Innpakket

- X

- år

- ennå

- du

- zephyrnet