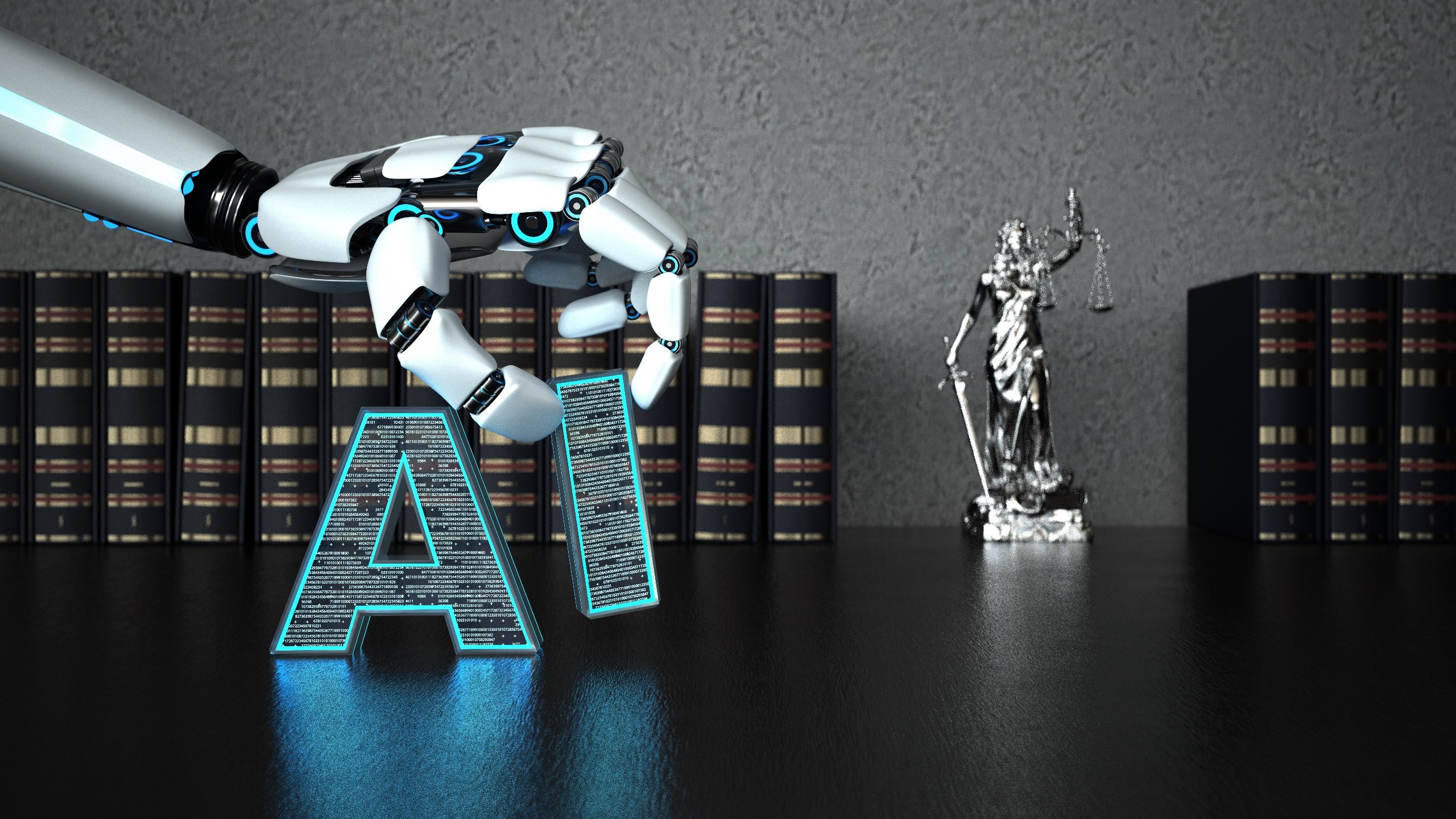

Den amerikanske radiokringkasteren Mark Walters saksøkte OpenAI for injurier etter at AI-chatboten ChatGPT anklaget ham for å ha underslått penger fra Second Amendment Foundation (SAF). Walters sier at påstandene er falske og at han heller aldri har jobbet for våpenrettighetsgruppen.

Søksmålet ble anlagt for Superior Court i Gwinnett County, Georgia, 5. juni, og antas å være det første noensinne som hevder at en AI-chatbot liker ChatGPT kan holdes ansvarlig for ærekrenkelse. Walters søker uspesifisert økonomisk erstatning fra OpenAI, rapporterer Gizmodo.

Les også: ChatGPTs falske sitater land amerikansk advokat i varmt vann

"OpenAI ærekrenket min klient"

Walters' advokat John Monroe påsto at ChatGPT "publiserte injurierende materiale" om programverten "Armed American Radio" da han svarte på et spørsmål fra Fred Riehl, sjefredaktør for våpennettstedet AmmoLand, som undersøkte en legitim SAF-sak.

Riehl ga chatboten en URL som pekte til en sak som involverte SAF og Washington statsadvokat Bob Ferguson, og ba om et sammendrag. ChatGPT utpekte selvsikkert, men feilaktig, Walters som tiltalt og identifiserte ham til og med som SAF-kasserer og finansdirektør, noe han ikke er.

ChatGPTs sammendrag av den verserende saken inkluderte den falske påstanden om at Mark Walters underslått midler fra Second Amendment Foundation. Den Georgia-baserte kringkasteren sier at han aldri har underslått noen penger og at han ikke har noen tilknytning til SAF.

"Alle faktaopplysninger i sammendraget som gjelder Walters er falske," sa Monroe i saken.

"OpenAI ærekrenket klienten min og kom på opprørende løgner om ham," advokaten senere fortalte andre bransjemedier.

ChatGPT er en stor språkmodell utviklet av OpenAI. Den ble lansert i november i fjor og er trent på milliarder av data fra internett. Chatboten kan utføre en rekke oppgaver, inkludert å generere tekst, oversette språk og løse vanskelige matematiske problemer.

ChatGPT er imidlertid utsatt for "hallusinasjoner,” som er et begrep som brukes i teknologibransjen for å beskrive når AI-chatbots produserer falsk eller villedende informasjon, ofte med selvtillit.

"Selv state-of-the-art modeller produserer fortsatt logiske feil, ofte kalt hallusinasjoner," skrev Karl Cobbe, en OpenAI-forsker, i en blogg innlegg. "Å dempe hallusinasjoner er et kritisk skritt mot å bygge tilpasset AGI [kunstig generell intelligens]."

Holder feil AI til regnskap

De feil har en tendens til å undergrave nytten av slik kunstig intelligent teknologi. Men AI-skapere inkludert OpenAI og Google, har fortsatt å markedsføre chatbotene som en ny måte å få informasjon på. Merkelig nok advarte selskapene også om at produksjonen deres ikke skulle stoles på.

her er GPT-4, vår mest dyktige og justerte modell hittil. den er tilgjengelig i dag i vår API (med venteliste) og i ChatGPT+.https://t.co/2ZFC36xqAJ

det er fortsatt feil, fortsatt begrenset, og det virker fortsatt mer imponerende ved første gangs bruk enn det gjør etter at du har brukt mer tid med det.

- Sam Altman (@sama) Mars 14, 2023

Under Fred Riehls undersøkelser fortsatte ChatGPT å generere falsk informasjon, til og med opprette hele passasjer om søksmålet som var fullstendig fabrikkert. Som Gizmodo rapporterte, fikk AI-verktøyet til og med saksnummeret feil.

Journalisten spurte AI om sammendraget med påstand om at Walters var involvert i Second Amendment Foundation v. Ferguson-saken, som utfordrer en statlig lov som forbyr salg av angrepsvåpen. ChatGPT svarte: "Sikkert," i henhold til Walters farge.

"Her er avsnittet fra klagen som angår Walters: 'Sakakte Mark Walters ("Walters") er en person som er bosatt i Georgia. Walters har fungert som kasserer og finansdirektør i SAF siden minst 2012. Walters har tilgang til SAFs bankkontoer og finansielle poster og er ansvarlig for å vedlikeholde disse postene og levere økonomiske rapporter til SAFs styre.»

Riehl publiserte ikke artikkelen, men delte i stedet AIs svar med SAF-grunnleggeren og visepresidenten Allan Gottlieb som sa at ChatGPT-utsagnene var falske.

I rettssaken sa advokat John Monroe at "ChatGPTs påstander var falske og ondsinnede" og skadet Walters omdømme. Han vil at selskaper som utvikler AI-chatbots skal holdes ansvarlige for den villedende informasjonen de kommer med.

"Selv om forskning og utvikling innen AI er en verdifull bestrebelse, er det uansvarlig å slippe løs et system på offentligheten vel vitende om at det produserer informasjon som kan forårsake skade," sa Monroe Gizmodo.

Saksøker OpenAIs ChatGPT

Men er det mulig at falsk informasjon generert av store språkmodeller som ChatGPT kan betraktes som injurier i en domstol? Prosper Mwedzi, en teknisk advokat ved det britiske finansdepartementet, fortalte MetaNews at problemet er komplekst.

"Dette er et komplekst spørsmål fordi det [ChatGPT] henter informasjon fra internett," sa han. "Så jeg vil tro at personen som saksøker ville ha det bedre å gå for kilden i stedet [enten OpenAI eller den originale utgiveren av det refererte materialet.]

"Jeg ser det som å søke etter noe på Google, og det henter frem en kilde med det ærekrenkende materialet - det ville helt klart ikke være Googles feil. Men hvis noen bruker ChatGPT til å skrive en injurierende artikkel, ble de ansvarlige siden de ikke kan forsvare at det er ChatGPT.»

Mwedzi ser liten sjanse for å lykkes med søksmålet til Mark Walters. "Jeg tror utsiktene ikke er veldig sterke," sa han.

Eugene Volokh, professor i jus ved University of California, Los Angeles, som skriver en journaloppgave om det juridiske ansvaret til AI-modeller, sa at det er mulig at AI-modeller kan holdes juridisk ansvarlig for handlingene deres.

"OpenAI erkjenner at det kan være feil, men [ChatGPT] faktureres ikke som en spøk; det er ikke fakturert som fiksjon; det er ikke fakturert som aper som skriver på en skrivemaskin,” sa han til Gizmodo.

Voksende trend

Dette er ikke første gang AI-drevne chatboter har slått ut usannheter om ekte mennesker. Forrige måned, amerikanske advokat Steven A. Schwartz møtt disiplinære tiltak etter at advokatfirmaet hans brukte ChatGPT til juridisk forskning og siterte seks falske saker i et søksmål.

Saken kom frem etter at Schwartz, en advokat med 30 års erfaring, brukte disse sakene som presedens for å støtte en sak der hans klient Roberto Mata saksøkte det colombianske flyselskapet Avianca for uaktsomhet forårsaket av en ansatt.

I mars, Brian Hood, ordføreren i Hepburn Shire i Australia, truet å saksøke OpenAI etter chatboten ChatGPT, hevdet feilaktig at han var dømt for bestikkelser. Hood var ikke involvert i bestikkelsesskandalen, og faktisk var han varsleren som avslørte den.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- EVM Finans. Unified Interface for desentralisert økonomi. Tilgang her.

- Quantum Media Group. IR/PR forsterket. Tilgang her.

- PlatoAiStream. Web3 Data Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://metanews.com/openais-chatgpt-accused-of-defamation-in-landmark-lawsuit/

- : har

- :er

- :ikke

- $OPP

- 13

- 14

- 2012

- 30

- 8

- a

- Om oss

- adgang

- ansvarlig

- kontoer

- tiltalte

- Handling

- handlinger

- Etter

- AGI

- AI

- AI chatbot

- AI-drevet

- Flyselskapet

- justert

- påstander

- påstått

- også

- amerikansk

- an

- og

- Angeles

- noen

- api

- ER

- Artikkel

- kunstig

- kunstig generell intelligens

- AS

- At

- advokat

- Justisminister

- Australia

- tilgjengelig

- Bank

- bankkontoer

- Bans

- bbc

- BE

- ble

- fordi

- vært

- antatt

- Bedre

- milliarder

- borde

- styret

- bob

- Brian

- Bringer

- Bygning

- men

- by

- california

- som heter

- kom

- CAN

- stand

- saken

- saker

- Årsak

- forårsaket

- cfo

- utfordringer

- sjanse

- chatbot

- chatbots

- ChatGPT

- sjef

- Økonomisjef

- finansdirektør

- sitert

- hevdet

- klart

- kunde

- Selskaper

- klage

- helt

- komplekse

- bekymringer

- selvtillit

- selvsikkert

- tilkobling

- ansett

- fortsatte

- kunne

- fylke

- Court

- Opprette

- kreasjoner

- skaperne

- kritisk

- dato

- ærekrenkelser

- forsvar

- Avdeling

- beskrive

- utvikle

- utviklet

- Utvikling

- gJORDE

- vanskelig

- Styremedlemmer

- disiplinære

- gjør

- redaktør-in-chief

- enten

- Ansatt

- forsøke

- Hele

- Selv

- erfaring

- utsatt

- Faktisk

- forfalskning

- falsk

- usannheter

- Fiction

- finansiell

- Firm

- Først

- første gang

- første noensinne

- feil

- Til

- Fundament

- Grunnleggeren

- fra

- midler

- general

- generell intelligens

- generere

- generert

- genererer

- Georgia

- få

- skal

- Googles

- Gruppe

- HAD

- skade

- Ha

- he

- Held

- hepburn

- ham

- hans

- panser

- vert

- HOT

- HTTPS

- i

- identifisert

- if

- imponerende

- in

- inkludert

- Inkludert

- individuelt

- industri

- informasjon

- i stedet

- Intelligens

- Intelligent

- Internet

- involvert

- involverer

- utstedelse

- IT

- DET ER

- John

- journal

- journalist

- juni

- Knowing

- Tomt

- landemerke

- Språk

- språk

- stor

- Siste

- I fjor

- seinere

- lansert

- Law

- advokatfirma

- Søksmålet

- advokat

- minst

- Lovlig

- lovlig

- legitim

- ansvar

- ligger

- lett

- i likhet med

- Begrenset

- lite

- logisk

- den

- Los Angeles

- opprettholde

- Mars

- merke

- Mata

- materiale

- math

- Saken

- Kan..

- Mayor

- Media

- MetaNews

- villedende

- feil

- modell

- modeller

- Monetære

- penger

- Måned

- mer

- mest

- my

- oppkalt

- aldri

- Ny

- Nei.

- November

- Antall

- of

- off

- Offiser

- ofte

- on

- OpenAI

- or

- original

- Annen

- vår

- ut

- produksjon

- Papir

- påvente

- Ansatte

- utføre

- person

- plato

- Platon Data Intelligence

- PlatonData

- mulig

- Post

- Presedens

- president

- problemer

- produsere

- Professor

- program

- fremme

- prospekter

- forutsatt

- gi

- offentlig

- publisere

- utgiver

- spørsmål

- avhørt

- radio

- Lese

- ekte

- poster

- rapportert

- Rapporter

- omdømme

- forskning

- forskning og utvikling

- svare

- svar

- ansvarlig

- Reuters

- rettigheter

- s

- Sa

- salg

- Sam

- sier

- Scandal

- Forsker

- søker

- Sekund

- se

- søker

- synes

- Sees

- delt

- bør

- siden

- SIX

- løse

- Noen

- noe

- kilde

- bruke

- Tilstand

- state-of-the-art

- uttalte

- Uttalelse

- uttalelser

- Trinn

- Still

- sterk

- suksess

- slik

- saksøke

- saksøkt

- Dress

- SAMMENDRAG

- overlegen

- støtte

- system

- oppgaver

- tech

- tech industrien

- begrep

- enn

- Det

- De

- Kilden

- Storbritannia

- deres

- deretter

- Der.

- Disse

- de

- tror

- denne

- De

- tid

- til

- i dag

- verktøy

- mot

- trent

- Kasserer

- treasury

- Treasury Avdeling

- sant

- klarert

- oss

- Uk

- STORBRITANNISK SKATKUR

- undergrave

- universitet

- University of California

- frigjøre

- URL

- us

- bruke

- brukt

- bruker

- variasjon

- veldig

- Vice President

- ønsker

- var

- Vei..

- Våpen

- Nettsted

- var

- når

- hvilken

- whistleblower

- HVEM

- med

- arbeidet

- verdt

- ville

- skrive

- skriving

- Feil

- år

- år

- ennå

- du

- zephyrnet