I det raskt utviklende feltet kunstig intelligens, har naturlig språkbehandling blitt et fokuspunkt for både forskere og utviklere. Bygger på grunnlaget for Transformatorarkitektur og BERTs toveis oppgradering, har flere banebrytende språkmodeller dukket opp de siste årene, og flyttet grensene for hva maskiner kan forstå og generere.

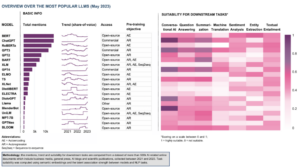

I denne artikkelen vil vi fordype oss i de siste fremskrittene i verden av storskala språkmodeller, og utforske forbedringer introdusert av hver modell, deres evner og potensielle applikasjoner. Vi vil også se nærmere på Visual Langauge Models (VLMs) som er opplært til å behandle ikke bare tekstlige, men også visuelle data.

Hvis du vil hoppe rundt, her er språkmodellene vi presenterte:

- GPT-3 av OpenAI

- LaMDA av Google

- PaLM av Google

- Flamingo av DeepMind

- BLIP-2 fra Salesforce

- LLaMA av Meta AI

- GPT-4 av OpenAI

Hvis dette inngående pedagogiske innholdet er nyttig for deg, kan du abonner på vår adresseliste for AI-forskning å bli varslet når vi slipper nytt materiale.

De viktigste store språkmodellene (LLM) og visuelle språkmodeller (VLM) i 2023

1. GPT-3 av OpenAI

Oppsummering

OpenAI-teamet introduserte GPT-3 som et alternativ til å ha et merket datasett for hver ny språkoppgave. De foreslo at oppskalering av språkmodeller kan forbedre oppgaveagnostisk få-skudds ytelse. For å teste dette forslaget trente de en 175B-parameter autoregressiv språkmodell, kalt GPT-3, og evaluerte ytelsen på over to dusin NLP-oppgaver. Evalueringen under få-skuddslæring, one-shot-læring og zero-shot-læring viste at GPT-3 oppnådde lovende resultater og til og med av og til overgikk de toppmoderne resultatene oppnådd med finjusterte modeller.

Hva er målet?

- For å foreslå en alternativ løsning på det eksisterende problemet, når et merket datasett er nødvendig for hver ny språkoppgave.

Hvordan tilnærmes problemet?

- Forskerne foreslo å skalere opp språkmodeller for å forbedre oppgaveagnostisk ytelse med få skudd.

- De GPT-3 modellen bruker samme modell og arkitektur som GPT-2, inkludert modifisert initialisering, pre-normalisering og reversibel tokenisering.

- I motsetning til GPT-2 bruker den imidlertid alternerende tette og lokalt båndede sparsomme oppmerksomhetsmønstre i transformatorlagene, som i Sparsom transformator.

Hva er resultatene?

- GPT-3-modellen uten finjustering oppnår lovende resultater på en rekke NLP-oppgaver, og overgår til og med avanserte moderne modeller som ble finjustert for den spesifikke oppgaven:

- På CoQA referanseindeks, 81.5 F1 i null-skudd-innstillingen, 84.0 F1 i ett-skudd-innstillingen, og 85.0 F1 i få-skudd-innstillingen, sammenlignet med 90.7 F1-poengsummen oppnådd med finjustert SOTA.

- På TriviaQA referanseindeks, 64.3% nøyaktighet i null-shot-innstillingen, 68.0% i one-shot-innstillingen, og 71.2% i få-shot-innstillingen, og overgår den nyeste teknologien (68%) med 3.2%.

- På LAMBADA datasett, 76.2% nøyaktighet i null-shot-innstillingen, 72.5% i one-shot-innstillingen, og 86.4% i noen-shot-innstillingen, noe som overgår den nyeste teknologien (68%) med 18%.

- Nyhetsartiklene generert av 175B-parameteren GPT-3-modellen er vanskelig å skille fra virkelige, ifølge menneskelige evalueringer (med nøyaktighet knapt over sjansenivået på ~ 52%).

- Til tross for den bemerkelsesverdige ytelsen til GPT-3, fikk den blandede anmeldelser fra AI-fellesskapet:

- “GPT-3-sprøyten er altfor mye. Det er imponerende (takk for de fine komplimentene!), Men det har fortsatt alvorlige svakheter og gjør noen ganger veldig dumme feil. AI kommer til å forandre verden, men GPT-3 er bare et veldig tidlig glimt. Vi har mye fortsatt å finne ut av. ” - Sam Altman, administrerende direktør og medstifter av OpenAI.

- "Jeg er sjokkert over hvor vanskelig det er å generere tekst om muslimer fra GPT-3 som ikke har noe med vold å gjøre ... eller å bli drept ..." - Abubakar Abid, administrerende direktør og grunnlegger av Gradio.

- "Nei. GPT-3 forstår i utgangspunktet ikke den verdenen den snakker om. Å øke corpus ytterligere vil tillate det å generere en mer troverdig pastiche, men ikke fikse dens grunnleggende mangel på forståelse av verden. Demoer av GPT-4 vil fortsatt kreve menneskelig kirsebærplukking. ” - Gary Marcus, administrerende direktør og grunnlegger av Robust.ai.

- "Å ekstrapolere den spektakulære ytelsen til GPT3 i fremtiden antyder at svaret på livet, universet og alt bare er 4.398 billioner parametere." - Geoffrey Hinton, Turing-prisvinner.

Hvor kan man lære mer om denne forskningen?

Hvor kan du få implementeringskode?

- Selve koden er ikke tilgjengelig, men noe datasettstatistikk sammen med ubetingede, ufiltrerte 2048-tokenprøver fra GPT-3 blir gitt ut på GitHub.

2. LaMDA av Google

Oppsummering

Laspråk Modeler for Ddialog Aapplikasjoner (TheMDA) ble opprettet gjennom prosessen med å finjustere en gruppe transformatorbaserte nevrale språkmodeller som er spesielt designet for dialoger. Disse modellene har maksimalt 137B parametere og ble opplært til å bruke eksterne kunnskapskilder. LaMDA-utviklere hadde tre hovedmål i tankene - kvalitet, sikkerhet og jordethet. Resultatene viste at finjustering muliggjør innsnevring av kvalitetsgapet til menneskelige nivåer, men modellens ytelse forble under menneskelig nivå med hensyn til sikkerhet og jordethet.

Googles Bard, utgitt nylig som et alternativ til ChatGPT, er drevet av LaMDA. Til tross for at Bard ofte blir stemplet som kjedelig, kan det sees på som bevis på Googles forpliktelse til å prioritere sikkerhet, selv midt i den intense rivaliseringen mellom Google og Microsoft om å etablere dominans innen generativ AI.

Hva er målet?

- Å bygge en modell for åpne-domene dialogapplikasjoner, der en dialogagent er i stand til å snakke om ethvert emne med svar som er fornuftige, spesifikke for konteksten, basert på pålitelige kilder og etiske.

Hvordan tilnærmes problemet?

- LaMDA er bygget på Transformator, en nevral nettverksarkitektur som Google Research oppfant og åpnet i 2017.

- I likhet med andre store språkmodeller, inkludert BERT og GPT-3, er LaMDA trent på terabyte med tekstdata for å lære hvordan ord forholder seg til hverandre og deretter forutsi hvilke ord som sannsynligvis kommer neste.

- Imidlertid, i motsetning til de fleste språkmodeller, ble LaMDA opplært i dialog for å fange opp nyanser som skiller åpen samtale fra andre former for språk.

- Modellen er også finjustert for å forbedre fornuftigheten, sikkerheten og spesifisiteten til responsene. Selv om setninger som "det er fint" og "jeg vet ikke" kan være meningsfulle i mange dialogscenarier, vil de sannsynligvis ikke føre til interessante og engasjerende samtaler.

- LaMDA-generatoren genererer først flere kandidatsvar, som alle blir skåret basert på hvor sikre, fornuftige, spesifikke og interessante de er. Svar med lav sikkerhetsscore blir filtrert ut, og deretter velges det topprangerte resultatet som svar.

Hva er resultatene?

- Tallrike eksperimenter viser at LaMDA kan delta i engasjerende åpne samtaler om en rekke emner.

- En serie kvalitative evalueringer bekreftet at modellens svar har en tendens til å være fornuftige, spesifikke, interessante og basert på pålitelige eksterne kilder, men det er fortsatt rom for forbedring.

- Til tross for alle fremskritt som er gjort så langt, erkjenner forfatterne at modellen fortsatt har mange begrensninger som kan resultere i å generere upassende eller til og med skadelige svar.

Hvor kan man lære mer om denne forskningen?

Hvor kan du få implementeringskode?

- En åpen kildekode PyTorch-implementering for førtreningsarkitekturen til LaMDA er tilgjengelig på GitHub.

3. PaLM av Google

Oppsummering

Paderetter Lkvaler Model (PALM) er en transformatorbasert språkmodell på 540 milliarder parameter. PaLM ble trent på 6144 TPU v4-brikker ved å bruke Pathways, et nytt ML-system for effektiv trening på tvers av flere TPU Pods. Modellen demonstrerer fordelene med skalering i få-skudds læring, og oppnår toppmoderne resultater på hundrevis av språkforståelse og generasjonsbenchmarks. PaLM overgår finjusterte toppmoderne modeller på flertrinns resonneringsoppgaver og overgår gjennomsnittlig menneskelig ytelse på BIG-bench-benchmark.

Hva er målet?

- For å forbedre forståelsen av hvordan skalering av store språkmodeller påvirker få-skuddslæring.

Hvordan tilnærmes problemet?

- Nøkkelideen er å skalere opplæringen av en 540 milliarder parameter språkmodell med Pathways-systemet:

- Teamet brukte dataparallellisme på Pod-nivå på tvers av to Cloud TPU v4 Pods mens de brukte standarddata og modellparallellisme i hver Pod.

- De var i stand til å skalere trening til 6144 TPU v4-brikker, den største TPU-baserte systemkonfigurasjonen som er brukt til trening til dags dato.

- Modellen oppnådde en treningseffektivitet på 57.8 % maskinvare-FLOP-utnyttelse, som, som forfatterne hevder, er den høyeste oppnådde treningseffektiviteten for store språkmodeller i denne skalaen.

- Opplæringsdataene for PaLM-modellen inkluderte en kombinasjon av engelske og flerspråklige datasett som inneholder høykvalitets nettdokumenter, bøker, Wikipedia, samtaler og GitHub-kode.

Hva er resultatene?

- Tallrike eksperimenter viser at modellytelsen økte kraftig etter hvert som teamet skalert til sin største modell.

- PaLM 540B oppnådde banebrytende ytelse på flere svært vanskelige oppgaver:

- Språkforståelse og generering. Den introduserte modellen overgikk ytelsen til tidligere store modeller med få skudd på 28 av 29 oppgaver som inkluderer oppgaver som svarer på spørsmål, oppgaver med stopp og fullføring av setninger, leseforståelsesoppgaver i kontekst, resonneringsoppgaver med sunn fornuft, SuperGLUE-oppgaver og mer. PaLMs ytelse på BIG-benk-oppgaver viste at den kunne skille årsak og virkning, samt forstå konseptuelle kombinasjoner i passende sammenhenger.

- Argumentasjon. Med 8-skuddspørring løser PaLM 58 % av problemene i GSM8K, en benchmark av tusenvis av utfordrende matematikkspørsmål på grunnskolenivå, og overgår den tidligere toppscore på 55 % oppnådd ved å finjustere GPT-3 175B-modellen. PaLM demonstrerer også evnen til å generere eksplisitte forklaringer i situasjoner som krever en kompleks kombinasjon av flertrinns logisk slutning, verdenskunnskap og dyp språkforståelse.

- Kodegenerering. PaLM yter på nivå med den finjusterte Codex 12B mens de bruker 50 ganger mindre Python-kode for trening, og bekrefter at store språkmodeller overfører læring fra både andre programmeringsspråk og naturlige språkdata mer effektivt.

Hvor kan man lære mer om denne forskningen?

Hvor kan du få implementeringskode?

- En uoffisiell PyTorch-implementering av den spesifikke Transformer-arkitekturen fra PaLM-forskningsartikkelen er tilgjengelig på GitHub. Den skaleres ikke og publiseres kun for pedagogiske formål.

4. Flamingo av DeepMind

Oppsummering

Flamingo er en banebrytende familie av visuelle språkmodeller (VLM), trent på storskala multimodale nettkorpora med blandet tekst og bilder. Med denne opplæringen kan modellene tilpasse seg nye oppgaver ved å bruke minimale kommenterte eksempler, gitt som en oppfordring. Flamingo inkorporerer viktige arkitektoniske fremskritt designet for å slå sammen styrkene til forhåndstrente modeller med kun syn og språk, behandle sekvenser av variabelt sammenflettede visuelle og tekstdata, og tilpasse bilder eller videoer som innganger sømløst. Modellene demonstrerer imponerende tilpasningsevne til en rekke bilde- og videooppgaver som visuelle spørsmålssvar, tekstingsoppgaver og visuelt svar på flere valg, og setter nye ytelsesstandarder ved å bruke oppgavespesifikke spørsmål i få-skuddslæring.

Hva er målet?

- For å gjøre fremskritt mot å aktivere multimodale modeller for raskt å lære og utføre nye oppgaver basert på korte instruksjoner:

- Det mye brukte paradigmet med å forhåndstrene en modell på en stor mengde overvåket data, og deretter finjustere den for den spesifikke oppgaven, er ressurskrevende og krever tusenvis av kommenterte datapunkter sammen med nøye justering av hyperparametere per oppgave.

- Nåværende modeller som bruker et kontrastivt mål tillater null-shot-tilpasning til nye oppgaver, men kommer til kort på mer åpne oppgaver som teksting eller visuelle spørsmålssvar fordi de mangler språkgenereringsevner.

- Denne forskningen tar sikte på å introdusere en ny modell som effektivt adresserer disse problemene og viser overlegen ytelse i regimer med lite data.

Hvordan tilnærmes problemet?

- DeepMind introduserte Flamingo, VLM-er designet for få-skudds læring på ulike åpne syns- og språkoppgaver, med bare noen få input/output-eksempler.

- Flamingo-modeller er visuelt betingede autoregressive tekstgenereringsmodeller som kan behandle teksttokens blandet med bilder og/eller videoer og generere tekst som utdata.

- Arkitekturen til Flamingo inkorporerer to komplementære forhåndstrente og frosne modeller:

- En visjonsmodell som er i stand til å "oppfatte" visuelle scener.

- En stor språkmodell som har til oppgave å utføre grunnleggende resonnement.

- Nye arkitekturkomponenter integrerer disse modellene på en måte som beholder kunnskapen som er oppnådd under deres beregningsintensive pre-trening.

- I tillegg har Flamingo-modeller en Perceiver-basert arkitektur, som lar dem innta bilder eller videoer med høy oppløsning. Denne arkitekturen kan generere et fast antall visuelle tokens per bilde/video fra et bredt og variabelt utvalg av visuelle input-funksjoner.

Hva er resultatene?

- Forskningen viser at på samme måte som LLM-er, som er gode elever med få skudd, kan VLM-er lære av noen få input/output-eksempler for bilde- og videoforståelsesoppgaver som klassifisering, teksting eller svar på spørsmål.

- Flamingo etablerer en ny målestokk innen få-skuddslæring, og demonstrerer overlegen ytelse på et bredt spekter av 16 multimodale språk- og bilde-/videoforståelsesoppgaver.

- For 6 av disse 16 oppgavene overgår Flamingo ytelsen til den finjusterte toppmoderne, selv om den bruker bare 32 oppgavespesifikke eksempler – omtrent 1000 ganger mindre oppgavespesifikke treningsdata enn dagens topppresterende modeller.

Hvor kan man lære mer om denne forskningen?

Hvor kan du få implementeringskode?

- DeepMind ga ikke ut den offisielle implementeringen av Flamingo.

- Du kan finne åpen kildekodeimplementering av den introduserte tilnærmingen i OpenFlamingo Github Repo.

- Den alternative PyTorch-implementeringen er tilgjengelig her..

5. BLIP-2 fra Salesforce

Oppsummering

BLIP-2 er et effektivt og generisk rammeverk for forhåndstrening for visjon- og språkmodeller, designet for å omgå de stadig mer uoverkommelige kostnadene ved å forhåndstrene store modeller. BLIP-2 utnytter hyllefrosne forhåndstrente bildekodere og frosne store språkmodeller for å starte opp vision-språk-foropplæring, med en lett Querying Transformer som er forhåndstrent i to trinn. Det første trinnet initierer visjon-språkrepresentasjonslæring fra en frossen bildekoder, og det andre trinnet driver frem visjon-til-språk-generativ læring fra en frossen språkmodell. Til tross for at den har betydelig færre trenbare parametere, overgår BLIP-2 toppmoderne metoder, og overgår DeepMinds Flamingo80B med 8.7 % på zero-shot VQAv2 med 54 ganger færre trenbare parametere. Modellen viser også lovende null-shot bilde-til-tekst-genereringsevner etter instruksjoner for naturlig språk.

Hva er målet?

- For å få toppmoderne ytelse på synsspråkoppgaver, samtidig som du reduserer beregningskostnadene.

Hvordan tilnærmes problemet?

- Salesforce-teamet introduserte et nytt rammeverk for forhåndstrening på visjonsspråk kalt BLIP-2, Bootstrapping Lspråk-IMage Pomtrening med frosne unimodale modeller:

- De forhåndstrente unimodale modellene forblir frosne under forhåndstrening for å redusere beregningskostnadene og unngå problemet med katastrofal glemsel.

- For å lette tverrmodal justering og bygge bro over modalitetsgapet mellom forhåndstrente synsmodeller og forhåndstrente språkmodeller, foreslår teamet en lett Querying Transformer (Q-Former) som fungerer som en informasjonsflaskehals mellom den frosne bildekoderen og den frosne. LLM.

- Q-former er forhåndstrent med en ny to-trinns strategi:

- Det første foropplæringsstadiet utfører visjon-språkrepresentasjonslæring. Dette tvinger Q-Former til å lære visuell representasjon som er mest relevant for teksten.

- Det andre fortreningsstadiet utfører generativ læring fra visjon til språk ved å koble utgangen fra Q-Former til en frossen LLM. Q-Former er opplært slik at dens visuelle representasjon kan tolkes av LLM.

Hva er resultatene?

- BLIP-2 leverer eksepsjonelle, toppmoderne resultater på tvers av en rekke synsspråklige oppgaver, som omfatter visuelle spørsmålssvar, bildeteksting og bilde-tekstinnhenting.

- For eksempel overgår den Flamingo med 8.7 % på zero-shot VQAv2.

- Dessuten oppnås denne enestående ytelsen med betydelig høyere datamaskineffektivitet:

- BLIP-2 overgår Flamingo-80B mens den bruker 54× færre trenbare parametere.

- BLIP-2 har kapasitet til å utføre null-shot bilde-til-tekst generering som svar på naturlige språkinstruksjoner, og baner dermed vei for utvikling av ferdigheter som visuell kunnskap resonnement og visuell samtale blant andre.

- Til slutt er det viktig å merke seg at BLIP-2 er en allsidig tilnærming som kan utnytte mer sofistikerte unimodale modeller for ytterligere å forbedre ytelsen til forhåndstrening i synsspråk.

Hvor kan man lære mer om denne forskningen?

Hvor kan du få implementeringskode?

Den offisielle BLIP-2-implementeringen er tilgjengelig på GitHub.

6. LLaMA av Meta AI

Oppsummering

Meta AI-teamet hevder at mindre modeller trent på flere tokens er lettere å omskolere og finjustere for spesifikke produktapplikasjoner. Derfor introduserer de Samtaler (Large Laspråk Model Meta AI), en samling av grunnleggende språkmodeller med 7B til 65B parametere. LLaMA 33B og 65B ble trent på 1.4 billioner tokens, mens den minste modellen, LLaMA 7B, ble trent på en billion tokens. De brukte utelukkende offentlig tilgjengelige datasett, uten å være avhengig av proprietære eller begrensede data. Teamet implementerte også viktige arkitektoniske forbedringer og treningshastighetsoptimaliseringsteknikker. Følgelig overgikk LLaMA-13B GPT-3, og var over 10 ganger mindre, og LLaMA-65B viste konkurransedyktig ytelse med PaLM-540B.

Hva er målet?

- Å demonstrere gjennomførbarheten av å trene topppresterende modeller utelukkende på offentlig tilgjengelige datasett, uten å stole på proprietære eller begrensede datakilder.

- For å gi forskningsmiljøet mindre og mer effektive modeller og dermed sette de som ikke har tilgang til store mengder infrastruktur i stand til å studere store språkmodeller.

Hvordan tilnærmes problemet?

- For å trene LLaMA-modellen brukte forskerne kun data som er offentlig tilgjengelige og kompatible med åpen kildekode.

- De har også introdusert noen forbedringer til standard transformatorarkitektur:

- Ved å ta i bruk GPT-3-metodikken ble treningsstabiliteten forbedret ved å normalisere inngangen for hvert transformatorunderlag, i stedet for å normalisere utgangen.

- Inspirert av PaLM-modellene erstattet forskerne ReLU ikke-linearitet med SwiGLU-aktiveringsfunksjonen, for å forbedre ytelsen.

- Inspirert av Su et al (2021), eliminerte de de absolutte posisjonelle innebyggingene og inkorporerte i stedet roterende posisjonelle innebygginger (RoPE) på hvert lag av nettverket.

- Til slutt forbedret Meta AI-teamet treningshastigheten til modellen deres ved å:

- Bruk av effektiv kausal multi-head oppmerksomhetsimplementering ved å ikke lagre oppmerksomhetsvekter eller beregne maskerte nøkkel-/spørringsresultater.

- Bruk av sjekkpunkt for å minimere omberegnede aktiveringer under bakoverpasseringen.

- Overlapping av beregningen av aktiveringer og kommunikasjonen mellom GPUer over nettverket (på grunn av all_reduce-operasjoner).

Hva er resultatene?

- LLaMA-13B overgår GPT-3 til tross for at den er over 10 ganger mindre, mens LLaMA-65B holder stand mot PaLM-540B.

Hvor kan man lære mer om denne forskningen?

Hvor kan du få implementeringskode?

- Meta AI gir tilgang til LLaMA til akademiske forskere, enkeltpersoner tilknyttet myndigheter, sivilsamfunn, akademiske institusjoner og globale industriforskningslaboratorier på individuelle case-evalueringsbasis. For å søke, gå til følgende GitHub repository.

7. GPT-4 av OpenAI

Oppsummering

GPT-4 er en storskala, multimodal modell som godtar bilde- og tekstinndata og genererer tekstutdata. På grunn av konkurranse- og sikkerhetshensyn holdes spesifikke detaljer om modellens arkitektur og opplæring tilbake. Når det gjelder ytelse, overgår GPT-4 tidligere språkmodeller på tradisjonelle benchmarks og viser betydelige forbedringer i brukerhensiktsforståelse og sikkerhetsegenskaper. Modellen oppnår også ytelse på menneskelig nivå på ulike eksamener, inkludert en topp 10 % poengsum på en simulert Uniform Bar Examination.

Hva er målet?

- Å utvikle en storskala, multimodal modell som kan akseptere bilde- og tekstinndata og produsere tekstutganger.

- Å utvikle infrastruktur og optimaliseringsmetoder som oppfører seg forutsigbart på tvers av et bredt spekter av skalaer.

Hvordan tilnærmes problemet?

- På grunn av konkurransemessige landskap og sikkerhetsimplikasjoner, bestemte OpenAI seg for å holde tilbake detaljer om arkitektur, modellstørrelse, maskinvare, treningsberegning, datasettkonstruksjon og opplæringsmetoder.

- De avslører at:

- GPT-4 er en transformatorbasert modell, forhåndsopplært til å forutsi neste token i et dokument.

- Den bruker offentlig tilgjengelige data og tredjeparts lisensierte data.

- Modellen ble finjustert ved hjelp av Reinforcement Learning from Human Feedback (RLHF).

- Ubekreftet informasjon tyder på at GPT-4 ikke er en enestående tett modell som sine forgjengere, men en kraftkoalisjon av åtte separate modeller, hver med svimlende 220 milliarder parametere.

Hva er resultatene?

- GPT-4 oppnår prestasjoner på menneskelig nivå på de fleste profesjonelle og akademiske eksamener, særlig scorer i topp 10% på en simulert enhetlig advokateksamen.

- Den forhåndstrente GPT-4-basismodellen utkonkurrerer eksisterende språkmodeller og tidligere toppmoderne systemer på tradisjonelle NLP-benchmarks, uten benchmark-spesifikk utforming eller tilleggsopplæringsprotokoller.

- GPT-4 demonstrerer en betydelig forbedring i å følge brukerintensjon, med svarene foretrukket fremfor GPT-3.5s svar i 70.2 % av 5,214 XNUMX forespørsler fra ChatGPT og OpenAI API.

- GPT-4s sikkerhetsegenskaper er betydelig forbedret sammenlignet med GPT-3.5, med en 82 % reduksjon i svar på ikke-tillatte innholdsforespørsler og en 29 % økning i overholdelse av retningslinjer for sensitive forespørsler (f.eks. medisinsk rådgivning og selvskading).

Hvor kan man lære mer om denne forskningen?

Hvor kan du få implementeringskode?

- Kodeimplementering av GPT-4 er ikke tilgjengelig.

Virkelige anvendelser av store (syns) språkmodeller

De viktigste AI-forskningsgjennombruddene de siste årene kommer fra store AI-modeller trent på enorme datasett. Disse modellene viser imponerende ytelse, og det er fascinerende å tenke på hvordan AI kan revolusjonere hele bransjer, som kundeservice, markedsføring, e-handel, helsevesen, programvareutvikling, journalistikk og mange andre.

Store språkmodeller har mange applikasjoner i den virkelige verden. GPT-4 viser følgende:

- Naturlig språkforståelse og generering for chatbots og virtuelle assistenter.

- Maskinoversettelse mellom språk.

- Oppsummering av artikler, rapporter eller andre tekstdokumenter.

- Sentimentanalyse for markedsundersøkelser eller overvåking av sosiale medier.

- Innholdsgenerering for markedsføring, sosiale medier eller kreativ skriving.

- Spørsmålssvarssystemer for kundestøtte eller kunnskapsbaser.

- Tekstklassifisering for spamfiltrering, emnekategorisering eller dokumentorganisering.

- Personlig tilpassede språklærings- og veiledningsverktøy.

- Kodegenerering og bistand til programvareutvikling.

- Medisinsk, juridisk og teknisk dokumentanalyse og assistanse.

- Tilgjengelighetsverktøy for personer med nedsatt funksjonsevne, for eksempel tekst-til-tale og tale-til-tekst-konvertering.

- Tjenester for talegjenkjenning og transkripsjon.

Hvis vi legger til en visuell del, utvides områdene med mulige applikasjoner ytterligere:

Det er veldig spennende å følge de siste AI-gjennombruddene og tenke på deres potensielle virkelige applikasjoner. Før vi implementerer disse modellene i det virkelige liv, må vi imidlertid ta tak i de tilsvarende risikoene og begrensningene, som dessverre er ganske betydelige.

Risikoer og begrensninger

Hvis du spør GPT-4 om risikoene og begrensningene, vil det sannsynligvis gi deg en lang liste med relevante bekymringer. Etter å ha filtrert gjennom denne listen og lagt til noen ekstra hensyn, har jeg endt opp med følgende sett med nøkkelrisikoer og begrensninger som moderne store språkmodeller besitter:

- Bias og diskriminering: Disse modellene lærer av enorme mengder tekstdata, som ofte inneholder skjevheter og diskriminerende innhold. Som et resultat kan de genererte utdataene utilsiktet opprettholde stereotypier, støtende språkbruk og diskriminering basert på faktorer som kjønn, rase eller religion.

- feil~~POS=TRUNC: Store språkmodeller kan generere innhold som er faktisk feil, villedende eller utdatert. Selv om modellene er opplært på en rekke forskjellige kilder, kan det hende at de ikke alltid gir den mest nøyaktige eller oppdaterte informasjonen. Ofte skjer dette fordi modellen prioriterer å generere utdata som er grammatisk korrekte eller virker sammenhengende, selv om de er misvisende.

- Mangel på forståelse: Selv om disse modellene ser ut til å forstå menneskelig språk, opererer de først og fremst ved å identifisere mønstre og statistiske assosiasjoner i treningsdataene. De har ikke en dyp forståelse av innholdet de genererer, noe som noen ganger kan resultere i useriøse eller irrelevante utdata.

- Upassende innhold: Språkmodeller kan noen ganger generere innhold som er støtende, skadelig eller upassende. Selv om det gjøres anstrengelser for å minimere slikt innhold, kan det fortsatt oppstå på grunn av typen treningsdata og modellenes manglende evne til å skjelne kontekst eller brukerintensjon.

konklusjonen

Store språkmodeller har utvilsomt revolusjonert feltet for naturlig språkbehandling og vist et enormt potensial for å øke produktiviteten på tvers av ulike roller og bransjer. Deres evne til å generere menneskelignende tekst, automatisere hverdagslige oppgaver og gi assistanse i kreative og analytiske prosesser har gjort dem til uunnværlige verktøy i dagens fartsfylte, teknologidrevne verden.

Det er imidlertid avgjørende å erkjenne og forstå begrensningene og risikoene knyttet til disse kraftige modellene. Problemer som skjevhet, feilinformasjon og potensialet for ondsinnet bruk kan ikke ignoreres. Når vi fortsetter å integrere disse AI-drevne teknologiene i våre daglige liv, er det viktig å finne en balanse mellom å utnytte deres evner og sikre menneskelig tilsyn, spesielt i sensitive og høyrisikosituasjoner.

Hvis vi lykkes med å ta i bruk generative AI-teknologier på en ansvarlig måte, vil vi bane vei for en fremtid der kunstig intelligens og menneskelig ekspertise jobber sammen for å drive innovasjon og skape en bedre verden for alle.

Liker du denne artikkelen? Registrer deg for flere AI-forskningsoppdateringer.

Vi gir beskjed når vi gir ut flere sammendragsartikler som denne.

I slekt

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://www.topbots.com/top-language-models-transforming-ai-in-2023/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 1

- 10

- 12b

- 16

- 2%

- 2017

- 2021

- 2023

- 214

- 220

- 28

- 32

- 50

- 7

- 70

- 710

- 72

- 8

- 84

- 90

- a

- evne

- I stand

- Om oss

- ovenfor

- Absolute

- akademisk

- Aksepterer

- godtar

- adgang

- tilgjengelig

- imøtekomme

- Ifølge

- nøyaktighet

- nøyaktig

- oppnådd

- oppnår

- oppnå

- anerkjenne

- tvers

- Aktivering

- aktiveringer

- handlinger

- tilpasse

- tilpasning

- legge til

- legge

- tillegg

- Ytterligere

- adresse

- adresser

- vedta

- fremskritt

- råd

- Etter

- mot

- Agent

- AI

- ai forskning

- mål

- AL

- alike

- Alle

- tillate

- tillate

- tillater

- langs

- også

- alternativ

- Selv

- alltid

- blant

- blant

- beløp

- beløp

- an

- analyse

- Analytisk

- og

- En annen

- besvare

- noen

- api

- vises

- søknader

- Påfør

- tilnærming

- hensiktsmessig

- ca

- arkitektonisk

- arkitektur

- ER

- områder

- rundt

- Array

- Kunst

- Artikkel

- artikler

- kunstig

- kunstig intelligens

- AS

- Assistanse

- assistenter

- assosiert

- foreninger

- At

- oppmerksomhet

- forfattere

- automatisere

- tilgjengelig

- gjennomsnittlig

- unngå

- award

- Balansere

- Bar

- basen

- basert

- grunnleggende

- basis

- BE

- fordi

- bli

- før du

- være

- under

- benchmark

- benchmarks

- Fordeler

- Bedre

- mellom

- Bias

- skjevheter

- Milliarder

- bøker

- Bootstrap

- både

- grenser

- gjennombrudd

- gjennombrudd

- BRO

- bred

- bygge

- Bygning

- bygget

- men

- by

- som heter

- CAN

- kandidat

- kan ikke

- evner

- stand

- Kapasitet

- forsiktig

- saken

- katastrofal

- Årsak

- konsernsjef

- Administrerende direktør og grunnlegger

- utfordrende

- sjanse

- endring

- chatbots

- ChatGPT

- chips

- hevder

- klassifisering

- Cloud

- Med-grunnlegger

- kode

- SAMMENHENGENDE

- samling

- kombinasjon

- kombinasjoner

- Kom

- engasjement

- Kommunikasjon

- samfunnet

- sammenlignet

- kompatibel

- konkurranse

- utfyllende

- komplekse

- samsvar

- komponenter

- beregningen

- Beregn

- datamaskin

- databehandling

- konseptuelle

- bekymringer

- Konfigurasjon

- BEKREFTET

- Tilkobling

- Følgelig

- betraktninger

- konstruksjon

- innhold

- kontekst

- sammenhenger

- fortsette

- kontrast

- Samtale

- samtaler

- Konvertering

- korrigere

- Tilsvarende

- Kostnad

- Kostnader

- kunne

- skape

- opprettet

- Kreativ

- troverdig

- avgjørende

- Gjeldende

- kunde

- Kundeservice

- Kundeservice

- skjærekant

- daglig

- dato

- datapunkter

- datasett

- Dato

- besluttet

- redusere

- dyp

- DeepMind

- leverer

- demonstrere

- demonstrert

- demonstrerer

- demonstrere

- Demonstrasjoner

- avhengig

- utplasserings

- designet

- Til tross for

- detaljer

- utvikle

- utviklere

- utvikle

- Utvikling

- Dialog

- Dialog

- vanskelig

- funksjonshemminger

- Avsløre

- Diskriminering

- skille

- diverse

- do

- dokument

- dokumenter

- gjør

- dominans

- ikke

- dusin

- stasjonen

- dubbet

- to

- under

- e

- e-handel

- E&T

- hver enkelt

- Tidlig

- enklere

- pedagogisk

- effekt

- effektivt

- effektivitet

- effektiv

- innsats

- eliminert

- dukket

- muliggjøre

- muliggjør

- altomfattende

- engasjerende

- Engelsk

- forbedre

- forbedret

- forbedringer

- styrke

- sikrer

- avgjørende

- etablere

- etablerer

- etisk

- evaluert

- evaluering

- evalueringer

- Selv

- Hver

- alt

- bevis

- utvikling

- undersøkelse

- eksempel

- eksempler

- stiger

- eksepsjonell

- spennende

- utelukkende

- utstillinger

- eksisterende

- Expand

- eksperimenter

- ekspertise

- Utforske

- utvendig

- f1

- legge til rette

- faktorer

- Fall

- familie

- langt

- fascinerende

- Fartsfylt

- Trekk

- kjennetegnet

- Egenskaper

- tilbakemelding

- Noen få

- færre

- felt

- Figur

- filtrering

- Finn

- Først

- Fix

- fikset

- følge

- etter

- Til

- skjemaer

- Foundations

- Grunnleggeren

- Rammeverk

- fra

- frossen

- funksjon

- fundamental

- fundamentalt

- videre

- framtid

- fikk

- mellomrom

- Kjønn

- generere

- generert

- genererer

- genererer

- generasjonen

- generative

- Generativ AI

- generator

- få

- GitHub

- Glimpse

- Global

- Go

- mål

- skal

- god

- Googles

- Regjeringen

- GPU

- klasse

- banebrytende

- Gruppe

- HAD

- skjer

- Hard

- maskinvare

- skadelig

- Ha

- å ha

- helsetjenester

- her.

- høykvalitets

- høy oppløsning

- høy risiko

- høyere

- høyest

- holder

- Hvordan

- Men

- HTML

- HTTPS

- stort

- menneskelig

- Hundrevis

- Hype

- Innstilling av hyperparameter

- Tanken

- identifisering

- if

- bilde

- bilder

- enorme

- gjennomføring

- implementert

- implikasjoner

- viktig

- imponerende

- forbedre

- forbedret

- forbedring

- forbedringer

- in

- dyptgående

- manglende evne

- inkludere

- inkludert

- Inkludert

- Incorporated

- inkorporerer

- innlemme

- Øke

- økt

- økende

- stadig

- individuelt

- individer

- bransjer

- industri

- informasjon

- Infrastruktur

- Starter

- Innovasjon

- inngang

- innganger

- i stedet

- institusjoner

- instruksjoner

- integrere

- Intelligens

- hensikt

- interessant

- inn

- introdusere

- introdusert

- Oppfunnet

- utstedelse

- saker

- IT

- DET ER

- selv

- journalistikk

- jpg

- bare

- nøkkel

- sentrale mål

- Vet

- kunnskap

- Labs

- maling

- landskap

- Språk

- språk

- stor

- storskala

- største

- siste

- lag

- lag

- føre

- LÆRE

- læring

- Lovlig

- mindre

- Nivå

- nivåer

- Leverage

- utnytter

- utnytte

- Licensed

- Life

- lettvekt

- i likhet med

- Sannsynlig

- begrensninger

- Liste

- lister

- Bor

- Llama

- lokalt

- logisk

- Lang

- Se

- Lot

- Lav

- maskiner

- laget

- gjøre

- GJØR AT

- mange

- Marcus

- marked

- markedsundersøkelser

- Marketing

- materiale

- math

- max bredde

- maksimal

- Kan..

- meningsfylt

- Media

- medisinsk

- Flett

- Meta

- metodikk

- metoder

- Microsoft

- tankene

- minimal

- feil~~POS=TRUNC

- villedende

- feil

- blandet

- ML

- modell

- modeller

- Moderne

- modifisert

- overvåking

- mer

- mest

- mye

- flere

- Muslimer

- Naturlig

- Naturlig språk

- Natural Language Processing

- Natur

- Trenger

- nødvendig

- nettverk

- neural

- Nevral språk

- nevrale nettverket

- Ny

- nyheter

- neste

- fint

- nlp

- spesielt

- ingenting

- Antall

- mange

- Målet

- mål

- forekomme

- of

- støtende

- offisiell

- ofte

- on

- ONE

- seg

- bare

- åpen

- åpen kildekode

- OpenAI

- betjene

- Drift

- optimalisering

- or

- organisasjon

- Annen

- andre

- vår

- ut

- bedre ytelse enn i

- utkonkurrerer

- produksjon

- enestående

- enn

- egen

- palm

- Papir

- paradigmet

- parameter

- parametere

- del

- delta

- spesielt

- passere

- mønstre

- vraket

- asfaltering

- for

- utføre

- ytelse

- utfører

- utfører

- setninger

- plukke

- plato

- Platon Data Intelligence

- PlatonData

- pods

- Point

- poeng

- Politikk

- mulig

- potensiell

- powered

- kraftig

- forutsi

- trekkes

- forrige

- primært

- Før

- prioritering

- Problem

- problemer

- prosess

- Prosesser

- prosessering

- produsere

- Produkt

- produktivitet

- profesjonell

- Programmering

- programmerings språk

- Progress

- lovende

- egenskaper

- foreslår

- proprietær

- protokoller

- gi

- forutsatt

- gir

- offentlig

- publisert

- formål

- Skyver

- Python

- pytorch

- kvalitativ

- kvalitet

- spørsmål

- spørsmål

- raskt

- Race

- område

- raskt

- heller

- Lesning

- ekte

- ekte liv

- virkelige verden

- nylig

- nylig

- anerkjennelse

- gjenkjenne

- redusere

- redusere

- dietter

- forsterkning læring

- slipp

- utgitt

- relevant

- pålitelig

- pålitelige kilder

- religion

- avhengig

- forbli

- forble

- bemerkelsesverdig

- erstattet

- Rapporter

- representasjon

- forespørsler

- krever

- Krever

- forskning

- forskning fellesskap

- forskere

- ressurskrevende

- respekt

- svare

- svar

- svar

- begrenset

- resultere

- Resultater

- beholder

- Anmeldelser

- Revolusjonere

- revolusjon

- risikoer

- rivalisering

- robust

- roller

- rom

- trygge

- Sikkerhet

- Salesforce

- samme

- Skala

- vekter

- skalering

- scenarier

- Scener

- Skole

- Resultat

- score

- scoring

- sømløst

- Sekund

- synes

- sett

- valgt

- sensitive

- separat

- Serien

- alvorlig

- tjeneste

- Tjenester

- sett

- innstilling

- flere

- sjokkert

- Kort

- Vis

- viste

- Viser

- undertegne

- signifikant

- betydelig

- på samme måte

- entall

- situasjoner

- Størrelse

- ferdigheter

- mindre

- So

- så langt

- selskap

- sosiale medier

- Samfunnet

- Software

- programvareutvikling

- utelukkende

- løsning

- løser

- noen

- sofistikert

- kilde

- Kilder

- Sourcing

- spam

- spesifikk

- spesielt

- spesifisitet

- spektakulær

- tale-til-tekst

- fart

- Stabilitet

- Scene

- stadier

- Standard

- standarder

- Tilstand

- state-of-the-art

- statistisk

- statistikk

- Still

- Strategi

- styrker

- streik

- Studer

- betydelig

- lykkes

- slik

- foreslår

- foreslår

- SAMMENDRAG

- overlegen

- tilsyn

- støtte

- gått

- system

- Systemer

- Snakker

- Oppgave

- oppgaver

- lag

- Teknisk

- teknikker

- Technologies

- vilkår

- test

- tekstgenerering

- Tekst-til-tale

- enn

- Takk

- Det

- De

- Fremtiden

- Staten

- verden

- deres

- Dem

- deretter

- Der.

- derved

- derfor

- Disse

- de

- tror

- tredjeparts

- denne

- De

- selv om?

- tusener

- tre

- Gjennom

- ganger

- til

- dagens

- sammen

- token

- tokenization

- tokens

- også

- verktøy

- topp

- TOPPBOTS

- Tema

- temaer

- mot

- tradisjonelle

- Tog

- trent

- Kurs

- overføre

- transformator

- transformere

- Oversettelse

- Trillion

- Turing

- Veiledning

- to

- ubetinget

- etter

- forstå

- forståelse

- påta

- utvilsomt

- dessverre

- Universe

- I motsetning til

- up-to-date

- oppdateringer

- bruke

- brukt

- Bruker

- bruker

- ved hjelp av

- bruker

- variasjon

- ulike

- enorme

- allsidig

- veldig

- video

- videoer

- virtuelle

- syn

- VOX

- var

- Vei..

- we

- web

- VI VIL

- var

- Hva

- når

- hvilken

- mens

- HVEM

- hele

- bred

- Bred rekkevidde

- Wikipedia

- vil

- med

- innenfor

- uten

- ord

- Arbeid

- arbeide sammen

- verden

- skriving

- år

- ennå

- du

- zephyrnet

- Zero-Shot læring