Meta har gitt ut enda en slags åpen maskinlæringsmodell, denne gangen innstilt for å generere programvarekildekode.

Kode Lama er en familie av store språkmodeller – derav en og annen stor bokstav «LLaMA» – basert på Llama 2-modellen utgitt i juli. Den har blitt finjustert og opplært til å distribuere og diskutere kildekode som svar på tekstmeldinger, i stedet for prosa som dens stamfader.

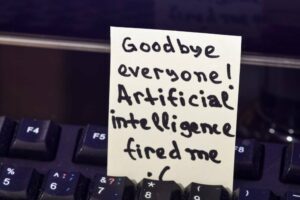

Som med all banebrytende teknologi, kommer Code Llama med risiko

"Code Llama har potensial til å bli brukt som et produktivitets- og pedagogisk verktøy for å hjelpe programmerere med å skrive mer robust, veldokumentert programvare," hevdet Meta i en kunngjøring Torsdag.

Hvis du ber Code Llama om å skrive en funksjon som produserer Fibonacci-sekvensen, vil modellen generere både kode og naturlig språk som forklarer kilden, sier Meta. Og AI-modellen kan gjøre det i Python, C++, Java, PHP, Typescript (Javascript), C#, Bash og andre språk.

Brukere blir imidlertid henvist til å adressere Code Llama på engelsk, da modellen ikke har blitt satt gjennom sikkerhetstesting på andre språk og kan bare si noe forferdelig hvis det blir spurt på en utenfor rekkevidde Språk.

"Som med all banebrytende teknologi, kommer Code Llama med risiko," forklarer Meta, og bemerker at under sitt eget røde team-testing for å be om opprettelse av ondsinnet kode, svarte Code Llama med sikrere svar enn ChatGPT (GPT3.5 Turbo).

I følge Meta utkonkurrerer Code Llama åpen kildekode, kodespesifikke LLM-er og sin egen overordnede Llama 2 på to benchmarks – HumanEval og for det meste grunnleggende Python-programmering (MBPP) – og matcher ytelsen til OpenAIs ChatGPT.

Code Llama kommer i tre størrelser – 7B, 13B og 34B parametere – og hver variant ble trent med 500B tokens med kode og koderelaterte data. Ett token er omtrent fire tegn på engelsk. Den største versjonen av OpenAIs Codex, da den ble utgitt, hadde 12B parametere.

De to minste Code Llama-modellene, sier Meta, har blitt opplært til å fylle inn manglende kilde som gjør at de kan brukes til kodefullføring uten ytterligere finjustering. 34B-versjonen sies å gi de beste resultatene, men de to minste reagerer raskere, noe som gjør dem bedre for oppgaver som kodefullføring der ventetiden er merkbar.

Det er også to varianter: Code Llama – Python, og Code Llama – Instruct. Førstnevnte kommer fra finjustering av Code Llama med en ekstra 100B tokens av Python-kode. Sistnevnte har blitt finjustert for å følge inn- og utgangsmønstre, noe som gjør den bedre egnet for kodegenerering.

Pålitelighet, noen?

LLM gir ofte feil svar til programmeringsprompter, selv om de likevel brukes av mange utviklere for å gjenkalle rote-mønstre og API-parametere, eller unngå søk og dokumentasjonssjekker.

Et av salgsargumentene til Code Llama er at den kan håndtere input og output av kodesekvenser som består av opptil 100,000 XNUMX tokens. Det vil si at du kan spørre modellen med mange linjer med kode, og du kan få et detaljert svar.

"Bortsett fra å være en forutsetning for å generere lengre programmer, låser det opp med lengre inngangssekvenser spennende nye bruksområder for en kode LLM," forklarte Meta. «Brukere kan for eksempel gi modellen mer kontekst fra kodebasen deres for å gjøre generasjonene mer relevante. Det hjelper også med å feilsøke scenarier i større kodebaser, der det kan være utfordrende for utviklere å holde seg på toppen av all kode relatert til et konkret problem."

Brukere kan gi modellen mer kontekst fra kodebasen deres for å gjøre generasjonene mer relevante

Code Llama slutter seg til et voksende felt av kodekyndige modeller som opprinnelig ble seedet av OpenAIs Codex og GitHubs tilknyttede rettstvist beheftet Copilot (2021) programmeringsforslagstjeneste. Programmeringspositive modeller som fulgte inkluderer DeepMinds Alfakode (2022), OpenAIs GPT-4 (2023), Amazon Code Whisperer (2023), og Googles Bard (2023), innstilt i april å generere kildekode.

I tillegg har det vært forskjellige åpen kildekode (eller slags åpne) LLM-er som StarCoder og XGen, for å nevne to.

Meta har gitt ut Code Llama under det samme fellesskapslisens som Llama 2, og siterer megaselskapets tro på "en åpen tilnærming til AI" som den beste måten å utvikle verktøy som er innovative, trygge og ansvarlige.

Men som det ble bemerket med Llama 2, er fellesskapslisensen ikke en åpen kildekode-lisens. Metas "åpne tilnærming" til AI er stengt for konkurranse - lisensen tillater eksplisitt bruk av programvaren "for å forbedre andre store språkmodeller."

Og mens Metas fellesskapslisens tillater kommersiell bruk av de forskjellige lamaene, trekker den grensen for tjenester med "større enn 700 millioner månedlige aktive brukere."

Det heller velg gruppe av megatjenester – YouTube, WeChat, TikTok, LinkedIn, Telegram, Snapchat og Douyin, blant sosiale medieplattformer som ikke allerede drives av Meta, og antagelig selskaper som kjører operativsystembaserte plattformer som Apple, Google og Microsoft – "må be om en lisens fra Meta, som Meta kan gi deg etter eget skjønn...” ®

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Bil / elbiler, Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- ChartPrime. Hev handelsspillet ditt med ChartPrime. Tilgang her.

- BlockOffsets. Modernisering av eierskap for miljøkompensasjon. Tilgang her.

- kilde: https://go.theregister.com/feed/www.theregister.com/2023/08/25/meta_lets_code_llama_run/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 000

- 100

- 2021

- 2022

- 2023

- 700

- a

- aktiv

- tillegg

- adresse

- overholde

- AI

- Alle

- tillater

- allerede

- også

- Amazon

- blant

- an

- og

- En annen

- svar

- noen

- noen

- api

- eple

- tilnærming

- April

- ER

- AS

- assosiert

- At

- unngå

- basert

- bash

- grunnleggende

- BE

- vært

- være

- tro

- benchmarks

- BEST

- Bedre

- både

- men

- by

- C + +

- CAN

- store bokstaver

- saker

- utfordrende

- tegn

- ChatGPT

- Sjekker

- hevdet

- stengt

- CO

- kode

- kodebase

- kommer

- kommersiell

- samfunnet

- Selskaper

- konkurranse

- ferdigstillelse

- kontekst

- skaperverket

- skjæring

- dato

- DeepMind

- utvikle

- utviklere

- gJORDE

- diskutere

- do

- dokumentasjon

- doujin

- trekker

- under

- hver enkelt

- Edge

- pedagogisk

- Engelsk

- Eter (ETH)

- eksempel

- spennende

- forklarte

- forklare

- forklarer

- ekstra

- familie

- raskere

- FB

- Fibonacci

- felt

- fyll

- slutt

- fulgt

- Til

- Tidligere

- fire

- fra

- funksjon

- videre

- generere

- genererer

- generasjonen

- generasjoner

- få

- GitHub

- innvilge

- større

- Økende

- HAD

- håndtere

- Ha

- å ha

- hjelpe

- hjelper

- derav

- Men

- HTTPS

- if

- forbedre

- in

- I andre

- inkludere

- i utgangspunktet

- innovative

- inngang

- i stedet

- utstedelse

- IT

- DET ER

- Java

- Javascript

- tiltrer

- jpg

- Juli

- bare

- Språk

- språk

- stor

- større

- største

- Ventetid

- læring

- Lar

- Tillatelse

- i likhet med

- linje

- linjer

- Llama

- lenger

- maskin

- maskinlæring

- gjøre

- Making

- mange

- Kan..

- Media

- Meta

- Microsoft

- kunne

- millioner

- mangler

- modell

- modeller

- månedlig

- mer

- for det meste

- må

- navn

- Naturlig

- Naturlig språk

- Ny

- bemerket

- merke seg

- sporadisk

- of

- ofte

- on

- ONE

- åpen

- åpen kildekode

- OpenAI

- drift

- or

- Annen

- utkonkurrerer

- produksjon

- egen

- parametere

- mønstre

- ytelse

- PHP

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- poeng

- potensiell

- produserer

- produktivitet

- stamfar

- programmerere

- Programmering

- programmer

- gi

- sette

- Python

- spørsmål

- heller

- RE

- Rød

- i slekt

- utgitt

- relevant

- anmode

- Svare

- svar

- ansvarlig

- Resultater

- Riot

- risikoer

- robust

- omtrent

- Kjør

- rennende

- s

- trygge

- sikrere

- Sikkerhet

- Sa

- samme

- sier

- sier

- scenarier

- Søk

- Å Sell

- Sequence

- tjeneste

- Tjenester

- størrelser

- mindre

- snapchat

- So

- selskap

- sosiale medier

- sosiale medieplattformer

- Software

- noe

- kilde

- kildekoden

- T

- oppgaver

- lag

- Teknologi

- Telegram

- vilkår

- Testing

- enn

- Det

- De

- Kilden

- deres

- Dem

- Der.

- de

- denne

- selv om?

- tre

- Gjennom

- Torsdag

- TikTok

- tid

- til

- token

- tokens

- verktøy

- verktøy

- topp

- trent

- to

- Loggfila

- etter

- låser opp

- bruke

- brukt

- Brukere

- ved hjelp av

- variant

- ulike

- versjon

- var

- Vei..

- når

- hvilken

- mens

- allment

- Wikipedia

- vil

- med

- uten

- skrive

- ennå

- du

- youtube

- zephyrnet