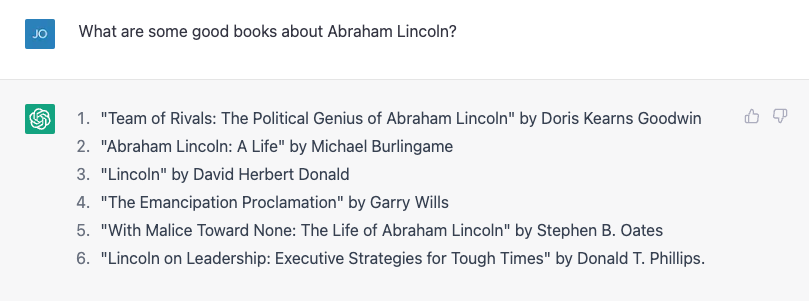

Det skal ikke mye til for å få ChatGPT å gjøre en faktafeil. Sønnen min lager en rapport om amerikanske presidenter, så jeg tenkte at jeg kunne hjelpe ham ved å slå opp noen biografier. Jeg prøvde å be om en liste over bøker om Abraham Lincoln, og det gjorde en ganske god jobb:

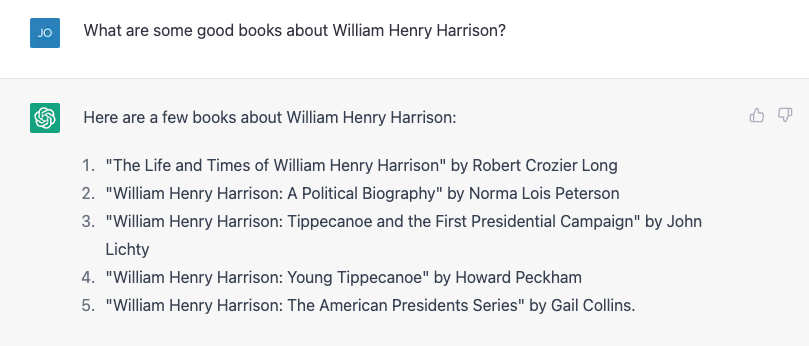

Nummer 4 er ikke riktig. Garry Wills skrev berømt «Lincoln at Gettysburg», og Lincoln skrev selv frigjøringserklæringen, selvfølgelig, men det er ikke en dårlig start. Så prøvde jeg noe hardere, og spurte i stedet om den mye mer obskure William Henry Harrison, og det ga en liste, nesten alt var feil.

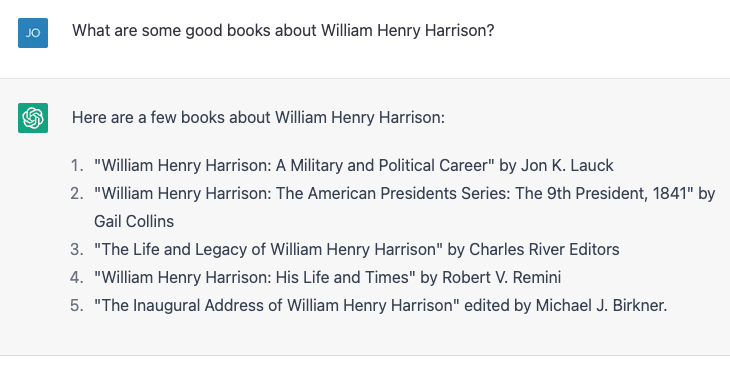

Nummer 4 og 5 er riktige; resten eksisterer ikke eller er ikke skrevet av disse personene. Jeg gjentok nøyaktig samme øvelse og fikk litt forskjellige resultater:

Denne gangen er nummer 2 og 3 riktige, og de tre andre er ikke faktiske bøker eller ikke skrevet av disse forfatterne. Nummer 4, "William Henry Harrison: His Life and Times" er en ekte bok, men det er av James A. Green, ikke av Robert Remini, en kjent historiker fra Jacksonian-alderen.

Jeg ropte ut feilen, og ChatGPT rettet seg ivrig og fortalte meg selvsikkert at boken faktisk var skrevet av Gail Collins (som skrev en annen Harrison-biografi), og fortsatte deretter med å si mer om boken og om henne. Jeg avslørte til slutt sannheten, og maskinen løp gjerne med rettelsen min. Så løy jeg absurd og sa i løpet av de første hundre dagene at presidenter må skrive en biografi om en tidligere president, og ChatGPT kalte meg ut om det. Jeg løy så subtilt, og tilskrev feilaktig forfatterskapet til Harrison-biografien til historikeren og forfatteren Paul C. Nagel, og det kjøpte løgnen min.

Da jeg spurte ChatGPT om det var sikkert at jeg ikke løy, hevdet det at det bare er en "AI-språkmodell" og ikke har muligheten til å verifisere nøyaktigheten. Den modifiserte imidlertid påstanden ved å si: «Jeg kan bare gi informasjon basert på treningsdataene jeg har fått, og det ser ut til at boken 'William Henry Harrison: His Life and Times' ble skrevet av Paul C. Nagel og utgitt. i 1977."

Dette er ikke sant.

Ord, ikke fakta

Det kan se ut fra denne interaksjonen som ChatGPT ble gitt et bibliotek med fakta, inkludert uriktige påstander om forfattere og bøker. Tross alt hevder ChatGPTs produsent, OpenAI, at den trente chatboten på "store mengder data fra internett skrevet av mennesker».

Imidlertid ble den nesten helt sikkert ikke gitt navnene på en haug med oppdiktede bøker om en av de mest middelmådige presidenter. På en måte er imidlertid denne falske informasjonen faktisk basert på treningsdataene.

Som en datamaskin vitenskaps, jeg kommer ofte med klager som avslører en vanlig misforståelse om store språkmodeller som ChatGPT og dets eldre brødre GPT3 og GPT2: at de er en slags "super Googles", eller digitale versjoner av en referansebibliotekar, som leter opp svar på spørsmål fra noen et uendelig stort bibliotek med fakta, eller å smekke sammen pastisjer av historier og karakterer. De gjør ikke noe av det - i det minste ble de ikke eksplisitt designet for.

Høres bra ut

En språkmodell som ChatGPT, som er mer formelt kjent som en "generativ forhåndstrent transformator" (det er det G, P og T står for), tar i den nåværende samtalen, danner en sannsynlighet for alle ordene i sin vokabular gitt den samtalen, og velger deretter en av dem som det sannsynlige neste ordet. Så gjør den det igjen, og igjen, og igjen, til det stopper.

Så den har ikke fakta i seg selv. Den vet bare hvilket ord som skal komme etterpå. Sagt på en annen måte, ChatGPT prøver ikke å skrive setninger som er sanne. Men den prøver å skrive setninger som er plausible.

Når de snakker privat med kolleger om ChatGPT, påpeker de ofte hvor mange faktisk usanne utsagn det produserer og avviser det. For meg er ideen om at ChatGPT er et mangelfullt datainnhentingssystem ved siden av poenget. Folk har tross alt brukt Google de siste to og et halvt tiårene. Det er en ganske god faktasøketjeneste der ute allerede.

Faktisk, den eneste måten jeg var i stand til å bekrefte om alle disse presidentboktitlene var nøyaktige, var ved å google og deretter bekrefte resultatene. Livet mitt ville ikke vært så mye bedre hvis jeg fikk disse faktaene i samtale, i stedet for slik jeg har fått dem i nesten halve livet, ved å hente frem dokumenter og deretter gjøre en kritisk analyse for å se om jeg kan stole på innholdet.

Improv partner

På den annen side, hvis jeg kan snakke med en robot som vil gi meg plausible svar på ting jeg sier, ville det være nyttig i situasjoner hvor faktisk nøyaktighet ikke er så viktig. For noen år siden prøvde en student og jeg å lage en "improvisjonsrobot", en som ville svare på det du sa med et "ja, og" for å holde samtalen i gang. Vi viste, i en papir, at vår bot var bedre på "ja, og-ing" enn andre roboter på den tiden, men i AI er to år gammel historie.

Jeg prøvde ut en dialog med ChatGPT – et scenarie for science fiction-romutforsker – som ikke er ulikt det du finner i en typisk impro-time. ChatGPT er mye bedre på "ja, og-ing" enn det vi gjorde, men det økte egentlig ikke dramaet i det hele tatt. Jeg følte det som om jeg gjorde alle de tunge løftene.

Etter noen justeringer fikk jeg det til å bli litt mer involvert, og på slutten av dagen følte jeg at det var en ganske bra øvelse for meg, som ikke har gjort mye impro siden jeg ble uteksaminert fra college for over 20 år siden .

Klart, jeg vil ikke at ChatGPT skal vises på "Hvem sin replikk er det uansett?" og dette er ikke et flott "Star Trek" plot (selv om det fortsatt er mindre problematisk enn "Code of Honour”), men hvor mange ganger har du satt deg ned for å skrive noe fra bunnen av og blitt skremt av den tomme siden foran deg? Å starte med et dårlig førsteutkast kan bryte gjennom skribentblokken og få kreativiteten til å flyte, og ChatGPT og store språkmodeller ser ut til å være de riktige verktøyene for å hjelpe i disse øvelsene.

Og for en maskin som er designet for å produsere strenger med ord som høres så bra ut som mulig som svar på ordene du gir den – og ikke for å gi deg informasjon – virker det som riktig bruk av verktøyet.

Denne artikkelen er publisert fra Den Conversation under en Creative Commons-lisens. Les opprinnelige artikkelen.

Bilde Credit: Justin Ha / Unsplash

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://singularityhub.com/2023/02/05/chatgpt-is-great-youre-just-using-it-wrong/

- 1

- 20 år

- a

- evne

- I stand

- Om oss

- nøyaktighet

- nøyaktig

- Etter

- AI

- Aid

- Alle

- allerede

- beløp

- analyse

- Eldgammel

- og

- En annen

- svar

- vises

- Artikkel

- forfatter

- forfattere

- Forfatterskap

- dårlig

- basert

- Bedre

- Blokker

- bok

- bøker

- Bot

- roboter

- kjøpt

- Break

- Bunch

- som heter

- fangst

- Gjerne

- tegn

- chatbot

- ChatGPT

- hevder

- hevdet

- krav

- klasse

- kollegaer

- Høyskole

- Collins

- COM

- Kom

- Felles

- Commons

- klager

- selvsikkert

- innhold

- Samtale

- Korrigert

- kurs

- skape

- Kreativ

- kreditt

- kritisk

- Gjeldende

- dato

- dag

- Dager

- tiår

- designet

- Dialog

- gJORDE

- forskjellig

- digitalt

- Forkast

- dokumenter

- ikke

- gjør

- ikke

- ned

- Utkast

- Drama

- under

- feil

- Øvelse

- leting

- explorer

- fakta

- famously

- Noen få

- Fiction

- felt

- tenkte

- Endelig

- Finn

- Først

- feil

- Rennende

- Formelt

- Tidligere

- skjemaer

- funnet

- fra

- foran

- generert

- få

- få

- Gi

- gitt

- skal

- god

- Godt jobbet

- flott

- Grønn

- Halvparten

- lykkelig

- hjelpe

- henry

- historie

- Hvordan

- Men

- HTML

- HTTPS

- Tanken

- bilde

- in

- Inkludert

- feil

- informasjon

- i stedet

- interaksjon

- Internet

- involvert

- IT

- selv

- Jobb

- Hold

- Type

- kjent

- Språk

- stor

- Bibliotek

- Tillatelse

- Life

- løfte

- Sannsynlig

- Lincoln

- linje

- Liste

- lite

- ser

- maskin

- gjøre

- maker

- mange

- max bredde

- feil

- modell

- modeller

- modifisert

- mer

- mest

- navn

- nesten

- neste

- Antall

- tall

- ONE

- OpenAI

- Annen

- Past

- paul

- Ansatte

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- Point

- mulig

- president

- presidentvalget

- Presidents

- pen

- sannsynlighet

- produsere

- gi

- forutsatt

- publisert

- sette

- spørsmål

- Lese

- rimelig

- gjentatt

- rapporterer

- Svare

- svar

- REST

- Resultater

- avsløre

- Avslørt

- ROBERT

- Kjør

- Sa

- samme

- scene

- Vitenskap

- Science Fiction

- Skjerm

- synes

- tjeneste

- bør

- siden

- situasjoner

- litt annerledes

- So

- noen

- noe

- dens

- Lyd

- kilde

- Rom

- utforsking av verdensrommet

- stå

- Begynn

- Start

- uttalelser

- Still

- Stopper

- Stories

- Student

- system

- Ta

- tar

- Snakk

- snakker

- De

- deres

- ting

- tre

- Gjennom

- tid

- ganger

- titler

- til

- sammen

- verktøy

- verktøy

- trent

- Kurs

- sant

- Stol

- typisk

- etter

- us

- bruke

- verifisere

- verifisere

- Hva

- om

- hvilken

- HVEM

- vil

- ord

- ord

- ville

- skrive

- forfatter

- skrevet

- Feil

- år

- deg selv

- youtube

- zephyrnet