Bilde av forfatter

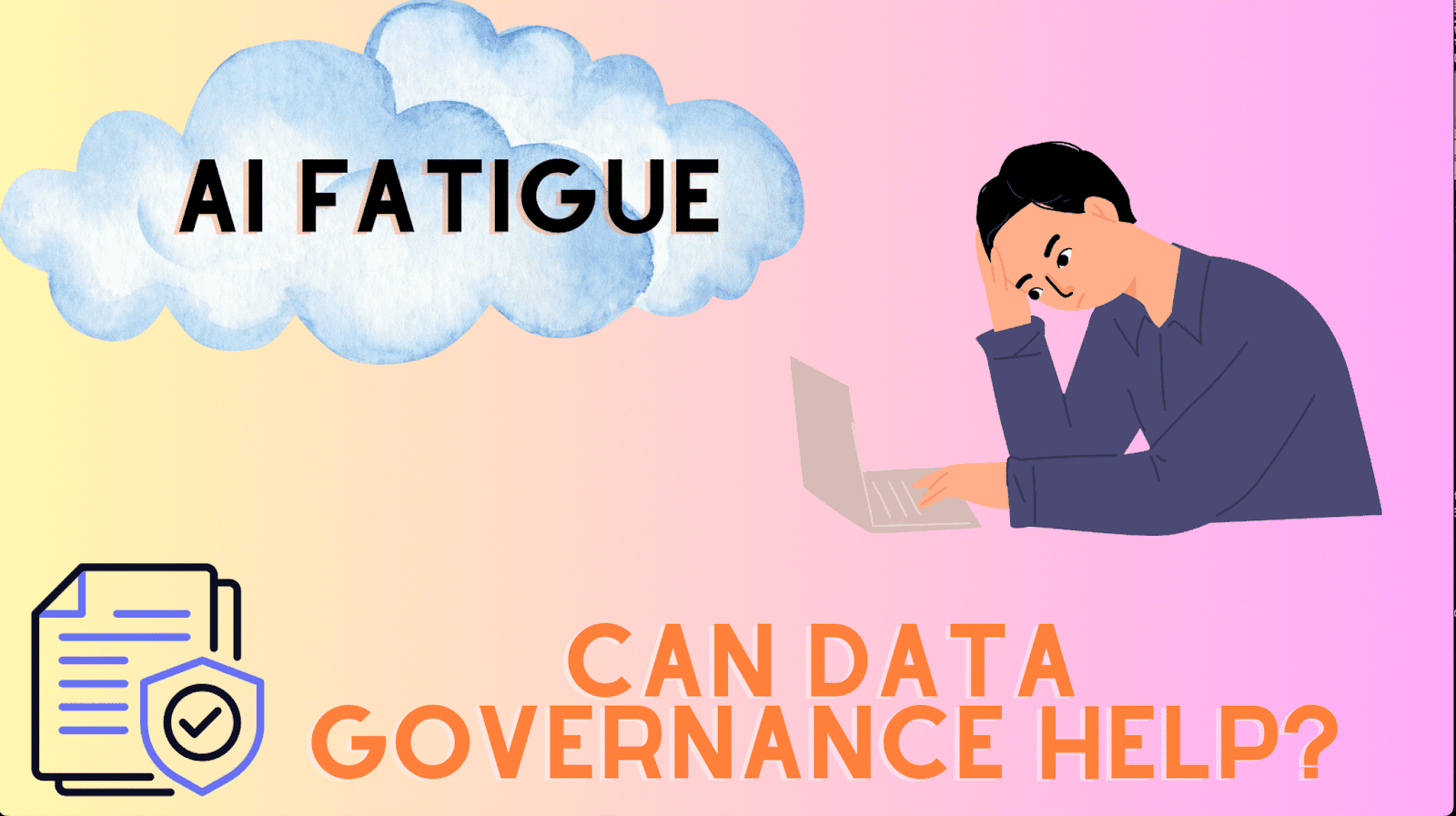

Data Governance og AI fatigue høres ut som to forskjellige konsepter, men det er en iboende sammenheng mellom de to. For å forstå det bedre, la oss starte med definisjonen deres.

Det har vært kjernefokuset i dataindustrien i lang tid.

Google sier det godt – «Datastyring er alt du gjør for å sikre at data er sikre, private, nøyaktige, tilgjengelige og brukbare. Det innebærer å sette interne standarder – datapolicyer – som gjelder hvordan data samles inn, lagres, behandles og kastes.»

Som denne definisjonen fremhever, handler datastyring om å administrere data – nettopp motoren som driver AI-modeller.

Nå som de første tegnene på koblingen mellom datastyring og AI har begynt å dukke opp, la oss relatere det til AI-tretthet. Selv om navnet gir det bort, sikrer det å fremheve årsakene som fører til slik tretthet konsekvent bruk av dette begrepet gjennom hele innlegget.

AI-tretthet setter inn på grunn av tilbakeslagene og utfordringene organisasjoner, utviklere eller team står overfor, noe som ofte fører til mislykket verdirealisering eller implementering av AI-systemer.

Det starter stort sett med urealistiske forventninger til hva AI er i stand til. For sofistikerte teknologier som AI, må sentrale interessenter tilpasse seg ikke bare egenskapene og mulighetene til AI, men også dens begrensninger og risikoer.

Når vi snakker om risiko, blir etikk ofte ansett som en ettertanke som fører til skroting av ikke-kompatible AI-initiativer.

Du må lure på hvilken rolle datastyring spiller for å forårsake AI-tretthet – premisset for dette innlegget.

Det er dit vi er på vei videre.

AI fatigue kan grovt sett kategoriseres som pre-distribusjon og post-distribusjon. La oss først fokusere på pre-distribusjon først.

Pre-distribusjon

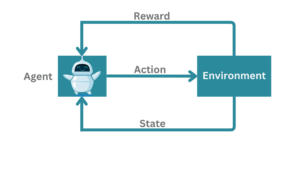

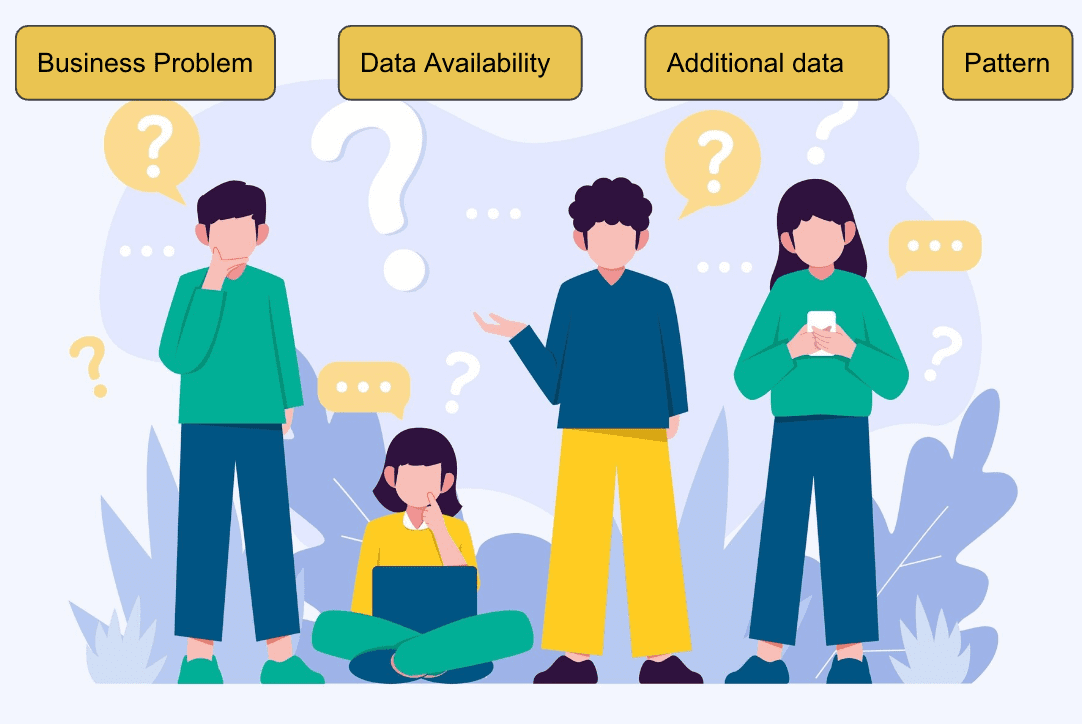

Ulike faktorer bidrar til å oppgradere en Proof of Concept (PoC) til distribusjon, for eksempel:

- Hva prøver vi å løse?

- Hvorfor er det et overbevisende problem å prioritere nå?

- Hvilke data er tilgjengelige?

- Er det ML-løselig i utgangspunktet?

- Har data et mønster?

- Kan fenomenet gjentas?

- Hvilke tilleggsdata vil løfte modellens ytelse?

Bilde fra Freepik

Når vi har evaluert at problemet best kan løses ved hjelp av ML-algoritmer, utfører datavitenskapsteamet en utforskende dataanalyse. Mange underliggende datamønstre avdekkes på dette stadiet, og fremhever om de gitte dataene er rike på signalet. Det hjelper også med å lage konstruerte funksjoner for å øke hastigheten på læringsprosessen til algoritmen.

Deretter bygger teamet den første grunnlinjemodellen, og finner ofte ut at den ikke presterer opp til det akseptable nivået. En modell hvis utgang er like god som en myntflipp gir ingen verdi. Dette er et av de første tilbakeslagene, også kjent som leksjoner, mens du bygger ML-modeller.

Organisasjoner kan flytte fra ett forretningsproblem til et annet, noe som forårsaker tretthet. Likevel, hvis de underliggende dataene ikke har et rikt signal, kan ingen AI-algoritme bygge på det. Modellen må lære de statistiske assosiasjonene fra treningsdataene for å generalisere på usett data.

Etter distribusjon

Til tross for at den trente modellen viser lovende resultater på valideringssettet, i tråd med de kvalifiserende forretningskriteriene, for eksempel 70 % presisjon, kan det fortsatt oppstå tretthet hvis modellen ikke klarer å yte tilstrekkelig i produksjonsmiljøet.

Denne typen AI-tretthet kalles post-distribusjonsfasen.

Utallige årsaker kan føre til dårligere ytelse, der dårlig datakvalitet er det vanligste problemet som plager modellen. Det begrenser modellens evne til nøyaktig å forutsi målresponsen i fravær av avgjørende attributter.

Tenk på når en av de essensielle funksjonene, som bare manglet 10 % i treningsdata, nå blir null 50 % av tiden i produksjonsdataene, noe som fører til feilaktige spådommer. Slike gjentakelser og anstrengelser for å sikre konsekvente modeller bygger tretthet hos dataforskerne og forretningsteamene, og svekker dermed tilliten til datarørledningene og risikerer investeringene som er gjort i prosjektet.

Robuste datastyringstiltak er avgjørende for å takle begge typer AI-tretthet. Gitt at dataene er kjernen i ML-modeller, er signalrike, feilfrie og høykvalitetsdata et must for å lykkes med et ML-prosjekt. Å håndtere AI-tretthet krever et sterkt fokus på datastyring. Så vi må jobbe strengt for å sikre riktig datakvalitet, legge grunnlaget for å bygge state-of-the-art modeller og levere pålitelig forretningsinnsikt.

Datakvalitet

Datakvalitet, nøkkelen til blomstrende datastyring, er en kritisk suksessfaktor for maskinlæringsalgoritmer. Organisasjoner må investere i datakvalitet, for eksempel å publisere rapporter til dataforbrukerne. I datavitenskapelige prosjekter, tenk på hva som skjer når data av dårlig kvalitet kommer til modellene, noe som kan føre til dårlig ytelse.

Bare under feilanalysen ville teamene få identifisert datakvalitetsbekymringene, som, når de sendes for å fikses oppstrøms, ender opp med å forårsake tretthet blant teamene.

Det er åpenbart ikke bare innsatsen som er brukt, men mye tid går tapt før de riktige dataene begynner å strømme inn.

Derfor anbefales det alltid å fikse dataproblemer ved kilden for å forhindre slike tidkrevende iterasjoner. Til slutt refererer de publiserte datakvalitetsrapportene til datavitenskapsteamet (eller, for den saks skyld, andre nedstrømsbrukere og dataforbrukere) med en forståelse av den akseptable kvaliteten på de innkommende dataene.

Uten datakvalitet og styringstiltak ville dataforskere blitt overbelastet med dataproblemer, noe som bidrar til mislykkede modeller som forårsaker AI-tretthet.

Innlegget fremhevet de to stadiene der AI-tretthet setter inn og presenterte hvordan datastyringstiltak som datakvalitetsrapporter kan være en muliggjører for å bygge pålitelige og robuste modeller.

Ved å etablere et solid grunnlag gjennom datastyring, kan organisasjoner bygge et veikart for vellykket og sømløs AI-utvikling og -adopsjon, og skape entusiasme.

For å sikre at innlegget gir en helhetlig oversikt over ulike måter å håndtere AI-tretthet på, legger jeg også vekt på organisasjonskulturens rolle, som, kombinert med andre beste praksiser som datastyring, vil gjøre datavitenskapsteam i stand til å bygge meningsfulle AI-bidrag raskere og raskere.

Vidhi Chugh er en AI-strateg og en digital transformasjonsleder som jobber i skjæringspunktet mellom produkt, vitenskap og ingeniørfag for å bygge skalerbare maskinlæringssystemer. Hun er en prisvinnende innovasjonsleder, en forfatter og en internasjonal foredragsholder. Hun er på et oppdrag for å demokratisere maskinlæring og bryte sjargongen for at alle skal være en del av denne transformasjonen.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.kdnuggets.com/can-data-governance-address-ai-fatigue?utm_source=rss&utm_medium=rss&utm_campaign=can-data-governance-address-ai-fatigue

- : har

- :er

- :ikke

- :hvor

- $OPP

- a

- evne

- Om oss

- akseptabelt

- nøyaktig

- nøyaktig

- Ytterligere

- adresse

- adressering

- Legger

- tilstrekkelig

- Adopsjon

- rådes

- AI

- AI-modeller

- AI-systemer

- aka

- algoritme

- algoritmer

- justere

- også

- alltid

- blant

- an

- analyse

- og

- En annen

- noen

- Påfør

- ER

- oppstår

- AS

- foreninger

- At

- attributter

- forfatter

- tilgjengelig

- Prisbelønte

- borte

- dårlig

- Baseline

- BE

- blir

- vært

- BEST

- beste praksis

- Bedre

- mellom

- både

- Break

- bredt

- bygge

- Bygning

- bygger

- virksomhet

- men

- by

- som heter

- CAN

- evner

- stand

- bære

- forårsaker

- utfordringer

- Coin

- kombinert

- Felles

- overbevisende

- konsept

- konsepter

- bekymringer

- selvtillit

- tilkobling

- ansett

- konsistent

- konsekvent

- Forbrukere

- bidra

- medvirkende

- bidragene

- Kjerne

- kunne

- skape

- kriterier

- kritisk

- avgjørende

- Kultur

- dato

- dataanalyse

- datakvalitet

- datavitenskap

- definisjon

- leverer

- demokrat

- distribusjon

- utviklere

- Utvikling

- forskjellig

- digitalt

- Digital Transformation

- do

- gjør

- kjøring

- to

- under

- innsats

- innsats

- dukke

- understreke

- bemyndige

- muliggjøre

- enabler

- slutt

- Motor

- konstruert

- Ingeniørarbeid

- sikre

- sikrer

- entusiasme

- Miljø

- feil

- avgjørende

- etablere

- Eter (ETH)

- etikk

- evaluert

- etter hvert

- alle

- alt

- forventninger

- Utforskende dataanalyse

- Face

- faktor

- faktorer

- mislykkes

- raskere

- tretthet

- Egenskaper

- finne

- Først

- Fix

- fikset

- Flip

- Fokus

- Til

- Fundament

- fra

- samlet

- få

- gitt

- gir

- god

- styresett

- grunnarbeid

- skjer

- Ha

- Overskrift

- hjelper

- høykvalitets

- Fremhevet

- utheving

- striper

- helhetlig

- Hvordan

- HTTPS

- i

- identifisere

- if

- gjennomføring

- in

- Innkommende

- industri

- initiativer

- Innovasjon

- innsikt

- intern

- internasjonalt

- kryss

- inn

- egenverdi

- Investere

- Investeringer

- innebærer

- utstedelse

- saker

- IT

- gjentakelser

- DET ER

- sjargong

- bare

- KDnuggets

- nøkkel

- legging

- føre

- leder

- ledende

- Fører

- LÆRE

- læring

- Lessons

- la

- Nivå

- i likhet med

- begrensninger

- grenser

- linje

- LINK

- Lang

- lang tid

- tapte

- Lot

- maskin

- maskinlæring

- laget

- gjøre

- GJØR AT

- administrerende

- mange

- Saken

- Kan..

- meningsfylt

- målinger

- medium

- mangler

- Oppdrag

- ML

- ML-algoritmer

- modell

- modeller

- mest

- for det meste

- flytte

- må

- navn

- Trenger

- neste

- Nei.

- nå

- of

- ofte

- on

- ONE

- bare

- or

- organisasjons

- organisasjoner

- Annen

- produksjon

- oversikt

- del

- Mønster

- mønstre

- utføre

- ytelse

- utfører

- utfører

- fase

- fenomen

- rør

- Sted

- plato

- Platon Data Intelligence

- PlatonData

- PoC

- dårlig

- muligheter

- Post

- praksis

- nettopp

- Precision

- forutsi

- Spådommer

- presentert

- forebygge

- Prioriter

- privat

- Problem

- prosess

- behandlet

- Produkt

- Produksjon

- prosjekt

- prosjekter

- lovende

- bevis

- proof of concept

- publisert

- Publisering

- setter

- kvalifiserende

- kvalitet

- kvalitetsdata

- realisering

- grunner

- repeterbar

- Rapporter

- Krever

- svar

- Resultater

- Rich

- ikke sant

- risikere

- risikoer

- veikart

- robust

- Rolle

- skalerbar

- Vitenskap

- VITENSKAPER

- forskere

- sømløs

- sikre

- sendt

- sett

- Tilbakeslag

- sett

- innstilling

- hun

- viser

- Signal

- Skilt

- So

- solid

- LØSE

- løst

- sofistikert

- Lyd

- kilde

- Høyttaler

- fart

- Scene

- stadier

- interessenter

- Begynn

- startet

- starter

- state-of-the-art

- statistisk

- Still

- lagret

- Strategist

- sterk

- suksess

- vellykket

- slik

- Systemer

- takling

- Target

- lag

- lag

- Technologies

- begrep

- Det

- De

- deres

- Der.

- derved

- tror

- denne

- selv om?

- blomstrende

- Gjennom

- hele

- tid

- tidkrevende

- til

- trent

- Kurs

- Transformation

- troverdig

- prøver

- to

- typen

- typer

- avdekket

- underliggende

- forstå

- forståelse

- til

- upon

- us

- bruk

- bruke

- Brukere

- ved hjelp av

- validering

- verdi

- var

- Vei..

- måter

- we

- VI VIL

- Hva

- når

- om

- hvilken

- mens

- hvem sin

- vil

- med

- lurer

- Arbeid

- arbeid

- ville

- du

- zephyrnet