Bilde av redaktør

Utbruddet av Graphical Processing Units (GPUer), og den eksponentielle datakraften de låser opp, har vært et vannskille for både startups og bedriftsbedrifter.

GPUer gir imponerende beregningskraft for å utføre komplekse oppgaver som involverer teknologi som AI, maskinlæring, og 3D-gjengivelse.

Men når det gjelder å utnytte denne overfloden av beregningskraft, står teknologiverdenen ved et veiskille når det gjelder den ideelle løsningen. Bør du bygge en dedikert GPU-maskin eller bruke GPU-skyen?

Denne artikkelen fordyper seg i hjertet av denne debatten, og dissekerer kostnadsimplikasjonene, ytelsesberegningene og skalerbarhetsfaktorene for hvert alternativ.

GPUer (Graphical Processing Units) er databrikker som er designet for raskt å gjengi grafikk og bilder ved å fullføre matematiske beregninger nesten umiddelbart. Historisk sett ble GPUer ofte assosiert med personlige spilldatamaskiner, men de brukes også i profesjonell databehandling, med fremskritt innen teknologi som krever ekstra datakraft.

GPU-er ble opprinnelig utviklet for å redusere arbeidsbelastningen som legges på CPU-en av moderne, grafikkintensive applikasjoner, som gjengir 2D- og 3D-grafikk ved hjelp av parallell prosessering, en metode som involverer flere prosessorer som håndterer forskjellige deler av en enkelt oppgave.

I næringslivet er denne metodikken effektiv til å akselerere arbeidsbelastninger og gi nok prosessorkraft til å muliggjøre prosjekter som kunstig intelligens (AI) og maskinlæring (ML)-modellering.

GPU-brukstilfeller

GPUer har utviklet seg de siste årene, og blitt mye mer programmerbare enn deres tidligere motparter, noe som gjør at de kan brukes i et bredt spekter av brukstilfeller, for eksempel:

- Rask gjengivelse av sanntids 2D- og 3D-grafiske applikasjoner, ved hjelp av programvare som Blender og ZBrush

- Videoredigering og oppretting av videoinnhold, spesielt stykker som er i 4k, 8k eller har høy bildefrekvens

- Gir den grafiske kraften til å vise videospill på moderne skjermer, inkludert 4k.

- Akselererende maskinlæringsmodeller, fra grunnleggende bildekonvertering til jpg å distribuere spesialtilpassede modeller med fullverdige frontends i løpet av få minutter

- Deling av CPU-arbeidsbelastninger for å levere høyere ytelse i en rekke applikasjoner

- Tilveiebringer beregningsressursene for å trene dype nevrale nettverk

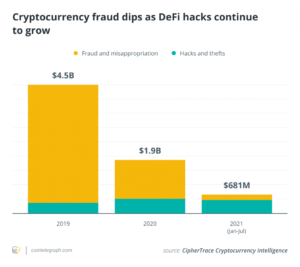

- Utvinning av kryptovalutaer som Bitcoin og Ethereum

Med fokus på utviklingen av nevrale nettverk, består hvert nettverk av noder som hver utfører beregninger som en del av en bredere analytisk modell.

GPUer kan forbedre ytelsen til disse modellene på tvers av et dypt læringsnettverk takket være den større parallelle behandlingen, og skaper modeller som har høyere feiltoleranse. Som et resultat er det nå mange GPUer på markedet som er bygget spesielt for dyplæringsprosjekter, slik som den nylig annonserte H200.

Mange bedrifter, spesielt startups, velger å bygge sine egne GPU-maskiner på grunn av deres kostnadseffektivitet, mens de fortsatt tilbyr den samme ytelsen som en GPU-skyløsning. Det er imidlertid ikke dermed sagt at et slikt prosjekt ikke kommer med utfordringer.

I denne delen vil vi diskutere fordeler og ulemper ved å bygge en GPU-maskin, inkludert forventede kostnader og administrasjon av maskinen som kan påvirke faktorer som sikkerhet og skalerbarhet.

Hvorfor bygge din egen GPU-maskin?

Den viktigste fordelen med å bygge en GPU-maskin på stedet er kostnadene, men et slikt prosjekt er ikke alltid mulig uten betydelig intern ekspertise. Løpende vedlikehold og fremtidige modifikasjoner er også hensyn som kan gjøre en slik løsning lite levedyktig. Men hvis en slik konstruksjon er innenfor teamets evner, eller hvis du har funnet en tredjepartsleverandør som kan levere prosjektet for deg, kan de økonomiske besparelsene være betydelige.

Det anbefales å bygge en skalerbar GPU-maskin for dyplæringsprosjekter, spesielt når man vurderer leiekostnadene til sky-GPU-tjenester som f.eks. Amazon Web Services EC2, Google Cloudeller Microsoft Azure. Selv om en administrert tjeneste kan være ideell for organisasjoner som ønsker å starte prosjektet så snart som mulig.

La oss vurdere de to hovedfordelene med en lokal, selvbyggende GPU-maskin, kostnad og ytelse.

Kostnader

Hvis en organisasjon utvikler et dypt nevralt nettverk med store datasett for kunstig intelligens og maskinlæringsprosjekter, kan driftskostnadene noen ganger skyte i været. Dette kan hindre utviklere i å levere de tiltenkte resultatene under modellopplæring og begrense skalerbarheten til prosjektet. Som et resultat kan de økonomiske implikasjonene resultere i et nedskalert produkt, eller til og med en modell som ikke er egnet til formålet.

Å bygge en GPU-maskin som er på stedet og selvstyrt kan bidra til å redusere kostnadene betraktelig, og gi utviklere og dataingeniører ressursene de trenger for omfattende iterasjon, testing og eksperimentering.

Dette skraper imidlertid bare i overflaten når det kommer til lokalt bygde og drevne GPU-maskiner, spesielt for åpen kildekode LLM-er, som blir stadig mer populære. Med bruken av faktiske brukergrensesnitt, kan du snart se din vennlige nabolagtannlege kjøre et par 4090s på bakrommet for ting som forsikringsverifisering, planlegging, datakryssreferanser og mye mer.

Ytelse

Omfattende dyplærings- og maskinlæringsmodeller/-algoritmer krever mye ressurser, noe som betyr at de trenger ekstremt høyytende prosesseringsevner. Det samme kan sies for organisasjoner som trenger å gjengi videoer av høy kvalitet, med ansatte som krever flere GPU-baserte systemer eller en toppmoderne GPU-server.

Selvbygde GPU-drevne systemer anbefales for produksjonsskala datamodeller og deres opplæring, med noen GPUer som kan gi dobbel presisjon, en funksjon som representerer tall som bruker 64 biter, som gir et større utvalg av verdier og bedre desimalpresisjon. Denne funksjonaliteten er imidlertid bare nødvendig for modeller som er avhengige av svært høy presisjon. Et anbefalt alternativ for et dobbelpresisjonssystem er Nvidias lokale Titan-baserte GPU-server.

Drift

Mange organisasjoner mangler ekspertisen og evnene til å administrere GPU-maskiner og servere på stedet. Dette er fordi et internt IT-team trenger eksperter som er i stand til å konfigurere GPU-basert infrastruktur for å oppnå det høyeste ytelsesnivået.

Videre kan mangelen på ekspertise hans føre til mangel på sikkerhet, noe som resulterer i sårbarheter som kan bli målrettet av nettkriminelle. Behovet for å skalere systemet i fremtiden kan også by på en utfordring.

GPU-maskiner på stedet gir klare fordeler når det gjelder ytelse og kostnadseffektivitet, men bare hvis organisasjoner har de nødvendige ekspertene internt. Dette er grunnen til at mange organisasjoner velger å bruke GPU-skytjenester, for eksempel Saturn Cloud som er fullt administrert for ekstra enkelhet og trygghet.

Cloud GPU-løsninger gjør dyplæringsprosjekter mer tilgjengelige for et bredere spekter av organisasjoner og bransjer, med mange systemer som kan matche ytelsesnivåene til selvbygde GPU-maskiner. Fremveksten av GPU-skyløsninger er en av hovedårsakene til at folk er det investere i AI-utvikling mer og mer, spesielt åpen kildekode-modeller som Mistral, hvis åpen kildekode-natur er skreddersydd for "utleiebare vRAM" og kjørende LLM-er uten å være avhengig av større leverandører, som OpenAI eller Anthropic.

Kostnader

Avhengig av behovene til organisasjonen eller modellen som trenes, a cloud GPU-løsning kan fungere billigere, forutsatt at timene det er nødvendig hver uke er rimelige. For mindre, mindre datatunge prosjekter er det sannsynligvis ikke nødvendig å investere i et kostbart par H100-er, med GPU-skyløsninger tilgjengelig på kontraktsbasis, så vel som i form av ulike månedlige planer, som passer til entusiasten alle veien til bedriften.

Ytelse

Det er en rekke CPU-skyalternativer som kan matche ytelsesnivåene til en DIY GPU-maskin, og gir optimalt balanserte prosessorer, nøyaktig minne, en høyytelsesdisk og åtte GPUer per instans for å håndtere individuelle arbeidsbelastninger. Selvfølgelig kan disse løsningene ha en kostnad, men organisasjoner kan ordne timefakturering for å sikre at de bare betaler for det de bruker.

Drift

Den viktigste fordelen med en sky-GPU fremfor en GPU-bygging er i driften, med et team av ekspertingeniører tilgjengelig for å hjelpe med eventuelle problemer og gi teknisk støtte. En lokal GPU-maskin eller server må administreres internt, ellers må et tredjepartsselskap administrere den eksternt, mot en ekstra kostnad.

Med en GPU-skytjeneste kan eventuelle problemer som nettverksbrudd, programvareoppdateringer, strømbrudd, utstyrsfeil eller utilstrekkelig diskplass løses raskt. Faktisk, med en fullstendig administrert løsning, er det usannsynlig at disse problemene oppstår i det hele tatt, da GPU-serveren vil være optimalt konfigurert for å unngå overbelastning og systemfeil. Dette betyr at IT-team kan fokusere på kjernebehovene til virksomheten.

Valget mellom å bygge en GPU-maskin eller bruke GPU-skyen avhenger av brukstilfellet, med store dataintensive prosjekter som krever ekstra ytelse uten å pådra seg betydelige kostnader. I dette scenariet kan et selvbygd system tilby den nødvendige ytelsen uten høye månedlige kostnader.

Alternativt, for organisasjoner som mangler intern ekspertise eller kanskje ikke krever toppytelse, kan en administrert sky GPU-løsning være å foretrekke, med maskinens administrasjon og vedlikehold ivaretatt av leverandøren.

Nahla Davies er programvareutvikler og teknologiskribent. Før hun viet arbeidet sitt på heltid til teknisk skriving, klarte hun – blant annet spennende – å fungere som hovedprogrammerer ved en Inc. 5,000 erfaringsbasert merkevareorganisasjon med kunder som Samsung, Time Warner, Netflix og Sony.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.kdnuggets.com/building-a-gpu-machine-vs-using-the-gpu-cloud?utm_source=rss&utm_medium=rss&utm_campaign=building-a-gpu-machine-vs-using-the-gpu-cloud

- : har

- :er

- :ikke

- 000

- 2D

- 3d

- 3D-gjengivelse

- 4k

- 8k

- a

- I stand

- overflod

- akselerer

- tilgjengelig

- nøyaktig

- Oppnå

- tvers

- faktiske

- la til

- Ytterligere

- fremskritt

- Fordel

- fordeler

- advent

- rådes

- AI

- algoritmer

- alike

- Alle

- tillate

- nesten

- også

- Selv

- alltid

- Amazon

- beløp

- an

- Analytisk

- og

- annonsert

- Antropisk

- noen

- søknader

- ER

- Array

- Artikkel

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- Kunstig intelligens og maskinlæring

- AS

- bistå

- assosiert

- At

- tilgjengelig

- unngå

- Balansert

- grunnleggende

- basis

- BE

- fordi

- bli

- vært

- før du

- være

- nytte

- Fordeler

- Bedre

- mellom

- fakturering

- Bitcoin

- bitcoin og ethereum

- Blender

- branding

- Breakdown

- bygge

- Bygning

- bygget

- virksomhet

- bedrifter

- men

- by

- CAN

- evner

- stand

- hvilken

- saken

- saker

- catering

- utfordre

- utfordringer

- billigere

- chips

- Velg

- fjerne

- klienter

- Cloud

- skytjenester

- CNBC

- COM

- Kom

- kommer

- kommer

- Selskapet

- fullført

- komplekse

- beregnings

- regnekraft

- datamaskin

- datamaskiner

- databehandling

- databehandlingskraft

- konfigurert

- konfigurering

- Ulemper

- Vurder

- betraktninger

- vurderer

- består

- innhold

- innholdsskaping

- kontraktsmessige

- Konvertering

- Kjerne

- Kostnad

- kostbar

- Kostnader

- kunne

- kolleger

- Par

- kurs

- prosessor

- Opprette

- skaperverket

- kryssreferanser

- Kryss

- cryptocurrencies

- nettkriminelle

- dato

- datasett

- debatt

- dedikert

- dyp

- dyp læring

- dype nevrale nettverk

- dype nevrale nettverk

- leverer

- levere

- avhengig

- avhenger

- utplasserings

- designet

- utviklet

- Utvikler

- utviklere

- utvikle

- Utvikling

- forskjellig

- diskutere

- Vise

- skjermer

- dIY

- gjør

- to

- under

- hver enkelt

- Tidligere

- redigering

- Effektiv

- veksten

- ansatte

- muliggjøre

- Ingeniører

- forbedre

- nok

- sikre

- Enterprise

- entusiast

- utstyr

- spesielt

- ethereum

- Selv

- utviklet seg

- forventet

- eksperimentelle

- Expert

- ekspertise

- eksperter

- eksponentiell

- omfattende

- ekstremt

- Faktisk

- faktorer

- Failure

- feil

- Trekk

- finansiell

- passer

- fikset

- Fokus

- Til

- For oppstart

- skjema

- funnet

- RAMME

- vennlig

- fra

- fullt

- fullverdig

- fullt

- funksjonalitet

- framtid

- Games

- gaming

- GPU

- GPU

- grafikk

- større

- Økende

- håndtere

- Håndtering

- Utnyttelse

- Ha

- Hjerte

- hjelpe

- her

- Høy

- høy ytelse

- høytytende

- høykvalitets

- høyere

- høyest

- hindre

- hans

- historisk

- TIMER

- Men

- HTML

- http

- HTTPS

- ideell

- if

- bilder

- Påvirkning

- implikasjoner

- imponerende

- in

- Inc.

- inkludere

- Inkludert

- individuelt

- bransjer

- Infrastruktur

- i utgangspunktet

- f.eks

- øyeblikkelig

- forsikring

- Intelligens

- tiltenkt

- inn

- fascinerende

- Investere

- involvere

- innebærer

- saker

- IT

- køyring

- DET ER

- KDnuggets

- nøkkel

- maling

- stor

- større

- føre

- læring

- mindre

- Nivå

- nivåer

- i likhet med

- BEGRENSE

- lokalt

- ser

- Lot

- maskin

- maskinlæring

- maskiner

- Hoved

- vedlikehold

- gjøre

- administrer

- fikk til

- ledelse

- mange

- marked

- Match

- matematiske

- Saken

- Kan..

- betyr

- midler

- Minne

- metode

- metodikk

- Metrics

- Microsoft

- kunne

- tankene

- ML

- modell

- modellering

- modeller

- Moderne

- modifikasjoner

- øyeblikk

- månedlig

- mer

- mye

- flere

- Natur

- Trenger

- nødvendig

- behov

- Netflix

- nettverk

- nettverk

- neural

- nevrale nettverket

- nevrale nettverk

- Nei.

- noder

- nå

- tall

- mange

- Nvidia

- forekomme

- of

- tilby

- tilby

- ofte

- on

- ONE

- pågående

- bare

- åpen kildekode

- OpenAI

- drift

- Drift

- Alternativ

- alternativer

- or

- organisasjon

- organisasjoner

- Annen

- ut

- brudd

- utfall

- enn

- egen

- par

- Parallel

- del

- deler

- Betale

- fred

- Ansatte

- for

- utføre

- ytelse

- personlig

- stykker

- plasseres

- planer

- plato

- Platon Data Intelligence

- PlatonData

- mulig

- makt

- Precision

- foret

- presentere

- sannsynligvis

- prosessering

- Behandlingseffekt

- prosessorer

- Produkt

- profesjonell

- programmerbar

- Programmerer

- prosjekt

- prosjekter

- PROS

- gi

- leverandør

- tilbydere

- gi

- formål

- raskt

- område

- raskt

- Sats

- sanntids

- rimelig

- grunner

- nylig

- nylig

- anbefales

- redusere

- avhengige

- eksternt

- gjengivelse

- krever

- påkrevd

- Ressurser

- resultere

- resulterende

- Kjør

- rennende

- Sa

- samme

- Samsung

- Saturn

- Besparelser

- sier

- skalerbarhet

- skalerbar

- Skala

- scenario

- planlegging

- Seksjon

- sikkerhet

- se

- betjene

- server

- servere

- tjeneste

- Tjenester

- hun

- bør

- signifikant

- enkelhet

- enkelt

- skyte i været

- mindre

- Software

- løsning

- Solutions

- noen

- noen ganger

- Sony

- Snart

- Rom

- spesielt

- står

- Begynn

- startups

- state-of-the-art

- Still

- slik

- støtte

- overflaten

- system

- Systemer

- tatt

- målrettet

- Oppgave

- oppgaver

- lag

- lag

- tech

- Teknisk

- teknisk støtte

- Teknologi

- vilkår

- Testing

- enn

- Takk

- Det

- De

- Fremtiden

- deres

- Dem

- deretter

- Der.

- Disse

- de

- ting

- tredjeparts

- denne

- tid

- til

- toleranse

- Tog

- trent

- Kurs

- to

- lomper

- usannsynlig

- låse opp

- oppdateringer

- bruke

- bruk sak

- brukt

- ved hjelp av

- bruke

- Verdier

- ulike

- leverandør

- veldig

- video

- videospill

- videoer

- vs

- Sikkerhetsproblemer

- Warner

- Vei..

- we

- web

- webtjenester

- uke

- VI VIL

- var

- Hva

- når

- hvilken

- mens

- HVEM

- hvem sin

- hvorfor

- bred

- Bred rekkevidde

- bredere

- vil

- med

- innenfor

- uten

- Arbeid

- trene

- verden

- ville

- forfatter

- skriving

- år

- du

- Din

- zephyrnet