Den raske veksten av generativ AI bringer lovende ny innovasjon, og reiser samtidig nye utfordringer. Disse utfordringene inkluderer noen som var vanlige før generativ AI, for eksempel skjevhet og forklarbarhet, og nye unike for foundation-modeller (FM), inkludert hallusinasjoner og toksisitet. Hos AWS er vi forpliktet til utvikle generativ AI på en ansvarlig måte, tar en menneskesentrisk tilnærming som prioriterer utdanning, vitenskap og våre kunder, for å integrere ansvarlig AI på tvers av ende-til-ende AI-livssyklusen.

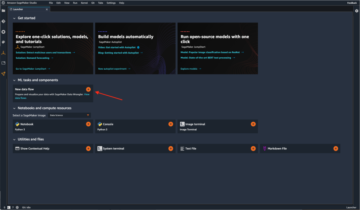

I løpet av det siste året har vi introdusert nye funksjoner i våre generative AI-applikasjoner og modeller som innebygd sikkerhetsskanning i Amazon Code Whisperer, opplæring for å oppdage og blokkere skadelig innhold Amazon Titan, og databeskyttelse i Amazonas grunnfjell. Vår investering i trygg, transparent og ansvarlig generativ AI inkluderer samarbeid med det globale samfunnet og beslutningstakere ettersom vi oppmuntret og støttet både Frivillige AI-forpliktelser i Det hvite hus og AI Safety Summit i Storbritannia. Og vi fortsetter å jobbe hånd i hånd med kunder for å operasjonalisere ansvarlig AI med spesialbygde verktøy som Amazon SageMaker Clarify, ML Governance med Amazon SageMaker, Og mer.

Introduserer ny ansvarlig AI-innovasjon

Når generativ AI skaleres til nye bransjer, organisasjoner og bruksområder, må denne veksten ledsages av en vedvarende investering i ansvarlig FM-utvikling. Kunder vil at FM-ene deres skal bygges med sikkerhet, rettferdighet og sikkerhet i tankene, slik at de igjen kan distribuere AI på en ansvarlig måte. På AWS re:Invent i år er vi glade for å kunngjøre nye evner for å fremme ansvarlig generativ AI-innovasjon på tvers av et bredt sett av funksjoner med nye innebygde verktøy, kundebeskyttelse, ressurser for å forbedre åpenhet og verktøy for å bekjempe desinformasjon. Vi tar sikte på å gi kundene den informasjonen de trenger for å evaluere FM-er mot viktige ansvarlige AI-hensyn, som toksisitet og robusthet, og introdusere rekkverk for å bruke sikkerhetstiltak basert på kundebrukstilfeller og ansvarlig AI-policy. Samtidig ønsker kundene våre å bli bedre informert om sikkerheten, rettferdigheten, sikkerheten og andre egenskaper til AI-tjenester og FM-er, ettersom de bruker dem i sin egen organisasjon. Vi er glade for å kunngjøre flere ressurser for å hjelpe kundene bedre å forstå våre AWS AI-tjenester og levere åpenheten de ber om.

Implementering av sikkerhetstiltak: Rekkverk for Amazon Bedrock

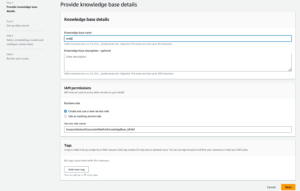

Sikkerhet er en prioritet når det gjelder å introdusere generativ AI i stor skala. Organisasjoner ønsker å fremme trygge interaksjoner mellom sine kunder og generative AI-applikasjoner som unngår skadelig eller støtende språk og er i tråd med selskapets retningslinjer. Den enkleste måten å gjøre det på er å sette på plass konsistente sikkerhetstiltak på tvers av hele organisasjonen slik at alle kan innovere trygt. I går annonserte vi forhåndsvisningen av Rekkverk for Amazon Bedrock—en ny funksjon som gjør det enkelt å implementere applikasjonsspesifikke sikkerhetstiltak basert på kundebrukstilfeller og ansvarlig AI-policy.

Guardrails gir konsistens i hvordan FM-er på Amazon Bedrock reagerer på uønsket og skadelig innhold i applikasjoner. Kunder kan bruke rekkverk på store språkmodeller på Amazon Bedrock samt på finjusterte modeller og i kombinasjon med Agenter for Amazon Bedrock. Guardrails lar deg spesifisere emner som skal unngås, og tjenesten oppdager og forhindrer automatisk spørsmål og svar som faller inn under begrensede kategorier. Kunder kan også konfigurere innholdsfilterterskler på tvers av kategorier, inkludert hatytringer, fornærmelser, seksualisert språk og vold for å filtrere ut skadelig innhold til ønsket nivå. For eksempel kan en nettbankapplikasjon settes opp for å unngå å gi investeringsråd og begrense upassende innhold (som hatytringer, fornærmelser og vold). I nær fremtid vil kunder også kunne redigere personlig identifiserbar informasjon (PII) i brukerinndata og FM-er sine svar, angi banningfiltre og gi en liste over tilpassede ord for å blokkere i interaksjoner mellom brukere og FM-er, forbedre overholdelse og ytterligere beskytte brukere. Med Guardrails kan du innovere raskere med generativ kunstig intelligens, samtidig som du opprettholder beskyttelser og sikkerhetstiltak i samsvar med selskapets retningslinjer.

Identifisere den beste FM-en for et spesifikt brukstilfelle: Model Evaluation in Amazon Bedrock

I dag har organisasjoner et bredt spekter av FM-alternativer for å drive sine generative AI-applikasjoner. For å finne den rette balansen mellom nøyaktighet og ytelse for deres brukstilfelle, må organisasjoner effektivt sammenligne modeller og finne det beste alternativet basert på viktige ansvarlige AI og kvalitetsmålinger som er viktige for dem. For å evaluere modeller, må organisasjoner først bruke dager på å identifisere benchmarks, sette opp evalueringsverktøy og kjøre vurderinger, alt dette krever dyp ekspertise innen datavitenskap. Dessuten er disse testene ikke nyttige for å evaluere subjektive kriterier (f.eks. merkestemme, relevans og stil) som krever vurdering gjennom kjedelige, tidkrevende arbeidsflyter for menneskelig vurdering. Tiden, ekspertisen og ressursene som kreves for disse evalueringene – for hver ny brukssituasjon – gjør det vanskelig for organisasjoner å evaluere modeller mot ansvarlige AI-dimensjoner og ta et informert valg rundt hvilken modell som vil gi kundene den mest nøyaktige og sikre opplevelsen.

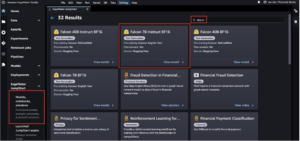

Nå tilgjengelig i forhåndsvisning, Modellevaluering på Amazonas grunnfjell hjelper kunder med å evaluere, sammenligne og velge de beste FM-ene for deres spesifikke brukssituasjon basert på tilpassede beregninger, for eksempel nøyaktighet og sikkerhet, ved å bruke enten automatiske eller menneskelige evalueringer. I Amazon Bedrock-konsollen velger kundene FM-ene de vil sammenligne for en gitt oppgave, for eksempel svar på spørsmål eller oppsummering av innhold. For automatiske evalueringer velger kunder forhåndsdefinerte evalueringskriterier (f.eks. nøyaktighet, robusthet og toksisitet) og laster opp sitt eget testdatasett eller velger fra innebygde, offentlig tilgjengelige datasett. For subjektive kriterier eller nyansert innhold som krever vurdering, kan kunder enkelt sette opp menneskebaserte evalueringsarbeidsflyter med bare noen få klikk. Disse arbeidsflytene utnytter en kundes interne arbeidsteam, eller bruker en administrert arbeidsstyrke levert av AWS, for å evaluere modellsvar. Under menneskebaserte evalueringer definerer kundene bruks-tilfellespesifikke beregninger (f.eks. relevans, stil og merkestemme). Når kundene er ferdige med oppsettprosessen, kjører Amazon Bedrock evalueringer og genererer en rapport, slik at kundene enkelt kan forstå hvordan modellen presterte på tvers av nøkkelkriterier for sikkerhet og nøyaktighet og velge den beste modellen for deres bruk.

Denne muligheten til å evaluere modeller er ikke begrenset til Amazon Bedrock, kunder kan også bruke modellevaluering i Amazon SageMaker Clarify for enkelt å evaluere, sammenligne og velge det beste FM-alternativet på tvers av nøkkelkvalitets- og ansvarsberegninger som nøyaktighet, robusthet og toksisitet – på tvers av alle FM-er.

Bekjempe desinformasjon: Vannmerking i Amazon Titan

I dag kunngjorde vi Amazon Titan Image Generator i forhåndsvisning, som gir kundene mulighet til raskt å produsere og forbedre bilder av høy kvalitet i stor skala. Vi vurderte ansvarlig AI under hvert trinn av modellutviklingsprosessen, inkludert opplæringsdatavalg, bygging av filtreringsevner for å oppdage og fjerne upassende brukerinndata og modellutdata, og forbedre demografisk mangfold av modellutdataene våre. Alle Amazon Titan-genererte bilder inneholder et usynlig vannmerke som standard, som er designet for å redusere spredningen av desinformasjon ved å tilby en diskret mekanisme for å identifisere AI-genererte bilder. AWS er blant de første modellleverandørene som i stor grad har frigitt innebygde usynlige vannmerker som er integrert i bildeutdata og er designet for å være motstandsdyktige mot endringer.

Bygge tillit: Står bak våre modeller og applikasjoner med erstatning

Å bygge kundetillit er kjernen i AWS. Vi har vært på en reise med kundene våre siden oppstarten, og med veksten av generativ AI er vi fortsatt forpliktet til å bygge innovativ teknologi sammen. For å gjøre det mulig for kunder å utnytte kraften i vår generative AI, må de vite at de er beskyttet. AWS tilbyr opphavsrettslig skadesløsholdelse for utganger av følgende Amazon generative AI-tjenester: Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazon Lexog Amazon Tilpasse. Dette betyr at kunder som bruker tjenestene på en ansvarlig måte, er beskyttet mot tredjeparts krav som påstår brudd på opphavsretten på grunn av utdataene generert av disse tjenestene (se avsnitt 50.10 i Vilkår for bruk). I tillegg beskytter vår standard IP-skadeserstatning for bruk av tjenestene kunder mot krav fra tredjeparter som påstår brudd på IP av tjenestene og dataene som brukes til å trene dem. For å si det på en annen måte, hvis du bruker en Amazon generativ AI-tjeneste som er oppført ovenfor og noen saksøker deg for brudd på IP, vil AWS forsvare det søksmålet, som inkluderer dekning av enhver dom mot deg eller forlikskostnader.

Vi står bak våre generative AI-tjenester og jobber for å kontinuerlig forbedre dem. Ettersom AWS lanserer nye tjenester og generativ AI fortsetter å utvikle seg, vil AWS fortsette å ubøyelig fokusere på å tjene og opprettholde kundenes tillit.

Forbedrer åpenheten: AWS AI Service Card for Amazon Titan Text

We introduserte AWS AI Service Cards på re:Invent 2022 som en åpenhetsressurs for å hjelpe kundene bedre å forstå AWS AI-tjenestene våre. AI Service Cards er en form for ansvarlig AI-dokumentasjon som gir kundene ett enkelt sted for å finne informasjon om tiltenkte brukstilfeller og begrensninger, ansvarlige AI-designvalg og beste praksiser for distribusjon og ytelsesoptimalisering for våre AI-tjenester. De er en del av en omfattende utviklingsprosess vi påtar oss for å bygge våre tjenester på en ansvarlig måte som tar for seg rettferdighet, forklarbarhet, sannhet og robusthet, styring, åpenhet, personvern og sikkerhet, sikkerhet og kontrollerbarhet.

På re:Invent i år annonserer vi en nytt AI-servicekort for Amazon Titan Text for å øke åpenheten i stiftelsesmodeller. Vi lanserer også fire nye AI-servicekort, inkludert: Amazon Comprehend Detect PII, Amazon Transkribering toksisitetsdeteksjon, Amazon Rekognition Face Livenessog AWS HealthScribe. Du kan utforske hvert av disse kortene på AWS nettsted. Ettersom generativ AI fortsetter å vokse og utvikle seg, vil åpenhet om hvordan teknologi utvikles, testes og brukes være en viktig komponent for å tjene tilliten til både organisasjoner og deres kunder. Hos AWS er vi forpliktet til å fortsette å bringe åpenhetsressurser som AI-tjenestekort til det bredere fellesskapet – og å gjenta og samle tilbakemeldinger om de beste veiene videre.

Investering i ansvarlig AI gjennom hele den generative AI-livssyklusen

Vi er begeistret over de nye innovasjonene annonsert på re:Invent denne uken som gir kundene våre flere verktøy, ressurser og innebygd beskyttelse for å bygge og bruke generativ AI på en sikker måte. Fra modellevaluering til rekkverk til vannmerking, kan kunder nå bringe generativ AI til organisasjonen sin raskere, samtidig som de reduserer risikoen. Ny beskyttelse for kunder som IP-skadeserstatning og nye ressurser for å øke åpenheten som ekstra AI-tjenestekort er også nøkkeleksempler på vår forpliktelse til å bygge tillit på tvers av teknologiselskaper, beslutningstakere, samfunnsgrupper, forskere og mer. Vi fortsetter å gjøre meningsfulle investeringer i ansvarlig AI gjennom livssyklusen til en grunnmodell – for å hjelpe kundene våre med å skalere AI på en trygg, sikker og ansvarlig måte.

Om forfatterne

Peter Hallinan leder initiativer innen vitenskapen og praksisen med ansvarlig AI ved AWS AI, sammen med et team av ansvarlige AI-eksperter. Han har dyp ekspertise innen AI (PhD, Harvard) og entreprenørskap (Blindsight, solgt til Amazon). Hans frivillige aktiviteter har inkludert å tjene som rådgivende professor ved Stanford University School of Medicine, og som president for American Chamber of Commerce på Madagaskar. Når det er mulig, er han på fjellet med barna sine: på ski, klatring, fotturer og rafting

Peter Hallinan leder initiativer innen vitenskapen og praksisen med ansvarlig AI ved AWS AI, sammen med et team av ansvarlige AI-eksperter. Han har dyp ekspertise innen AI (PhD, Harvard) og entreprenørskap (Blindsight, solgt til Amazon). Hans frivillige aktiviteter har inkludert å tjene som rådgivende professor ved Stanford University School of Medicine, og som president for American Chamber of Commerce på Madagaskar. Når det er mulig, er han på fjellet med barna sine: på ski, klatring, fotturer og rafting

Vasi Philomin er for tiden VP for Generative AI hos AWS. Han leder generativ AI-innsats inkludert Amazon Bedrock, Amazon Titan og Amazon CodeWhisperer.

Vasi Philomin er for tiden VP for Generative AI hos AWS. Han leder generativ AI-innsats inkludert Amazon Bedrock, Amazon Titan og Amazon CodeWhisperer.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- : har

- :er

- :ikke

- $OPP

- 10

- 100

- 125

- 2022

- 50

- a

- evne

- I stand

- Om oss

- ovenfor

- ledsaget

- nøyaktighet

- nøyaktig

- tvers

- Aktiviteter

- tillegg

- Ytterligere

- adresser

- råd

- mot

- AI

- AI-tjenester

- sikte

- justere

- alike

- Alle

- sammen

- også

- Amazon

- Amazon Code Whisperer

- Amazon SageMaker

- Amazon Web Services

- amerikansk

- blant

- an

- og

- Kunngjøre

- annonsert

- Kunngjøring

- En annen

- noen

- Søknad

- søknader

- Påfør

- tilnærming

- ER

- rundt

- AS

- spør

- vurderingene

- At

- Automatisk

- automatisk

- tilgjengelig

- unngå

- unngås

- AWS

- AWS re: Oppfinne

- Balansere

- Banking

- basert

- BE

- vært

- før du

- bak

- benchmarks

- BEST

- beste praksis

- Bedre

- mellom

- Bias

- Blokker

- både

- merke

- bringe

- Bringer

- bred

- bredere

- bygge

- bygge tillit

- Bygning

- bygget

- innebygd

- by

- CAN

- evner

- evne

- kort

- Kort

- saken

- saker

- kategorier

- utfordringer

- Chamber

- Barn

- valg

- valg

- Velg

- krav

- klatring

- samarbeid

- bekjempe

- kombinasjon

- kommer

- Handel

- engasjement

- forpliktet

- Felles

- samfunnet

- Selskaper

- Selskapet

- sammenligne

- samsvar

- komponent

- fatte

- omfattende

- betraktninger

- ansett

- konsistent

- Konsoll

- konsulent

- inneholde

- innhold

- kontinuerlig

- fortsette

- fortsetter

- fortsetter

- copyright

- brudd på opphavsretten

- Kjerne

- Kostnader

- dekning

- dekker

- kriterier

- I dag

- skikk

- kunde

- Kunder

- dato

- personvern

- datavitenskap

- datasett

- Dager

- dyp

- dyp ekspertise

- Misligholde

- definere

- leverer

- demografiske

- utplassere

- distribusjon

- utforming

- designet

- ønsket

- oppdage

- utviklet

- Utvikling

- vanskelig

- dimensjoner

- desinformasjon

- Mangfold

- do

- dokumentasjon

- stasjonen

- under

- e

- hver enkelt

- tjene

- tjene

- enkleste

- lett

- lett

- Kunnskap

- effektivt

- innsats

- enten

- bemyndiger

- muliggjøre

- oppfordret

- ende til ende

- forbedre

- Hele

- entreprenørskap

- Eter (ETH)

- evaluere

- evaluere

- evaluering

- evalueringer

- Hver

- alle

- utvikle seg

- eksempel

- eksempler

- opphisset

- erfaring

- ekspertise

- eksperter

- Forklarbarhet

- utforske

- ekspress

- Face

- rettferdighet

- Fall

- raskere

- tilbakemelding

- Noen få

- filtrere

- filtrering

- filtre

- Finn

- ferdig

- Først

- Fokus

- etter

- Til

- skjema

- Forward

- Foster

- Fundament

- fire

- fra

- videre

- Dess

- framtid

- samle

- generert

- genererer

- generative

- Generativ AI

- gitt

- gir

- Global

- styresett

- Gruppens

- Grow

- Vekst

- skadelig

- seletøy

- harvard

- hater

- hatmeldinger

- Ha

- he

- hjelpe

- hjelper

- høykvalitets

- vandreturer

- hans

- hus

- Hvordan

- HTTPS

- menneskelig

- identifisere

- identifisering

- if

- bilde

- bilder

- iverksette

- viktig

- forbedre

- bedre

- in

- begynnelse

- inkludere

- inkludert

- inkluderer

- Inkludert

- Øke

- bransjer

- informasjon

- informert

- overtredelse

- initiativer

- innovere

- Innovasjon

- innovasjoner

- innovative

- innovativ teknologi

- innganger

- integrere

- integrert

- tiltenkt

- interaksjoner

- inn

- introdusere

- introdusert

- innføre

- investering

- Investeringer

- usynlig

- IP

- IT

- reise

- jpg

- bare

- nøkkel

- Vet

- Språk

- stor

- lanseringer

- lansere

- Søksmålet

- Fører

- Lar

- Nivå

- Leverage

- Livssyklus

- i likhet med

- BEGRENSE

- begrensninger

- Begrenset

- Liste

- oppført

- opprettholde

- gjøre

- GJØR AT

- fikk til

- meningsfylt

- midler

- mekanisme

- medisin

- Metrics

- tankene

- formildende

- modell

- modeller

- mer

- mest

- må

- Nær

- Trenger

- Ny

- nå

- of

- off

- støtende

- Tilbud

- on

- gang

- seg

- på nett

- nettbank

- optimalisering

- Alternativ

- alternativer

- or

- organisasjon

- organisasjoner

- Annen

- vår

- ut

- utganger

- egen

- del

- Past

- ytelse

- utført

- personlig

- phd

- PII

- Sted

- plato

- Platon Data Intelligence

- PlatonData

- Politikk

- beslutningstakere

- mulig

- makt

- praksis

- praksis

- president

- forhindrer

- Forhåndsvisning

- prioriterer

- prioritet

- privatliv

- Personvern og sikkerhet

- prosess

- produsere

- Banning

- profesjonell

- Professor

- lovende

- fremme

- egenskaper

- beskyttet

- beskytte

- beskytter

- gi

- forutsatt

- tilbydere

- gi

- offentlig

- sette

- kvalitet

- spørsmål

- hever

- område

- rask

- raskt

- RE

- redusere

- slipp

- relevans

- forbli

- fjerne

- rapporterer

- påkrevd

- Krever

- motstandsdyktig

- ressurs

- Ressurser

- Svare

- svar

- ansvar

- ansvarlig

- ansvarlig

- begrenset

- ikke sant

- Risiko

- robusthet

- rennende

- går

- trygge

- sikringstiltak

- trygt

- Sikkerhet

- sagemaker

- samme

- Skala

- skala ai

- vekter

- skanning

- Skole

- Vitenskap

- forskere

- Seksjon

- sikre

- sikkerhet

- se

- velg

- utvalg

- tjeneste

- Tjenester

- servering

- sett

- innstilling

- bosetting

- oppsett

- siden

- enkelt

- So

- solgt

- noen

- Noen

- spesifikk

- tale

- bruke

- spre

- Scene

- stå

- Standard

- stående

- stanford

- Stanford University

- streik

- stil

- slik

- Saksøke

- Støttes

- vedvarende

- ta

- Oppgave

- lag

- Teknologi

- teknologiselskaper

- testet

- Testing

- tester

- tekst

- Det

- De

- informasjonen

- Storbritannia

- deres

- Dem

- Disse

- de

- tredjeparts

- denne

- denne uka

- dette året

- De

- Gjennom

- tid

- titan

- til

- sammen

- verktøy

- temaer

- Tog

- Kurs

- Åpenhet

- gjennomsiktig

- Stol

- SVING

- Uk

- forstå

- påta

- unik

- universitet

- bruke

- bruk sak

- brukt

- Bruker

- Brukere

- ved hjelp av

- vital

- Voice

- frivillig

- frivillig

- vp

- ønsker

- vannmerke

- Vannmerking

- vannmerker

- Vei..

- måter

- we

- web

- webtjenester

- Nettsted

- uke

- VI VIL

- var

- Hva

- når

- hvilken

- mens

- HVEM

- hele

- bred

- Bred rekkevidde

- allment

- vil

- med

- innenfor

- ord

- Arbeid

- arbeidsflyt

- arbeidsstyrke

- år

- i går

- du

- zephyrnet