Bilde av forfatter

Denne artikkelen vil diskutere 7-AI-drevne verktøy som kan hjelpe deg med å øke produktiviteten din som dataforsker. Disse verktøyene kan hjelpe deg med å automatisere oppgavene som datarensing og funksjonsvalg, modellinnstilling osv., som direkte eller indirekte gjør arbeidet ditt mer effektivt, nøyaktig og effektivt og hjelper også til å ta bedre beslutninger.

Mange av dem har brukervennlige brukergrensesnitt og er veldig enkle å bruke. Samtidig lar noen dataforskere dele og samarbeide om prosjekter med andre medlemmer, noe som bidrar til å øke produktiviteten til teamene.

DataRobot er en nettbasert plattform som hjelper deg med å automatisere bygging, distribusjon og vedlikehold av maskinlæringsmodeller. Den støtter mange funksjoner og teknikker som dyp læring, ensemblelæring og tidsserieanalyse. Den bruker avanserte algoritmer og teknikker som hjelper til med å bygge modeller raskt og nøyaktig, og gir også funksjoner for å vedlikeholde og overvåke den distribuerte modellen.

Bilde av DataRobot

Det lar også dataforskere dele og samarbeide om prosjekter med andre, noe som gjør det lettere å jobbe som et team på komplekse prosjekter.

H20.ai er en åpen kildekode-plattform som tilbyr profesjonelle verktøy for dataforskere. Hovedfunksjonen er Automated Machine Learning (AutoML) som automatiserer prosessen med å bygge og justere maskinlæringsmodellene. Det inkluderer også algoritmer som gradientforsterkning, tilfeldige skoger, etc.

Som en åpen kildekode-plattform kan dataforskere tilpasse kildekoden i henhold til deres behov, slik at de kan passe den inn i deres eksisterende systemer.

Bilde av H20.ai

Den bruker et versjonskontrollsystem som holder styr på alle endringer og modifikasjoner som er presset inn i koden. H2O.ai kan også kjøre på sky- og edge-enheter og støtter et stort og aktivt fellesskap av brukere og utviklere som bidrar til plattformen.

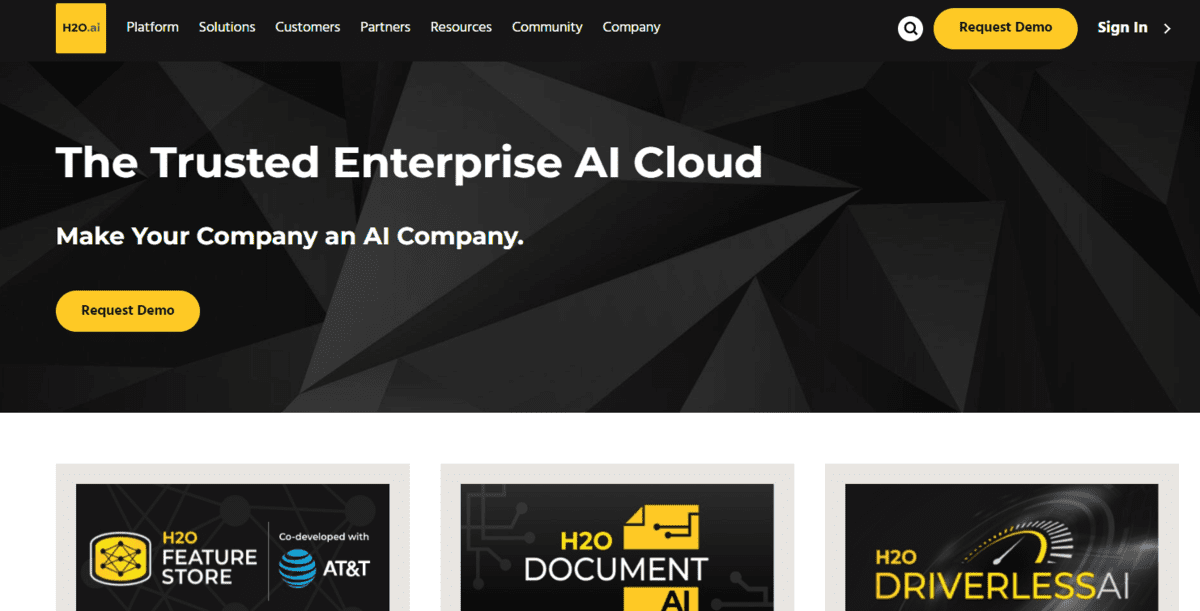

Big Panda brukes til å automatisere hendelseshåndtering og avviksdeteksjon i IT-drift. Enkelt sagt er anomalideteksjon å identifisere mønstre, hendelser eller observasjoner i et datasett som avviker betydelig fra forventet atferd. Den brukes til å identifisere uvanlige eller unormale datapunkter som kan indikere et problem.

Den bruker ulike AI- og ML-teknikker for å analysere loggdata og identifisere potensielle problemer. Den kan automatisk løse hendelser og redusere behovet for manuell intervensjon.

Bilde av Stor Panda

Big Panda kan overvåke systemer i sanntid, noe som kan bidra til å identifisere og løse problemer raskt. Det kan også bidra til å identifisere årsaken til hendelser, gjøre det enklere å løse problemer og forhindre at de skjer igjen.

HuggingFace brukes til naturlig språkbehandling (NLP) og gir forhåndstrente modeller, slik at dataforskere kan implementere NLP-oppgaver raskt. Den utfører mange funksjoner som tekstklassifisering, navngitt enhetsgjenkjenning, svar på spørsmål og språkoversettelse. Det gir også muligheten til å finjustere de forhåndstrente modellene på spesifikke oppgaver og datasett, noe som gjør det mulig å forbedre ytelsen.

De ferdigtrente modellene har oppnådd toppmoderne ytelse på ulike benchmarks fordi de er trent på store datamengder. Dette kan spare dataforskere for tid og ressurser ved å la dem bygge modeller raskt uten å trene dem fra bunnen av.

Bilde av Klemme ansiktet

Plattformen lar også dataforskere finjustere de forhåndstrente modellene på spesifikke oppgaver og datasett, noe som kan forbedre ytelsen til modellene. Dette kan gjøres ved hjelp av et enkelt API, som gjør det enkelt å bruke selv for de med begrenset NLP-erfaring.

CatBoost-biblioteket brukes til gradientforsterkende oppgaver og er spesielt designet for håndtering av kategoriske data. Den oppnår state-of-the-art ytelse på mange datasett og støtter raskere modelltreningsprosessen på grunn av parallelle GPU-beregninger.

Bilde av CatBoost

CatBoost er mest stabil og robust mot overtilpasning og støy i dataene, noe som kan forbedre generaliseringsevnen til modellene. Den bruker en algoritme kalt "ordret boosting" for å iterativt fylle ut manglende verdier før du foretar en prediksjon.

CatBoost gir funksjonsviktighet, som kan hjelpe dataforskere med å forstå hver funksjons bidrag til modellspådommene.

Optuna er også et åpen kildekode-bibliotek som hovedsakelig brukes til justering og optimalisering av hyperparameter. Dette hjelper dataforskere med å finne de beste parameterne for deres maskinlæringsmodeller. Den bruker en teknikk kalt "Bayesian optimization" som automatisk kan søke etter de optimale hyperparametrene for en gitt modell.

Bilde av Optuna

Den andre hovedfunksjonen er at den enkelt kan integreres med forskjellige maskinlæringsrammer og biblioteker som TensorFlow, PyTorch og scikit-learn. Den kan også utføre samtidige optimaliseringer av flere mål, noe som gir en god avveining mellom ytelse og andre beregninger.

Det er en plattform for å tilby forhåndsopplærte modeller designet for å gjøre det enkelt for utviklere å integrere disse modellene i sine eksisterende applikasjoner eller tjenester.

Det gir også ulike APIer som tale-til-tekst eller naturlig språkbehandling. Tale-til-tekst API brukes til å hente teksten fra lyd- eller videofiler med høy nøyaktighet. Det naturlige språk-APIet kan også hjelpe til med å behandle oppgaver som sentimentanalyse, bildeenhetsgjenkjenning, tekstoppsummering, etc.

Bilde av AssemblyAI

Trening av en maskinlæringsmodell inkluderer datainnsamling og forberedelse, utforskende dataanalyse, funksjonsteknikk, modellvalg og opplæring, modellevaluering og til slutt modelldistribusjon. For å utføre alle oppgavene trenger du kunnskapen om de ulike verktøyene og kommandoene som er involvert. Disse syv verktøyene kan hjelpe deg med å trene og distribuere modellen din med minimal innsats.

Avslutningsvis håper jeg du har likt denne artikkelen og funnet den informativ. Hvis du har forslag eller tilbakemeldinger, vennligst kontakt meg via Linkedin.

Ariske Garg er en B.Tech. Elektroingeniørstudent, går for tiden siste året av undergraden. Hans interesse ligger innen webutvikling og maskinlæring. Han har fulgt denne interessen og er ivrig etter å jobbe mer i disse retningene.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://www.kdnuggets.com/2023/02/7-aipowered-tools-enhance-productivity-data-scientists.html?utm_source=rss&utm_medium=rss&utm_campaign=7-ai-powered-tools-to-enhance-productivity-for-data-scientists

- 7

- a

- evne

- Ifølge

- nøyaktighet

- nøyaktig

- nøyaktig

- oppnådd

- oppnår

- aktiv

- avansert

- AI

- AI-drevet

- algoritme

- algoritmer

- Alle

- tillate

- tillater

- beløp

- analyse

- analysere

- og

- anomali påvisning

- api

- APIer

- søknader

- Artikkel

- lyd

- automatisere

- Automatisert

- automatisert maskinlæring

- automatiserer

- automatisk

- Automatisere

- AutoML

- Bayesiansk

- fordi

- før du

- benchmarks

- BEST

- Bedre

- mellom

- øke

- øke

- bygge

- Bygning

- som heter

- Årsak

- Endringer

- klassifisering

- Rengjøring

- Cloud

- kode

- samarbeide

- samling

- samfunnet

- komplekse

- beregninger

- konklusjon

- bidra

- bidrag

- kontroll

- I dag

- tilpasse

- dato

- dataanalyse

- datapunkter

- dataforsker

- DataRobot

- datasett

- avgjørelser

- dyp

- dyp læring

- utplassere

- utplassert

- utplasserings

- distribusjon

- designet

- Gjenkjenning

- utviklere

- Utvikling

- Enheter

- direkte

- diskutere

- hver enkelt

- enklere

- lett

- Edge

- Effektiv

- effektiv

- innsats

- elektroteknikk

- Ingeniørarbeid

- enhet

- etc

- evaluering

- Selv

- hendelser

- eksisterende

- forventet

- erfaring

- Utforskende dataanalyse

- Trekk

- Egenskaper

- tilbakemelding

- felt

- Filer

- fyll

- slutt~~POS=TRUNC

- Endelig

- Finn

- passer

- funnet

- rammer

- fra

- funksjoner

- få

- gitt

- gir

- god

- GPU

- Håndtering

- hjelpe

- hjelper

- Høy

- håp

- HTTPS

- Innstilling av hyperparameter

- identifisere

- identifisering

- iverksette

- betydning

- forbedre

- in

- hendelse

- inkluderer

- økende

- indikerer

- indirekte

- informative

- integrere

- integrert

- interesse

- intervensjon

- involvert

- saker

- IT

- KDnuggets

- Språk

- stor

- læring

- bibliotekene

- Bibliotek

- Begrenset

- maskin

- maskinlæring

- Hoved

- Hovedfunksjon

- vedlikeholde

- gjøre

- GJØR AT

- Making

- ledelse

- håndbok

- mange

- medlemmer

- Metrics

- minimum

- mangler

- ML

- ML teknikker

- modell

- modeller

- modifikasjoner

- Overvåke

- mer

- mer effektivt

- mest

- flere

- oppkalt

- Naturlig

- Naturlig språk

- Natural Language Processing

- Trenger

- behov

- nlp

- Bråk

- mål

- åpen kildekode

- Drift

- optimal

- optimalisering

- Annen

- andre

- Parallel

- parametere

- mønstre

- utføre

- ytelse

- utfører

- plattform

- plato

- Platon Data Intelligence

- PlatonData

- vær så snill

- poeng

- potensiell

- powered

- prediksjon

- Spådommer

- hindre

- Problem

- problemer

- prosess

- prosessering

- produktivitet

- profesjonell

- prosjekter

- gir

- gi

- presset

- pytorch

- spørsmål

- raskt

- tilfeldig

- å nå

- sanntids

- anerkjennelse

- redusere

- løse

- Ressurser

- robust

- root

- Kjør

- samme

- Spar

- Forsker

- forskere

- scikit lære

- Søk

- utvalg

- sentiment

- Serien

- Tjenester

- syv

- Del

- betydelig

- Enkelt

- samtidig

- So

- noen

- kilde

- kildekoden

- spesifikk

- spesielt

- tale-til-tekst

- stabil

- state-of-the-art

- Student

- Støtter

- system

- Systemer

- oppgaver

- lag

- lag

- tech

- teknikker

- tensorflow

- vilkår

- Tekstklassifisering

- De

- Kilden

- deres

- tid

- Tidsserier

- til

- verktøy

- spor

- Tog

- trent

- Kurs

- Oversettelse

- forstå

- uvanlig

- bruke

- brukervennlig

- Brukere

- Verdier

- ulike

- versjon

- versjonskontroll

- av

- video

- web

- Webutvikling

- Web-basert

- hvilken

- HVEM

- vil

- uten

- Arbeid

- år

- Din

- zephyrnet