6 kule Python -biblioteker som jeg kom over nylig

Sjekk ut disse fantastiske Python-bibliotekene for maskinlæring.

By Dhilip Subramanian, Data Scientist og AI Enthusiast

Python er en integrert del av maskinlæring og biblioteker gjør livet vårt enklere. Nylig kom jeg over 6 fantastiske biblioteker mens jeg jobbet med ML-prosjektene mine. De hjalp meg med å spare mye tid, og jeg kommer til å diskutere dem i denne bloggen.

1. ren tekst

Et virkelig utrolig bibliotek, ren tekst bør være din favoritt når du trenger å håndtere skraping eller sosiale mediedata. Det kuleste med det er at det ikke krever noen lang fancy kode eller regulære uttrykk for å rense dataene våre. La oss se noen eksempler:

Installasjon

!pip install cleantextEksempel

#Importing the clean text library

from cleantext import clean# Sample texttext = """ Zürich, largest city of Switzerland and capital of the canton of 633Zürich. Located in an Alu017eupine. (https://google.com). Currency is not ₹"""# Cleaning the "text" with clean textclean(text, fix_unicode=True, to_ascii=True, lower=True, no_urls=True, no_numbers=True, no_digits=True, no_currency_symbols=True, no_punct=True, replace_with_punct=" ", replace_with_url="", replace_with_number="", replace_with_digit=" ", replace_with_currency_symbol="Rupees")Produksjon

Fra ovenstående kan vi se at det har Unicode i ordet Zurich (bokstaven 'u' er kodet), ASCII-tegn (i Alu017eupine.), valutasymbol i rupi, HTML-lenke, tegnsetting.

Du trenger bare å nevne de nødvendige ASCII, Unicode, URL-er, tall, valuta og tegnsetting i rensefunksjonen. Eller de kan erstattes med erstatningsparametere i funksjonen ovenfor. For eksempel endret jeg rupi-symbolet til Rupees.

Det er absolutt ingen grunn til å bruke vanlige uttrykk eller lange koder. Veldig hendig bibliotek, spesielt hvis du vil rense tekstene fra skraping eller sosiale mediedata. Basert på ditt krav, kan du også sende argumentene individuelt i stedet for å kombinere dem alle.

For mer informasjon, vennligst sjekk dette GitHub repository.

2. tegnedata

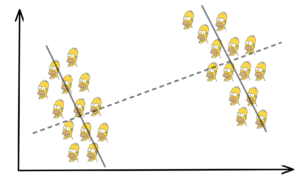

Drawdata er nok et kult funn fra mitt pythonbibliotek. Hvor mange ganger har du vært borti en situasjon der du trenger å forklare ML-konseptene for teamet? Det må skje ofte fordi datavitenskap handler om teamarbeid. Dette biblioteket hjelper deg med å tegne et datasett i Jupyter-notisboken.

Personlig likte jeg å bruke dette biblioteket da jeg forklarte ML-konsepter til teamet mitt. Kudos til utviklerne som opprettet dette biblioteket!

Drawdata er kun for klassifiseringsproblemet med fire klasser.

Installasjon

!pip install drawdataEksempel

# Importing the drawdata from drawdata import draw_scatterdraw_scatter()Produksjon

Bilde av forfatteren

Tegningsvinduene ovenfor åpnes etter å ha utført draw_Scatter(). Det er tydelig at det er fire klasser, nemlig A, B, C og D. Du kan klikke på hvilken som helst klasse og tegne poengene du ønsker. Hver klasse representerer de forskjellige fargene i tegningen. Du har også muligheten til å laste ned dataene som en csv- eller json-fil. Dataene kan også kopieres til utklippstavlen og leses fra koden nedenfor

#Reading the clipboardimport pandas as pd df = pd.read_clipboard(sep=",")

dfEn av begrensningene til dette biblioteket er at det bare gir to datapunkter med fire klasser. Men ellers er det definitivt verdt det. For mer informasjon, vennligst sjekk dette GitHub-lenke.

3. Autoviz

Jeg vil aldri glemme tiden jeg brukte på utforskende dataanalyse ved hjelp av matplotlib. Det er mange enkle visualiseringsbiblioteker. Imidlertid fant jeg nylig ut om Autoviz som automatisk visualiserer ethvert datasett med en enkelt kodelinje.

Installasjon

!pip install autovizEksempel

Jeg brukte IRIS-datasettet for dette eksemplet.

# Importing Autoviz class from the autoviz library

from autoviz.AutoViz_Class import AutoViz_Class#Initialize the Autoviz class in a object called df

df = AutoViz_Class()# Using Iris Dataset and passing to the default parametersfilename = "Iris.csv"

sep = ","graph = df.AutoViz( filename, sep=",", depVar="", dfte=None, header=0, verbose=0, lowess=False, chart_format="svg", max_rows_analyzed=150000, max_cols_analyzed=30,

)Parametrene ovenfor er standard én. For mer informasjon, vennligst sjekk her..

Produksjon

Bilde av forfatteren

Vi kan se alt det visuelle og fullføre vår EDA med en enkelt kodelinje. Det er mange autovisualiseringsbiblioteker, men jeg likte å bli kjent med dette spesielt.

4. Mito

Alle liker Excel, ikke sant? Det er en av de enkleste måtene å utforske et datasett på i første omgang. Jeg kom over Mito for noen måneder siden, men prøvde den nylig, og jeg elsket den absolutt!

Det er et Jupyter-lab-utvidelse python-bibliotek med GUI-støtte som legger til regnearkfunksjonalitet. Du kan laste inn csv-dataene dine og redigere datasettet som et regneark, og det genererer automatisk Pandas-kode. Veldig kult.

Mito fortjener virkelig et helt blogginnlegg. Jeg skal imidlertid ikke gå så mye i detalj i dag. Her er en enkel oppgavedemonstrasjon for deg i stedet. For mer informasjon, vennligst sjekk her..

Installasjon

#First install mitoinstaller in the command prompt

pip install mitoinstaller# Then, run the installer in the command prompt

python -m mitoinstaller install# Then, launch Jupyter lab or jupyter notebook from the command prompt

python -m jupyter labFor mer informasjon om installasjon, vennligst sjekk her..

# Importing mitosheet and ruuning this in Jupyter labimport mitosheet

mitosheet.sheet()Etter å ha utført koden ovenfor, åpnes mitosheet i jupyter-laben. Jeg bruker IRIS-datasettet. For det første opprettet jeg to nye kolonner. Den ene er gjennomsnittlig begerbladlengde og den andre er summen begerbladsbredde. For det andre endret jeg kolonnenavnet for gjennomsnittlig sepallengde. Til slutt opprettet jeg et histogram for den gjennomsnittlige sepallengdekolonnen.

Koden genereres automatisk etter at trinnene ovenfor er fulgt.

Produksjon

Bilde av forfatteren

Koden nedenfor ble generert for trinnene ovenfor:

from mitosheet import * # Import necessary functions from Mito

register_analysis('UUID-119387c0-fc9b-4b04-9053-802c0d428285') # Let Mito know which analysis is being run# Imported C:UsersDhilipDownloadsarchive (29)Iris.csv

import pandas as pd

Iris_csv = pd.read_csv('C:UsersDhilipDownloadsarchive (29)Iris.csv')# Added column G to Iris_csv

Iris_csv.insert(6, 'G', 0)# Set G in Iris_csv to =AVG(SepalLengthCm)

Iris_csv['G'] = AVG(Iris_csv['SepalLengthCm'])# Renamed G to Avg_Sepal in Iris_csv

Iris_csv.rename(columns={"G": "Avg_Sepal"}, inplace=True)5. Gramformer

Nok et imponerende bibliotek, Gramformer er basert på generative modeller som hjelper oss å korrigere grammatikken i setningene. Dette biblioteket har tre modeller som har en detektor, en highlighter og en korrektor. Detektoren identifiserer om teksten har feil grammatikk. Markøren markerer de defekte delene av talen og korrigereren fikser feilene. Gramformer er en helt åpen kildekode og er i en tidlig fase. Men det er ikke egnet for lange avsnitt, da det bare fungerer på setningsnivå og har blitt trent for 64 setninger.

Foreløpig fungerer korrektor- og highlighter-modellen. La oss se noen eksempler.

Installasjon

!pip3 install -U git+https://github.com/PrithivirajDamodaran/Gramformer.gitInstantiate Gramformer

gf = Gramformer(models = 1, use_gpu = False) # 1=corrector, 2=detector (presently model 1 is working, 2 has not implemented)

Eksempel

#Giving sample text for correction under gf.correctgf.correct(""" New Zealand is island countrys in southwestern Paciific Ocaen. Country population was 5 million """)Produksjon

Bilde av forfatteren

Fra utgangen ovenfor kan vi se at den korrigerer grammatikk og til og med stavefeil. Et virkelig fantastisk bibliotek og fungerer veldig bra også. Jeg har ikke prøvd highlighter her, du kan prøve å sjekke denne GitHub-dokumentasjonen for mer detaljer.

6. Stilformer

Min positive erfaring med Gramformer oppmuntret meg til å se etter flere unike biblioteker. Det var slik jeg fant Styleformer, et annet svært tiltalende Python-bibliotek. Både Gramformer og Styleformer ble laget av Prithiviraj Damodaran og begge er basert på generative modeller. Kudos til skaperen for åpen kildekode.

Styleformer hjelper til med å konvertere tilfeldige til formelle setninger, formelle til tilfeldige setninger, aktive til passive og passive til aktive setninger.

La oss se noen eksempler

Installasjon

!pip install git+https://github.com/PrithivirajDamodaran/Styleformer.gitInstantiate Styleformer

sf = Styleformer(style = 0)# style = [0=Casual to Formal, 1=Formal to Casual, 2=Active to Passive, 3=Passive to Active etc..]Eksempler

# Converting casual to formal sf.transfer("I gotta go")

# Formal to casual sf = Styleformer(style = 1) # 1 -> Formal to casual# Converting formal to casual

sf.transfer("Please leave this place")

# Active to Passive sf = Styleformer(style = 2) # 2-> Active to Passive# Converting active to passive

sf.transfer("We are going to watch a movie tonight.")

# passive to active

sf = Styleformer(style = 2) # 2-> Active to Passive# Converting passive to active

sf.transfer("Tenants are protected by leases")

Se utgangen ovenfor, den konverterer nøyaktig. Jeg brukte dette biblioteket for å konvertere uformell til formell, spesielt for innlegg på sosiale medier i en av mine analyser. For mer informasjon, vennligst sjekk GitHub.

Du er kanskje kjent med noen av de tidligere nevnte bibliotekene, men de som Gramformer og Styleformer er nyere spillere. De er ekstremt undervurdert og fortjener absolutt å bli kjent fordi de sparte mye av tiden min og jeg brukte dem mye til NLP-prosjektene mine.

Takk for at du leste. Hvis du har noe å legge til, legg gjerne igjen en kommentar!

Du kan også like min forrige artikkel Fem kule Python-biblioteker for datavitenskap

Bio: Dhilip Subramanian er en maskiningeniør og har fullført sin mastergrad i Analytics. Han har 9 års erfaring med spesialisering innen ulike domener relatert til data, inkludert IT, markedsføring, bank, kraft og produksjon. Han er lidenskapelig opptatt av NLP og maskinlæring. Han er en bidragsyter til SAS-samfunnet og elsker å skrive tekniske artikler om forskjellige aspekter av datavitenskap på Medium-plattformen.

original. Ompostet med tillatelse.

Relatert:

| Topphistorier siste 30 dager | |||||

|---|---|---|---|---|---|

|

|

||||

Kilde: https://www.kdnuggets.com/2021/09/6-cool-python-libraries-recently.html

- "

- &

- 9

- aktiv

- AI

- Alle

- analyse

- analytics

- Søknad

- argumenter

- artikler

- auto

- Banking

- Blogg

- hovedstad

- City

- klassifisering

- Rengjøring

- kode

- Kolonne

- Felles

- skaperen

- valuta

- dato

- dataanalyse

- datavitenskap

- dataforsker

- dyp læring

- detalj

- utviklere

- Regissør

- domener

- Tidlig

- ingeniør

- etc

- Excel

- erfaring

- Endelig

- Først

- Gratis

- funksjon

- gif

- GitHub

- GPU

- Grammatikk

- praktisk

- her.

- Hvordan

- HTTPS

- bilde

- importere

- Inkludert

- informasjon

- integrert

- Intervju

- IT

- Jupyter Notebook

- lansere

- LÆRE

- læring

- Nivå

- Bibliotek

- linje

- LINK

- laste

- Lang

- maskinlæring

- produksjon

- Marketing

- Media

- medium

- millioner

- ML

- modell

- måneder

- film

- nemlig

- neural

- New Zealand

- nlp

- tall

- åpen

- åpen kildekode

- Alternativ

- Annen

- plattform

- befolkningen

- innlegg

- makt

- prosjekter

- Python

- Lesning

- grunner

- regresjon

- Kjør

- SAS

- Vitenskap

- forskere

- skraping

- sett

- Enkelt

- selskap

- sosiale medier

- regneark

- Stories

- støtte

- sveits

- Teknisk

- tid

- topp

- unicode

- us

- visualisering

- Se

- HVEM

- vinduer

- virker

- verdt

- X

- år

- Zürich