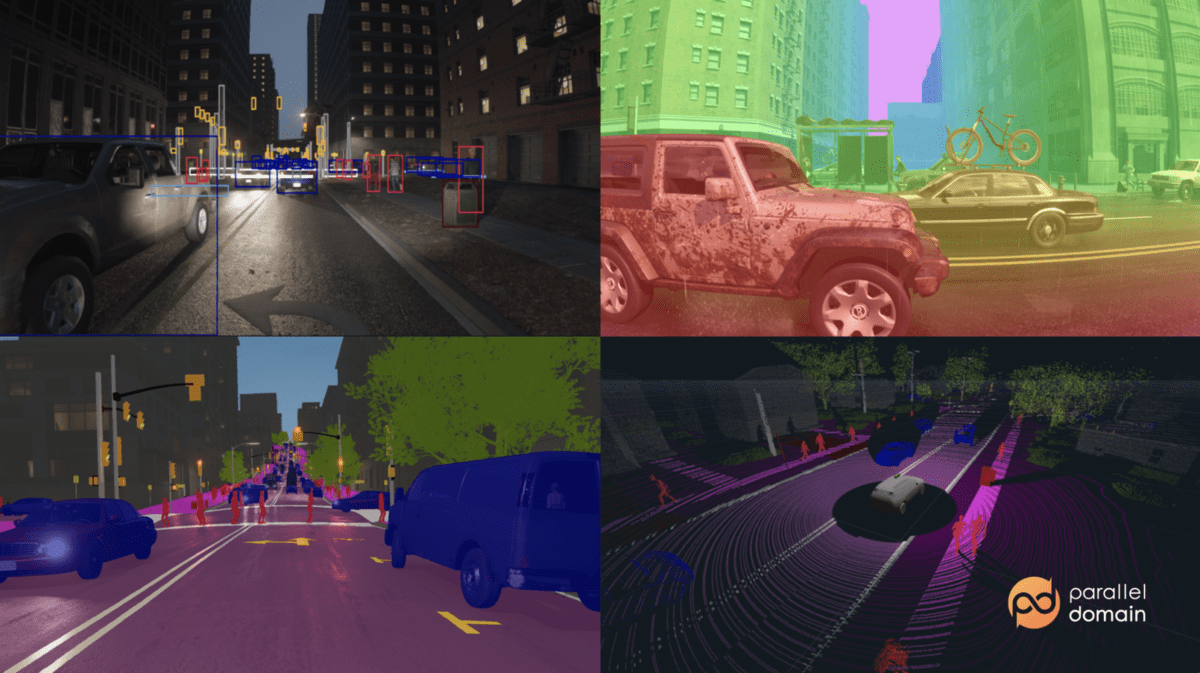

Syntetiske data generert fra Kubric

For å trene en maskinlæringsmodell trenger du data. Datavitenskapsoppgaver er vanligvis ikke en Kaggle-konkurranse der du har et fint stort kuratert datasett som kommer forhåndsmerket. Noen ganger må du samle inn, organisere og rense dine egne data. Denne prosessen med å samle inn og merke data i den virkelige verden kan være tidkrevende, tungvint, dyr, unøyaktig og noen ganger farlig. Videre, på slutten av denne prosessen, kan du ende opp med at dataene du møtte i den virkelige verden ikke nødvendigvis er dataene du ønsker når det gjelder kvalitet, mangfold (f.eks. klasseubalanse) og kvantitet. Nedenfor er vanlige problemer du kan støte på når du arbeider med ekte data:

- Ekte datainnsamling og merking er ikke skalerbare

- Manuell merking av ekte data kan noen ganger være umulig

- Ekte data har personvern- og sikkerhetsproblemer

- Ekte data er ikke programmerbare

- En modell som er trent utelukkende på ekte data, er ikke ytelsesdyktig nok (f.eks. langsom utviklingshastighet)

Heldigvis kan problemer som disse løses med syntetiske data. Du lurer kanskje, hva er syntetiske data? Syntetiske data kan defineres som kunstig genererte data som vanligvis lages ved hjelp av algoritmer som simulerer virkelige prosesser, fra oppførselen til andre trafikanter helt ned til oppførselen til lys når det samhandler med overflater. Dette innlegget går over begrensningene til virkelige data, og hvordan syntetiske data kan bidra til å overvinne disse problemene og forbedre modellytelsen.

For små datasett er det vanligvis mulig å samle inn og merke data manuelt; Imidlertid krever mange komplekse maskinlæringsoppgaver enorme datasett for opplæring. For eksempel trenger modeller som er trent for autonome kjøretøyapplikasjoner store mengder data samlet inn fra sensorer koblet til biler eller droner. Denne datainnsamlingsprosessen er treg og kan ta måneder eller til og med år. Når rådataene er samlet inn, må de deretter kommenteres manuelt av mennesker, noe som også er dyrt og tidkrevende. Videre er det ingen garanti for at de merkede dataene som kommer tilbake vil være nyttige som treningsdata, siden de kanskje ikke inneholder eksempler som informerer om modellens nåværende kunnskapshull.

[innebygd innhold][innebygd innhold]

Merking av disse dataene innebærer ofte at mennesker tegner etiketter for hånd på toppen av sensordata. Dette er svært kostbart ettersom høyt betalte ML-team ofte bruker en stor del av tiden sin på å sikre at etikettene er riktige og sende feil tilbake til etikettørene. En stor styrke med syntetiske data er at du kan generere så mye perfekt merket data du vil. Alt du trenger er en måte å generere syntetiske kvalitetsdata på.

Programvare med åpen kildekode for å generere syntetiske data: Kubric (flerobjektvideoer med segmenteringsmasker, dybdekart og optisk flyt) og SDV (tabell-, relasjons- og tidsseriedata).

Noen (av mange) selskaper som selger produkter eller bygger plattformer som kan generere syntetiske data inkluderer Gretel.ai (syntetiske datasett som sikrer personvernet til ekte data), NVIDIA (omnivers), og Parallelt domene (autonome kjøretøy). For mer, se 2022-listen over syntetiske dataselskaper.

Bilde fra Parallelt domene

Det er noen data som mennesker ikke helt kan tolke og merke. Nedenfor er noen brukstilfeller der syntetiske data er det eneste alternativet:

- Nøyaktig estimering av dybde og optisk flyt fra enkeltbilder

- Selvkjørende applikasjoner som bruker radardata som ikke er synlige for det menneskelige øyet

- Generer dype forfalskninger som kan brukes til å teste ansiktsgjenkjenningssystemer

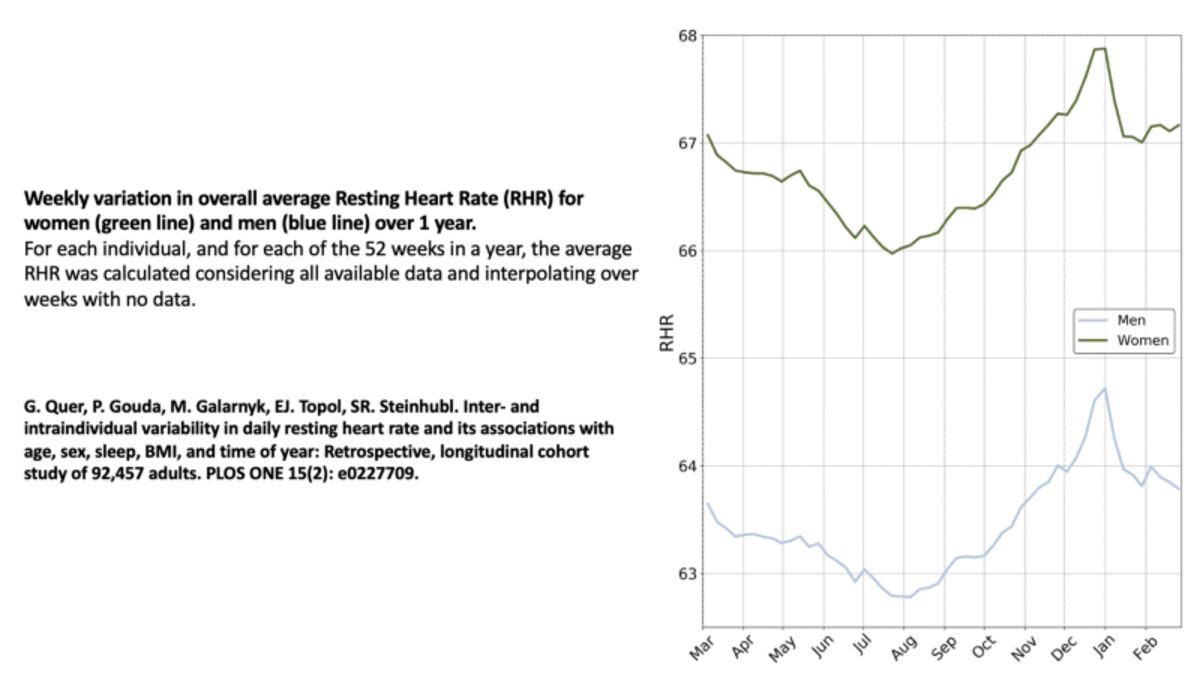

Bilde av Michael Galarnyk

Syntetiske data er svært nyttig for applikasjoner i domener der du ikke enkelt kan få ekte data. Dette inkluderer noen typer bilulykkedata og de fleste typer helsedata som har personvernbegrensninger (f.eks. elektroniske helsejournaler). De siste årene har helsepersonell vært interessert i å forutsi atrieflimmer (uregelmessig hjerterytme) ved hjelp av EKG- og PPG-signaler. Å utvikle en arytmidetektor er ikke bare utfordrende siden merking av disse signalene er kjedelig og kostbar, men også på grunn av personvernbegrensninger. Dette er en grunn til at det er det forskning på å simulere disse signalene.

Det er viktig å understreke at innsamling av ekte data ikke bare tar tid og energi, men kan faktisk være farlig. Et av kjerneproblemene med robotapplikasjoner som selvkjørende biler er at de er fysiske applikasjoner for maskinlæring. Du kan ikke distribuere en usikker modell i den virkelige verden og ha en krasj på grunn av mangel på relevante data. Å utvide et datasett med syntetiske data kan hjelpe modeller med å unngå disse problemene.

Følgende er noen selskaper som bruker syntetiske data for å forbedre applikasjonssikkerheten: Toyota, Waymoog cruise.

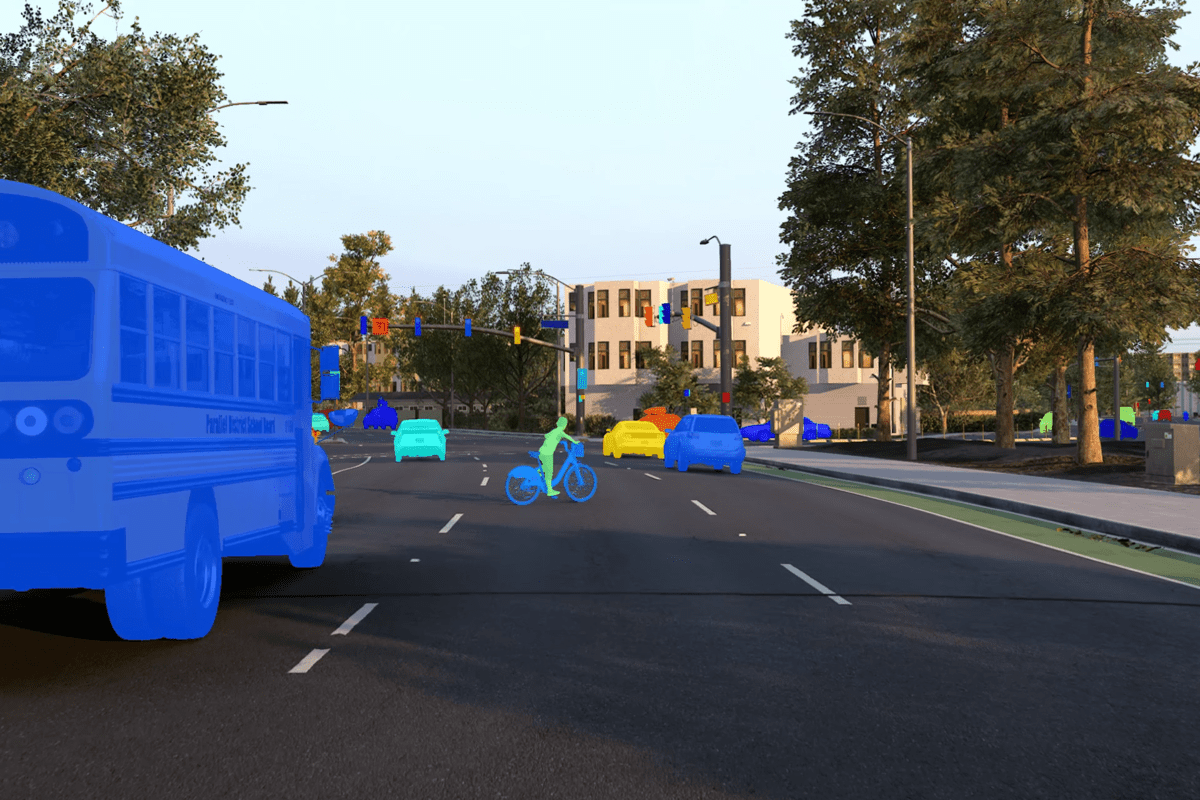

Bilde fra Parallelt domene

Syntetisk bilde av et okkludert barn på en sykkel som dukker opp bak en skolebuss og sykler over gaten i et forstadsmiljø i California-stil.

Autonome kjøretøyapplikasjoner håndterer ofte relativt "uvanlige" (i forhold til normale kjøreforhold) hendelser som fotgjengere om natten eller syklister som sykler midt på veien. Modeller trenger ofte hundretusener eller til og med millioner av eksempler for å lære et scenario. Et stort problem er at de innsamlede dataene fra den virkelige verden kanskje ikke er det du leter etter når det gjelder kvalitet, mangfold (f.eks. klasseubalanse, værforhold, plassering) og kvantitet. Et annet problem er at for selvkjørende biler og roboter vet du ikke alltid hvilke data du trenger i motsetning til tradisjonelle maskinlæringsoppgaver med faste datasett og faste benchmarks. Mens noen dataforsterkningsteknikker som systematisk eller tilfeldig endrer bilder er nyttige, kan disse teknikkene introdusere sine egne problemer.

Det er her syntetiske data kommer inn. APIer for generering av syntetiske data lar deg konstruere datasett. Disse APIene kan spare deg for mye penger siden det er veldig dyrt å bygge roboter og samle inn data i den virkelige verden. Det er mye bedre og raskere å prøve å generere data og finne ut de tekniske prinsippene ved å bruke syntetisk datasett.

Følgende er eksempler som fremhever hvordan programmerbare syntetiske data hjelper modeller å lære: forebygging av uredelige transaksjoner (American Express), bedre syklistdeteksjon (Parallell Domain)og kirurgisk analyse og gjennomgang (Hutom.io).

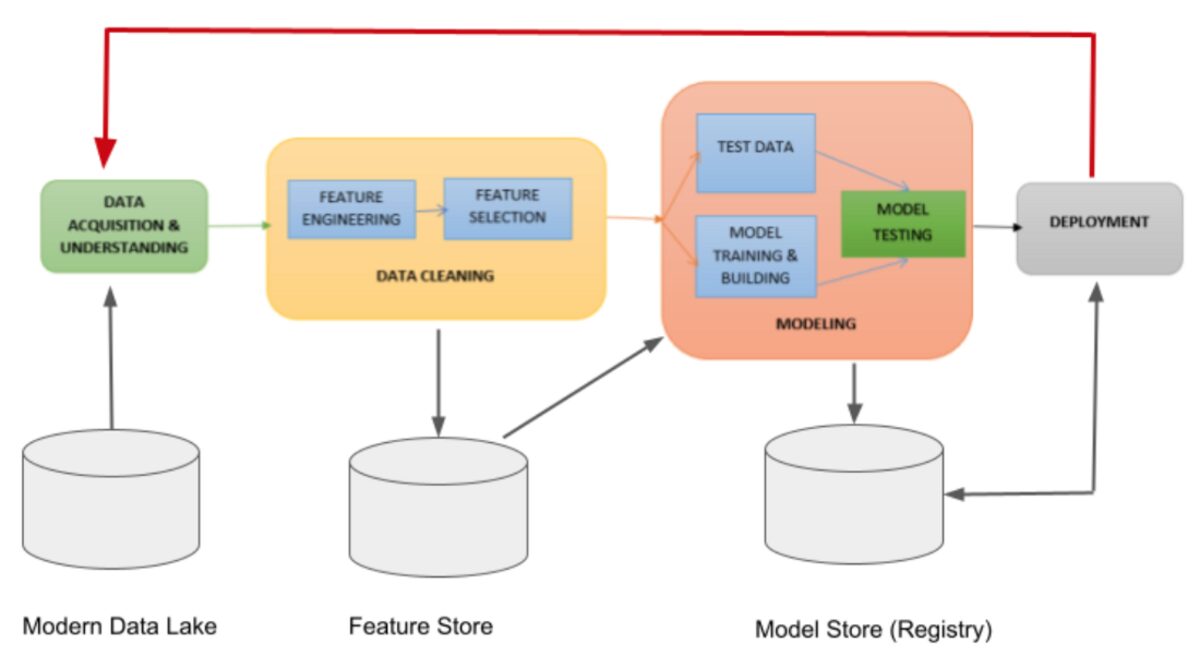

Faser i modellutviklingssyklusen | Bilde fra Jules S. Damji

I industrien finnes det en rekke faktorer som påvirker levedyktigheten/ytelsen til et maskinlæringsprosjekt i både utvikling og produksjon (f.eks. datainnsamling, merknader, modelltrening, skalering, distribusjon, overvåking, omskolering av modellen og utviklingshastighet). Nylig, 18 maskinlæringsingeniører deltok i en intervjustudie som hadde som mål å forstå vanlige MLOps-praksis og utfordringer på tvers av organisasjoner og applikasjoner (f.eks. autonome kjøretøy, maskinvare, detaljhandel, annonser, anbefalingssystemer, etc.). En av konklusjonene fra studien var viktigheten av utviklingshastighet, som grovt kan defineres som evnen til raskt å prototyper og iterere på ideer.

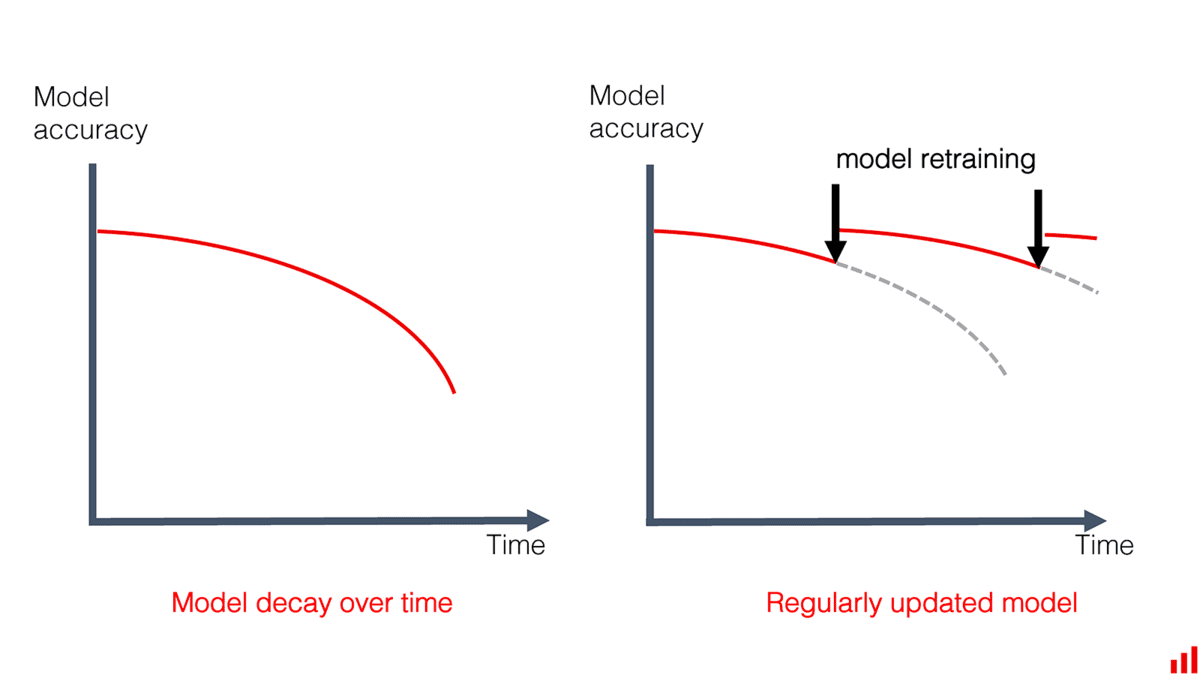

En faktor som påvirker utviklingshastigheten er behovet for å ha data for å utføre den innledende modelltreningen og evalueringen samt hyppig modellomskolering på grunn av modellytelse som avtar over tid på grunn av datadrift, konseptdrift, eller til og med skjevhet i trening og servering.

Bilde fra Tydeligvis AI

Studien rapporterte også at dette behovet førte til at noen organisasjoner satte opp et team for å merke live data ofte. Dette er dyrt, tidkrevende og begrenser en organisasjons mulighet til å omskolere modeller ofte.

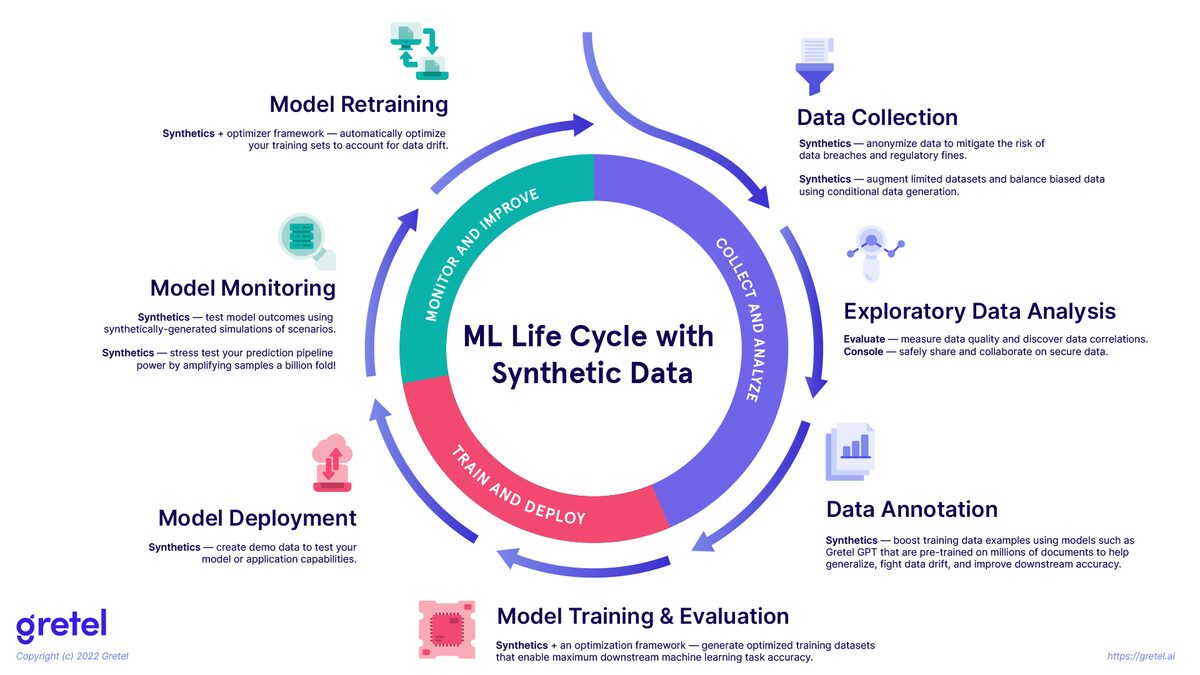

Bilde fra Gretel.ai

Merk at dette diagrammet ikke dekker hvordan syntetiske data også kan brukes til ting som MLOps-testing i anbefalere.

Syntetiske data har potensial til å bli brukt sammen med data fra den virkelige verden i livssyklusen for maskinlæring (bildet over) for å hjelpe organisasjoner med å holde modellene sine mer effektive.

Syntetisk datagenerering blir mer og mer vanlig i arbeidsflyter for maskinlæring. Faktisk, Gartner spår at innen 2030 vil syntetiske data bli brukt mye mer enn virkelige data for å trene maskinlæringsmodeller. Hvis du har spørsmål eller tanker om dette innlegget, ta gjerne kontakt i kommentarfeltet nedenfor eller gjennom Twitter.

Michael Galarnyk er Data Science Professional, og jobber i Developer Relations på Anyscale.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://www.kdnuggets.com/2023/02/5-reasons-need-synthetic-data.html?utm_source=rss&utm_medium=rss&utm_campaign=5-reasons-why-you-need-synthetic-data

- 2022

- a

- evne

- Om oss

- ovenfor

- ulykke

- oppkjøp

- tvers

- faktisk

- annonser

- påvirke

- påvirker

- algoritmer

- Alle

- alltid

- amerikansk

- American Express

- beløp

- analyse

- og

- En annen

- APIer

- Søknad

- søknader

- autonom

- autonome kjøretøy

- autonome kjøretøyer

- tilbake

- fordi

- bli

- bak

- være

- under

- benchmarks

- gunstig

- Bedre

- blank

- bygge

- buss

- bil

- biler

- saker

- utfordringer

- utfordrende

- barn

- klasse

- samle

- Samle

- samling

- kommentarer

- Felles

- Selskaper

- konkurranse

- komplekse

- datamaskin

- konsept

- forhold

- innhold

- Kjerne

- dekke

- Crash

- opprettet

- kuratert

- Gjeldende

- syklus

- Dangerous

- dato

- datavitenskap

- datasett

- datasett

- avtale

- dyp

- Deep Fakes

- definert

- utplassere

- distribusjon

- dybde

- Gjenkjenning

- Utvikler

- utvikle

- Utvikling

- Mangfold

- ikke

- domene

- domener

- ikke

- ned

- tegning

- kjøring

- Droner

- lett

- innebygd

- Emery

- understreke

- møte

- energi

- ingeniør

- Ingeniørarbeid

- Ingeniører

- nok

- sikre

- Miljø

- etc

- evaluering

- Selv

- hendelser

- eksempel

- eksempler

- utelukkende

- dyrt

- ekspress

- Face

- ansiktsgjenkjenning

- faktorer

- raskere

- Figur

- fikset

- flyten

- etter

- uredelig

- Gratis

- hyppig

- ofte

- fra

- fullt

- Dess

- Gartner

- generere

- generert

- generasjonen

- få

- gif

- mål

- Går

- garantere

- maskinvare

- Helse

- helsetjenester

- Hjerte

- hjelpe

- hjelper

- Høy

- Uthev

- svært

- Hvordan

- Men

- HTML

- HTTPS

- stort

- menneskelig

- Mennesker

- Hundrevis

- Ideer

- bilde

- bilder

- ubalanse

- betydning

- viktig

- umulig

- forbedre

- in

- unøyaktig

- inkludere

- inkluderer

- industri

- innledende

- interaktiv

- interessert

- Intervju

- saker

- IT

- KDnuggets

- Hold

- Vet

- kunnskap

- Etiketten

- merking

- etiketter

- maling

- stor

- LÆRE

- læring

- lærende ingeniører

- Led

- Life

- lett

- begrensninger

- grenser

- Liste

- leve

- live data

- plassering

- lenger

- ser

- Lot

- maskin

- maskinlæring

- større

- Making

- manuelt

- mange

- Kart

- masker

- massive

- medium

- Middle

- kunne

- millioner

- feil

- ML

- MLOps

- modell

- modeller

- penger

- overvåking

- måneder

- mer

- mest

- nødvendigvis

- Trenger

- natt

- normal

- Nvidia

- OmniVerse

- ONE

- Alternativ

- organisasjon

- organisasjoner

- Annen

- Overcome

- egen

- betalt

- Parallel

- del

- ytelse

- fysisk

- Plattformer

- plato

- Platon Data Intelligence

- PlatonData

- mulig

- Post

- potensiell

- praksis

- forutsi

- spår

- prinsipper

- privatliv

- Problem

- problemer

- prosess

- Prosesser

- Produkter

- profesjonell

- prosjekt

- prototype

- kvalitet

- kvantitet

- spørsmål

- radar

- raskt

- Raw

- rådata

- å nå

- ekte

- virkelige verden

- grunnen til

- grunner

- nylig

- nylig

- anerkjennelse

- relasjoner

- relativt

- relevant

- rapportert

- krever

- forskning

- forskere

- restriksjoner

- detaljhandel

- omskolering

- anmeldelse

- riding

- vei

- roboter

- omtrent

- Sikkerhet

- Spar

- skalerbar

- skalering

- scenario

- Skole

- Vitenskap

- segmentering

- self-kjøring

- selger

- sending

- sensorer

- Serien

- sett

- sett

- signaler

- siden

- enkelt

- skjev

- langsom

- liten

- Software

- noen

- kilde

- bruke

- gate

- styrke

- Studer

- syntetisk

- syntetiske data

- Systemer

- Ta

- oppgaver

- lag

- lag

- teknikker

- vilkår

- test

- Testing

- De

- deres

- ting

- tusener

- tid

- Tidsserier

- tidkrevende

- til

- topp

- tradisjonelle

- Tog

- trent

- Kurs

- Transaksjoner

- typer

- typisk

- forståelse

- bruke

- Brukere

- vanligvis

- bruke

- kjøretøy

- Kjøretøy

- Hastighet

- videoer

- synlig

- Vær

- Hva

- hvilken

- vil

- lurer

- arbeidsflyt

- arbeid

- virker

- verden

- ville

- år

- Din

- youtube

- zephyrnet