Gesponsorde content

ChatGPT en soortgelijke tools gebaseerd op grote taalmodellen (LLM's) zijn geweldig. Maar het zijn geen universele hulpmiddelen.

Het is net als het kiezen van andere hulpmiddelen voor bouwen en creëren. U moet de juiste kiezen voor de taak. Je zou niet proberen een bout vast te draaien met een hamer of een hamburgerpasteitje om te draaien met een garde. Het proces zou lastig zijn en resulteren in een rommelige mislukking.

Taalmodellen zoals LLM's vormen slechts een deel van de bredere machine learning-toolkit, die zowel generatieve AI als voorspellende AI omvat. Het selecteren van het juiste type machine learning-model is cruciaal om aan te sluiten bij de vereisten van uw taak.

Laten we dieper ingaan op de vraag waarom LLM's beter geschikt zijn om u te helpen bij het opstellen van tekst of om te brainstormen over cadeau-ideeën dan om de meest kritische voorspellende modelleringstaken van uw bedrijf aan te pakken. Er is nog steeds een cruciale rol weggelegd voor de ‘traditionele’ machine learning-modellen die aan LLM’s voorafgingen en die herhaaldelijk hun waarde hebben bewezen in bedrijven. We zullen ook een baanbrekende aanpak onderzoeken om deze tools samen te gebruiken – een opwindende ontwikkeling die wij bij Pecan noemen Voorspellende GenAI.

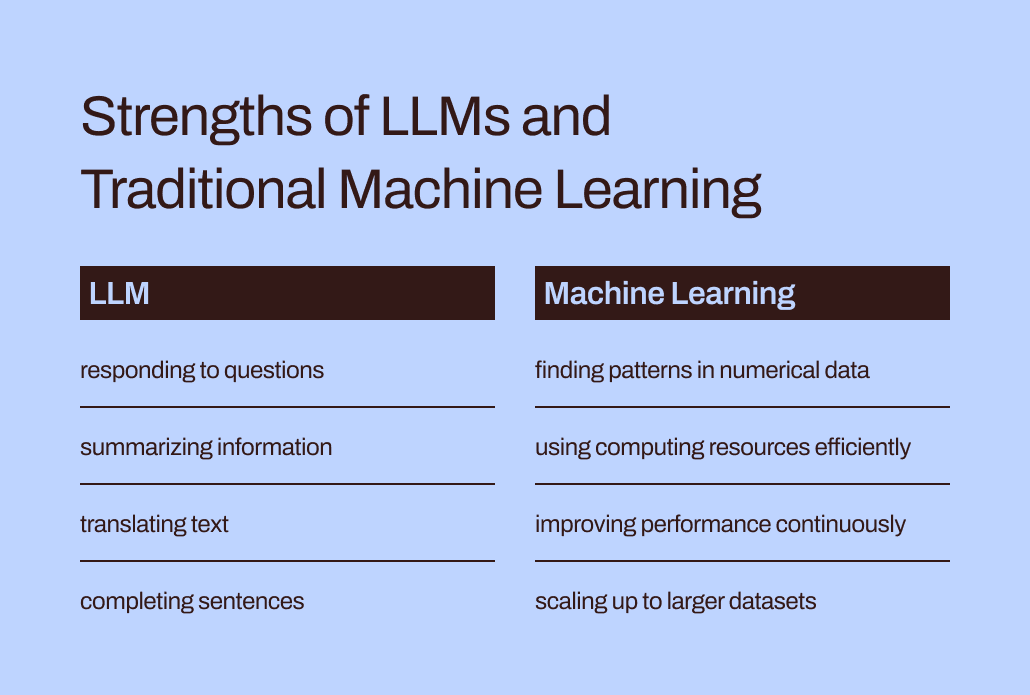

LLM's zijn ontworpen voor woorden, niet voor cijfers

Bij machinaal leren worden verschillende wiskundige methoden gebruikt om zogenaamde ‘trainingsgegevens’ te analyseren: een eerste dataset die het probleem vertegenwoordigt dat een data-analist of datawetenschapper hoopt op te lossen.

Het belang van trainingsgegevens kan niet genoeg worden benadrukt. Het bevat de patronen en relaties die een machine learning-model zal “leren” om resultaten te voorspellen wanneer het later nieuwe, ongeziene gegevens krijgt.

Dus, wat is specifiek een LLM? Grote taalmodellen, of LLM's, vallen onder de paraplu van machinaal leren. Ze komen voort uit deep learning en hun structuur is specifiek ontwikkeld voor natuurlijke taalverwerking.

Je zou kunnen zeggen dat ze zijn gebouwd op een fundament van woorden. Hun doel is simpelweg om te voorspellen welk woord het volgende zal zijn in een reeks woorden. De autocorrectiefunctie van iPhones in iOS 17 gebruikt nu bijvoorbeeld een LLM om beter te voorspellen welk woord u waarschijnlijk als volgende wilt typen.

Stel je nu voor dat je een machine learning-model bent. (Heb geduld, we weten dat het lastig is.) Je bent getraind om woorden te voorspellen. Je hebt miljoenen woorden uit een breed scala aan bronnen over allerlei onderwerpen gelezen en bestudeerd. Je mentoren (ook wel ontwikkelaars genoemd) hebben je geholpen de beste manieren te leren om woorden te voorspellen en nieuwe tekst te maken die past bij het verzoek van een gebruiker.

Maar hier is een wending. Een gebruiker geeft u nu een enorme spreadsheet met klant- en transactiegegevens, met miljoenen rijen getallen, en vraagt u getallen te voorspellen die verband houden met deze bestaande gegevens.

Hoe denk je dat jouw voorspellingen zouden uitpakken? Ten eerste zou je waarschijnlijk geïrriteerd zijn dat deze taak niet overeenkomt met datgene waarvoor je zo hard hebt gewerkt om te leren. (Gelukkig hebben LLM's, voor zover wij weten, nog geen gevoelens.) Belangrijker nog is dat er van je wordt gevraagd een taak uit te voeren die niet overeenkomt met wat je hebt geleerd. En je zult waarschijnlijk niet zo goed presteren.

De kloof tussen training en taak verklaart mede waarom LLM's niet goed geschikt zijn voor voorspellende taken met numerieke, tabellarische gegevens – het primaire gegevensformaat dat de meeste bedrijven verzamelen. In plaats daarvan is een machine learning-model dat specifiek is ontworpen en afgestemd op het verwerken van dit soort gegevens effectiever. Het is hier letterlijk voor getraind.

De efficiëntie- en optimalisatie-uitdagingen van LLM's

Traditionele machine learning-methoden passen niet alleen beter bij numerieke gegevens, maar zijn ook veel efficiënter en gemakkelijker te optimaliseren voor betere prestaties dan LLM's.

Laten we teruggaan naar uw ervaring met het nabootsen van een LLM. Het lezen van al die woorden en het bestuderen van hun stijl en volgorde klinkt als een hoop werk, toch? Het zou veel moeite kosten om al die informatie te internaliseren.

Op dezelfde manier kan de complexe training van LLM's resulteren in modellen met miljarden parameters. Die complexiteit zorgt ervoor dat deze modellen de lastige nuances van de menselijke taal kunnen begrijpen en erop kunnen reageren. Zware training brengt echter zware rekenvereisten met zich mee wanneer LLM's antwoorden genereren. Numeriek georiënteerde ‘traditionele’ machine learning-algoritmen, zoals beslissingsbomen of neurale netwerken, zullen waarschijnlijk veel minder computerbronnen nodig hebben. En dit is geen geval van ‘groter is beter’. Zelfs als LLM's numerieke gegevens zouden kunnen verwerken, zou dit verschil betekenen dat traditionele methoden voor machinaal leren nog steeds sneller, efficiënter, ecologisch duurzamer en kosteneffectiever zouden zijn.

Heeft u ChatGPT bovendien ooit gevraagd hoe het een bepaald antwoord kon geven? Het antwoord zal waarschijnlijk een beetje vaag zijn:

Ik genereer antwoorden op basis van een combinatie van gelicentieerde gegevens, gegevens gemaakt door menselijke trainers en openbaar beschikbare gegevens. Mijn training omvatte ook grootschalige datasets verkregen uit verschillende bronnen, waaronder boeken, websites en andere teksten, om een breed begrip van menselijke taal te ontwikkelen. Het trainingsproces omvat het uitvoeren van berekeningen op duizenden GPU's gedurende weken of maanden, maar exacte details en tijdschalen zijn eigendom van OpenAI.

Hoeveel van de ‘kennis’ die in die reactie tot uiting kwam, kwam van de menselijke trainers versus de publieke gegevens versus boeken? Zelfs ChatGPT zelf weet het niet zeker: “De relatieve verhoudingen van deze bronnen zijn onbekend, en ik heb geen gedetailleerd inzicht in welke specifieke documenten deel uitmaakten van mijn trainingsset.”

Het is een beetje zenuwslopend om te zien dat ChatGPT zulke zelfverzekerde antwoorden op uw vragen geeft, maar de antwoorden niet naar specifieke bronnen kan herleiden. De beperkte interpreteerbaarheid en uitlegbaarheid van LLM's brengt ook uitdagingen met zich mee bij het optimaliseren ervan voor specifieke zakelijke behoeften. Het kan moeilijk zijn om de reden achter hun informatie of voorspellingen te begrijpen. Om de zaken nog ingewikkelder te maken, kampen bepaalde bedrijven met eisen van regelgeving die inhouden dat ze de factoren moeten kunnen verklaren die van invloed zijn op de voorspellingen van een model. Al met al laten deze uitdagingen zien dat traditionele machine learning-modellen – over het algemeen beter interpreteerbaar en verklaarbaar – waarschijnlijk beter geschikt zijn voor zakelijke toepassingen.

De juiste plek voor LLM's in de voorspellende toolkit van bedrijven

Moeten we LLM’s dus gewoon aan hun woordgerelateerde taken overlaten en ze vergeten voor voorspellende gebruiksscenario’s? Het lijkt nu misschien alsof ze toch niet kunnen helpen met het voorspellen van klantverloop of klantlevensduurwaarde.

Het punt is: hoewel het zeggen van ‘traditionele machine learning-modellen’ ervoor zorgt dat deze technieken algemeen worden begrepen en gemakkelijk te gebruiken zijn, weten we uit onze ervaring bij Pecan dat bedrijven nog steeds grotendeels moeite hebben om zelfs deze meer bekende vormen van AI over te nemen.

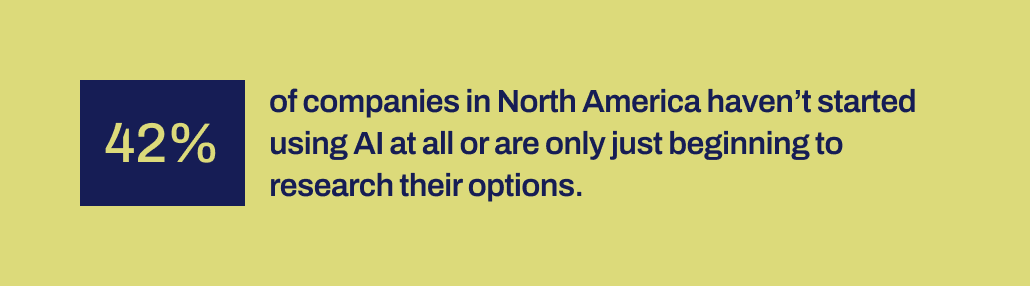

Uit recent onderzoek van Workday blijkt dat 42% van de bedrijven in Noord-Amerika nog niet is begonnen met het gebruik van AI of zich nog maar in de beginfase bevindt van het verkennen van hun mogelijkheden. En het is al meer dan tien jaar geleden dat machine learning-tools toegankelijker werden voor bedrijven. Ze hebben de tijd gehad en er zijn verschillende hulpmiddelen beschikbaar.

Om de een of andere reden zijn succesvolle AI-implementaties verrassend zeldzaam geweest, ondanks de enorme buzz rond datawetenschap en AI – en hun erkende potentieel voor aanzienlijke zakelijke impact. Er ontbreekt een belangrijk mechanisme om de kloof te overbruggen tussen de beloften van AI en het vermogen om deze productief te implementeren.

En dat is precies waar wij geloven dat LLM's nu een cruciale brugrol kunnen spelen. LLM's kunnen zakelijke gebruikers helpen de kloof te overbruggen tussen het identificeren van een bedrijfsprobleem dat moet worden opgelost en het ontwikkelen van een voorspellend model.

Nu LLM's in beeld zijn, kunnen bedrijfs- en datateams die niet over de mogelijkheid of capaciteit beschikken om machine learning-modellen met de hand te coderen, hun behoeften nu beter in modellen vertalen. Ze kunnen ‘hun woorden gebruiken’, zoals ouders graag zeggen, om het modelleringsproces op gang te brengen.

LLM's combineren met machine learning-technieken die zijn gebouwd om uit te blinken op het gebied van bedrijfsgegevens

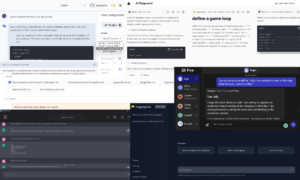

Die mogelijkheid is nu beschikbaar in Pecan's Predictive GenAI, die de sterke punten van LLM's combineert met ons toch al zeer verfijnde en geautomatiseerde machine learning-platform. Onze door LLM aangedreven Predictive Chat verzamelt input van een zakelijke gebruiker om de definitie en ontwikkeling van een voorspellende vraag te begeleiden: het specifieke probleem dat de gebruiker met een model wil oplossen.

Vervolgens genereert ons platform met behulp van GenAI een Predictive Notebook om de volgende stap naar modellering nog eenvoudiger te maken. Ook hier bevat het notebook, op basis van LLM-mogelijkheden, vooraf ingevulde SQL-query's om de trainingsgegevens voor het voorspellende model te selecteren. Pecan's geautomatiseerde gegevensvoorbereiding, feature-engineering, modelbouw en implementatiemogelijkheden kunnen de rest van het proces in recordtijd uitvoeren, sneller dan welke andere oplossing voor voorspellende modellering dan ook.

Kortom, Pecan's Predictive GenAI gebruikt de ongeëvenaarde taalvaardigheden van LLM's om ons best-in-class voorspellende modelleringsplatform veel toegankelijker en vriendelijker te maken voor zakelijke gebruikers. We zijn blij om te zien hoe deze aanpak veel meer bedrijven zal helpen succesvol te worden met AI.

Dus, terwijl LLM's alleen zijn niet goed geschikt om aan al uw voorspellende behoeften te voldoen, ze kunnen een krachtige rol spelen bij het vooruit helpen van uw AI-projecten. Door uw gebruiksscenario te interpreteren en u een voorsprong te geven met automatisch gegenereerde SQL-code, loopt Pecan's Predictive GenAI voorop bij het verenigen van deze technologieën. Jij kan Bekijk het nu met een gratis proefperiode.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://www.kdnuggets.com/2024/01/pecan-llms-used-alone-cant-address-companys-predictive-needs?utm_source=rss&utm_medium=rss&utm_campaign=why-llms-used-alone-cant-address-your-companys-predictive-needs

- : heeft

- :is

- :niet

- :waar

- 15%

- 17

- a

- vermogen

- in staat

- Over

- beschikbaar

- erkend

- toevoeging

- adres

- adopteren

- Na

- weer

- AI

- aka

- algoritmen

- richten

- Alles

- toestaat

- alleen

- al

- ook

- verbazingwekkend

- Amerika

- an

- analist

- analyseren

- en

- beantwoorden

- antwoorden

- elke

- nadering

- ZIJN

- rond

- aangekomen

- AS

- helpen

- At

- geautomatiseerde

- geautomatiseerde machine learning

- webmaster.

- Beschikbaar

- terug

- gebaseerde

- BE

- Beer

- werd

- geweest

- Begin

- achter

- wezen

- geloofd wie en wat je bent

- BEST

- Betere

- tussen

- miljarden

- Beetje

- Bolt

- Boeken

- zowel

- brainstorm

- BRUG

- overbrugging

- bredere

- Gebouw

- bebouwd

- bedrijfsdeskundigen

- zakelijke impact

- ondernemingen

- maar

- by

- Bellen

- kwam

- CAN

- mogelijkheden

- bekwaamheid

- Inhoud

- dragen

- geval

- gevallen

- zeker

- uitdagingen

- kloof

- de chat

- ChatGPT

- het kiezen van

- code

- verzamelen

- komt

- Bedrijven

- Bedrijf

- complex

- ingewikkeldheid

- computationeel

- berekeningen

- computergebruik

- zeker

- vormen

- bevat

- te corrigeren

- kostenefficient

- kon

- bewerkte

- en je merk te creëren

- aangemaakt

- Wij creëren

- kritisch

- Cross

- cruciaal

- klant

- gegevens

- data-analist

- Data voorbereiding

- data science

- data scientist

- datasets

- decennium

- beslissing

- deep

- diepgaand leren

- diepere

- definitie

- eisen

- inzet

- ontworpen

- Niettegenstaande

- gedetailleerd

- gegevens

- ontwikkelen

- ontwikkelde

- ontwikkelaars

- het ontwikkelen van

- Ontwikkeling

- verschil

- anders

- DIG

- do

- documenten

- Nee

- don

- Dont

- draft

- tekening

- Vroeg

- gemakkelijker

- En het is heel gemakkelijk

- effectief

- doeltreffendheid

- doeltreffend

- inspanning

- beide

- allesomvattende

- Engineering

- milieuvriendelijke

- Ether (ETH)

- Zelfs

- OOIT

- voorbeeld

- Excel

- opgewonden

- opwindend

- bestaand

- ervaring

- Verklaren

- Uitlegbaarheid

- Verken

- Verkennen

- factoren

- Storing

- Vallen

- vertrouwd

- ver

- sneller

- Kenmerk

- gevoelens

- minder

- Voornaam*

- geschikt

- fits

- Tik

- Voor

- formaat

- formulieren

- Gelukkig

- Naar voren

- Foundation

- Gratis

- vriendelijk

- oppompen van

- verder

- fusing

- kloof

- genai

- algemeen

- voortbrengen

- gegenereerde

- genereert

- generatief

- generatieve AI

- gift

- gegeven

- geeft

- Vrijgevigheid

- Go

- doel

- GPU's

- gids

- HAD

- hamer

- handvat

- Behandeling

- Hard

- Hebben

- veilige haven

- hoofd

- heavy-duty

- hulp

- geholpen

- het helpen van

- helpt

- zeer

- houdt

- hoopt

- Hoe

- Echter

- HTTPS

- menselijk

- i

- ideeën

- het identificeren van

- if

- beeld

- Impact

- uitvoeren

- implementaties

- belangrijk

- belangrijker

- in

- Inclusief

- beïnvloeden

- informatie

- eerste

- geïnitieerd

- invoer

- verkrijgen in plaats daarvan

- voornemens zijn

- in

- betrokken zijn

- gaat

- waarbij

- iOS

- IT

- HAAR

- zelf

- Jobomschrijving:

- voor slechts

- KDnuggets

- blijven

- bekend

- taal

- Groot

- grootschalig

- grotendeels

- later

- leidend

- LEARN

- geleerd

- leren

- Verlof

- Erkend

- levensduur

- als

- Waarschijnlijk

- Beperkt

- lot

- machine

- machine learning

- Machine Learning-technieken

- gemaakt

- maken

- MERKEN

- veel

- massief

- Match

- wiskundig

- gemiddelde

- mechanisme

- mentoren

- methoden

- macht

- miljoenen

- vermist

- mengsel

- model

- modellering

- modellen

- maanden

- meer

- efficiënter

- meest

- bewegend

- veel

- Dan moet je

- my

- Naturel

- Natuurlijke taal

- Natural Language Processing

- Noodzaak

- behoeften

- netwerken

- Neural

- neurale netwerken

- New

- volgende

- noorden

- Noord-Amerika

- notitieboekje

- nu

- shading

- nummers

- verkregen

- of

- on

- EEN

- Slechts

- OpenAI

- optimalisatie

- Optimaliseer

- optimaliseren

- Opties

- or

- Overige

- onze

- uit

- resultaten

- over

- overschat

- parameters

- ouders

- deel

- bijzonder

- patronen

- uitvoeren

- prestatie

- kiezen

- beeld

- baanbrekende

- plaats

- platform

- Plato

- Plato gegevensintelligentie

- PlatoData

- Spelen

- potentieel

- krachtige

- Precies

- voorspellen

- het voorspellen van

- Voorspellingen

- voorspellend

- voorbereiding

- primair

- waarschijnlijk

- probleem

- verwerking

- projecten

- Beloften

- gepatenteerd

- bewezen

- zorgen voor

- publiek

- in het openbaar

- queries

- vraag

- Contact

- reeks

- BIJZONDER

- motivering

- Lees

- lezing

- reden

- record

- verfijnd

- weerspiegeld

- regelgevers

- verwant

- Relaties

- relatief

- HERHAALDELIJK

- vertegenwoordigen

- te vragen

- Voorwaarden

- onderzoek

- Resources

- Reageren

- antwoord

- reacties

- REST

- resultaat

- verkregen

- onthult

- rechts

- Rol

- lopend

- s

- ervaren

- gezegde

- Wetenschap

- Wetenschapper

- zien

- lijken

- kiezen

- selecteren

- Volgorde

- reeks

- Bermuda's

- moet

- tonen

- betekenis

- aanzienlijke

- gelijk

- eenvoudigweg

- sinds

- vaardigheden

- So

- oplossing

- OPLOSSEN

- sommige

- Geluid

- geluiden

- bronnen

- specifiek

- specifiek

- spreadsheet

- SQL

- stadia

- begin

- gestart

- Stap voor

- Still

- sterke punten

- structuur

- Worstelen

- bestudeerd

- Bestuderen

- stijl

- slagen

- geslaagd

- dergelijk

- zeker

- duurzaam

- T

- aanpakken

- Nemen

- Taak

- taken

- teams

- technieken

- Technologies

- tekst

- neem contact

- dat

- De

- hun

- Ze

- Deze

- ze

- ding

- spullen

- denken

- dit

- die

- duizenden kosten

- aandraaien

- niet de tijd of

- naar

- samen

- Toon

- toolkit

- tools

- onderwerpen

- in de richting van

- opsporen

- traditioneel

- getraind

- Trainingen

- transactie

- vertalen

- Bomen

- proberen

- BEURT

- twist

- type dan:

- paraplu

- voor

- begrijpen

- begrip

- begrijpelijk

- verenigen

- onbekend

- ongeëvenaard

- us

- .

- use case

- gebruikt

- Gebruiker

- gebruikers

- toepassingen

- gebruik

- waarde

- variëteit

- divers

- groot

- zichtbaarheid

- vitaal

- vs

- wil

- Manier..

- manieren

- we

- websites

- weken

- GOED

- waren

- Wat

- Wat is

- wanneer

- welke

- en

- Waarom

- wijd

- wil

- Met

- binnen

- Woord

- woorden

- Mijn werk

- werkte

- waard

- zou

- nog

- u

- Your

- zephyrnet