Gegenereerd met Midjourney

Ondernemingen in elke branche en uithoek van de wereld haasten zich om de kracht van grote taalmodellen (LLM's) zoals OpenAI's ChatGPT, Anthropic's Claude en AI12Lab's Jurassic te integreren om de prestaties te verbeteren in een breed scala aan zakelijke toepassingen, zoals marktonderzoek, klantenservice en contentgeneratie.

Het bouwen van een LLM-applicatie op bedrijfsschaal vereist echter een andere toolset en inzicht dan het bouwen van traditionele machine learning (ML)-applicaties. Bedrijfsleiders en leidinggevenden die de merkstem en betrouwbare servicekwaliteit willen behouden, moeten een beter begrip ontwikkelen van hoe LLM's werken en de voor- en nadelen van verschillende tools in een LLM-applicatiestack.

In dit artikel geven we je een essentiële inleiding tot de strategie en tools op hoog niveau die je nodig hebt om een LLM-applicatie voor je bedrijf te bouwen en uit te voeren.

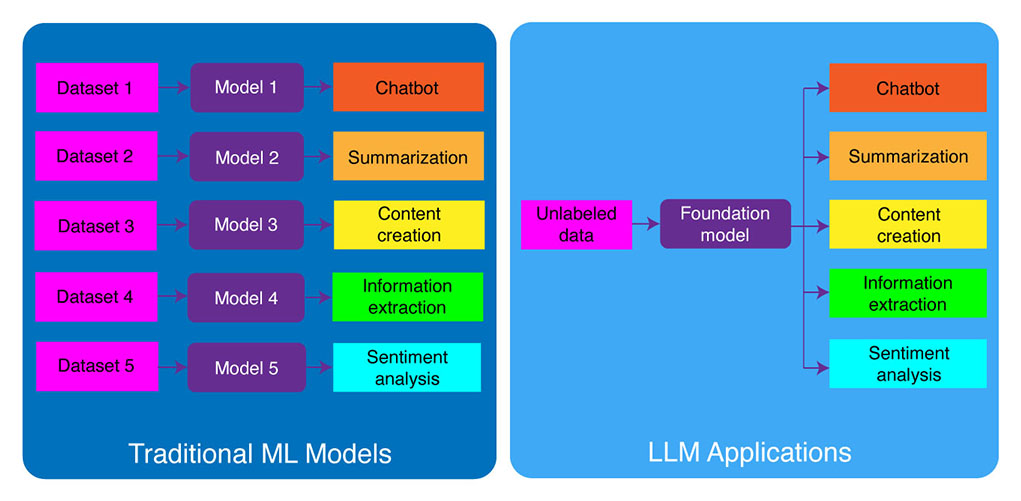

Traditionele ML-ontwikkeling versus LLM-applicaties

Traditionele machine learning-modellen waren taakspecifiek, wat betekent dat u voor elke afzonderlijke taak een apart model moest bouwen. Als u bijvoorbeeld het klantsentiment wilt analyseren, moet u één model bouwen en als u een chatbot voor klantenondersteuning wilt bouwen, moet u een ander model bouwen.

Dit proces van het bouwen en trainen van taakspecifieke ML-modellen is tijdrovend en vereist veel gegevens. Het soort datasets dat nodig is om deze verschillende ML-modellen te trainen, is ook afhankelijk van de taak. Om een model te trainen om klantsentiment te analyseren, hebt u een dataset nodig van klantrecensies die zijn gelabeld met een overeenkomstig sentiment (positief, negatief, neutraal). Om een model te trainen om een chatbot voor klantenondersteuning te bouwen, hebt u een dataset nodig van gesprekken tussen klanten en technische ondersteuning.

Grote taalmodellen hebben dit veranderd. LLM's zijn vooraf getraind op een enorme dataset van tekst en code, waardoor ze out-of-the-box goed kunnen presteren op een breed scala aan taken, waaronder:

- Tekst samenvatting

- Content creatie

- Vertaling

- Informatie-extractie

- Vraag beantwoorden

- Sentiment analyse

- Klantenservice

- Verkoopondersteuning

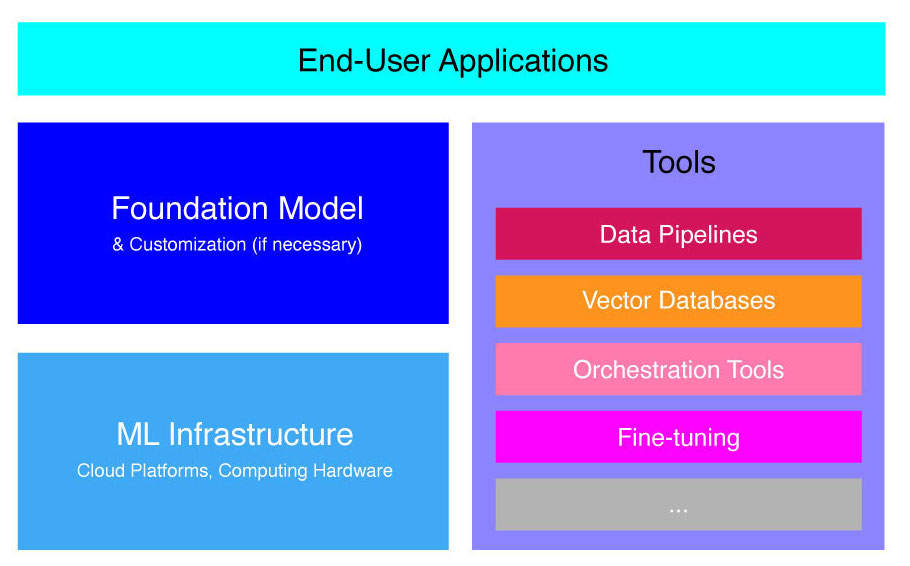

Het proces van het ontwikkelen van LLM-applicaties kan worden onderverdeeld in vier essentiële stappen:

- Kies een geschikt funderingsmodel. Het is een belangrijk onderdeel dat de prestaties van uw LLM-toepassing bepaalt.

- Pas het model indien nodig aan. Mogelijk moet u het model verfijnen of uitbreiden met de aanvullende kennisbank om aan uw specifieke behoeften te voldoen.

- Stel ML-infrastructuur in. Dit omvat de hardware en software die nodig is om uw toepassing uit te voeren (dwz halfgeleiders, chips, cloudhosting, inferentie en implementatie).

- Breid uw applicatie uit met extra tools. Deze hulpprogramma's kunnen de efficiëntie, prestaties en beveiliging van uw toepassing helpen verbeteren.

Laten we nu eens kijken naar de overeenkomstige technologiestapel.

Als deze diepgaande educatieve inhoud nuttig voor u is, abonneer je op onze AI-mailinglijst om gewaarschuwd te worden wanneer we nieuw materiaal uitbrengen.

LLM-applicatiestack op hoog niveau

LLM-applicaties zijn gebouwd op verschillende belangrijke componenten, waaronder:

- Een funderingsmodel, waarvoor in specifieke gebruikssituaties mogelijk maatwerk nodig is.

- ML-infrastructuur voor voldoende rekenkracht via cloudplatforms of eigen hardware.

- Aanvullende tools, zoals datapijplijnen, vectordatabases, orkestratietools, fijnafstemming van ML-platforms, tools voor het monitoren van modelprestaties, enz.

We gaan u kort door deze componenten leiden, zodat u de toolkit beter begrijpt die nodig is om een LLM-toepassing te bouwen en te implementeren.

Wat zijn funderingsmodellen?

Het gebruik van een enkele vooraf getrainde LLM kan u veel tijd en middelen besparen. Het trainen van een dergelijk model vanaf de basis is echter een tijdrovend en kostbaar proces dat de mogelijkheden van de meeste bedrijven te boven gaat, behalve een elite paar technologieleiders.

Verschillende bedrijven en onderzoeksteams hebben deze modellen getraind en laten andere bedrijven ze gebruiken. Toonaangevende voorbeelden zijn ChatGPT, Claude, Llama, Jurassic en T5. Deze publieksgerichte modellen worden funderingsmodellen genoemd. Sommigen van hen zijn bedrijfseigen en zijn tegen betaling toegankelijk via API-aanroepen. Anderen zijn open-source en kunnen gratis worden gebruikt. Deze modellen zijn vooraf getraind op een enorme dataset van niet-gelabelde tekstuele gegevens, waardoor ze een breed scala aan taken kunnen uitvoeren, van het genereren van creatieve advertentiekopieën tot het namens het bedrijf communiceren met uw klanten in hun moedertaal.

Er zijn twee hoofdtypen basismodellen: bedrijfseigen en open-source.

Eigen modellen zijn eigendom van één bedrijf of organisatie en zijn doorgaans alleen tegen betaling beschikbaar. Enkele van de meest populaire voorbeelden van propriëtaire modellen zijn GPT-modellen van OpenAI, Claude-modellen van Anthropic en Jurassic-modellen van AI21 Labs.

Open source-modellen zijn meestal gratis beschikbaar voor iedereen die ze wil gebruiken. Sommige open-sourcemodellen hebben echter beperkingen op het gebruik ervan, zoals: (1) ze zijn alleen beschikbaar voor onderzoeksdoeleinden, (2) ze zijn alleen beschikbaar voor commercieel gebruik door bedrijven van een bepaalde omvang. De open-sourcegemeenschap beweert dat het stellen van dergelijke beperkingen niet toelaat dat een model als "open-source" wordt aangemerkt. Toch zijn de meest prominente voorbeelden van taalmodellen die gratis kunnen worden gebruikt, Llama-modellen van Meta, Falcon-modellen van het Technology Innovation Institute in Abu Dhabi en StableLM-modellen van Stability AI. Lees meer over open-source modellen en de bijbehorende risico's hier.

Laten we nu een aantal factoren bespreken waarmee u rekening moet houden bij het kiezen van een basismodel voor uw LLM-toepassing.

Kies een funderingsmodel

Het selecteren van het beste basismodel voor uw LLM-toepassing kan een uitdagend proces zijn, maar we kunnen het in principe opsplitsen in drie stappen:

- Kies tussen propriëtaire en open-source modellen. Gepatenteerde modellen zijn doorgaans groter en capabeler dan open-sourcemodellen, maar ze kunnen duurder in gebruik en minder flexibel zijn. Bovendien is de code niet zo transparant, wat het moeilijk maakt om problemen met de prestaties van propriëtaire modellen te debuggen of op te lossen. Open-sourcemodellen krijgen daarentegen meestal minder updates en minder ondersteuning van de ontwikkelaars.

- Kies de maat van het model. Grotere modellen zijn meestal beter in het uitvoeren van taken die veel kennis vereisen, zoals het beantwoorden van vragen of het genereren van creatieve tekst. Grotere modellen zijn echter ook rekenkundig duurder in gebruik. U kunt beginnen met het experimenteren met grotere modellen en vervolgens naar kleinere modellen gaan, zolang de prestaties van een model bevredigend zijn voor uw gebruiksscenario.

- Selecteer een specifiek model. U kunt beginnen met het bekijken van de algemene benchmarks om de modellen op de shortlist te zetten om te testen. Ga vervolgens verder met het testen van verschillende modellen voor uw toepassingsspecifieke opdrachten. Overweeg berekeningen voor aangepaste benchmarking BLEU- en ROUGE-scores, de statistieken die helpen bij het kwantificeren van het aantal correcties dat nodig is voor door AI gegenereerde tekst voordat de uitvoer wordt vrijgegeven voor human-in-the-loop-toepassingen.

Voor een beter begrip van de verschillen tussen verschillende taalmodellen, ga naar ons overzicht van de krachtigste taal- (LLM) en beeldtaalmodellen (VLM).

Nadat u een basismodel voor uw toepassing hebt gekozen, kunt u overwegen of u het model moet aanpassen voor nog betere prestaties.

Een funderingsmodel aanpassen

In sommige gevallen wilt u misschien een basistaalmodel aanpassen voor betere prestaties in uw specifieke gebruikssituatie. U wilt bijvoorbeeld optimaliseren voor een bepaald:

- Domein. Als u actief bent in specifieke domeinen, zoals juridische, financiële of gezondheidszorg, wilt u misschien de woordenschat van het model in dit domein verrijken, zodat het de vragen van eindgebruikers beter kan begrijpen en beantwoorden.

- Taak. Als u bijvoorbeeld wilt dat het model marketingcampagnes genereert, kunt u het voorzien van specifieke voorbeelden van merkgerelateerde marketinginhoud. Dit zal het model helpen de patronen en stijlen te leren die geschikt zijn voor uw bedrijf en publiek.

- Toon van stem. Als u wilt dat het model een specifieke tone-of-voice gebruikt, kunt u het model aanpassen op een dataset die voorbeelden bevat van uw beoogde taalvoorbeelden.

Er zijn drie mogelijke manieren om een basistaalmodel aan te passen:

- Scherpstellen: voorziet het model van een domeinspecifieke gelabelde dataset van ongeveer 100-500 records. De modelgewichten worden bijgewerkt, wat zou moeten resulteren in betere prestaties op de taken die door deze dataset worden vertegenwoordigd.

- Domein aanpassing: voorziet het model van een domeinspecifieke niet-gelabelde dataset die een groot corpus aan gegevens van het corresponderende domein bevat. De modelgewichten worden in dit geval ook bijgewerkt.

- Informatie ophalen: vult het basismodel aan met gesloten-domeinkennis. Het model wordt niet opnieuw getraind en de gewichten van het model blijven hetzelfde. Het model mag echter informatie ophalen uit een vectordatabase met relevante gegevens.

De eerste twee benaderingen vereisen aanzienlijke computerresources om het model opnieuw te trainen, wat meestal alleen haalbaar is voor grote bedrijven met het juiste technische talent om de aanpassing te beheren. Kleinere bedrijven gebruiken meestal de meer gebruikelijke benadering om het model uit te breiden met domeinkennis via een vectordatabase, die we later in dit artikel in detail beschrijven in het gedeelte over LLM-tools.

Stel ML-infrastructuur in

De ML-infrastructuurcomponent van het LLMOps-landschap omvat de cloudplatforms, computerhardware en andere bronnen die nodig zijn om LLM's te implementeren en uit te voeren. Dit onderdeel is met name relevant als u ervoor kiest om een open-sourcemodel te gebruiken of het model voor uw toepassing aan te passen. In dit geval hebt u mogelijk aanzienlijke computerbronnen nodig om het model, indien nodig, te verfijnen en uit te voeren.

Er zijn een aantal cloudplatforms die services bieden voor het implementeren van LLM's, waaronder Google Cloud Platform, Amazon Web Services en Microsoft Azure. Deze platforms bieden een aantal functies die het eenvoudig maken om LLM's te implementeren en uit te voeren, waaronder:

- Vooraf getrainde modellen die kunnen worden afgestemd op uw specifieke toepassing

- Beheerde infrastructuur die zorgt voor de onderliggende hard- en software

- Tools en services voor het monitoren en debuggen van uw LLM's

De hoeveelheid computerresources die u nodig heeft, hangt af van de grootte en complexiteit van uw model, de taken die u wilt dat het uitvoert en de schaal van de bedrijfsactiviteit waarvoor u dit model wilt implementeren.

Vergroot met gereedschap

Aanvullende LLM-aangrenzende tools kunnen worden gebruikt om de prestaties van uw LLM-toepassing verder te verbeteren.

Data pijplijnen

Als u uw gegevens in uw LLM-product moet gebruiken, zal de datavoorverwerkingspijplijn een essentiële pijler zijn van uw nieuwe tech-stack, net als in de traditionele enterprise AI-stack. Deze tools omvatten connectoren om gegevens uit elke bron op te nemen, een gegevenstransformatielaag en downstream-connectoren. Toonaangevende aanbieders van datapijplijnen, zoals Databricks en Snowflake, en nieuwe spelers, zoals Unstructured, maken het voor ontwikkelaars gemakkelijk om grote en zeer heterogene corpora van natuurlijke taalgegevens aan te wijzen (bijv. duizenden pdf's, PowerPoint-presentaties, chatlogs, geschrapte HTML, enz.) naar een enkel toegangspunt of zelfs naar een enkel document dat verder kan worden gebruikt door LLM-toepassingen.

Vector-databases

Grote taalmodellen zijn beperkt tot het verwerken van een paar duizend woorden per keer, dus ze kunnen grote documenten zelf niet effectief verwerken. Om de kracht van grote documenten te benutten, moeten bedrijven vectordatabases gebruiken.

Vectordatabases zijn opslagsystemen die grote documenten die ze via datapijplijnen ontvangen, omzetten in beheersbare vectoren of inbeddingen. LLM-toepassingen kunnen deze databases vervolgens doorzoeken om de juiste vectoren te lokaliseren, waarbij alleen de noodzakelijke klompjes informatie worden geëxtraheerd.

Enkele van de meest prominente vectordatabases die momenteel beschikbaar zijn, zijn Pinecone, Chroma en Weaviate.

Orkestratietools

Wanneer een gebruiker een vraag indient bij uw LLM-toepassing, zoals een vraag voor de klantenservice, moet de toepassing een reeks prompts opstellen voordat deze vraag naar het taalmodel wordt verzonden. Het uiteindelijke verzoek aan het taalmodel bestaat doorgaans uit een door de ontwikkelaar hard gecodeerd promptsjabloon, voorbeelden van geldige outputs, zogenaamde few-shot-voorbeelden, alle benodigde informatie die is opgehaald uit externe API's en een reeks relevante documenten die zijn opgehaald uit de vectordatabase. . Orkestratietools van bedrijven als LangChain of LlamaIndex kunnen helpen dit proces te stroomlijnen door kant-en-klare frameworks te bieden voor het beheren en uitvoeren van prompts.

Scherpstellen

Grote taalmodellen die zijn getraind op enorme datasets kunnen grammaticaal correcte en vloeiende tekst produceren. Het kan echter zijn dat ze op bepaalde gebieden, zoals medicijnen of rechten, niet nauwkeurig zijn. Door deze modellen af te stemmen op domeinspecifieke datasets kunnen ze de unieke kenmerken van die gebieden internaliseren, waardoor ze beter in staat zijn om relevante tekst te genereren.

Het verfijnen van een LLM kan een kostenintensief proces zijn voor kleine bedrijven. Oplossingen van bedrijven als Weights & Biases en OctoML kunnen echter helpen bij een gestroomlijnde en efficiënte afstemming. Deze oplossingen bieden bedrijven een platform om LLM's te verfijnen zonder te hoeven investeren in hun eigen infrastructuur.

andere hulpmiddelen

Er zijn veel andere tools die nuttig kunnen zijn voor het bouwen en uitvoeren van LLM-applicaties. U hebt bijvoorbeeld labeltools nodig als u het model wilt verfijnen met uw specifieke gegevensvoorbeelden. Mogelijk wilt u ook specifieke hulpprogramma's implementeren om de prestaties van uw toepassing te bewaken, aangezien zelfs kleine wijzigingen in het basismodel of verzoeken van klanten een aanzienlijke invloed kunnen hebben op de prestaties van prompts. Ten slotte zijn er tools die de veiligheid van modellen bewaken om te voorkomen dat u haatdragende inhoud, gevaarlijke aanbevelingen of vooroordelen promoot. De noodzaak en het belang van deze verschillende tools hangt af van uw specifieke gebruikssituatie.

Wat is de toekomst in LLM-toepassingsontwikkeling?

De vier stappen voor LLM-productontwikkeling die we hier hebben besproken, vormen een essentiële basis van de generatieve AI-strategie van elke onderneming die gebruikmaakt van grote taalmodellen. Ze zijn belangrijk voor niet-technische bedrijfsleiders om te begrijpen, zelfs als u een technisch team hebt dat de details implementeert. We zullen in de toekomst meer gedetailleerde tutorials publiceren over hoe we het brede scala aan generatieve AI-tools op de markt kunnen benutten. Voor nu kan dat abonneren op onze nieuwsbrief om de laatste updates te krijgen.

Geniet van dit artikel? Meld u aan voor meer zakelijke AI-updates.

We laten het u weten wanneer we meer samenvattende artikelen zoals deze vrijgeven.

Verwant

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://www.topbots.com/llm-product-development-technology-stack/

- :is

- :niet

- :waar

- $UP

- 1

- a

- vermogen

- Over

- abu dhabi

- toegang

- geraadpleegde

- activiteit

- Ad

- Extra

- Daarnaast

- aangrenzend

- AI

- AI-strategie

- toelaten

- toegestaan

- toestaat

- ook

- Amazone

- Amazon Web Services

- bedragen

- an

- analyseren

- en

- Nog een

- antropisch

- elke

- iedereen

- api

- APIs

- Aanvraag

- Application Development

- toepassingen

- nadering

- benaderingen

- passend

- ZIJN

- gebieden

- dit artikel

- artikelen

- AS

- geassocieerd

- At

- gehoor

- Beschikbaar

- vermijd

- Azuur

- baseren

- Eigenlijk

- BE

- geweest

- vaardigheden

- namens

- wezen

- benchmarking

- benchmarks

- BEST

- Betere

- tussen

- Verder

- vooroordelen

- boost

- Box camera's

- merk

- branded

- Breken

- kort

- Kapot

- bouw

- Gebouw

- bebouwd

- bedrijfsdeskundigen

- Business Applications

- Zakelijke leiders

- ondernemingen

- maar

- by

- het berekenen van

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- oproepen

- Campagnes

- CAN

- mogelijkheden

- in staat

- verzorging

- geval

- gevallen

- zeker

- uitdagend

- veranderd

- Wijzigingen

- Chatbot

- ChatGPT

- controle

- chips

- Kies

- het kiezen van

- uitgekozen

- vorderingen

- Cloud

- Cloud Hosting

- Cloud Platform

- code

- commercieel

- Gemeen

- communiceren

- gemeenschap

- Bedrijven

- afstand

- Bedrijf

- ingewikkeldheid

- bestanddeel

- componenten

- samengesteld

- computergebruik

- NADELEN

- Overwegen

- bouwen

- bevat

- content

- conversaties

- kopieën

- Hoek

- te corrigeren

- Correcties

- Overeenkomend

- kostbaar

- Creatieve

- Op dit moment

- gewoonte

- klant

- Klantenservice

- Klantenservice

- Klanten

- maatwerk

- aan te passen

- gevaarlijk

- gegevens

- Database

- databanken

- Databricks

- datasets

- diepere

- het definiëren van

- Afhankelijk

- implementeren

- het inzetten

- inzet

- detail

- gedetailleerd

- gegevens

- ontwikkelen

- Ontwikkelaar

- ontwikkelaars

- het ontwikkelen van

- Ontwikkeling

- Dhabi

- verschillen

- anders

- moeilijk

- bespreken

- besproken

- document

- documenten

- Nee

- domein

- domeinen

- beneden

- e

- elk

- En het is heel gemakkelijk

- onderwijs

- effectief

- doeltreffendheid

- doeltreffend

- de elite

- waardoor

- verhogen

- verbeteren

- verrijken

- Enterprise

- vooral

- essentieel

- etc

- Ether (ETH)

- Zelfs

- Alle

- voorbeeld

- voorbeelden

- Behalve

- uitvoeren

- leidinggevende

- duur

- extern

- factoren

- valk

- uitvoerbaar

- Voordelen

- honorarium

- weinig

- minder

- finale

- Tot slot

- financieel

- Voornaam*

- flexibel

- Voor

- Foundation

- vier

- frameworks

- Gratis

- oppompen van

- verder

- toekomst

- Algemeen

- voortbrengen

- het genereren van

- generatie

- generatief

- generatieve AI

- krijgen

- Geven

- wereldbol

- Go

- gaan

- Kopen Google Reviews

- Google Cloud

- Google Cloud Platform

- Ground

- hand

- Hardware

- harnas

- Hebben

- met

- gezondheidszorg

- hulp

- hier

- high-level

- zeer

- Hosting

- Hoe

- How To

- Echter

- HTML

- HTTPS

- i

- if

- Impact

- uitvoering

- belang

- belangrijk

- verbeteren

- in

- diepgaande

- omvatten

- omvat

- Inclusief

- -industrie

- informatie

- Infrastructuur

- Innovatie

- Instituut

- integreren

- in

- Introductie

- Investeren

- IT

- jpg

- voor slechts

- sleutel

- Soort

- blijven

- kennis

- etikettering

- Labs

- Gebrek

- Landschap

- taal

- Groot

- groter

- later

- laatste

- Laatste updates

- Wet

- lagen

- leiders

- leidend

- LEARN

- leren

- Juridisch

- minder

- Hefboomwerking

- hefbomen

- als

- beperkingen

- Beperkt

- Lama

- lang

- Kijk

- lot

- machine

- machine learning

- Hoofd

- maken

- MERKEN

- beheer

- beheren

- veel

- Markt

- marktonderzoek

- Marketing

- Marketing campagnes

- markt

- massief

- materiaal

- max-width

- Mei..

- betekenis

- geneeskunde

- Maak kennis met

- meta

- Metriek

- Microsoft

- Microsoft Azure

- macht

- minder

- ML

- model

- modellen

- monitor

- Grensverkeer

- meer

- meest

- Meest populair

- inheemse

- Naturel

- Natuurlijke taal

- noodzakelijk

- Noodzaak

- nodig

- behoeften

- negatief

- Neutraal

- New

- Nieuwe technologie

- Nieuwsbrief

- volgende

- niet-technische

- nu

- aantal

- of

- bieden

- on

- EEN

- degenen

- Slechts

- open source

- OpenAI

- besturen

- Optimaliseer

- or

- orkestratie

- organisatie

- Overige

- Overig

- onze

- uit

- uitgang

- overzicht

- het te bezitten.

- eigendom

- patronen

- uitvoeren

- prestatie

- uitvoerend

- Pijler

- pijpleiding

- platform

- platforms

- Plato

- Plato gegevensintelligentie

- PlatoData

- spelers

- punt

- Populair

- positief

- mogelijk

- energie

- krachtige

- precisie

- Presentaties

- problemen

- verwerking

- produceren

- Product

- productontwikkeling

- vooraanstaand

- Het bevorderen van

- gepatenteerd

- PROS

- zorgen voor

- providers

- biedt

- het verstrekken van

- publiceren

- doeleinden

- Putting

- kwalificeren

- kwaliteit

- queries

- vraag

- Contact

- reeks

- Lees

- ontvangen

- aanbevelingen

- archief

- los

- het vrijgeven van

- relevante

- betrouwbaar

- vertegenwoordigd

- te vragen

- verzoeken

- vereisen

- vereist

- onderzoek

- Resources

- Reageren

- beperkingen

- resultaat

- herzien

- Recensies

- rechts

- risico's

- lopen

- lopend

- Veiligheid

- dezelfde

- Bespaar

- Scale

- sectie

- veiligheid

- Halfgeleiders

- sentiment

- apart

- -Series

- service

- Diensten

- reeks

- verscheidene

- moet

- teken

- aanzienlijke

- aanzienlijk

- single

- Maat

- Klein

- kleinere

- So

- Software

- Oplossingen

- sommige

- bron

- specifiek

- Stabiliteit

- stack

- begin

- blijven

- Stappen

- Still

- mediaopslag

- Strategie

- gestroomlijnd

- gestroomlijnd

- stijlen

- dergelijk

- voldoende

- OVERZICHT

- ondersteuning

- Systems

- Nemen

- neemt

- Talent

- doelwit

- Taak

- taken

- team

- teams

- tech

- Technisch

- technische hulp

- Technologie

- technologische innovatie

- sjabloon

- Testen

- neem contact

- dat

- De

- De toekomst

- hun

- Ze

- harte

- Er.

- Deze

- ze

- dit

- die

- duizenden kosten

- drie

- Door

- niet de tijd of

- tijdrovend

- naar

- TONE

- Tone of Voice

- toolkit

- tools

- top

- TOPBOTS

- traditioneel

- Trainen

- getraind

- Trainingen

- Transformeren

- Transformatie

- transparant

- tutorials

- twee

- types

- typisch

- die ten grondslag liggen

- begrijpen

- begrip

- unieke

- unieke kenmerken

- bijgewerkt

- updates

- .

- use case

- gebruikt

- Gebruiker

- doorgaans

- divers

- via

- Stem

- vs

- willen

- gezocht

- wil

- manieren

- we

- web

- webservices

- GOED

- waren

- wanneer

- of

- welke

- WIE

- breed

- Grote range

- wil

- Met

- zonder

- woorden

- Mijn werk

- zou

- u

- Your

- zephyrnet