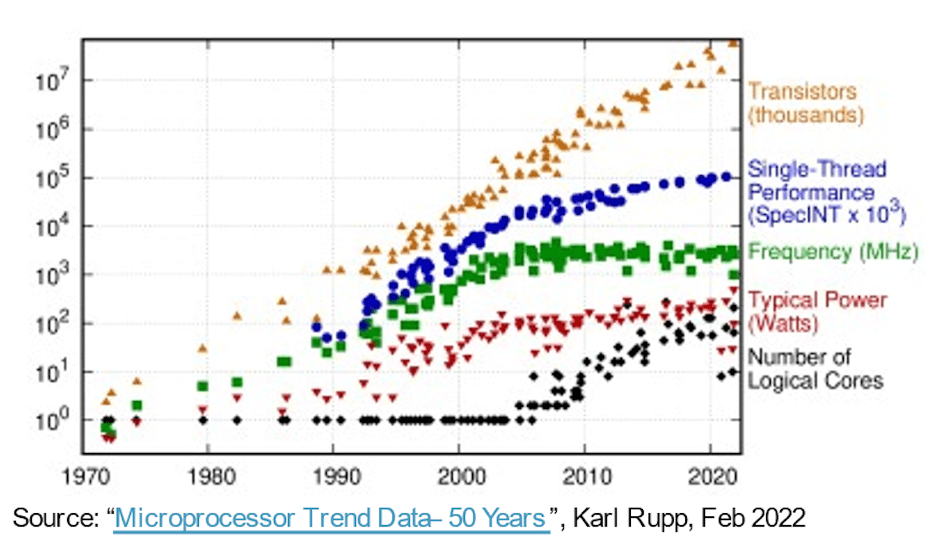

In de mars naar meer capabele, snellere, kleinere en energiezuinigere systemen gaf de wet van Moore software ruim dertig jaar lang gratis toegang, puur en alleen op het gebied van de evolutie van halfgeleiderprocessen. Compute-hardware leverde elk jaar betere prestatie-/oppervlakte-/vermogensstatistieken op, waardoor de software in complexiteit kon uitbreiden en meer mogelijkheden kon bieden zonder nadelen. Toen werden de gemakkelijke overwinningen minder eenvoudig. Geavanceerdere processen bleven hogere poortaantallen per oppervlakte-eenheid opleveren, maar de winst in prestatie en vermogen begon af te vlakken. Omdat onze verwachtingen ten aanzien van innovatie niet zijn opgehouden, zijn de ontwikkelingen op het gebied van de hardwarearchitectuur belangrijker geworden om de achterstand op te vangen.

Drijfveren voor het verhogen van het aantal cores

Bij een eerste stap in deze richting werd gebruik gemaakt van multi-core CPU's om de totale doorvoer te versnellen door een mix van gelijktijdige taken over cores heen te threaden of te virtualiseren, waardoor het stroomverbruik indien nodig werd verminderd door inactieve cores stationair te draaien of uit te schakelen. Multi-core is tegenwoordig standaard en een trend in Many-Core (nog meer CPU's op een chip) is al duidelijk zichtbaar in de serverinstance-opties die beschikbaar zijn in cloudplatforms van AWS, Azure, Alibaba en anderen.

Multi-/many-core architecturen zijn een stap voorwaarts, maar parallellisme via CPU-clusters is grofkorrelig en heeft zijn eigen prestatie- en vermogenslimieten, dankzij de wet van Amdahl. Architecturen werden heterogener en voegden versnellers toe voor beeld, audio en andere gespecialiseerde behoeften. AI-versnellers hebben ook een fijnkorrelig parallellisme bevorderd, waarbij ze zijn overgegaan op systolische arrays en andere domeinspecifieke technieken. Dat werkte redelijk goed totdat ChatGPT verscheen met 175 miljard parameters, waarbij GPT-3 evolueerde naar GPT-4 met 100 biljoen parameters – ordes van grootte complexer dan de huidige AI-systemen – waardoor nog meer gespecialiseerde versnellingsfuncties binnen AI-versnellers werden afgedwongen.

Op een ander front worden multisensorsystemen in automobieltoepassingen nu geïntegreerd in afzonderlijke SoC's voor een beter milieubewustzijn en een betere PPA. Hier zijn nieuwe niveaus van autonomie in de automobielsector afhankelijk van het samenvoegen van input van meerdere sensortypen binnen één enkel apparaat, in subsystemen die 2X, 4X of 8X repliceren.

Volgens Michał Siwinski (CMO bij Arteris) wijst een steekproef van gesprekken van een maand met meerdere ontwerpteams over een breed scala aan toepassingen erop dat deze teams zich actief wenden tot hogere kernaantallen om te voldoen aan de doelstellingen op het gebied van capaciteit, prestaties en vermogen. Hij vertelt me dat ze deze trend ook zien versnellen. Procesverbeteringen helpen nog steeds bij het tellen van de SoC-poorten, maar de verantwoordelijkheid voor het behalen van prestatie- en machtsdoelstellingen ligt nu stevig in handen van de architecten.

Meer cores, meer interconnectie

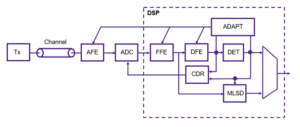

Meer kernen op een chip impliceren meer dataverbindingen tussen die kernen. Binnen een versneller tussen aangrenzende verwerkingselementen, naar lokale cache, naar versnellers voor schaarse matrix en andere gespecialiseerde afhandeling. Voeg hiërarchische connectiviteit toe tussen acceleratortegels en bussen op systeemniveau. Voeg connectiviteit toe voor gewichtsopslag op de chip, decompressie, uitzending, verzameling en hercompressie. Voeg HBM-connectiviteit toe voor werkcache. Voeg indien nodig een fusiemotor toe.

Het CPU-gebaseerde controlecluster moet verbinding maken met elk van deze gerepliceerde subsystemen en met alle gebruikelijke functies: codecs, geheugenbeheer, veiligheidseiland en root of trust indien van toepassing, UCIe als het een implementatie met meerdere chiplets betreft, PCIe voor I/O met hoge bandbreedte en Ethernet of glasvezel voor netwerken.

Dat zijn veel onderlinge verbindingen, met directe gevolgen voor de verkoopbaarheid van producten. Bij processen onder 16 nm draagt de NoC-infrastructuur nu 10-12% bij aan de oppervlakte. Nog belangrijker is dat het, als communicatiesnelweg tussen kernen, een aanzienlijke impact kan hebben op de prestaties en het vermogen. Er bestaat een reëel gevaar dat een suboptimale implementatie de verwachte architectuurprestaties en vermogenswinsten zal verspillen, of erger nog, zal resulteren in talloze herontwerplussen die convergeren. Toch is het vinden van een goede implementatie in een complexe SoC-plattegrond nog steeds afhankelijk van langzame 'trial-and-error'-optimalisaties in toch al strakke ontwerpschema's. We moeten de sprong maken naar fysiek bewust NoC-ontwerp, om volledige prestaties en stroomondersteuning van complexe NoC-hiërarchieën te garanderen, en we moeten deze optimalisaties sneller maken.

Fysiek bewuste NoC-ontwerpen houden de wet van Moore op koers

De wet van Moore is misschien niet dood, maar de vooruitgang op het gebied van prestaties en kracht is tegenwoordig te danken aan architectuur en NoC-interconnectie in plaats van aan processen. De architectuur stimuleert meer acceleratorkernen, meer versnellers binnen versnellers en meer subsysteemreplicatie op de chip. Ze verhogen allemaal de complexiteit van on-chip interconnectie. Naarmate ontwerpen het aantal kernen vergroten en overgaan op procesgeometrieën op 16 nm en lager, kunnen de talrijke NoC-verbindingen die de SoC en zijn subsystemen omspannen alleen het volledige potentieel van deze complexe ontwerpen ondersteunen als ze optimaal worden geïmplementeerd tegen fysieke en timingbeperkingen – via een fysiek bewust netwerk. op chipontwerp.

Als u zich ook zorgen maakt over deze trends, wilt u misschien meer weten over Arteris FlexNoC 5 IP-technologie HIER.

Deel dit bericht via:

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://semiwiki.com/artificial-intelligence/326727-interconnect-under-the-spotlight-as-core-counts-accelerate/

- :is

- $UP

- 100

- a

- Over

- versnellen

- versnellen

- versnelling

- versneller

- versnellers

- over

- actief

- vergevorderd

- voorschotten

- tegen

- AI

- AI-systemen

- Alibaba

- Alles

- Het toestaan

- al

- en

- verscheen

- toepassingen

- passend

- architectuur

- ZIJN

- GEBIED

- AS

- At

- audio

- automotive

- Beschikbaar

- bewustzijn

- AWS

- Azuur

- bandbreedte

- BE

- worden

- onder

- tussen

- Miljard

- uitzenden

- bussen

- by

- cache

- CAN

- in staat

- ChatGPT

- spaander

- Cloud

- TROS

- CMO

- hoe

- Communicatie

- complex

- ingewikkeldheid

- Berekenen

- gelijktijdig

- Verbinden

- aansluitingen

- Connectiviteit

- Gevolgen

- beperkingen

- voortgezet

- onder controle te houden

- convergeren

- Kern

- CPU

- GEVAAR

- gegevens

- dood

- leveren

- geleverd

- afhankelijk

- Design

- ontwerpen

- apparaat

- anders

- directe

- richting

- discussies

- beneden

- minpunten

- elk

- Vroeg

- geeft je de mogelijkheid

- Motor

- Milieu

- Zelfs

- Alle

- Evolutie

- evoluerende

- Uitvouwen

- verwachtingen

- verwacht

- sneller

- Voordelen

- het vinden van

- stevig

- Voor

- Naar voren

- Gratis

- oppompen van

- voor

- vol

- functies

- fusie

- verdiensten

- Doelen

- goed

- garantie

- Behandeling

- handen

- Hardware

- Hebben

- hulp

- hier

- Hoge

- hoger

- Snelweg

- HTTPS

- beeld

- Impact

- uitvoering

- geïmplementeerd

- belangrijk

- verbeterd

- in

- inactief

- Laat uw omzet

- meer

- Infrastructuur

- Innovatie

- instantie

- Integreren

- IP

- eiland

- IT

- HAAR

- springen

- Wet

- LEARN

- Niveau

- niveaus

- grenzen

- lokaal

- lot

- maken

- management

- Maart

- Matrix

- max-width

- Maak kennis met

- vergadering

- Geheugen

- Metriek

- macht

- Maand

- meer

- beweging

- bewegend

- meervoudig

- Noodzaak

- nodig

- behoeften

- netwerk

- netwerken

- New

- vele

- of

- on

- Opties

- orders

- Overige

- Overig

- het te bezitten.

- parameters

- prestatie

- Fysiek

- fysiek

- platforms

- Plato

- Plato gegevensintelligentie

- PlatoData

- Post

- potentieel

- energie

- Powering

- mooi

- processen

- verwerking

- Product

- puur

- geduwd

- voortvarend

- reeks

- liever

- vast

- vermindering

- gerepliceerd

- kopiëren

- verantwoordelijkheid

- resultaat

- Rijden

- wortel

- Veiligheid

- halfgeleider

- aanzienlijke

- sinds

- single

- speling

- traag

- kleinere

- So

- Software

- schaarse matrix

- gespecialiseerde

- Spotlight

- standaard

- gestart

- Stap voor

- Still

- stop

- mediaopslag

- Stelt voor

- ondersteuning

- system

- Systems

- taken

- teams

- technieken

- Technologie

- vertelt

- dat

- De

- Deze

- Door

- doorvoer

- timing

- naar

- vandaag

- vandaag

- Totaal

- trend

- Trends

- Triljoen

- Trust

- Draai

- types

- voor

- eenheid

- via

- gewicht

- GOED

- welke

- breed

- Grote range

- wil

- Wint

- Met

- binnen

- werkzaam

- jaar

- jaar

- zephyrnet