Je hebt met succes je uitgevoerd A / B-tests, analyseerde de gegevens minutieus en maakte strategische beslissingen op basis van de resultaten. Er ontstaat echter een raadselachtige situatie als de resultaten worden waargenomen in die verfijnde A / B testtools komen niet overeen met waarnemingen uit de echte wereld.

Wat geeft? Welkom in de wereld van de discrepantie tussen A/B-testtools en waarnemingen uit het echte leven. Het is een wilde rit waar factoren als statistische variantie, steekproefbias, contextuele verschillen, technische storingen, verkeerde afstemming van de tijdinvestering veilig is en u uw kans vergroot op regressie naar het gemiddelde kan uw zorgvuldig berekende resultaten afwerpen.

Doe je gordel om terwijl we ingaan op de kern van waarom deze afwijkingen gebeuren en wat je eraan kunt doen.

Technische problemen

A/B-testtools vertrouwen op JavaScript-code of andere technische implementaties om gebruikers toe te wijzen aan verschillende variaties. Ondanks hoe robuust ze zijn, zijn deze tools dat wel niet immuun voor technische problemen die de nauwkeurigheid van hun resultaten kunnen beïnvloeden. Bijvoorbeeld, scriptfouten binnen de uitvoering kan voorkomen, voorkomen juiste tracking van gebruikersinteracties of leidt tot foutieve toewijzing van gebruikers tot variaties. Deze fouten kunnen de gegevens verstoren incassotraject en inconsistenties introduceren in de behaalde resultaten. Bovendien zijn er compatibiliteitsproblemen met verschillende webbrowsers or variaties in caching-mechanismen kan mogelijk de functionaliteit van het hulpprogramma beïnvloeden leiden tot afwijkingen tussen de waargenomen en daadwerkelijke gebruikerservaring.

Bovendien is de impact van technische problemen kan variëren afhankelijk van de complexiteit van de website or toepassing wordt getest. Websites met complexe gebruikerspaden or dynamische inhoud zijn bijzonder gevoelig voor technische uitdagingen die dat wel kunnen het A/B-testen verstoren proces. De aanwezigheid van scripts van derden or integraties kan de zaken nog ingewikkelder maken, zoals conflicten or fouten in deze componenten kan interfereren met de nauwkeurige tracking van gebruikersgedrag. Deze technische complexiteiten benadrukken het belang van grondig testen en kwaliteitsborging om de goede werking van A / B testtools en minimaliseer de kans op afwijkingen tussen de resultaten van de tools en de werkelijke prestaties van de variaties in real-world scenario's.

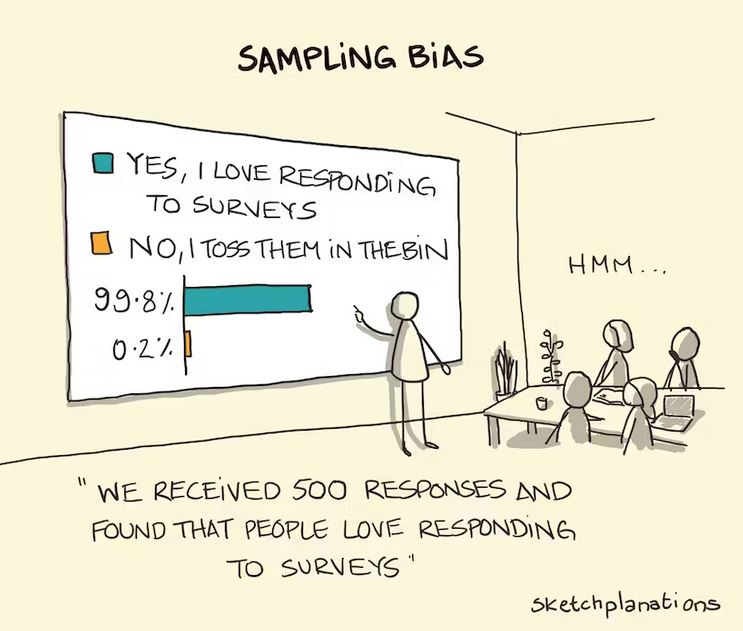

Bemonstering vooringenomenheid

A/B-testtools wijzen gebruikers vaak toe verschillende variaties willekeurig. Vanwege de willekeurige aard van de opdracht kunnen er echter gevallen zijn waarin bepaalde gebruikerssegmenten zijn onevenredig vertegenwoordigd in de ene variatie in vergelijking met de andere. Dit kan introduceren vooringenomenheid en de resultaten beïnvloeden waargenomen in het gereedschap. Als een bepaalde variant bijvoorbeeld vaker wordt getoond aan gebruikers die dat wel zijn al geneigd om een aankoop te doen, kan het kunstmatig worden opgeblazen de omrekeningskoers voor die variatie.

Evenzo, als een een bepaald gebruikerssegment is ondervertegenwoordigd in een variatie, de tool mag niet vastleggen hun gedrag adequaat, leidend tot onjuiste conclusies over de effectiviteit van de variatie. Dit steekproefbias kan een maken discrepantie tussen de verkregen resultaten van AB-testtools en de feitelijk gedrag van de bredere gebruikersgroep.

Verkeerde uitlijning van het tijdsbestek

Meestal A/B-testtools gegevens verzamelen gedurende een bepaalde periode om de resultaten te analyseren. echter, de tijdstip van gegevensverzameling in relatie tot de live performance van de variatie kan afwijkingen introduceren. Een veelvoorkomend probleem is wanneer de tool gegevens verzamelt voor een langere periode dan de periode waarin de variatie daadwerkelijk live was. In dergelijke gevallen kan de tool onbedoeld omvatten extra tijdvakken waar de prestatie van de variatie verschilde van de beoogde versie, waardoor de algehele analyse scheeftrekt. Dit kan leiden tot misleidende conclusies en een ontkoppeling tussen de de resultaten van het hulpmiddel en daadwerkelijke impact van de variatie tijdens het beoogde tijdsbestek.

Omgekeerd kunnen er ook gevallen zijn waarin de gegevensverzamelingsperiode van de A/B-testtool slaagt er niet in om het volledige effect vast te leggen van de variatie. Als de het tijdsbestek van het hulpmiddel is kortere neem contact de periode die gebruikers nodig hebben om volledig betrokken te raken met en reageren op de variatie, de resultaten kunnen niet nauwkeurig de waarheid weergeven prestatie. Dit kan gebeuren wanneer de variatie dit vereist een langere aanpassingsperiode voor gebruikers om hun gedrag aan te passen of wanneer de de impact van de variatie ontvouwt zich geleidelijk na een tijdje. In dergelijke gevallen kan de tool voortijdig conclusies trekken over de effectiviteit van de variatie, wat leidt tot een discrepantie tussen de bevindingen van de tool en de werkelijke prestaties op lange termijn in reële omstandigheden.

Naar de impact verzachten van verkeerde uitlijning van het tijdsbestek, is het van cruciaal belang om zorgvuldig plannen en synchroniseren de gegevensverzamelingsperiode van A/B-testtools met de live inzet van variaties. Hierbij hoort afstemming de begin- en einddatum van de testfase met de werkelijke tijdsbestek wanneer de variaties actief zijn. Bovendien gezien de mogelijke vertragingstijd voor gebruikers om zich aan te passen en te reageren op de veranderingen kan een meer omvattend begrip van de werkelijke impact van de variatie. Door te zorgen voor een goede afstemming van tijdschema's, kunnen bedrijven vermindering van het risico van verschillen en maak meer nauwkeurig datagedreven beslissingen op basis van de resultaten van A/B-testen.

Contextueel verschil

A/B-testtools werken vaak binnen een gecontroleerde testomgeving, waar gebruikers zijn niet op de hoogte van de test en kan zich anders gedragen in vergelijking met wanneer de variatie is live gezet in de echte wereld. Een belangrijke factor die bijdraagt aan de discrepantie tussen de resultaten van de testtool en live optreden is de nieuwigheidseffect. Wanneer gebruikers een nieuwe variatie tegenkomen in een testomgeving kunnen ze dat wel blijk geven van verhoogde nieuwsgierigheid or betrokkenheid eenvoudig omdat het anders is dan ze gewend zijn. Dit kan kunstmatig opblazen de prestatiestatistieken die zijn vastgelegd door de testtool, aangezien gebruikers mogelijk enthousiaster omgaan met de variatie dan ze zouden doen tijdens hun normale browse- of koopgedrag.

Daarnaast is de bekendheid van deel uitmaken van een experiment kan het gebruikersgedrag beïnvloeden. Wanneer gebruikers zich ervan bewust zijn dat ze deel uitmaken van een testproces, kunnen ze dat ook bewust vertonen or onbewuste vooroordelen die hun reacties kunnen beïnvloeden. Dit fenomeen, bekend als de Hawthorne-effect, verwijst naar de verandering van gedrag vanwege het besef geobserveerd of getest te worden. Gebruikers kunnen oplettender worden, zelfbewuster worden of geneigd zijn zich te gedragen op een manier die zij als wenselijk beschouwen, waardoor de resultaten van de testtool mogelijk worden vertekend. Deze discrepantie tussen het gecontroleerd testen milieu en de echte wereld kan leiden tot verschillen in gebruikersbetrokkenheid en conversieratio's wanneer de variatie buiten de testomgeving wordt geïmplementeerd. Een persoon met een scherp oog kunnen meestal de subtiele signalen opmerken die bepalen dat ze een A/B-test invoeren.

Daarnaast wordt de afwezigheid van de echte wereld context in de testomgeving kan ook van invloed zijn op gebruikersgedrag en beïnvloeden vervolgens de resultaten. In de echte wereld komen gebruikers variaties tegen binnen de context van hun dagelijks leven, waaronder een breed scala aan externe factoren, zoals tijdsdruk, concurrerende afleidingenof persoonlijke omstandigheden. Deze contextuele elementen kunnen de beslissing van de gebruiker aanzienlijk beïnvloedenhet maken van en acties. Echter, A / B testtools vaak isoleer gebruikers van deze real-world invloeden, focussen uitsluitend op de variatie zelf. Als gevolg hiervan geven de resultaten van de tool mogelijk niet nauwkeurig weer hoe gebruikers zou reageren aan de variatie wanneer ze worden geconfronteerd met de complexiteit van hun dagelijkse ervaringen. Deze discrepantie in contextuele factoren kan leiden tot verschillen in gebruikersgedrag en resultaten tussen de testtool en de live uitvoering van de variatie.

Regressie naar het gemiddelde

Bij A/B-testen wel niet ongewoon om waar te nemen extreme resultaten voor een variatie tijdens de testfase. Dit kan gebeuren door willekeurige kans, een specifiek gebruikerssegment responsiever de variatie of andere factoren dat klopt misschien niet wanneer de variatie gedurende een langere periode wordt blootgesteld aan een groter, diverser publiek. Dit fenomeen staat bekend als regressie naar het gemiddelde.

Regressie naar het gemiddelde treedt op wanneer extreem or uitschieter resultaten waargenomen tijdens het testen zijn niet duurzaam op lange termijn. Als een variatie bijvoorbeeld een significante stijging in conversie tarieven tijdens de testfase is het mogelijk dat deze piek te wijten was aan een specifieke groep van gebruikers die bijzonder ontvankelijk waren voor de veranderingen. Wanneer de variatie echter is live gezet en blootgestelde voor een groter en meer divers publiek, is het waarschijnlijk dat de eerste piek zal afnemenEn prestaties zullen convergeren naar het gemiddelde of basisniveau. Dit kan leiden tot verschillende resultaten vergeleken met wat de testtool aanvankelijk aangaf, aangezien de extreme uitkomsten die tijdens het testen zijn waargenomen, mogelijk niet indicatief zijn voor de langetermijnimpact van de variatie.

Inzicht in de begrip achteruitgang to the mean is essentieel bij het interpreteren van A/B-testresultaten. Het benadrukt het belang van niet alleen vertrouwen op de eerste testfase bevindingen maar gezien de algehele prestatie van de variatie over een meer verlengde periode. Door rekening te houden met het potentieel voor regressie naar het gemiddelde, bedrijven kan voorkomen dat er verkeerde conclusies worden getrokken or veranderingen doorvoeren gebaseerd op tijdelijke pieken or dalen waargenomen tijdens de testfase. Het onderstreept de noodzaak van een voorzichtige interpretatie van de resultaten van A/B-testen en een alomvattend beeld van de prestaties van de variant in de echte wereld.

Conclusie

Dus daar heb je het. De realiteit van A/B-testtools komt niet altijd overeen met de echte wereld resultaten die je ervaart. Het is geen fout in je analysevaardigheden of een teken dat A/B-testen onbetrouwbaar zijn. Het is gewoon de aard van het beestje.

. interpreteren van A/B-testresultaten, is het cruciaal om niet alleen te vertrouwen op de eerste bevindingen maar denk aan de de performance over het geheel van de variatie over een langere periode. Door dit te doen, kunnen bedrijven voorkomen dat er verkeerde conclusies worden getrokken or veranderingen doorvoeren gebaseerd op tijdelijke pieken of dalen die tijdens de testfase zijn waargenomen.

Om door de realiteitskloof te navigeren, is het belangrijk om te benaderen A / B-testen resultaat met een kritische blik. Wees je bewust van de beperkingen van de hulpmiddelen en rekening houden met real-world contexten. Vul uw bevindingen aan met andere onderzoeksmethoden om een uitgebreid inzicht te krijgen in de prestaties van de variant. Door een holistische benadering te volgen, bent u goed toegerust om gegevensgestuurde beslissingen te nemen die aansluiten bij de realiteit van uw gebruikers.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://blog.2checkout.com/gap-between-ab-testing-tools-and-real-outcomes/

- :is

- :niet

- :waar

- ][P

- $UP

- 32

- a

- Over

- AC

- nauwkeurigheid

- nauwkeurig

- actieve

- daadwerkelijk

- werkelijk

- aanpassen

- aanpassing

- Daarnaast

- voldoende

- invloed hebben op

- AG

- AI

- richten

- uitlijnen

- ook

- altijd

- an

- analyse

- analyseren

- geanalyseerd

- en

- Nog een

- nadering

- ZIJN

- AS

- zekerheid

- gehoor

- gemiddelde

- AVG

- vermijd

- bewust

- bewustzijn

- baseren

- gebaseerde

- Baseline

- BE

- omdat

- worden

- wezen

- tussen

- bredere

- Bladeren

- ondernemingen

- maar

- by

- berekend

- CAN

- vangen

- Het vastleggen

- voorzichtig

- gevallen

- voorzichtig

- uitdagingen

- Wijzigingen

- Collectie

- verzamelt

- vergeleken

- verenigbaarheid

- complex

- complexiteit

- ingewikkeldheid

- componenten

- uitgebreid

- voorwaarden

- Overwegen

- aangezien

- verband

- contextual

- bij te dragen

- gecontroleerd

- Camper ombouw

- en je merk te creëren

- kritisch

- cruciaal

- dagelijks

- gegevens

- Gegevensgestuurde

- beslissingen

- Afhankelijk

- inzet

- Niettegenstaande

- Bepalen

- verschillen

- anders

- discrepantie

- ontwrichten

- diversen

- Divers publiek

- do

- doen

- trekken

- twee

- duur

- gedurende

- e

- effectiviteit

- geeft je de mogelijkheid

- voorschijn

- benadrukken

- ontmoeting

- einde

- engagement

- verzekeren

- zorgen

- het invoeren van

- Milieu

- essentieel

- Ether (ETH)

- Zelfs

- alledaags

- voorbeeld

- uitgevoerd

- ervaring

- Ervaringen

- blootgestelde

- extern

- extreem

- oog

- factor

- factoren

- FAIL

- defect

- Met

- bevindingen

- fout

- gericht

- Voor

- vaak

- oppompen van

- vol

- geheel

- functionaliteit

- functionerende

- verder

- Krijgen

- kloof

- gif

- geeft

- gebeuren

- Hebben

- verhoogde

- highlights

- houden

- holistische

- Hoe

- Echter

- HTTPS

- HubSpot

- i

- if

- 면역

- Impact

- uitvoering

- geïmplementeerd

- belang

- belangrijk

- in

- Geneigd zijn

- omvatten

- omvat

- aangegeven

- indicatief

- beïnvloeden

- eerste

- eerste

- instantie

- bestemde

- interactie

- interacties

- interfereren

- interpretatie

- in

- voorstellen

- Investopedia

- problemen

- IT

- HAAR

- jpg

- voor slechts

- bekend

- groter

- leiden

- leidend

- Niveau

- Waarschijnlijk

- leven

- Lives

- lang

- langdurig

- langer

- gemaakt

- maken

- maken

- Zaken

- max-width

- Mei..

- gemiddelde

- methoden

- minutieus

- Metriek

- macht

- meer

- NATUUR

- OP DEZE WEBSITE VIND JE

- Noodzaak

- New

- Merk op..

- opgemerkt

- verkregen

- zich voordoen

- of

- korting

- vaak

- on

- EEN

- besturen

- or

- Overige

- resultaten

- buiten

- over

- totaal

- deel

- bijzonder

- vooral

- prestatie

- periode

- persoon

- fase

- een fenomeen

- plan

- Plato

- Plato gegevensintelligentie

- PlatoData

- mogelijk

- potentieel

- mogelijk

- aanwezigheid

- het voorkomen van

- gepast

- zorgen voor

- de aankoop van

- kwaliteit

- willekeurige

- reeks

- tarief

- Tarieven

- waardering

- vast

- echte wereld

- Realiteit

- opgenomen

- verwijst

- reflecteren

- regressie

- regelmatig

- relatie

- vertrouwen

- te vertrouwen

- vertegenwoordigd

- vereist

- onderzoek

- Reageren

- reacties

- resultaat

- Resultaten

- Rijden

- robuust

- lopen

- s

- scenario's

- partituur

- segment

- segmenten

- Bermuda's

- getoond

- Shows

- teken

- aanzienlijk

- situatie

- vaardigheden

- So

- uitsluitend

- geraffineerd

- specifiek

- gespecificeerd

- aar

- spikes

- begin

- statistisch

- Met goed gevolg

- dergelijk

- aanvullen

- neemt

- het nemen

- Technisch

- tijdelijk

- proef

- getest

- Testen

- neem contact

- dat

- De

- de wereld

- hun

- Ze

- Er.

- Deze

- ze

- dit

- die

- niet de tijd of

- tijdsbestek

- naar

- tools

- tools

- in de richting van

- Tracking

- waar

- typisch

- Uncommon

- underscores

- begrip

- Gebruiker

- Gebruikerservaring

- gebruikers

- Bekijk

- stemmen

- W

- was

- manieren

- we

- web

- websites

- welkom

- waren

- Wat

- wanneer

- welke

- WIE

- Waarom

- breed

- Grote range

- Wikipedia

- Wild

- wil

- Met

- binnen

- wereld

- zou

- X

- u

- Your

- zephyrnet