Onderzoekers in Australië ontwikkelen een slimme bril voor blinden, waarbij ze gebruik maken van een technologie genaamd ‘akoestische aanraking’ om beelden in geluiden om te zetten. Eerste experimenten suggereren dat deze draagbare ruimtelijke audiotechnologie mensen die blind zijn of een aanzienlijk verminderd gezichtsvermogen hebben, kan helpen objecten in de buurt te lokaliseren.

Recente verbeteringen in augmented reality, praktische draagbare cameratechnologie en op deep learning gebaseerd computervisie versnellen de ontwikkeling van slimme brillen als een haalbare en multifunctionele ondersteunende technologie voor mensen die blind of slechtziend zijn. Dergelijke slimme brillen bevatten camera's, GPS-systemen, een microfoon en traagheidsmetingen en dieptesensoren om functies te leveren zoals navigatie, spraakherkenning of het weergeven van objecten, tekst of omgeving als computergesynthetiseerde spraak.

Howe Yuan Zhu en collega's van de University of Technology Sydney (UTS) en de Universiteit van Sydney onderzocht de toevoeging van akoestische aanraking aan slimme brillen, een aanpak die gebruik maakt van hoofdscans en de activering van auditieve iconen wanneer objecten verschijnen binnen een gedefinieerd gezichtsveld (FOV).

Schrijven in PLoS ONEleggen de onderzoekers uit dat akoestische aanraking verschillende voordelen biedt ten opzichte van bestaande benaderingen, waaronder het gemak van integratie met slimme briltechnologie en intuïtiever gebruik dan computergesynthetiseerde spraak. Dergelijke systemen vereisen mogelijk ook minder training voordat gebruikers er vaardig in worden.

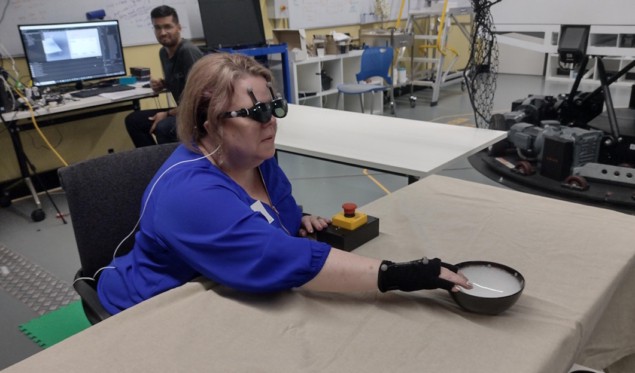

In samenwerking met ARIA Research uit Sydney (dat onlangs won Australisch technologiebedrijf van het jaar vanwege zijn baanbrekende vision-tech-innovaties) creëerde het team een foveated audio-apparaat (FAD) om deze aannames te testen op zeven vrijwilligers met geen of slecht zicht, plus zeven ziende geblinddoekte deelnemers. De FAD bestaat uit een smartphone en de NREAL augmented reality-bril, waaraan het team bewegingsvastleggende reflecterende markeringen heeft bevestigd om het volgen van hoofdbewegingen mogelijk te maken.

De FAD voert objectherkenning uit en bepaalt de afstand van het object met behulp van de stereocamera’s op de bril. Vervolgens wijst het passende auditieve pictogrammen toe aan de objecten, zoals bijvoorbeeld een geluid voor het omslaan van pagina's voor een boek. Wanneer een drager zijn hoofd draait, verandert de herhalingsfrequentie van de auditieve pictogrammen afhankelijk van de positie van het item binnen het auditieve gezichtsveld.

De vrijwilligers namen deel aan zowel zittende als staande oefeningen. Voor de zittende taak moesten ze verschillende methoden gebruiken om alledaagse voorwerpen te zoeken en te hanteren, waaronder een boek, fles, kom of beker, geplaatst op een of meerdere tafels. Deze taak mat hun vermogen om een item te detecteren, een geluid te herkennen en de positie van het item te onthouden.

De onderzoekers ontwierpen deze taak om de FAD-prestaties te vergelijken met twee conventionele spraaksignalen: verbale aanwijzingen op de wijzerplaat; en het opeenvolgend afspelen van auditieve iconen uit luidsprekers die zich bij elk item bevinden. Ze ontdekten dat voor blinde of slechtziende deelnemers de prestaties met behulp van de FAD vergelijkbaar waren met de twee geïdealiseerde omstandigheden. De geblinddoekte ziende groep presteerde echter slechter bij gebruik van de FAD.

Hersenimplantaat zorgt ervoor dat blinde vrouwen eenvoudige vormen kunnen zien

Bij de staande reiktaak moesten de deelnemers de FAD gebruiken om een doelitem tussen meerdere afleidende items te zoeken en te bereiken. Deelnemers werd gevraagd objecten te vinden die op drie tafels waren geplaatst en die waren omgeven door vier flessen met verschillende vormen. Deze taak beoordeelde voornamelijk de functionele prestaties van het systeem en het menselijk gedrag bij gebruik van volledige lichaamsbeweging tijdens het zoeken.

“Dit jaar hebben we intensief onderzoek gedaan naar het gebruik van de auditieve soundscape ter ondersteuning van verschillende complexe taken”, vertelt Zhu Fysische wereld. “We hebben in het bijzonder onderzoek gedaan naar het gebruik van verschillende soorten ruimtelijke geluiden om mensen te begeleiden tijdens navigatie en ter ondersteuning van sportactiviteiten, met name tafeltennis. Volgend jaar hopen we deze gebieden verder uit te breiden en studies uit te voeren in de praktijk.”

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://physicsworld.com/a/acoustic-touch-technology-helps-blind-people-see-using-sound/

- :is

- 90

- a

- vermogen

- versnellen

- Volgens

- akoestisch

- Activering

- activiteiten

- toevoeging

- voordelen

- ook

- onder

- an

- en

- verschijnen

- nadering

- benaderingen

- passend

- ZIJN

- gebieden

- gebied

- AS

- geëvalueerd

- veronderstellingen

- At

- audio

- audio technologie

- aangevuld

- Augmented Reality

- Australië

- worden

- geweest

- gedrag

- blind

- boek

- zowel

- by

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- camera

- camera's

- Wijzigingen

- collega's

- COM

- afstand

- vergelijkbaar

- vergelijken

- complex

- omvat

- computer

- Computer visie

- voorwaarden

- Gedrag

- voortzetten

- onder controle te houden

- conventioneel

- kon

- aangemaakt

- beker

- deep

- gedefinieerd

- leveren

- diepte

- ontworpen

- opsporen

- bepaalt

- het ontwikkelen van

- Ontwikkeling

- apparaat

- anders

- richtingen

- afstand

- gedurende

- elk

- gemak

- in staat stellen

- maakt

- alledaags

- voorbeeld

- bestaand

- uit te breiden

- experimenten

- Verklaren

- Nagegaan

- Verkennen

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- Voor

- gevonden

- vier

- oppompen van

- functioneel

- functies

- bril

- gps

- Groep

- gids

- handvat

- Hebben

- hoofd

- hard

- hulp

- helpt

- hoop

- Echter

- HTTPS

- menselijk

- pictogrammen

- beeld

- afbeeldingen

- verbeteringen

- in

- Inclusief

- nemen

- informatie

- eerste

- innovaties

- integratie

- in

- intuïtief

- kwestie

- IT

- artikelen

- HAAR

- jpg

- laboratorium

- minder

- Laag

- max-width

- Mei..

- afgemeten

- maat

- lid

- methoden

- microfoon

- gemengd

- gemengde realiteit

- meer

- beweging

- beweging

- bewegingen

- meervoudig

- Navigatie

- New

- volgende

- geen

- Onwerkelijk

- object

- objecten

- of

- Aanbod

- on

- EEN

- or

- over

- deel

- deelnemers

- bijzonder

- Mensen

- prestatie

- uitgevoerd

- presteert

- Fysica

- Natuurkunde wereld

- baanbrekende

- geplaatst

- platform

- Plato

- Plato gegevensintelligentie

- PlatoData

- spelen

- plus

- positie

- gepositioneerd

- PRAKTISCH

- in de eerste plaats

- tarief

- bereiken

- het bereiken van

- echte wereld

- Realiteit

- onlangs

- erkenning

- herkennen

- weergave

- vereisen

- nodig

- onderzoek

- onderzoekers

- het scannen

- Ontdek

- zoeken

- zien

- settings

- zeven

- verscheidene

- vormen

- aanzienlijk

- Eenvoudig

- gelegen

- slim

- Slimme bril

- smartphone

- Geluid

- ruimtelijke

- speakers

- specifiek

- toespraak

- staand

- studies

- dergelijk

- stel

- ondersteuning

- Ondersteuning

- omgeven

- sydney

- system

- Systems

- tafel

- doelwit

- Taak

- taken

- team

- Technologie

- vertelt

- tennis

- proef

- tekst

- neem contact

- dat

- De

- hun

- Ze

- harte

- Deze

- ze

- dit

- die

- drie

- thumbnail

- naar

- nam

- Tracking

- Trainingen

- waar

- BEURT

- twee

- types

- eenheden

- universiteit-

- .

- gebruikers

- toepassingen

- gebruik

- divers

- rendabel

- visie

- Stem

- spraakherkenning

- vrijwilligers

- was

- we

- draagbaar

- waren

- wanneer

- welke

- WIE

- Met

- binnen

- vrouw

- Won

- wereld

- erger

- jaar

- Yuan

- zephyrnet