De snelle groei van generatieve AI brengt veelbelovende nieuwe innovatie met zich mee, en roept tegelijkertijd nieuwe uitdagingen op. Deze uitdagingen omvatten enkele die vóór generatieve AI gebruikelijk waren, zoals vooringenomenheid en verklaarbaarheid nieuwe die uniek zijn voor funderingsmodellen (FM's), inclusief hallucinaties en toxiciteit. Bij AWS streven we ernaar op een verantwoorde manier generatieve AI ontwikkelen, een mensgerichte aanpak hanteren die prioriteit geeft aan onderwijs, wetenschap en onze klanten, om verantwoorde AI te integreren in de end-to-end AI-levenscyclus.

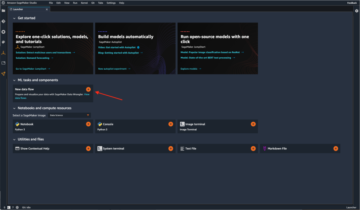

Het afgelopen jaar hebben we nieuwe mogelijkheden geïntroduceerd in onze generatieve AI-toepassingen en -modellen, zoals ingebouwde beveiligingsscans Amazon Code Whisperer, training om schadelijke inhoud te detecteren en te blokkeren Amazone Titanen bescherming van gegevensprivacy in Amazonebodem. Onze investering in veilige, transparante en verantwoorde generatieve AI omvat samenwerking met de mondiale gemeenschap en beleidsmakers, waarbij we zowel de Vrijwillige AI-toezeggingen van het Witte Huis en AI-veiligheidstop in het Verenigd Koninkrijk. En we blijven hand in hand met klanten samenwerken om verantwoorde AI te operationaliseren met speciaal gebouwde tools zoals Amazon SageMaker verduidelijken, ML-governance met Amazon SageMakerEn nog veel meer.

Introductie van nieuwe verantwoorde AI-innovatie

Terwijl generatieve AI zich uitbreidt naar nieuwe industrieën, organisaties en gebruiksscenario's, moet deze groei gepaard gaan met een duurzame investering in verantwoorde FM-ontwikkeling. Klanten willen dat hun FM’s worden gebouwd met het oog op veiligheid, eerlijkheid en beveiliging, zodat zij op hun beurt AI op een verantwoorde manier kunnen inzetten. Bij AWS re:Invent dit jaar zijn we verheugd om nieuwe mogelijkheden aan te kondigen om verantwoorde generatieve AI-innovatie te bevorderen via een breed scala aan mogelijkheden met nieuwe ingebouwde tools, klantbescherming, middelen om de transparantie te vergroten en tools om desinformatie te bestrijden. We streven ernaar klanten de informatie te bieden die ze nodig hebben om FM's te beoordelen op basis van belangrijke verantwoordelijke AI-overwegingen, zoals toxiciteit en robuustheid, en vangrails te introduceren om waarborgen toe te passen op basis van klantgebruiksscenario's en verantwoord AI-beleid. Tegelijkertijd willen onze klanten beter geïnformeerd worden over de veiligheid, eerlijkheid, beveiliging en andere eigenschappen van AI-diensten en FM’s, zoals zij deze binnen hun eigen organisatie gebruiken. We zijn verheugd om meer middelen aan te kondigen om klanten te helpen onze AWS AI-services beter te begrijpen en de transparantie te bieden waar ze om vragen.

Beveiligingsmaatregelen implementeren: vangrails voor Amazon Bedrock

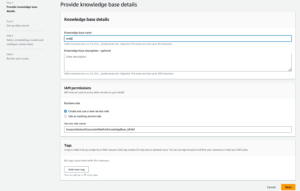

Veiligheid is een prioriteit als het gaat om de introductie van generatieve AI op grote schaal. Organisaties willen veilige interacties tussen hun klanten en generatieve AI-toepassingen bevorderen die schadelijk of aanstootgevend taalgebruik vermijden en aansluiten bij het bedrijfsbeleid. De eenvoudigste manier om dat te doen is door consistente waarborgen in de hele organisatie te implementeren, zodat iedereen veilig kan innoveren. Gisteren maakten we de preview bekend van Vangrails voor Amazon Bedrock– een nieuwe mogelijkheid die het eenvoudig maakt om toepassingsspecifieke beveiligingen te implementeren op basis van klantgebruiksscenario’s en verantwoord AI-beleid.

Guardrails zorgen voor consistentie in de manier waarop FM's op Amazon Bedrock reageren op ongewenste en schadelijke inhoud binnen applicaties. Klanten kunnen vangrails toepassen op grote taalmodellen op Amazon Bedrock, maar ook op verfijnde modellen en in combinatie met Agenten voor Amazon Bedrock. Met Guardrails kunt u onderwerpen opgeven die u wilt vermijden, en de service detecteert en voorkomt automatisch vragen en antwoorden die in beperkte categorieën vallen. Klanten kunnen ook inhoudsfilterdrempels configureren voor categorieën, waaronder haatzaaiende uitlatingen, beledigingen, geseksualiseerde taal en geweld, om schadelijke inhoud tot het gewenste niveau te filteren. Er kan bijvoorbeeld een applicatie voor online bankieren worden opgezet om het verstrekken van beleggingsadvies te vermijden en ongepaste inhoud (zoals haatzaaiende uitlatingen, beledigingen en geweld) te beperken. In de nabije toekomst zullen klanten ook persoonlijk identificeerbare informatie (PII) in gebruikersinvoer en reacties van FM's kunnen redigeren, filters voor grof taalgebruik kunnen instellen en een lijst met aangepaste woorden kunnen aanbieden die ze kunnen blokkeren in interacties tussen gebruikers en FM's, waardoor de naleving wordt verbeterd en de regelgeving verder wordt verbeterd. gebruikers beschermen. Met Guardrails kunt u sneller innoveren met generatieve AI, terwijl de bescherming en waarborgen in overeenstemming blijven met het bedrijfsbeleid.

De beste FM voor een specifiek gebruik identificeren: Modelevaluatie in Amazon Bedrock

Tegenwoordig beschikken organisaties over een breed scala aan FM-opties om hun generatieve AI-toepassingen aan te drijven. Om de juiste balans tussen nauwkeurigheid en prestaties voor hun gebruiksscenario te vinden, moeten organisaties modellen efficiënt vergelijken en de beste optie vinden op basis van de belangrijkste verantwoorde AI en kwaliteitsstatistieken die voor hen belangrijk zijn. Om modellen te evalueren, moeten organisaties eerst dagen besteden aan het identificeren van benchmarks, het opzetten van evaluatietools en het uitvoeren van beoordelingen, wat allemaal een diepgaande expertise in datawetenschap vereist. Bovendien zijn deze tests niet bruikbaar voor het evalueren van subjectieve criteria (bijvoorbeeld de stem van het merk, relevantie en stijl) die een oordeel vereisen via vervelende, tijdrovende, menselijke beoordelingsworkflows. De tijd, expertise en middelen die nodig zijn voor deze evaluaties (voor elke nieuwe use case) maken het moeilijk voor organisaties om modellen te beoordelen op basis van verantwoorde AI-dimensies en een weloverwogen keuze te maken over welk model de meest nauwkeurige, veilige ervaring voor hun klanten zal bieden.

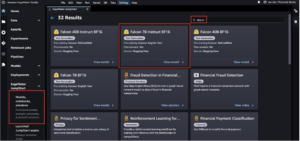

Nu beschikbaar als voorbeeld, Modelevaluatie op Amazon Bedrock helpt klanten bij het evalueren, vergelijken en selecteren van de beste FM's voor hun specifieke gebruiksscenario op basis van aangepaste statistieken, zoals nauwkeurigheid en veiligheid, met behulp van automatische of menselijke evaluaties. In de Amazon Bedrock-console kiezen klanten de FM's die ze willen vergelijken voor een bepaalde taak, zoals het beantwoorden van vragen of het samenvatten van inhoud. Voor automatische evaluaties selecteren klanten vooraf gedefinieerde evaluatiecriteria (bijvoorbeeld nauwkeurigheid, robuustheid en toxiciteit) en uploaden ze hun eigen testdataset of kiezen ze uit ingebouwde, openbaar beschikbare datasets. Voor subjectieve criteria of genuanceerde inhoud die beoordeling vereist, kunnen klanten met slechts een paar klikken eenvoudig op mensen gebaseerde evaluatieworkflows opzetten. Deze workflows maken gebruik van het interne werkteam van een klant, of maken gebruik van een beheerd personeelsbestand van AWS, om modelreacties te evalueren. Tijdens menselijke evaluaties definiëren klanten use case-specifieke statistieken (bijvoorbeeld relevantie, stijl en merkstem). Zodra klanten het installatieproces hebben voltooid, voert Amazon Bedrock evaluaties uit en genereert een rapport, zodat klanten gemakkelijk kunnen begrijpen hoe het model presteerde op basis van de belangrijkste veiligheids- en nauwkeurigheidscriteria en het beste model voor hun gebruiksscenario kunnen selecteren.

Deze mogelijkheid om modellen te evalueren is niet beperkt tot Amazon Bedrock; klanten kunnen modelevaluatie ook gebruiken in Amazon SageMaker Clarify om eenvoudig de beste FM-optie te evalueren, vergelijken en selecteren op basis van belangrijke kwaliteits- en verantwoordelijkheidsstatistieken zoals nauwkeurigheid, robuustheid en toxiciteit – over de hele linie. alle FM's.

Bestrijding van desinformatie: watermerken in Amazon Titan

Vandaag hebben we aangekondigd Amazon Titan-afbeeldingsgenerator in preview, waarmee klanten snel afbeeldingen van hoge kwaliteit op schaal kunnen produceren en verbeteren. We hebben tijdens elke fase van het modelontwikkelingsproces rekening gehouden met verantwoorde AI, inclusief de selectie van trainingsgegevens, het bouwen van filtermogelijkheden om ongepaste gebruikersinvoer en modeluitvoer te detecteren en verwijderen, en het verbeteren van de demografische diversiteit van onze modeluitvoer. Alle door Amazon Titan gegenereerde afbeeldingen bevatten standaard een onzichtbaar watermerk, dat is ontworpen om de verspreiding van desinformatie te helpen verminderen door een discreet mechanisme te bieden om door AI gegenereerde afbeeldingen te identificeren. AWS is een van de eerste modelaanbieders die op grote schaal ingebouwde onzichtbare watermerken uitbrengt die zijn geïntegreerd in beelduitvoer en zijn ontworpen om bestand te zijn tegen wijzigingen.

Vertrouwen opbouwen: met schadeloosstelling achter onze modellen en toepassingen staan

Het opbouwen van klantvertrouwen is de kern van AWS. Sinds onze oprichting zijn we op reis geweest met onze klanten, en met de groei van generatieve AI blijven we ons inzetten om samen innovatieve technologie te bouwen. Om klanten in staat te stellen de kracht van onze generatieve AI te benutten, moeten ze weten dat ze beschermd zijn. AWS biedt dekking voor auteursrechtvrijwaring voor de output van de volgende generatieve AI-services van Amazon: Amazon Titan Text Express, Amazon Titan Text Lite, Amazon Titan Embeddings, Amazon Titan Multimodal Embeddings, Amazon CodeWhisperer Professional, AWS HealthScribe, Amazon-Lex en Amazon personaliseren. Dit betekent dat klanten die de diensten op verantwoorde wijze gebruiken, worden beschermd tegen claims van derden die beweren inbreuk op het auteursrecht te maken door de output die door die diensten wordt gegenereerd (zie sectie 50.10 van de Servicevoorwaarden). Bovendien beschermt onze standaard IE-vrijwaring voor het gebruik van de diensten klanten tegen claims van derden wegens vermeende inbreuk op IE door de diensten en de gegevens die worden gebruikt om hen te trainen. Met andere woorden: als u een hierboven genoemde generatieve AI-service van Amazon gebruikt en iemand u aanklaagt wegens inbreuk op uw intellectuele eigendom, zal AWS die rechtszaak verdedigen, inclusief het dekken van eventuele vonnissen tegen u of de schikkingskosten.

Wij staan achter onze generatieve AI-diensten en werken eraan om deze voortdurend te verbeteren. Terwijl AWS nieuwe diensten lanceert en generatieve AI blijft evolueren, zal AWS zich onophoudelijk blijven concentreren op het verdienen en behouden van het vertrouwen van klanten.

Transparantie vergroten: AWS AI Service Card voor Amazon Titan Text

We introduceerde AWS AI-servicekaarten op re:Invent 2022 als transparantiebron om klanten te helpen onze AWS AI-services beter te begrijpen. AI Service Cards zijn een vorm van verantwoorde AI-documentatie waarmee klanten op één plek informatie kunnen vinden over de beoogde gebruiksscenario's en beperkingen, verantwoorde AI-ontwerpkeuzes en best practices voor implementatie en prestatie-optimalisatie voor onze AI-diensten. Ze maken deel uit van een alomvattend ontwikkelingsproces dat we ondernemen om onze diensten op een verantwoorde manier op te bouwen, waarbij eerlijkheid, verklaarbaarheid, waarheidsgetrouwheid en robuustheid, bestuur, transparantie, privacy en beveiliging, veiligheid en controleerbaarheid aan bod komen.

Bij re:Invent kondigen we dit jaar een nieuwe AI-servicekaart voor Amazon Titan Text om de transparantie in funderingsmodellen te vergroten. We lanceren ook vier nieuwe AI Service Cards, waaronder: Amazon Comprehend PII detecteren, Amazon Transcribe Toxiciteitsdetectie, Amazon-herkenning Gezichtslevendheid en AWS HealthScribe. Je kunt elk van deze kaarten verkennen op de AWS-website. Naarmate generatieve AI blijft groeien en evolueren, zal transparantie over hoe technologie wordt ontwikkeld, getest en gebruikt een essentieel onderdeel zijn om het vertrouwen van zowel organisaties als hun klanten te winnen. Bij AWS streven we ernaar om transparantiebronnen zoals AI Service Cards naar de bredere gemeenschap te blijven brengen, en om feedback te blijven geven en te verzamelen over de beste manieren om vooruit te komen.

Investeren in verantwoorde AI gedurende de gehele generatieve AI-levenscyclus

We zijn enthousiast over de nieuwe innovaties die deze week op re:Invent zijn aangekondigd en die onze klanten meer tools, middelen en ingebouwde bescherming bieden om generatieve AI veilig te bouwen en te gebruiken. Van modelevaluatie tot vangrails tot watermerken: klanten kunnen generatieve AI nu sneller naar hun organisatie brengen, terwijl ze de risico's beperken. Nieuwe bescherming voor klanten, zoals dekking voor IP-schadeloosstelling en nieuwe middelen om de transparantie te vergroten, zoals extra AI Service Cards, zijn ook belangrijke voorbeelden van onze toewijding om vertrouwen op te bouwen bij technologiebedrijven, beleidsmakers, gemeenschapsgroepen, wetenschappers en meer. We blijven betekenisvolle investeringen doen in verantwoorde AI gedurende de hele levenscyclus van een basismodel, om onze klanten te helpen AI op een veilige, beveiligde en verantwoorde manier op te schalen.

Over de auteurs

Peter Hallinan leidt initiatieven in de wetenschap en praktijk van Responsible AI bij AWS AI, samen met een team van verantwoordelijke AI-experts. Hij heeft diepgaande expertise in AI (PhD, Harvard) en ondernemerschap (Blindsight, verkocht aan Amazon). Zijn vrijwilligersactiviteiten omvatten onder meer het dienen als adviserend professor aan de Stanford University School of Medicine en als president van de Amerikaanse Kamer van Koophandel in Madagaskar. Als het even kan, gaat hij met zijn kinderen de bergen in: skiën, klimmen, wandelen en raften

Peter Hallinan leidt initiatieven in de wetenschap en praktijk van Responsible AI bij AWS AI, samen met een team van verantwoordelijke AI-experts. Hij heeft diepgaande expertise in AI (PhD, Harvard) en ondernemerschap (Blindsight, verkocht aan Amazon). Zijn vrijwilligersactiviteiten omvatten onder meer het dienen als adviserend professor aan de Stanford University School of Medicine en als president van de Amerikaanse Kamer van Koophandel in Madagaskar. Als het even kan, gaat hij met zijn kinderen de bergen in: skiën, klimmen, wandelen en raften

Vasi Philomin is momenteel de VP Generative AI bij AWS. Hij leidt generatieve AI-inspanningen, waaronder Amazon Bedrock, Amazon Titan en Amazon CodeWhisperer.

Vasi Philomin is momenteel de VP Generative AI bij AWS. Hij leidt generatieve AI-inspanningen, waaronder Amazon Bedrock, Amazon Titan en Amazon CodeWhisperer.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://aws.amazon.com/blogs/machine-learning/announcing-new-tools-and-capabilities-to-enable-responsible-ai-innovation/

- : heeft

- :is

- :niet

- $UP

- 10

- 100

- 125

- 2022

- 50

- a

- vermogen

- in staat

- Over

- boven

- vergezeld

- nauwkeurigheid

- accuraat

- over

- activiteiten

- toevoeging

- Extra

- adressen

- advies

- tegen

- AI

- AI-diensten

- streven

- richten

- gelijk

- Alles

- naast

- ook

- Amazone

- Amazon Code Whisperer

- Amazon Sage Maker

- Amazon Web Services

- Amerikaans

- onder

- an

- en

- aankondigen

- aangekondigd

- Het aankondigen

- Nog een

- elke

- Aanvraag

- toepassingen

- Solliciteer

- nadering

- ZIJN

- rond

- AS

- vragen

- assessments

- At

- Automatisch

- webmaster.

- Beschikbaar

- vermijd

- vermeden

- AWS

- AWS re: Invent

- Balance

- Bankieren

- gebaseerde

- BE

- geweest

- vaardigheden

- achter

- benchmarks

- BEST

- 'best practices'

- Betere

- tussen

- vooringenomenheid

- Blok

- zowel

- merk

- brengen

- Brengt

- breed

- bredere

- bouw

- vertrouwen op te bouwen

- Gebouw

- bebouwd

- ingebouwd

- by

- CAN

- mogelijkheden

- bekwaamheid

- kaart

- Kaarten

- geval

- gevallen

- categorieën

- uitdagingen

- Klimaatkamers

- Kinderen

- keuze

- keuzes

- Kies

- vorderingen

- Beklimming

- samenwerking

- tegen te gaan

- combinatie van

- komt

- Lenen en verhuur

- verplichting

- toegewijd

- Gemeen

- gemeenschap

- Bedrijven

- afstand

- vergelijken

- nakoming

- bestanddeel

- begrijpen

- uitgebreid

- overwegingen

- beschouwd

- consequent

- troosten

- consulting

- bevatten

- content

- permanent

- voortzetten

- blijft

- voortgezette

- auteursrecht

- schending van het auteursrecht

- Kern

- Kosten

- dekking

- aan het bedekken

- criteria

- Op dit moment

- gewoonte

- klant

- Klanten

- gegevens

- data Privacy

- data science

- datasets

- dagen

- deep

- diepe expertise

- Standaard

- bepalen

- leveren

- demografisch

- implementeren

- inzet

- Design

- ontworpen

- gewenste

- opsporen

- ontwikkelde

- Ontwikkeling

- moeilijk

- Afmeting

- disinformatie

- Verscheidenheid

- do

- documentatie

- rit

- gedurende

- e

- elk

- verdienen

- verdiencapaciteit

- gemakkelijkste

- gemakkelijk

- En het is heel gemakkelijk

- Onderwijs

- efficiënt

- inspanningen

- beide

- machtigt

- in staat stellen

- aangemoedigd

- eind tot eind

- verhogen

- Geheel

- ondernemerschap

- Ether (ETH)

- schatten

- evalueren

- evaluatie

- evaluaties

- Alle

- iedereen

- ontwikkelen

- voorbeeld

- voorbeelden

- opgewonden

- ervaring

- expertise

- deskundigen

- Uitlegbaarheid

- Verken

- uitdrukkelijk

- Gezicht

- eerlijkheid

- Vallen

- sneller

- feedback

- weinig

- filter

- filtering

- filters

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- afmaken

- Voornaam*

- Focus

- volgend

- Voor

- formulier

- Naar voren

- Bevorderen

- Foundation

- vier

- oppompen van

- verder

- Bovendien

- toekomst

- verzamelen

- gegenereerde

- genereert

- generatief

- generatieve AI

- gegeven

- geeft

- Globaal

- bestuur

- Groep

- Groeien

- schadelijk

- harnas

- harvard

- haat

- Haattoespraak

- Hebben

- he

- hulp

- helpt

- hoogwaardige

- wandelen

- zijn

- Huis

- Hoe

- HTTPS

- menselijk

- identificeren

- het identificeren van

- if

- beeld

- afbeeldingen

- uitvoeren

- belangrijk

- verbeteren

- het verbeteren van

- in

- begin

- omvatten

- inclusief

- omvat

- Inclusief

- Laat uw omzet

- industrieën

- informatie

- op de hoogte

- inbreuk

- initiatieven

- innoveren

- Innovatie

- innovaties

- innovatieve

- innovatieve technologie

- ingangen

- integreren

- geïntegreerde

- bestemde

- interacties

- in

- voorstellen

- geïntroduceerd

- de invoering

- investering

- Investeringen

- onzichtbaar

- IP

- IT

- jpg

- voor slechts

- sleutel

- blijven

- taal

- Groot

- lanceert

- lancering

- proces

- Leads

- Laten we

- Niveau

- Hefboomwerking

- levenscyclus van uw product

- als

- LIMIT

- beperkingen

- Beperkt

- Lijst

- opgesomd

- behoud van

- maken

- MERKEN

- beheerd

- zinvolle

- middel

- mechanisme

- geneeskunde

- Metriek

- denken

- verzachtende

- model

- modellen

- meer

- meest

- Dan moet je

- Nabij

- Noodzaak

- New

- nu

- of

- korting

- aanvallend

- Aanbod

- on

- eens

- degenen

- online.

- online bankieren

- optimalisatie

- Keuze

- Opties

- or

- organisatie

- organisaties

- Overige

- onze

- uit

- uitgangen

- het te bezitten.

- deel

- verleden

- prestatie

- uitgevoerd

- Persoonlijk

- phd

- pii

- plaats

- Plato

- Plato gegevensintelligentie

- PlatoData

- beleidsmaatregelen door te lezen.

- beleidsmakers

- mogelijk

- energie

- praktijk

- praktijken

- president

- voorkomt

- Voorbeschouwing

- prioriteert

- prioriteit

- privacy

- Privacy en Beveiliging

- produceren

- VULGAIR TAALGEBRUIK

- professioneel

- Hoogleraar

- veelbelovend

- promoten

- vastgoed

- beschermd

- beschermen

- beschermt

- zorgen voor

- mits

- providers

- het verstrekken van

- in het openbaar

- zetten

- kwaliteit

- queries

- verhoogt

- reeks

- snel

- snel

- RE

- verminderen

- los

- relevantie

- blijven

- verwijderen

- verslag

- nodig

- vereist

- bestand tegen

- hulpbron

- Resources

- Reageren

- reacties

- verantwoordelijkheid

- verantwoordelijk

- verantwoorde

- begrensd

- rechts

- Risico

- robuustheid

- lopend

- loopt

- veilig

- waarborgen

- veilig

- Veiligheid

- sagemaker

- dezelfde

- Scale

- schaal ai

- balans

- het scannen

- School

- Wetenschap

- wetenschappers

- sectie

- beveiligen

- veiligheid

- zien

- kiezen

- selectie

- service

- Diensten

- serveer-

- reeks

- het instellen van

- nederzetting

- setup

- sinds

- single

- So

- uitverkocht

- sommige

- Iemand

- specifiek

- toespraak

- besteden

- verspreiden

- Stadium

- staan

- standaard

- staand

- stanford

- Stanford University

- slaan

- stijl

- dergelijk

- Klaagt

- ondersteunde

- volgehouden

- het nemen

- Taak

- team

- Technologie

- technologiebedrijven

- getest

- Testen

- testen

- tekst

- dat

- De

- de informatie

- Brittannië

- hun

- Ze

- Deze

- ze

- van derden

- dit

- deze week

- dit jaar

- die

- Door

- niet de tijd of

- Titan

- naar

- samen

- tools

- onderwerpen

- Trainen

- Trainingen

- Transparantie

- transparant

- Trust

- BEURT

- Uk

- begrijpen

- ondernemen

- unieke

- universiteit-

- .

- use case

- gebruikt

- Gebruiker

- gebruikers

- gebruik

- vitaal

- Stem

- vrijwillig

- vrijwilliger

- vp

- willen

- watermerk

- watermerken

- watermerken

- Manier..

- manieren

- we

- web

- webservices

- Website

- week

- GOED

- waren

- Wat

- wanneer

- welke

- en

- WIE

- geheel

- breed

- Grote range

- wijd

- wil

- Met

- binnen

- woorden

- Mijn werk

- workflows

- Workforce

- jaar

- gisteren

- u

- zephyrnet