Jay Dawani is mede-oprichter en CEO van Lemurische Labs, een startup die een versneld computerplatform ontwikkelt dat specifiek is afgestemd op AI-toepassingen. Het platform doorbreekt de hardwarebarrières om de ontwikkeling van AI sneller, goedkoper, duurzamer en toegankelijker te maken voor meer dan slechts een paar bedrijven.

Voordat hij Lemurian oprichtte, richtte Jay twee andere bedrijven op in de AI-ruimte. Hij is ook de auteur van het best beoordeelde “Wiskunde voor diep leren. '

Jay, een expert op het gebied van kunstmatige intelligentie, robotica en wiskunde, heeft gediend als CTO van BlocPlay, een beursgenoteerd bedrijf dat een op blockchain gebaseerd gamingplatform bouwt, en was directeur van AI bij GEC, waar hij leiding gaf aan de ontwikkeling van verschillende klantprojecten op gebieden van detailhandel, algoritmische handel, het vouwen van eiwitten, robots voor ruimteverkenning, aanbevelingssystemen en meer. In zijn vrije tijd was hij ook adviseur bij NASA Frontier Development Lab, Spacebit en SiaClassic.

De laatste keer dat we Lemurian Labs presenteerden, was je gefocust op robotica en edge-AI. Nu concentreert u zich op datacenter- en cloudinfrastructuur. Wat is er gebeurd waardoor je wilde omkeren?

We zijn inderdaad overgestapt van de focus op het bouwen van een systeem-op-chip met hoge prestaties en lage latentie voor autonome robotica-applicaties dat de hele sense-plan-act-lus zou kunnen versnellen naar het bouwen van een domeinspecifieke accelerator voor AI die zich richt op applicaties op datacenterschaal. . Maar het was niet zomaar een draaipunt; het was een klaroenstoot waarvan we vonden dat we de verantwoordelijkheid hadden om te antwoorden.

In 2018 waren we bezig met het trainen van een parametermodel ter waarde van 2.1 miljard dollar, maar we hebben deze inspanning opgegeven omdat de kosten zo buitengewoon hoog waren dat we het niet konden rechtvaardigen. Stel je dus mijn verbazing voor dat GPT3, dat OpenAI in november 2022 als ChatGPT uitbracht, een parametermodel van $ 175 miljard was. Dit model is meer dan 80x groter dan waar we vier jaar eerder aan werkten, wat zowel spannend als beangstigend is.

De kosten voor het trainen van een dergelijk model zijn op zijn zachtst gezegd ontzagwekkend. Op basis van de huidige schaaltrends kunnen we verwachten dat de kosten voor het trainen van een grensverleggend AI-model in de niet al te verre toekomst meer dan een miljard dollar zullen bedragen. Hoewel de mogelijkheden van deze modellen verbazingwekkend zullen zijn, zijn de kosten belachelijk hoog. Op basis van dit traject zal slechts een handvol zeer goed uitgeruste bedrijven met hun eigen datacenters het zich kunnen veroorloven om deze modellen te trainen, in te zetten en te verfijnen. Dit komt niet puur omdat computers duur en energieverslindend zijn, maar ook omdat de softwarestacks waarop we vertrouwen niet voor deze wereld zijn gebouwd.

Vanwege geografische en energiebeperkingen zijn er maar een beperkt aantal plaatsen waar datacenters kunnen worden gebouwd. Om aan de rekenbehoeften van AI te voldoen, moeten we machines op zettaschaal kunnen bouwen zonder dat daarvoor twintig kernreactoren nodig zijn. We hebben een meer praktische, schaalbare en economische oplossing nodig. We keken om ons heen en zagen niemand die op weg was om dit op te lossen. En dus gingen we naar de tekentafel om het probleem holistisch te bekijken als een systeem van systemen en te redeneren over een oplossing vanuit de eerste principes. We vroegen ons af hoe we de volledige stack, van software tot hardware, zouden ontwerpen als we op een economische manier 20 miljard LLM-query's per dag zouden moeten afhandelen. We hebben onze zinnen gezet op een machine op zettaschaal met een vermogen van minder dan 10 MW in 200.

De truc is om ernaar te kijken vanuit het oogpunt van onevenredige schaalvergroting: verschillende delen van een systeem volgen verschillende schaalregels, dus op een gegeven moment stoppen dingen gewoon met werken, gaan ze kapot of is de afweging tussen kosten en baten niet langer logisch. Wanneer dit gebeurt, is de enige optie het opnieuw ontwerpen van het systeem. Onze beoordeling en oplossing omvat de werklast, het nummersysteem, het programmeermodel, de compiler, runtime en hardware holistisch.

Gelukkig zien onze bestaande investeerders en de rest van de markt de visie, en hebben we een startronde van $9 miljoen opgehaald om ons getalformaat (PAL) te ontwikkelen, om de ontwerpruimte te verkennen en te convergeren naar een architectuur voor onze domeinspecifieke accelerator, en om onze domeinspecifieke versneller te ontwerpen. compiler en runtime. In simulaties zijn we erin geslaagd een doorvoerwinst van 20x te realiseren bij een kleinere energievoetafdruk dan moderne GPU's, en we verwachten een 8x voordeel te kunnen behalen in systeemprestaties voor de totale eigendomskosten op dezelfde transistortechnologie.

Het is onnodig om te zeggen dat we nog veel werk voor de boeg hebben, maar we zijn behoorlijk enthousiast over het vooruitzicht dat we de economie van datacenters opnieuw kunnen definiëren om een toekomst te garanderen waarin AI overvloedig beschikbaar is voor iedereen.

Dat klinkt zeker spannend en die cijfers klinken indrukwekkend. Maar u heeft nummersystemen, hardware, compilers en runtimes genoemd als alle zaken waar u zich op concentreert. Het klinkt als veel voor elk bedrijf om in één keer op zich te nemen. Het lijkt een zeer riskant voorstel. Moeten startups niet meer gefocust zijn?

Het klinkt als een heleboel verschillende inspanningen, maar het is in feite één inspanning met veel onderling verbonden onderdelen. Het oplossen van slechts één van deze componenten, los van de andere, zal het innovatiepotentieel alleen maar belemmeren, omdat hierdoor de systemische inefficiënties en knelpunten over het hoofd worden gezien. Jensen Huang zei het het beste: “Om een versneld computerbedrijf te zijn, moet je een full-stackbedrijf zijn”, en daar ben ik het volledig mee eens. Ze zijn niet voor niets de huidige marktleider. Maar ik wil het idee betwisten dat we niet gefocust zijn. Onze focus ligt op de manier waarop we holistisch over het probleem nadenken en hoe we dit het beste voor onze klanten kunnen oplossen.

Daarvoor is een multidisciplinaire aanpak nodig, zoals de onze. Elk onderdeel van ons werk informeert en ondersteunt de andere, waardoor we een oplossing kunnen creëren die veel meer is dan de som der delen. Stel je voor dat je een raceauto moest bouwen. Je zou niet willekeurig een chassis kiezen, racebanden toevoegen en de krachtigste motor die je kunt vinden erin stoppen en ermee racen, toch? Je zou nadenken over de aerodynamische eigenschappen van de carrosserie van de auto om de luchtweerstand te verminderen en de neerwaartse kracht te vergroten, de gewichtsverdeling te optimaliseren voor een goede wegligging, de motor op maat te ontwerpen voor maximale prestaties, een koelsysteem te krijgen om oververhitting te voorkomen, een rolkooi te specificeren om de bestuurder veilig te houden , enz. Elk van deze elementen bouwt voort op de andere en informeert deze.

Dat gezegd hebbende, is het riskant om te proberen alles in één keer te doen voor elk bedrijf in welke branche dan ook. Om de risico's te beheersen hanteren we een gefaseerde aanpak, waardoor we onze technologie bij klanten kunnen valideren en onze strategie indien nodig kunnen aanpassen. We hebben bewezen dat ons getalformaat werkt en dat het een beter vermogen-prestatiegebied heeft dan gelijkwaardige drijvende-kommatypen, terwijl het ook betere numerieke eigenschappen heeft die het gemakkelijker maken om neurale netwerken te kwantiseren naar kleinere bitbreedtes. We hebben een architectuur ontworpen waar we vertrouwen in hebben, en die geschikt is voor zowel training als gevolgtrekking. Maar belangrijker dan dat alles is het goed krijgen van de software, en dat is het grootste deel van onze directe focus. We moeten ervoor zorgen dat we de juiste beslissingen nemen in onze softwarestack voor de situatie waarin we de wereld over een jaar of twee of langer zien.

Het opbouwen van een hardwarebedrijf is zwaar, duur en duurt lang. De focus op software klinkt in eerste instantie als een zeer levensvatbare onderneming op zichzelf, en potentieel aantrekkelijker voor investeerders in het huidige klimaat. Waarom doe je ook hardware, aangezien zoveel goed gefinancierde bedrijven in de sector hun deuren sluiten, moeite hebben om acceptatie bij klanten te krijgen en grotere spelers hun eigen hardware bouwen?

Je hebt absoluut gelijk als je zegt dat softwarebedrijven over het algemeen veel gemakkelijker kapitaal hebben kunnen aantrekken dan hardwarebedrijven, en dat hardware erg lastig is. Onze huidige focus ligt vooral op software, omdat we daar het grotere probleem zien. Laat me duidelijk zijn: het probleem is niet of ik kernels met hoge prestaties op een CPU of GPU kan laten draaien; dat is een al lang opgelost probleem. Het probleem van vandaag is hoe we het voor ontwikkelaars gemakkelijker kunnen maken om op productieve wijze meer prestaties te halen uit enkele duizenden knooppuntclusters die uit heterogene rekenkracht bestaan, zonder hen te vragen hun workflow te herzien.

Dat is het probleem waar we ons momenteel op richten met een softwarestack die ontwikkelaars superkrachten geeft en de volledige capaciteit van computers op magazijnschaal ontgrendelt, zodat we AI-modellen economischer kunnen trainen en inzetten.

Wat betreft investeringen: Ja, durfkapitaalfondsen zijn selectiever in het soort bedrijven dat zij steunen, maar het betekent ook dat durfkapitaalfondsen op zoek zijn naar bedrijven met het potentieel om werkelijk baanbrekende producten aan te bieden die een duidelijk pad naar commercialisering hebben en tegelijkertijd een aanzienlijke impact hebben. We hebben geleerd van de uitdagingen en fouten van anderen en hebben ons bedrijfsmodel en routekaart actief ontworpen om de risico's aan te pakken. Het is ook belangrijk om op te merken dat wat startups succesvol heeft gemaakt zelden het gemak is waarmee ze durfkapitaalfinanciering kunnen binnenhalen, maar meer te maken heeft met hun vindingrijkheid, koppigheid en klantgerichtheid.

En voordat je het vraagt: we werken nog steeds aan hardware, maar nu vooral aan simulatie. Het is niet de bedoeling dat we een tijdje gaan opnemen. Maar dat gesprek kunnen we bewaren voor een andere keer.

Dat is zeker overtuigend en uw gefaseerde aanpak is heel anders vergeleken met wat we andere hardwarebedrijven hebben zien doen. Ik begrijp het probleem dat u zegt dat uw softwarestack zal oplossen, maar hoe onderscheidt uw software zich van de verschillende inspanningen op de markt?

De meeste bedrijven waarnaar u verwijst, richten zich op het eenvoudiger maken van het programmeren van GPU's door op tegels gebaseerde of taaktoewijzingsprogrammeermodellen te introduceren om meer prestaties uit GPU's te halen, of door nieuwe programmeertalen te bouwen om krachtige kernels op verschillende locaties te kunnen plannen. platforms met ondersteuning voor in-line montage. Dat zijn belangrijke problemen die ze aanpakken, maar we beschouwen het probleem dat we oplossen als bijna orthogonaal.

Laten we even nadenken over de cadans van hardware- en software-overgangen. Single-core architecturen wonnen aan prestaties dankzij de kloksnelheid en de transistordichtheid, maar uiteindelijk bereikten de kloksnelheden een plateau. Parallellisme met behulp van veel kernen omzeilde dit en zorgde voor aanzienlijke versnellingen. Het kostte software ongeveer tien jaar om zijn achterstand in te halen, omdat programmeermodellen, compilers en runtimes opnieuw moesten worden bedacht om ontwikkelaars te helpen de waarde uit dit paradigma te halen. Toen begonnen GPU's versnellers voor algemene doeleinden te worden, wederom met een ander programmeermodel. Nogmaals, het duurde bijna tien jaar voordat ontwikkelaars hier waarde uit konden halen.

Opnieuw bereikt hardware een plateau: de wet van Moore, energie- en thermische beperkingen, geheugenknelpunten en de diversiteit aan werklasten plus de behoefte aan exponentieel meer rekenkracht drijven ons ertoe steeds heterogenere computerarchitecturen te bouwen voor betere prestaties, efficiëntie en totale kosten. Deze verschuiving in de hardware zal uiteraard voor uitdagingen voor de software zorgen, omdat we niet over de juiste compilers en runtimes beschikken om de volgende evolutie van computergebruik te ondersteunen. Deze keer hoeven we echter niet nog eens tien jaar te wachten voordat software de waarde van heterogene architecturen of grote clusters kan onttrekken, vooral als deze voor meer dan 10% ongebruikt blijven.

Waar we ons op concentreren is het bouwen van een heterogeniteitsbewust programmeermodel met taakgebaseerd parallellisme, waarbij draagbare prestaties worden aangepakt met cross-processoroptimalisaties, contextbewuste compilatie en dynamische toewijzing van bronnen. En voor ons maakt het niet uit of het een CPU, GPU, TPU, SPU (de architectuur van Lemurië) of een mesh van allemaal is. Ik weet dat dit als veel mooie woorden klinkt, maar wat het eigenlijk zegt, is dat we het mogelijk hebben gemaakt om elk soort processor met één enkele aanpak te programmeren, en dat we code van het ene soort processor naar de andere kunnen overbrengen met minimale inspanning. zonder dat dit ten koste gaat van de prestaties, en plan werk adaptief en dynamisch over verschillende knooppunten heen.

Als wat u zegt waar is, kunt u computers misschien volledig opnieuw definiëren. Laten we het over de financiering hebben. U heeft vorig jaar $9 miljoen aan startfinanciering opgehaald, wat duidt op sterke steun van investeerders en geloof in uw visie. Wat heb je sindsdien gedaan?

Het afgelopen jaar hebben we, dankzij de startfinanciering, aanzienlijke vooruitgang geboekt. Nu ons team uit twintig leden bestaat, hebben we de uitdagingen minutieus aangepakt, met klanten samengewerkt en onze aanpak verfijnd.

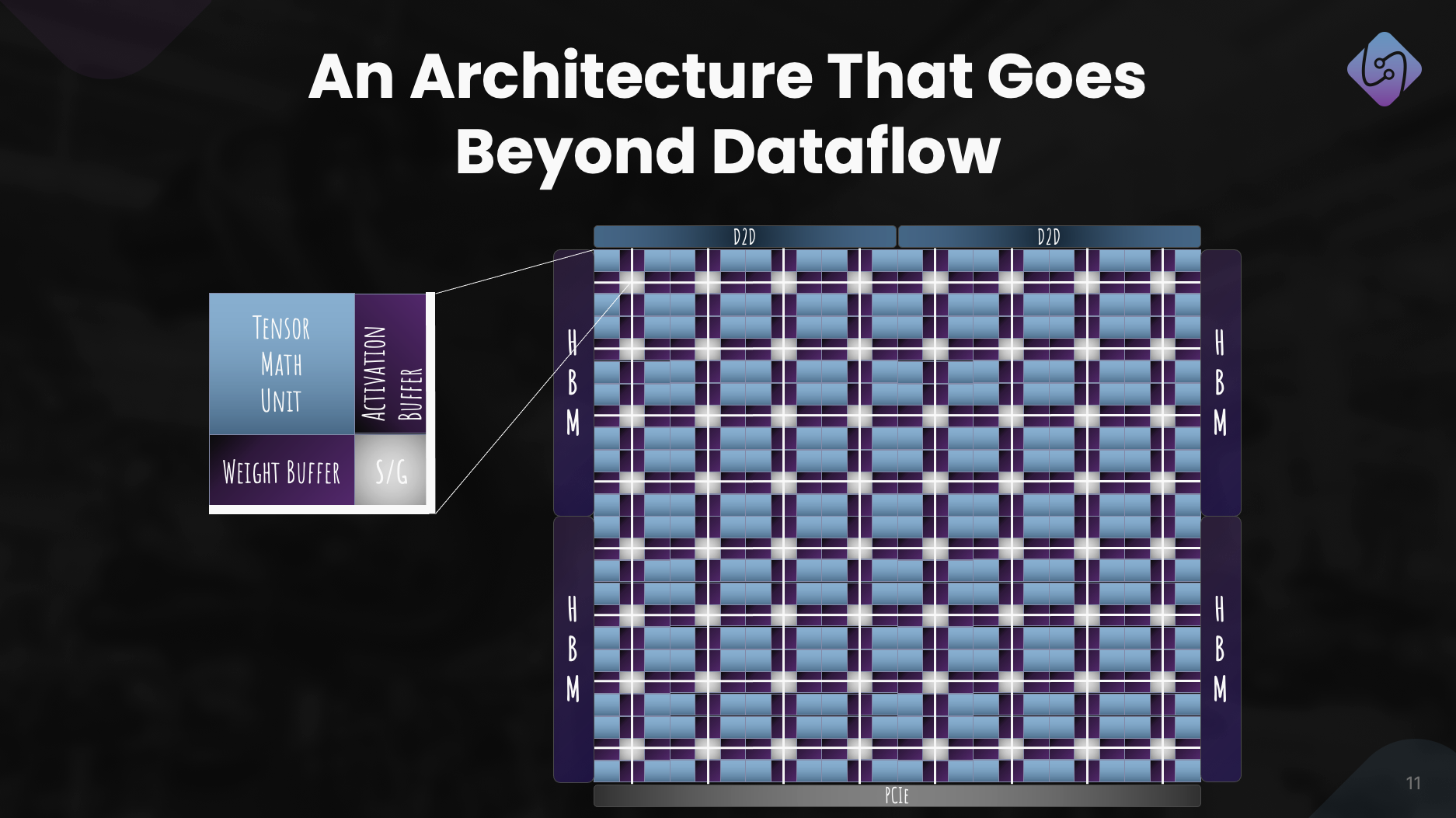

We concentreerden ons op het verbeteren van PAL voor training en gevolgtrekking, verkenden de computerarchitectuur voor onze accelerator en ontwikkelden een simulator voor prestatiestatistieken. Tegelijkertijd hebben we onze softwarestack voor datacentertoepassingen opnieuw vormgegeven, waarbij de nadruk ligt op heterogeen computergebruik.

Deze inspanning resulteerde in een goed gedefinieerde architectuur, die de doeltreffendheid van PAL voor AI op grote schaal demonstreert. Naast technologische vooruitgang streefden we ook naar samenwerking en outreach om de toegang te democratiseren. Deze inspanningen positioneren Lemurian Labs om de onmiddellijke uitdagingen van klanten aan te pakken en zich voor te bereiden op de vrijgave van ons productie-silicium.

Wat zijn de middellangetermijnplannen van Lemurian Labs met betrekking tot de ontwikkeling van softwarestacks, samenwerkingen en de verbetering van de architectuur van de accelerator?

Ons directe doel is om een softwarestack te creëren die zich richt op CPU's, GPU's en onze AI-versnellers met draagbare prestaties, die eind dit jaar beschikbaar zal worden gesteld aan vroege partners. We zijn momenteel in gesprek met de meeste toonaangevende halfgeleiderbedrijven, cloudserviceproviders, hyperscalers en AI-bedrijven om hen toegang te geven tot onze compiler en runtime. Tegelijkertijd blijven we werken aan en verbeteren van de architectuur van onze accelerator voor een echt gezamenlijk ontworpen systeem van hardware en software. En natuurlijk zijn we net begonnen met het verhogen van onze serie A met zeer sterke interesse van de investeerdersgemeenschap, waardoor we ons team kunnen laten groeien en ons doel voor de levering van softwareproducten aan het eind van het jaar kunnen bereiken.

Tot slot: hoe ziet u dat Lemurian Labs de komende jaren zal bijdragen aan het veranderen van het landschap van AI-ontwikkeling, toegankelijkheid en gelijkheid?

Het was niet onze bedoeling om computergebruik alleen maar te herdefiniëren voor commercieel gewin of voor het plezier ervan. Als Lemurianen is onze drijvende kracht dat we geloven in het transformerende potentieel van AI en dat meer dan slechts een paar bedrijven de middelen moeten hebben om de toekomst van deze technologie te bepalen en hoe we deze gebruiken. We vinden het ook niet acceptabel dat de datacenterinfrastructuur voor AI op koers ligt om in 20 maar liefst 2030% van de energie in de wereld te verbruiken. We kwamen allemaal samen omdat we geloven dat er een betere weg voorwaarts is voor de samenleving als we ervoor kunnen zorgen AI wordt toegankelijker door de bijbehorende kosten dramatisch te verlagen, het innovatietempo op het gebied van AI te versnellen en de impact ervan te vergroten. Door de uitdagingen van de huidige hardware-infrastructuur aan te pakken, proberen we de weg vrij te maken om een miljard mensen te voorzien van de mogelijkheden van AI, en zo een eerlijke distributie van deze geavanceerde technologie te garanderen. We hopen dat onze toewijding aan productgerichte oplossingen, samenwerking en voortdurende innovatie ons positioneert als een drijvende kracht in het vormgeven van de toekomst van AI-ontwikkeling om een positieve te zijn.

Lees ook:

Deel dit bericht via:

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

- Bron: https://semiwiki.com/ceo-interviews/341485-ceo-interview-jay-dawani-of-lemurian-labs-2/

- : heeft

- :is

- :niet

- :waar

- $ 9 miljoen

- $UP

- 1

- 10

- 20

- 2018

- 2022

- 2028

- 2030

- 20x

- 300

- 4

- a

- in staat

- Over

- absoluut

- versnellen

- versneld

- versneller

- versnellers

- aanvaardbaar

- toegang

- de toegankelijkheid

- beschikbaar

- Bereiken

- over

- actief

- toevoegen

- adres

- aangesproken

- aanpakken

- aanpassen

- Adoptie

- vergevorderd

- "Gevorderde Technologie

- vooruitgang

- adviseur

- weer

- vooruit

- AI

- AI-modellen

- algoritmische

- algoritmische handel

- Alles

- toewijzing

- Het toestaan

- bijna

- ook

- Amazone

- an

- en

- Nog een

- beantwoorden

- elke

- iedereen

- aantrekkelijk

- toepassingen

- nadering

- willekeurig

- architectuur

- architecturen

- ZIJN

- gebieden

- rond

- kunstmatig

- kunstmatige intelligentie

- AS

- vragen

- vragen

- bijeenkomst

- beoordeling

- geassocieerd

- verbazend

- At

- auteur

- autonoom

- Beschikbaar

- terug

- barrières

- gebaseerde

- BE

- omdat

- worden

- geweest

- vaardigheden

- wezen

- geloof

- geloofd wie en wat je bent

- voordeel

- BEST

- Betere

- Verder

- groter

- Miljard

- blockchain-gebaseerde

- boord

- lichaam

- zowel

- knelpunten

- Breaking

- breaks

- verbreden

- bouw

- Gebouw

- bouwt

- bebouwd

- massa

- bedrijfsdeskundigen

- bedrijfsmodel

- ondernemingen

- maar

- by

- Cadans

- Bellen

- kwam

- CAN

- Kan krijgen

- mogelijkheden

- bekwaamheid

- hoofdstad

- het worstelen

- Centreren

- ceo

- Interview met de CEO

- zeker

- uitdagen

- uitdagingen

- veranderende

- chassis

- ChatGPT

- goedkoper

- duidelijk

- klant

- Klimaat

- Klok

- sluitend

- Cloud

- cloud infrastructuur

- Mede-oprichter

- code

- samenwerking

- samenwerkingen

- komst

- commercieel

- commercialisering

- verplichting

- gemeenschap

- Bedrijven

- afstand

- vergeleken

- dwingende

- compiler

- compleet

- componenten

- Berekenen

- computer

- computers

- computergebruik

- zeker

- beperkingen

- consumeren

- voortzetten

- doorlopend

- bij te dragen

- convergeren

- Gesprek

- conversaties

- koelsysteem

- te corrigeren

- Kosten

- kon

- cursus

- aan het bedekken

- CPU

- en je merk te creëren

- Cross

- CTO

- Actueel

- Op dit moment

- gewoonte

- aangepast ontwerp

- klant

- Klanten

- gegevens

- Data Center

- Datacenter

- dag

- decennium

- beslissingen

- deep

- bepalen

- leveren

- levering

- eisen

- democratiseren

- dichtheid

- implementeren

- Design

- ontworpen

- ontwikkelen

- ontwikkelde

- ontwikkelaars

- het ontwikkelen van

- Ontwikkeling

- DEED

- anders

- onderscheiden

- Director

- afgelegen

- distributie

- Verscheidenheid

- do

- doet

- Nee

- doen

- dollar

- domein

- gedaan

- Dont

- deuren

- dramatisch

- tekening

- bestuurder

- aandrijving

- Val

- dynamisch

- dynamisch

- elk

- Vroeger

- Vroeg

- gemakkelijker

- gemakkelijk

- economisch

- Economie

- rand

- werkzaamheid

- doeltreffendheid

- inspanning

- inspanningen

- geeft je de mogelijkheid

- nadruk te leggen op

- empowering

- in staat stellen

- waardoor

- omvat

- einde

- energie-niveau

- bezig

- Motor

- verhogen

- verbeteren

- verzekeren

- zorgen

- Geheel

- billijk

- billijkheid

- Gelijkwaardig

- vooral

- etc

- uiteindelijk

- iedereen

- Evolutie

- overtreffen

- opgewonden

- opwindend

- bestaand

- verwachten

- duur

- expert

- exploratie

- Verken

- Nagegaan

- exponentieel

- extract

- buitengewoon

- feit

- verbeelding

- ver

- sneller

- uitgelicht

- voelen

- vilt

- weinig

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- Voornaam*

- drijvend

- Focus

- gericht

- gericht

- volgen

- Footprint

- Voor

- Dwingen

- formaat

- Naar voren

- Opgericht

- oprichten

- oppompen van

- Grens

- aangewakkerd

- vol

- Volledige stapel

- geheel

- leuke

- financiering

- toekomst

- Toekomst van AI

- Krijgen

- opgedaan

- gaming

- Gaming platform

- tandwieloverbrenging

- Algemeen

- algemeen

- geografisch

- krijgen

- het krijgen van

- Geven

- gegeven

- geeft

- doel

- gaan

- goed

- Kopen Google Reviews

- kreeg

- GPU

- GPU's

- baanbrekende

- Groeien

- HAD

- handvol

- Behandeling

- gebeurd

- gebeurt

- Hardware

- Hebben

- met

- he

- hulp

- hier

- Hoge

- hinderen

- zijn

- Hit

- raken

- hoop

- Hoe

- How To

- HTTPS

- Huang

- Hongerig

- i

- if

- beeld

- Onmiddellijk

- Impact

- belangrijk

- indrukwekkend

- verbeteren

- verbetering

- in

- in toenemende mate

- -industrie

- inefficiënties

- informeert

- Infrastructuur

- Innovatie

- Intelligentie

- voornemens zijn

- met elkaar verbonden

- belang

- Interview

- de invoering

- investering

- investeerder

- Investeerders

- isolatie

- IT

- HAAR

- Jensen Huang

- jpg

- voor slechts

- Houden

- Soort

- blijven

- laboratorium

- Labs

- Landschap

- Talen

- Groot

- groter

- Achternaam*

- Afgelopen jaar

- Wachttijd

- Wet

- leider

- leidend

- geleerd

- minst

- LED

- laten

- als

- ll

- lm

- lang

- lange tijd

- langer

- Kijk

- keek

- op zoek

- lot

- Laag

- het verlagen van

- machine

- Machines

- gemaakt

- maken

- MERKEN

- maken

- beheer

- veel

- Markt

- Marktleider

- wiskunde

- Materie

- max-width

- maximaal

- Mei..

- me

- middel

- Maak kennis met

- Leden

- Geheugen

- vermeld

- alleen

- mesh

- minutieus

- Metriek

- miljoen

- minimaal

- fouten

- model

- modellen

- Modern

- moment

- meer

- meest

- veel

- multidisciplinaire

- my

- NASA

- Noodzaak

- nodig

- nodig

- netwerken

- Neural

- neurale netwerken

- New

- volgende

- geen

- knooppunt

- knooppunten

- nota

- notie

- November

- nu

- nucleair

- aantal

- nummers

- of

- bieden

- on

- eens

- EEN

- Slechts

- OpenAI

- optimalisaties

- Optimaliseer

- Keuze

- or

- bestellen

- gewoon

- Overige

- Overig

- onze

- onszelf

- uit

- overtreffen

- over

- Revisie

- het te bezitten.

- ownership

- Tempo

- paradigma

- Parallel

- parameter

- deel

- partners

- onderdelen

- verleden

- pad

- plaveien

- Mensen

- prestatie

- Gefaseerde

- kiezen

- Spil

- plaatsen

- plannen

- platform

- platforms

- Plato

- Plato gegevensintelligentie

- PlatoData

- plus

- punt

- Oogpunt

- draagbare

- positie

- posities

- positief

- mogelijk

- Post

- potentieel

- mogelijk

- energie

- krachtige

- PRAKTISCH

- mooi

- voorkomen

- in de eerste plaats

- principes

- probleem

- problemen

- verwerking

- Gegevensverwerker

- Product

- productie

- Producten

- Programma

- Programming

- programmeertalen

- projecten

- vastgoed

- voorstel

- vooruitzicht

- Eiwit

- bewezen

- mits

- providers

- publiek

- puur

- doel

- voortvarend

- queries

- Race

- Racing

- verhogen

- opgebracht

- het verhogen van

- zelden

- Lees

- werkelijk

- reden

- Aanbeveling

- herdefiniëren

- herontwerp

- verminderen

- verwijzend

- verfijnd

- met betrekking tot

- reimagined

- los

- uitgebracht

- vertrouwen

- vereist

- hulpbron

- Resources

- verantwoordelijkheid

- REST

- resulteerde

- Resultaten

- <HR>Retail

- rechts

- risico's

- Riskant

- roadmap

- robotica

- robots

- Rollen

- ruw

- ronde

- reglement

- lopend

- offeren

- veilig

- Zei

- dezelfde

- Bespaar

- ervaren

- gezegde

- schaalbare

- Scale

- scaling

- rooster

- gepland

- zien

- zaad

- Startkapitaal

- Zaad rond

- Zoeken

- lijkt

- gezien

- selectief

- halfgeleider

- zin

- -Series

- Serie A

- dienen

- geserveerd

- service

- dienstverleners

- reeks

- verscheidene

- vorming

- verschuiving

- moet

- presentatie

- Bezienswaardigheden

- aanzienlijke

- betekent

- Silicium

- simulatie

- simulaties

- simulator

- gelijktijdig

- sinds

- single

- omvangrijk

- Schuif

- kleinere

- So

- Maatschappij

- Software

- oplossing

- Oplossingen

- OPLOSSEN

- opgelost

- Het oplossen van

- sommige

- Geluid

- geluiden

- Tussenruimte

- ruimteonderzoek

- ruimtelijke

- specifiek

- specifiek

- snelheid

- snelheden

- stack

- Stacks

- onthutsend

- begin

- gestart

- startup

- Startups

- Still

- stop

- Strategie

- stappen

- sterke

- Worstelen

- geslaagd

- dergelijk

- geschikt

- som

- ondersteuning

- steunen

- vermeend

- verrassing

- duurzaam

- system

- systemische

- Systems

- op maat gemaakt

- Nemen

- neemt

- het nemen

- Talk

- band

- doelwit

- doelen

- team

- tech

- Technologie

- neem contact

- dat

- De

- De toekomst

- Het landschap

- de wereld

- hun

- Ze

- harte

- Er.

- warmte-

- Deze

- ze

- spullen

- denken

- dit

- die

- toch?

- duizend

- Door

- doorvoer

- niet de tijd of

- banden

- naar

- vandaag

- samen

- ook

- nam

- Totaal

- taai

- in de richting van

- spoor

- Handel

- Trainen

- Trainingen

- traject

- transformatieve

- overgang

- overgangen

- Trends

- truc

- waar

- echt

- proberen

- twee

- types

- voor

- begrijpen

- eenheid

- ontsluit

- op

- us

- .

- gebruik

- BEVESTIG

- waarde

- divers

- VC

- VC-financiering

- VC's

- zeer

- via

- rendabel

- Bekijk

- visie

- wachten

- willen

- Magazijn

- was

- we

- gewicht

- GOED

- goed gedefinieerd

- gegaan

- waren

- Wat

- wanneer

- of

- welke

- en

- Waarom

- wil

- Met

- zonder

- woorden

- Mijn werk

- workflow

- werkzaam

- Bedrijven

- wereld

- s werelds

- zou

- jaar

- jaar

- ja

- u

- Your

- zephyrnet