Afbeelding gemaakt door Editor met Midjourney

Welkom bij de editie van deze week van "This Week in AI" op KDnuggets. Deze samengestelde wekelijkse post is bedoeld om u op de hoogte te houden van de meest boeiende ontwikkelingen in de snel voortschrijdende wereld van kunstmatige intelligentie. Van baanbrekende krantenkoppen die ons begrip van de rol van AI in de samenleving bepalen tot tot nadenken stemmende artikelen, verhelderende leermiddelen en uitgelicht onderzoek dat de grenzen van onze kennis verlegt, dit bericht biedt een uitgebreid overzicht van het huidige landschap van AI. Deze wekelijkse update is bedoeld om u op de hoogte te houden van dit steeds evoluerende veld. Blijf op de hoogte en veel leesplezier!

In de rubriek “Headlines” wordt het belangrijkste nieuws en de ontwikkelingen van de afgelopen week op het gebied van kunstmatige intelligentie besproken. De informatie varieert van AI-beleid van de overheid tot technologische vooruitgang en bedrijfsinnovaties op het gebied van AI.

👏 ChatGPT in de problemen: OpenAI kan in 2024 failliet gaan, AI-bot kost bedrijf elke dag $ 700,000

OpenAI heeft financiële problemen vanwege de hoge kosten voor het uitvoeren van ChatGPT en andere AI-diensten. Ondanks de snelle groei in het begin is het gebruikersbestand van ChatGPT de afgelopen maanden afgenomen. OpenAI worstelt om zijn technologie effectief te gelde te maken en duurzame inkomsten te genereren. Ondertussen blijft het contant geld in een alarmerend tempo doorbranden. Nu de concurrentie toeneemt en de GPU-tekorten van bedrijven de modelontwikkeling belemmeren, moet OpenAI dringend wegen naar winstgevendheid vinden. Als dat niet lukt, kan een faillissement aan de horizon liggen voor de baanbrekende AI-startup.

👏 Stability AI kondigt StableCode aan, een AI-coderingsassistent voor ontwikkelaars

Stability AI heeft StableCode uitgebracht, het eerste generatieve AI-product dat is geoptimaliseerd voor softwareontwikkeling. StableCode bevat meerdere modellen die zijn getraind op meer dan 500 miljard tokens aan code om intelligente automatische aanvulling te bieden, te reageren op instructies in natuurlijke taal en lange reeksen code te beheren. Hoewel conversatie-AI al code kan schrijven, is StableCode speciaal gebouwd om de productiviteit van programmeurs te verhogen door inzicht te krijgen in de codestructuur en afhankelijkheden. Met zijn gespecialiseerde training en modellen die lange contexten aankunnen, wil StableCode de werkstromen van ontwikkelaars verbeteren en de toetredingsdrempel voor aspirant-codeerders verlagen. De lancering vertegenwoordigt Stability AI's uitstapje naar AI-ondersteunde coderingstools te midden van groeiende concurrentie in de ruimte.

👏 Introductie van Superalignment door OpenAI

OpenAI werkt proactief aan het aanpakken van potentiële risico's van superintelligente AI via hun nieuwe Superalignment-team, dat technieken gebruikt zoals versterkend leren van menselijke feedback om AI-systemen op elkaar af te stemmen. De belangrijkste doelen zijn het ontwikkelen van schaalbare trainingsmethoden die gebruikmaken van andere AI-systemen, het valideren van de robuustheid van modellen en het stresstesten van de volledige uitlijningspijplijn, zelfs met opzettelijk verkeerd uitgelijnde modellen. Over het algemeen wil OpenAI laten zien dat machine learning veilig kan worden uitgevoerd door baanbrekende benaderingen om superintelligentie op verantwoorde wijze te sturen.

👏 Leer terwijl u zoekt (en bladert) met behulp van generatieve AI

Google kondigt verschillende updates aan voor zijn Search Engine Generation (SGE) AI-mogelijkheden, waaronder hover-definities voor wetenschappelijke/historische onderwerpen, kleurgecodeerde syntaxisaccentuering voor code-overzichten en een vroeg experiment genaamd "SGE tijdens browsen" dat de belangrijkste punten samenvat en gebruikers helpt pagina's verkennen bij het lezen van lange inhoud op internet. Deze zijn bedoeld om het begrip van complexe onderwerpen te verbeteren, de vertering van coderingsinformatie te verbeteren en navigatie en leren te vergemakkelijken terwijl gebruikers browsen. De updates vertegenwoordigen de voortdurende inspanningen van Google om zijn AI-zoekervaring te ontwikkelen op basis van gebruikersfeedback, met de nadruk op begrip en het extraheren van belangrijke details uit complexe webinhoud.

👏 Together.ai breidt Llama2 uit naar een contextvenster van 32k

LLaMA-2-7B-32K is een open-source taalmodel met lange context, ontwikkeld door Together Computer, dat de contextlengte van Meta's LLaMA-2 uitbreidt tot 32K-tokens. Het maakt gebruik van optimalisaties zoals FlashAttention-2 om efficiëntere gevolgtrekkingen en training mogelijk te maken. Het model is vooraf getraind met behulp van een combinatie van gegevens, waaronder boeken, papers en instructiegegevens. Er worden voorbeelden gegeven voor het verfijnen van QA- en samenvattingstaken in lange vorm. Gebruikers hebben toegang tot het model via Hugging Face of gebruiken de OpenChatKit voor aangepaste fijnafstemming. Zoals alle taalmodellen kan LLaMA-2-7B-32K vooringenomen of onjuiste inhoud genereren, waardoor voorzichtigheid geboden is bij het gebruik.

Het gedeelte 'Artikelen' presenteert een reeks tot nadenken stemmende stukken over kunstmatige intelligentie. Elk artikel duikt diep in een specifiek onderwerp en biedt lezers inzicht in verschillende aspecten van AI, waaronder nieuwe technieken, revolutionaire benaderingen en baanbrekende tools.

Met LangChain kunnen ontwikkelaars capabele AI-taalgebaseerde apps bouwen zonder het wiel opnieuw uit te vinden. De composable structuur maakt het gemakkelijk om componenten zoals LLM's, promptsjablonen, externe tools en geheugen te mixen en matchen. Dit versnelt prototyping en maakt een naadloze integratie van nieuwe mogelijkheden in de loop van de tijd mogelijk. Of u nu een chatbot, QA-bot of multi-step redeneeragent wilt maken, LangChain biedt de bouwstenen om snel geavanceerde AI samen te stellen.

📰 Hoe ChatGPT te gebruiken om tekst om te zetten in een PowerPoint-presentatie

Het artikel schetst een proces in twee stappen voor het gebruik van ChatGPT om tekst om te zetten in een PowerPoint-presentatie, waarbij eerst de tekst wordt samengevat in diatitels en inhoud, en vervolgens Python-code wordt gegenereerd om de samenvatting naar PPTX-indeling te converteren met behulp van de python-pptx-bibliotheek. Dit maakt het mogelijk om snel boeiende presentaties te maken van lange tekstdocumenten, waardoor vervelende handmatige inspanningen worden overwonnen. Er wordt duidelijke instructie gegeven over het maken van de ChatGPT-prompts en het uitvoeren van de code, wat een efficiënte geautomatiseerde oplossing biedt voor presentatiebehoeften.

📰 Open uitdagingen in LLM-onderzoek

Het artikel geeft een overzicht van 10 belangrijke onderzoeksrichtingen om grote taalmodellen te verbeteren: hallucinatie verminderen, contextlengte/constructie optimaliseren, multimodale data integreren, modellen versnellen, nieuwe architecturen ontwerpen, GPU-alternatieven zoals fotonische chips ontwikkelen, bruikbare agents bouwen, leren van menselijke feedback, verbeterde chatinterfaces en uitbreiding naar niet-Engelse talen. Het citeert relevante artikelen over deze gebieden, en wijst op uitdagingen zoals het weergeven van menselijke voorkeuren voor versterkend leren en het bouwen van modellen voor talen met weinig middelen. De auteur concludeert dat sommige kwesties, zoals meertaligheid, beter hanteerbaar zijn, terwijl andere, zoals architectuur, meer doorbraken vereisen. Over het algemeen zal zowel technische als niet-technische expertise van onderzoekers, bedrijven en de gemeenschap van cruciaal belang zijn om LLM's positief te sturen.

📰 Waarom u (waarschijnlijk) geen LLM hoeft te verfijnen

Het artikel geeft een overzicht van 10 belangrijke onderzoeksrichtingen om grote taalmodellen te verbeteren: hallucinatie verminderen, contextlengte/constructie optimaliseren, multimodale data integreren, modellen versnellen, nieuwe architecturen ontwerpen, GPU-alternatieven zoals fotonische chips ontwikkelen, bruikbare agents bouwen, leren van menselijke feedback, verbeterde chatinterfaces en uitbreiding naar niet-Engelse talen. Het citeert relevante artikelen over deze gebieden, en wijst op uitdagingen zoals het weergeven van menselijke voorkeuren voor versterkend leren en het bouwen van modellen voor talen met weinig middelen. De auteur concludeert dat sommige kwesties, zoals meertaligheid, beter hanteerbaar zijn, terwijl andere, zoals architectuur, meer doorbraken vereisen. Over het algemeen zal zowel technische als niet-technische expertise van onderzoekers, bedrijven en de gemeenschap van cruciaal belang zijn om LLM's positief te sturen.

📰 Best practices voor het gebruik van het OpenAI GPT-model

Het artikel schetst best practices voor het verkrijgen van uitvoer van hoge kwaliteit bij het gebruik van de GPT-modellen van OpenAI, gebaseerd op de ervaring van de gemeenschap. Het raadt aan om gedetailleerde aanwijzingen te geven met details zoals lengte en persona; instructies in meerdere stappen; voorbeelden om na te bootsen; referenties en citaten; tijd voor kritisch denken; en code-uitvoering voor precisie. Het volgen van deze tips voor het instrueren van de modellen, zoals het specificeren van stappen en persona's, kan leiden tot nauwkeurigere, relevantere en aanpasbare resultaten. De richtlijnen zijn bedoeld om gebruikers te helpen prompts effectief te structureren om het meeste uit de krachtige generatieve mogelijkheden van OpenAI te halen.

📰 We hebben het helemaal mis over AI

De auteur betoogt dat de huidige AI-mogelijkheden worden onderschat en gebruikt voorbeelden als creativiteit, zoeken en personalisatie om algemene misvattingen tegen te gaan. Hij stelt dat AI creatief kan zijn door concepten opnieuw te combineren, niet alleen door willekeurige ideeën te genereren; het is niet alleen een supercharged zoekmachine zoals Google; en het kan gepersonaliseerde relaties ontwikkelen, niet alleen generieke vaardigheden. Hoewel hij niet zeker weet welke toepassingen het nuttigst zullen blijken, dringt de auteur aan op een open geest in plaats van afwijzend te zijn, waarbij hij benadrukt dat de beste manier om het potentieel van AI te bepalen, is door voortdurend hands-on onderzoek te doen. Hij concludeert dat onze verbeeldingskracht rond AI beperkt is en dat het gebruik ervan de huidige voorspellingen waarschijnlijk ver overtreft.

In het gedeelte "Tools" staan handige apps en scripts die door de community zijn gemaakt voor degenen die aan de slag willen met praktische AI-toepassingen. Hier vindt u een scala aan tooltypes, van grote uitgebreide codebases tot kleine nichescripts. Houd er rekening mee dat tools worden gedeeld zonder goedkeuring en zonder enige vorm van garantie. Doe je eigen huiswerk over alle software voorafgaand aan installatie en gebruik!

️ MetaGPT: het multi-agent-framework

MetaGPT neemt een regelvereiste als input en output gebruikersverhalen / concurrentieanalyse / vereisten / datastructuren / API's / documenten, enz. Intern omvat MetaGPT productmanagers / architecten / projectmanagers / ingenieurs. Het biedt het hele proces van een softwarebedrijf, samen met zorgvuldig georkestreerde SOP's.

Het doel van dit project is het verkennen van een experimentele nieuwe pijplijn om een goed presterend taakspecifiek model te trainen. We proberen alle complexiteit weg te abstraheren, dus het is zo gemakkelijk mogelijk om van idee -> performant, volledig getraind model te gaan.

Voer gewoon een beschrijving van uw taak in en het systeem genereert een geheel nieuwe dataset, ontleedt deze in het juiste formaat en stemt een LLaMA 2-model voor u af.

DoctorGPT is een groot taalmodel dat kan slagen voor het US Medical Licensing Exam. Dit is een open-sourceproject met als missie om iedereen zijn eigen privédokter te geven. DoctorGPT is een versie van Meta's Llama2 7 miljard parameter Large Language Model dat is verfijnd op een Medical Dialogue Dataset en vervolgens verder is verbeterd met behulp van Reinforcement Learning & Constitutional AI. Aangezien het model slechts 3 gigabyte groot is, past het op elk lokaal apparaat, dus u hoeft geen API te betalen om het te gebruiken.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- PlatoData.Network Verticale generatieve AI. Versterk jezelf. Toegang hier.

- PlatoAiStream. Web3-intelligentie. Kennis versterkt. Toegang hier.

- PlatoESG. Automotive / EV's, carbon, CleanTech, Energie, Milieu, Zonne, Afvalbeheer. Toegang hier.

- Plato Gezondheid. Intelligentie op het gebied van biotech en klinische proeven. Toegang hier.

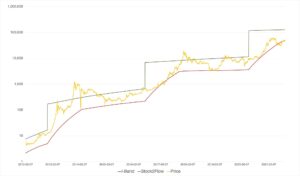

- ChartPrime. Verhoog uw handelsspel met ChartPrime. Toegang hier.

- BlockOffsets. Eigendom voor milieucompensatie moderniseren. Toegang hier.

- Bron: https://www.kdnuggets.com/2023/08/this-week-ai-2023-08-18.html?utm_source=rss&utm_medium=rss&utm_campaign=this-week-in-ai-august-18-openai-in-financial-trouble-stability-ai-announces-stablecode

- : heeft

- :is

- :niet

- $UP

- 000

- 10

- 11

- 14

- 2024

- 500

- 7

- a

- Over

- SAMENVATTING

- versnelt

- versnellen

- toegang

- accuraat

- over

- adres

- vergevorderd

- vooruitgang

- oprukkende

- Agent

- agenten

- AI

- AI-diensten

- AI-systemen

- Steun

- streven

- wil

- richten

- Alles

- toestaat

- langs

- al

- alternatieven

- midden

- an

- analyse

- en

- kondigt

- Het aankondigen

- elke

- api

- APIs

- toepassingen

- benaderingen

- apps

- architecten

- architectuur

- ZIJN

- gebieden

- Argumenten

- rond

- reeks

- dit artikel

- artikelen

- kunstmatig

- kunstmatige intelligentie

- AS

- aspecten

- eerzuchtig

- Assistent

- At

- Augustus

- auteur

- geautomatiseerde

- weg

- bankroet

- Faillissement

- barrière

- baseren

- gebaseerde

- BE

- BEST

- 'best practices'

- vooringenomen

- Miljard

- miljard tokens

- Blokken

- Boeken

- boost

- Bot

- zowel

- grenzen

- doorbraken

- Bladeren

- bouw

- Gebouw

- modellen bouwen

- brandwond

- druk

- by

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- CAN

- mogelijkheden

- in staat

- voorzichtig

- Contant geld

- voorzichtigheid

- uitdagingen

- Chatbot

- ChatGPT

- chips

- duidelijk

- code

- codering

- Gemeen

- gemeenschap

- Bedrijven

- afstand

- dwingende

- concurrentie

- concurrerend

- complex

- ingewikkeldheid

- componenten

- uitgebreid

- computer

- concepten

- uitgevoerd

- content

- verband

- contexten

- voortgezet

- blijft

- spraakzaam

- conversatie AI

- converteren

- Bedrijfs-

- Kosten

- Counter

- en je merk te creëren

- aangemaakt

- het aanmaken

- Creatieve

- creativiteit

- kritisch

- curated

- Actueel

- aanpasbare

- aangepaste

- gegevens

- deep

- definities

- afhankelijkheden

- beschrijving

- ontworpen

- ontwerpen

- Niettegenstaande

- gedetailleerd

- gegevens

- Bepalen

- ontwikkelen

- ontwikkelde

- Ontwikkelaar

- ontwikkelaars

- het ontwikkelen van

- Ontwikkeling

- ontwikkelingen

- apparaat

- Dialoog

- richtingen

- do

- dokter

- documenten

- Dont

- tekening

- twee

- elk

- Vroeg

- En het is heel gemakkelijk

- editie

- editor

- effectief

- doeltreffend

- inspanningen

- nadruk te leggen op

- in staat stellen

- boeiende

- Motor

- Ingenieurs

- verhogen

- verbeteren

- Enterprise

- Geheel

- toegang

- etc

- Ether (ETH)

- Zelfs

- Alle

- iedereen

- ontwikkelen

- tentamen

- voorbeelden

- overtreffen

- uitvoering

- uit te breiden

- ervaring

- experiment

- experimenteel

- expertise

- exploratie

- Verken

- verlengen

- strekt

- extern

- Gezicht

- naar

- mislukt

- ver

- feedback

- veld-

- financieel

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- Voornaam*

- Focus

- volgend

- Voor

- inval

- formaat

- oppompen van

- vol

- verder

- voortbrengen

- het genereren van

- generatie

- generatief

- generatieve AI

- krijgen

- Go

- doel

- Doelen

- Kopen Google Reviews

- regerings-

- GPU

- baanbrekende

- baanbrekende

- Groeiend

- garantie

- leiding

- handvat

- hands-on

- gelukkig

- he

- Headlines

- hulp

- helpt

- hier

- Hoge

- goed presterende

- hoogwaardige

- markeren

- huiswerk

- horizont

- zweven

- HTML

- HTTPS

- menselijk

- idee

- ideeën

- if

- verbeelding

- verbeteren

- verbeterd

- het verbeteren van

- in

- omvat

- Inclusief

- omvat

- opnemen

- informatie

- op de hoogte

- innovaties

- invoer

- inzichtelijke

- inzichten

- installatie

- leerzaam

- instructies

- integratie

- Intelligentie

- Intelligent

- opzettelijk

- interfaces

- inwendig

- in

- problemen

- IT

- HAAR

- voor slechts

- KDnuggets

- Houden

- sleutel

- kennis

- Landschap

- taal

- Talen

- Groot

- lancering

- leiden

- leren

- Lengte

- hefbomen

- leveraging

- Bibliotheek

- Licenties

- als

- Waarschijnlijk

- Beperkt

- Lijn

- lijsten

- Lama

- lokaal

- lang

- op zoek

- te verlagen

- machine

- machine learning

- MERKEN

- beheer

- Managers

- handboek

- Match

- Mei..

- Ondertussen

- medisch

- Geheugen

- alleen

- meta

- methoden

- denken

- misvattingen

- Missie

- mengen

- mengsel

- model

- modellen

- gelde

- maanden

- meer

- efficiënter

- meest

- meervoudig

- Naturel

- Natuurlijke taal

- Navigatie

- Noodzaak

- behoeften

- New

- nieuws

- nis

- geen

- niet-technische

- opmerkend

- het verkrijgen van

- of

- het aanbieden van

- on

- EEN

- Slechts

- open

- open source

- OpenAI

- geoptimaliseerde

- optimaliseren

- or

- georkestreerd

- Overige

- Overig

- onze

- uit

- outlines

- over

- totaal

- het overwinnen van

- overzicht

- het te bezitten.

- paginas

- papieren

- parameter

- passeren

- verleden

- Betaal

- Personalisatie

- Gepersonaliseerde

- stukken

- baanbrekende

- pijpleiding

- Plato

- Plato gegevensintelligentie

- PlatoData

- punten

- beleidsmaatregelen door te lezen.

- mogelijk

- Post

- potentieel

- krachtige

- PRAKTISCH

- praktijken

- precisie

- Voorspellingen

- voorkeuren

- presentatie

- Presentaties

- cadeautjes

- Voorafgaand

- privaat

- waarschijnlijk

- Product

- produktiviteit

- winstgevendheid

- Programmeur

- project

- prototyping

- Bewijzen

- zorgen voor

- mits

- biedt

- het verstrekken van

- voortvarend

- Python

- Q & A

- willekeurige

- reeks

- snel

- snel

- tarief

- liever

- RE

- lezers

- lezing

- recent

- beveelt

- vermindering

- referenties

- versterking van leren

- Relaties

- uitgebracht

- relevante

- vertegenwoordigen

- vertegenwoordigen

- vertegenwoordigt

- vereisen

- vereiste

- Voorwaarden

- onderzoek

- onderzoekers

- Resources

- Reageren

- Resultaten

- inkomsten

- revolutionair

- rechts

- risico's

- robuustheid

- Rol

- lopend

- s

- veilig

- schaalbare

- krassen

- scripts

- naadloos

- Ontdek

- zoekmachine

- sectie

- Diensten

- verscheidene

- Vorm

- gedeeld

- tekorten

- tonen

- sinds

- Maat

- vaardigheden

- Schuif

- Klein

- So

- Maatschappij

- Software

- software development

- oplossing

- sommige

- Tussenruimte

- overspanningen

- gespecialiseerde

- specifiek

- bijzonderheden

- Stabiliteit

- startup

- Staten

- blijven

- Stappen

- Blog

- spanning

- structuur

- Worstelen

- dergelijk

- OVERZICHT

- superintelligentie

- duurzaam

- syntaxis

- system

- Systems

- neemt

- Taak

- taken

- team

- Technisch

- technieken

- technologisch

- Technologie

- templates

- Testen

- neem contact

- dat

- De

- de informatie

- hun

- harte

- Er.

- Deze

- het denken

- dit

- deze week

- die

- tot nadenken stemmend

- Door

- niet de tijd of

- tips

- titels

- naar

- samen

- tokens

- tools

- tools

- top

- onderwerp

- onderwerpen

- Trainen

- getraind

- Trainingen

- moeite

- proberen

- types

- begrip

- bijwerken

- bijgewerkt

- updates

- driften

- us

- bruikbaar

- .

- Gebruiker

- gebruikers

- toepassingen

- gebruik

- valideren

- divers

- versie

- via

- willen

- was

- Manier..

- we

- web

- week

- per week

- Wiel

- wanneer

- of

- welke

- en

- WIE

- wil

- Met

- zonder

- workflows

- werkzaam

- wereld

- schrijven

- code schrijven

- Verkeerd

- u

- Your

- zephyrnet