Intel Corporation의 연구원들은 "Intel GPU의 효율적인 LLM 추론 솔루션"이라는 기술 논문을 발표했습니다.

요약 :

“Transformer 기반 LLM(Large Language Models)은 다양한 분야에서 널리 사용되고 있으며, LLM 추론의 효율성은 실제 응용 분야에서 화제가 되고 있습니다. 그러나 LLM은 일반적으로 대규모 작업이 포함된 모델 구조로 복잡하게 설계되고 자동 회귀 모드에서 추론을 수행하므로 높은 효율성으로 시스템을 설계하는 것이 어려운 작업입니다.

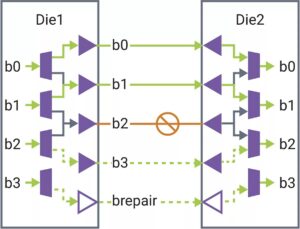

본 논문에서는 낮은 지연 시간과 높은 처리량을 갖춘 효율적인 LLM 추론 솔루션을 제안합니다. 첫째, 메모리 액세스 빈도를 줄이고 시스템 대기 시간을 낮추기 위해 데이터 이동과 요소별 작업을 융합하여 LLM 디코더 계층을 단순화합니다. 또한 효과적인 장치 메모리 관리를 위해 요청 및 응답 토큰의 키/값을 별도의 물리적 메모리에 유지하여 런타임 배치 크기를 확대하고 시스템 처리량을 향상시키는 세그먼트 KV 캐시 정책을 제안합니다. 맞춤형 Scaled-Dot-Product-Attention 커널은 세그먼트 KV 캐시 솔루션을 기반으로 하는 융합 정책과 일치하도록 설계되었습니다. 우리는 Intel GPU에서 LLM 추론 솔루션을 구현하고 이를 공개적으로 게시합니다. 표준 HuggingFace 구현과 비교하여 제안된 솔루션은 Intel GPU의 일부 인기 있는 LLM에 대해 최대 7배 더 낮은 토큰 대기 시간과 27배 더 높은 처리량을 달성합니다."

찾기 여기에 기술 문서가 있습니다. 2023년 XNUMX월 출판(사전 인쇄).

Wu, Hui, Yi Gan, Feng Yuan, Jing Ma, Wei Zhu, Yutao Xu, Hong Zhu, Yuhua Zhu, Xiaoli Liu 및 Jinghui Gu. “인텔 GPU의 효율적인 LLM 추론 솔루션.” arXiv 사전 인쇄 arXiv:2401.05391 (2023).

관련 독서

CPU에 대한 LLM 추론(인텔)

인텔 연구진은 "CPU에 대한 효율적인 LLM 추론"이라는 기술 논문을 발표했습니다.

AI는 가장자리까지 경주합니다.

AI가 새로운 애플리케이션으로 확산됨에 따라 추론 및 일부 교육이 더 작은 장치로 추진되고 있습니다.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- PlatoData.Network 수직 생성 Ai. 자신에게 권한을 부여하십시오. 여기에서 액세스하십시오.

- PlatoAiStream. 웹3 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 플라톤ESG. 탄소, 클린테크, 에너지, 환경, 태양광, 폐기물 관리. 여기에서 액세스하십시오.

- PlatoHealth. 생명 공학 및 임상 시험 인텔리전스. 여기에서 액세스하십시오.

- 출처: https://semiengineering.com/llm-inference-on-gpus-intel/

- :이다

- $UP

- 2023

- a

- ACCESS

- 달성하다

- AI

- 또한

- an

- 및

- 어플리케이션

- 있군요

- AS

- At

- 기반으로

- 된다

- 된

- 존재

- by

- 캐시

- 도전

- 비교

- 법인

- 사용자 정의

- 데이터

- XNUMX월

- 디자인

- 설계

- 장치

- 디바이스

- 유효한

- 효율성

- 효율적인

- 크게 하다

- Fields

- 럭셔리

- 진동수

- 융합

- 퓨전

- GPU

- GPU

- 있다

- 도움이

- 여기에서 지금 확인해 보세요.

- 높은

- 더 높은

- 홍콩

- 뜨거운

- 그러나

- HTTPS

- 포옹 얼굴

- 구현

- 이행

- 개선

- in

- 인텔

- IT

- JPG

- 유지

- 언어

- 넓은

- 숨어 있음

- 층

- llm

- 낮은

- 절감

- 유튜브 영상을 만드는 것은

- 구축

- .

- 거대한

- 경기

- 메모리

- 모드

- 모델

- 모델

- 운동

- 신제품

- of

- on

- 열 수

- 행정부

- 우리의

- 서

- 수행

- 물리적

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- 정책

- 인기 문서

- 제안

- 제안 된

- 공개적으로

- 게시

- 출판

- 밀

- 경마 대회

- 현실

- 감소

- 의뢰

- 연구원

- 응답

- 분절

- 별도의

- 단순화

- 크기

- 작은

- 해결책

- 일부

- 스프레드

- 표준

- 구조

- 체계

- 태스크

- 테크니컬

- XNUMXD덴탈의

- 이

- 처리량

- 제목의

- 에

- 토큰

- 토큰

- 화제

- 트레이닝

- 익숙한

- 보통

- 였다

- we

- 크게

- 과

- 원

- 제퍼 넷