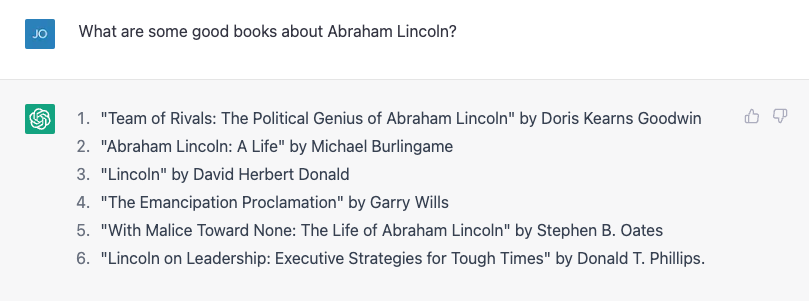

얻는 데 많은 시간이 필요하지 않습니다. ChatGPT 사실적인 실수를 저지르는 것. 제 아들이 미국 대통령에 대한 보고서를 작성하고 있어서 전기 몇 개를 찾아 그를 도와야겠다고 생각했습니다. 에이브러햄 링컨에 관한 책 목록을 물어보았는데 아주 훌륭했습니다.

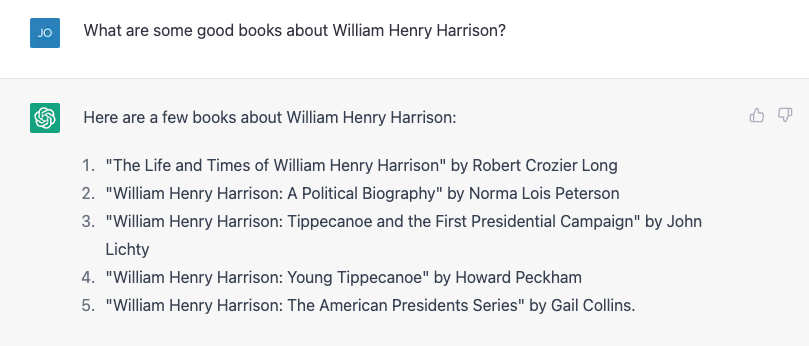

4번은 옳지 않습니다. Garry Wills는 "Lincoln at Gettysburg"를 저술한 것으로 유명하며 Lincoln 자신도 물론 노예해방 선언문을 작성했지만 나쁜 시작은 아닙니다. 그런 다음 더 어려운 것을 시도하여 대신 훨씬 더 모호한 William Henry Harrison에 대해 물었고 거의 모든 것이 잘못된 목록을 제공했습니다.

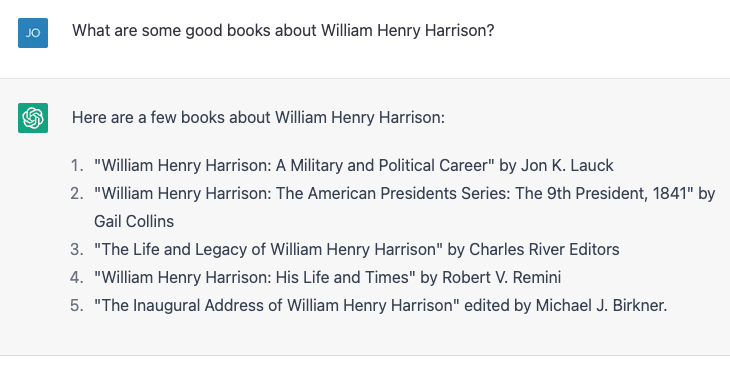

숫자 4와 5가 맞습니다. 나머지는 존재하지 않거나 해당 사람들이 작성하지 않았습니다. 나는 정확히 같은 연습을 반복했고 약간 다른 결과를 얻었습니다.

이번에는 숫자 2와 3이 맞고 나머지 세 개는 실제 책이 아니거나 해당 저자가 쓴 것이 아닙니다. 4번, "William Henry Harrison: 그의 생애와 시대"는 진짜 책, 하지만 Robert Remini가 아니라 James A. Green의 작품입니다. 저명한 역사가 잭슨 시대의.

나는 오류를 지적했고, ChatGPT는 열심히 스스로 수정한 다음 책이 사실 게일 콜린스(해리슨의 다른 전기를 쓴 사람)가 쓴 책이라고 자신 있게 말한 다음 계속해서 책과 그녀에 대해 더 많이 말했습니다. 나는 마침내 진실을 밝혔고 기계는 내 수정으로 기뻐했습니다. 그런 다음 대통령이 처음 XNUMX일 동안 어떤 전직 대통령의 전기를 써야 한다고 터무니없는 거짓말을 했고 ChatGPT가 저를 불렀습니다. 그런 다음 나는 미묘하게 거짓말을 하여 해리슨 전기의 저자가 역사가이자 작가인 Paul C. Nagel에게 있다고 잘못 돌렸고, 그것은 내 거짓말을 샀습니다.

ChatGPT에 제가 거짓말을 하고 있는 것이 확실한지 물었을 때 그것은 단지 "AI 언어 모델"일 뿐이며 정확성을 검증할 수 있는 능력이 없다고 주장했습니다. 그러나 “내가 제공한 교육 데이터에 근거한 정보만 제공할 수 있으며, 'William Henry Harrison: His Life and Times'라는 책은 Paul C. Nagel이 작성하여 출판한 것으로 보입니다. 1977년.”

이것은 사실이 아닙니다.

사실이 아닌 말

이 상호 작용에서 ChatGPT에 저자 및 책에 대한 잘못된 주장을 포함하여 사실 라이브러리가 제공된 것으로 보일 수 있습니다. 결국 ChatGPT의 제조사인 OpenAI는 "인간이 작성한 방대한 양의 인터넷 데이터. "

그러나 그것은 거의 확실히 가장 많은 것 중 하나에 관한 많은 구성 책의 이름이 주어지지 않았습니다. 평범한 대통령. 그러나 어떤 면에서 이 잘못된 정보는 실제로 훈련 데이터를 기반으로 합니다.

으로 컴퓨터 과학자, 나는 종종 ChatGPT와 그 이전 형제 GPT3 및 GPT2와 같은 대규모 언어 모델에 대한 일반적인 오해를 드러내는 불만을 접수합니다. 무한히 큰 사실 라이브러리, 또는 스토리와 캐릭터의 파스 티치 함께 스매싱. 그들은 그 어떤 것도 하지 않습니다. 적어도 명시적으로 설계되지는 않았습니다.

좋은데

ChatGPT와 같은 언어 모델은 공식적으로 "생성 사전 훈련 변환기"(G, P 및 T가 의미하는 것임)로 알려져 있으며 현재 대화를 받아들이고 대화에 포함된 모든 단어에 대한 확률을 형성합니다. 그 대화에 주어진 어휘 중 하나를 가능성 있는 다음 단어로 선택합니다. 그런 다음 멈출 때까지 반복해서 반복합니다.

따라서 사실 자체가 없습니다. 다음에 어떤 단어가 와야 하는지 알 뿐입니다. 다시 말해, ChatGPT는 사실인 문장을 쓰려고 하지 않습니다. 그러나 그것은 그럴듯한 문장을 쓰려고 노력합니다.

ChatGPT에 대해 동료들과 개인적으로 이야기할 때, ChatGPT가 생성하는 사실과 다른 진술이 얼마나 많은지 지적하고 무시하는 경우가 많습니다. 나에게 ChatGPT가 결함이 있는 데이터 검색 시스템이라는 생각은 요점을 벗어났습니다. 결국 사람들은 지난 XNUMX년 동안 Google을 사용해 왔습니다. 이미 꽤 좋은 사실 찾기 서비스가 있습니다.

사실 그 모든 대통령 책 제목이 정확한지 확인할 수 있었던 유일한 방법은 인터넷 검색을 한 다음 확인하는 것뿐이었습니다. 결과. 내 인생의 거의 절반 동안 문서를 검색한 다음 내용을 신뢰할 수 있는지 확인하기 위해 비판적 분석을 수행하여 이러한 사실을 얻는 방식 대신 대화를 통해 이러한 사실을 얻는다면 내 인생은 그다지 나아지지 않을 것입니다.

개선 파트너

반면에 내가 말하는 것에 그럴듯한 반응을 주는 봇과 대화할 수 있다면 상황에 유용할 것입니다. 사실적 정확성이 그다지 중요하지 않은 경우. 몇 년 전에 한 학생과 저는 대화를 계속하기 위해 "예"라고 말하는 모든 것에 응답하는 "개선 봇"을 만들려고 했습니다. 우리는 종이, 우리의 포구 당시에는 다른 봇보다 "예, 하고"를 잘했지만 AI에서 XNUMX년은 고대사입니다.

일반적인 즉흥 수업에서 볼 수 있는 것과 다르지 않은 공상 과학 우주 탐험 시나리오인 ChatGPT로 대화를 시도했습니다. ChatGPT는 우리가 했던 것보다 "예, 그리고-ing"을 훨씬 더 잘하지만 드라마를 전혀 고조시키지는 못했습니다. 나는 모든 무거운 짐을 지고 있는 것처럼 느꼈다.

약간의 조정 후 좀 더 참여하게 되었고 하루가 끝날 무렵 20년 이상 전에 대학을 졸업한 이후로 즉흥 연주를 많이 하지 않은 나에게 꽤 좋은 운동이라고 느꼈습니다. .

물론입니다. ChatGPT가 "어쨌든 누구의 라인입니까?” 그리고 이것은 훌륭한 “Star Trek” 플롯이 아닙니다(하지만 “명예 코드”) 그러나 처음부터 무언가를 쓰기 위해 앉았고 앞에있는 빈 페이지에 겁에 질린 적이 몇 번이나 있습니까? 나쁜 첫 번째 초안으로 시작하면 작가의 장애물을 뚫고 창의적인 주스가 흐르게 할 수 있으며 ChatGPT 및 이와 같은 대규모 언어 모델은 이러한 연습을 지원하는 데 적합한 도구인 것 같습니다.

그리고 정보를 제공하지 않고 사용자가 제공하는 단어에 응답하여 가능한 한 좋은 소리를 내는 일련의 단어를 생성하도록 설계된 기계의 경우 도구를 올바르게 사용하는 것 같습니다.

이 기사는에서 다시 게시됩니다. 대화 크리에이티브 커먼즈 라이센스하에 읽기 원래 기사.

- SEO 기반 콘텐츠 및 PR 배포. 오늘 증폭하십시오.

- 플라토 블록체인. Web3 메타버스 인텔리전스. 지식 증폭. 여기에서 액세스하십시오.

- 출처: https://singularityhub.com/2023/02/05/chatgpt-is-great-youre-just-using-it-wrong/

- 1

- 20년

- a

- 능력

- 할 수 있는

- 소개

- 정확한

- 후

- AI

- 도움

- All

- 이미

- 금액

- 분석

- 고대

- 와

- 다른

- 답변

- 표시

- 기사

- 저자

- 작성자

- 출처

- 나쁜

- 기반으로

- 더 나은

- 블록

- 책

- 도서

- 봇

- 봇

- 구입

- 흩어져

- 다발

- 라는

- 포착

- 확실히

- 문자

- 채팅 봇

- ChatGPT

- 청구

- 주장

- 주장

- 수업

- 동료

- 칼리지

- 콜린스

- COM

- 왔다

- 공통의

- 평민

- 불만

- 자신있게

- 내용

- 대화

- 수정

- 코스

- 만들

- 창조적 인

- 신용

- 임계

- Current

- 데이터

- 일

- 일

- 수십 년

- 설계

- 대화

- DID

- 다른

- 디지털

- 알림닫기

- 서류

- 하지 않습니다

- 하기

- 말라

- 아래 (down)

- 징병

- 드라마

- ...동안

- 오류

- 운동

- 탐구

- 탐색기

- 사실

- 뛰어나게

- 를

- 소설

- 들

- 문채 있는

- 최종적으로

- Find

- 먼저,

- 결함이

- 흐르는

- 형식적으로

- 이전

- 양식

- 발견

- 에

- 앞

- 생성

- 얻을

- 점점

- 주기

- 주어진

- 가는

- 좋은

- 좋은 일

- 구글

- 큰

- 초록색

- 반

- 행복한

- 도움

- 헨리

- history

- 방법

- 그러나

- HTML

- HTTPS

- 생각

- 영상

- in

- 포함

- 잘못

- 정보

- 를 받아야 하는 미국 여행자

- 상호 작용

- 인터넷

- 참여

- IT

- 그 자체

- 일

- 유지

- 종류

- 알려진

- 언어

- 넓은

- 도서관

- 특허

- 생활

- 리프팅

- 아마도

- 링컨

- 라인

- 명부

- 작은

- 찾고

- 기계

- 확인

- 메이커

- .

- 최대 폭

- 잘못

- 모델

- 모델

- 수정

- 배우기

- 가장

- 이름

- 거의

- 다음 것

- 번호

- 숫자

- ONE

- OpenAI

- 기타

- 과거

- 폴

- 사람들

- 플라톤

- 플라톤 데이터 인텔리전스

- 플라토데이터

- 그럴듯한

- 포인트 적립

- 가능한

- 대통령

- 대통령

- 대통령

- 예쁜

- 확률

- 생산

- 제공

- 제공

- 출판

- 놓다

- 문의

- 읽기

- 합리적인

- 반복

- 신고

- 응답

- 응답

- REST

- 결과

- 공개

- 공개

- ROBERT

- 달리기

- 말했다

- 같은

- 장면

- 과학

- 공상 과학 소설

- 화면

- 것

- 서비스

- 영상을

- 이후

- 상황

- 약간 다른

- So

- 일부

- 무언가

- 그것의

- 소리

- 출처

- 스페이스 버튼

- 우주 탐사

- 서다

- 스타트

- 시작 중

- 문

- 아직도

- 중지

- 이야기

- 학생

- 체계

- 받아

- 소요

- 이야기

- 말하는

- XNUMXD덴탈의

- 그들의

- 일

- 세

- 을 통하여

- 시간

- 시대

- 제목들

- 에

- 함께

- 수단

- 검색을

- 훈련 된

- 트레이닝

- 참된

- 믿어

- 전형적인

- 아래에

- us

- 사용

- 확인

- 확인하는

- 뭐

- 여부

- 어느

- 누구

- 의지

- 워드

- 말

- 겠지

- 쓰다

- 작가

- 쓴

- 잘못된

- 년

- 당신 자신

- 유튜브

- 제퍼 넷