DALL-E3で作成したイメージ

人工知能はテクノロジーの世界における完全な革命です。

人間の知能を模倣し、かつては人間の領域のみと考えられていたタスクを実行するその能力は、今でも私たちのほとんどを驚かせています。

ただし、最近の AI の進歩がどれほど優れていたとしても、改善の余地は常にあります。

そして、まさにここで、迅速なエンジニアリングが機能します。

AI モデルの生産性を大幅に向上できるこの分野に参入してください。

一緒に発見しましょう!

プロンプト エンジニアリングは、言語モデルの効率と有効性の向上に焦点を当てた、AI 内で急速に成長している分野です。 重要なのは、AI モデルが望ましい出力を生成するように導くための完璧なプロンプトを作成することです。

これは、誰かがタスクを正しく理解して実行できるように、より適切な指示を与える方法を学ぶことだと考えてください。

迅速なエンジニアリングが重要な理由

- 生産性の向上: 高品質のプロンプトを使用することで、AI モデルはより正確で関連性の高い応答を生成できます。 これは、修正に費やす時間が減り、AI の機能を活用する時間が増えることを意味します。

- コスト効率: AI モデルのトレーニングにはリソースが大量に消費されます。 プロンプト エンジニアリングにより、より適切なプロンプトを通じてモデルのパフォーマンスを最適化し、再トレーニングの必要性を減らすことができます。

- 汎用性: 適切に作成されたプロンプトにより、AI モデルの汎用性が高まり、より幅広いタスクや課題に取り組むことができるようになります。

最も高度なテクニックに入る前に、最も役立つ (そして基本的な) プロンプト エンジニアリング テクニックを XNUMX つ思い出してください。

「ステップバイステップで考えよう」のシーケンシャルシンキング

今日では、「ステップごとに考えてみましょう」という単語シーケンスを追加すると、LLM モデルの精度が大幅に向上することがよく知られています。

なぜ…と疑問に思うかもしれません。

これは、モデルにタスクを複数のステップに分割するよう強制しており、モデルが各ステップを処理するのに十分な時間を確保しているためです。

たとえば、次のプロンプトを使用して GPT3.5 に挑戦できます。

ジョンが 5 個の梨を持っていて、2 個食べて、さらに 5 個買って、3 個を友達にあげた場合、彼は梨を何個持っていますか?

モデルさんならすぐに答えてくれますよ。 ただし、最後の「ステップごとに考えてみましょう」を追加すると、モデルに複数のステップで思考プロセスを生成させることになります。

数発のプロンプト

ゼロショット プロンプトは、コンテキストや事前の知識を提供せずにモデルにタスクの実行を要求することを指しますが、少数ショット プロンプト手法は、特定の質問とともに目的の出力のいくつかの例を LLM に提示することを意味します。

たとえば、詩的なトーンを使用して用語を定義するモデルを考え出したい場合、それを説明するのは非常に難しいかもしれません。 右?

ただし、次の数回のプロンプトを使用して、モデルを希望の方向に導くことができます。

あなたの課題は、次のスタイルに沿った一貫したスタイルで回答することです。

:レジリエンスについて教えてください。

: 復元力は、風で曲がりますが決して折れない木のようなものです。

逆境から立ち直り、前に進み続ける力です。

: ここに入力してください。

まだ試したことがない場合は、GPT に挑戦してください。

ただし、これらの基本的なテクニックはほとんどの方がすでにご存知だと思いますので、いくつかの高度なテクニックに挑戦してみます。

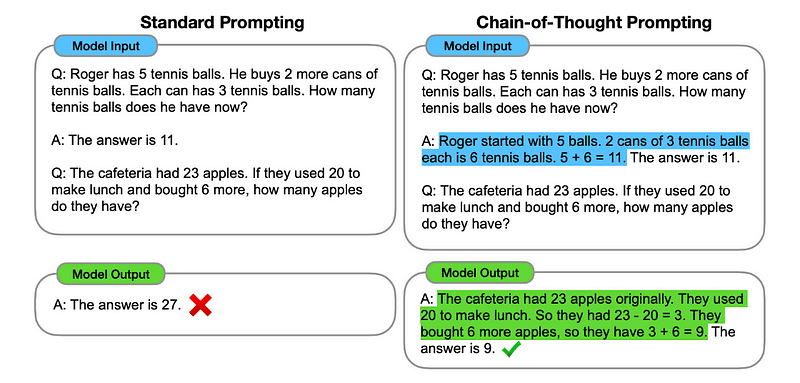

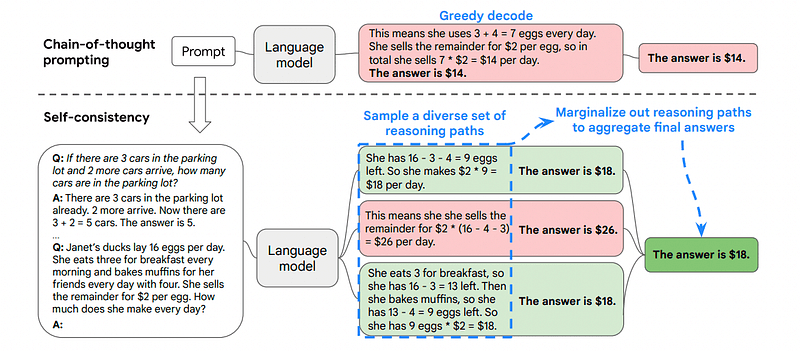

1. 思考連鎖 (CoT) プロンプト

導入者 2022年のGoogle、この方法には、最終的な応答を提供する前にいくつかの推論段階を経るようモデルに指示することが含まれます。

おなじみですね? もしそうなら、あなたは完全に正しいです。

これは、Sequential Thinking と Few-Shot Prompting の両方を統合したようなものです。

方法は?

基本的に、CoT プロンプトは、LLM に情報を順番に処理するように指示します。 これは、複数のステップの推論で最初の問題を解決する方法を例示し、実際のタスクをモデルに送信し、解決したい実際のクエリに応答するときに同等の思考連鎖をエミュレートすることを期待することを意味します。

からの画像 紙.

したがって、最初の例に従って、最初の問題を示すプロンプトと、それを解決する方法の連続した説明を提供できます。 次に、入力を送信して、魔法がどのように起こるかを確認します。

ジョンが 5 個の梨を持っていて、2 個食べて、さらに 5 個買って、3 個を友達にあげた場合、彼は梨を何個持っていますか? 段階的に考えてみましょう。

一歩ずつ進んでいきましょう。 ジョンは 5 つの梨から始めます。 彼は梨を 2 個食べたので、5-2 = 3 個の梨が残りました。 それから、彼はさらに梨を5個買います。 つまり、彼は 3 + 5 = 8 個の梨を持っています。 最後に、彼は梨を 3 個友人にプレゼントします。 したがって、8-3 = 5 個の梨が残っています。 これらすべての手順を経て、ジョンは 5 つの梨を手に入れました。

ここにあなたの意見を入力してください。

しかし、ほとんどの人は次のように考えているはずです…ChatGPT で何か質問したいときはいつでも、問題を解決するための順番に方法を考えなければなりませんか?

まあ…あなたが最初の人ではありません! そしてこれは私たちを導きます…

2. 自動思考連鎖 (Auto-CoT)

2022年には、 チャン と同僚は、この手動プロセスを回避する方法を導入しました。 手動タスクを避ける主な理由は XNUMX つあります。

- 退屈かもしれません。

- たとえば、私たちの精神プロセスが間違っている場合など、悪い結果が生じる可能性があります。

彼らは、LLM を「ステップごとに考えてみましょう」プロンプトと組み合わせて使用し、デモンストレーションごとに推論チェーンを順番に生成することを提案しました。

これは、ChatGPT に問題を解決する方法を順番に尋ね、次にこの同じ例を使用して他の問題を解決する方法を訓練することを意味します。

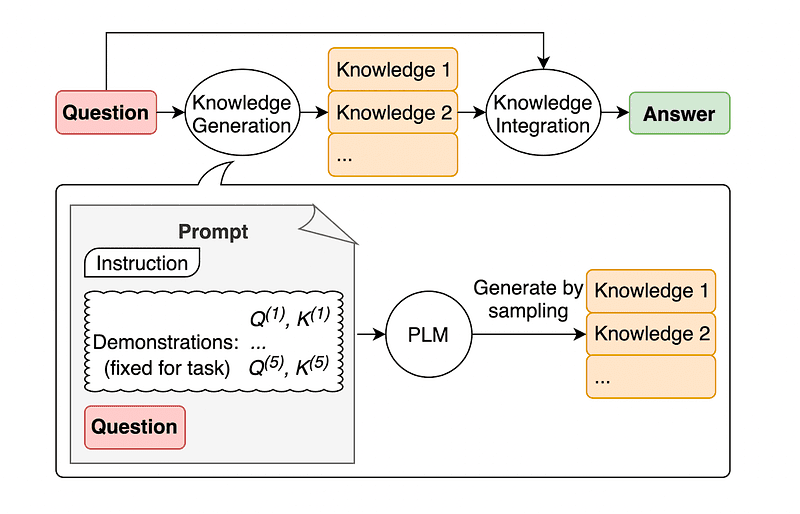

3. 自己一貫性

自己一貫性は、より複雑な推論問題を促す思考の連鎖を改善することを目的とした、もう XNUMX つの興味深いプロンプト テクニックです。

それで…主な違いは何でしょうか?

自己一貫性の主な考え方は、間違った例を使用してモデルをトレーニングできることを認識することです。 私が間違った思考プロセスで前の問題を解決したと想像してみてください。

ジョンが 5 個の梨を持っていて、2 個食べて、さらに 5 個買って、3 個を友達にあげた場合、彼は梨を何個持っていますか? 段階的に考えてみましょう。

梨5個から始めます。 ジョンは梨を 2 個食べます。 それから彼は梨を3個友達にあげます。 これらのアクションは組み合わせることができます: 2 (食べる) + 3 (与える) = 合計 5 個の梨が影響を受けます。 ここで、最初の 5 つの梨から影響を受ける梨の合計を引きます。5 (初期) – 5 (影響を受ける) = 0 梨が残ります。

そうなると、モデルに送信する他のタスクは間違ってしまいます。

このため、自己一貫性では、それぞれの推論パスに一連の思考が含まれているさまざまな推論パスからサンプリングし、問題を解決するための最適かつ最も一貫したパスを LLM に選択させる必要があります。

からの画像 紙

この場合、再び最初の例に従って、問題を解決するさまざまな方法をモデルに示すことができます。

ジョンが 5 個の梨を持っていて、2 個食べて、さらに 5 個買って、3 個を友達にあげた場合、彼は梨を何個持っていますか?

梨5個から始めます。 ジョンは梨を 2 個食べると、5-2 = 3 個の梨が残ります。 彼はさらに 5 個の梨を購入し、合計 3 + 5 = 8 個の梨になります。 最後に、彼は梨 3 個を友達にあげたので、8-3 = 5 個の梨が残りました。

ジョンが 5 個の梨を持っていて、2 個食べて、さらに 5 個買って、3 個を友達にあげた場合、彼は梨を何個持っていますか?

梨5個から始めます。 それから彼は梨をさらに 5 個購入します。 ジョンは今梨を 2 個食べています。 これらのアクションは組み合わせることができます: 2 (食べる) + 5 (買う) = 合計 7 個の梨。 梨の合計量からジョンが食べた梨を引きます。 7(合計量) – 2(食べた) = 5 個の梨が残ります。

ここにあなたの意見を入力してください。

そして最後のテクニックが登場します。

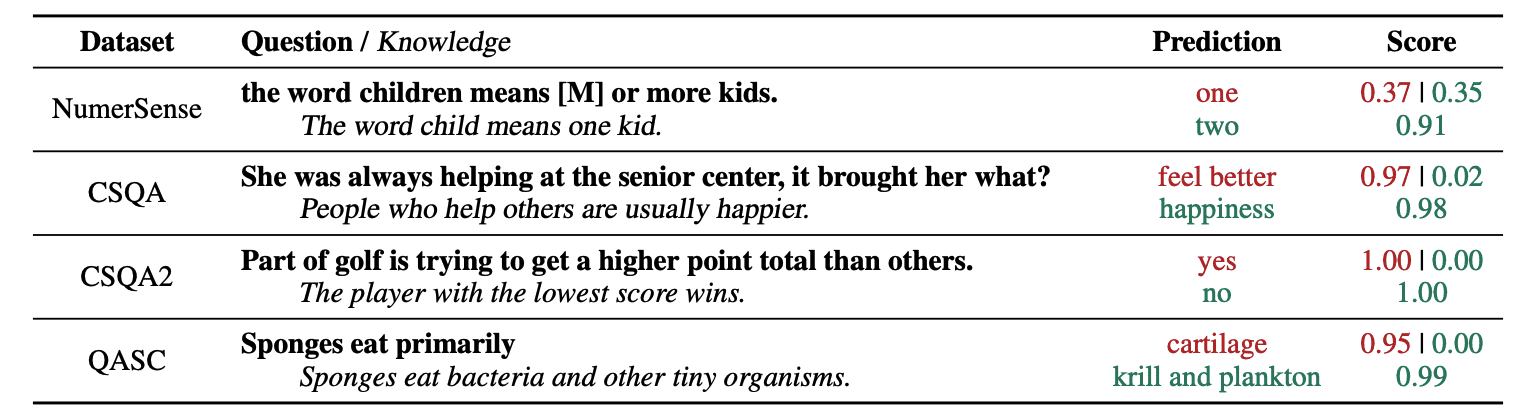

4. 一般知識のプロンプト

プロンプト エンジニアリングの一般的な方法は、最終的な API 呼び出しを GPT-3 または GPT-4 に送信する前に、追加の知識でクエリを強化することです。

による Jiacheng Liu と Co.、LLM が質問についてよりよく理解できるように、いつでもリクエストに何らかの知識を追加できます。

からの画像 紙.

したがって、たとえば、ゴルフの一部が他の部分よりも高い合計ポイントを獲得しようとしているかどうかを ChatGPT に尋ねると、それが検証されます。 しかし、ゴルフの主な目的は全く逆です。 このため、「スコアの低いプレイヤーが勝ち」という事前知識を追加することができます。

では、モデルに正確に答えを伝えているとしたら、何が面白いのでしょうか?

この場合、この手法は、LLM との対話方法を改善するために使用されます。

そのため、論文の著者らは、外部データベースから補足的なコンテキストを取得するのではなく、LLM に独自の知識を生成させることを推奨しています。 この自己生成の知識はプロンプトに統合され、常識的な推論を強化し、より良い出力を提供します。

これが、トレーニング データセットを増やさずに LLM を改善できる方法です。

プロンプト エンジニアリングは、LLM の機能を強化するための極めて重要な技術として浮上しています。 プロンプトを反復して改善することで、より直接的な方法で AI モデルに通信できるため、より正確でコンテキストに関連した出力を取得でき、時間とリソースの両方を節約できます。

テクノロジー愛好家、データ サイエンティスト、コンテンツ クリエーターにとって、プロンプト エンジニアリングを理解し習得することは、AI の可能性を最大限に活用する上で貴重な資産となります。

慎重に設計された入力プロンプトとこれらのより高度なテクニックを組み合わせることで、プロンプト エンジニアリングのスキルセットを身につけることで、今後数年間で間違いなく優位性を得ることができるでしょう。

ジョセップ・フェレール バルセロナ出身の分析エンジニアです。 彼は物理工学を卒業し、現在は人間の移動に適用されるデータ サイエンス分野で働いています。 彼は、データ サイエンスとテクノロジーに焦点を当てた非常勤のコンテンツ クリエイターです。 あなたは彼に連絡することができます LinkedIn, Twitter or M.

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.kdnuggets.com/some-kick-ass-prompt-engineering-techniques-to-boost-our-llm-models?utm_source=rss&utm_medium=rss&utm_campaign=some-kick-ass-prompt-engineering-techniques-to-boost-our-llm-models

- :持っている

- :は

- :not

- :どこ

- $UP

- 10

- 11

- 2022

- 29

- 7

- 8

- a

- 能力

- 私たちについて

- 精度

- 正確な

- 行動

- 実際の

- 加えます

- 追加

- NEW

- 高度な

- 後

- 再び

- AI

- AIモデル

- 目指して

- 整列した

- 同様に

- すべて

- 許可

- 沿って

- 既に

- 常に

- am

- 量

- an

- 分析論

- および

- 別の

- 回答

- どれか

- API

- 適用された

- です

- AS

- 頼む

- 質問

- 資産

- 著者

- オートマチック

- 避ける

- 知って

- 離れて

- バック

- 悪い

- バルセロナ

- 基本

- BE

- なぜなら

- き

- さ

- BEST

- より良いです

- ボルスター

- ブースト

- 退屈な

- 両言語で

- 買った

- バウンス

- ブレーク

- 休憩

- もたらす

- より広い

- 焙煎が極度に未発達や過発達のコーヒーにて、クロロゲン酸の味わいへの影響は強くなり、金属を思わせる味わいと乾いたマウスフィールを感じさせます。

- 買う

- by

- コール

- 缶

- 機能

- 慎重に

- 場合

- チェーン

- チェーン

- 挑戦する

- 課題

- AI言語モデルを活用してコードのデバッグからデータの異常検出まで、

- 選択する

- 同僚

- 組み合わせた

- 結合

- 来ます

- comes

- 到来

- コマンドと

- 伝える

- 匹敵します

- コンプリート

- 複雑な

- 見なさ

- 整合性のある

- 接触

- コンテンツ

- コンテンツ制作者

- コンテキスト

- 補正

- 可能性

- 作成した

- クリエイター

- クリエイター

- 現在

- データ

- データサイエンス

- データベース

- 定義する

- 配信する

- 設計

- 希望

- 違い

- 異なります

- 直接

- 方向

- 発見する

- ダイビング

- do

- ありません

- ドメイン

- ドメイン

- ダウン

- 各

- エッジ(Edge)

- 有効

- 効率

- 登場

- エンジニア

- エンジニアリング

- 高めます

- 強化

- 十分な

- 確保

- 愛好家

- 正確に

- 例

- 例

- 実行します

- 期待して

- 説明する

- 説明

- おなじみの

- 少数の

- フィールド

- ファイナル

- 最後に

- 名

- 焦点を当て

- 焦点を当てて

- フォロー中

- 強制

- フォワード

- 友人

- から

- フル

- おかしいです

- 生成する

- 取得する

- 与える

- 与えられた

- 与える

- Go

- 目標

- ゴルフ

- 良い

- ガイド

- ハード

- 利用する

- 持ってる

- 持って

- he

- こちら

- 高品質

- より高い

- 彼に

- 彼の

- 認定条件

- How To

- しかしながら

- HTTPS

- 人間

- 人間の知性

- i

- アイデア

- if

- 絵

- 改善します

- 改善されました

- 改善

- 改善

- in

- の増加

- 情報

- 初期

- 説明書

- 統合された

- インテリジェンス

- 相互作用する

- 興味深い

- に

- 導入

- 関与

- IT

- ITS

- John Redfern

- ジョン

- ただ

- KDナゲット

- キープ

- キック

- キック

- 知っている

- 知識

- 知っている

- 言語

- 姓

- 遅く

- リード

- 跳躍

- 学習

- 残す

- 左

- less

- う

- させる

- 活用

- ような

- 下側

- マジック

- メイン

- make

- 作成

- 方法

- マニュアル

- 多くの

- マスタリング

- 問題

- me

- 手段

- メンタル

- マージ

- 方法

- かもしれない

- モビリティ

- モデル

- 他には?

- 最も

- 移動する

- の試合に

- しなければなりません

- 必要

- 決して

- いいえ

- 今

- 入手する

- of

- on

- かつて

- 反対

- 最適化

- or

- その他

- その他

- 私たちの

- でる

- 出力

- outputs

- 外側

- 自分の

- 紙素材

- 部

- path

- 完璧

- 実行する

- パフォーマンス

- 物理学

- 極めて重要な

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- プレイヤー

- ポイント

- 潜在的な

- 練習

- 正確に

- 現在

- かなり

- 前

- 問題

- 問題

- プロセス

- 作り出す

- 生産性

- 提供します

- 提供

- 引き

- 質問

- 非常に

- 範囲

- むしろ

- リアル

- 理由は

- 推奨する

- 減らします

- 指し

- 関連した

- 要求

- 回復力

- リソースを大量に消費する

- リソース

- 応答

- 応答

- 回答

- 結果

- 再訓練

- 革命

- 右

- ルーム

- s

- 同じ

- 節約

- 科学

- 科学技術

- 科学者たち

- スコア

- 送信

- 送信

- シーケンス

- セッションに

- いくつかの

- 表示する

- 著しく

- 技能

- So

- もっぱら

- 解決する

- 解決

- 一部

- 誰か

- 何か

- 特定の

- 費やした

- ステージ

- start

- 開始

- 舵を取る

- 手順

- ステップ

- まだ

- 確か

- タックル

- 撮影

- 仕事

- タスク

- テク

- 技術

- テクニック

- テクノロジー

- 占い

- 期間

- より

- それ

- それら

- その後

- そこ。

- したがって、

- ボーマン

- 彼ら

- 考える

- 考え

- この

- 考え

- 介して

- 従って

- 時間

- 〜へ

- TONE

- トータル

- 完全に

- トレーニング

- トレーニング

- ツリー

- 試み

- 試します

- しよう

- 2

- 究極の

- 下

- 受ける

- わかる

- 理解する

- 間違いなく

- us

- つかいます

- 中古

- 検証

- 貴重な

- さまざまな

- 多才な

- 非常に

- 欲しいです

- 仕方..

- 方法

- we

- 周知

- した

- いつ

- which

- なぜ

- 意志

- 風

- 以内

- 無し

- Word

- ワーキング

- 世界

- 間違った

- 年

- まだ

- 産出

- 貴社

- あなたの

- ゼファーネット