ニューラル検索機能の開始により、 AmazonOpenSearchサービス OpenSearch 2.9 では、AI/ML モデルと簡単に統合して、セマンティック検索やその他のユースケースを強化できるようになりました。 OpenSearch Service は、2020 年の k 最近傍 (k-NN) 機能の導入以来、字句検索とベクトル検索の両方をサポートしてきました。ただし、セマンティック検索を構成するには、取り込みと検索のために機械学習 (ML) モデルを統合するフレームワークを構築する必要がありました。ニューラル検索機能により、取り込みおよび検索中のテキストからベクターへの変換が容易になります。検索中にニューラル クエリを使用すると、クエリはベクトル埋め込みに変換され、k-NN を使用してコーパスから最も近いベクトル埋め込みが返されます。

ニューラル検索を使用するには、ML モデルを設定する必要があります。 AI/ML コネクタを AWS AI および ML サービス (たとえば、 アマゾンセージメーカー or アマゾンの岩盤)またはサードパーティの代替品。 OpenSearch Service のバージョン 2.9 以降、AI/ML コネクタはニューラル検索と統合され、データ コーパスとクエリのベクトル埋め込みへの変換を簡素化して運用できるようになり、ベクトルのハイドレーションと検索の複雑さの多くが解消されます。

この投稿では、OpenSearch Service コンソールを介して外部モデルへの AI/ML コネクタを構成する方法を示します。

ソリューションの概要

具体的には、この投稿では、SageMaker でモデルに接続する手順を説明します。次に、ML モデルへの接続を通じてサポートされるユースケースの例として、コネクタを使用して OpenSearch サービスでセマンティック検索を構成する方法を説明します。 Amazon Bedrock と SageMaker の統合は現在、OpenSearch Service コンソール UI でサポートされており、UI でサポートされるファーストパーティおよびサードパーティの統合のリストは今後も拡大していく予定です。

UI を通じてサポートされていないモデルについては、代わりに利用可能な API と ML ブループリント。 詳細については、を参照してください。 OpenSearch モデルの概要。各コネクタのブループリントは、 ML Commons GitHub リポジトリ.

前提条件

OpenSearch Service コンソール経由でモデルを接続する前に、OpenSearch Service ドメインを作成します。マップを作成する AWS IDおよびアクセス管理 (IAM) 名前によるロール LambdaInvokeOpenSearchMLCommonsRole のバックエンドの役割として ml_full_access 次のビデオで示すように、OpenSearch ダッシュボードのセキュリティ プラグインを使用してロールを設定します。 OpenSearch サービス統合ワークフローには、 LambdaInvokeOpenSearchMLCommonsRole デフォルトでは、OpenSearch Service ドメインと SageMaker にデプロイされたモデルの間のコネクタを作成する IAM ロール。 OpenSearch Service コンソール統合でカスタム IAM ロールを使用する場合は、カスタム ロールがバックエンド ロールとしてマップされていることを確認してください。 ml_full_access テンプレートをデプロイする前に権限を付与します。

AWS CloudFormation を使用してモデルをデプロイする

次のビデオは、OpenSearch Service コンソールを使用して Amazon SageMaker に数分以内にモデルをデプロイし、AI コネクタ経由でモデル ID を生成する手順を示しています。最初のステップは選択することです インテグレーション OpenSearch Service AWS コンソールのナビゲーション ペインで、利用可能な統合のリストにルーティングされます。統合は UI を通じて設定され、必要な入力を求めるプロンプトが表示されます。

統合を設定するには、OpenSearch Service ドメイン エンドポイントを指定し、モデル接続を一意に識別するためのモデル名を指定するだけです。デフォルトでは、テンプレートは Hugging Face 文変換モデルをデプロイします。 djl://ai.djl.huggingface.pytorch/sentence-transformers/all-MiniLM-L6-v2.

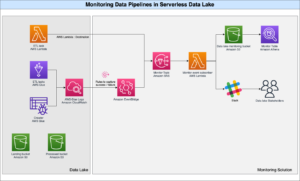

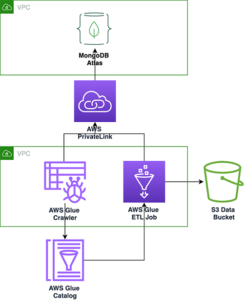

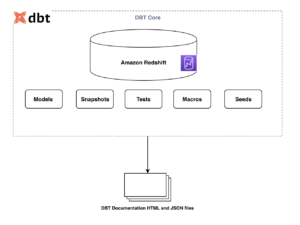

選ぶとき スタックを作成にルーティングされます。 AWS CloudFormation コンソール。 CloudFormation テンプレートは、次の図で詳しく説明されているアーキテクチャをデプロイします。

CloudFormation スタックは AWSラムダ モデルをデプロイするアプリケーション Amazon シンプル ストレージ サービス (Amazon S3)、コネクタを作成し、出力にモデル ID を生成します。その後、このモデル ID を使用してセマンティック インデックスを作成できます。

デフォルトの all-MiniLM-L6-v2 モデルが目的を満たさない場合は、モデルアーティファクトをアクセス可能な S3 オブジェクトとして提供することで、選択した任意のテキスト埋め込みモデルを、選択したモデルホスト (SageMaker または Amazon Bedrock) にデプロイできます。あるいは、次のいずれかを選択できます。 事前トレーニングされた言語モデル それを SageMaker にデプロイします。エンドポイントとモデルを設定する手順については、以下を参照してください。 利用可能な Amazon SageMaker イメージ.

SageMaker は、あらゆるユースケースで高性能かつ低コストの ML を実現する幅広いツールセットをまとめたフルマネージド サービスで、モデルのモニタリング、サーバーレス ホスティング、継続的なトレーニングとデプロイメントのためのワークフローの自動化などの主要な利点を提供します。 SageMaker を使用すると、テキスト埋め込みモデルのライフサイクルをホストおよび管理し、それらを使用して OpenSearch Service のセマンティック検索クエリを強化できます。接続すると、SageMaker はモデルをホストし、OpenSearch Service を使用して SageMaker からの推論結果に基づいてクエリを実行します。

OpenSearch ダッシュボードを通じてデプロイされたモデルを表示する

CloudFormation テンプレートが OpenSearch Service ドメインにモデルを正常にデプロイしたことを確認し、モデル ID を取得するには、OpenSearch Dashboards Dev Tools を通じて ML Commons REST GET API を使用できます。

GET _plugins REST API は、モデルのステータスも表示する追加の API を提供するようになりました。次のコマンドを使用すると、リモート モデルのステータスを確認できます。

次のスクリーンショットに示すように、 DEPLOYED 応答内のステータスは、モデルが OpenSearch Service クラスターに正常にデプロイされたことを示します。

あるいは、OpenSearch Service ドメインにデプロイされたモデルを表示するには、 機械学習 OpenSearch ダッシュボードのページ。

このページには、モデル情報と、展開されているすべてのモデルのステータスがリストされます。

モデル ID を使用してニューラル パイプラインを作成する

モデルのステータスが次のいずれかを示している場合 DEPLOYED 開発ツールまたはグリーンで、 応答する OpenSearch ダッシュボードでは、モデル ID を使用してニューラル インジェスト パイプラインを構築できます。次の取り込みパイプラインは、ドメインの OpenSearch ダッシュボード開発ツールで実行されます。モデル ID を、ドメインにデプロイされたモデルに対して生成された一意の ID に置き換えてください。

ニューラル パイプラインをデフォルトのパイプラインとして使用してセマンティック検索インデックスを作成する

これで、前のステップで作成した新しいニューラル パイプラインを使用するように構成されたデフォルトのパイプラインを使用してインデックス マッピングを定義できるようになりました。ベクトル フィールドが次のように宣言されていることを確認します。 knn_vector 寸法は SageMaker にデプロイされるモデルに適切です。 SageMaker に all-MiniLM-L6-v2 モデルをデプロイするためのデフォルト設定を保持している場合は、次の設定をそのままにして、Dev Tools でコマンドを実行します。

サンプルドキュメントを取り込んでベクトルを生成する

このデモでは、 小売デモストア製品カタログのサンプル 新しい semantic_demostore 索引。ユーザー名、パスワード、およびドメイン エンドポイントをドメイン情報に置き換え、生データを OpenSearch Service に取り込みます。

新しい semantic_demostore インデックスを検証する

データセットを OpenSearch サービス ドメインに取り込んだので、すべてのフィールドをフェッチする単純な検索を使用して、必要なベクトルが生成されているかどうかを検証します。フィールドが次のように定義されているかどうかを検証します。 knn_vectors 必要なベクトルを持っています。

検索結果の比較ツールを使用して、ニューラル検索を活用した字句検索と意味検索を比較します。

検索結果比較ツール OpenSearch ダッシュボードでは、実稼働ワークロードで使用できます。に移動できます。 検索結果を比較する ページにアクセスし、以前に生成されたモデル ID を使用するように構成された字句検索とニューラル検索の間でクエリ結果を比較します。

クリーンアップ

この投稿の手順に従って CloudFormation スタックを削除することで、作成したリソースを削除できます。これにより、SageMaker にデプロイされたモデルを含む Lambda リソースと S3 バケットが削除されます。次の手順を実行します。

- AWS CloudFormation コンソールで、スタックの詳細ページに移動します。

- 選択する 削除.

- 選択する 削除 確認します。

スタック削除の進行状況は、AWS CloudFormation コンソールで監視できます。

CloudFormation スタックを削除しても、SageMaker ドメインにデプロイされたモデルと作成された AI/ML コネクタは削除されないことに注意してください。これは、これらのモデルとコネクタをドメイン内の複数のインデックスに関連付けることができるためです。モデルとその関連コネクタを具体的に削除するには、次のスクリーンショットに示すようにモデル API を使用します。

まず、 undeploy OpenSearch Service ドメイン メモリからのモデル:

その後、モデル インデックスからモデルを削除できます。

最後に、コネクタ インデックスからコネクタを削除します。

まとめ

この投稿では、SageMaker でモデルをデプロイし、OpenSearch Service コンソールを使用して AI/ML コネクタを作成し、ニューラル検索インデックスを構築する方法を学びました。 OpenSearch Service で AI/ML コネクタを構成できる機能により、外部モデルへの統合がネイティブになるため、ベクター ハイドレーション プロセスが簡素化されます。ニューラル インジェスト パイプラインとニューラル検索を使用すると、ニューラル検索インデックスを数分で作成できます。ニューラル検索では、モデル ID を使用して、取り込みと検索中にオンザフライでベクトル埋め込みを生成します。

これらの AI/ML コネクタの詳細については、以下を参照してください。 Amazon OpenSearch Service AWS サービス用 AI コネクタ, セマンティック検索のための AWS CloudFormation テンプレートの統合, サードパーティの ML プラットフォーム用のコネクタの作成.

著者について

アルナ・ゴビンダラジュ Amazon OpenSearch スペシャリスト ソリューション アーキテクトであり、多くの商用およびオープンソースの検索エンジンと協力してきました。彼女は検索、関連性、ユーザー エクスペリエンスに情熱を注いでいます。エンドユーザーのシグナルと検索エンジンの動作を関連付けることに関する彼女の専門知識は、多くの顧客の検索エクスペリエンスを向上させるのに役立ちました。

アルナ・ゴビンダラジュ Amazon OpenSearch スペシャリスト ソリューション アーキテクトであり、多くの商用およびオープンソースの検索エンジンと協力してきました。彼女は検索、関連性、ユーザー エクスペリエンスに情熱を注いでいます。エンドユーザーのシグナルと検索エンジンの動作を関連付けることに関する彼女の専門知識は、多くの顧客の検索エクスペリエンスを向上させるのに役立ちました。

ダグニー・ブラウン AWS のプリンシパルプロダクトマネージャーで、OpenSearch に重点を置いています。

ダグニー・ブラウン AWS のプリンシパルプロダクトマネージャーで、OpenSearch に重点を置いています。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://aws.amazon.com/blogs/big-data/power-neural-search-with-ai-ml-connectors-in-amazon-opensearch-service/

- :持っている

- :は

- :not

- $UP

- 1

- 100

- 12

- 視聴者の38%が

- 2020

- 25

- 7

- 8

- 9

- a

- 能力

- 私たちについて

- アクセス

- アクセス可能な

- NEW

- AI

- AI / ML

- すべて

- ことができます

- また

- 選択肢

- Amazon

- アマゾンセージメーカー

- Amazon Webサービス

- an

- および

- どれか

- API

- API

- 申し込み

- 適切な

- 建築

- です

- AS

- 関連する

- At

- オートメーション

- 利用できます

- AWS

- AWS CloudFormation

- バックエンド

- ベース

- BE

- なぜなら

- 行動

- 利点

- の間に

- 両言語で

- もたらす

- 広い

- ビルド

- 建物

- by

- 缶

- 場合

- 例

- カタログ

- 選択

- 選択する

- 選ばれた

- クラスタ

- コマーシャル

- コモンズ

- 比較します

- コンプリート

- 複雑さ

- 設定された

- 構成する

- 確認します

- 交流

- 接続する

- 接続

- 領事

- 含む

- 続ける

- 連続的な

- 相関する

- 作ります

- 作成した

- 作成します。

- 現在

- カスタム

- Customers

- ダッシュボード

- データ

- デフォルト

- 定義します

- 定義済みの

- 配信する

- デモ

- 実証します

- 実証

- 展開します

- 展開

- 展開する

- 展開

- 配備する

- 説明

- 詳細な

- 細部

- デベロッパー

- 次元

- 大きさ

- ドキュメント

- そうではありません

- ドメイン

- 間に

- 各

- 前

- 楽な

- どちら

- 埋め込み

- enable

- エンドポイント

- エンジン

- エンジン

- 確保

- エーテル(ETH)

- 例

- 体験

- 専門知識

- 外部

- 顔

- 促進する

- 特徴

- フィールズ

- もう完成させ、ワークスペースに掲示しましたか?

- 名

- 焦点を当て

- フォロー中

- フレームワーク

- から

- 完全に

- 生成する

- 生成された

- 生成

- 取得する

- GIF

- GitHubの

- グリーン

- 成長する

- ガイド

- 持ってる

- 助けました

- 彼女の

- ハイパフォーマンス

- host

- ホスティング

- ホスト

- 認定条件

- How To

- しかしながら

- HTML

- HTTP

- HTTPS

- 抱き合う顔

- 水分補給

- IAM

- ID

- 識別する

- アイデンティティ

- if

- 改善します

- in

- index

- インデックス

- を示し

- 情報

- 入力

- を取得する必要がある者

- 説明書

- 統合する

- 統合

- 統合

- に

- 概要

- IT

- ITS

- JPG

- JSON

- キープ

- キー

- 言語

- 起動する

- LEARN

- 学んだ

- 学習

- wifecycwe

- リスト

- リスト

- 低コストの

- 機械

- 機械学習

- make

- 作成

- 管理します

- マネージド

- マネージャー

- 多くの

- 地図

- マッピング

- メモリ

- 方法

- 分

- ML

- モデル

- モニター

- モニタリング

- 他には?

- ずっと

- の試合に

- しなければなりません

- 名

- ネイティブ

- ナビゲート

- ナビゲーション

- 必要

- 必要

- ニューラル

- 新作

- 今

- オブジェクト

- of

- on

- ONE

- の

- 開いた

- オープンソース

- or

- その他

- 出力

- ページ

- ペイン

- 情熱的な

- パスワード

- パーミッション

- パイプライン

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- プラグイン

- ポスト

- 電力

- パワード

- 前

- 校長

- 事前の

- プロセス

- プロセッサ

- プロダクト

- プロダクトマネージャー

- 生産

- 進捗

- プロパティ

- 提供します

- は、大阪で

- 提供

- 目的

- クエリ

- Raw

- 生データ

- 推奨する

- 参照する

- リモート

- 除去

- replace

- の提出が必要です

- リソース

- 応答

- REST

- 結果

- 小売

- 保持された

- return

- 職種

- ルート

- ラン

- セージメーカー

- スクリーンショット

- を検索

- 検索エンジン

- 検索エンジン

- セキュリティ

- select

- 役立つ

- サーバレス

- サービス

- サービス

- セッションに

- 設定

- 彼女

- 示す

- 作品

- 信号

- 簡単な拡張で

- 簡素化する

- 簡素化する

- から

- ソリューション

- ソース

- 専門家

- 特に

- スタック

- 起動

- Status:

- 手順

- ステップ

- ストレージ利用料

- 首尾よく

- そのような

- サポート

- 確か

- template

- 클라우드 기반 AI/ML및 고성능 컴퓨팅을 통한 디지털 트윈의 기초 – Edward Hsu, Rescale CPO 많은 엔지니어링 중심 기업에게 클라우드는 R&D디지털 전환의 첫 단계일 뿐입니다. 클라우드 자원을 활용해 엔지니어링 팀의 제약을 해결하는 단계를 넘어, 시뮬레이션 운영을 통합하고 최적화하며, 궁극적으로는 모델 기반의 협업과 의사 결정을 지원하여 신제품을 결정할 때 데이터 기반 엔지니어링을 적용하고자 합니다. Rescale은 이러한 혁신을 돕기 위해 컴퓨팅 추천 엔진, 통합 데이터 패브릭, 메타데이터 관리 등을 개발하고 있습니다. 이번 자리를 빌려 비즈니스 경쟁력 제고를 위한 디지털 트윈 및 디지털 스레드 전략 개발 방법에 대한 인사이트를 나누고자 합니다.

- それ

- アプリ環境に合わせて

- それら

- その後

- それによって

- ボーマン

- サードパーティ

- この

- 介して

- 〜へ

- 一緒に

- 豊富なツール群

- トレーニング

- 変換

- インタビュー

- true

- type

- ui

- ユニーク

- 独特に

- つかいます

- 使用事例

- 中古

- ユーザー

- 操作方法

- 検証

- 確認する

- バージョン

- 、

- ビデオ

- 詳しく見る

- walks

- ました

- we

- ウェブ

- Webサービス

- いつ

- which

- 意志

- 以内

- 働いていました

- ワークフロー

- ワークフローの自動化

- 貴社

- あなたの

- ゼファーネット