人工知能 (AI) の世界は急速に進化しており、計り知れない可能性と倫理的課題の両方が最前線にさらされています。 これに関連して、知性は悪用されると、まったく持たない場合よりも深刻になる可能性があることを覚えておくことが重要です。 AI テクノロジーが拡大し、さまざまな分野での影響力が高まるにつれ、潜在的な害を軽減しながらその利点を活用するには、責任あるガバナンスが最も重要になります。 の出現 generative AIは有望ではあるが、主に実験と周辺部に限定されている。 これらのテクノロジーを大規模に展開するには、望ましくない行為を有効または防止し、セキュリティ対策を強化し、新たな規制枠組みに適応し、コストとコストの両方の観点から持続可能性を確保する明確に定義されたルールによって推進される、信頼され管理されたフレームワークが必要です。人間の能力と環境、社会、ガバナンス (ESG) 要素への影響。

企業が AI がもたらす計り知れない可能性を大規模に真に活用するには、業界のより広範な状況の中で責任あるガバナンスを優先する必要があります。 責任第一のアプローチは、この重要な側面に対処しようとし、企業が倫理基準を維持しながら AI テクノロジーを有意義に活用できるようにします。

AI における倫理的懸念

AI テクノロジーには、無視できない多くの倫理的懸念が伴います。 これらの懸念には以下が含まれます: データプライバシー、アルゴリズムの偏り、誤用の可能性、規制順守。

個人データの収集、保管、利用は、プライバシーに関する重大な問題を引き起こしています。 データの誤った取り扱いは重大な結果をもたらし、個人の権利を侵害する可能性があります。 さらに、AI システムは偏見の影響を受けないわけではなく、既存の不平等や固定観念を意図せず永続させる可能性があります。 アルゴリズムのバイアスに対処することは、公平性と公平性を確保するために重要です。

AI テクノロジーの悪用も広範囲に影響を及ぼし、誤った情報、監視、意図しない危害など、さまざまな社会的および倫理的問題を引き起こす可能性があります。 これは、倫理基準を維持するために不可欠である一方で、対処が困難な新たな規制によってさらに悪化しています。 こうした進化する規制の枠組みに適応することは、責任ある AI の重要な側面です。

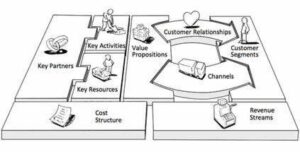

AI の責任あるガバナンスは、以下を含む多面的な取り組みです。

- 倫理的枠組み: 組織は、AI の開発と導入をガイドする明確な倫理的枠組みを確立し、テクノロジーが個人の権利と社会的価値観を尊重するようにする必要があります。

- アルゴリズムの公平性: AI アルゴリズムのバイアスを検出して修正するための措置を実装することは、公平性と公平な結果を確保するために不可欠です。

- 信頼できるトランザクション: AI テクノロジーを効果的に拡張するには、信頼できるトランザクションを確立し、ユーザーが AI 主導の意思決定を安心して信頼できるようにする必要があります。

- セキュリティ対策: AI システムをサイバー脅威から守り、データのプライバシーを確保するには、堅牢なセキュリティ プロトコルが必要です。

- 適応性: AI システムは、進化する規制状況に適応し、倫理的および法的基準への継続的なコンプライアンスを確保するように設計する必要があります。

- コストの持続可能性: AI の導入を経済的に実行可能にし、より幅広い組織が AI を利用できるようにするには、費用対効果が非常に重要です。

- 人間の能力と ESG への影響: AI は人間の能力を向上させると同時に、環境、社会、ガバナンス (ESG) 要素にプラスの影響を与え、より持続可能で公平な社会に貢献するはずです。

AI テクノロジーが業界と社会を再構築し続けるにつれて、AI の責任あるガバナンスはもはやオプションではなくなりました。 それは必須です。 責任第一のアプローチでは、倫理と説明責任が AI の開発と導入の中核に据えられ、組織はデータ プライバシー、アルゴリズムの偏り、悪用の可能性などの倫理的懸念に対処しながらテクノロジーの利点を活用できるようになります。 そうすることで、AI の力を責任を持って活用し、企業と社会の両方に利益をもたらすことができます。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- PlatoData.Network 垂直生成 Ai。 自分自身に力を与えましょう。 こちらからアクセスしてください。

- プラトアイストリーム。 Web3 インテリジェンス。 知識増幅。 こちらからアクセスしてください。

- プラトンESG。 カーボン、 クリーンテック、 エネルギー、 環境、 太陽、 廃棄物管理。 こちらからアクセスしてください。

- プラトンヘルス。 バイオテクノロジーと臨床試験のインテリジェンス。 こちらからアクセスしてください。

- 情報源: https://www.dataversity.net/responsible-first-ai-governance-addressing-ethical-concerns-for-scalable-adoption/

- :持っている

- :は

- :not

- a

- アクセス可能な

- 説明責任

- 行動

- 適応する

- 住所

- アドレッシング

- 養子縁組

- 出現

- AI

- AIガバナンス

- AIシステム

- アルゴリズム

- アルゴリズムの

- アルゴリズムバイアス

- アルゴリズム

- すべて

- 許可

- また

- an

- および

- です

- 人工の

- 人工知能

- 人工知能(AI)

- AS

- 側面

- At

- 試み

- BE

- になる

- になる

- き

- 恩恵を受ける

- 利点

- バイアス

- 両言語で

- 持って来る

- 持参

- より広い

- ビジネス

- by

- 缶

- 機能

- 機能

- 課題

- 挑戦

- クリア

- コレクション

- コンプライアンス

- 懸念事項

- 信頼

- 結果

- コンテキスト

- 続ける

- 継続します

- 貢献

- 基本

- 正しい

- 費用

- 重大な

- サイバー

- データ

- データプライバシー

- データバーシティ

- 決定

- 展開します

- 展開

- 設計

- 検出

- 開発

- すること

- ドリブン

- 効果的に

- 新興の

- enable

- 有効にする

- 包含する

- 将来

- 強制します

- 高めます

- 確保

- 確保する

- 企業

- 環境の

- 公平な

- 株式

- IT G

- 本質的な

- 確立する

- 設立

- 倫理的な

- 倫理

- 進化

- 既存の

- 要因

- 公平

- 広範囲に及ぶ

- 財政的に

- 最前線

- フレームワーク

- から

- さらに

- ガバナンス

- 支配

- ガイド

- 害

- ハーネス

- 利用

- 持ってる

- 持って

- host

- HTTPS

- 人間

- 計り知れない

- 免疫

- 影響

- 影響を与える

- 命令的

- 実装

- in

- include

- 含めて

- ますます

- 個人

- 産業

- 産業を変えます

- 不平等

- 影響力のある

- インテリジェンス

- 問題

- IT

- キー

- 主として

- 主要な

- リーガルポリシー

- 活用します

- より長いです

- 保守

- make

- 作成

- 意味のある

- 措置

- 誤った取り扱い

- 誤報

- 誤用

- 緩和する

- 他には?

- 多面

- しなければなりません

- ナビゲート

- 必要

- 必要

- いいえ

- of

- on

- or

- 組織

- 成果

- 最高の

- 個人的な

- 個人データ

- 視点

- 場所

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 積極的に

- 潜在的な

- 電力

- プレゼント

- 防ぐ

- 優先順位をつける

- プライバシー

- 有望

- プロトコル

- 隆起した

- 範囲

- 急速に

- 規制

- レギュレータ

- 企業コンプライアンス

- 頼る

- 残っている

- 覚えています

- 形を変える

- 敬意

- 責任

- 責任をもって

- 権利

- ルール

- ド電源のデ

- 規模

- スケールai

- セクター

- セキュリティ

- セキュリティー対策

- 厳しい

- すべき

- 重要

- So

- 社会

- 社会的

- 社会

- 規格

- ストレージ利用料

- そのような

- 監視

- 持続可能性

- 持続可能な

- システム

- テクノロジー

- テクノロジー

- より

- それ

- アプリ環境に合わせて

- それら

- そこ。

- ボーマン

- 彼ら

- この

- しかし?

- 脅威

- 〜へ

- 取引

- 真に

- 信頼されている

- に

- つかいます

- users

- 価値観

- さまざまな

- 実行可能な

- 極めて重要な

- we

- 明確な

- いつ

- which

- while

- 以内

- 世界

- ゼファーネット