עולם הבינה המלאכותית (AI) מתפתח במהירות, ומביא לקדמת הבמה גם פוטנציאל עצום וגם אתגרים אתיים. בהקשר זה, חיוני לזכור כי אינטליגנציה, כאשר נעשה בה שימוש לרעה, עלולה להיות חמורה יותר מאשר אין אותה כלל. ככל שטכנולוגיות בינה מלאכותית מתרחבות והופכות למשפיעות יותר ויותר במגזרים שונים, ממשל אחראי הופך להיות בעל חשיבות עליונה כדי לרתום את היתרונות שלהן תוך הפחתת הנזק הפוטנציאלי. הופעתו של AI ייצור, למרות שהוא מבטיח, הוגבל ברובו לניסויים ולשוליים. כדי לפרוס את הטכנולוגיות הללו בקנה מידה, יש צורך במסגרות מהימנות ומבוקרות, המונעות על ידי כללים מוגדרים היטב המאפשרים או מונעים פעולות לא רצויות, אוכפים אמצעי אבטחה, מסתגלים למסגרות רגולטוריות מתפתחות ומבטיחים קיימות הן מנקודת מבט של עלות והן מבחינה כלכלית. השפעה על היכולת האנושית וגורמים סביבתיים, חברתיים וממשל (ESG).

כדי שארגונים יוכלו למנף באמת את הפוטנציאל העצום ש-AI מציגה בקנה מידה, עליהם לתעדף ממשל אחראי בהקשר הרחב יותר של התעשייה. גישה אחראית-ראשונה מנסה לטפל בהיבט מפתח זה, ומאפשרת לעסקים לעשות שימוש משמעותי בטכנולוגיית AI תוך שמירה על סטנדרטים אתיים.

דאגות אתיות בבינה מלאכותית

טכנולוגיות AI מביאות איתן שורה של חששות אתיים שאי אפשר להתעלם מהם. חששות אלה כוללים פרטיות מידע, הטיית אלגוריתמים, שימוש לרעה פוטנציאלי ותאימות לתקנות.

איסוף, אחסון וניצול של נתונים אישיים העלו בעיות פרטיות משמעותיות. טיפול שגוי בנתונים עלול להיות בעל השלכות חמורות ולהפר את זכויותיהם של אנשים. יתרה מכך, מערכות בינה מלאכותית אינן חסינות מפני הטיה, והן יכולות להנציח ללא כוונה אי-שוויון או סטריאוטיפים קיימים. טיפול בהטיה אלגוריתמית חיונית כדי להבטיח הוגנות ושוויון.

שימוש לרעה בטכנולוגיות בינה מלאכותית יכול גם להיות בעל השפעה מרחיקת לכת, מה שמוביל למגוון של סוגיות חברתיות ואתיות, כולל מידע מוטעה, מעקב ונזק בלתי מכוון. זה מחמיר עוד יותר על ידי תקנות מתעוררות, שאמנם חיוניות לשמירה על סטנדרטים אתיים, אך עלולות להיות מאתגרות לניווט. ההסתגלות למסגרות הרגולטוריות המתפתחות הללו היא היבט מכריע של בינה מלאכותית אחראית.

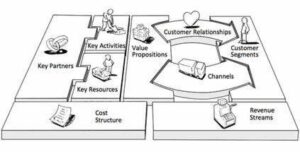

הממשל האחראי של AI הוא מאמץ רב-גוני, הכולל:

- מסגרות אתיות: ארגונים חייבים להקים מסגרות אתיות ברורות המנחות את הפיתוח והפריסה של בינה מלאכותית, תוך הבטחה שהטכנולוגיה מכבדת את זכויות הפרט ואת הערכים החברתיים.

- הגינות אלגוריתמית: יישום אמצעים לאיתור ותיקון הטיה באלגוריתמי AI חיוני להבטחת הוגנות ותוצאות שוויוניות.

- עסקאות מהימנות: כדי להגדיל את טכנולוגיות הבינה המלאכותית ביעילות, יש ליצור עסקאות מהימנות, שיאפשרו למשתמשים להסתמך על החלטות מונעות בינה מלאכותית בביטחון.

- אמצעי ביטחון: פרוטוקולי אבטחה חזקים נחוצים כדי להגן על מערכות AI מאיומי סייבר ולהבטיח פרטיות נתונים.

- יכולת הסתגלות: מערכות בינה מלאכותית צריכות להיות מתוכננות כך שיתאימו לנופים הרגולטוריים המתפתחים, תוך הבטחת עמידה מתמשכת בתקנים אתיים ומשפטיים.

- קיימות עלות: עלות-תועלת חיונית כדי להבטיח שפריסת בינה מלאכותית תישאר משתלמת מבחינה פיננסית, מה שהופך אותה לנגישה למגוון רחב יותר של ארגונים.

- יכולת אנושית והשפעת ESG: בינה מלאכותית צריכה לשפר את היכולות האנושיות תוך השפעה חיובית על גורמים סביבתיים, חברתיים וממשל (ESG), ולתרום לחברה בת קיימא ושוויונית יותר.

ככל שטכנולוגיות AI ממשיכות לעצב מחדש את התעשיות והחברה, הממשל האחראי של AI אינו אופציונלי עוד; זה הכרחי. הגישה האחריות-ראשונה מציבה אתיקה ואחריות בליבה של פיתוח ופריסה של בינה מלאכותית, ומאפשרת לארגונים לרתום את היתרונות של הטכנולוגיה תוך התייחסות לחששות אתיים כגון פרטיות נתונים, הטיית אלגוריתמים ופוטנציאל שימוש לרעה. בכך, אנו יכולים להבטיח שכוחה של AI מנוצל באחריות, תוך תועלת הן לעסקים והן לחברה.

- הפצת תוכן ויחסי ציבור מופעל על ידי SEO. קבל הגברה היום.

- PlatoData.Network Vertical Generative Ai. העצים את עצמך. גישה כאן.

- PlatoAiStream. Web3 Intelligence. הידע מוגבר. גישה כאן.

- PlatoESG. פחמן, קלינטק, אנרגיה, סביבה, שמש, ניהול פסולת. גישה כאן.

- PlatoHealth. מודיעין ביוטכנולוגיה וניסויים קליניים. גישה כאן.

- מקור: https://www.dataversity.net/responsible-first-ai-governance-addressing-ethical-concerns-for-scalable-adoption/

- :יש ל

- :הוא

- :לֹא

- a

- נגיש

- דין וחשבון

- פעולות

- להסתגל

- כתובת

- פְּנִיָה

- אימוץ

- הִתגַלוּת

- AI

- ממשל AI

- מערכות AI

- אַלגוֹרִיתְם

- אלגוריתמי

- הטיה אלגוריתמית

- אלגוריתמים

- תעשיות

- מאפשר

- גם

- an

- ו

- ARE

- מלאכותי

- בינה מלאכותית

- בינה מלאכותית (AI)

- AS

- אספקט

- At

- ניסיונות

- BE

- להיות

- הופך להיות

- היה

- מרוויח

- הטבות

- הטיה

- שניהם

- להביא

- מביאים

- רחב

- עסקים

- by

- CAN

- לא יכול

- יכולות

- יכולת

- האתגרים

- אתגר

- ברור

- אוסף

- הענות

- דאגות

- אמון

- השלכות

- הקשר

- להמשיך

- נמשך

- תורם

- ליבה

- לתקן

- עלות

- מכריע

- סייבר

- נתונים

- פרטיות מידע

- קושי

- החלטות

- לפרוס

- פריסה

- מעוצב

- לאתר

- צעצועי התפתחות

- עושה

- מונע

- יעילות

- מתעורר

- לאפשר

- מה שמאפשר

- מקיף

- מאמץ

- לאכוף

- להגביר את

- לְהַבטִיחַ

- הבטחתי

- חברות

- סביבתי

- הוֹגֶן

- הון עצמי

- ESG

- חיוני

- להקים

- נוסד

- אֶתִי

- אתיקה

- מתפתח

- קיימים

- גורמים

- הגינות

- מרחיק לכת

- כלכלית

- בעד

- בחזית

- מסגרות

- החל מ-

- נוסף

- ממשל

- נשלט

- מדריך

- לפגוע

- רתמת

- רָתוּם

- יש

- יש

- המארח

- HTTPS

- בן אנוש

- עָצוּם

- חסין

- פְּגִיעָה

- השפעה

- הֶכְרֵחִי

- יישום

- in

- לכלול

- כולל

- יותר ויותר

- בנפרד

- תעשיות

- תעשייה

- אי-שוויון

- בעל השפעה

- מוֹדִיעִין

- בעיות

- IT

- מפתח

- במידה רבה

- מוביל

- משפטי

- תנופה

- עוד

- שמירה

- לעשות

- עשייה

- משמעותי

- אמצעים

- טיפול לא נכון

- מידע שגוי

- שימוש לרעה

- מקלה

- יותר

- רב פנים

- צריך

- נווט

- הכרחי

- צורך

- לא

- of

- on

- or

- ארגונים

- תוצאות

- הגדול ביותר

- אישי

- מידע אישי

- פרספקטיבה

- מקומות

- אפלטון

- מודיעין אפלטון

- אפלטון נתונים

- חיובי

- פוטנציאל

- כּוֹחַ

- מתנות

- למנוע

- תיעדוף

- פְּרָטִיוּת

- מבטיח

- פרוטוקולים

- מורם

- רכס

- מהר

- תקנון

- רגולטורים

- התאמה לתקנות

- לסמוך

- שְׂרִידִים

- לזכור

- לעצב מחדש

- מכבד

- אחראי

- באחריות

- זכויות

- כללי

- להרחבה

- סולם

- סולם ai

- מגזרים

- אבטחה

- אמצעי אבטחה

- קשה

- צריך

- משמעותי

- So

- חֶברָתִי

- חברתי

- חֶברָה

- תקנים

- אחסון

- כזה

- מעקב

- קיימות

- בר קיימא

- מערכות

- טכנולוגיות

- טכנולוגיה

- מֵאֲשֶׁר

- זֶה

- השמיים

- שֶׁלָהֶם

- אותם

- שם.

- אלה

- הֵם

- זֶה

- אם כי?

- איומים

- ל

- עסקות

- באמת

- מהימן

- על

- להשתמש

- משתמשים

- ערכים

- שונים

- בַּר חַיִים

- חיוני

- we

- מוגדר היטב

- מתי

- אשר

- בזמן

- עם

- בתוך

- עוֹלָם

- זפירנט